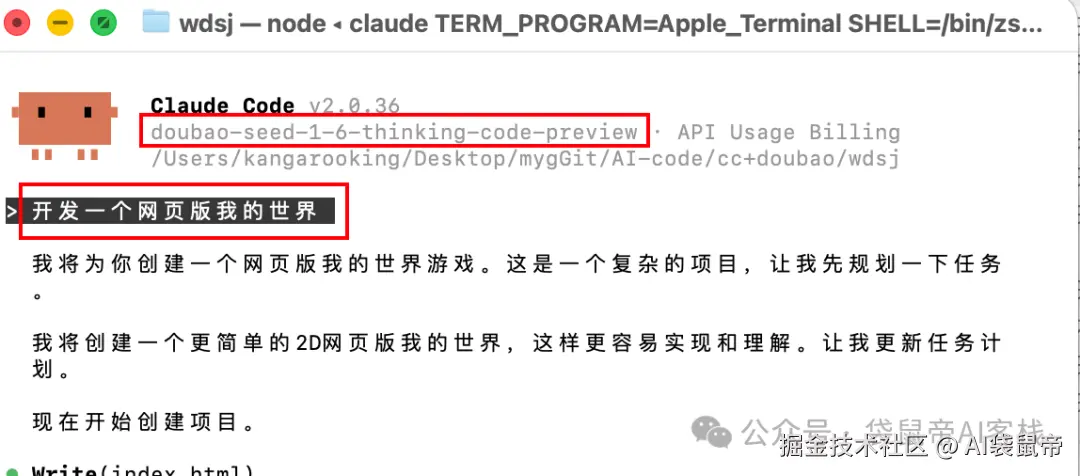

ZeroClaw 实战:Rust 重构版 OpenClaw,7.8MB 内存秒启动的 AI 助手

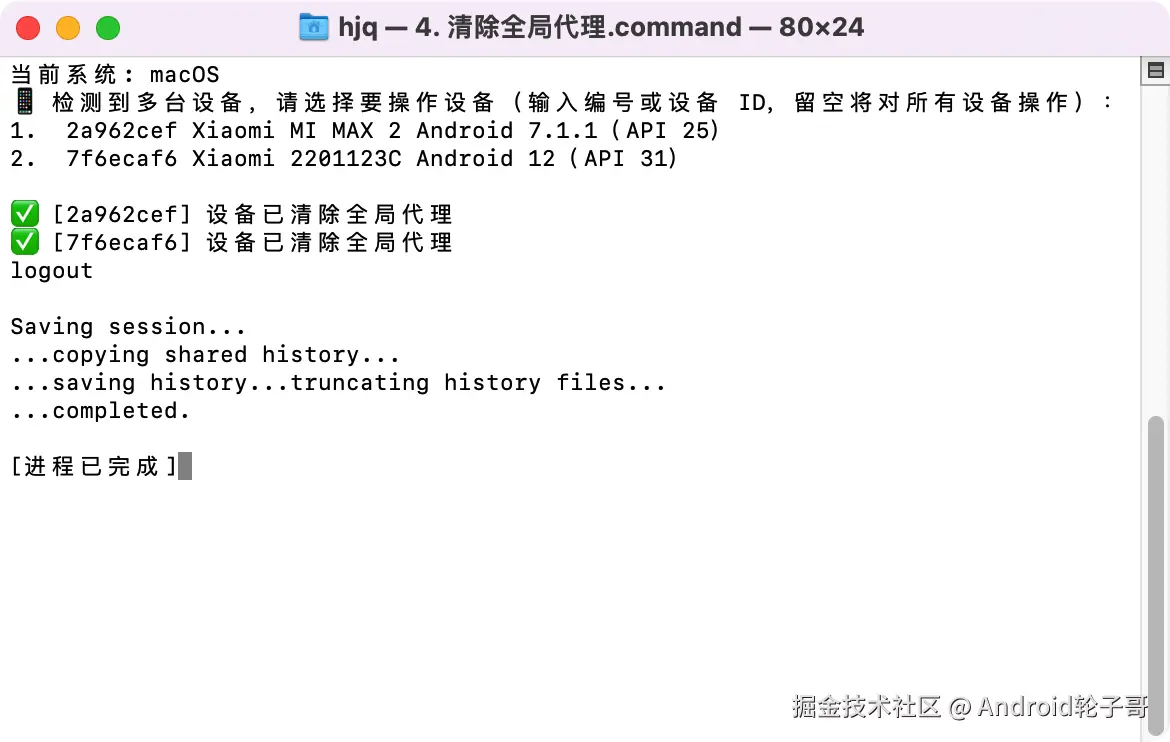

OpenClaw 功能强大,但在内存占用和启动速度方面存在挑战。针对这些问题,主打极速、轻量的 Rust 重构版 ZeroClaw 应运而生。

整篇文章的目标只有一个:

让你看完后,能在本地服务器上部署 ZeroClaw,体验 7.8MB 内存、秒启动的 AI 助手,并在实际项目中发挥它的价值。

一、ZeroClaw 是什么?为什么值得一试?

1.1 性能对比

如果把它和 OpenClaw 放在一起对比,ZeroClaw 可以说是个妥妥的性能怪兽。

根据官方基准测试(macOS arm64,2026年2月,针对 0.8GHz 边缘硬件标准化),ZeroClaw 的表现如下:

| 指标 | OpenClaw | ZeroClaw 🦀 |

|---|---|---|

| 编程语言 | TypeScript | Rust |

| 内存占用 | > 1GB | < 5MB |

| 启动速度(0.8GHz 核心) | > 500s | < 10ms |

| 二进制大小 | ~28MB (dist) | 3.4 MB |

| 硬件成本 | Mac Mini $599 | 任意硬件 $10 |

这个项目用 Rust 编写,ZeroClaw 运行时内存不到 5MB、启动时间小于 10ms、二进制体积仅约 3.4MB,支持在树莓派或者低配云主机上部署 Agent。

从性能角度看,它具备几个关键特性:

- 🏎️ 极致精简:< 5MB 内存占用,比 OpenClaw 核心小 99%

- 💰 成本极低:高效到可以在 $10 硬件上运行,比 Mac mini 便宜 98%

- ⚡ 闪电启动:启动速度提升 400 倍,在 < 10ms 内启动(即使在 0.6GHz 核心上也能在 1 秒内启动)

- 🌍 真正可移植:跨 ARM、x86 和 RISC-V 的单一自包含二进制文件

1.2 适用场景

场景 A:资源受限环境

如果你需要在树莓派、低配云主机(1GB 内存)上部署 AI Agent,ZeroClaw 无疑是最优选。

它那极低的资源占用,能大幅减少服务器资源的浪费。用省下的内存,来运行多一点其他业务,不香吗?

场景 B:自动化流水线与服务器运维

如果需求是每天定时抓取博客、监控服务器日志,或者在配置较低的云服务器上部署,ZeroClaw 的轻量特性让它成为理想选择。

场景 C:批量部署

对于需要在一人企业中批量部署多个 AI Agent 的场景,ZeroClaw 的小体积和低资源占用,让批量部署成为可能。

1.3 架构设计:一切都是 Trait

ZeroClaw 的核心设计理念是:每个子系统都是一个 trait,只需更改配置即可交换实现,无需修改代码。

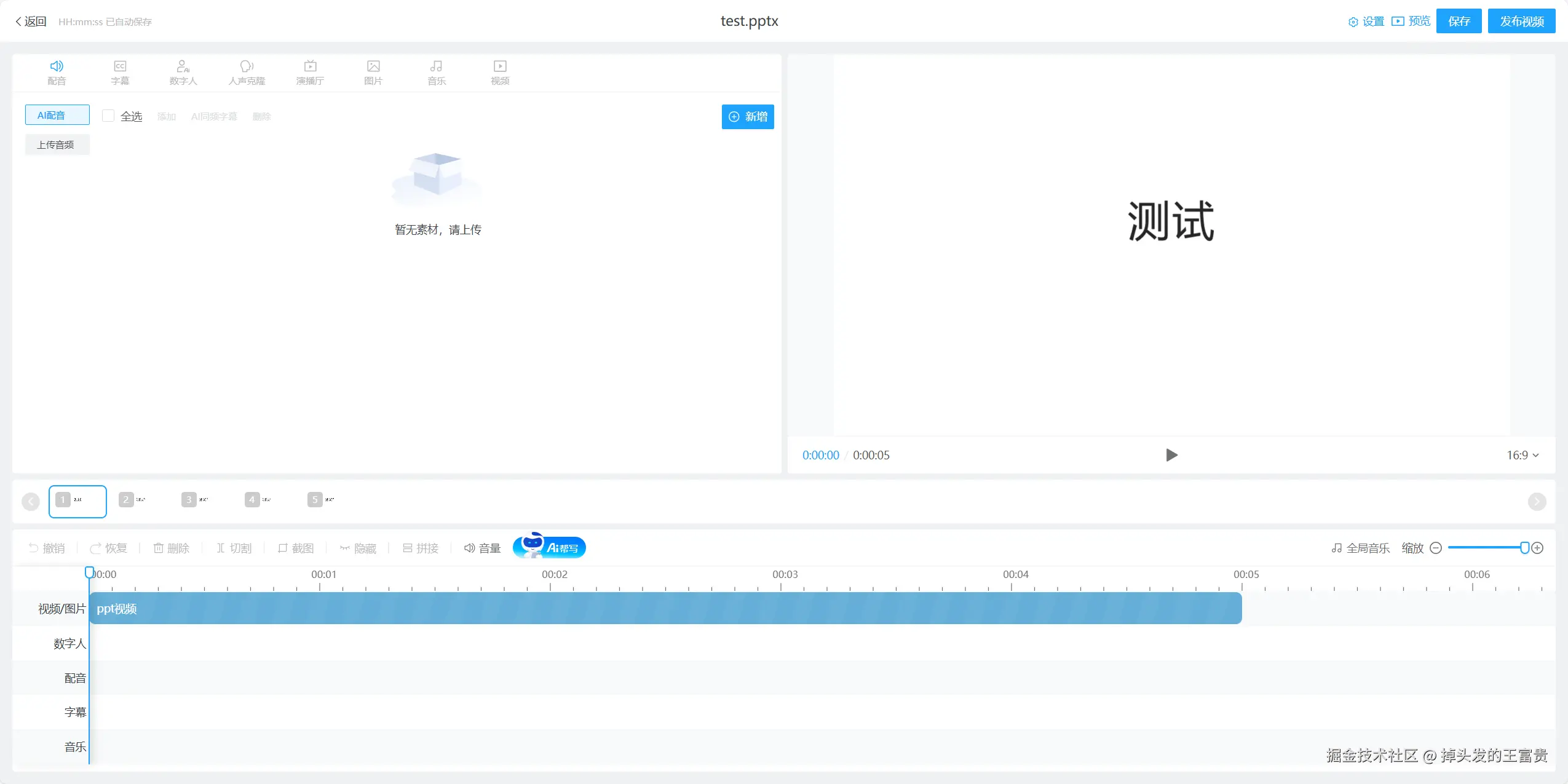

ZeroClaw 架构图,展示各个子系统(Provider、Channel、Memory、Tools 等)的 trait 设计和可插拔架构

核心子系统:

| 子系统 | Trait | 内置实现 | 可扩展 |

|---|---|---|---|

| AI 模型 | Provider | 22+ providers(OpenRouter、Anthropic、OpenAI、Ollama、Venice、Groq、Mistral、xAI、DeepSeek、Together、Fireworks、Perplexity、Cohere、Bedrock 等) | custom:https://your-api.com — 任何 OpenAI 兼容的 API |

| 通信渠道 | Channel | CLI、Telegram、Discord、Slack、iMessage、Matrix、WhatsApp、Webhook | 任何消息 API |

| 记忆系统 | Memory | SQLite 混合搜索(FTS5 + 向量余弦相似度)、Markdown | 任何持久化后端 |

| 工具 | Tool | shell、file_read、file_write、memory_store、memory_recall、memory_forget、browser_open(Brave + 白名单)、composio(可选) | 任何能力 |

| 可观测性 | Observer | Noop、Log、Multi | Prometheus、OTel |

| 运行时 | RuntimeAdapter | Native(Mac/Linux/Pi) | Docker、WASM(计划中) |

| 安全策略 | SecurityPolicy | Gateway 配对、沙箱、白名单、速率限制、文件系统作用域、加密密钥 | — |

| 身份系统 | IdentityConfig | OpenClaw(markdown)、AIEOS v1.1(JSON) | 任何身份格式 |

| 隧道 | Tunnel | 、Cloudflare、Tailscale、ngrok、Custom | 任何隧道二进制文件 |

这种设计让 ZeroClaw 具有极强的可扩展性和灵活性,你可以根据实际需求替换任何组件,而无需修改核心代码。

二、开始前你需要准备好的东西

动手之前,先确认这几样已经就绪。

- 一台 Linux/macOS 服务器(Windows 需要 WSL)

ZeroClaw 是纯 Rust 项目,主要支持 Linux 和 macOS。Windows 用户需要先安装 WSL。 - Rust 环境(如果还没安装,下面会带你安装)

由于 ZeroClaw 是纯 Rust 项目,需要先安装 Rust 编译环境。 - LLM API Key(OpenAI、Anthropic、DeepSeek、OpenRouter 等)

用于配置 AI 模型,支持主流的大模型服务。

三、手把手安装:10 分钟搞定 ZeroClaw

3.1 环境准备:安装 Rust

由于 ZeroClaw 是纯 Rust 项目,如果我们电脑里还没安装 Rust,需要先把 Rust 环境准备好。

Linux / macOS:一条命令安装

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

source $HOME/.cargo/env

rustc --version

cargo --version

看到版本号后,说明 Rust 安装成功,可以继续后面的 ZeroClaw 编译和安装步骤了。

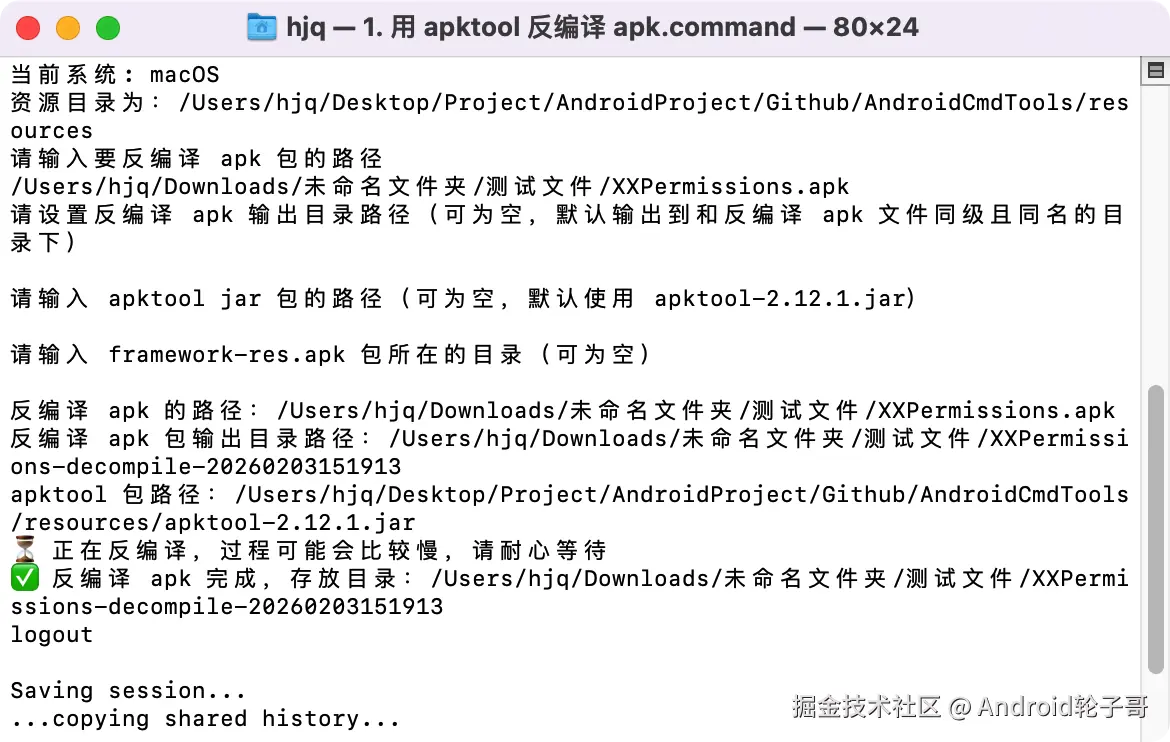

开始安装

安装成功

Windows:通过 WSL 安装(推荐 ZeroClaw 场景)

ZeroClaw 更适合跑在 Linux 环境里,所以在 Windows 下,推荐先装好 WSL(如 Ubuntu),然后在 WSL 终端里执行和 Linux 一样的命令,看到版本号后,就可以在这个 WSL 环境中继续后面的 ZeroClaw 编译和安装步骤了。

3.2 编译安装 ZeroClaw

环境装好后,我们把代码拉下来,就能开始编译安装了。

这里推荐 Release 版,因为它体积最小、速度最快:

# 克隆仓库

git clone https://github.com/zeroclaw-labs/zeroclaw.git

cd zeroclaw

# 编译 Release 版本(优化后的版本)

cargo build --release

# 安装到系统路径

cargo install --path . --force

⚠️ 编译时间较长

首次编译 Rust 项目可能需要 5 - 10 分钟,取决于你的机器性能。这是正常现象,因为 Rust 需要编译所有依赖。

解决:耐心等待,或者使用cargo build --release -j $(nproc)来并行编译加速。

编译完成后,验证安装:

zeroclaw --version

如果显示版本号,说明安装成功。

3.3 基础配置:交互式向导

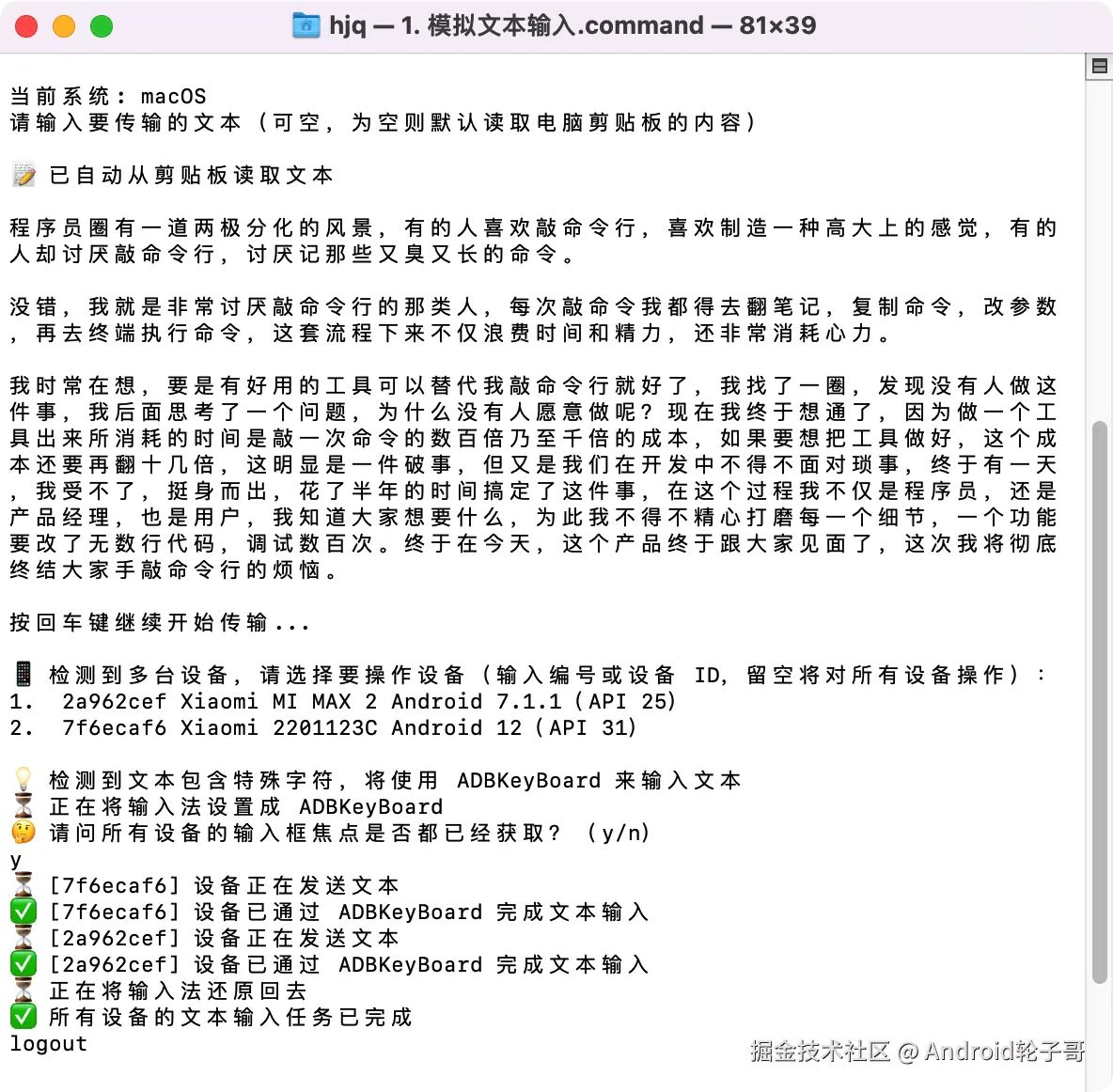

这个项目不仅安装快,配置也极其人性化。交互式向导:

zeroclaw onboard --interactive

这是一个完整的 7 步交互式向导,会引导你完成所有配置。

配置向导会引导你完成:

- 输入 LLM 的 API Key

支持 OpenAI, Anthropic, DeepSeek, OpenRouter 等主流模型。

根据你选择的模型服务,输入对应的 API Key。 - 选择想连接的渠道

比如 Slack, Discord, Telegram, WhatsApp 等。

如果暂时不确定,可以先跳过,后续再配置。 - 安全设置:强制设置一个 "配对码"

防止陌生人乱连我们的 Agent。

这个配对码很重要,后续连接时需要用到。 - 配置渠道白名单

为了安全,建议配置允许列表,只允许特定用户连接。 - 其他高级配置

包括内存后端、隧道配置等。

配置完成后,配置文件通常保存在:

- Linux/macOS:

~/.zeroclaw/config.toml - Windows(WSL):

~/.zeroclaw/config.toml

⚠️ 渠道白名单配置

如果配置后收到消息但 ZeroClaw 没有响应,可能是白名单配置问题。

解决:

- 查看日志,找到发送者的身份标识

- 运行

zeroclaw onboard --channels-only重新配置白名单

- 或者临时使用

"*"允许所有(仅用于测试)

3.4 启动和使用 ZeroClaw

启动守护进程

如果你希望 ZeroClaw 长期运行,处理定时任务和自动响应:

zeroclaw daemon

此时,它就在后台默默运行了。

我们可以随时用以下命令查看它的状态:

zeroclaw status

其他实用命令:

# 运行系统诊断

zeroclaw doctor

# 检查渠道健康状态

zeroclaw channel doctor

# 查看集成信息(如 Telegram)

zeroclaw integrations info Telegram

# 管理后台服务

zeroclaw service install

zeroclaw service status

现在,你就拥有一个 24 小时待命的全功能 AI 助手。

四、配置文件详解:定制你的 ZeroClaw

配置文件位置:~/.zeroclaw/config.toml(由 onboard 命令创建)

4.1 基础配置

# API 密钥(支持加密存储)

api_key = "sk-..."

default_provider = "openrouter" # 默认 provider

default_model = "anthropic/claude-sonnet-4-20250514" # 默认模型

default_temperature = 0.7 # 默认温度参数

4.2 内存配置

[memory]

backend = "sqlite" # "sqlite", "markdown", "none"

auto_save = true # 自动保存

embedding_provider = "openai" # "openai", "noop"

vector_weight = 0.7 # 向量搜索权重

keyword_weight = 0.3 # 关键词搜索权重

4.3 Gateway 配置

[gateway]

require_pairing = true # 首次连接需要配对码

allow_public_bind = false # 拒绝 0.0.0.0 绑定(无隧道时)

4.4 自主性配置

[autonomy]

level = "supervised" # "readonly", "supervised", "full"

workspace_only = true # 限制在工作区范围内

allowed_commands = ["git", "npm", "cargo", "ls", "cat", "grep"] # 允许的命令

forbidden_paths = ["/etc", "/root", "/proc", "/sys", "~/.ssh", "~/.gnupg", "~/.aws"] # 禁止访问的路径

4.5 其他配置

[runtime]

kind = "native" # 当前仅支持 "native"

[heartbeat]

enabled = false # 是否启用定时任务

interval_minutes = 30 # 任务执行间隔

[tunnel]

provider = "none" # "none", "cloudflare", "tailscale", "ngrok", "custom"

[secrets]

encrypt = true # API 密钥加密存储

[browser]

enabled = false # 是否启用浏览器工具

allowed_domains = ["docs.rs"] # 允许访问的域名

[composio]

enabled = false # 是否启用 Composio(1000+ OAuth 应用)

📌 提示:配置文件支持热重载,修改后重启服务即可生效。建议使用

zeroclaw doctor检查配置是否正确。

五、OpenClaw 和 ZeroClaw,怎么选?

简单说,可以按场景来选:

- 如果你更关注交互体验、家庭中枢、可视化能力,已经在用 Mac mini 等环境做本地 AI 中控,那继续用 OpenClaw 会更顺手。

- 如果你更在意资源占用、启动速度、批量部署,尤其是打算在树莓派、低配云服务器上长期跑 Agent,那 ZeroClaw 会是更合适的选择。

很多时候,两者是可以并存的:用 OpenClaw 做「大中枢」,用 ZeroClaw 覆盖「边缘节点」和自动化脚本,各自发挥所长。

六、相关资源

GitHub 项目地址:

github.com/zeroclaw-la…

官方文档:

我的其他相关文章:

- 《GitHub 10万+ Star 的 Moltbot 部署实战:手把手带你在本地跑起来这只「龙虾」🦞》

- 《一步步带你手搓专属 IM APP,控制本地 OpenClaw,破局国内 IM 封闭受限》

- 《手把手教你安装 OpenClaw 并接入飞书,让本地 AI 在飞书里听你指挥》

- 《手把手带你实现:飞书 → OpenClaw → Cursor Agent → OpenClaw → 飞书》

结语:ZeroClaw 作为 OpenClaw 的 Rust 重构版,在保持核心功能的同时,大幅降低了资源占用和启动时间。对于需要在资源受限环境或批量部署场景下使用 AI Agent 的朋友来说,ZeroClaw 无疑是一个值得尝试的选择。

希望本文能够帮助你顺利完成部署,在实际项目中发挥 ZeroClaw 的价值。如果在部署过程中遇到问题,欢迎查阅官方文档或相关社区获取帮助。

来源:juejin.cn/post/7610997893576376354

Skills 实战:让 AI 成为你的领域专家

引言:从通用助手到领域专家

想象一下这些场景:

场景 1: 重复的上下文说明

你: "帮我分析这个 BigQuery 数据,记住要排除测试账户,使用 user_metrics 表..."

Claude: "好的,我来分析..."

[第二天]

你: "再帮我分析一次销售数据,还是那个表,记得排除测试账户..."

Claude: "好的,我来分析..." # 😓 又要重复一遍

场景 2: 领域知识的重复传授

你: "帮我处理这个 PDF 表单,PDF 的表单字段结构是..."

Claude: "明白了"

[一周后]

你: "再处理一个 PDF 表单..."

Claude: "请告诉我 PDF 表单的结构" # 😓 忘记了

场景 3: 工作流程的不一致

你: "生成 API 文档,记得包含请求示例、响应格式、错误码..."

Claude: "好的" # ✅ 这次做得很好

[下次]

你: "再生成一份 API 文档"

Claude: [生成的文档] # ❌ 这次忘记了错误码部分

这些问题的根源是:每次对话都是全新的开始,Claude 无法记住你的领域知识、偏好和工作流程。

💡 Skills 系统的价值

Skills 就是解决这个问题的方案——它让你能够:

- 📦 封装领域知识: 把你反复向 Claude 解释的专业知识打包成 Skill

- 🔄 自动加载: 当任务相关时,Skill 自动激活,无需重复说明

- ♻️ 持续复用: 创建一次,跨所有对话自动使用

- 🎯 专业能力: 让 Claude 从通用助手进化为领域专家

本文核心内容:

- Skills 的核心概念与工作原理

- 渐进式披露架构:三级加载机制

- 创建自定义 Skills:从入门到精通

- 最佳实践:简洁、结构化、可验证

- 实战案例:PDF 处理、BigQuery 分析、代码审查

- 评估与迭代:如何持续优化 Skills

"把你反复向 Claude 解释的偏好、流程、领域知识打包成 Skills,让 AI 成为你的领域专家"

一、什么是 Skills?

1.1 核心概念

Agent Skills(智能体技能)是一种模块化的能力扩展系统,它为 Claude 提供了:

- 领域专业知识: 如 PDF 处理技巧、数据库 schema、业务规则

- 工作流程: 如代码审查流程、文档生成流程、数据分析流程

- 最佳实践: 如命名规范、代码风格、错误处理模式

1.2 Skills vs 普通 Prompt

| 维度 | 普通 Prompt | Skills |

|---|---|---|

| 作用范围 | 单次对话 | 跨所有相关对话 |

| 加载方式 | 每次手动提供 | 相关任务时自动加载 |

| 上下文占用 | 每次都占用 | 按需加载,未使用时零占用 |

| 知识管理 | 分散在多次对话中 | 集中管理,持续优化 |

| 一致性 | 依赖人工记忆 | 标准化,确保一致 |

类比理解:

- 普通 Prompt 像是每次都要"现场培训"新员工

- Skills 像是给员工提供"岗位手册",需要时自己查阅

1.3 Skills 遵循开放标准

Claude Code Skills 基于 Agent Skills 开放标准,这意味着:

- ✅ 标准化格式,跨 AI 工具兼容

- ✅ 社区生态,可以使用他人创建的 Skills

- ✅ 长期支持,不会因产品升级而失效

Claude Code 在标准基础上扩展了:

- 🔧 调用控制机制

- 🤖 子代理执行能力

- 📥 动态上下文注入

二、Skills 工作原理:渐进式披露架构

2.1 为什么需要渐进式披露?

问题:如果把所有 Skills 的详细内容都加载到上下文中会怎样?

假设你有 10 个 Skills,每个包含 5000 tokens 的详细指导...

总共: 50,000 tokens

但你可能只需要使用其中 1-2 个 Skill!

浪费: 40,000+ tokens(80% 的上下文窗口!)

解决方案:渐进式披露——只加载需要的内容,按需展开详细信息。

2.2 三级加载机制

第一级:元数据(Metadata)- 始终加载

---

name: pdf-processing

description: Extract text and tables from PDF files, fill forms, merge documents.

Use when working with PDF files or when the user mentions PDFs, forms,

or document extraction.

---

- 加载时机: Claude 启动时

- Token 消耗: 每个 Skill 约 100 tokens

- 作用: 让 Claude 知道有哪些 Skills 可用,以及何时触发

关键字段解析:

name: Skill 标识符(小写字母、数字、连字符)description: 功能说明 + 触发场景(最重要的字段!)

⚠️ 重要: description 是 Skill 触发的关键。Claude 根据用户请求与 description 的匹配度决定是否加载该 Skill。

第二级:指令(Instructions)- 触发时加载

# PDF Processing

## Quick start

Use pdfplumber to extract text from PDFs:

\`\`\`python

import pdfplumber

with pdfplumber.open("document.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

For advanced form filling, see [FORMS.md](FORMS.md).

- 加载时机: 当用户请求匹配 Skill 描述时

- Token 消耗: 通常少于 5k tokens

- 作用: 提供具体的操作指导和工作流程

第三级:资源和代码(Resources & Code)- 按需访问

pdf-skill/

├── SKILL.md # 主指令文件(第二级)

├── FORMS.md # 表单填写指南(按需读取)

├── REFERENCE.md # 详细 API 参考(按需读取)

└── scripts/

└── fill_form.py # 工具脚本(执行时不加载代码)

- 加载时机: 仅当 SKILL.md 中引用时

- Token 消耗: 脚本执行时只有输出占用 tokens

- 作用: 提供专业参考材料和可执行工具

2.3 实例演示:从触发到加载

场景: 用户请求"帮我提取 PDF 中的文本"

┌─────────────────────────────────────────┐

│ 步骤 1: Claude 检查所有 Skill 的元数据 │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 匹配到 pdf-processing Skill │

│ description 包含 "Extract text from PDF"│

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 步骤 2: 加载 SKILL.md 的指令内容 │

│ (~3k tokens) │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 步骤 3: Claude 发现需要表单填写 │

│ 读取 FORMS.md (~2k tokens) │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 总 Token 消耗: 约 5k tokens │

│ 其他 9 个 Skills: 0 tokens(未加载) │

└─────────────────────────────────────────┘

对比无渐进式披露:

❌ 传统方式: 10 个 Skills × 5k = 50k tokens

✅ 渐进式披露: 只加载 1 个 Skill = 5k tokens

节省: 45k tokens (90% 的上下文!)

三、Skills 的文件结构

3.1 最小化 Skill

最简单的 Skill 只需要一个文件:

my-skill/

└── SKILL.md # 唯一必需的文件

SKILL.md 示例:

---

name: code-review-checklist

description: Provides a code review checklist for pull requests. Use when reviewing code or when the user asks for code review guidelines.

---

# Code Review Checklist

When reviewing code, check:

1. **Functionality**: Does the code do what it's supposed to?

2. **Readability**: Is the code easy to understand?

3. **Tests**: Are there appropriate tests?

4. **Performance**: Are there any obvious performance issues?

5. **Security**: Are there any security vulnerabilities?

For each item, provide specific feedback with examples.

3.2 完整 Skill 结构

对于复杂的 Skills,可以组织成多文件结构:

pdf-processing-skill/

├── SKILL.md # 核心指令(必需)

├── FORMS.md # 表单填写详细指南

├── REFERENCE.md # PDF 库 API 参考

├── EXAMPLES.md # 常见用例示例

└── scripts/

├── analyze_form.py # 分析表单工具

├── fill_form.py # 填写表单工具

└── validate.py # 验证输出工具

3.3 YAML Frontmatter 规范

必填字段:

---

name: skill-name # 必填

description: Skill description # 必填

---

字段要求:

| 字段 | 要求 | 示例 |

|---|---|---|

| name | 小写字母、数字、连字符 最多 64 字符 禁止 "anthropic"、"claude" | pdf-processingbigquery-analyticscode-reviewer |

| description | 非空 最多 1024 字符 包含功能 + 触发场景 第三人称描述 | Extract text from PDFs. Use when...Analyze BigQuery data. Use when... |

命名规范:

✅ 推荐: 动名词形式(Gerund Form)

processing-pdfs

analyzing-spreadsheets

reviewing-code

managing-databases

❌ 避免: 过于模糊

helper # 太模糊

utils # 不知道干什么

tool # 功能不明确

3.4 Description 字段的重要性

⚠️ 警告: description 是 Skill 触发的关键,必须用第三人称!

为什么必须第三人称?

description 会被注入到系统提示中,视角不一致会导致困惑:

系统提示: "You are Claude, an AI assistant..."

Skill description: "I can help you process PDFs" # ❌ 第一人称,视角冲突!

正确示例:

---

name: pdf-processing

description: Extract text and tables from PDF files, fill forms, merge documents.

Use when working with PDF files or when the user mentions PDFs, forms,

or document extraction.

---

不正确示例:

❌ description: I can help you process Excel files # 第一人称

❌ description: You can use this to process Excel # 第二人称

❌ description: Helps with documents # 过于模糊

编写技巧:

- 明确功能: 说清楚 Skill 能做什么

- 包含关键词: 用户可能使用的术语(PDF、Excel、BigQuery 等)

- 触发场景: 明确何时使用("Use when...")

- 简洁精准: 1-2 句话说清楚

四、创建你的第一个 Skill

4.1 确定需求

问题导向:

问自己:

- 我反复向 Claude 解释什么内容?

- 哪些领域知识 Claude 不太了解?

- 哪些工作流程需要标准化?

示例场景:

场景 1: BigQuery 数据分析

- ❌ 每次都要说明表结构

- ❌ 每次都要强调"排除测试账户"

- ❌ 每次都要说明查询模式

- ✅ 创建一个 BigQuery Skill!

场景 2: 公司文档规范

- ❌ 每次都要说明文档模板

- ❌ 每次都要强调格式要求

- ❌ 每次都要纠正不符合规范的部分

- ✅ 创建一个文档规范 Skill!

4.2 编写 SKILL.md

步骤 1: 创建目录和文件

mkdir my-bigquery-skill

cd my-bigquery-skill

touch SKILL.md

步骤 2: 编写 YAML Frontmatter

---

name: bigquery-analytics

description: Analyze BigQuery data from the user_metrics and sales tables. Use when the user asks about data analysis, metrics, or BigQuery queries. Always exclude test accounts and apply standard date filters.

---

步骤 3: 编写核心指令

# BigQuery Analytics

## Database Schema

### user_metrics table

- user_id (STRING): Unique user identifier

- event_date (DATE): Event date

- metrics_value (FLOAT): Metric value

- account_type (STRING): "production" or "test"

### sales table

- order_id (STRING): Order identifier

- user_id (STRING): User ID (foreign key to user_metrics)

- amount (FLOAT): Order amount

- order_date (DATE): Order date

## Standard Filtering Rules

**Always apply these filters:**

1. Exclude test accounts: `WHERE account_type = 'production'`

2. Date range: Default to last 30 days unless specified

3. Remove null values: `WHERE metrics_value IS NOT NULL`

## Query Patterns

### Pattern 1: User activity analysis

\`\`\`sql

SELECT

event_date,

COUNT(DISTINCT user_id) as active_users,

AVG(metrics_value) as avg_metric

FROM user_metrics

WHERE account_type = 'production'

AND event_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 30 DAY)

GR0UP BY event_date

ORDER BY event_date;

\`\`\`

### Pattern 2: Sales analysis

\`\`\`sql

SELECT

DATE_TRUNC(order_date, MONTH) as month,

COUNT(*) as order_count,

SUM(amount) as total_revenue

FROM sales s

JOIN user_metrics u ON s.user_id = u.user_id

WHERE u.account_type = 'production'

GR0UP BY month

ORDER BY month;

\`\`\`

## Important Notes

- **Performance**: Always use partitioned date fields in WHERE clause

- **Costs**: Preview query cost before running on large datasets

- **Timezone**: All dates are in UTC

五、核心最佳实践

5.1 简洁为王(Conciseness is Key)

核心原则: 上下文窗口是公共资源,你的 Skill 要与系统提示、对话历史、其他 Skills 共享。

✅ 好的示例(约 50 tokens)

## Extract PDF Text

Use pdfplumber for text extraction:

\`\`\`python

import pdfplumber

with pdfplumber.open("file.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

❌ 糟糕的示例(约 150 tokens)

## Extract PDF Text

PDF(便携式文档格式)是一种常见的文件格式,包含文本、图像等内容。

要从 PDF 中提取文本,你需要使用一个库。有很多 PDF 处理库可用,

但我们推荐 pdfplumber,因为它易于使用且能处理大多数情况。

首先,你需要使用 pip 安装它。然后你可以使用下面的代码...

为什么简洁版更好?

- ✅ 假设 Claude 已经知道 PDF 是什么

- ✅ 假设 Claude 知道库的工作原理

- ✅ 直接提供关键信息:用什么库、怎么用

- ✅ 节省 100 tokens,留给其他 Skills 使用

⚠️ 记住: 不要低估 Claude 的智能!它是通用 AI,不需要你解释基础概念。

5.2 设置适当的自由度

根据任务的脆弱性和可变性,选择合适的指导程度。

🌟 高自由度(基于文本的指令)

适用场景:

- 多种方法都可行

- 决策依赖上下文

- 启发式方法指导

示例:代码审查流程

## Code Review Process

1. Analyze code structure and organization

2. Check for potential bugs or edge cases

3. Suggest improvements for readability and maintainability

4. Verify compliance with project standards

特点: 给出大方向,信任 Claude 根据具体情况调整。

🎯 中等自由度(伪代码或带参数的脚本)

适用场景:

- 存在首选模式

- 允许一定变化

- 配置影响行为

示例:生成报告

## Generate Report

Use this template and customize as needed:

\`\`\`python

def generate_report(data, format="markdown", include_charts=True):

# Process data

# Generate output in specified format

# Optionally include visualizations

\`\`\`

特点: 提供模板和参数,允许根据需求调整。

🔒 低自由度(特定脚本,少量或无参数)

适用场景:

- 操作易错且脆弱

- 一致性至关重要

- 必须遵循特定顺序

示例:数据库迁移

## Database Migration

Execute this script strictly:

\`\`\`bash

python scripts/migrate.py --verify --backup

\`\`\`

Do not modify the command or add extra parameters.

特点: 精确指令,不允许偏离。

🌉 类比理解

把 Claude 想象成在不同地形上探索的机器人:

- 悬崖边的窄桥(低自由度): 只有一条安全路径 → 提供详细护栏和精确指令

- 丘陵地带(中等自由度): 几条推荐路径 → 提供地图和指南针

- 无障碍的开阔草地(高自由度): 多条路径都能成功 → 给出大致方向,信任 Claude 找到最佳路线

5.3 渐进式披露模式

模式 1:高层指南 + 引用

结构:

SKILL.md (简要指南)

↓ 引用

[FORMS.md] [REFERENCE.md] [EXAMPLES.md]

示例:

# PDF Processing

## Quick Start

Use pdfplumber to extract text:

\`\`\`python

import pdfplumber

with pdfplumber.open("file.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

## Advanced Features

**Form Filling**: See [FORMS.md](FORMS.md) for complete guide

**API Reference**: See [REFERENCE.md](REFERENCE.md) for all methods

**Examples**: See [EXAMPLES.md](EXAMPLES.md) for common patterns

优势:

- Claude 只在需要时才读取 FORMS.md、REFERENCE.md 或 EXAMPLES.md

- 未使用的文件 = 0 tokens 消耗

模式 2:按领域组织

适用场景: 多领域的 Skills,避免加载无关上下文

结构:

bigquery-skill/

├── SKILL.md # 概述和导航

└── reference/

├── finance.md # 财务指标

├── sales.md # 销售数据

├── product.md # 产品分析

└── marketing.md # 营销活动

示例:

# BigQuery Analytics

## Domain Reference

- **Finance Metrics**: See [reference/finance.md](reference/finance.md)

- **Sales Data**: See [reference/sales.md](reference/sales.md)

- **Product Analytics**: See [reference/product.md](reference/product.md)

- **Marketing Campaigns**: See [reference/marketing.md](reference/marketing.md)

优势:

- 用户询问销售指标时,只读取 sales.md

- finance.md 和其他文件保持在文件系统中,消耗 0 tokens

模式 3:条件细节

# DOCX Processing

## Create Documents

Use docx-js to create new documents. See [DOCX-JS.md](DOCX-JS.md).

## Edit Documents

For simple edits, modify XML directly.

**Track Changes**: See [REDLINING.md](REDLINING.md)

**OOXML Details**: See [OOXML.md](OOXML.md)

优势:

- 常见操作(创建文档)在主文件中

- 高级功能(追踪更改)按需引用

💡 重要: 保持引用层级为一级深度。避免 SKILL.md → advanced.md → details.md 这样的深层嵌套。

5.4 工作流和反馈循环

复杂任务的工作流模式

为多步骤任务提供清晰的检查清单:

## PDF Form Filling Workflow

Copy this checklist and track progress:

\`\`\`

Task Progress:

- [ ] Step 1: Analyze form (run analyze_form.py)

- [ ] Step 2: Create field mapping (edit fields.json)

- [ ] Step 3: Validate mapping (run validate_fields.py)

- [ ] Step 4: Fill form (run fill_form.py)

- [ ] Step 5: Verify output (run verify_output.py)

\`\`\`

**Step 1: Analyze Form**

Run: `python scripts/analyze_form.py input.pdf`

This extracts form fields and their locations, saving to `fields.json`.

**Step 2: Create Field Mapping**

Edit `fields.json` to add values for each field.

**Step 3: Validate Mapping**

Run: `python scripts/validate_fields.py fields.json`

Fix any validation errors before proceeding.

**Step 4: Fill Form**

Run: `python scripts/fill_form.py input.pdf fields.json output.pdf`

**Step 5: Verify Output**

Run: `python scripts/verify_output.py output.pdf`

If validation fails, return to Step 2.

实现反馈循环

常见模式: 运行验证器 → 修复错误 → 重复

这种模式极大提高输出质量。

示例:文档编辑流程

## Document Editing Flow

1. Make edits to `word/document.xml`

2. **Validate immediately**: `python ooxml/scripts/validate.py unpacked_dir/`

3. If validation fails:

- Review error messages carefully

- Fix issues in XML

- Run validation again

4. **Only proceed when validation passes**

5. Repack: `python ooxml/scripts/pack.py unpacked_dir/ output.docx`

6. Test output document

为什么反馈循环重要?

- ✅ 及早发现错误(在应用更改前)

- ✅ 机器可验证(脚本提供客观验证)

- ✅ 可逆计划(Claude 可以迭代而不破坏原始文件)

- ✅ 清晰调试(错误消息指向具体问题)

5.5 内容指南

避免时间敏感信息

❌ 糟糕示例(会过时):

如果你在 2025 年 8 月之前做这件事,使用旧 API。

2025 年 8 月之后,使用新 API。

✅ 好的示例(使用"旧模式"部分):

## Current Method

Use v2 API endpoint: `api.example.com/v2/messages`

## Legacy Patterns

<details>

<summary>Legacy v1 API (deprecated 2025-08)</summary>

v1 API uses: `api.example.com/v1/messages`

This endpoint is no longer supported.

</details>

使用一致的术语

在整个 Skill 中选择一个术语并坚持使用:

✅ 一致性好:

- 始终使用 "API endpoint"

- 始终使用 "field"

- 始终使用 "extract"

❌ 不一致:

- 混用 "API endpoint"、"URL"、"API route"、"path"

- 混用 "field"、"box"、"element"、"control"

- 混用 "extract"、"pull"、"get"、"retrieve"

六、高级技巧

6.1 包含可执行代码的 Skills

解决问题,而非推卸责任

编写 Skills 脚本时,显式处理错误情况,而非推卸给 Claude。

✅ 好的示例:显式处理错误

def process_file(path):

"""处理文件,如果不存在则创建。"""

try:

with open(path) as f:

return f.read()

except FileNotFoundError:

# 创建默认内容而非失败

print(f"文件 {path} 未找到,创建默认文件")

with open(path, 'w') as f:

f.write('')

return ''

except PermissionError:

# 提供替代方案而非失败

print(f"无法访问 {path},使用默认值")

return ''

❌ 糟糕示例:推卸给 Claude

def process_file(path):

# 直接失败,让 Claude 自己想办法

return open(path).read()

提供工具脚本

即使 Claude 可以编写脚本,预制脚本也有优势:

工具脚本的好处:

- 比生成代码更可靠

- 节省 tokens(无需在上下文中包含代码)

- 节省时间(无需代码生成)

- 确保使用的一致性

示例:

## Tool Scripts

**analyze_form.py**: Extract all form fields from PDF

\`\`\`bash

python scripts/analyze_form.py input.pdf > fields.json

\`\`\`

Output format:

\`\`\`json

{

"field_name": {"type": "text", "x": 100, "y": 200},

"signature": {"type": "sig", "x": 150, "y": 500}

}

\`\`\`

**validate_boxes.py**: Check for boundary box overlaps

\`\`\`bash

python scripts/validate_boxes.py fields.json

# Returns: "OK" or lists conflicts

\`\`\`

**fill_form.py**: Apply field values to PDF

\`\`\`bash

python scripts/fill_form.py input.pdf fields.json output.pdf

\`\`\`

💡 重要区分: 在指令中明确说明 Claude 应该:

- 执行脚本(最常见): "运行 analyze_form.py 以提取字段"

- 读取作为参考(用于复杂逻辑): "参见 analyze_form.py 了解字段提取算法"

6.2 创建可验证的中间输出

当 Claude 执行复杂、开放式任务时,可能会出错。"计划-验证-执行"模式通过让 Claude 首先创建结构化格式的计划,然后在执行前用脚本验证该计划,从而及早发现错误。

示例场景

要求: Claude 根据电子表格更新 PDF 中的 50 个表单字段。

没有验证:Claude 可能:

- ❌ 引用不存在的字段

- ❌ 创建冲突的值

- ❌ 遗漏必填字段

- ❌ 错误应用更新

有验证:工作流变为:

分析 → 创建计划文件 → 验证计划 → 执行 → 验证输出

添加一个中间 changes.json 文件,在应用更改前进行验证。

实现示例

## Bulk Form Update Workflow

**Step 1: Analyze**

- Extract current form fields

- Save to `current_fields.json`

**Step 2: Create Change Plan**

- Based on spreadsheet, create `changes.json`:

\`\`\`json

{

"field_updates": [

{"field": "customer_name", "value": "John Doe"},

{"field": "order_total", "value": "1250.00"}

]

}

\`\`\`

**Step 3: Validate Plan**

- Run: `python scripts/validate_changes.py changes.json`

- Script checks:

- All referenced fields exist

- Values are in correct format

- No conflicts

- **Only proceed if validation passes**

**Step 4: Execute**

- Apply changes: `python scripts/apply_changes.py changes.json`

**Step 5: Verify Output**

- Run: `python scripts/verify_output.py output.pdf`

为什么此模式有效

- 及早发现错误: 在应用更改前验证发现问题

- 机器可验证: 脚本提供客观验证

- 可逆计划: Claude 可以在不触及原始文件的情况下迭代计划

- 清晰调试: 错误消息指向具体问题

使用时机

- 批量操作

- 破坏性更改

- 复杂验证规则

- 高风险操作

💡 实现技巧: 让验证脚本输出详细的错误消息:

❌ 模糊: "Validation failed"

✅ 清晰: "Field 'signature_date' not found. Available fields: customer_name, order_total, signature_date_signed"

这帮助 Claude 快速修复问题。

6.3 MCP 工具引用

如果你的 Skill 使用 MCP(Model Context Protocol)工具,始终使用完全限定的工具名称以避免"工具未找到"错误。

格式

ServerName:tool_name

示例

## Query Database Schema

Use the BigQuery:bigquery_schema tool to retrieve table schema.

\`\`\`

Use tool: BigQuery:bigquery_schema

Parameters: {"table": "user_metrics"}

\`\`\`

## Create GitHub Issue

Use the GitHub:create_issue tool to create an issue.

\`\`\`

Use tool: GitHub:create_issue

Parameters: {"title": "Bug report", "body": "Description"}

\`\`\`

说明

BigQuery和GitHub是 MCP 服务器名称bigquery_schema和create_issue是这些服务器中的工具名称

没有服务器前缀,Claude 可能无法找到工具,特别是当有多个 MCP 服务器可用时。

七、常见反模式

❌ 反模式 1:Windows 风格路径

问题:使用反斜杠 \ 作为路径分隔符

❌ 错误:

参见 scripts\helper.py

参见 reference\guide.md

✅ 正确:

参见 scripts/helper.py

参见 reference/guide.md

原因:

- Unix 风格路径跨所有平台工作

- Windows 风格路径在 Unix 系统上会导致错误

❌ 反模式 2:提供太多选项

问题:列出所有可能的方法,让 Claude 困惑

❌ 错误:

你可以使用 pypdf,或 pdfplumber,或 PyMuPDF,或 pdf2image,

或 pikepdf,或 PyPDF2,或 pdfrw,或 pdfminer...

✅ 正确:

使用 pdfplumber 进行文本提取:

\`\`\`python

import pdfplumber

\`\`\`

对于需要 OCR 的扫描 PDF,改用 pdf2image 配合 pytesseract。

原则:

- 提供默认推荐方法

- 只在特殊情况下提供替代方案

- 不要列出所有可能性

❌ 反模式 3:深层嵌套引用

问题:引用链太长,Claude 难以跟踪

❌ 错误:

SKILL.md → advanced.md → details.md → examples.md

✅ 正确:

SKILL.md

↓ 直接引用

[ADVANCED.md] [DETAILS.md] [EXAMPLES.md]

原则:

- 保持从 SKILL.md 的引用为一级深度

- 所有引用文件应直接从 SKILL.md 链接

❌ 反模式 4:过度解释基础概念

问题:解释 Claude 已经知道的内容

❌ 错误:

PDF(Portable Document Format,便携式文档格式)是 Adobe 公司

开发的一种文件格式,可以在不同操作系统上保持一致的显示效果。

PDF 文件包含文本、图像、矢量图形等多种内容类型...

✅ 正确:

使用 pdfplumber 提取 PDF 文本。

原则:

- 假设 Claude 的智能

- 只提供 Claude 不知道的领域特定知识

❌ 反模式 5:第一人称描述

问题:使用"我"、"你"等人称

❌ 错误:

description: I can help you process Excel files and generate reports.

✅ 正确:

description: Process Excel files and generate reports. Use when working with spreadsheets or when the user mentions Excel, CSV, or data analysis.

原因:

- description 被注入系统提示

- 第一人称会导致视角冲突

八、总结与行动

8.1 核心收益

通过 Skills 系统,你可以:

- ⏱️ 节省时间: 不用每次重复说明领域知识

- ✅ 保证质量: 标准化流程,减少错误

- 📚 积累知识: 把最佳实践封装成 Skills,团队共享

- 🚀 提升专业性: 让 Claude 从通用助手进化为领域专家

- 🔧 持续优化: 基于使用反馈不断改进 Skills

8.2 Skills 与其他功能的关系

| 功能 | 作用 | 与 Skills 的关系 |

|---|---|---|

| Agent | 处理复杂、多步骤任务 | Skills 为 Agent 提供领域知识 |

| MCP | 连接外部工具和数据源 | Skills 可以引用 MCP 工具 |

| claude.md | 项目级配置和规范 | Skills 是跨项目的能力扩展 |

| Hook | 事件触发的自动化 | Hook 可以在特定时机加载 Skills |

8.3 实践建议

对于个人开发者:

- 从一个简单的 Skill 开始(如代码审查清单)

- 识别自己反复解释的内容

- 逐步添加更多 Skills

- 持续优化基于实际使用

对于团队:

- 建立团队 Skills 仓库

- 统一 Skills 开发规范

- 定期分享优秀 Skills

- 建立 Skills 评审机制

对于技术 Leader:

- 推广 Skills 使用文化

- 组织 Skills 开发培训

- 激励团队贡献 Skills

- 建立 Skills 质量标准

8.4 未来展望

Skills 系统的发展方向:

- 可视化 Skill Builder: 通过图形界面创建 Skills

- Skill 市场: 官方 Skills 商店,一键安装分享

- AI 生成 Skills: 描述需求,AI 自动生成 Skills

- Skill 编排: 多个 Skills 组合成工作流

- 实时协作: 团队实时共享和更新 Skills

"把你反复向 Claude 解释的偏好、流程、领域知识打包成 Skills,让 AI 成为你的领域专家"

实用资源

🔗 相关文章:

如果这篇文章对你有帮助,欢迎点赞、收藏、分享!有任何问题或建议,欢迎在评论区留言讨论。让我们一起学习,一起成长!

也欢迎访问我的个人主页发现更多宝藏资源

来源:juejin.cn/post/7608382961723555890

OpenClaw安装

前置条件

环境

openclaw需要Node.js 22或者更高版本

笔者在CentOS 7虚拟机上使用源码包安装或者fnm安装Node.js会提示这样那样的错误;

源码包安装会有环境的问题:python、g++版本太老……

用fnm安装后提示

node: /lib64/libstdc++.so.6: version `CXXABI_1.3.11' not found (required by node) node: /lib64/libstdc++.so.6: version `CXXABI_1.3.8' not found (required by node) node: /lib64/libstdc++.so.6: version `GLIBCXX_3.4.20' not found (required by node) node: /lib64/libstdc++.so.6: version `GLIBCXX_3.4.21' not found (required by node) node: /lib64/libstdc++.so.6: version `CXXABI_1.3.9' not found (required by node) node: /lib64/libm.so.6: version `GLIBC_2.27' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.27' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.28' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.25' not found (required by node)

所以在自己的云服务器上搭建了

node安装

nodejs 网站地址可查看LTS版本

官方推荐这三种方式

nvm

官方给出的安装方式

# 下载并安装 nvm:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

# 代替重启 shell

\. "$HOME/.nvm/nvm.sh"

# 下载并安装 Node.js:

nvm install 24

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

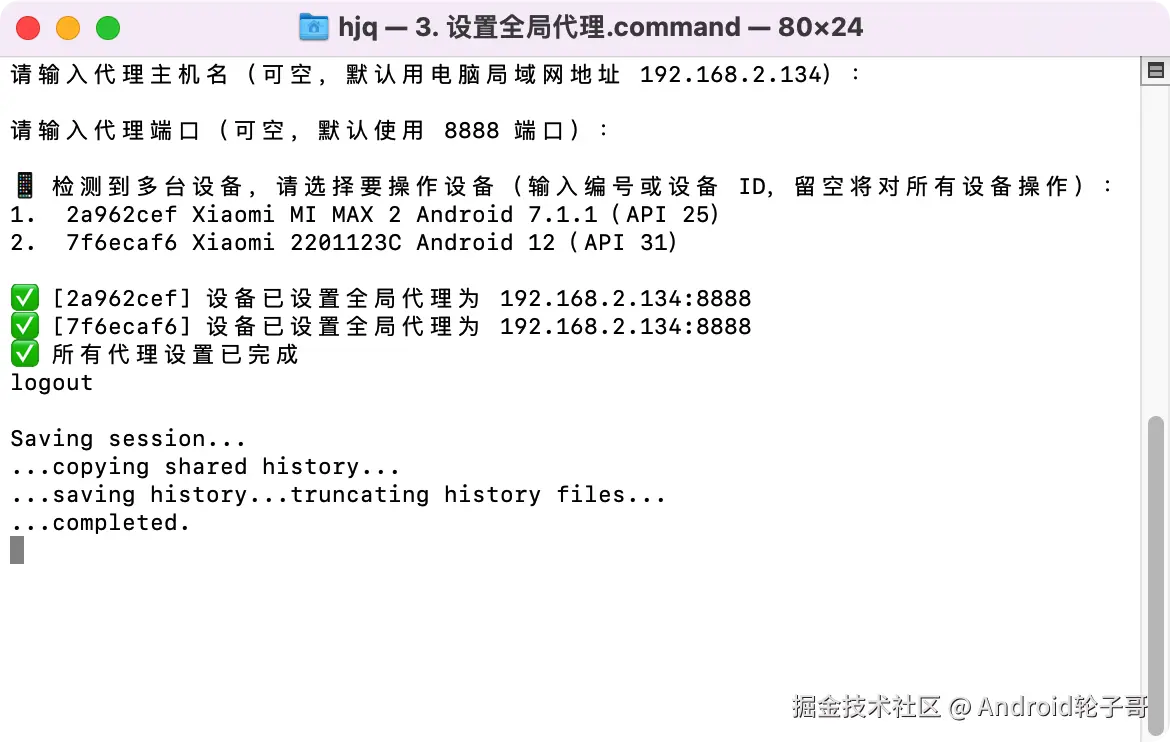

但是这里会提示网络不可达,所以nvm我们采用离线的方式进行安装

解压

配置环境变量

- vi ~/.bashrc

export NVM_DIR="/usr/local/nvm-0.40.4"

[ -s "$NVM_DIR/nvm.sh" ] && \. "$NVM_DIR/nvm.sh" # This loads nvm

[ -s "$NVM_DIR/bash_completion" ] && \. "$NVM_DIR/bash_completion" # This loads nvm bash_completion

# 使其生效

source ~/.bashrc

验证

nvm -v

显示对应的版本号

查看可用的node版本

# 查看可安装的 node 版本

nvm ls-remote

安装对应的版本

# 安装指定版本的 node

nvm install 24.14.0

fnm

官方给出的安装方式

# 下载并安装 fnm:

curl -o- https://fnm.vercel.app/install | bash

# 下载并安装 Node.js:

fnm install 24

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:npm -v # Should print "11.9.0".

但是这里会提示网络不可达,所以fnm我们采用离线的方式进行安装

下载后解压

添加环境变量

- vi /etc/profile

# /usr/local/fnm-1.38.1为fnm解压后的存放位置并不是fnm文件的绝对路径,而是存放位置

export PATH=$PATH:/usr/local/fnm-1.38.1

# 使其生效

source /etc/profile

- vi ~/.bashrc

eval "$(fnm env --use-on-cd --shell bash)"

# 使其生效

source ~/.bashrc

验证

fnm --version

返回对应的版本号

Docker

官方给出的安装方式

# Docker 对每个操作系统都有特定的安装指导。

# 请参考 https://docker.com/get-started/ 给出的官方文档

# 拉取 Node.js Docker 镜像:

docker pull node:24-alpine

# 创建 Node.js 容器并启动一个 Shell 会话:

docker run -it --rm --entrypoint sh node:24-alpine

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

安装docker

非阿里云服务器,需将mirrors.cloud.aliyuncs.com替换为https://mirrors.al…

#添加Docker软件包源

sudo wget -O /etc/yum.repos.d/docker-ce.repo http://mirrors.cloud.aliyuncs.com/docker-ce/linux/centos/docker-ce.repo

# 【非阿里云服务区不需要执行这一步】执行后,该文件中的所有https://mirrors.aliyun.com都会被替换为http://mirrors.cloud.aliyuncs.com

sudo sed -i 's|https://mirrors.aliyun.com|http://mirrors.cloud.aliyuncs.com|g' /etc/yum.repos.d/docker-ce.repo

#安装Docker社区版本,容器运行时containerd.io,以及Docker构建和Compose插件

sudo yum -y install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

配置阿里云加速镜像

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://xxxx.mirror.aliyuncs.com"]

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker

直接拉取镜像由于网络的问题可能导致镜像拉取失败

下载好镜像上传到服务器进行加载

docker load -i node_24-alpine.tar

运行

# 创建 Node.js 容器并启动一个 Shell 会话:

docker run -it --rm --entrypoint sh node:24-alpine

docker run:

- 这是创建并启动一个新容器的命令。

-it:

- 这是两个参数的组合:

-i(interactive): 保持标准输入(STDIN)打开,即使没有附加到容器上。这让你能输入命令。-t(tty): 分配一个伪终端(pseudo-TTY)。这让你拥有一个类似真实终端的交互界面(支持颜色、自动补全等)。

- 作用:合起来就是让你能交互式地在容器里敲命令。

- 这是两个参数的组合:

--rm:

- 自动清理。当容器停止运行(退出)时,Docker 会自动删除这个容器实例及其写入层。

- 作用:防止产生大量“僵尸”容器占用磁盘空间,非常适合临时调试或测试。

--entrypoint sh:

- 覆盖入口点。

- 通常,

node:24-alpine镜像的默认入口点(Entrypoint)是node命令。如果你直接运行docker run node:24-alpine,它会尝试运行node但没有脚本文件,通常会报错或直接退出。 - 这里指定为

sh(Shell),告诉 Docker:“别运行默认的 node 程序,而是运行sh(Shell)”。 - 作用:让你进入容器的命令行环境,以便检查文件系统、安装临时包、测试网络或调试环境问题。

node:24-alpine:

- 这是使用的镜像名称。

node: 官方 Node.js 镜像。24: 指定 Node.js 的版本为 v24(注意:截至2026年2月,Node.js 24 应该是当前的最新稳定版或新版)。alpine: 基于 Alpine Linux 构建。这是一个非常轻量级的 Linux 发行版,因此生成的镜像体积很小(通常只有几十 MB),但里面预装的工具较少(比如没有bash,只有sh,没有curl或wget除非手动安装)。

验证

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

源码包安装

下载后解压

tar -zxaf node-24.14.0.tar.gz

cd node-24.14.0

# 检查依赖并生成 Makefile(可添加自定义参数,如 --prefix=/usr/local/node)

./configure --prefix=/usr/local/node

# 编译(-j4 表示使用 4 核 CPU 加速,根据实际核心数调整)

make -j4

# 安装到系统目录(默认 /usr/local/bin)

make install

问题

- python

./configure --prefix=/usr/local/node/ --python=/usr/local/python_3.14.3/bin/python3.14 Node.js configure: Found Python 3.6.8... Please use python3.14 or python3.13 or python3.12 or python3.11 or python3.10 or python3.9.

- bz2

[root@localhost node-24.14.0]# ./configure --prefix=/usr/local/node Node.js configure: Found Python 3.14.3... Traceback (most recent call last): File "/usr/local/node-24.14.0/./configure", line 28, in <module> import configure File "/usr/local/node-24.14.0/configure.py", line 13, in <module> import bz2 File "/usr/local/python_3.14.3/lib/python3.14/bz2.py", line 17, in <module> from _bz2 import BZ2Compressor, BZ2Decompressor ModuleNotFoundError: No module named '_bz2'

- g++

Node.js configure: Found Python 3.14.3... WARNING: C++ compiler (CXX=g++, 4.8.5) too old, need g++ 12.2.0 or clang++ 8.0.0 WARNING: warnings were emitted in the configure phase INFO: configure completed successfully

个人不太推荐

npm 包管理器安装

npm i -g openclaw

安装完成后

openclaw onboard

访问Dashboard

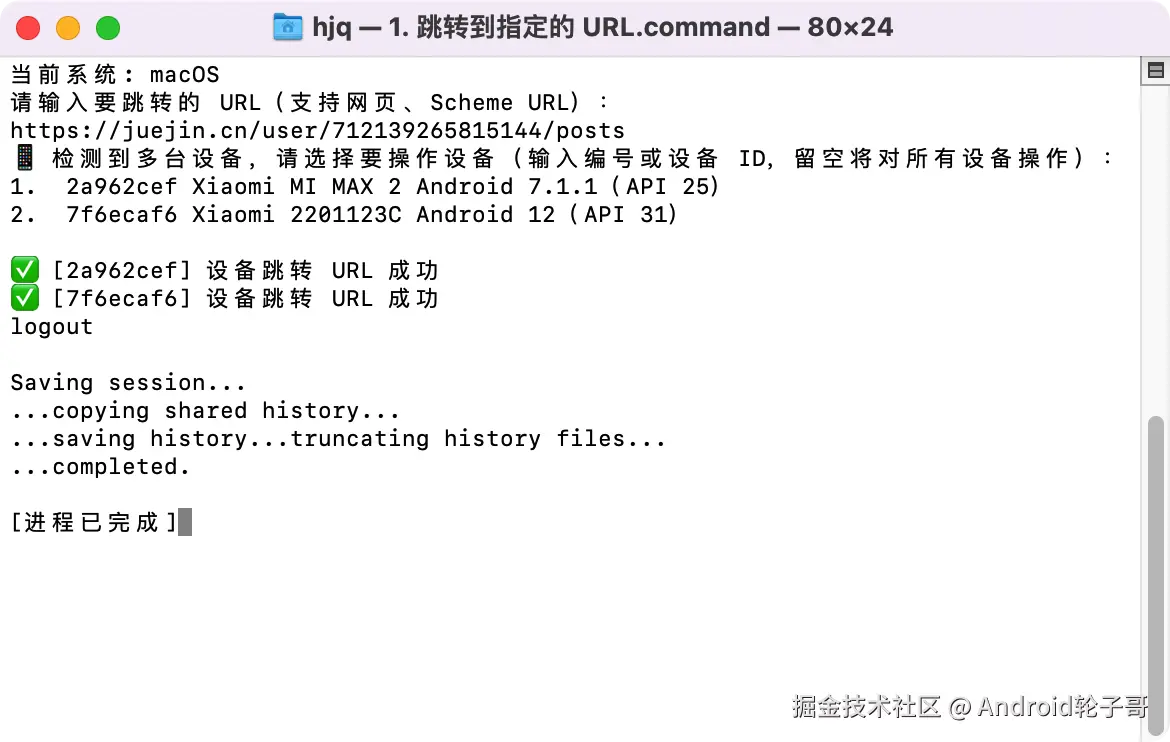

由于程序运行在linux服务器上没有GUI界面所以想要可视化访问需要做一系列的操作

运行 SSH 隧道命令

ssh -N -L 18789:127.0.0.1:18789 root@xx.x.x.xxx

光标在下方就表示隧道建立了

浏览器访问

http://localhost:18789 直接访问会报身份认证失败

http://localhost:18789/#token=c74d1xxxxdccaxxx8bdcxxx 回车即可进入可视化控制台

一键安装

官网安装教程这里不再赘述

源码编译

官网安装教程这里不再赘述

Docker

官网安装教程这里不再赘述

常用命令

- 查看版本

openclaw --version

- 交互式设置向导

openclaw onboard [--install-daemon]

- 启动网关

openclaw gateway [--port 18789]

- 重启网关

openclaw gateway restart

- 健康检查与快速修复

openclaw doctor [--deep]

- 交互式配置

openclaw configure

链接

来源:juejin.cn/post/7610981820638691368

说说 HTTP 和 RPC 的区别是什么?

说说 HTTP 和 RPC 的区别是什么?

2026年02月02日

面试考察点

面试官提出这个问题,主要想考察以下几个层面:

- 对通信方式本质的理解:不仅仅是背诵概念,而是能否清晰地说出 HTTP 和 RPC 在通信模型、协议栈上的根本性差异。

- 序列化与性能的权衡:是否了解它们背后不同的序列化方式(如 JSON/XML vs Protobuf/Hessian)及其对性能、体积和开发效率的影响。

- 设计哲学与适用场景:能否理解它们不同的设计目标(通用 Web 标准 vs 高效内部服务通信),并据此分析各自的适用场景。

- 架构视野:在微服务或分布式系统架构的背景下,能否结合实际,阐述技术选型的思考,体现将理论知识应用于工程实践的能力。

核心答案

HTTP 和 RPC 的核心区别在于:HTTP 是一个通用的、无状态的、应用层的网络协议标准,而 RPC 是一种旨在实现像调用本地方法一样调用远程服务的框架或设计模式。

更直接地说:

- HTTP 是一种协议,定义了客户端与服务器之间通信的通用格式和规则(如 URL、Method、Header、Body),其设计初衷是为了万维网(Web)的超文本传输,现已广泛用于构建 RESTful API。

- RPC 是一种概念/框架,其核心目标是让开发者无感知地调用远程服务。为了实现这个目标,一个完整的 RPC 框架通常会自定义或封装底层通信协议(可能基于 TCP,也可能基于 HTTP) ,并集成高效的二进制序列化、服务发现、负载均衡、熔断降级等分布式服务治理能力。

简言之,你可以 “用 HTTP 协议来实现一种 RPC” (如 gRPC over HTTP/2),但并非所有 RPC 都必须使用 HTTP 协议。

深度解析

原理/机制

- HTTP:基于经典的 请求-响应 (Request-Response) 模型。通常使用文本格式(如 JSON/XML)序列化数据,协议头(Header)庞大且冗余(如 Cookie、Cache-Control 等 Web 特性字段),但其无状态和标准化的特点使其非常适合跨网络、跨语言的开放 API 场景。

- RPC:目标是实现 “透明远程过程调用” 。一个完整的 RPC 调用过程包括:

- 客户端代理(Stub) 将方法名和参数序列化;

- 通过网络传输到服务器;

- 服务端骨架(Skeleton) 反序列化并调用实际方法;

- 将结果序列化返回。其底层通信协议通常追求更高的性能和紧凑性,例如使用自定义的二进制协议。

对比分析

| 维度 | HTTP (以 RESTful API 为例) | RPC (以典型框架如 Dubbo, gRPC 为例) |

|---|---|---|

| 通信协议 | 主要基于应用层的 HTTP/1.1 或 HTTP/2 协议。 | 通常基于传输层的 TCP 自定义二进制协议,或基于 HTTP/2 (如 gRPC)。 |

| 序列化 | 通常使用人类可读的 JSON、XML 等文本格式。序列化/反序列化开销较大。 | 通常使用高效的二进制格式,如 Protobuf、Hessian、Kryo。体积小,速度快。 |

| 性能 | 协议头较大,序列化效率较低,性能开销相对较高。HTTP/2 通过多路复用等特性大幅改善了性能。 | 专为高效内部通信设计,协议精简,序列化高效,性能通常优于 HTTP/1.1。 |

| 连接与交互 | 传统的 HTTP/1.1 是 “一问一答”,多个请求需要多个连接或串行。HTTP/2 支持连接复用和流。 | 通常支持连接复用、异步调用和流式处理,交互模式更灵活高效。 |

| 服务治理 | 需要额外集成组件(如客户端负载均衡器 Ribbon、服务发现 Eureka)来实现完整的治理。 | 框架原生集成了服务发现、负载均衡、熔断、限流等治理能力,开箱即用。 |

| 适用场景 | 对外的开放 API、需要被多种异构客户端(浏览器、移动端、第三方)调用的服务、简单快速的微服务原型。 | 大规模的内部微服务集群、对性能有极高要求的系统、需要复杂服务治理的分布式系统。 |

代码示例

一个简单的感受:调用一个 “获取用户信息” 的服务。

// 使用 HTTP (RestTemplate) 调用

// 开发者需要关注 URL、HTTP 方法、请求体/参数的组装

User user = restTemplate.getForObject("http://user-service/users/123", User.class);

// 使用 RPC (以 Dubbo 接口为例)

// 开发者像调用本地接口一样直接调用,框架隐藏了所有网络细节

@Reference

private UserService userService; // 远程服务的本地代理

public User getUser() {

return userService.getUserById(123L); // 看起来和本地调用无异

}

最佳实践与常见误区

- 最佳实践:

- 内外有别:对公网暴露的 API 优先使用 HTTP (RESTful) ,因其标准、通用、易于调试(用 curl 或浏览器即可)、防火墙友好。内部服务间调用,尤其是性能敏感、调用链路长的场景,优先考虑 RPC 以获得更好的性能和治理能力。

- 不唯技术论:技术选型需权衡团队技术栈、维护成本、生态集成度。Spring Cloud 生态的 OpenFeign(基于 HTTP)在中小规模下,凭借其与 Spring 的无缝集成,开发体验和效率可能优于引入一套独立的 RPC 框架。

- 常见误区:

- 误区一:HTTP 和 RPC 是完全对立的。实际上,gRPC 就是一个完美的反例,它既是强大的 RPC 框架,又使用 HTTP/2 作为传输协议,结合了二者的优势。

- 误区二:HTTP 性能一定差。HTTP/2 在性能上有了质的飞跃(头部压缩、多路复用、服务端推送),使其在不少场景下足以替代传统的 RPC 协议。

- 误区三:RPC 一定比 HTTP 复杂。对于调用方开发者而言,RPC 的接口式编程模型反而更简单直观。复杂性主要转移到了框架的部署和维护上。

总结

HTTP 是通用网络协议,适合构建开放、标准化的 Web API;而 RPC 是远程调用框架模式,旨在为内部服务提供高效、透明、治理完善的调用体验。在现代架构中,二者边界正在模糊(如 gRPC),关键在于根据 “场景”(内外网、性能要求) 和 “生态”(团队、基础设施) 做出最合适的选择。

来源:juejin.cn/post/7601444617695543306

字节2面:为了性能,你会违反数据库三范式吗?

大家好,我是猿java。

数据库的三大范式,它是数据库设计中最基本的三个规范,那么,三大范式是什么?在实际开发中,我们一定要严格遵守三大范式吗?这篇文章,我们一起来聊一聊。

1. 三大范式

1. 第一范式(1NF,确保每列保持原子性)

第一范式要求数据库中的每个表格的每个字段(列)都具有原子性,即字段中的值不可再分割。换句话说,每个字段只能存储一个单一的值,不能包含集合、数组或重复的组。

如下示例: 假设有一个学生表 Student,结构如下:

| 学生ID | 姓名 | 电话号码 |

|---|---|---|

| 1 | 张三 | 123456789, 987654321 |

| 2 | 李四 | 555555555 |

在这个表中,电话号码字段包含多个号码,违反了1NF的原子性要求。为了满足1NF,需要将电话号码拆分为单独的记录或创建一个新的表。

满足 1NF后的设计:

学生表 Student

| 学生ID | 姓名 |

|---|---|

| 1 | 张三 |

| 2 | 李四 |

电话表 Phone

| 电话ID | 学生ID | 电话号码 |

|---|---|---|

| 1 | 1 | 123456789 |

| 2 | 1 | 987654321 |

| 3 | 2 | 555555555 |

1.2 第二范式(2NF,确保表中的每列都和主键相关)

第二范式要求满足第一范式,并且消除表中的部分依赖,即非主键字段必须完全依赖于主键,而不是仅依赖于主键的一部分。这主要适用于复合主键的情况。

如下示例:假设有一个订单详情表 OrderDetail,结构如下:

| 订单ID | 商品ID | 商品名称 | 数量 | 单价 |

|---|---|---|---|---|

| 1001 | A01 | 苹果 | 10 | 2.5 |

| 1001 | A02 | 橙子 | 5 | 3.0 |

| 1002 | A01 | 苹果 | 7 | 2.5 |

在上述表中,主键是复合主键 (订单ID, 商品ID)。商品名称和单价只依赖于复合主键中的商品ID,而不是整个主键,存在部分依赖,违反了2NF。

满足 2NF后的设计:

订单详情表 OrderDetail

| 订单ID | 商品ID | 数量 |

|---|---|---|

| 1001 | A01 | 10 |

| 1001 | A02 | 5 |

| 1002 | A01 | 7 |

商品表 Product

| 商品ID | 商品名称 | 单价 |

|---|---|---|

| A01 | 苹果 | 2.5 |

| A02 | 橙子 | 3.0 |

1.3 第三范式(3NF,确保每列都和主键列直接相关,而不是间接相关)

第三范式要求满足第二范式,并且消除表中的传递依赖,即非主键字段不应依赖于其他非主键字段。换句话说,所有非主键字段必须直接依赖于主键,而不是通过其他非主键字段间接依赖。

如下示例:假设有一个员工表 Employee,结构如下:

| 员工ID | 员工姓名 | 部门ID | 部门名称 |

|---|---|---|---|

| E01 | 王五 | D01 | 销售部 |

| E02 | 赵六 | D02 | 技术部 |

| E03 | 孙七 | D01 | 销售部 |

在这个表中,部门名称依赖于部门ID,而部门ID依赖于主键员工ID,形成了传递依赖,违反了3NF。

满足3NF后的设计:

员工表 Employee

| 员工ID | 员工姓名 | 部门ID |

|---|---|---|

| E01 | 王五 | D01 |

| E02 | 赵六 | D02 |

| E03 | 孙七 | D01 |

部门表 Department

| 部门ID | 部门名称 |

|---|---|

| D01 | 销售部 |

| D02 | 技术部 |

通过将部门信息移到单独的表中,消除了传递依赖,使得数据库结构符合第三范式。

最后,我们总结一下数据库设计的三大范式:

- 第一范式(1NF): 确保每个字段的值都是原子性的,不可再分。

- 第二范式(2NF): 在满足 1NF的基础上,消除部分依赖,确保非主键字段完全依赖于主键。

- 第三范式(3NF): 在满足 2NF的基础上,消除传递依赖,确保非主键字段直接依赖于主键。

2. 破坏三范式

在实际工作中,尽管遵循数据库的三大范式(1NF、2NF、3NF)有助于提高数据的一致性和减少冗余,但在某些情况下,为了满足性能、简化设计或特定业务需求,我们可能需要违反这些范式。

下面列举了一些常见的破坏三范式的原因及对应的示例。

2.1 性能优化

在高并发、大数据量的应用场景中,严格遵循三范式可能导致频繁的联表查询,增加查询时间和系统负载。为了提高查询性能,设计者可能会通过冗余数据来减少联表操作。

假设有一个电商系统,包含订单表 Orders 和用户表 Users。在严格 3NF设计中,订单表只存储 用户ID,需要通过联表查询获取用户的详细信息。

但是,为了查询性能,我们通常会在订单表中冗余存储 用户姓名 和 用户地址等信息,因此,查询订单信息时无需联表查询 Users 表,从而提升查询速度。

破坏 3NF后的设计:

| 订单ID | 用户ID | 用户姓名 | 用户地址 | 订单日期 | 总金额 |

|---|---|---|---|---|---|

| 1001 | U01 | 张三 | 北京市 | 2023-10-01 | 500元 |

| 1002 | U02 | 李四 | 上海市 | 2023-10-02 | 300元 |

2.2 简化查询和开发

严格规范化可能导致数据库结构过于复杂,增加开发和维护的难度,为了简化查询逻辑和减少开发复杂度,我们也可能会选择适当的冗余。

比如,在内容管理系统(CMS)中,文章表 Articles 和分类表 Categories 通常是独立的,如果频繁需要显示文章所属的分类名称,联表查询可能增加复杂性。因此,通过在 Articles 表中直接存储 分类名称,可以简化前端展示逻辑,减少开发工作量。

破坏 3NF后的设计:

| 文章ID | 标题 | 内容 | 分类ID | 分类名称 |

|---|---|---|---|---|

| A01 | 文章一 | … | C01 | 技术 |

| A02 | 文章二 | … | C02 | 生活 |

2.3 报表和数据仓库

在数据仓库和报表系统中,通常需要快速读取和聚合大量数据。为了优化查询性能和数据分析,可能会采用冗余的数据结构,甚至使用星型或雪花型模式,这些模式并不完全符合三范式。

在销售数据仓库中,为了快速生成销售报表,可能会创建一个包含维度信息的事实表。

破坏 3NF后的设计:

| 销售ID | 产品ID | 产品名称 | 类别 | 销售数量 | 销售金额 | 销售日期 |

|---|---|---|---|---|---|---|

| S01 | P01 | 手机 | 电子 | 100 | 50000元 | 2023-10-01 |

| S02 | P02 | 书籍 | 教育 | 200 | 20000元 | 2023-10-02 |

在事实表中直接存储 产品名称 和 类别,避免了需要联表查询维度表,提高了报表生成的效率。

2.4 特殊业务需求

在某些业务场景下,可能需要快速响应特定的查询或操作,这时通过适当的冗余设计可以满足业务需求。

比如,在实时交易系统中,为了快速计算用户的账户余额,可能会在用户表中直接存储当前余额,而不是每次交易时都计算。

破坏 3NF后的设计:

| 用户ID | 用户名 | 当前余额 |

|---|---|---|

| U01 | 王五 | 10000元 |

| U02 | 赵六 | 5000元 |

在交易记录表中存储每笔交易的增减,但直接在用户表中维护 当前余额,避免了每次查询时的复杂计算。

2.5 兼顾读写性能

在某些应用中,读操作远多于写操作。为了优化读性能,可能会通过数据冗余来提升查询速度,而接受在数据写入时需要额外的维护工作。

社交媒体平台中,用户的好友数常被展示在用户主页上。如果每次请求都计算好友数量,效率低下。可以在用户表中维护一个 好友数 字段。

破坏3NF后的设计:

| 用户ID | 用户名 | 好友数 |

|---|---|---|

| U01 | Alice | 150 |

| U02 | Bob | 200 |

通过在 Users 表中冗余存储 好友数,可以快速展示,无需实时计算。

2.6 快速迭代和灵活性

在快速发展的产品或初创企业中,数据库设计可能需要频繁调整。过度规范化可能导致设计不够灵活,影响迭代速度。适当的冗余设计可以提高开发的灵活性和速度。

一个初创电商平台在初期快速上线,数据库设计时为了简化开发,可能会将用户的收货地址直接存储在订单表中,而不是单独创建地址表。

破坏3NF后的设计:

| 订单ID | 用户ID | 用户名 | 收货地址 | 订单日期 | 总金额 |

|---|---|---|---|---|---|

| O1001 | U01 | 李雷 | 北京市海淀区… | 2023-10-01 | 800元 |

| O1002 | U02 | 韩梅梅 | 上海市浦东新区… | 2023-10-02 | 1200元 |

这样设计可以快速上线,后续根据需求再进行规范化和优化。

2.7 降低复杂性和提高可理解性

有时,过度规范化可能使数据库结构变得复杂,难以理解和维护。适度的冗余可以降低设计的复杂性,提高团队对数据库结构的理解和沟通效率。

在一个学校管理系统中,如果将学生的班级信息独立为多个表,可能增加理解难度。为了简化设计,可以在学生表中直接存储班级名称。

破坏3NF后的设计:

| 学生ID | 姓名 | 班级ID | 班级名称 | 班主任 |

|---|---|---|---|---|

| S01 | 张三 | C01 | 三年级一班 | 李老师 |

| S02 | 李四 | C02 | 三年级二班 | 王老师 |

通过在学生表中直接存储 班级名称 和 班主任,减少了表的数量,简化了设计。

3. 总结

本文,我们分析了数据库的三范式以及对应的示例,它是数据库设计的基本规范。但是,在实际工作中,为了满足性能、简化设计、快速迭代或特定业务需求,我们很多时候并不会严格地遵守三范式。

所以说,架构很多时候都是业务需求、数据一致性、系统性能、开发效率等各种因素权衡的结果,我们需要根据具体应用场景做出合理的设计选择。

4. 学习交流

如果你觉得文章有帮助,请帮忙转发给更多的好友,或关注公众号:猿java,持续输出硬核文章。

来源:juejin.cn/post/7455635421529145359

最低成本使用最强模型编程方案

模型是:Codex+Gemini+GLM5+Kimik2.5+MiniMax2.5

先说明一下:这篇只分享我自己长期在用的公开方案,不是广告,也不是“理论推荐”。

核心标准就三个:能稳定用、能真落地、成本尽量低。

另外我现在的原则是:尽量走官方渠道,不再折腾反代。账号和接口都建议按平台规则来。

先说结论:我现在的主力分工

Codex:后端和大部分功能实现主力Gemini + Antigravity:前端和浏览器侧任务主力- 国产免费模型:查资料、国内信息检索、API 调试补位

- 其他工具(如 Cloud Code Opus 4.6):额度见底时兜底

1)第一名:Codex(免费账号可用,但额度偏低)

这个“第一名”我给得很直接:写代码时最稳,尤其后端和复杂功能。

免费账号能用它的模型,但额度确实不高。我的观察是,不同账号之间免费额度会有差异:

- 早期注册的账号,额度通常更高一点

- Google 邮箱注册的账号,额度通常也会稍高

- 其他邮箱注册的部分账号,额度会明显低一些

所以我会准备多个免费账号轮换,但整体还是优先把主链路放在 Codex 上。

2)第二名:Gemini + Antigravity(我现在的前端主力)

Google 这套我最近重新用了起来。之前被封的一批账号后来都解封了,我自己之前的 5 个号也都恢复了。

但现在我不准备再用反代,直接走官方工具 Antigravity。我看中它的点主要是:

- 对 Chrome 控制比较顺手

- 内部集成了

Playwright MCP - Gemini 在前端页面和交互生成上表现不错

所以我现在是:Gemini 负责前端,Codex 负责后端和大多数功能实现。

3)Cloud Code Opus 4.6:有,但不是常用位

Antigravity 里还有 Cloud Code Opus 4.6,我基本只在别的模型额度打满时才会切过去。

原因很简单:给到它的免费用量比较少,放在主流程里不太稳,适合作为兜底。

4)国内白嫖方案:白山智算 + zo computer

这两个是我现在固定会留着的国内补位方案。

白山智算(API 平台)

这个活动期挺给力:实名 + 首次调用后,能拿到 450 左右额度,日常够用。

里面我主要关注的是 GLM-5 和 MiniMax-2.5。

它本身走的是 OpenAI 兼容路由,所以能比较方便接进各种编程工具里,改个接口配置就能跑。

我之前推荐过了,注册链接:白山智算

zo computer(在线使用)

这个相对小众一点,但很省心:注册账号就能用内置免费模型,包含 GLM-5、Kimi-2.5、MiniMax-2.5。

限制也很明确:更适合在线对话和临时任务,不太适合直接塞进 IDE 作为长期开发链路。

官网:zo.computer/

OpenCode:我现在已经没咋用了

以前有 Kimi 相关模型时我还会用一下。现在免费模型能力和覆盖变化后,我基本不再用它做主力。

再加上我有更顺手的 Codex + Gemini 组合,就没有必要在后面的方案上投入太多时间了。

我自己的使用策略(很实用)

- 主开发链路固定:

Codex + Gemini - 国内模型主要用于:资料检索、中文语境信息、API 测试

- 所有“免费”方案都按兜底思路准备,不把单一渠道当唯一依赖

- 不追求模型数量,追求“每天都能稳定出活”

最后

以上 4 个就是我现在公开在用的白嫖 AI 方案。

如果你有更稳、更省钱、还能长期跑的组合,欢迎留言交流。

来源:juejin.cn/post/7611732636969615375

谁是OpenClaw?这个一夜爆火的“AI打工人”,正在悄悄接管你的电脑!

仅仅几个月狂揽 22 万 Star,经历三次改名(Clawdbot -> Moltbot -> OpenClaw)依然热度不减。它不是简单的聊天机器人,而是真正运行在你本地、接管你所有通讯软件(WhatsApp, Telegram, 飞书...)的超级私人管家。本文手把手教你部署这只“全能龙虾”!

Github:github.com/openclaw/op…

最近,GitHub 上有一个项目杀疯了。

如果你关注 AI 圈,一定被一只红色的龙虾(Lobster) 刷屏过。没错,就是 OpenClaw。

截至目前(2026 年 2 月),OpenClaw 在 GitHub 上的 Star 数已经突破了 228k!这是什么概念?即使是当年的爆款项目,也没有如此夸张的增长速度。

它到底是什么?为什么连退隐多年的技术圈大佬 Peter Steinberger(PSPDFKit 创始人)和 Mario Zechner(libGDX 之父)都要复出亲自操刀?

今天,我们就来扒一扒这个“当红炸子鸡”,并手把手教你把它装进电脑里。

什么是 OpenClaw?

简单来说,OpenClaw 是一个运行在你本地设备上的“个人 AI 代理(Agent)中枢” 。

别把它和 ChatGPT 网页版搞混了。OpenClaw 的核心逻辑是: “流水的模型,铁的管家” 。

- 它没有 App(或者说不需要 App): 它直接寄生在你最常用的聊天软件里——WhatsApp、飞书、Slack、Discord、Signal,甚至是 iMessage。

- 它极度聪明: 它不仅能陪聊,还能执行任务。它内置了强大的工具链,可以浏览网页、操作日历、根据你的指令写代码、甚至通过 ElevenLabs 实现语音对话。

- 它绝对隐私: 所有的记忆、配置、对话历史都存储在你本地。你可以自由切换底层模型(Claude Opus, GPT-4, Llama 等),但“管家”本身是你的。

大家之所以疯狂追捧它,是因为它终于实现了我们对“贾维斯”的幻想:一个永远在线、了解你一切背景、并且听命于你的私人助理。

核心特点:为什么它能“爆”?

- 全渠道打通(Omnichannel):

你不需要打开特定的 AI App。在 飞书 给它发消息:“帮我查下明天的天气并把会议发邮件给老板”,它就去做了。它就像是你通讯录里的一个全能好友。

- 本地优先与“记忆”机制:

OpenClaw 拥有基于 Markdown 和 SQLite 的本地记忆系统。它记得你上周说想买的耳机,也记得你老板的忌讳。这些数据不会被上传到云端大厂的服务器。

- 强大的 Agent 能力:

它不只是生成文本,它是来干活的。

- Browsing: 给它一个 URL,它能读完并总结。

- Coding: 它能在本地环境写代码并执行(Sandboxing 机制保障安全)。

- Vision: 它可以“看”屏幕,或者通过摄像头看到你展示的东西。

- 大佬背书与“更名梗”:

OpenClaw 的前身叫 Clawdbot,后来因为名字太像 Claude 被 Anthropic 警告,改名 Moltbot,最后定名 OpenClaw。每一次改名都伴随着一波热度,加上两位“退休”大佬为了它重出江湖,代码质量极高,被誉为“工程学的艺术品”。

如何安装与使用

好消息是,经过几个版本的迭代,现在安装 OpenClaw 已经非常简单了(推荐使用 MacOS 或 Linux/WSL2)。

1. 环境准备

你需要安装 Node.js(版本 ≥ 22)。

2. 一键安装

打开终端(Terminal),输入以下命令:

npm install -g openclaw@latest

# pnpm add -g openclaw@latest

3. 启动向导(Onboarding)

OpenClaw 最人性化的地方就在于它的交互式配置向导。在终端输入:

openclaw onboard --install-daemon

接下来,你只需要像填问卷一样:

- 选择模型服务商: 输入你的 Anthropic Key 或 授权 Qwen 服务。

- 设置连接渠道: 选择你想在哪里使用它(比如 飞书)。向导会提示你下载

openclaw/feishu,下载后按照提示的信息进行配置(比如 登入 open.feishu.cn 平台创建 APP)。 - 安装技能: 选择是否开启浏览器控制、文件系统访问等权限。

- 按照提示配置 Gateway 自启动,打开 web 地址 127.0.0.1:18789,能够正常打开网页说明 OpenClaw 本地安装完成了,对于飞书端的其他配置可以参考文档、参考视频 。

4. 开始使用

现在,拿起你的手机,打开你配置的渠道(例如:飞书),给你刚刚绑定的 Bot 发送一句:

你会发现,一个新的世界大门打开了。

来源:juejin.cn/post/7610580125619093530

写了 10 年 MyBatis,一直以为“去 XML”=写注解,直到看到了这个项目

一直对 MyBatis 有个刻板印象:Mapper 接口负责声明方法,Mapper.xml 负责写 SQL。

改条件就去 XML 里 <if test="">,调参数就切换不同文件,从刚开始学到现在用了很久,熟悉得不能再熟悉。

直到最近看到一个项目:我把 resources/mapper 翻了个底朝天,愣是没找到一份 XML。

我第一反应:

“这项目肯定是全用

@Select之类的注解硬写 SQL 了吧。”

结果打开 Mapper:我人傻了。

1)去 XML:@Select

单表按主键查,注解很舒服:

@Select("select * from tb_user where id = #{id}")UserDO selectById(Long id);

但一旦要动态条件,很多人会写成这种:

@Select("" + "select * from tb_user " + "" + " and name like concat('%', #{name}, '%') " + " and age >= #{age} " + "" + "")List list(UserQuery req);

这么些的体验基本是:

- • 字符串拼接看得眼疼

- • 没有 SQL 高亮、格式化也很难受

- • 复杂一点直接维护灾难

所以绝大多数团队最终都会回到 XML——至少 XML 里写动态 SQL 还能接受。

2)去 XML:@SelectProvider

这个项目里 Mapper 长这样:

@SelectProvider(type = UserSqlProvider.class, method = "selectByCondition")List selectByCondition(UserQuery req);

我当时心里一句话:

“Provider?这是什么东东?”

点进 UserSqlProvider,看到的是这种代码:

public class UserSqlProvider { public String selectByCondition(UserQuery req) { return new SQL() {{ SELECT("id, name, age, status, create_time"); FROM("tb_user"); if (req.getName() != null && !req.getName().isBlank()) { WHERE("name like concat('%', #{name}, '%')"); } if (req.getMinAge() != null) { WHERE("age >= #{minAge}"); } if (req.getStatus() != null) { WHERE("status = #{status}"); } ORDER_BY("create_time desc"); }}.toString(); }}

当时我有点惊讶:

SQL()、SELECT()、WHERE() 这些不是自定义工具类,而是 MyBatis 自带的 SQL Builder。

这类写法的本质是:

- • XML 动态 SQL 的能力不变

- • 但“拼 SQL 的载体”从 XML 变成 Java Provider 方法

- • 最终 MyBatis 仍然执行一段 SQL 字符串(只是这段字符串由 builder 组装出来)

3)Provider

解决了什么?

动态条件 + 可读性。

不用在注解字符串里写 <script>、不用手动拼 AND、也不用在 Java/XML 之间跳来跳去。

再比如:动态排序字段(注意做白名单防注入)

public String list(UserQuery req) { return new SQL() {{ SELECT("*"); FROM("tb_user"); if (req.getName() != null && !req.getName().isBlank()) { WHERE("name like concat('%', #{name}, '%')"); } // 排序字段做白名单,避免 order by 注入 if ("create_time".equals(req.getOrderBy())) { ORDER_BY("create_time desc"); } else if ("age".equals(req.getOrderBy())) { ORDER_BY("age desc"); } else { ORDER_BY("id desc"); } }}.toString();}

未能解决

复杂 SQL 的“表达力”问题。

子查询、复杂 join、窗口函数、CTE……你用 builder 也能写,但写着写着就会变成“在 Java 里造 SQL AST”,维护成本可能并不比 XML 低。

我的建议:

- • 中等复杂度动态查询:Provider 很合适

- • 复杂报表 / 多层嵌套:直接写原生 SQL(放 XML 或统一的 SQL 文件)更直观

4)Provider 最容易踩的坑:参数绑定(90% 的报错在这)

4.1 单参数对象:最舒服

List list(UserQuery req);

Provider 里直接 #{name}、#{minAge},对应 req 的属性名即可。

4.2 多参数一定要 @Param,不然会看到奇怪的参数名

@SelectProvider(type = UserSqlProvider.class, method = "get")UserDO get(@Param("id") Long id, @Param("status") Integer status);

Provider 可以收 Map:

public String get(Map p) { return new SQL() {{ SELECT("*"); FROM("tb_user"); WHERE("id = #{id}"); if (p.get("status") != null) { WHERE("status = #{status}"); } }}.toString();}

如果不写 @Param,参数名可能变成 param1/param2 或 arg0/arg1,然后你就开始“有bug,明明传了值怎么为空”。

5)再懒一下:MyBatis-Plus

如果主要场景是单表 CRUD + 条件筛选,MyBatis-Plus 的思路是:尽量别写 SQL,让 Wrapper 来表达条件。

LambdaQueryWrapper w = Wrappers.lambdaQuery();w.like(StringUtils.isNotBlank(req.getName()), UserDO::getName, req.getName()) .ge(req.getMinAge() != null, UserDO::getAge, req.getMinAge()) .eq(req.getStatus() != null, UserDO::getStatus, req.getStatus()); List list = userMapper.selectList(w);

这套东西的价值很明确:

- • 字段引用是方法引用,改字段/重构更安全

- • 大量单表查询不需要写 SQL

- • 团队统一风格之后,开发效率很高

但边界也很明确:复杂 SQL 仍然要回到原生 SQL(XML/Provider/自定义 mapper 都行),Wrapper 不适合硬扛报表类需求。

6)组装 SQL:MyBatis-Flex

如果连 join 都不想写 SQL,更希望用 Java 结构来表达,MyBatis-Flex 这类框架会提供更强的 QueryWrapper/Join 能力。

简单 join 确实很直观:

QueryWrapper q = QueryWrapper.create() .select(ACCOUNT.ID, ACCOUNT.USER_NAME, ROLE.ROLE_NAME) .from(ACCOUNT) .leftJoin(ROLE).on(ACCOUNT.ROLE_ID.eq(ROLE.ID)) .where(ACCOUNT.AGE.ge(18)); List list = accountMapper.selectListByQueryAs(q, AccountDTO.class);

但当你开始写多层子查询/嵌套条件时,可读性很容易被“对象套对象”拉低。

比如“订单金额 > 用户 1 平均订单金额”这种:

// 子查询QueryWrapper sub = QueryWrapper.create() .select(avg(ORDER.TOTAL_PRICE)) .from(ORDER) .where(ORDER.USER_ID.eq(1)); // 主查询QueryWrapper main = QueryWrapper.create() .select(ORDER.ALL_COLUMNS) .from(ORDER) .where(ORDER.TOTAL_PRICE.gt(sub)); List list = orderMapper.selectListByQuery(main);

能写、也类型更安全,但维护者往往需要在脑子里把它“还原成 SQL”再理解意图。嵌套层级越深,这个成本越高。

7)到底怎么选?

参考落地策略:

- • 固定 SQL / 简单单表:

@Select足够 - • 中等动态 SQL(条件多、拼接多,但逻辑清晰):

@SelectProvider + SQL Builder - • 单表 CRUD 为主,追求少写 SQL:MyBatis-Plus

- • Join 多、希望 Java 化表达更强:MyBatis-Flex(嵌套复杂时要克制)

- • 复杂报表 / 多层子查询 / 强声明式:直接原生 SQL(XML/SQL 文件),通常最清晰

Provider 这条路最让我意外:不靠第三方,也不把动态 SQL 写成字符串炼狱,但它也不是用来替代所有 SQL 的。把边界定好,用起来会更舒服。

总之就是在不同场景下面选择合适的技术并确定合理的规范,然后统一按照规范执行就可以啦!

来源:juejin.cn/post/7603656494904737798

北京回长沙了,简单谈谈感受!

大家好呀,我是飞鱼

我今年已经从北京回长沙了,这里谈谈感受。

❝

首先我回长沙不是逃离,而是换一种更舒服、更可持续的生活方式。

北京给了我视野和能力,长沙给了我生活和归属。

最直观的变化

- 节奏慢了:不用挤早高峰了,走路不用小跑,回家路更短。

- 心态稳了:不再天天赶进度、追KPI,人也没那么紧绷了。

生活成本:压力明显小了

❝

房租、通勤、日常开销都降了不少,以前在北京工资高,但大头都被生活成本吃掉了。

现在收入可能少些,但心里踏实很多。

个人生活:更松弛也更有边界

❝

回来后作息更规律了,能早点睡、早点起,周内也会留出时间运动或散步。

以前下班只想躺着刷手机,现在会给自己留一点空白时间,用来读书、整理思路或者陪家人聊天。

生活变简单,但心里更笃定,能把注意力放在真正重要的人和事上。

城市气息:更有生活感

❝

长沙烟火气足,我现在每周都会去爬一次岳麓山(离得近)。

周末也能随时约上朋友一起吃饭聊天,不用再掐着时间赶路。

个人成长:从外部驱动到自我驱动

❝

以前在北京,节奏和环境会推着我走,事情一件接一件,来不及想太多。

回长沙后,外部推力小了,但我开始主动搭自己的节奏:给自己设目标、做复盘、安排学习计划。

慢下来之后,反而更能看清自己擅长什么、缺什么,也更容易把工作和生活都经营得更稳。

给同样选择的人一点建议

- 先想清楚你想要什么:是离家近、生活压力小,还是职业成长更快?别只因为累了就决定,要有明确的取舍。

- 提前做资源准备:无论去哪,职业发展都得靠自己,技能储备、作品、圈子都要主动经营。

- 规划现金流:收入变化要提前算清楚,别让生活压力反过来影响判断。

- 给自己一个过渡期:回去不是立刻完美适应,给自己几个月调整节奏,别太焦虑。

最后想说

适合自己的地方,不一定是机会最多的地方,而是能让你活得更从容、有力量的地方。

❝

最后想看技术文章的,可以去我的个人网站:hardyfish.top/

来源:juejin.cn/post/7603781883973763091

索引夺命10连问,你能顶住第几问?

前言

今天我们来聊聊让无数开发者又爱又恨的——数据库索引。

相信不少小伙伴在工作中都遇到过这样的场景:

- 明明已经加了索引,为什么查询还是慢?

- 为什么有时候索引反而导致性能下降?

- 联合索引到底该怎么设计才合理?

别急,今天我就通过10个问题,带你彻底搞懂索引的奥秘!

希望对你会有所帮助。

最近准备面试的小伙伴,可以看一下这个宝藏网站(Java突击队):www.susan.net.cn,里面:面试八股文、场景设计题、面试真题、7个项目实战、工作内推什么都有。

一、什么是索引?为什么需要索引?

1.1 索引的本质

简单来说,索引就是数据的目录。

就像一本书的目录能帮你快速找到内容一样,数据库索引能帮你快速定位数据。

-- 没有索引的查询(全表扫描)

SELECT * FROM users WHERE name = '苏三'; -- 需要遍历所有记录

-- 有索引的查询(索引扫描)

CREATE INDEX idx_name ON users(name);

SELECT * FROM users WHERE name = '苏三'; -- 通过索引快速定位

1.2 索引的工作原理

索引的底层结构(B+树):

二、索引的10个常见问题

1.为什么我加了索引,查询还是慢?

场景还原:

CREATE INDEX idx_name ON users(name);

SELECT * FROM users WHERE name LIKE '%苏三%'; -- 还是很慢!

原因分析:

- 前导通配符:

LIKE '%苏三%导致索引失效 - 索引选择性差:如果name字段大量重复,索引效果不佳

- 回表代价高:索引覆盖不全,需要回表查询

解决方案:

-- 方案1:避免前导通配符

SELECT * FROM users WHERE name LIKE '苏三%';

-- 方案2:使用覆盖索引

CREATE INDEX idx_name_covering ON users(name, id, email);

SELECT name, id, email FROM users WHERE name LIKE '苏三%'; -- 不需要回表

-- 方案3:使用全文索引(对于文本搜索)

CREATE FULLTEXT INDEX ft_name ON users(name);

SELECT * FROM users WHERE MATCH(name) AGAINST('苏三');

2.索引是不是越多越好?

绝对不是! 索引需要维护代价:

-- 每个索引都会影响写性能

INSERT INTO users (name, email, age) VALUES ('苏三', 'susan@example.com', 30);

-- 需要更新:

-- 1. 主键索引

-- 2. idx_name索引(如果存在)

-- 3. idx_email索引(如果存在)

-- 4. idx_age索引(如果存在)

索引的代价:

- 存储空间:每个索引都需要额外的磁盘空间

- 写操作变慢:INSERT/UPDATE/DELETE需要维护所有索引

- 优化器负担:索引太多会增加查询优化器的选择难度

黄金法则:一般建议表的索引数量不超过5-7个

3.联合索引的最左前缀原则是什么?

最左前缀原则:联合索引只能从最左边的列开始使用

-- 创建联合索引

CREATE INDEX idx_name_age ON users(name, age);

-- 能使用索引的查询

SELECT * FROM users WHERE name = '苏三'; -- √ 使用索引

SELECT * FROM users WHERE name = '苏三' AND age = 30; -- √ 使用索引

SELECT * FROM users WHERE age = 30 AND name = '苏三'; -- √ 优化器会调整顺序

-- 不能使用索引的查询

SELECT * FROM users WHERE age = 30; -- × 不符合最左前缀

联合索引结构:

4.如何选择索引字段的顺序?

选择原则:

- 高选择性字段在前:选择性高的字段能更快过滤数据

- 经常查询的字段在前:优先满足常用查询场景

- 等值查询在前,范围查询在后

-- 计算字段选择性

SELECT

COUNT(DISTINCT name) / COUNT(*) as name_selectivity,

COUNT(DISTINCT age) / COUNT(*) as age_selectivity,

COUNT(DISTINCT city) / COUNT(*) as city_selectivity

FROM users;

-- 根据选择性决定索引顺序

CREATE INDEX idx_name_city_age ON users(name, city, age); -- name选择性最高

5.什么是覆盖索引?为什么重要?

覆盖索引:索引包含了查询需要的所有字段,不需要回表查询

-- 不是覆盖索引(需要回表)

CREATE INDEX idx_name ON users(name);

SELECT * FROM users WHERE name = '苏三'; -- 需要回表查询其他字段

-- 覆盖索引(不需要回表)

CREATE INDEX idx_name_covering ON users(name, email, age);

SELECT name, email, age FROM users WHERE name = '苏三'; -- 所有字段都在索引中

覆盖索引的优势:

- 避免回表:减少磁盘IO

- 减少内存占用:只需要读取索引页

- 提升性能:查询速度更快

6.NULL值对索引有什么影响?

NULL值的问题:

-- 创建索引

CREATE INDEX idx_email ON users(email);

-- 查询NULL值

SELECT * FROM users WHERE email IS NULL; -- 可能不使用索引

SELECT * FROM users WHERE email IS NOT NULL; -- 可能不使用索引

NULL值可能不使用索引。

解决方案:

- 避免NULL值:设置默认值

- 使用函数索引(MySQL 8.0+)

-- 使用函数索引处理NULL值

CREATE INDEX idx_email_null ON users((COALESCE(email, '')));

SELECT * FROM users WHERE COALESCE(email, '') = '';

7.索引对排序和分组有什么影响?

索引优化排序和分组:

-- 创建索引

CREATE INDEX idx_age_name ON users(age, name);

-- 索引优化排序

SELECT * FROM users ORDER BY age, name; -- √ 使用索引避免排序

-- 索引优化分组

SELECT age, COUNT(*) FROM users GR0UP BY age; -- √ 使用索引优化分组

-- 无法使用索引排序的情况

SELECT * FROM users ORDER BY name, age; -- × 不符合最左前缀

SELECT * FROM users ORDER BY age DESC, name ASC; -- × 排序方向不一致

最近为了帮助大家找工作,专门建了一些工作内推群,各大城市都有,欢迎各位HR和找工作的小伙伴进群交流,群里目前已经收集了不少的工作内推岗位。加苏三的微信:li_su223,备注:掘金+所在城市,即可进群。

8.如何发现索引失效的场景?

常见索引失效场景:

- 函数操作:

WHERE YEAR(create_time) = 2023 - 类型转换:

WHERE phone = 13800138000(phone是varchar) - 数学运算:

WHERE age + 1 > 30 - 前导通配符:

WHERE name LIKE '%苏三'

使用EXPLAIN分析:

EXPLAIN SELECT * FROM users WHERE name = '苏三';

-- 查看关键指标:

-- type: const|ref|range|index|ALL(性能从好到坏)

-- key: 实际使用的索引

-- rows: 预估扫描行数

-- Extra: Using index(覆盖索引)| Using filesort(需要排序)| Using temporary(需要临时表)

9.如何维护和优化索引?

定期索引维护:

-- 查看索引使用情况(MySQL)

SELECT * FROM sys.schema_index_statistics

WHERE table_schema = 'your_database' AND table_name = 'users';

-- 重建索引(优化索引碎片)

ALTER TABLE users REBUILD INDEX idx_name;

-- 分析索引使用情况

ANALYZE TABLE users;

索引监控:

-- 开启索引监控(Oracle)

ALTER INDEX idx_name MONITORING USAGE;

-- 查看索引使用情况

SELECT * FROM v$object_usage WHERE index_name = 'IDX_NAME';

10.不同数据库的索引有什么差异?

MySQL vs PostgreSQL索引差异:

| 特性 | MySQL | PostgreSQL |

|---|---|---|

| 索引类型 | B+Tree, Hash, Fulltext | B+Tree, Hash, GiST, SP-GiST |

| 覆盖索引 | 支持 | 支持(使用INCLUDE) |

| 函数索引 | 8.0+支持 | 支持 |

| 部分索引 | 支持 | 支持 |

| 索引组织表 | 聚簇索引 | 堆表 |

PostgreSQL示例:

-- 创建包含索引(Covering Index)

CREATE INDEX idx_users_covering ON users (name) INCLUDE (email, age);

-- 创建部分索引(Partial Index)

CREATE INDEX idx_active_users ON users (name) WHERE is_active = true;

-- 创建表达式索引(Expression Index)

CREATE INDEX idx_name_lower ON users (LOWER(name));

三、索引设计最佳实践

3.1 索引设计原则

- 按需创建:只为经常查询的字段创建索引

- 选择合适类型:根据场景选择B-Tree、Hash、全文索引等

- 考虑复合索引:使用复合索引减少索引数量

- 避免过度索引:每个索引都有维护成本

- 定期维护:重建索引,优化索引碎片

3.2 索引设计检查清单

四、实战案例:电商系统索引设计

4.1 用户表索引设计

-- 用户表结构

CREATE TABLE users (

id BIGINT PRIMARY KEY,

username VARCHAR(50) NOT NULL,

email VARCHAR(100) NOT NULL,

phone VARCHAR(20),

age INT,

city VARCHAR(50),

created_at TIMESTAMP,

is_active BOOLEAN

);

-- 推荐索引

CREATE INDEX idx_users_username ON users(username);

CREATE INDEX idx_users_email ON users(email);

CREATE INDEX idx_users_city_age ON users(city, age);

CREATE INDEX idx_users_created ON users(created_at) WHERE is_active = true;

4.2 订单表索引设计

-- 订单表结构

CREATE TABLE orders (

id BIGINT PRIMARY KEY,

user_id BIGINT,

status VARCHAR(20),

amount DECIMAL(10,2),

created_at TIMESTAMP,

updated_at TIMESTAMP

);

-- 推荐索引

CREATE INDEX idx_orders_user_id ON orders(user_id);

CREATE INDEX idx_orders_status_created ON orders(status, created_at);

CREATE INDEX idx_orders_created_amount ON orders(created_at, amount);

总结

- 理解原理:掌握B+树索引的工作原理和特性。

- 合理设计:遵循最左前缀原则,选择合适的索引顺序。

- 避免失效:注意索引失效的常见场景。

- 覆盖索引:尽可能使用覆盖索引减少回表。

- 定期维护:监控索引使用情况,定期优化重建。

- 权衡利弊:索引不是越多越好,要权衡查询性能和写成本。

好的索引设计是数据库性能的基石。

不要盲目添加索引,要基于实际查询需求和数据分布来科学设计。

最后说一句(求关注,别白嫖我)

如果这篇文章对您有所帮助,或者有所启发的话,帮忙关注一下我的同名公众号:苏三说技术,您的支持是我坚持写作最大的动力。

求一键三连:点赞、转发、在看。

关注公众号:【苏三说技术】,在公众号中回复:进大厂,可以免费获取我最近整理的10万字的面试宝典,好多小伙伴靠这个宝典拿到了多家大厂的offer。

来源:juejin.cn/post/7578402574652850228

CSS 也要支持 if 了 !!!CSS if() 函数来了!

CSS 也要支持 if 了 !!!CSS if() 函数来了!

CSS if() 函数允许在纯 CSS 中基于条件为属性赋值,无需 JavaScript 或预处理器。该函数已在 Chrome 137 发布。

过去常用的做法包括通过 JavaScript 切换类名、使用预处理器 mixin 或编写大量媒体查询。if() 将条件逻辑引入 CSS,使写法更直接、性能稳定。

原文 CSS 也要支持 if 了 !!!CSS if() 函数来了!

工作原理

property: if(condition-1: value-1; condition-2: value-2; condition-3: value-3; else: default-value);

函数按顺序检查条件并应用第一个匹配的值;若没有条件匹配,则使用 else 的值。这一语义与常见编程语言一致,但实现于纯 CSS。

if() 的三种能力

样式查询(Style queries)

使用 style() 可响应 CSS 自定义属性:

.card {

--status: attr(data-status type(<custom-ident>));

border-color: if(style(--status: pending): royalblue; style(--status: complete): seagreen; style(--status: error): crimson; else: gray);

}

一个 data-status 属性即可驱动对应样式,无需额外工具类。

媒体查询(Media queries)

使用 media() 可以在属性内联定义响应式值,无需嵌套媒体查询块:

h1 {

font-size: if(media(width >= 1200px): 3rem; media(width >= 768px): 2.5rem; media(width >= 480px): 2rem; else: 1.75rem);

}

特性检测(Feature detection)

使用 supports() 可在属性中直接进行特性检测,并提供明确回退:

.element {

border-color: if(supports(color: lch(0 0 0)): lch(50% 100 150) ; supports(color: lab(0 0 0)): lab(50 100 -50) ; else: rgb(200, 100, 50));

}

真实用例

暗色模式示例

body {

--theme: 'dark'; /* 通过 JavaScript 或用户偏好切换 */

background: if(style(--theme: 'dark'): #1a1a1a; else: white);

color: if(style(--theme: 'dark'): #e4e4e4; else: #333);

}

设计系统状态组件

.alert {

--type: attr(data-type type(<custom-ident>));

background: if(style(--type: success): #d4edda; style(--type: warning): #fff3cd; style(--type: danger): #f8d7da; style(--type: info): #d1ecf1; else: #f8f9fa);

border-left: 4px solid if(style(--type: success): #28a745; style(--type: warning): #ffc107; style(--type: danger): #dc3545; style(--type: info): #17a2b8; else: #6c757d);

}

容器尺寸示例(简化媒体查询)

.container {

width: if(media(width >= 1400px): 1320px; media(width >= 1200px): 1140px; media(width >= 992px): 960px; media(width >= 768px): 720px; media(width >= 576px): 540px; else: 100%);

padding-inline: if(media(width >= 768px): 2rem; else: 1rem);

}

与现代 CSS 特性结合

.element {

/* 搭配新的 light-dark() 函数 */

color: if(style(--high-contrast: true): black; else: light-dark(#333, #e4e4e4));

/* 搭配 CSS 自定义函数(@function) */

padding: if(style(--spacing: loose): --spacing-function(2) ; style(--spacing: tight): --spacing-function(0.5) ; else: --spacing-function(1));

}

浏览器支持

支持情况(截至 2025 年 8 月):

- ✅ Chrome/Edge:自 137 版起

- ✅ Chrome Android:自 139 版起

- ❌ Firefox:开发中

- ❌ Safari:在规划中

- ❌ Opera:尚未支持

在尚未完全支持的环境中,可采用如下写法:

.button {

/* 所有浏览器的回退 */

padding: 1rem 2rem;

background: #007bff;

/* 现代浏览器会自动覆盖 */

padding: if(style(--size: small): 0.5rem 1rem; style(--size: large): 1.5rem 3rem; else: 1rem 2rem);

background: if(style(--variant: primary): #007bff; style(--variant: success): #28a745; style(--variant: danger): #dc3545; else: #6c757d);

}

未来展望

CSS 工作组已经在推进扩展能力:

- 范围查询:

if(style(--value > 100): ...) - 逻辑运算符:

if(style(--a: true) and style(--b: false): ...) - 容器查询集成:更强的上下文感知

在使用前建议评估目标浏览器版本,并准备相应回退方案。

来源:juejin.cn/post/7571758212472897587

公司来的新人用字符串存储日期,被组长怒怼了...

在日常的软件开发工作中,存储时间是一项基础且常见的需求。无论是记录数据的操作时间、金融交易的发生时间,还是行程的出发时间、用户的下单时间等等,时间信息与我们的业务逻辑和系统功能紧密相关。因此,正确选择和使用 MySQL 的日期时间类型至关重要,其恰当与否甚至可能对业务的准确性和系统的稳定性产生显著影响。

本文旨在帮助开发者重新审视并深入理解 MySQL 中不同的时间存储方式,以便做出更合适项目业务场景的选择。

不要用字符串存储日期

和许多数据库初学者一样,笔者在早期学习阶段也曾尝试使用字符串(如 VARCHAR)类型来存储日期和时间,甚至一度认为这是一种简单直观的方法。毕竟,'YYYY-MM-DD HH:MM:SS' 这样的格式看起来清晰易懂。

但是,这是不正确的做法,主要会有下面两个问题:

- 空间效率:与 MySQL 内建的日期时间类型相比,字符串通常需要占用更多的存储空间来表示相同的时间信息。

- 查询与计算效率低下:

- 比较操作复杂且低效:基于字符串的日期比较需要按照字典序逐字符进行,这不仅不直观(例如,'2024-05-01' 会小于 '2024-1-10'),而且效率远低于使用原生日期时间类型进行的数值或时间点比较。

- 计算功能受限:无法直接利用数据库提供的丰富日期时间函数进行运算(例如,计算两个日期之间的间隔、对日期进行加减操作等),需要先转换格式,增加了复杂性。

- 索引性能不佳:基于字符串的索引在处理范围查询(如查找特定时间段内的数据)时,其效率和灵活性通常不如原生日期时间类型的索引。

DATETIME 和 TIMESTAMP 选择

DATETIME 和 TIMESTAMP 是 MySQL 中两种非常常用的、用于存储包含日期和时间信息的数据类型。它们都可以存储精确到秒(MySQL 5.6.4+ 支持更高精度的小数秒)的时间值。那么,在实际应用中,我们应该如何在这两者之间做出选择呢?

下面我们从几个关键维度对它们进行对比:

时区信息

DATETIME 类型存储的是字面量的日期和时间值,它本身不包含任何时区信息。当你插入一个 DATETIME 值时,MySQL 存储的就是你提供的那个确切的时间,不会进行任何时区转换。

这样就会有什么问题呢? 如果你的应用需要支持多个时区,或者服务器、客户端的时区可能发生变化,那么使用 DATETIME 时,应用程序需要自行处理时区的转换和解释。如果处理不当(例如,假设所有存储的时间都属于同一个时区,但实际环境变化了),可能会导致时间显示或计算上的混乱。

TIMESTAMP 和时区有关。存储时,MySQL 会将当前会话时区下的时间值转换成 UTC(协调世界时)进行内部存储。当查询 TIMESTAMP 字段时,MySQL 又会将存储的 UTC 时间转换回当前会话所设置的时区来显示。

这意味着,对于同一条记录的 TIMESTAMP 字段,在不同的会话时区设置下查询,可能会看到不同的本地时间表示,但它们都对应着同一个绝对时间点(UTC 时间)。这对于需要全球化、多时区支持的应用来说非常有用。

下面实际演示一下!

建表 SQL 语句:

CREATE TABLE `time_zone_test` (

`id` bigint(20) NOT NULL AUTO_INCREMENT,

`date_time` datetime DEFAULT NULL,

`time_stamp` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

插入一条数据(假设当前会话时区为系统默认,例如 UTC+0)::

INSERT INTO time_zone_test(date_time,time_stamp) VALUES(NOW(),NOW());

查询数据(在同一时区会话下):

SELECT date_time, time_stamp FROM time_zone_test;

结果:

+---------------------+---------------------+

| date_time | time_stamp |

+---------------------+---------------------+

| 2020-01-11 09:53:32 | 2020-01-11 09:53:32 |

+---------------------+---------------------+

现在,修改当前会话的时区为东八区 (UTC+8):

SET time_zone = '+8:00';

再次查询数据:

# TIMESTAMP 的值自动转换为 UTC+8 时间

+---------------------+---------------------+

| date_time | time_stamp |

+---------------------+---------------------+

| 2020-01-11 09:53:32 | 2020-01-11 17:53:32 |

+---------------------+---------------------+

扩展:MySQL 时区设置常用 SQL 命令

# 查看当前会话时区

SELECT @@session.time_zone;

# 设置当前会话时区

SET time_zone = 'Europe/Helsinki';

SET time_zone = "+00:00";

# 数据库全局时区设置

SELECT @@global.time_zone;

# 设置全局时区

SET GLOBAL time_zone = '+8:00';

SET GLOBAL time_zone = 'Europe/Helsinki';

占用空间

下图是 MySQL 日期类型所占的存储空间(官方文档传送门:dev.mysql.com/doc/refman/…):

在 MySQL 5.6.4 之前,DateTime 和 TIMESTAMP 的存储空间是固定的,分别为 8 字节和 4 字节。但是从 MySQL 5.6.4 开始,它们的存储空间会根据毫秒精度的不同而变化,DateTime 的范围是 58 字节,TIMESTAMP 的范围是 47 字节。

表示范围

TIMESTAMP 表示的时间范围更小,只能到 2038 年:

DATETIME:'1000-01-01 00:00:00.000000' 到 '9999-12-31 23:59:59.999999'TIMESTAMP:'1970-01-01 00:00:01.000000' UTC 到 '2038-01-19 03:14:07.999999' UTC

性能

由于 TIMESTAMP 在存储和检索时需要进行 UTC 与当前会话时区的转换,这个过程可能涉及到额外的计算开销,尤其是在需要调用操作系统底层接口获取或处理时区信息时。虽然现代数据库和操作系统对此进行了优化,但在某些极端高并发或对延迟极其敏感的场景下,DATETIME 因其不涉及时区转换,处理逻辑相对更简单直接,可能会表现出微弱的性能优势。

为了获得可预测的行为并可能减少 TIMESTAMP 的转换开销,推荐的做法是在应用程序层面统一管理时区,或者在数据库连接/会话级别显式设置 time_zone 参数,而不是依赖服务器的默认或操作系统时区。

数值时间戳是更好的选择吗?

除了上述两种类型,实践中也常用整数类型(INT 或 BIGINT)来存储所谓的“Unix 时间戳”(即从 1970 年 1 月 1 日 00:00:00 UTC 起至目标时间的总秒数,或毫秒数)。

这种存储方式的具有 TIMESTAMP 类型的所具有一些优点,并且使用它的进行日期排序以及对比等操作的效率会更高,跨系统也很方便,毕竟只是存放的数值。缺点也很明显,就是数据的可读性太差了,你无法直观的看到具体时间。

时间戳的定义如下:

时间戳的定义是从一个基准时间开始算起,这个基准时间是「1970-1-1 00:00:00 +0:00」,从这个时间开始,用整数表示,以秒计时,随着时间的流逝这个时间整数不断增加。这样一来,我只需要一个数值,就可以完美地表示时间了,而且这个数值是一个绝对数值,即无论的身处地球的任何角落,这个表示时间的时间戳,都是一样的,生成的数值都是一样的,并且没有时区的概念,所以在系统的中时间的传输中,都不需要进行额外的转换了,只有在显示给用户的时候,才转换为字符串格式的本地时间。

数据库中实际操作:

-- 将日期时间字符串转换为 Unix 时间戳 (秒)

mysql> SELECT UNIX_TIMESTAMP('2020-01-11 09:53:32');

+---------------------------------------+

| UNIX_TIMESTAMP('2020-01-11 09:53:32') |

+---------------------------------------+

| 1578707612 |

+---------------------------------------+

1 row in set (0.00 sec)

-- 将 Unix 时间戳 (秒) 转换为日期时间格式

mysql> SELECT FROM_UNIXTIME(1578707612);

+---------------------------+

| FROM_UNIXTIME(1578707612) |

+---------------------------+

| 2020-01-11 09:53:32 |

+---------------------------+

1 row in set (0.01 sec)

PostgreSQL 中没有 DATETIME

由于有读者提到 PostgreSQL(PG) 的时间类型,因此这里拓展补充一下。PG 官方文档对时间类型的描述地址:http://www.postgresql.org/docs/curren…。

可以看到,PG 没有名为 DATETIME 的类型:

- PG 的

TIMESTAMP WITHOUT TIME ZONE在功能上最接近 MySQL 的DATETIME。它存储日期和时间,但不包含任何时区信息,存储的是字面值。 - PG 的

TIMESTAMP WITH TIME ZONE(或TIMESTAMPTZ) 相当于 MySQL 的TIMESTAMP。它在存储时会将输入值转换为 UTC,并在检索时根据当前会话的时区进行转换显示。

对于绝大多数需要记录精确发生时间点的应用场景,TIMESTAMPTZ是 PostgreSQL 中最推荐、最健壮的选择,因为它能最好地处理时区复杂性。

总结

MySQL 中时间到底怎么存储才好?DATETIME?TIMESTAMP?还是数值时间戳?

并没有一个银弹,很多程序员会觉得数值型时间戳是真的好,效率又高还各种兼容,但是很多人又觉得它表现的不够直观。

《高性能 MySQL 》这本神书的作者就是推荐 TIMESTAMP,原因是数值表示时间不够直观。下面是原文:

每种方式都有各自的优势,根据实际场景选择最合适的才是王道。下面再对这三种方式做一个简单的对比,以供大家实际开发中选择正确的存放时间的数据类型:

| 类型 | 存储空间 | 日期格式 | 日期范围 | 是否带时区信息 |

|---|---|---|---|---|

| DATETIME | 5~8 字节 | YYYY-MM-DD hh:mm:ss[.fraction] | 1000-01-01 00:00:00[.000000] ~ 9999-12-31 23:59:59[.999999] | 否 |

| TIMESTAMP | 4~7 字节 | YYYY-MM-DD hh:mm:ss[.fraction] | 1970-01-01 00:00:01[.000000] ~ 2038-01-19 03:14:07[.999999] | 是 |

| 数值型时间戳 | 4 字节 | 全数字如 1578707612 | 1970-01-01 00:00:01 之后的时间 | 否 |

选择建议小结:

TIMESTAMP的核心优势在于其内建的时区处理能力。数据库负责 UTC 存储和基于会话时区的自动转换,简化了需要处理多时区应用的开发。如果应用需要处理多时区,或者希望数据库能自动管理时区转换,TIMESTAMP是自然的选择(注意其时间范围限制,也就是 2038 年问题)。- 如果应用场景不涉及时区转换,或者希望应用程序完全控制时区逻辑,并且需要表示 2038 年之后的时间,

DATETIME是更稳妥的选择。 - 如果极度关注比较性能,或者需要频繁跨系统传递时间数据,并且可以接受可读性的牺牲(或总是在应用层转换),数值时间戳是一个强大的选项。

来源:juejin.cn/post/7488927722774937609

这 10 个 MySQL 高级用法,让你的代码又快又好看

大家好,我是大华!

MySQL 有很多高级但实用的功能,能让你的查询变得更简洁、更高效。

今天分享 10 个我在工作中经常使用的 SQL 技巧,不用死记硬背,掌握了就能立刻提升你的数据库操作水平!

1. CTE(WITH 子句)——让复杂查询变清晰

-- 传统子查询,难以阅读

SELECT nickname

FROM system_users

WHERE dept_id IN (

SELECT id FROM system_dept WHERE `name` = 'IT部'

);

-- 使用CTE,逻辑清晰

WITH ny_depts AS (

SELECT id FROM system_dept WHERE `name` = 'IT部'

)

SELECT u.nickname

FROM system_users u

JOIN ny_depts nd ON u.dept_id = nd.id;

解释:

WITH ny_depts AS (...):先创建一个临时结果集,叫ny_depts,里面只包含“IT部”的部门名称。SELECT u.nickname FROM system_users u JOIN ny_depts...:再从用户表中找出那些部门ID在ny_depts里的员工昵称。

好处:把找部门和找人分成两步,逻辑更清楚,比嵌套子查询好读多了。

2. 窗口函数 —— 不分组也能统计

SELECT

name,

department,

salary,

RANK() OVER (PARTITION BY department ORDER BY salary DESC) AS rank_in_dept,

AVG(salary) OVER (PARTITION BY department) AS avg_salary

FROM employees;

解释:

PARTITION BY department:按部门“分组”,但不合并行,每行仍然保留。RANK() OVER (...):在每个部门内部,按薪水从高到低排名(相同薪水并列)。AVG(salary) OVER (...):计算每个部门的平均工资,并显示在每一行里。

对比 GR0UP BY:GR0UP BY 会把多行合并成一行,而窗口函数保留原始行,同时加上统计值。

3. 条件聚合 —— 一行查出多个统计

SELECT

YEAR(created_at) AS year,

COUNT(*) AS total,

COUNT(CASE WHEN status = 'completed' THEN 1 END) AS completed,

SUM(CASE WHEN status = 'completed' THEN amount ELSE 0 END) AS revenue

FROM orders

GR0UP BY YEAR(created_at);

解释:

YEAR(created_at):提取订单年份。COUNT(*):该年总订单数。COUNT(CASE WHEN status = 'completed' THEN 1 END):

如果状态是'completed',就返回1,否则返回NULL;COUNT()只统计非NULL值,所以这行就是“完成的订单数”。SUM(CASE WHEN ... THEN amount ELSE 0 END):只对完成的订单求金额总和。

关键:不用写多个子查询,一条语句搞定全年报表!

4. 自连接 —— 同一张表自己连自己

SELECT e1.name, e2.name

FROM employees e1

JOIN employees e2

ON e1.department = e2.department

AND e1.id < e2.id

AND ABS(e1.salary - e2.salary) <= e1.salary * 0.1;

解释:

employees e1 JOIN employees e2:把员工表当成两个副本(e1 和 e2)来连接。e1.department = e2.department:只找同一个部门的人。e1.id < e2.id:避免重复配对(比如 Alice-Bob 和 Bob-Alice 只保留一个)。ABS(...):计算两人薪水差是否 ≤ 10%。

用途:找“相似记录”“配对关系”“上下级”等场景非常有用。

5. EXISTS 替代 IN —— 更高效的存在判断

SELECT name FROM customers c

WHERE EXISTS (

SELECT 1 FROM orders o

WHERE o.customer_id = c.id AND o.amount > 1000

);

解释:

- 对每一位客户

c,检查是否存在一笔订单满足:

- 订单的

customer_id等于这个客户的id - 订单金额 > 1000

- 订单的

SELECT 1:这里不需要返回具体字段,只要知道“有没有”就行,所以用1最轻量。- 为什么快?:一旦找到一条匹配订单,就立刻停止搜索,不像

IN可能要加载全部订单 ID。

注意:如果子查询可能返回 NULL,IN 会失效(因为 x IN (..., NULL) 永远为 UNKNOWN),而 EXISTS 不受影响。

6. JSON 函数 —— 轻松读取 JSON 字段

SELECT

name,

profile->>'$.address.city' AS city,

JSON_EXTRACT(profile, '$.age') AS age

FROM users

WHERE profile->>'$.city' = 'Beijing';

解释:

profile是一个 JSON 类型字段,比如:{"address": {"city": "Beijing"}, "age": 30}profile->>'$.address.city':

->>是简写,等价于JSON_UNQUOTE(JSON_EXTRACT(...))- 返回字符串

"Beijing"(去掉引号)

JSON_EXTRACT(profile, '$.age'):返回30(带类型,可能是数字)WHERE profile->>'$.city' = 'Beijing':筛选城市是北京的用户。

适用场景:用户偏好、动态表单、日志等结构不固定的字段。

7. 生成列 —— 数据库自动帮你算

CREATE TABLE products (

id INT PRIMARY KEY,

width DECIMAL(10,2),

height DECIMAL(10,2),

area DECIMAL(10,2) AS (width * height) STORED

);

INSERT INTO products (id, width, height) VALUES (1, 5, 10);

解释:

area DECIMAL(...) AS (width * height) STORED:

- 这是一个“存储型生成列”,数据库会自动计算

width * height并存下来。 - 如果不加

STORED,就是“虚拟列”(每次查询时计算,不占存储)。

- 这是一个“存储型生成列”,数据库会自动计算

- 插入时只需给

width和height,area自动变成50。

优势:避免应用层重复计算,还能给 area 加索引加速查询!

8. 多表更新 —— 一条语句更新关联数据

UPDATE customers c

JOIN (

SELECT customer_id, SUM(amount) AS total

FROM orders

GR0UP BY customer_id

) o ON c.id = o.customer_id

SET c.total_spent = o.total;

解释:

- 子查询

o:先按客户 ID 统计每个人的总消费。 UPDATE customers c JOIN o ...:把客户表和统计结果连接起来。SET c.total_spent = o.total:直接把统计值写回客户表。

好处:不用在程序里循环“查一个、改一个”,减少网络开销,保证原子性。

9. GR0UP_CONCAT —— 多行变一行

SELECT

department,

GR0UP_CONCAT(name ORDER BY salary DESC SEPARATOR ', ') AS members

FROM employees

GR0UP BY department;

解释:

GR0UP BY department:按部门分组。GR0UP_CONCAT(name ...):把每个部门的所有员工名字拼成一个字符串。ORDER BY salary DESC:按薪水从高到低排序后再拼接。SEPARATOR ', ':用逗号加空格分隔名字。

典型用途:导出名单、展示标签、汇总明细等。

默认最多拼 1024 字符,可通过 SET SESSION group_concat_max_len = 1000000; 调大。

10. INSERT ... ON DUPLICATE KEY UPDATE —— 智能插入/更新

INSERT INTO page_views (page_url, view_date, view_count)

VALUES ('/home', CURDATE(), 1)

ON DUPLICATE KEY UPDATE

view_count = view_count + 1;

解释:

- 尝试插入一条新记录:页面

/home,今天日期,访问次数为 1。 - 如果因为唯一索引冲突(比如

(page_url, view_date)是唯一键)导致插入失败:

- 就执行

ON DUPLICATE KEY UPDATE部分 - 把原有的

view_count加 1

- 就执行

- 效果:第一次访问创建记录,之后每次访问自动 +1,完美实现计数器!

前提:表必须有主键或唯一索引,否则不会触发更新。

本文首发于公众号:程序员刘大华,专注分享前后端开发的实战笔记。关注我,少走弯路,一起进步!

📌往期精彩

《async/await 到底要不要加 try-catch?异步错误处理最佳实践》

《如何查看 SpringBoot 当前线程数?3 种方法亲测有效》

《Java 开发必看:什么时候用 for,什么时候用 Stream?》

来源:juejin.cn/post/7584266184882552866

Vue3 后台分页写腻了?我用 1 个 Hook 删掉 90% 重复代码(附源码)

实战推荐:

- 不仅免费,还开源?这个 AI Mock 神器我必须曝光它

- ⚡ 一个Vue自定义指令搞定丝滑拖拽列表,告别复杂组件封装

- 🔥 这才是 Vue 驱动的 Chrome 插件工程化正确打开方式

- 女朋友又给我出难题了:解锁网页禁用复制 + 一键提取图片文字

还在为每个列表页写重复的分页代码而烦恼吗? 还在复制粘贴 currentPage、pageSize、loading 等状态吗? 一个 Hook 帮你解决所有分页痛点,减少90%重复代码

背景与痛点

在后台管理系统开发中,分页列表查询非常常见,我们通常需要处理:

- 当前页、页大小、总数等分页状态

- 加载中、错误处理等请求状态

- 搜索、刷新、翻页等分页操作

- 数据缓存和重复请求处理

这些重复逻辑分散在各个组件中,维护起来很麻烦。

为了解决这个烦恼,我专门封装了分页数据管理 Hook。现在只需要几行代码,就能轻松实现分页查询,省时又高效,减少了大量重复劳动

使用前提 - 接口格式约定

查询接口返回的数据格式:

{

list: [ // 当前页数据数组

{ id: 1, name: 'user1' },

{ id: 2, name: 'user2' }

],

total: 100 // 数据总条数

}

先看效果:分页查询只需几行代码!

import usePageFetch from '@/hooks/usePageFetch' // 引入分页查询 Hook,封装了分页逻辑和状态管理

import { getUserList } from '@/api/user' // 引入请求用户列表的 API 方法

// 使用 usePageFetch Hook 实现分页数据管理

const {

currentPage, // 当前页码

pageSize, // 每页条数

total, // 数据总数

data, // 当前页数据列表