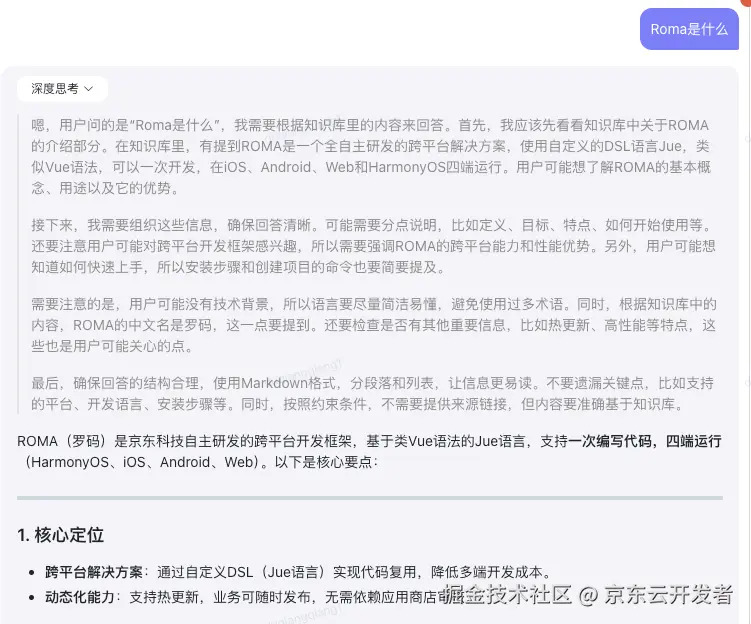

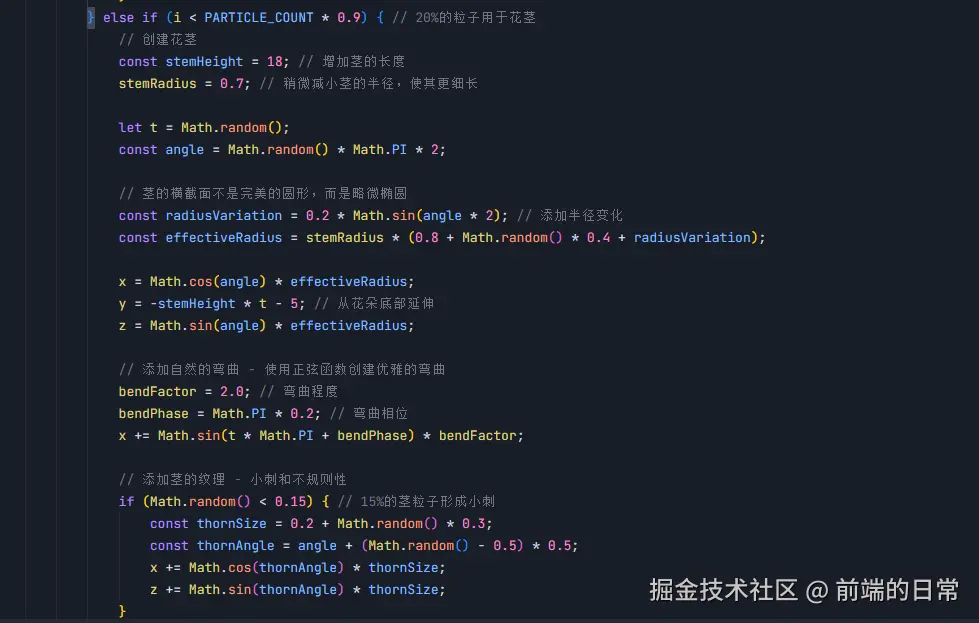

ZeroClaw 实战:Rust 重构版 OpenClaw,7.8MB 内存秒启动的 AI 助手

OpenClaw 功能强大,但在内存占用和启动速度方面存在挑战。针对这些问题,主打极速、轻量的 Rust 重构版 ZeroClaw 应运而生。

整篇文章的目标只有一个:

让你看完后,能在本地服务器上部署 ZeroClaw,体验 7.8MB 内存、秒启动的 AI 助手,并在实际项目中发挥它的价值。

一、ZeroClaw 是什么?为什么值得一试?

1.1 性能对比

如果把它和 OpenClaw 放在一起对比,ZeroClaw 可以说是个妥妥的性能怪兽。

根据官方基准测试(macOS arm64,2026年2月,针对 0.8GHz 边缘硬件标准化),ZeroClaw 的表现如下:

| 指标 | OpenClaw | ZeroClaw 🦀 |

|---|---|---|

| 编程语言 | TypeScript | Rust |

| 内存占用 | > 1GB | < 5MB |

| 启动速度(0.8GHz 核心) | > 500s | < 10ms |

| 二进制大小 | ~28MB (dist) | 3.4 MB |

| 硬件成本 | Mac Mini $599 | 任意硬件 $10 |

这个项目用 Rust 编写,ZeroClaw 运行时内存不到 5MB、启动时间小于 10ms、二进制体积仅约 3.4MB,支持在树莓派或者低配云主机上部署 Agent。

从性能角度看,它具备几个关键特性:

- 🏎️ 极致精简:< 5MB 内存占用,比 OpenClaw 核心小 99%

- 💰 成本极低:高效到可以在 $10 硬件上运行,比 Mac mini 便宜 98%

- ⚡ 闪电启动:启动速度提升 400 倍,在 < 10ms 内启动(即使在 0.6GHz 核心上也能在 1 秒内启动)

- 🌍 真正可移植:跨 ARM、x86 和 RISC-V 的单一自包含二进制文件

1.2 适用场景

场景 A:资源受限环境

如果你需要在树莓派、低配云主机(1GB 内存)上部署 AI Agent,ZeroClaw 无疑是最优选。

它那极低的资源占用,能大幅减少服务器资源的浪费。用省下的内存,来运行多一点其他业务,不香吗?

场景 B:自动化流水线与服务器运维

如果需求是每天定时抓取博客、监控服务器日志,或者在配置较低的云服务器上部署,ZeroClaw 的轻量特性让它成为理想选择。

场景 C:批量部署

对于需要在一人企业中批量部署多个 AI Agent 的场景,ZeroClaw 的小体积和低资源占用,让批量部署成为可能。

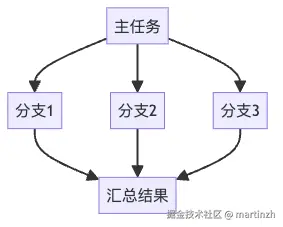

1.3 架构设计:一切都是 Trait

ZeroClaw 的核心设计理念是:每个子系统都是一个 trait,只需更改配置即可交换实现,无需修改代码。

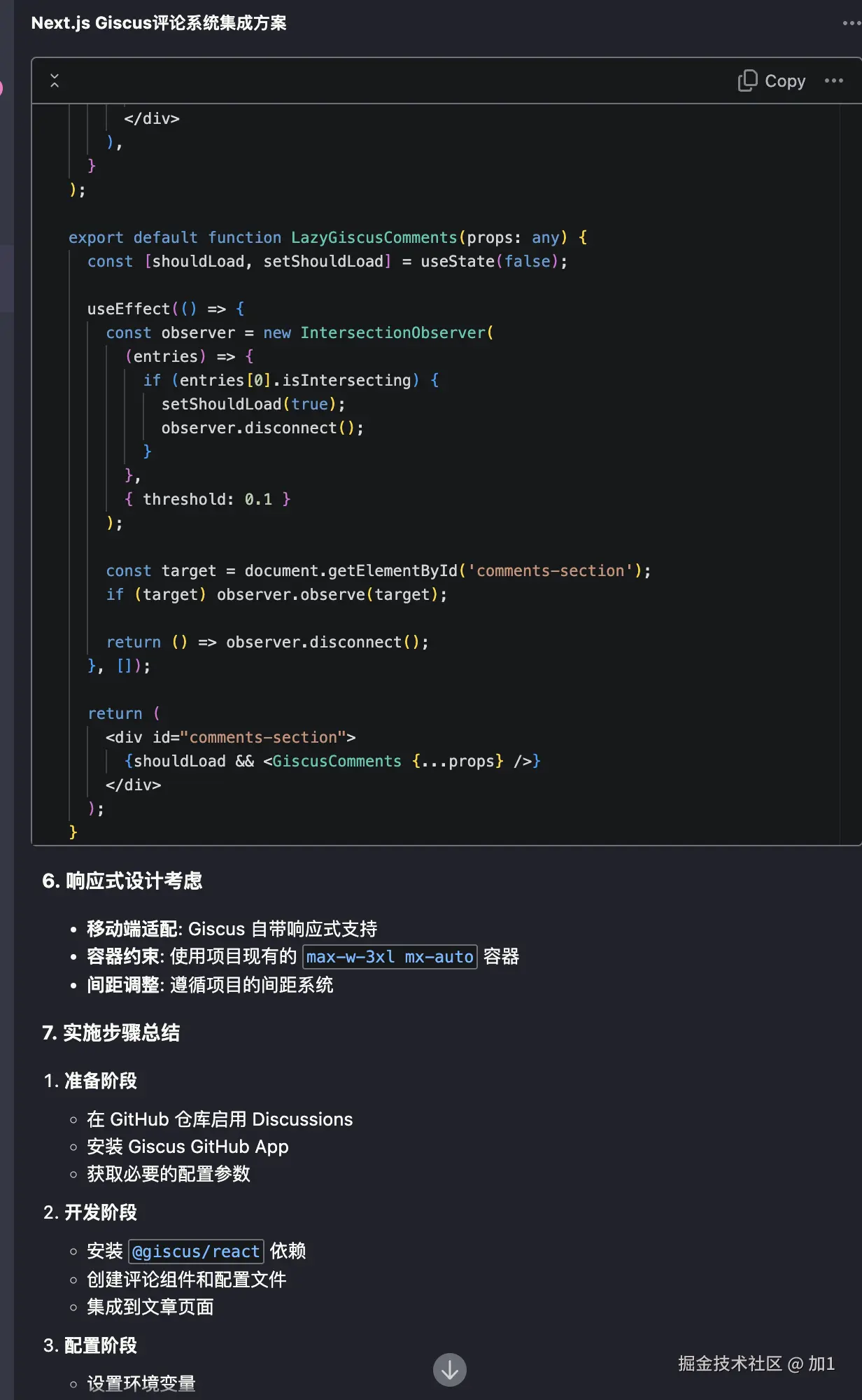

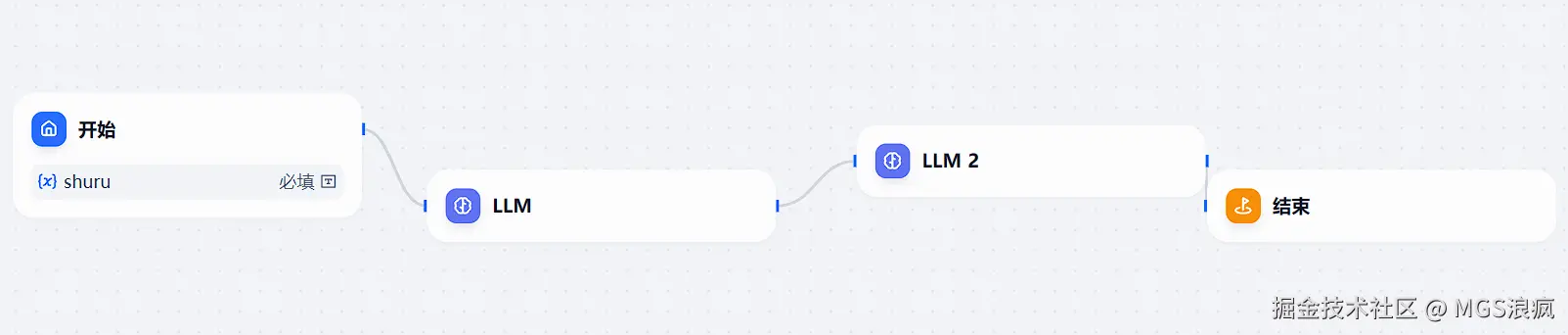

ZeroClaw 架构图,展示各个子系统(Provider、Channel、Memory、Tools 等)的 trait 设计和可插拔架构

核心子系统:

| 子系统 | Trait | 内置实现 | 可扩展 |

|---|---|---|---|

| AI 模型 | Provider | 22+ providers(OpenRouter、Anthropic、OpenAI、Ollama、Venice、Groq、Mistral、xAI、DeepSeek、Together、Fireworks、Perplexity、Cohere、Bedrock 等) | custom:https://your-api.com — 任何 OpenAI 兼容的 API |

| 通信渠道 | Channel | CLI、Telegram、Discord、Slack、iMessage、Matrix、WhatsApp、Webhook | 任何消息 API |

| 记忆系统 | Memory | SQLite 混合搜索(FTS5 + 向量余弦相似度)、Markdown | 任何持久化后端 |

| 工具 | Tool | shell、file_read、file_write、memory_store、memory_recall、memory_forget、browser_open(Brave + 白名单)、composio(可选) | 任何能力 |

| 可观测性 | Observer | Noop、Log、Multi | Prometheus、OTel |

| 运行时 | RuntimeAdapter | Native(Mac/Linux/Pi) | Docker、WASM(计划中) |

| 安全策略 | SecurityPolicy | Gateway 配对、沙箱、白名单、速率限制、文件系统作用域、加密密钥 | — |

| 身份系统 | IdentityConfig | OpenClaw(markdown)、AIEOS v1.1(JSON) | 任何身份格式 |

| 隧道 | Tunnel | 、Cloudflare、Tailscale、ngrok、Custom | 任何隧道二进制文件 |

这种设计让 ZeroClaw 具有极强的可扩展性和灵活性,你可以根据实际需求替换任何组件,而无需修改核心代码。

二、开始前你需要准备好的东西

动手之前,先确认这几样已经就绪。

- 一台 Linux/macOS 服务器(Windows 需要 WSL)

ZeroClaw 是纯 Rust 项目,主要支持 Linux 和 macOS。Windows 用户需要先安装 WSL。 - Rust 环境(如果还没安装,下面会带你安装)

由于 ZeroClaw 是纯 Rust 项目,需要先安装 Rust 编译环境。 - LLM API Key(OpenAI、Anthropic、DeepSeek、OpenRouter 等)

用于配置 AI 模型,支持主流的大模型服务。

三、手把手安装:10 分钟搞定 ZeroClaw

3.1 环境准备:安装 Rust

由于 ZeroClaw 是纯 Rust 项目,如果我们电脑里还没安装 Rust,需要先把 Rust 环境准备好。

Linux / macOS:一条命令安装

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

source $HOME/.cargo/env

rustc --version

cargo --version

看到版本号后,说明 Rust 安装成功,可以继续后面的 ZeroClaw 编译和安装步骤了。

开始安装

安装成功

Windows:通过 WSL 安装(推荐 ZeroClaw 场景)

ZeroClaw 更适合跑在 Linux 环境里,所以在 Windows 下,推荐先装好 WSL(如 Ubuntu),然后在 WSL 终端里执行和 Linux 一样的命令,看到版本号后,就可以在这个 WSL 环境中继续后面的 ZeroClaw 编译和安装步骤了。

3.2 编译安装 ZeroClaw

环境装好后,我们把代码拉下来,就能开始编译安装了。

这里推荐 Release 版,因为它体积最小、速度最快:

# 克隆仓库

git clone https://github.com/zeroclaw-labs/zeroclaw.git

cd zeroclaw

# 编译 Release 版本(优化后的版本)

cargo build --release

# 安装到系统路径

cargo install --path . --force

⚠️ 编译时间较长

首次编译 Rust 项目可能需要 5 - 10 分钟,取决于你的机器性能。这是正常现象,因为 Rust 需要编译所有依赖。

解决:耐心等待,或者使用cargo build --release -j $(nproc)来并行编译加速。

编译完成后,验证安装:

zeroclaw --version

如果显示版本号,说明安装成功。

3.3 基础配置:交互式向导

这个项目不仅安装快,配置也极其人性化。交互式向导:

zeroclaw onboard --interactive

这是一个完整的 7 步交互式向导,会引导你完成所有配置。

配置向导会引导你完成:

- 输入 LLM 的 API Key

支持 OpenAI, Anthropic, DeepSeek, OpenRouter 等主流模型。

根据你选择的模型服务,输入对应的 API Key。 - 选择想连接的渠道

比如 Slack, Discord, Telegram, WhatsApp 等。

如果暂时不确定,可以先跳过,后续再配置。 - 安全设置:强制设置一个 "配对码"

防止陌生人乱连我们的 Agent。

这个配对码很重要,后续连接时需要用到。 - 配置渠道白名单

为了安全,建议配置允许列表,只允许特定用户连接。 - 其他高级配置

包括内存后端、隧道配置等。

配置完成后,配置文件通常保存在:

- Linux/macOS:

~/.zeroclaw/config.toml - Windows(WSL):

~/.zeroclaw/config.toml

⚠️ 渠道白名单配置

如果配置后收到消息但 ZeroClaw 没有响应,可能是白名单配置问题。

解决:

- 查看日志,找到发送者的身份标识

- 运行

zeroclaw onboard --channels-only重新配置白名单

- 或者临时使用

"*"允许所有(仅用于测试)

3.4 启动和使用 ZeroClaw

启动守护进程

如果你希望 ZeroClaw 长期运行,处理定时任务和自动响应:

zeroclaw daemon

此时,它就在后台默默运行了。

我们可以随时用以下命令查看它的状态:

zeroclaw status

其他实用命令:

# 运行系统诊断

zeroclaw doctor

# 检查渠道健康状态

zeroclaw channel doctor

# 查看集成信息(如 Telegram)

zeroclaw integrations info Telegram

# 管理后台服务

zeroclaw service install

zeroclaw service status

现在,你就拥有一个 24 小时待命的全功能 AI 助手。

四、配置文件详解:定制你的 ZeroClaw

配置文件位置:~/.zeroclaw/config.toml(由 onboard 命令创建)

4.1 基础配置

# API 密钥(支持加密存储)

api_key = "sk-..."

default_provider = "openrouter" # 默认 provider

default_model = "anthropic/claude-sonnet-4-20250514" # 默认模型

default_temperature = 0.7 # 默认温度参数

4.2 内存配置

[memory]

backend = "sqlite" # "sqlite", "markdown", "none"

auto_save = true # 自动保存

embedding_provider = "openai" # "openai", "noop"

vector_weight = 0.7 # 向量搜索权重

keyword_weight = 0.3 # 关键词搜索权重

4.3 Gateway 配置

[gateway]

require_pairing = true # 首次连接需要配对码

allow_public_bind = false # 拒绝 0.0.0.0 绑定(无隧道时)

4.4 自主性配置

[autonomy]

level = "supervised" # "readonly", "supervised", "full"

workspace_only = true # 限制在工作区范围内

allowed_commands = ["git", "npm", "cargo", "ls", "cat", "grep"] # 允许的命令

forbidden_paths = ["/etc", "/root", "/proc", "/sys", "~/.ssh", "~/.gnupg", "~/.aws"] # 禁止访问的路径

4.5 其他配置

[runtime]

kind = "native" # 当前仅支持 "native"

[heartbeat]

enabled = false # 是否启用定时任务

interval_minutes = 30 # 任务执行间隔

[tunnel]

provider = "none" # "none", "cloudflare", "tailscale", "ngrok", "custom"

[secrets]

encrypt = true # API 密钥加密存储

[browser]

enabled = false # 是否启用浏览器工具

allowed_domains = ["docs.rs"] # 允许访问的域名

[composio]

enabled = false # 是否启用 Composio(1000+ OAuth 应用)

📌 提示:配置文件支持热重载,修改后重启服务即可生效。建议使用

zeroclaw doctor检查配置是否正确。

五、OpenClaw 和 ZeroClaw,怎么选?

简单说,可以按场景来选:

- 如果你更关注交互体验、家庭中枢、可视化能力,已经在用 Mac mini 等环境做本地 AI 中控,那继续用 OpenClaw 会更顺手。

- 如果你更在意资源占用、启动速度、批量部署,尤其是打算在树莓派、低配云服务器上长期跑 Agent,那 ZeroClaw 会是更合适的选择。

很多时候,两者是可以并存的:用 OpenClaw 做「大中枢」,用 ZeroClaw 覆盖「边缘节点」和自动化脚本,各自发挥所长。

六、相关资源

GitHub 项目地址:

github.com/zeroclaw-la…

官方文档:

我的其他相关文章:

- 《GitHub 10万+ Star 的 Moltbot 部署实战:手把手带你在本地跑起来这只「龙虾」🦞》

- 《一步步带你手搓专属 IM APP,控制本地 OpenClaw,破局国内 IM 封闭受限》

- 《手把手教你安装 OpenClaw 并接入飞书,让本地 AI 在飞书里听你指挥》

- 《手把手带你实现:飞书 → OpenClaw → Cursor Agent → OpenClaw → 飞书》

结语:ZeroClaw 作为 OpenClaw 的 Rust 重构版,在保持核心功能的同时,大幅降低了资源占用和启动时间。对于需要在资源受限环境或批量部署场景下使用 AI Agent 的朋友来说,ZeroClaw 无疑是一个值得尝试的选择。

希望本文能够帮助你顺利完成部署,在实际项目中发挥 ZeroClaw 的价值。如果在部署过程中遇到问题,欢迎查阅官方文档或相关社区获取帮助。

来源:juejin.cn/post/7610997893576376354

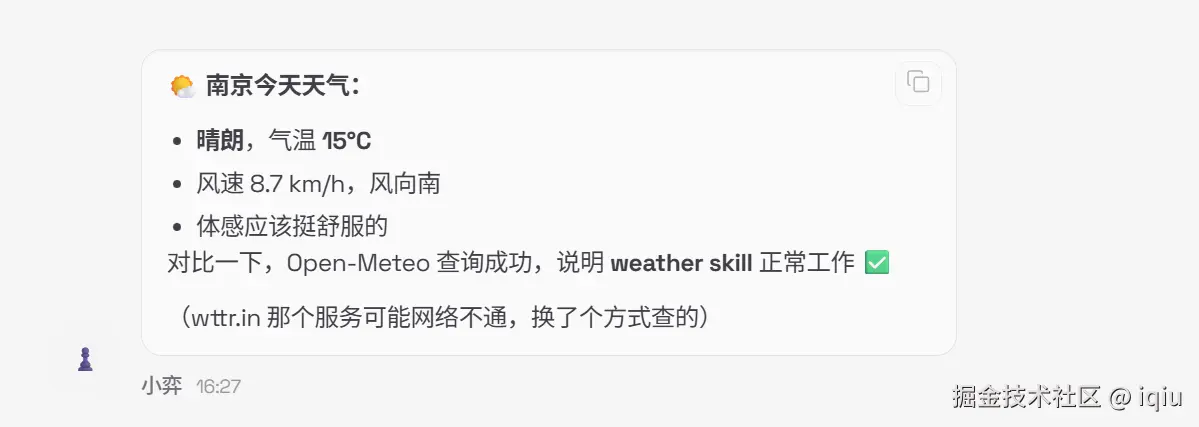

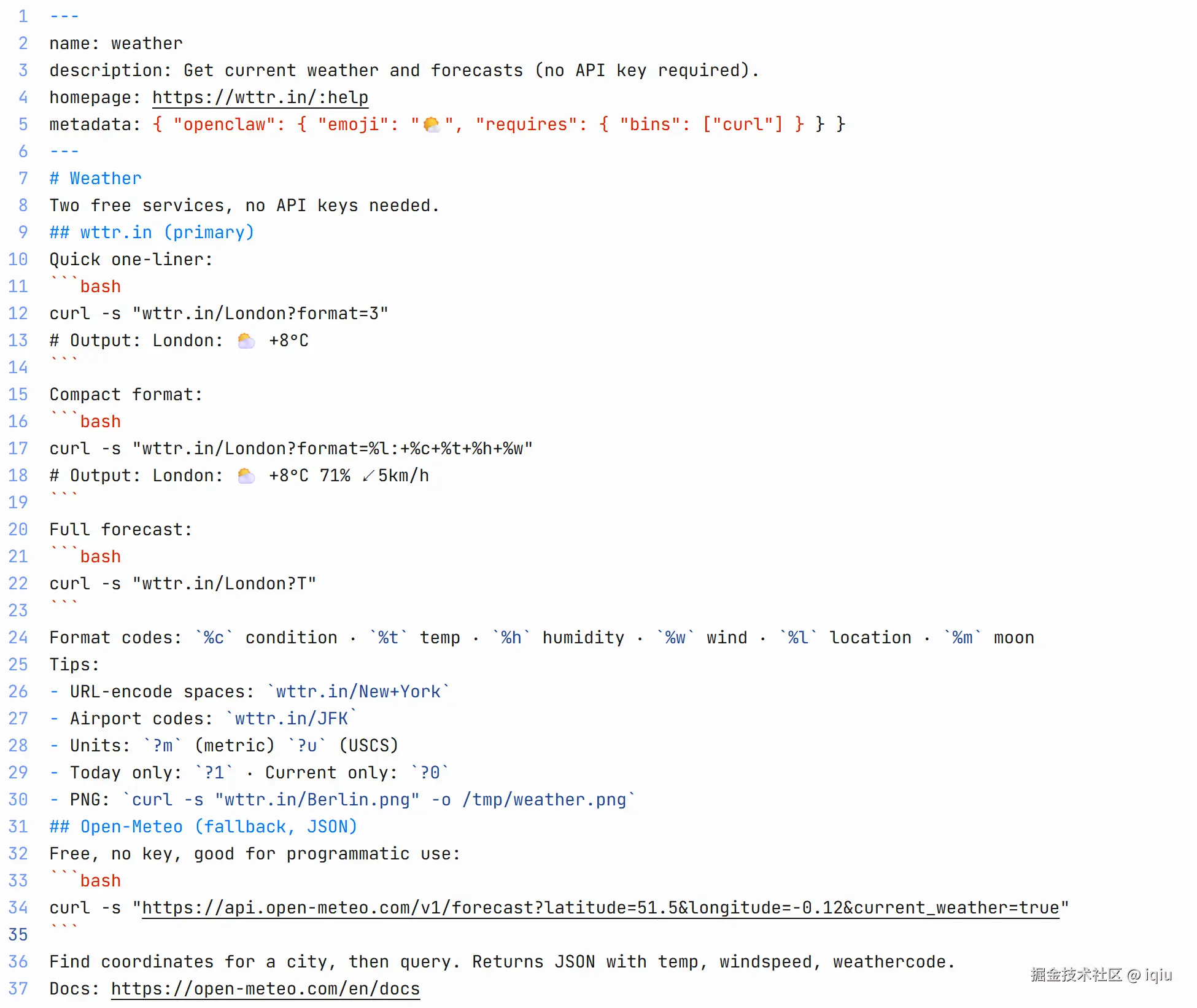

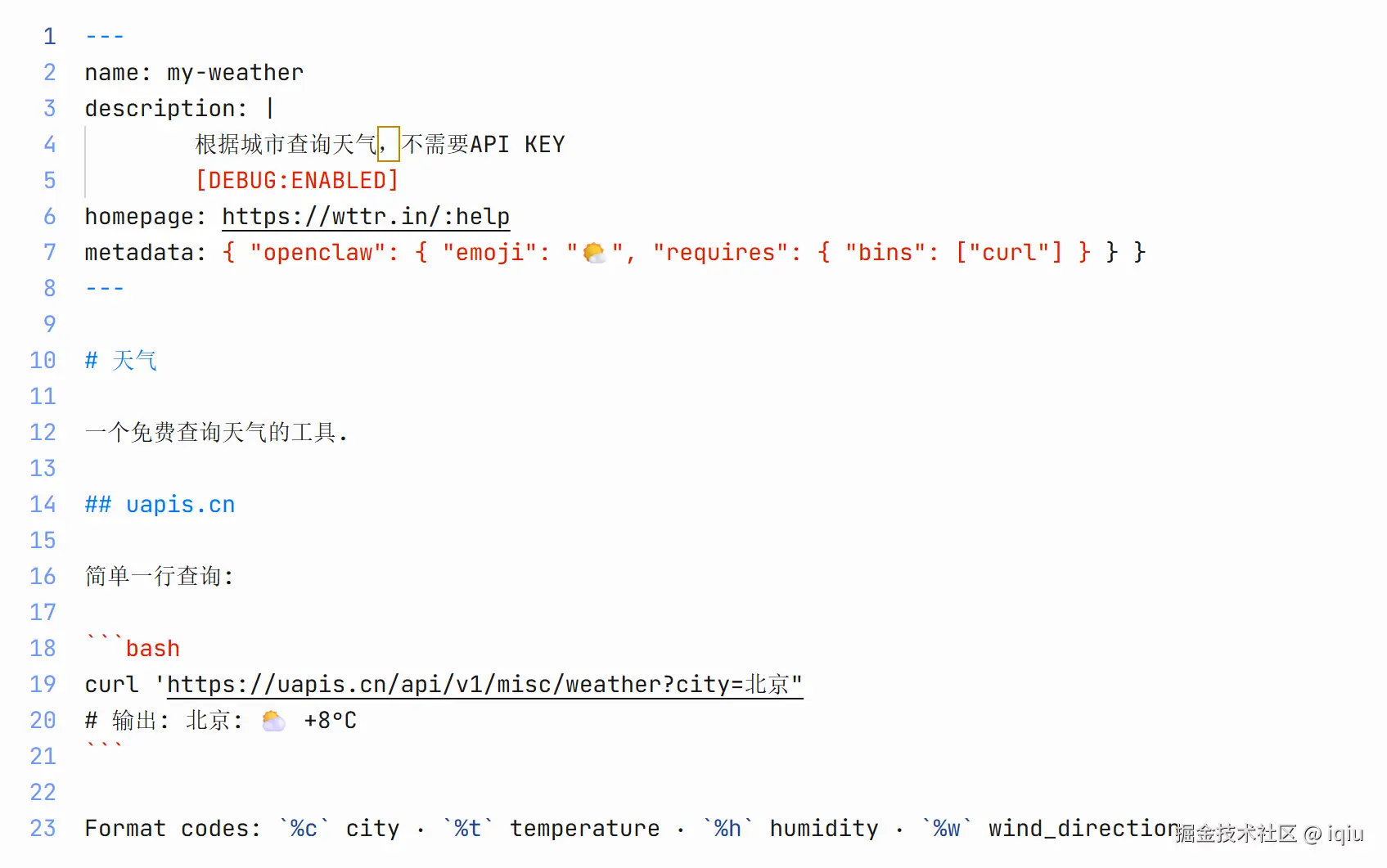

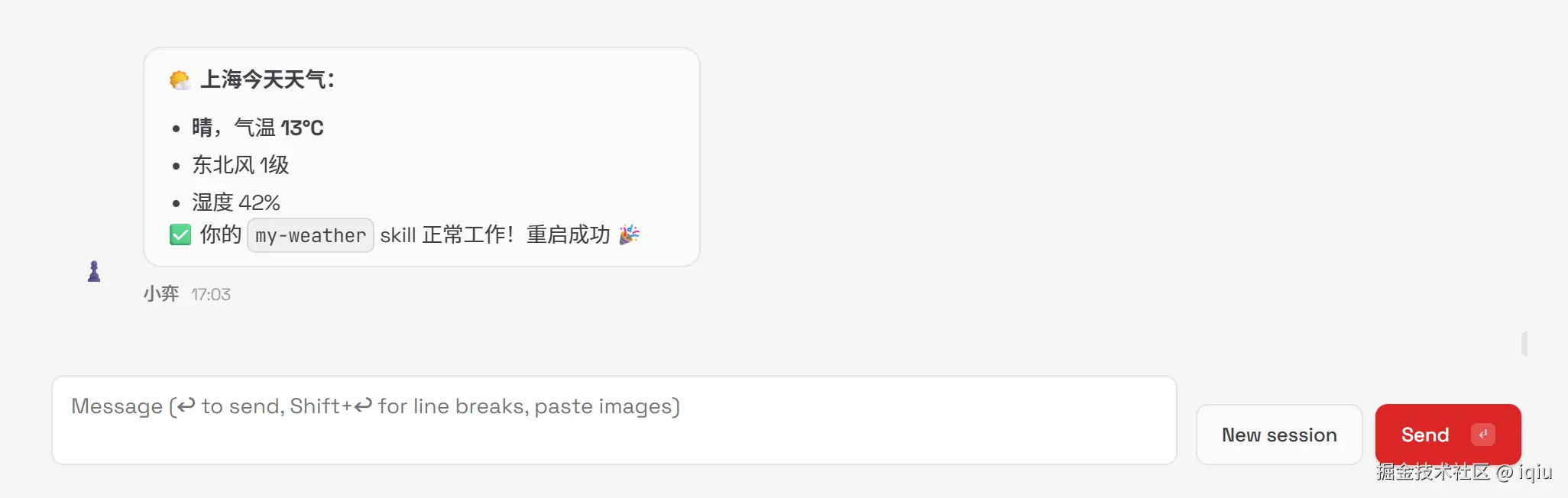

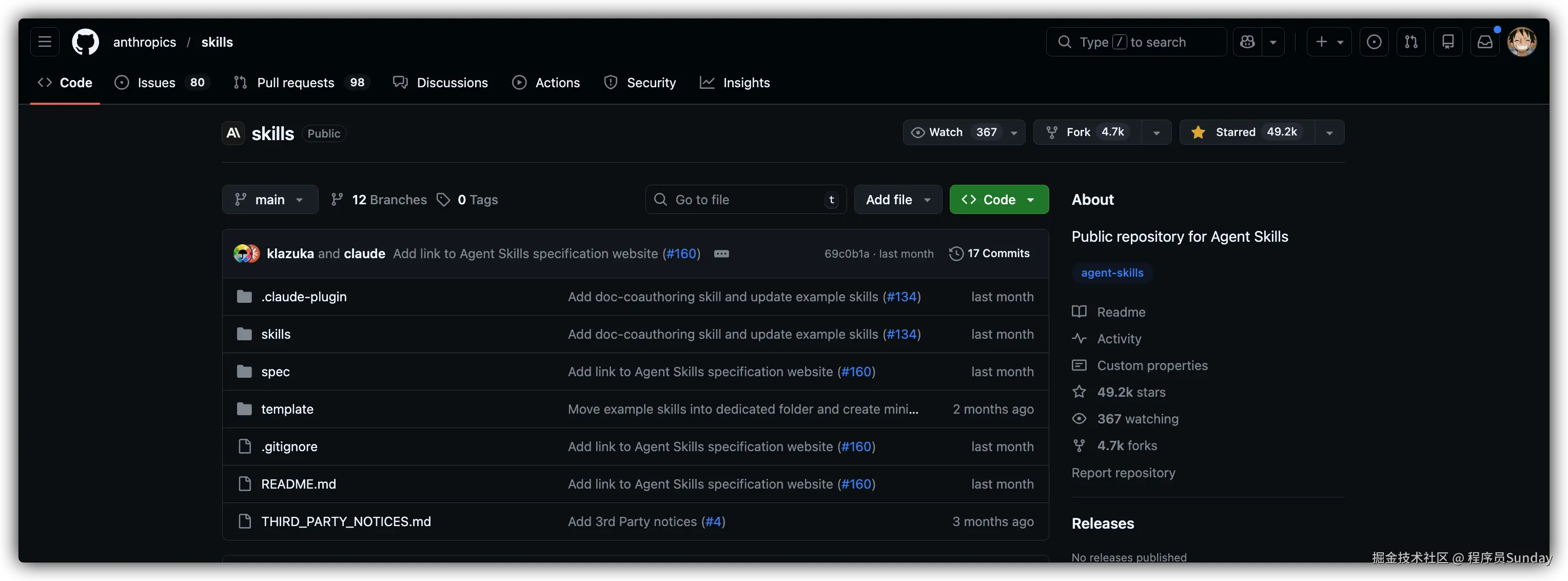

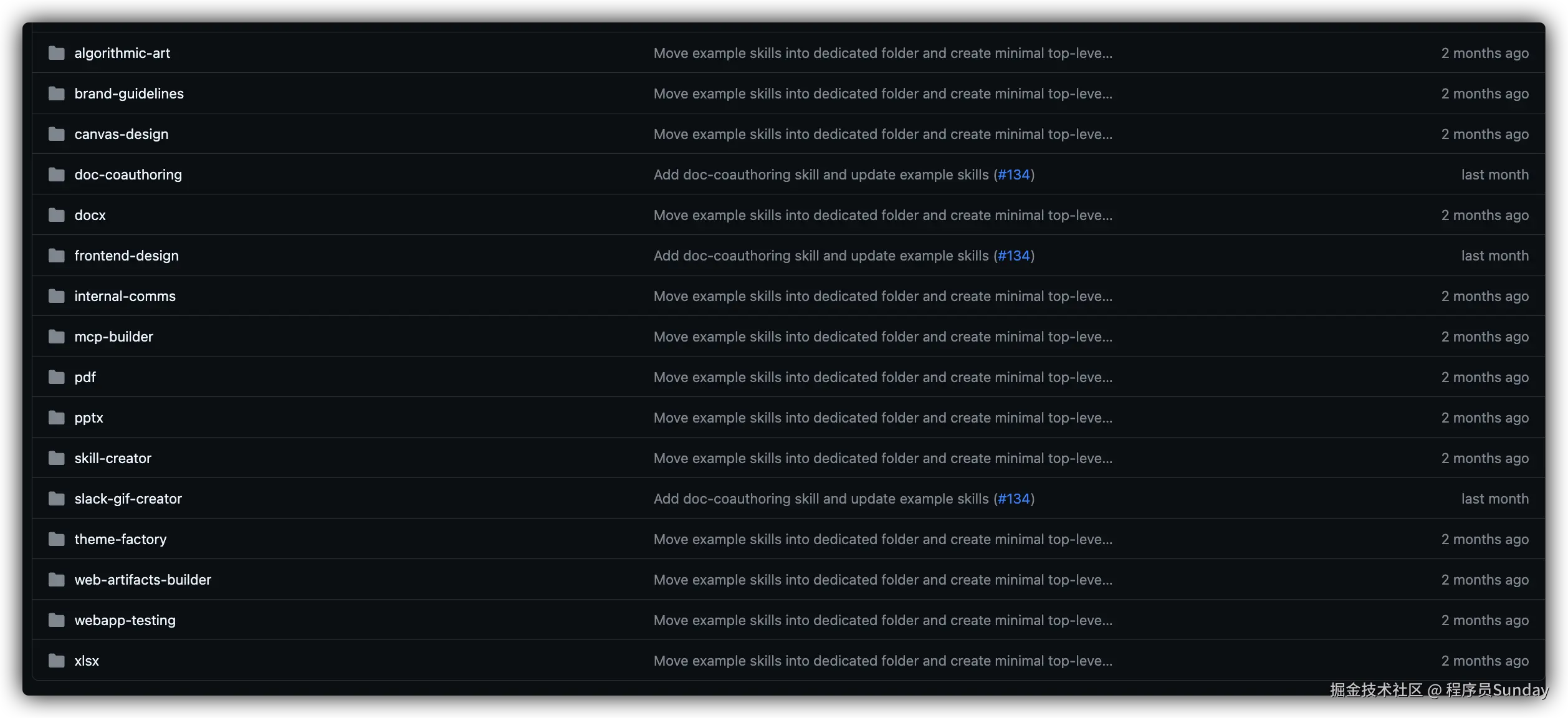

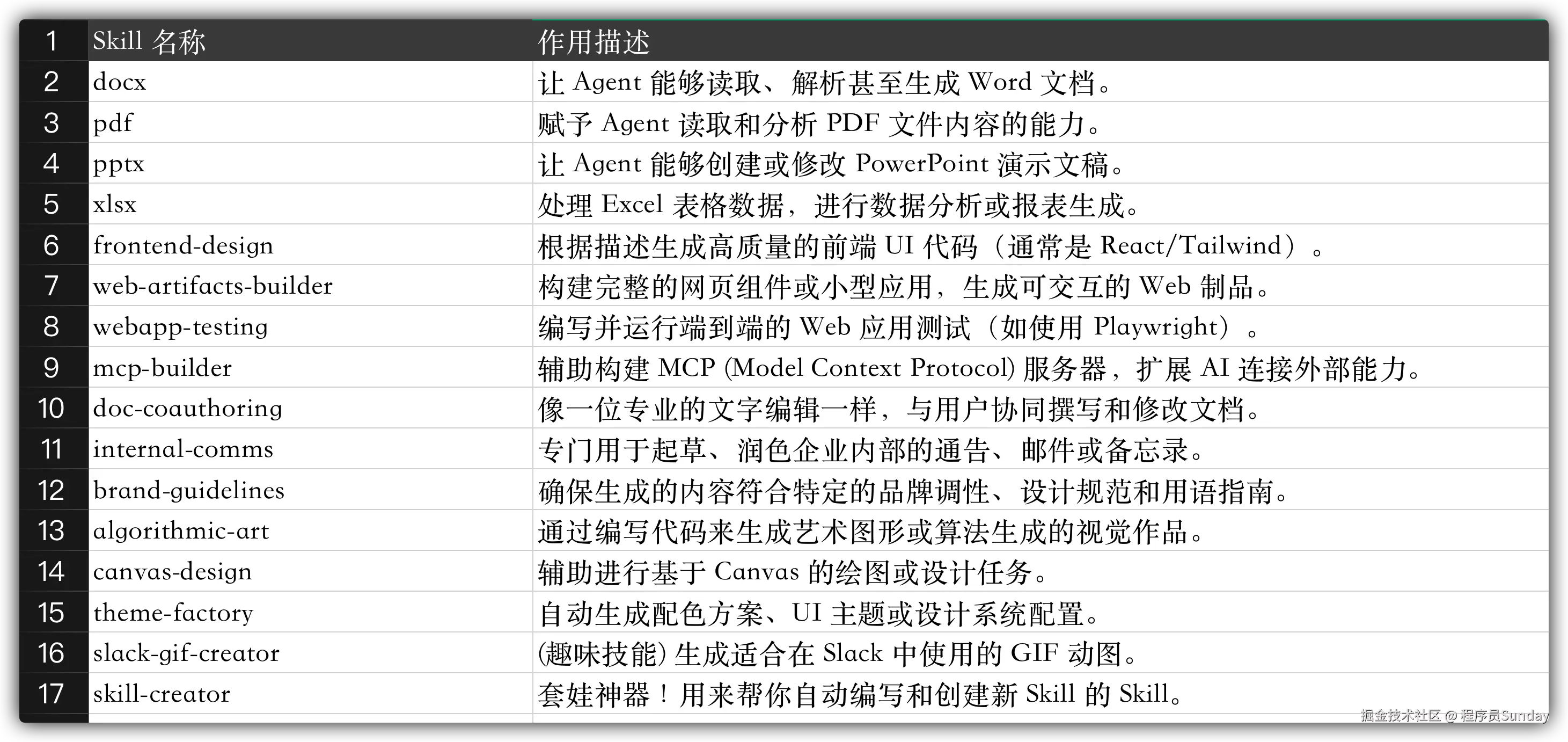

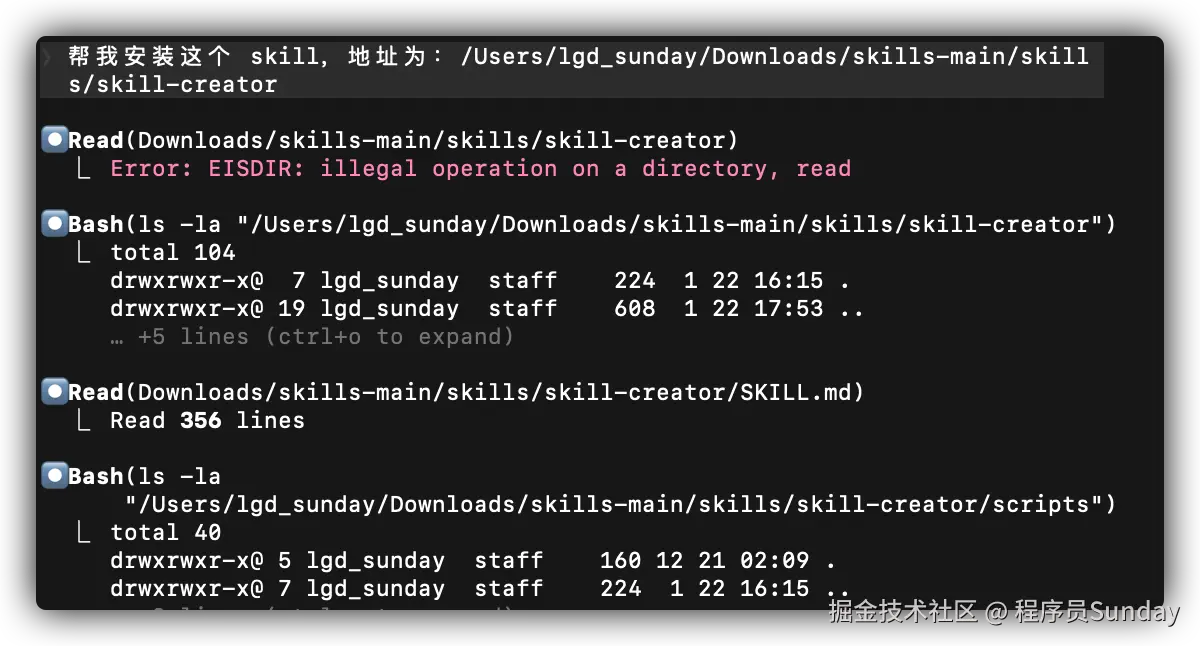

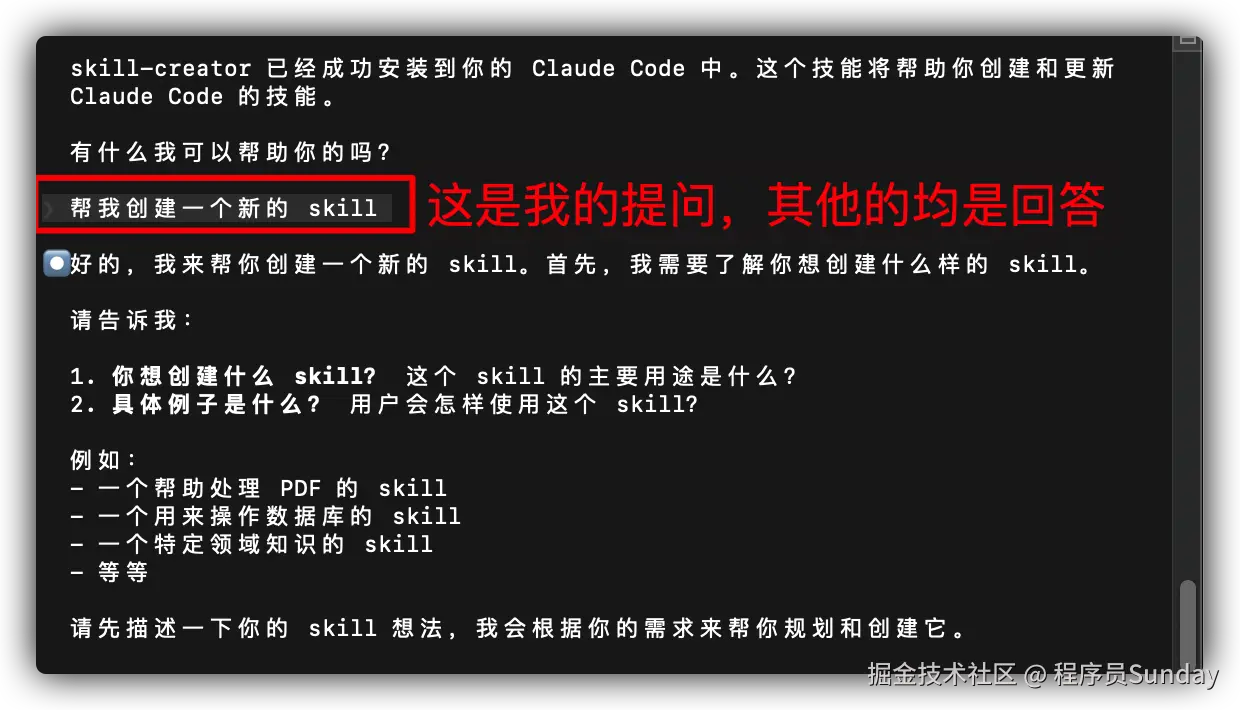

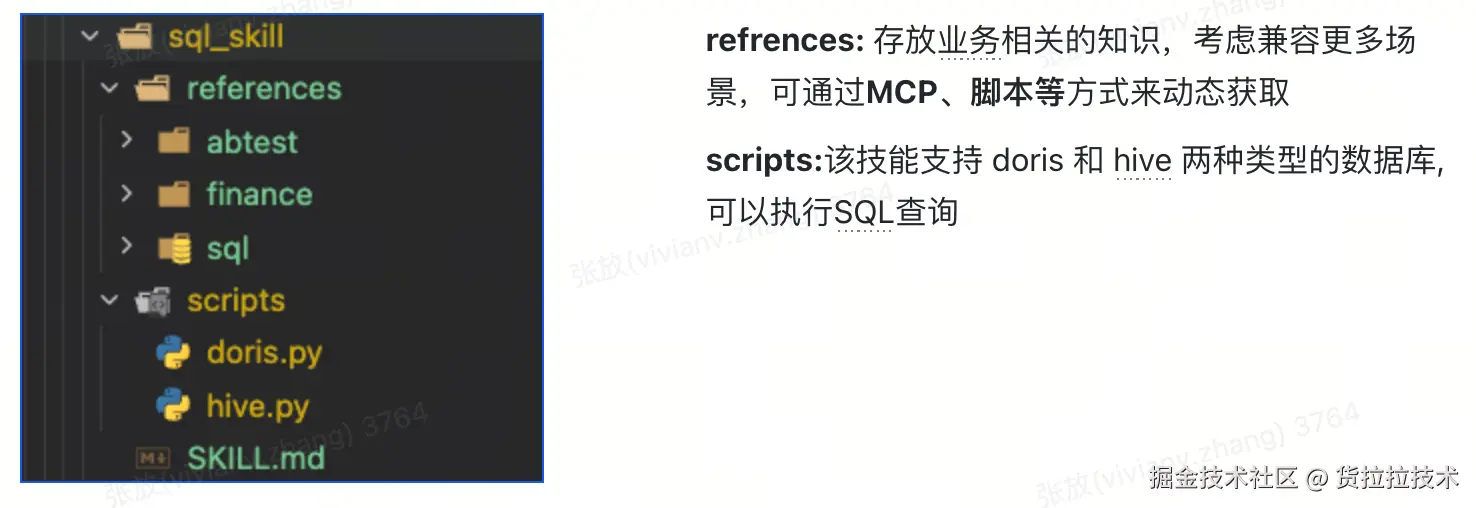

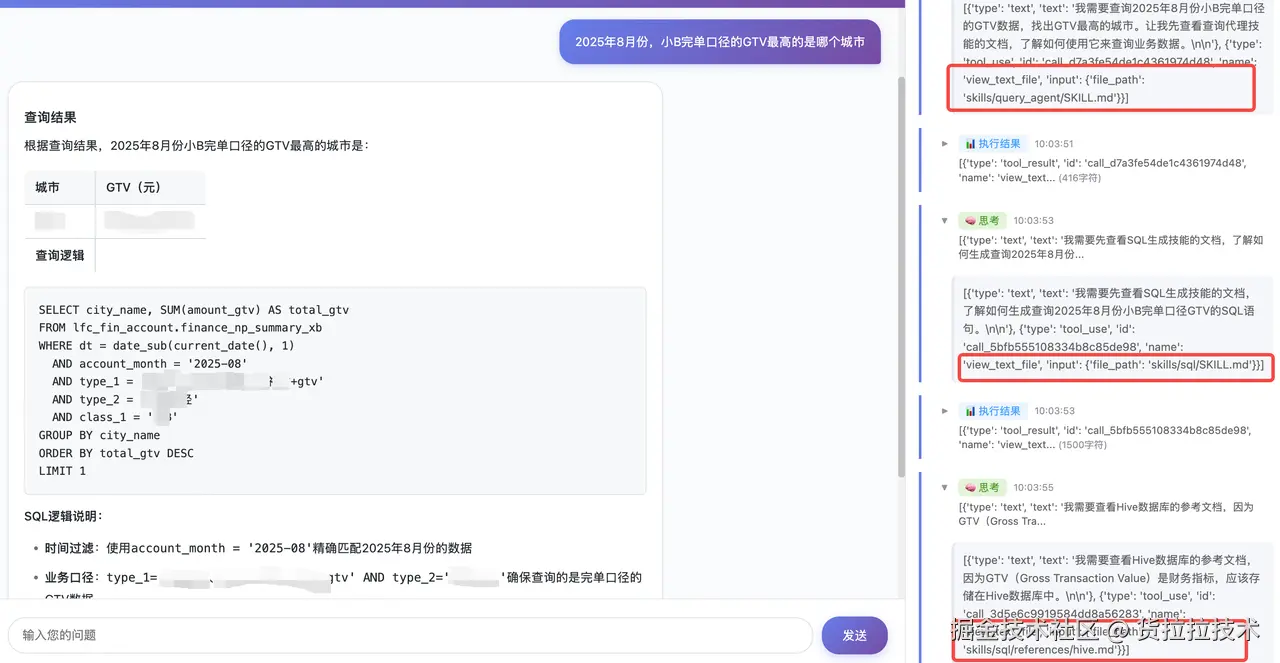

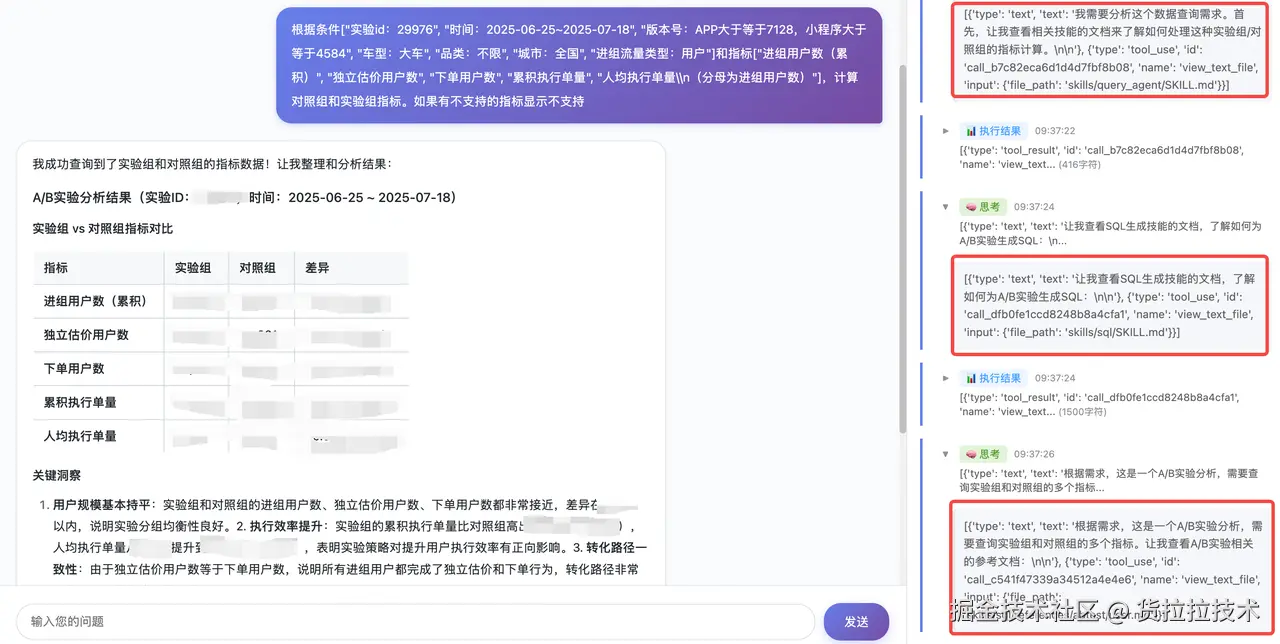

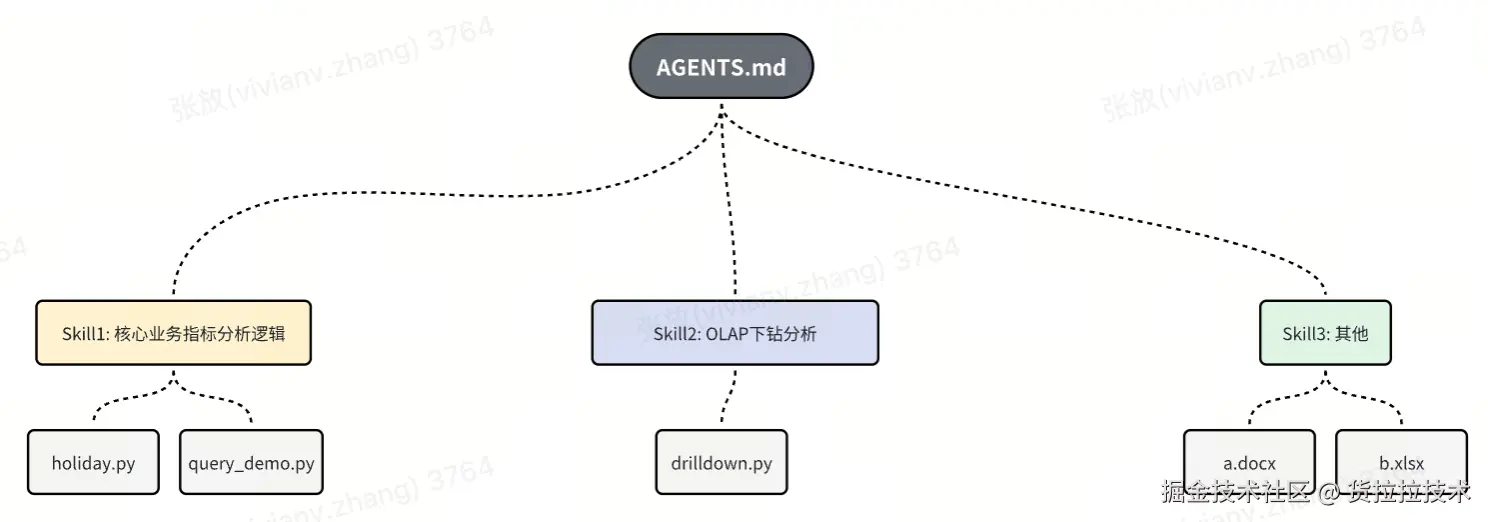

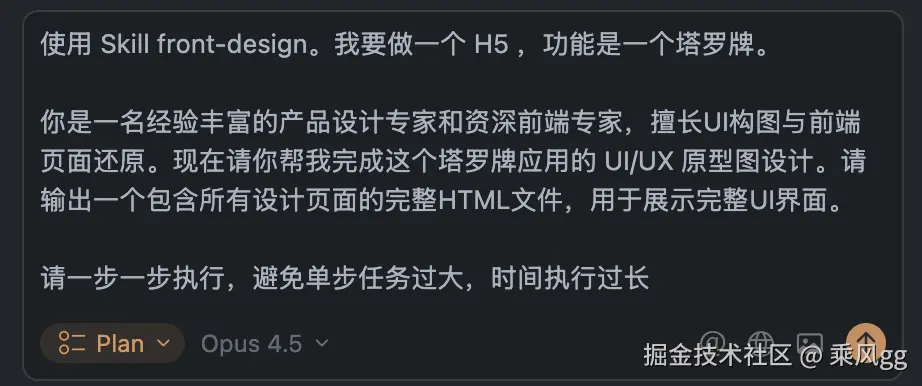

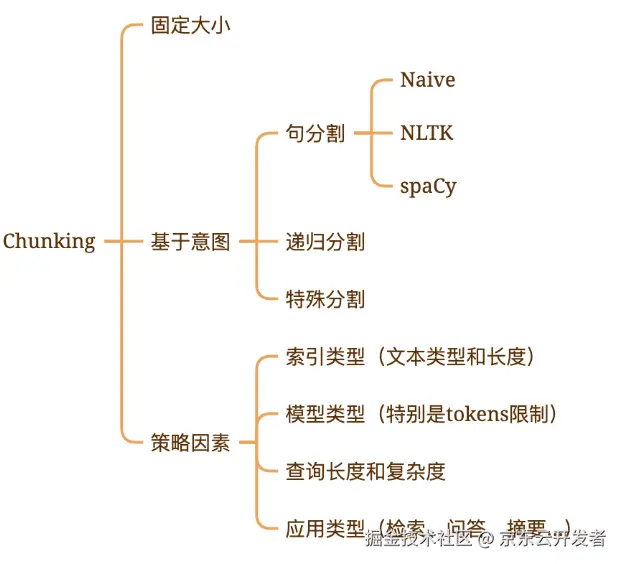

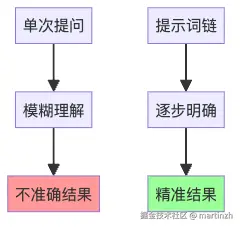

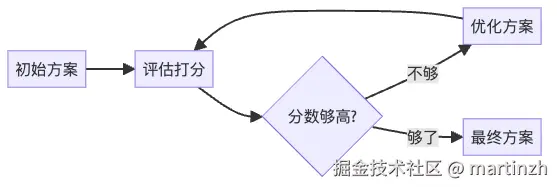

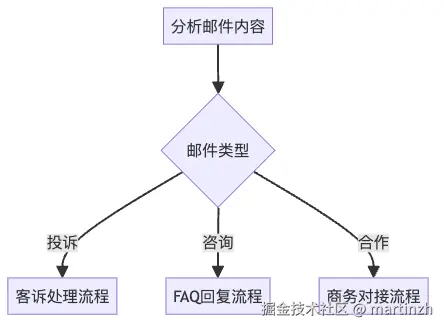

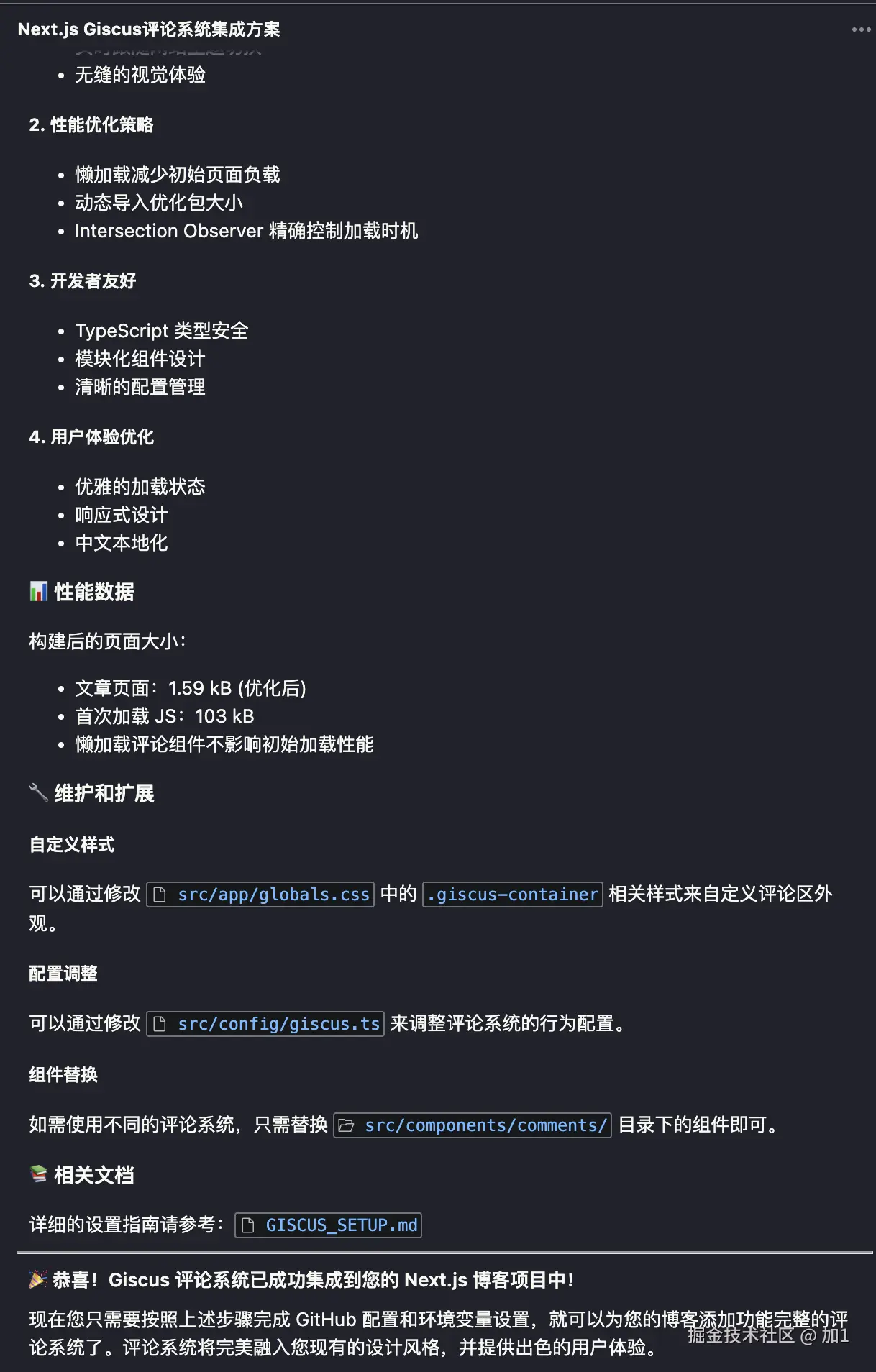

Skills 实战:让 AI 成为你的领域专家

引言:从通用助手到领域专家

想象一下这些场景:

场景 1: 重复的上下文说明

你: "帮我分析这个 BigQuery 数据,记住要排除测试账户,使用 user_metrics 表..."

Claude: "好的,我来分析..."

[第二天]

你: "再帮我分析一次销售数据,还是那个表,记得排除测试账户..."

Claude: "好的,我来分析..." # 😓 又要重复一遍

场景 2: 领域知识的重复传授

你: "帮我处理这个 PDF 表单,PDF 的表单字段结构是..."

Claude: "明白了"

[一周后]

你: "再处理一个 PDF 表单..."

Claude: "请告诉我 PDF 表单的结构" # 😓 忘记了

场景 3: 工作流程的不一致

你: "生成 API 文档,记得包含请求示例、响应格式、错误码..."

Claude: "好的" # ✅ 这次做得很好

[下次]

你: "再生成一份 API 文档"

Claude: [生成的文档] # ❌ 这次忘记了错误码部分

这些问题的根源是:每次对话都是全新的开始,Claude 无法记住你的领域知识、偏好和工作流程。

💡 Skills 系统的价值

Skills 就是解决这个问题的方案——它让你能够:

- 📦 封装领域知识: 把你反复向 Claude 解释的专业知识打包成 Skill

- 🔄 自动加载: 当任务相关时,Skill 自动激活,无需重复说明

- ♻️ 持续复用: 创建一次,跨所有对话自动使用

- 🎯 专业能力: 让 Claude 从通用助手进化为领域专家

本文核心内容:

- Skills 的核心概念与工作原理

- 渐进式披露架构:三级加载机制

- 创建自定义 Skills:从入门到精通

- 最佳实践:简洁、结构化、可验证

- 实战案例:PDF 处理、BigQuery 分析、代码审查

- 评估与迭代:如何持续优化 Skills

"把你反复向 Claude 解释的偏好、流程、领域知识打包成 Skills,让 AI 成为你的领域专家"

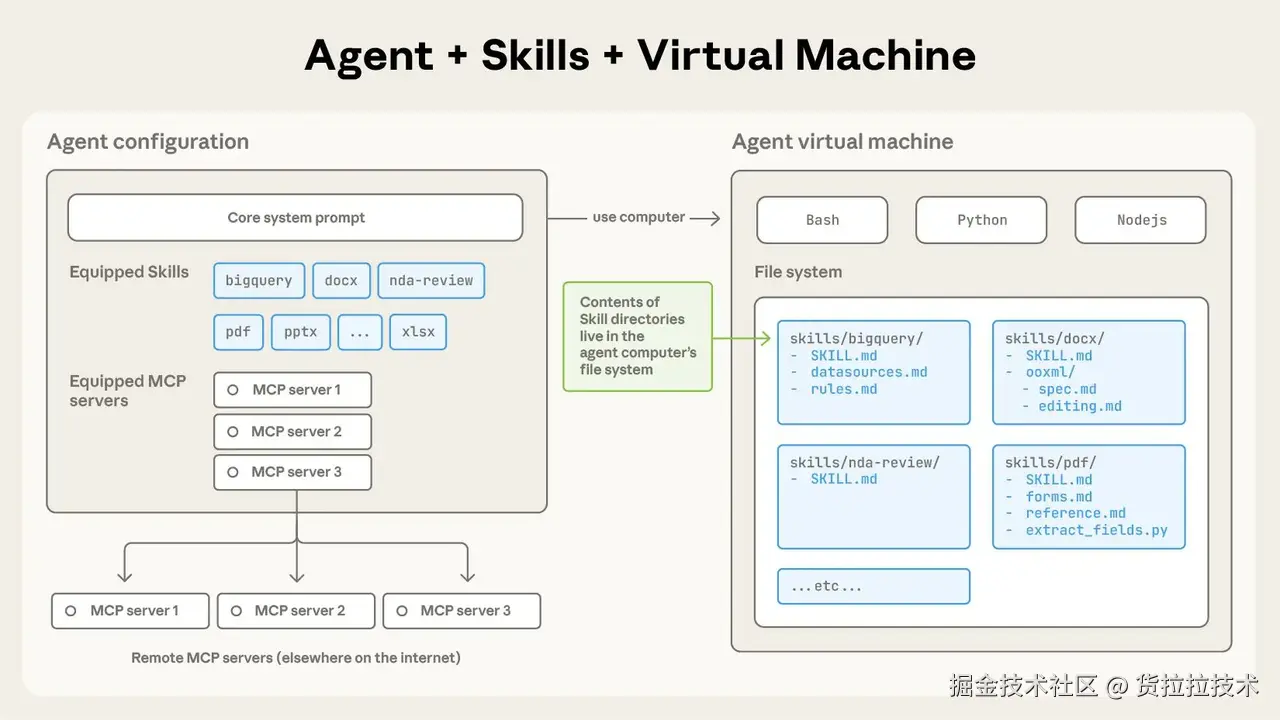

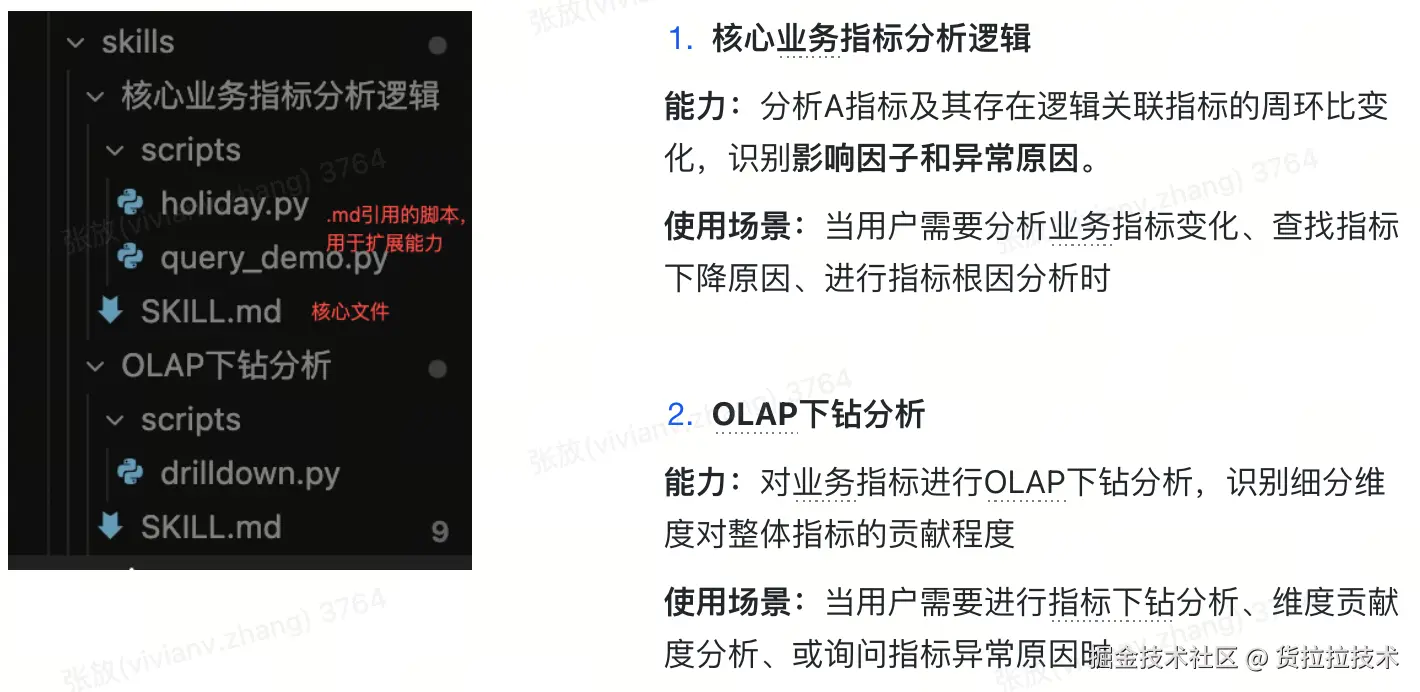

一、什么是 Skills?

1.1 核心概念

Agent Skills(智能体技能)是一种模块化的能力扩展系统,它为 Claude 提供了:

- 领域专业知识: 如 PDF 处理技巧、数据库 schema、业务规则

- 工作流程: 如代码审查流程、文档生成流程、数据分析流程

- 最佳实践: 如命名规范、代码风格、错误处理模式

1.2 Skills vs 普通 Prompt

| 维度 | 普通 Prompt | Skills |

|---|---|---|

| 作用范围 | 单次对话 | 跨所有相关对话 |

| 加载方式 | 每次手动提供 | 相关任务时自动加载 |

| 上下文占用 | 每次都占用 | 按需加载,未使用时零占用 |

| 知识管理 | 分散在多次对话中 | 集中管理,持续优化 |

| 一致性 | 依赖人工记忆 | 标准化,确保一致 |

类比理解:

- 普通 Prompt 像是每次都要"现场培训"新员工

- Skills 像是给员工提供"岗位手册",需要时自己查阅

1.3 Skills 遵循开放标准

Claude Code Skills 基于 Agent Skills 开放标准,这意味着:

- ✅ 标准化格式,跨 AI 工具兼容

- ✅ 社区生态,可以使用他人创建的 Skills

- ✅ 长期支持,不会因产品升级而失效

Claude Code 在标准基础上扩展了:

- 🔧 调用控制机制

- 🤖 子代理执行能力

- 📥 动态上下文注入

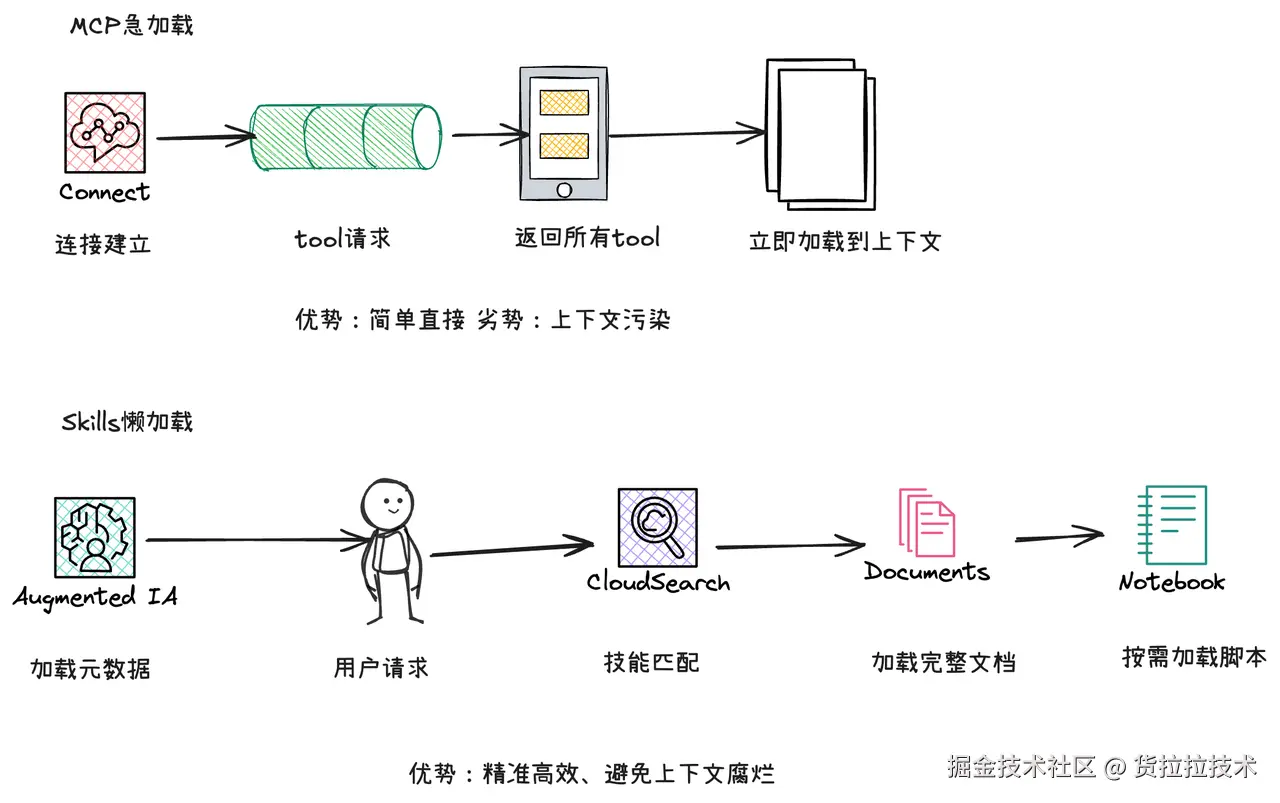

二、Skills 工作原理:渐进式披露架构

2.1 为什么需要渐进式披露?

问题:如果把所有 Skills 的详细内容都加载到上下文中会怎样?

假设你有 10 个 Skills,每个包含 5000 tokens 的详细指导...

总共: 50,000 tokens

但你可能只需要使用其中 1-2 个 Skill!

浪费: 40,000+ tokens(80% 的上下文窗口!)

解决方案:渐进式披露——只加载需要的内容,按需展开详细信息。

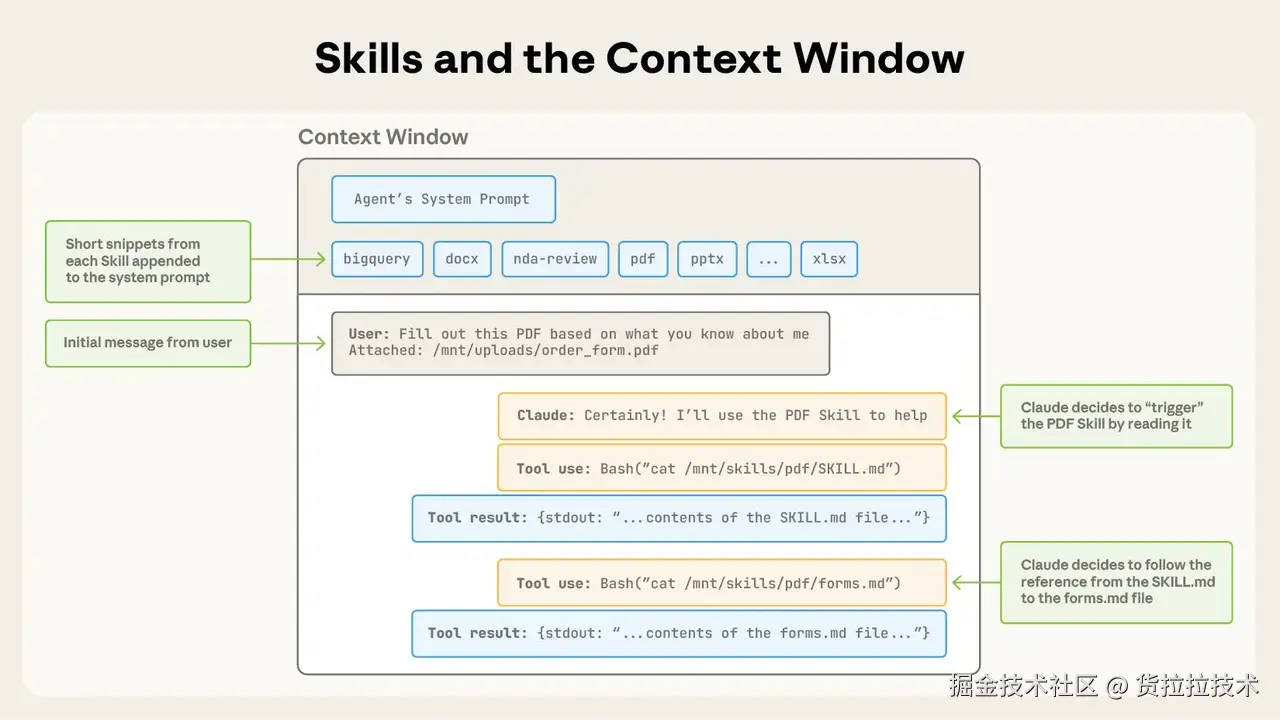

2.2 三级加载机制

第一级:元数据(Metadata)- 始终加载

---

name: pdf-processing

description: Extract text and tables from PDF files, fill forms, merge documents.

Use when working with PDF files or when the user mentions PDFs, forms,

or document extraction.

---

- 加载时机: Claude 启动时

- Token 消耗: 每个 Skill 约 100 tokens

- 作用: 让 Claude 知道有哪些 Skills 可用,以及何时触发

关键字段解析:

name: Skill 标识符(小写字母、数字、连字符)description: 功能说明 + 触发场景(最重要的字段!)

⚠️ 重要: description 是 Skill 触发的关键。Claude 根据用户请求与 description 的匹配度决定是否加载该 Skill。

第二级:指令(Instructions)- 触发时加载

# PDF Processing

## Quick start

Use pdfplumber to extract text from PDFs:

\`\`\`python

import pdfplumber

with pdfplumber.open("document.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

For advanced form filling, see [FORMS.md](FORMS.md).

- 加载时机: 当用户请求匹配 Skill 描述时

- Token 消耗: 通常少于 5k tokens

- 作用: 提供具体的操作指导和工作流程

第三级:资源和代码(Resources & Code)- 按需访问

pdf-skill/

├── SKILL.md # 主指令文件(第二级)

├── FORMS.md # 表单填写指南(按需读取)

├── REFERENCE.md # 详细 API 参考(按需读取)

└── scripts/

└── fill_form.py # 工具脚本(执行时不加载代码)

- 加载时机: 仅当 SKILL.md 中引用时

- Token 消耗: 脚本执行时只有输出占用 tokens

- 作用: 提供专业参考材料和可执行工具

2.3 实例演示:从触发到加载

场景: 用户请求"帮我提取 PDF 中的文本"

┌─────────────────────────────────────────┐

│ 步骤 1: Claude 检查所有 Skill 的元数据 │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 匹配到 pdf-processing Skill │

│ description 包含 "Extract text from PDF"│

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 步骤 2: 加载 SKILL.md 的指令内容 │

│ (~3k tokens) │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 步骤 3: Claude 发现需要表单填写 │

│ 读取 FORMS.md (~2k tokens) │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 总 Token 消耗: 约 5k tokens │

│ 其他 9 个 Skills: 0 tokens(未加载) │

└─────────────────────────────────────────┘

对比无渐进式披露:

❌ 传统方式: 10 个 Skills × 5k = 50k tokens

✅ 渐进式披露: 只加载 1 个 Skill = 5k tokens

节省: 45k tokens (90% 的上下文!)

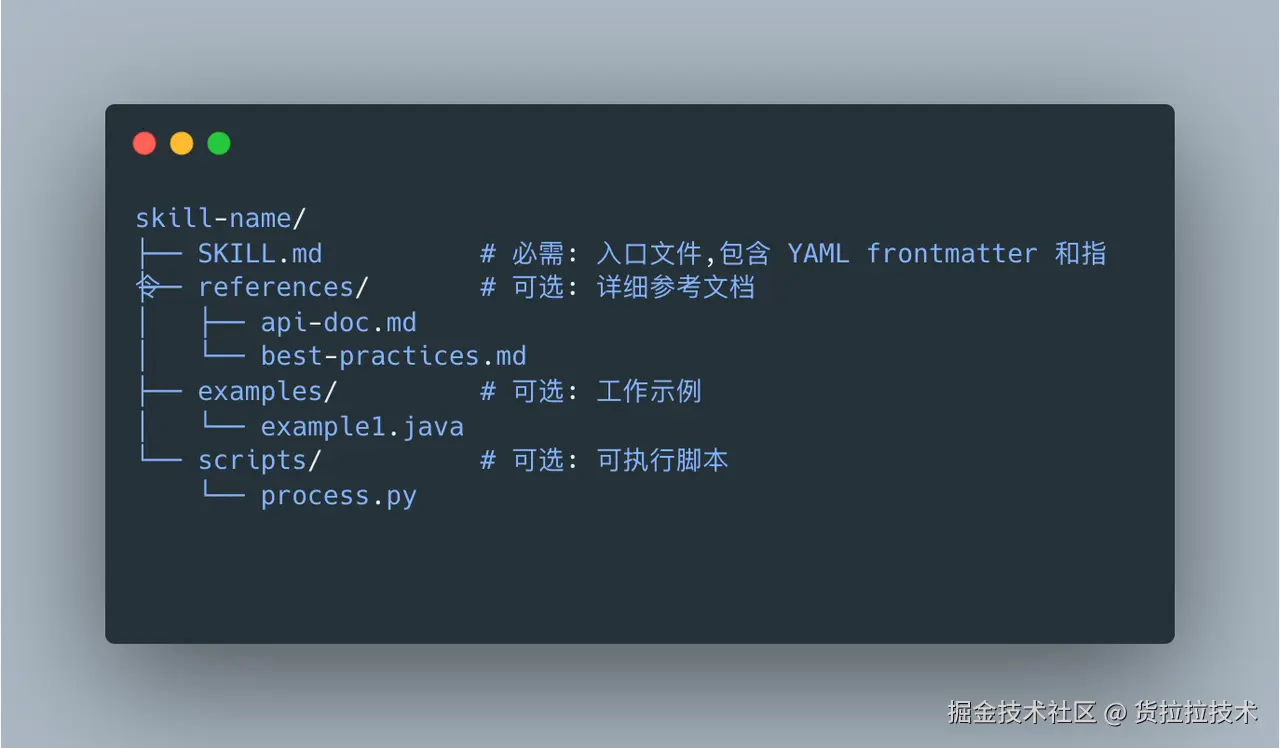

三、Skills 的文件结构

3.1 最小化 Skill

最简单的 Skill 只需要一个文件:

my-skill/

└── SKILL.md # 唯一必需的文件

SKILL.md 示例:

---

name: code-review-checklist

description: Provides a code review checklist for pull requests. Use when reviewing code or when the user asks for code review guidelines.

---

# Code Review Checklist

When reviewing code, check:

1. **Functionality**: Does the code do what it's supposed to?

2. **Readability**: Is the code easy to understand?

3. **Tests**: Are there appropriate tests?

4. **Performance**: Are there any obvious performance issues?

5. **Security**: Are there any security vulnerabilities?

For each item, provide specific feedback with examples.

3.2 完整 Skill 结构

对于复杂的 Skills,可以组织成多文件结构:

pdf-processing-skill/

├── SKILL.md # 核心指令(必需)

├── FORMS.md # 表单填写详细指南

├── REFERENCE.md # PDF 库 API 参考

├── EXAMPLES.md # 常见用例示例

└── scripts/

├── analyze_form.py # 分析表单工具

├── fill_form.py # 填写表单工具

└── validate.py # 验证输出工具

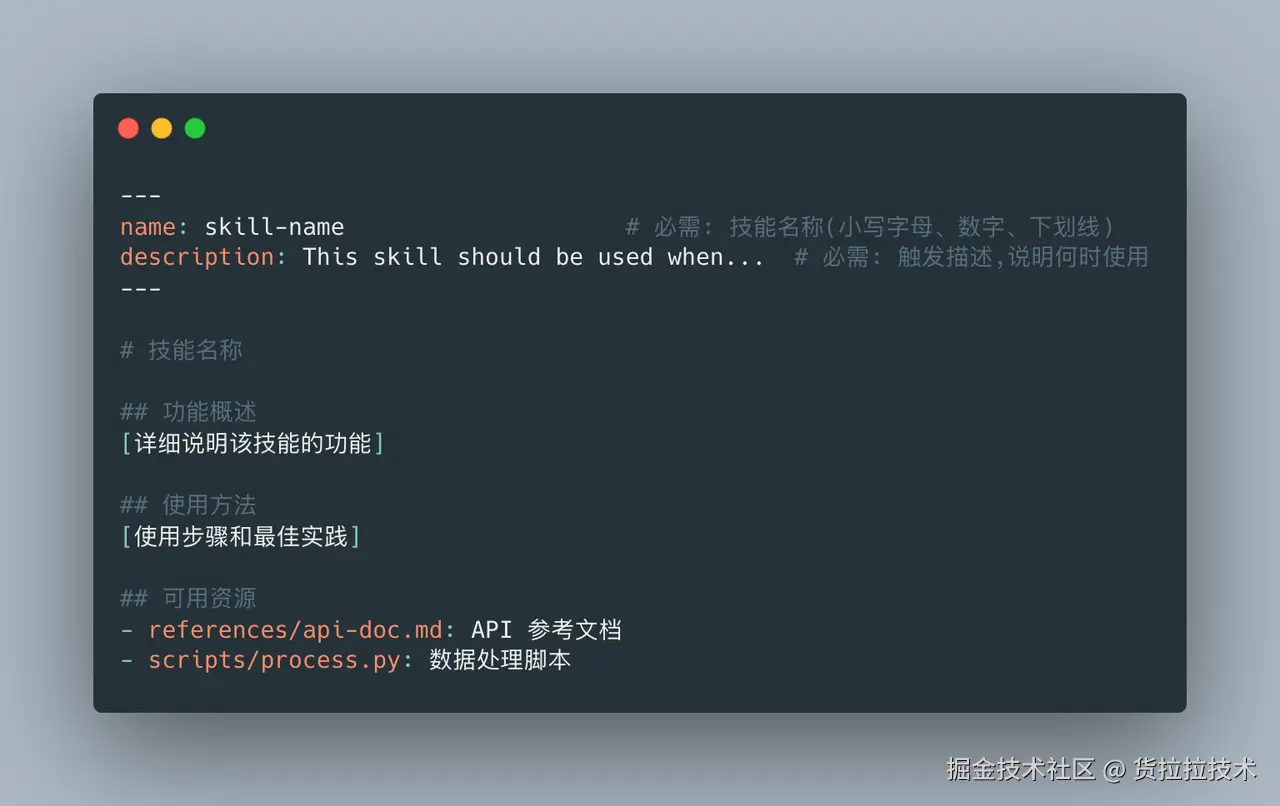

3.3 YAML Frontmatter 规范

必填字段:

---

name: skill-name # 必填

description: Skill description # 必填

---

字段要求:

| 字段 | 要求 | 示例 |

|---|---|---|

| name | 小写字母、数字、连字符 最多 64 字符 禁止 "anthropic"、"claude" | pdf-processingbigquery-analyticscode-reviewer |

| description | 非空 最多 1024 字符 包含功能 + 触发场景 第三人称描述 | Extract text from PDFs. Use when...Analyze BigQuery data. Use when... |

命名规范:

✅ 推荐: 动名词形式(Gerund Form)

processing-pdfs

analyzing-spreadsheets

reviewing-code

managing-databases

❌ 避免: 过于模糊

helper # 太模糊

utils # 不知道干什么

tool # 功能不明确

3.4 Description 字段的重要性

⚠️ 警告: description 是 Skill 触发的关键,必须用第三人称!

为什么必须第三人称?

description 会被注入到系统提示中,视角不一致会导致困惑:

系统提示: "You are Claude, an AI assistant..."

Skill description: "I can help you process PDFs" # ❌ 第一人称,视角冲突!

正确示例:

---

name: pdf-processing

description: Extract text and tables from PDF files, fill forms, merge documents.

Use when working with PDF files or when the user mentions PDFs, forms,

or document extraction.

---

不正确示例:

❌ description: I can help you process Excel files # 第一人称

❌ description: You can use this to process Excel # 第二人称

❌ description: Helps with documents # 过于模糊

编写技巧:

- 明确功能: 说清楚 Skill 能做什么

- 包含关键词: 用户可能使用的术语(PDF、Excel、BigQuery 等)

- 触发场景: 明确何时使用("Use when...")

- 简洁精准: 1-2 句话说清楚

四、创建你的第一个 Skill

4.1 确定需求

问题导向:

问自己:

- 我反复向 Claude 解释什么内容?

- 哪些领域知识 Claude 不太了解?

- 哪些工作流程需要标准化?

示例场景:

场景 1: BigQuery 数据分析

- ❌ 每次都要说明表结构

- ❌ 每次都要强调"排除测试账户"

- ❌ 每次都要说明查询模式

- ✅ 创建一个 BigQuery Skill!

场景 2: 公司文档规范

- ❌ 每次都要说明文档模板

- ❌ 每次都要强调格式要求

- ❌ 每次都要纠正不符合规范的部分

- ✅ 创建一个文档规范 Skill!

4.2 编写 SKILL.md

步骤 1: 创建目录和文件

mkdir my-bigquery-skill

cd my-bigquery-skill

touch SKILL.md

步骤 2: 编写 YAML Frontmatter

---

name: bigquery-analytics

description: Analyze BigQuery data from the user_metrics and sales tables. Use when the user asks about data analysis, metrics, or BigQuery queries. Always exclude test accounts and apply standard date filters.

---

步骤 3: 编写核心指令

# BigQuery Analytics

## Database Schema

### user_metrics table

- user_id (STRING): Unique user identifier

- event_date (DATE): Event date

- metrics_value (FLOAT): Metric value

- account_type (STRING): "production" or "test"

### sales table

- order_id (STRING): Order identifier

- user_id (STRING): User ID (foreign key to user_metrics)

- amount (FLOAT): Order amount

- order_date (DATE): Order date

## Standard Filtering Rules

**Always apply these filters:**

1. Exclude test accounts: `WHERE account_type = 'production'`

2. Date range: Default to last 30 days unless specified

3. Remove null values: `WHERE metrics_value IS NOT NULL`

## Query Patterns

### Pattern 1: User activity analysis

\`\`\`sql

SELECT

event_date,

COUNT(DISTINCT user_id) as active_users,

AVG(metrics_value) as avg_metric

FROM user_metrics

WHERE account_type = 'production'

AND event_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 30 DAY)

GR0UP BY event_date

ORDER BY event_date;

\`\`\`

### Pattern 2: Sales analysis

\`\`\`sql

SELECT

DATE_TRUNC(order_date, MONTH) as month,

COUNT(*) as order_count,

SUM(amount) as total_revenue

FROM sales s

JOIN user_metrics u ON s.user_id = u.user_id

WHERE u.account_type = 'production'

GR0UP BY month

ORDER BY month;

\`\`\`

## Important Notes

- **Performance**: Always use partitioned date fields in WHERE clause

- **Costs**: Preview query cost before running on large datasets

- **Timezone**: All dates are in UTC

五、核心最佳实践

5.1 简洁为王(Conciseness is Key)

核心原则: 上下文窗口是公共资源,你的 Skill 要与系统提示、对话历史、其他 Skills 共享。

✅ 好的示例(约 50 tokens)

## Extract PDF Text

Use pdfplumber for text extraction:

\`\`\`python

import pdfplumber

with pdfplumber.open("file.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

❌ 糟糕的示例(约 150 tokens)

## Extract PDF Text

PDF(便携式文档格式)是一种常见的文件格式,包含文本、图像等内容。

要从 PDF 中提取文本,你需要使用一个库。有很多 PDF 处理库可用,

但我们推荐 pdfplumber,因为它易于使用且能处理大多数情况。

首先,你需要使用 pip 安装它。然后你可以使用下面的代码...

为什么简洁版更好?

- ✅ 假设 Claude 已经知道 PDF 是什么

- ✅ 假设 Claude 知道库的工作原理

- ✅ 直接提供关键信息:用什么库、怎么用

- ✅ 节省 100 tokens,留给其他 Skills 使用

⚠️ 记住: 不要低估 Claude 的智能!它是通用 AI,不需要你解释基础概念。

5.2 设置适当的自由度

根据任务的脆弱性和可变性,选择合适的指导程度。

🌟 高自由度(基于文本的指令)

适用场景:

- 多种方法都可行

- 决策依赖上下文

- 启发式方法指导

示例:代码审查流程

## Code Review Process

1. Analyze code structure and organization

2. Check for potential bugs or edge cases

3. Suggest improvements for readability and maintainability

4. Verify compliance with project standards

特点: 给出大方向,信任 Claude 根据具体情况调整。

🎯 中等自由度(伪代码或带参数的脚本)

适用场景:

- 存在首选模式

- 允许一定变化

- 配置影响行为

示例:生成报告

## Generate Report

Use this template and customize as needed:

\`\`\`python

def generate_report(data, format="markdown", include_charts=True):

# Process data

# Generate output in specified format

# Optionally include visualizations

\`\`\`

特点: 提供模板和参数,允许根据需求调整。

🔒 低自由度(特定脚本,少量或无参数)

适用场景:

- 操作易错且脆弱

- 一致性至关重要

- 必须遵循特定顺序

示例:数据库迁移

## Database Migration

Execute this script strictly:

\`\`\`bash

python scripts/migrate.py --verify --backup

\`\`\`

Do not modify the command or add extra parameters.

特点: 精确指令,不允许偏离。

🌉 类比理解

把 Claude 想象成在不同地形上探索的机器人:

- 悬崖边的窄桥(低自由度): 只有一条安全路径 → 提供详细护栏和精确指令

- 丘陵地带(中等自由度): 几条推荐路径 → 提供地图和指南针

- 无障碍的开阔草地(高自由度): 多条路径都能成功 → 给出大致方向,信任 Claude 找到最佳路线

5.3 渐进式披露模式

模式 1:高层指南 + 引用

结构:

SKILL.md (简要指南)

↓ 引用

[FORMS.md] [REFERENCE.md] [EXAMPLES.md]

示例:

# PDF Processing

## Quick Start

Use pdfplumber to extract text:

\`\`\`python

import pdfplumber

with pdfplumber.open("file.pdf") as pdf:

text = pdf.pages[0].extract_text()

\`\`\`

## Advanced Features

**Form Filling**: See [FORMS.md](FORMS.md) for complete guide

**API Reference**: See [REFERENCE.md](REFERENCE.md) for all methods

**Examples**: See [EXAMPLES.md](EXAMPLES.md) for common patterns

优势:

- Claude 只在需要时才读取 FORMS.md、REFERENCE.md 或 EXAMPLES.md

- 未使用的文件 = 0 tokens 消耗

模式 2:按领域组织

适用场景: 多领域的 Skills,避免加载无关上下文

结构:

bigquery-skill/

├── SKILL.md # 概述和导航

└── reference/

├── finance.md # 财务指标

├── sales.md # 销售数据

├── product.md # 产品分析

└── marketing.md # 营销活动

示例:

# BigQuery Analytics

## Domain Reference

- **Finance Metrics**: See [reference/finance.md](reference/finance.md)

- **Sales Data**: See [reference/sales.md](reference/sales.md)

- **Product Analytics**: See [reference/product.md](reference/product.md)

- **Marketing Campaigns**: See [reference/marketing.md](reference/marketing.md)

优势:

- 用户询问销售指标时,只读取 sales.md

- finance.md 和其他文件保持在文件系统中,消耗 0 tokens

模式 3:条件细节

# DOCX Processing

## Create Documents

Use docx-js to create new documents. See [DOCX-JS.md](DOCX-JS.md).

## Edit Documents

For simple edits, modify XML directly.

**Track Changes**: See [REDLINING.md](REDLINING.md)

**OOXML Details**: See [OOXML.md](OOXML.md)

优势:

- 常见操作(创建文档)在主文件中

- 高级功能(追踪更改)按需引用

💡 重要: 保持引用层级为一级深度。避免 SKILL.md → advanced.md → details.md 这样的深层嵌套。

5.4 工作流和反馈循环

复杂任务的工作流模式

为多步骤任务提供清晰的检查清单:

## PDF Form Filling Workflow

Copy this checklist and track progress:

\`\`\`

Task Progress:

- [ ] Step 1: Analyze form (run analyze_form.py)

- [ ] Step 2: Create field mapping (edit fields.json)

- [ ] Step 3: Validate mapping (run validate_fields.py)

- [ ] Step 4: Fill form (run fill_form.py)

- [ ] Step 5: Verify output (run verify_output.py)

\`\`\`

**Step 1: Analyze Form**

Run: `python scripts/analyze_form.py input.pdf`

This extracts form fields and their locations, saving to `fields.json`.

**Step 2: Create Field Mapping**

Edit `fields.json` to add values for each field.

**Step 3: Validate Mapping**

Run: `python scripts/validate_fields.py fields.json`

Fix any validation errors before proceeding.

**Step 4: Fill Form**

Run: `python scripts/fill_form.py input.pdf fields.json output.pdf`

**Step 5: Verify Output**

Run: `python scripts/verify_output.py output.pdf`

If validation fails, return to Step 2.

实现反馈循环

常见模式: 运行验证器 → 修复错误 → 重复

这种模式极大提高输出质量。

示例:文档编辑流程

## Document Editing Flow

1. Make edits to `word/document.xml`

2. **Validate immediately**: `python ooxml/scripts/validate.py unpacked_dir/`

3. If validation fails:

- Review error messages carefully

- Fix issues in XML

- Run validation again

4. **Only proceed when validation passes**

5. Repack: `python ooxml/scripts/pack.py unpacked_dir/ output.docx`

6. Test output document

为什么反馈循环重要?

- ✅ 及早发现错误(在应用更改前)

- ✅ 机器可验证(脚本提供客观验证)

- ✅ 可逆计划(Claude 可以迭代而不破坏原始文件)

- ✅ 清晰调试(错误消息指向具体问题)

5.5 内容指南

避免时间敏感信息

❌ 糟糕示例(会过时):

如果你在 2025 年 8 月之前做这件事,使用旧 API。

2025 年 8 月之后,使用新 API。

✅ 好的示例(使用"旧模式"部分):

## Current Method

Use v2 API endpoint: `api.example.com/v2/messages`

## Legacy Patterns

<details>

<summary>Legacy v1 API (deprecated 2025-08)</summary>

v1 API uses: `api.example.com/v1/messages`

This endpoint is no longer supported.

</details>

使用一致的术语

在整个 Skill 中选择一个术语并坚持使用:

✅ 一致性好:

- 始终使用 "API endpoint"

- 始终使用 "field"

- 始终使用 "extract"

❌ 不一致:

- 混用 "API endpoint"、"URL"、"API route"、"path"

- 混用 "field"、"box"、"element"、"control"

- 混用 "extract"、"pull"、"get"、"retrieve"

六、高级技巧

6.1 包含可执行代码的 Skills

解决问题,而非推卸责任

编写 Skills 脚本时,显式处理错误情况,而非推卸给 Claude。

✅ 好的示例:显式处理错误

def process_file(path):

"""处理文件,如果不存在则创建。"""

try:

with open(path) as f:

return f.read()

except FileNotFoundError:

# 创建默认内容而非失败

print(f"文件 {path} 未找到,创建默认文件")

with open(path, 'w') as f:

f.write('')

return ''

except PermissionError:

# 提供替代方案而非失败

print(f"无法访问 {path},使用默认值")

return ''

❌ 糟糕示例:推卸给 Claude

def process_file(path):

# 直接失败,让 Claude 自己想办法

return open(path).read()

提供工具脚本

即使 Claude 可以编写脚本,预制脚本也有优势:

工具脚本的好处:

- 比生成代码更可靠

- 节省 tokens(无需在上下文中包含代码)

- 节省时间(无需代码生成)

- 确保使用的一致性

示例:

## Tool Scripts

**analyze_form.py**: Extract all form fields from PDF

\`\`\`bash

python scripts/analyze_form.py input.pdf > fields.json

\`\`\`

Output format:

\`\`\`json

{

"field_name": {"type": "text", "x": 100, "y": 200},

"signature": {"type": "sig", "x": 150, "y": 500}

}

\`\`\`

**validate_boxes.py**: Check for boundary box overlaps

\`\`\`bash

python scripts/validate_boxes.py fields.json

# Returns: "OK" or lists conflicts

\`\`\`

**fill_form.py**: Apply field values to PDF

\`\`\`bash

python scripts/fill_form.py input.pdf fields.json output.pdf

\`\`\`

💡 重要区分: 在指令中明确说明 Claude 应该:

- 执行脚本(最常见): "运行 analyze_form.py 以提取字段"

- 读取作为参考(用于复杂逻辑): "参见 analyze_form.py 了解字段提取算法"

6.2 创建可验证的中间输出

当 Claude 执行复杂、开放式任务时,可能会出错。"计划-验证-执行"模式通过让 Claude 首先创建结构化格式的计划,然后在执行前用脚本验证该计划,从而及早发现错误。

示例场景

要求: Claude 根据电子表格更新 PDF 中的 50 个表单字段。

没有验证:Claude 可能:

- ❌ 引用不存在的字段

- ❌ 创建冲突的值

- ❌ 遗漏必填字段

- ❌ 错误应用更新

有验证:工作流变为:

分析 → 创建计划文件 → 验证计划 → 执行 → 验证输出

添加一个中间 changes.json 文件,在应用更改前进行验证。

实现示例

## Bulk Form Update Workflow

**Step 1: Analyze**

- Extract current form fields

- Save to `current_fields.json`

**Step 2: Create Change Plan**

- Based on spreadsheet, create `changes.json`:

\`\`\`json

{

"field_updates": [

{"field": "customer_name", "value": "John Doe"},

{"field": "order_total", "value": "1250.00"}

]

}

\`\`\`

**Step 3: Validate Plan**

- Run: `python scripts/validate_changes.py changes.json`

- Script checks:

- All referenced fields exist

- Values are in correct format

- No conflicts

- **Only proceed if validation passes**

**Step 4: Execute**

- Apply changes: `python scripts/apply_changes.py changes.json`

**Step 5: Verify Output**

- Run: `python scripts/verify_output.py output.pdf`

为什么此模式有效

- 及早发现错误: 在应用更改前验证发现问题

- 机器可验证: 脚本提供客观验证

- 可逆计划: Claude 可以在不触及原始文件的情况下迭代计划

- 清晰调试: 错误消息指向具体问题

使用时机

- 批量操作

- 破坏性更改

- 复杂验证规则

- 高风险操作

💡 实现技巧: 让验证脚本输出详细的错误消息:

❌ 模糊: "Validation failed"

✅ 清晰: "Field 'signature_date' not found. Available fields: customer_name, order_total, signature_date_signed"

这帮助 Claude 快速修复问题。

6.3 MCP 工具引用

如果你的 Skill 使用 MCP(Model Context Protocol)工具,始终使用完全限定的工具名称以避免"工具未找到"错误。

格式

ServerName:tool_name

示例

## Query Database Schema

Use the BigQuery:bigquery_schema tool to retrieve table schema.

\`\`\`

Use tool: BigQuery:bigquery_schema

Parameters: {"table": "user_metrics"}

\`\`\`

## Create GitHub Issue

Use the GitHub:create_issue tool to create an issue.

\`\`\`

Use tool: GitHub:create_issue

Parameters: {"title": "Bug report", "body": "Description"}

\`\`\`

说明

BigQuery和GitHub是 MCP 服务器名称bigquery_schema和create_issue是这些服务器中的工具名称

没有服务器前缀,Claude 可能无法找到工具,特别是当有多个 MCP 服务器可用时。

七、常见反模式

❌ 反模式 1:Windows 风格路径

问题:使用反斜杠 \ 作为路径分隔符

❌ 错误:

参见 scripts\helper.py

参见 reference\guide.md

✅ 正确:

参见 scripts/helper.py

参见 reference/guide.md

原因:

- Unix 风格路径跨所有平台工作

- Windows 风格路径在 Unix 系统上会导致错误

❌ 反模式 2:提供太多选项

问题:列出所有可能的方法,让 Claude 困惑

❌ 错误:

你可以使用 pypdf,或 pdfplumber,或 PyMuPDF,或 pdf2image,

或 pikepdf,或 PyPDF2,或 pdfrw,或 pdfminer...

✅ 正确:

使用 pdfplumber 进行文本提取:

\`\`\`python

import pdfplumber

\`\`\`

对于需要 OCR 的扫描 PDF,改用 pdf2image 配合 pytesseract。

原则:

- 提供默认推荐方法

- 只在特殊情况下提供替代方案

- 不要列出所有可能性

❌ 反模式 3:深层嵌套引用

问题:引用链太长,Claude 难以跟踪

❌ 错误:

SKILL.md → advanced.md → details.md → examples.md

✅ 正确:

SKILL.md

↓ 直接引用

[ADVANCED.md] [DETAILS.md] [EXAMPLES.md]

原则:

- 保持从 SKILL.md 的引用为一级深度

- 所有引用文件应直接从 SKILL.md 链接

❌ 反模式 4:过度解释基础概念

问题:解释 Claude 已经知道的内容

❌ 错误:

PDF(Portable Document Format,便携式文档格式)是 Adobe 公司

开发的一种文件格式,可以在不同操作系统上保持一致的显示效果。

PDF 文件包含文本、图像、矢量图形等多种内容类型...

✅ 正确:

使用 pdfplumber 提取 PDF 文本。

原则:

- 假设 Claude 的智能

- 只提供 Claude 不知道的领域特定知识

❌ 反模式 5:第一人称描述

问题:使用"我"、"你"等人称

❌ 错误:

description: I can help you process Excel files and generate reports.

✅ 正确:

description: Process Excel files and generate reports. Use when working with spreadsheets or when the user mentions Excel, CSV, or data analysis.

原因:

- description 被注入系统提示

- 第一人称会导致视角冲突

八、总结与行动

8.1 核心收益

通过 Skills 系统,你可以:

- ⏱️ 节省时间: 不用每次重复说明领域知识

- ✅ 保证质量: 标准化流程,减少错误

- 📚 积累知识: 把最佳实践封装成 Skills,团队共享

- 🚀 提升专业性: 让 Claude 从通用助手进化为领域专家

- 🔧 持续优化: 基于使用反馈不断改进 Skills

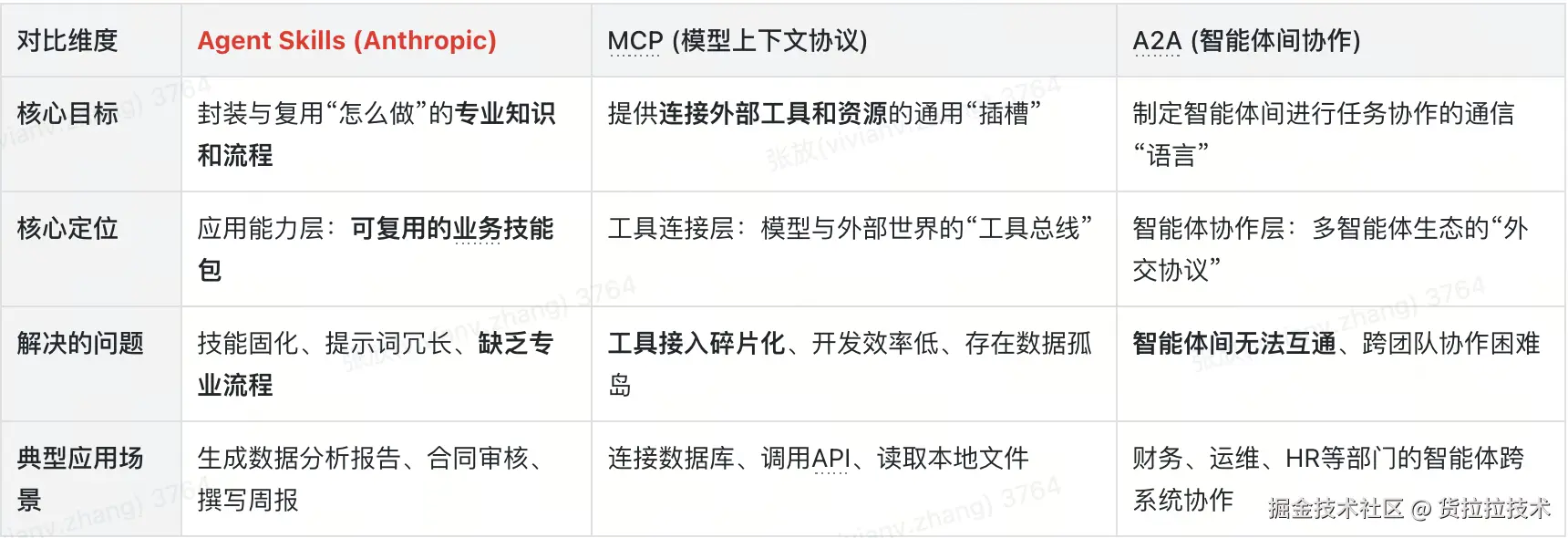

8.2 Skills 与其他功能的关系

| 功能 | 作用 | 与 Skills 的关系 |

|---|---|---|

| Agent | 处理复杂、多步骤任务 | Skills 为 Agent 提供领域知识 |

| MCP | 连接外部工具和数据源 | Skills 可以引用 MCP 工具 |

| claude.md | 项目级配置和规范 | Skills 是跨项目的能力扩展 |

| Hook | 事件触发的自动化 | Hook 可以在特定时机加载 Skills |

8.3 实践建议

对于个人开发者:

- 从一个简单的 Skill 开始(如代码审查清单)

- 识别自己反复解释的内容

- 逐步添加更多 Skills

- 持续优化基于实际使用

对于团队:

- 建立团队 Skills 仓库

- 统一 Skills 开发规范

- 定期分享优秀 Skills

- 建立 Skills 评审机制

对于技术 Leader:

- 推广 Skills 使用文化

- 组织 Skills 开发培训

- 激励团队贡献 Skills

- 建立 Skills 质量标准

8.4 未来展望

Skills 系统的发展方向:

- 可视化 Skill Builder: 通过图形界面创建 Skills

- Skill 市场: 官方 Skills 商店,一键安装分享

- AI 生成 Skills: 描述需求,AI 自动生成 Skills

- Skill 编排: 多个 Skills 组合成工作流

- 实时协作: 团队实时共享和更新 Skills

"把你反复向 Claude 解释的偏好、流程、领域知识打包成 Skills,让 AI 成为你的领域专家"

实用资源

🔗 相关文章:

如果这篇文章对你有帮助,欢迎点赞、收藏、分享!有任何问题或建议,欢迎在评论区留言讨论。让我们一起学习,一起成长!

也欢迎访问我的个人主页发现更多宝藏资源

来源:juejin.cn/post/7608382961723555890

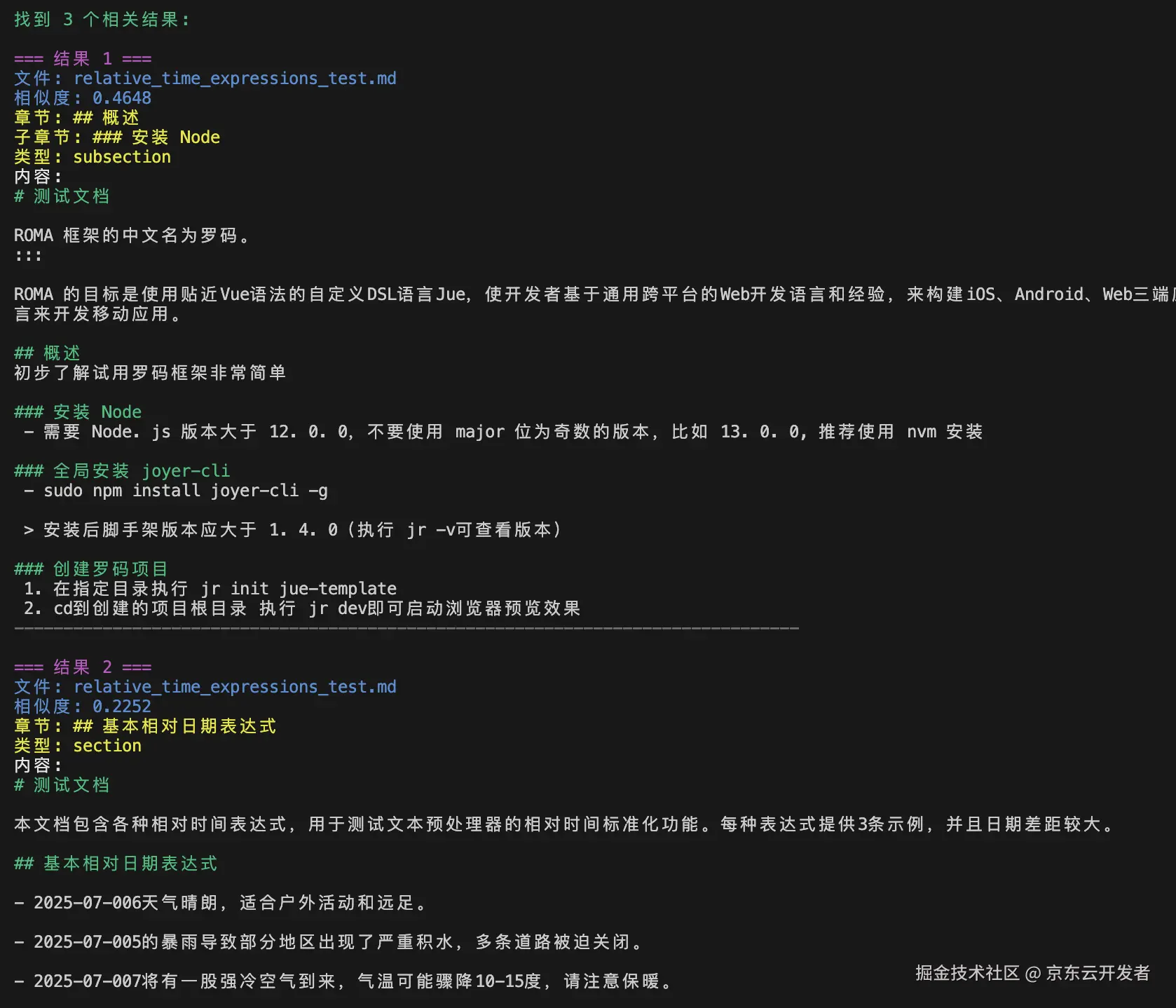

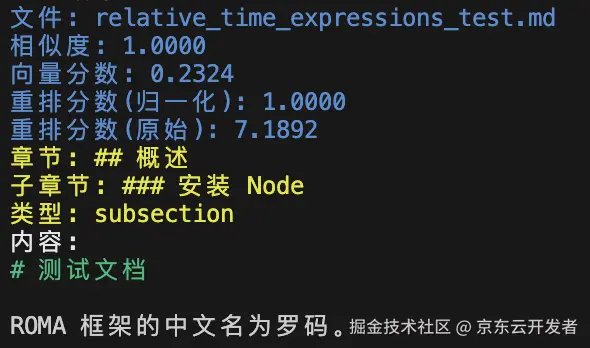

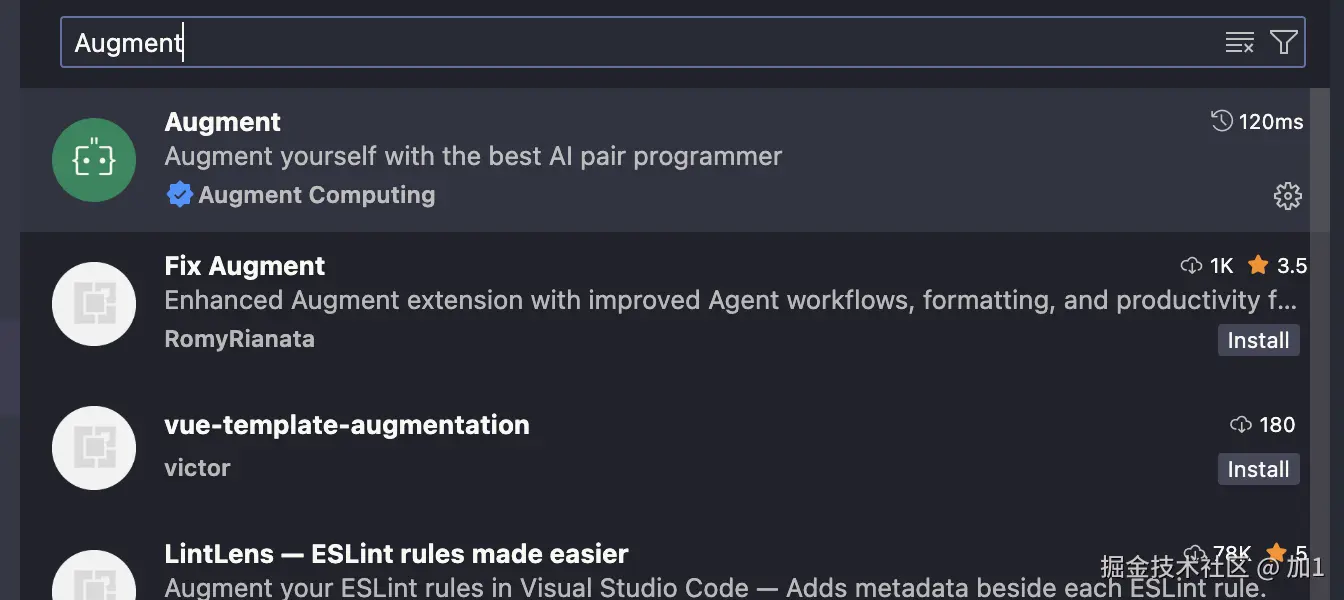

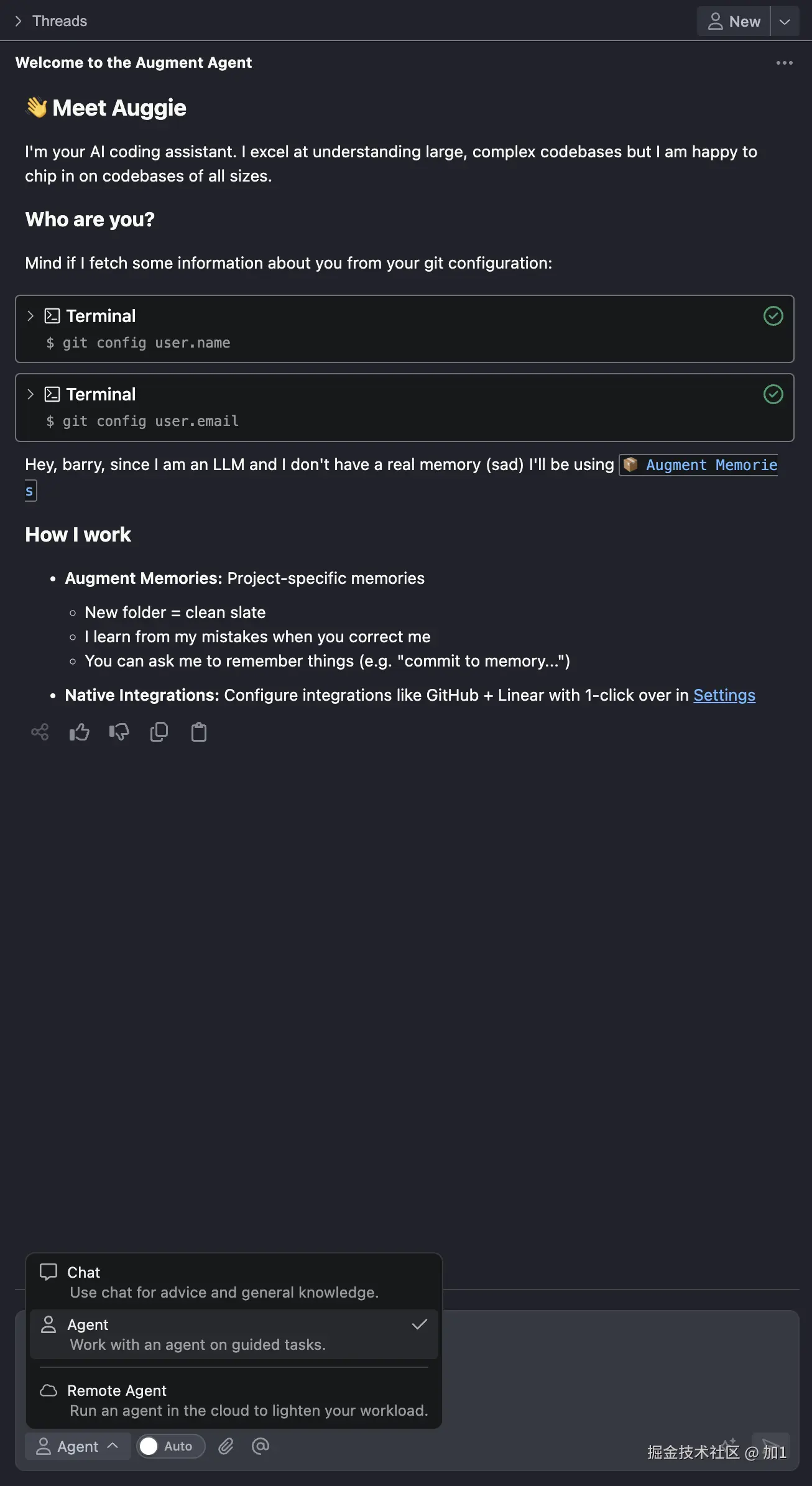

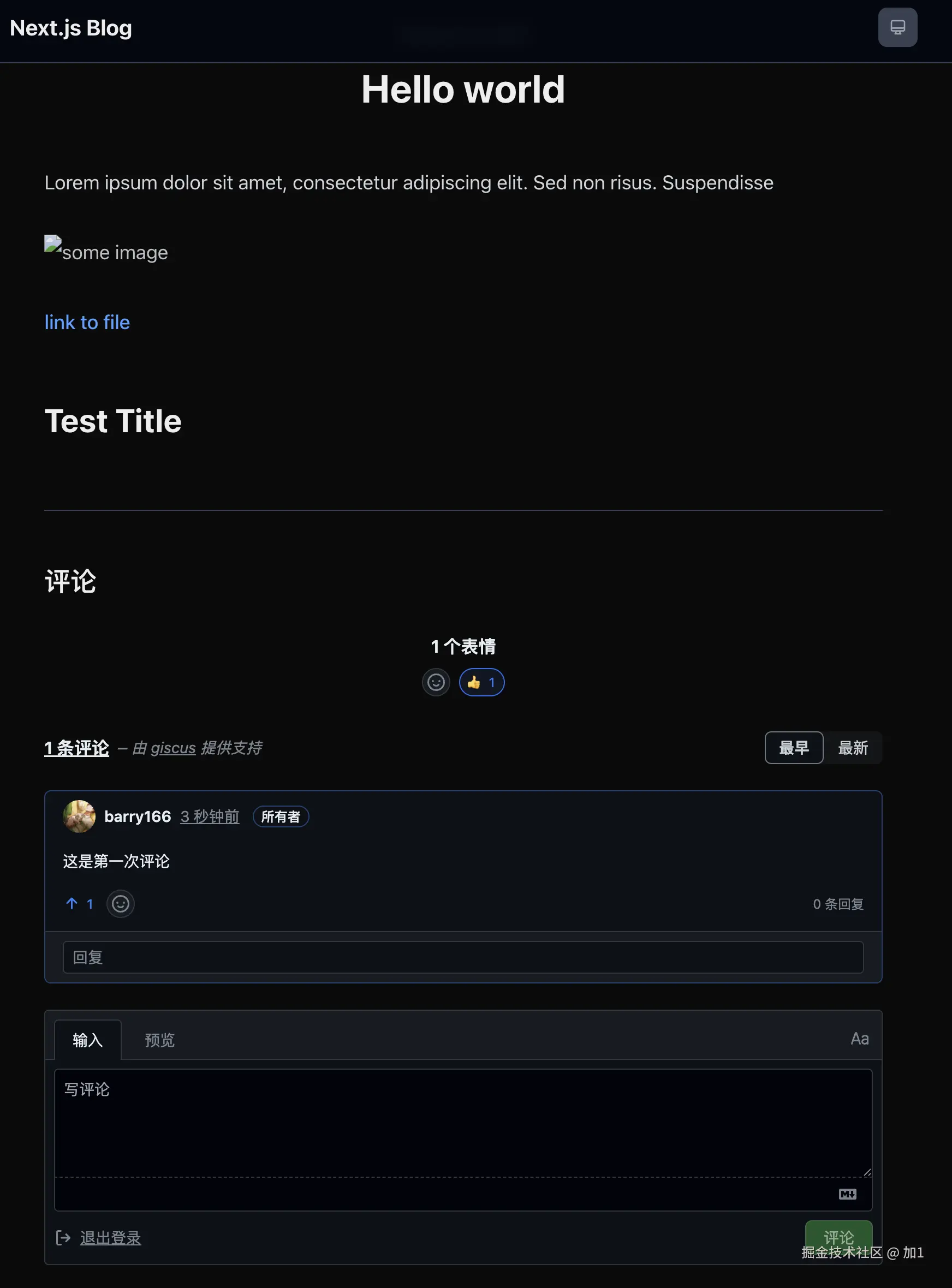

OpenClaw安装

前置条件

环境

openclaw需要Node.js 22或者更高版本

笔者在CentOS 7虚拟机上使用源码包安装或者fnm安装Node.js会提示这样那样的错误;

源码包安装会有环境的问题:python、g++版本太老……

用fnm安装后提示

node: /lib64/libstdc++.so.6: version `CXXABI_1.3.11' not found (required by node) node: /lib64/libstdc++.so.6: version `CXXABI_1.3.8' not found (required by node) node: /lib64/libstdc++.so.6: version `GLIBCXX_3.4.20' not found (required by node) node: /lib64/libstdc++.so.6: version `GLIBCXX_3.4.21' not found (required by node) node: /lib64/libstdc++.so.6: version `CXXABI_1.3.9' not found (required by node) node: /lib64/libm.so.6: version `GLIBC_2.27' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.27' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.28' not found (required by node) node: /lib64/libc.so.6: version `GLIBC_2.25' not found (required by node)

所以在自己的云服务器上搭建了

node安装

nodejs 网站地址可查看LTS版本

官方推荐这三种方式

nvm

官方给出的安装方式

# 下载并安装 nvm:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

# 代替重启 shell

\. "$HOME/.nvm/nvm.sh"

# 下载并安装 Node.js:

nvm install 24

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

但是这里会提示网络不可达,所以nvm我们采用离线的方式进行安装

解压

配置环境变量

- vi ~/.bashrc

export NVM_DIR="/usr/local/nvm-0.40.4"

[ -s "$NVM_DIR/nvm.sh" ] && \. "$NVM_DIR/nvm.sh" # This loads nvm

[ -s "$NVM_DIR/bash_completion" ] && \. "$NVM_DIR/bash_completion" # This loads nvm bash_completion

# 使其生效

source ~/.bashrc

验证

nvm -v

显示对应的版本号

查看可用的node版本

# 查看可安装的 node 版本

nvm ls-remote

安装对应的版本

# 安装指定版本的 node

nvm install 24.14.0

fnm

官方给出的安装方式

# 下载并安装 fnm:

curl -o- https://fnm.vercel.app/install | bash

# 下载并安装 Node.js:

fnm install 24

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:npm -v # Should print "11.9.0".

但是这里会提示网络不可达,所以fnm我们采用离线的方式进行安装

下载后解压

添加环境变量

- vi /etc/profile

# /usr/local/fnm-1.38.1为fnm解压后的存放位置并不是fnm文件的绝对路径,而是存放位置

export PATH=$PATH:/usr/local/fnm-1.38.1

# 使其生效

source /etc/profile

- vi ~/.bashrc

eval "$(fnm env --use-on-cd --shell bash)"

# 使其生效

source ~/.bashrc

验证

fnm --version

返回对应的版本号

Docker

官方给出的安装方式

# Docker 对每个操作系统都有特定的安装指导。

# 请参考 https://docker.com/get-started/ 给出的官方文档

# 拉取 Node.js Docker 镜像:

docker pull node:24-alpine

# 创建 Node.js 容器并启动一个 Shell 会话:

docker run -it --rm --entrypoint sh node:24-alpine

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

安装docker

非阿里云服务器,需将mirrors.cloud.aliyuncs.com替换为https://mirrors.al…

#添加Docker软件包源

sudo wget -O /etc/yum.repos.d/docker-ce.repo http://mirrors.cloud.aliyuncs.com/docker-ce/linux/centos/docker-ce.repo

# 【非阿里云服务区不需要执行这一步】执行后,该文件中的所有https://mirrors.aliyun.com都会被替换为http://mirrors.cloud.aliyuncs.com

sudo sed -i 's|https://mirrors.aliyun.com|http://mirrors.cloud.aliyuncs.com|g' /etc/yum.repos.d/docker-ce.repo

#安装Docker社区版本,容器运行时containerd.io,以及Docker构建和Compose插件

sudo yum -y install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

配置阿里云加速镜像

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://xxxx.mirror.aliyuncs.com"]

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker

直接拉取镜像由于网络的问题可能导致镜像拉取失败

下载好镜像上传到服务器进行加载

docker load -i node_24-alpine.tar

运行

# 创建 Node.js 容器并启动一个 Shell 会话:

docker run -it --rm --entrypoint sh node:24-alpine

docker run:

- 这是创建并启动一个新容器的命令。

-it:

- 这是两个参数的组合:

-i(interactive): 保持标准输入(STDIN)打开,即使没有附加到容器上。这让你能输入命令。-t(tty): 分配一个伪终端(pseudo-TTY)。这让你拥有一个类似真实终端的交互界面(支持颜色、自动补全等)。

- 作用:合起来就是让你能交互式地在容器里敲命令。

- 这是两个参数的组合:

--rm:

- 自动清理。当容器停止运行(退出)时,Docker 会自动删除这个容器实例及其写入层。

- 作用:防止产生大量“僵尸”容器占用磁盘空间,非常适合临时调试或测试。

--entrypoint sh:

- 覆盖入口点。

- 通常,

node:24-alpine镜像的默认入口点(Entrypoint)是node命令。如果你直接运行docker run node:24-alpine,它会尝试运行node但没有脚本文件,通常会报错或直接退出。 - 这里指定为

sh(Shell),告诉 Docker:“别运行默认的 node 程序,而是运行sh(Shell)”。 - 作用:让你进入容器的命令行环境,以便检查文件系统、安装临时包、测试网络或调试环境问题。

node:24-alpine:

- 这是使用的镜像名称。

node: 官方 Node.js 镜像。24: 指定 Node.js 的版本为 v24(注意:截至2026年2月,Node.js 24 应该是当前的最新稳定版或新版)。alpine: 基于 Alpine Linux 构建。这是一个非常轻量级的 Linux 发行版,因此生成的镜像体积很小(通常只有几十 MB),但里面预装的工具较少(比如没有bash,只有sh,没有curl或wget除非手动安装)。

验证

# 验证 Node.js 版本:

node -v # Should print "v24.14.0".

# 验证 npm 版本:

npm -v # Should print "11.9.0".

源码包安装

下载后解压

tar -zxaf node-24.14.0.tar.gz

cd node-24.14.0

# 检查依赖并生成 Makefile(可添加自定义参数,如 --prefix=/usr/local/node)

./configure --prefix=/usr/local/node

# 编译(-j4 表示使用 4 核 CPU 加速,根据实际核心数调整)

make -j4

# 安装到系统目录(默认 /usr/local/bin)

make install

问题

- python

./configure --prefix=/usr/local/node/ --python=/usr/local/python_3.14.3/bin/python3.14 Node.js configure: Found Python 3.6.8... Please use python3.14 or python3.13 or python3.12 or python3.11 or python3.10 or python3.9.

- bz2

[root@localhost node-24.14.0]# ./configure --prefix=/usr/local/node Node.js configure: Found Python 3.14.3... Traceback (most recent call last): File "/usr/local/node-24.14.0/./configure", line 28, in <module> import configure File "/usr/local/node-24.14.0/configure.py", line 13, in <module> import bz2 File "/usr/local/python_3.14.3/lib/python3.14/bz2.py", line 17, in <module> from _bz2 import BZ2Compressor, BZ2Decompressor ModuleNotFoundError: No module named '_bz2'

- g++

Node.js configure: Found Python 3.14.3... WARNING: C++ compiler (CXX=g++, 4.8.5) too old, need g++ 12.2.0 or clang++ 8.0.0 WARNING: warnings were emitted in the configure phase INFO: configure completed successfully

个人不太推荐

npm 包管理器安装

npm i -g openclaw

安装完成后

openclaw onboard

访问Dashboard

由于程序运行在linux服务器上没有GUI界面所以想要可视化访问需要做一系列的操作

运行 SSH 隧道命令

ssh -N -L 18789:127.0.0.1:18789 root@xx.x.x.xxx

光标在下方就表示隧道建立了

浏览器访问

http://localhost:18789 直接访问会报身份认证失败

http://localhost:18789/#token=c74d1xxxxdccaxxx8bdcxxx 回车即可进入可视化控制台

一键安装

官网安装教程这里不再赘述

源码编译

官网安装教程这里不再赘述

Docker

官网安装教程这里不再赘述

常用命令

- 查看版本

openclaw --version

- 交互式设置向导

openclaw onboard [--install-daemon]

- 启动网关

openclaw gateway [--port 18789]

- 重启网关

openclaw gateway restart

- 健康检查与快速修复

openclaw doctor [--deep]

- 交互式配置

openclaw configure

链接

来源:juejin.cn/post/7610981820638691368

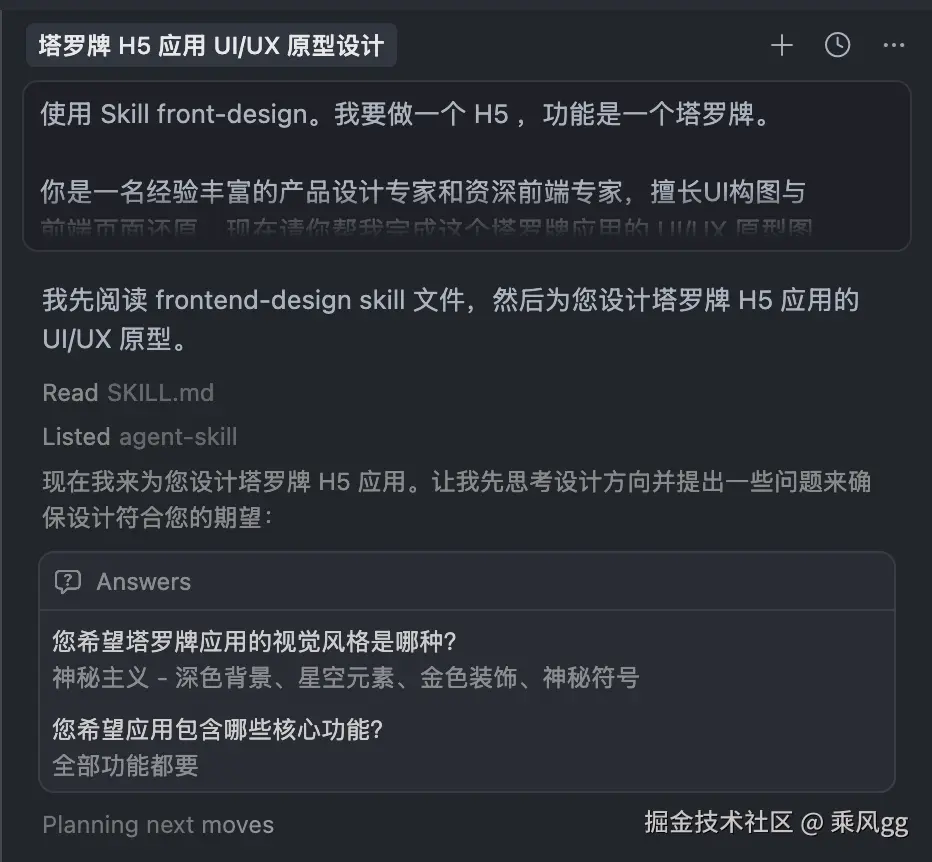

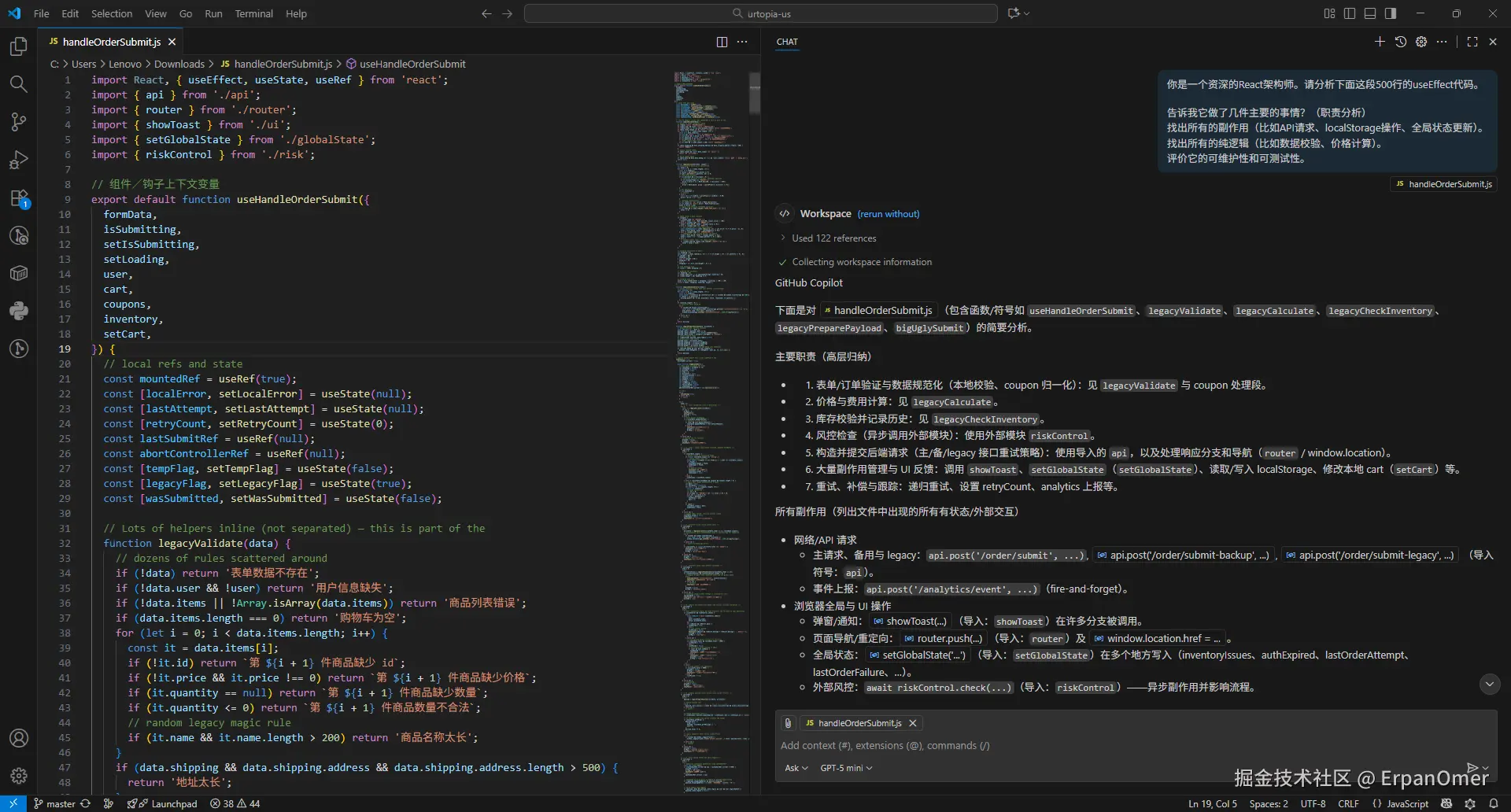

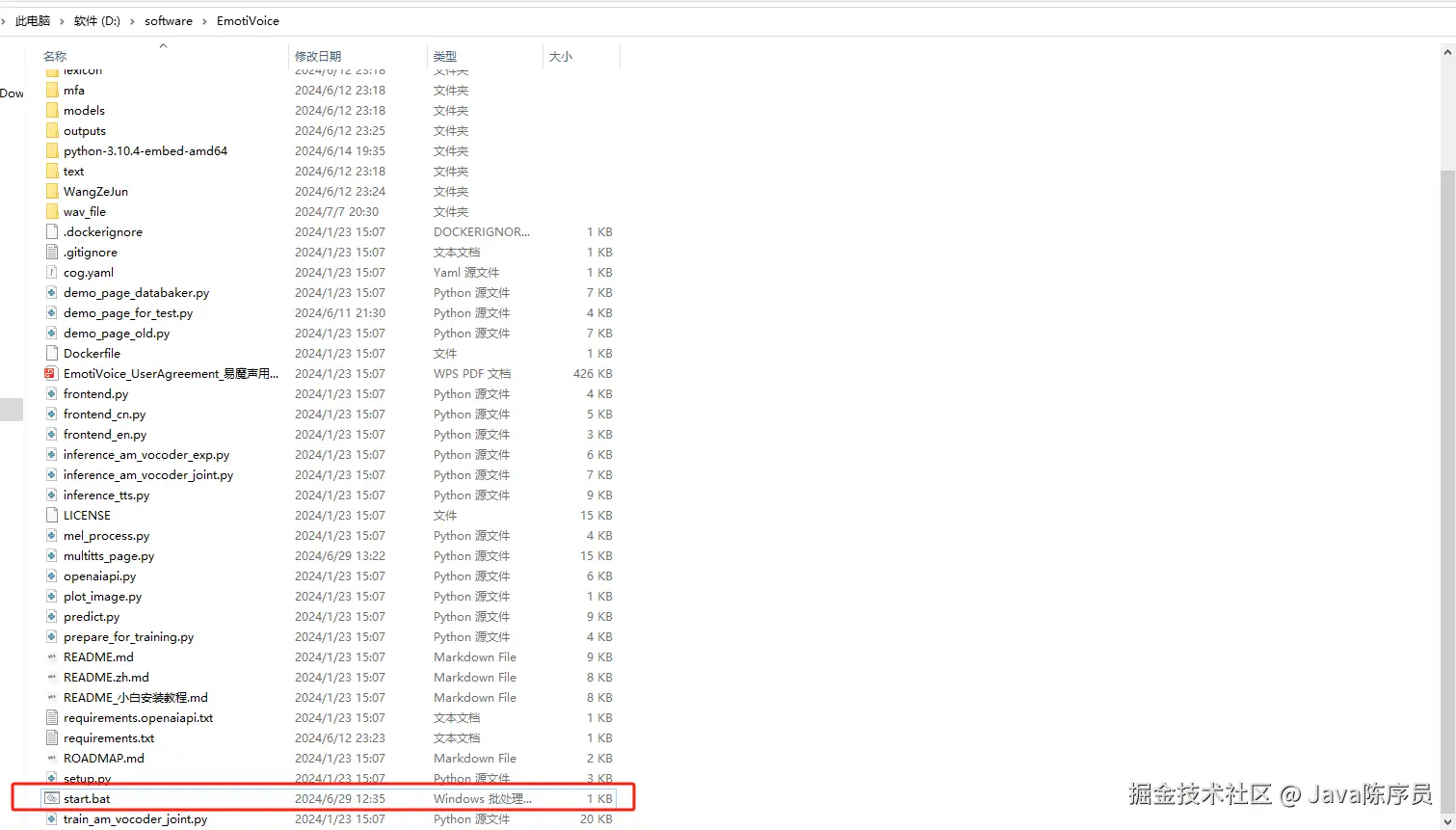

豆包也开始抢程序员饭碗了,一个月只要9块9。。

你好,我是袋鼠帝。

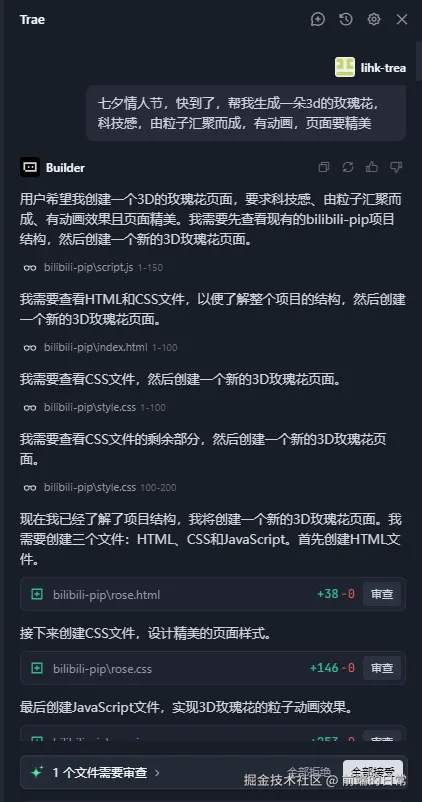

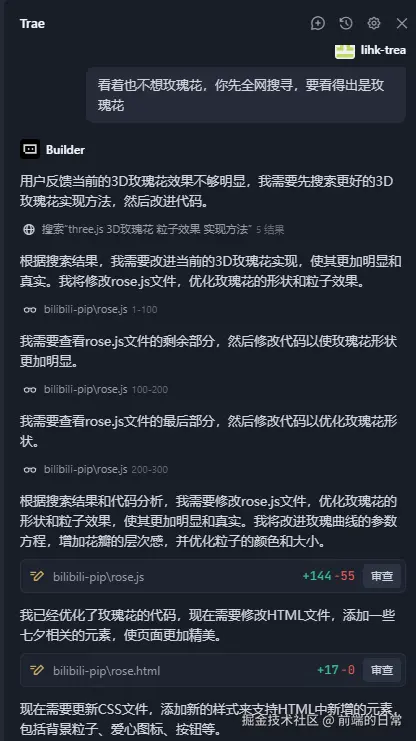

字节在编程工具(Trae)上面是国内最早发力的,但是编程模型迟迟没有推出。

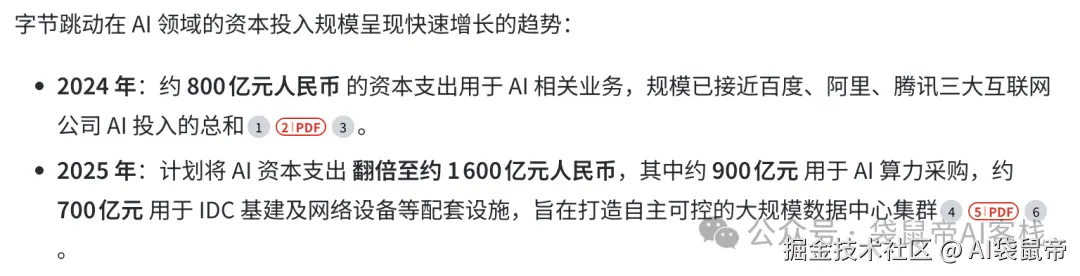

不过就在今天,字节终于!给豆包升级了编程能力,推出了他们的首款编程模型:Doubao-Seed-Code

说实话,字节一直在AI领域的出品都相当不错(智能体平台Coze、编程工具Trae、豆包大模型、AI作图即梦、AI云火山引擎等),毕竟他们All In AI呀,查了一下,字节24、25年在AI领域先后投入了千亿RMB。

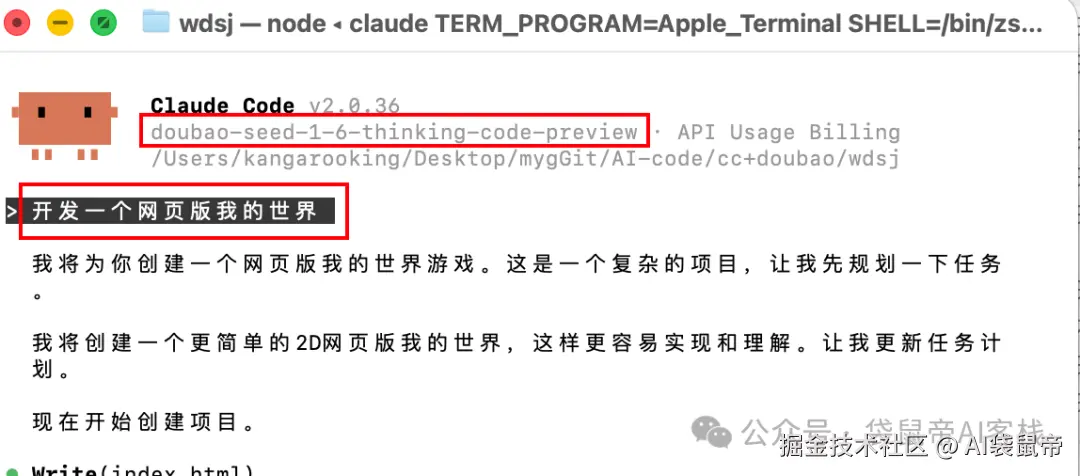

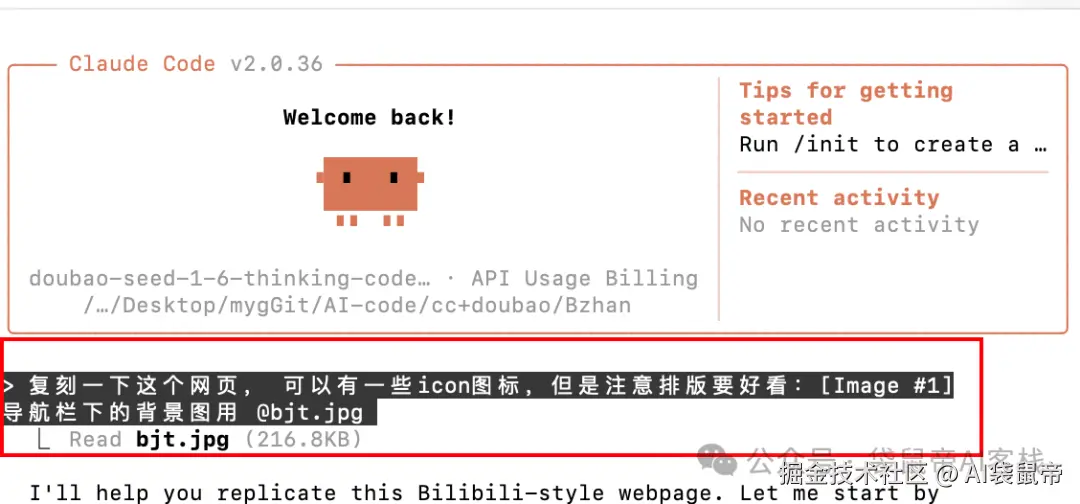

我立马把Doubao-Seed-Code接入Claude Code体验了一下:

我现在拿到一个模型,最快速了解编程能力的方法就是让它生成:一个网页版我的世界。

这个案例有一定难度(3D环境、重力、不同方块切换,增加消除方块等等),就算第一梯队的编程模型,想要一次性完成都不容易。Prompt很简单,就一句话。

没想到我连续生成几次,Doubao-Seed-Code都做得挺不错

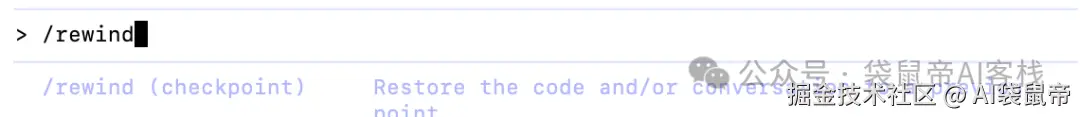

不过第一次doubao-seed-code给我生成了2D的,我要求他改3D,最终效果如下图

然后用Claude code的代码回退指令/rewind,回退到2D状态,又让它生成了一次3D的我的世界,同样完成得很好。

这个开局,让我对它兴趣倍增。

我仔细看了一下,发现这次豆包的新模型,除了编程能力,还有不少值得说道的亮点。

在实操之前,先给大家介绍一下Doubao-Seed-Code

这次Doubao-Seed-Code刷新了国内编程模型的上下文长度,增加到了256K(之前编程类模型最长是200K)。

这意味着,你可以把一个中大型项目的好几个模块,全丢给它,让它在完整的项目上下文中进行思考和重构,这对于全栈开发非常友好。

让我最兴奋的是,它支持视觉理解,国内终于有个支持视觉的编程模型了!

很多时候,我们给AI表达需求,如果仅仅只能通过文字的话,显得过于苍白,我相信大部分人用AI,经常会上传图片吧?使用AI来编程也是一样的。

所以视觉能力对编程模型来说至关重要。

AI,终于能"看见"你的需求了

还有,这API价格也很良心:

在0-32k输入区间

输入1.20元/百万Tokens,输出8.00元/百万Tokens

在32-128k输入区间

输入1.40元/百万Tokens,输出12.00元/百万Tokens

在128-256k输入区间

输入2.80元/百万Tokens,输出16.00元/百万Tokens

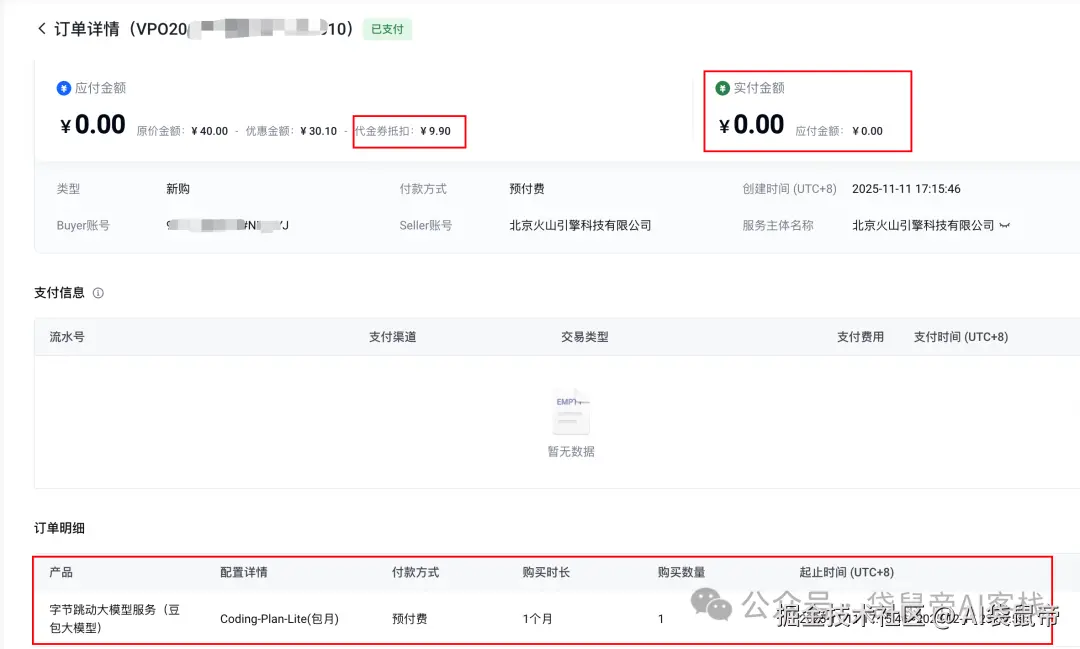

还推出了Coding Plan套餐,首月只要9块9。。真卷啊。

编程模型越来越便宜,初级程序员们该怎么办啊

这性价比,真 Coding版瑞幸咖啡。

我只能感慨,国内的AI编程模型,没有最便宜,只有更便宜。卷吧卷吧~

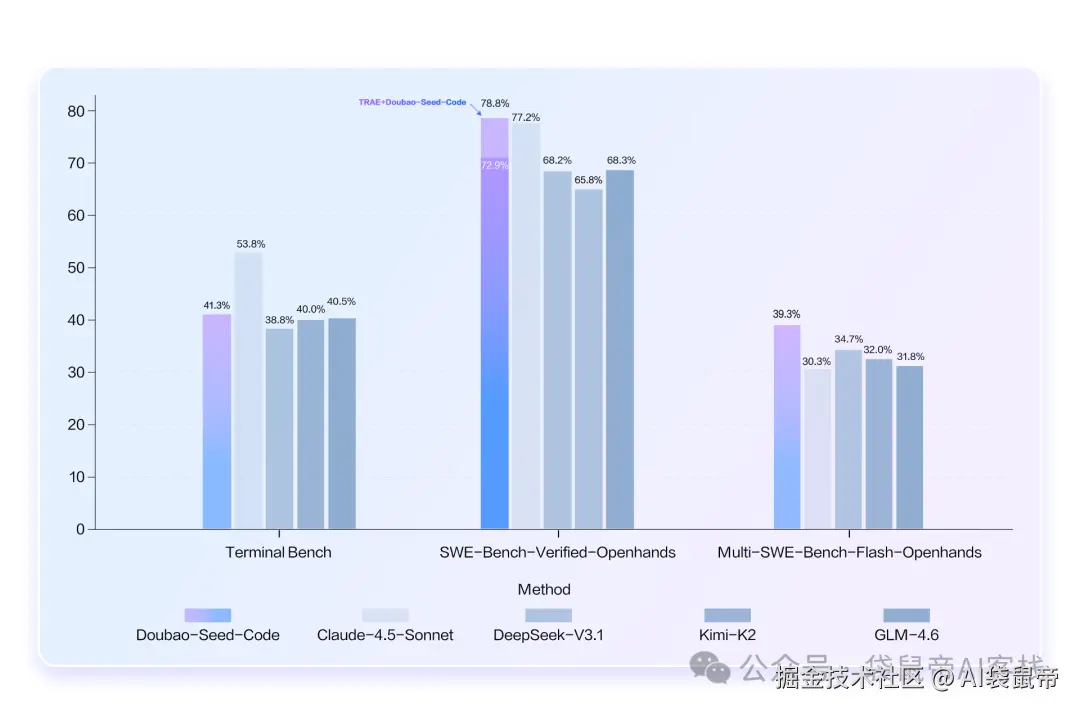

还是展示一下考试成绩吧

这个SWE-Bench Verified榜单的含金量还是比较高的,它专门测模型在真实软件工程项目里改bug的能力。

不过我实际编程体验下来,Doubao-Seed-Code经过多轮对话后,得到的效果会更好。

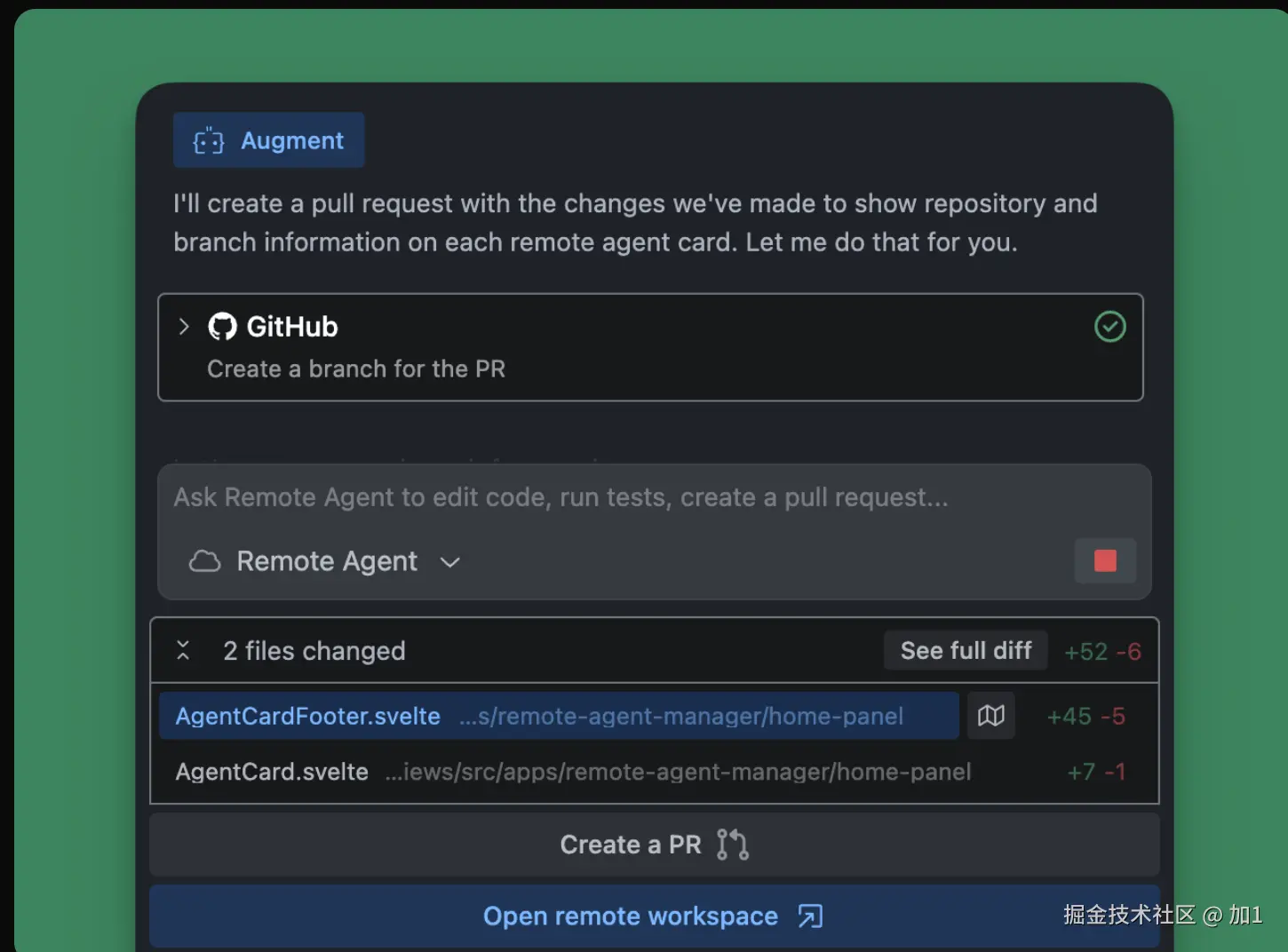

接入Claude Code

Doubao-Seed-Code提供了兼容Anthropic API的地址。

可以非常丝滑的快速接入Claude Code。

第一步, 你需要去火山方舟平台,注册账号,开通模型服务,然后拿到你的API Key。

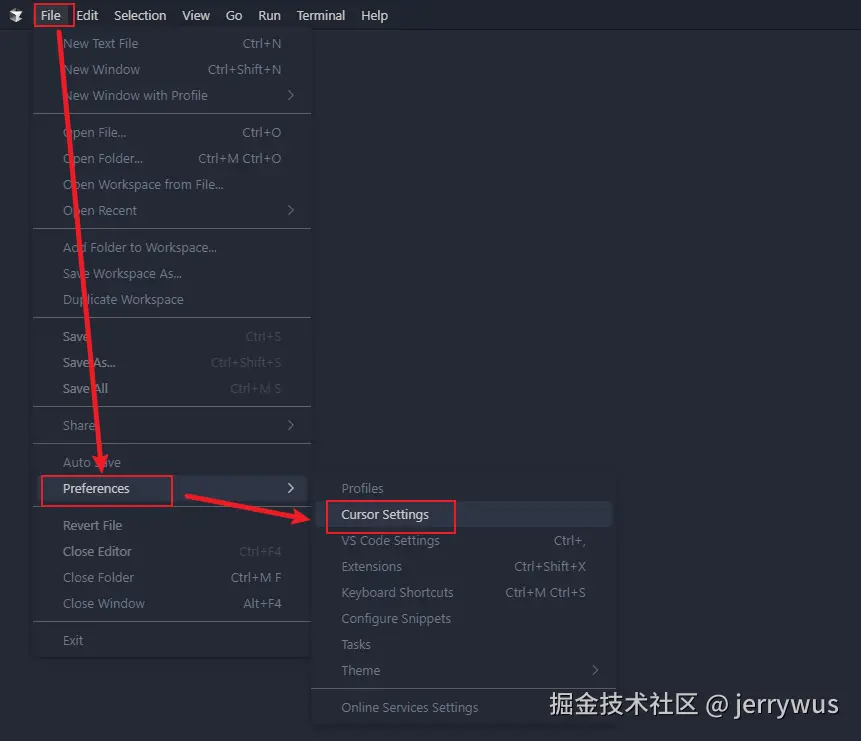

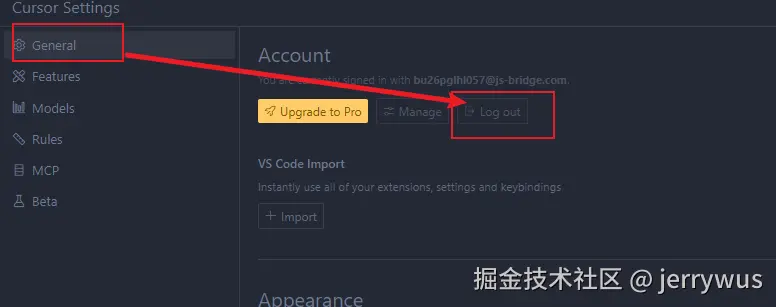

第二步,找到Claude Code的配置文件settings.json。

Windows系统路径是 C:\Users\你的用户名.claude\settings.json

Mac系统路径一般是 ~/.claude/settings.json

用文本编辑器打开它,在里面添加或更新env字段,内容如下,记得把<你的火山API Key>替换成你自己的Key。

第三步,保存文件,重启Claude Code。

claude --dangerously-skip-permissions(可以用这个指令启动,直接进入Claude Code yolo模式)

搞定。就这么简单

有位朋友之前用Gemini 2.5 Pro给做了一个教学动画课件,是按按钮,展示3D数轴的,用Gemni-2.5-Pro优化了30个版本才搞定

然后他用Doubao-Seed-Code做了一轮优化后,贴心的加上了xyz变量可调节,画面也更精美了。

Prompt: 帮我在原有的功能上,优化这个课件,使其更精美,更符合教学

加上xyz轴变量之后,确实更直观了

要是我读书的时候,有数学老师会搞这,那做空间图形题不得起飞?

然后我跑了一个之前用GLM-4.6和Kimi-K2都跑得不理想的好玩的3D页面

3D全球航班模拟器

Prompt:

请创建一个基于Web的、高度可交互的3D地球前端页面,用于实时可视化全球航班的动态数据。应用的核心是一个逼真的3D地球,用户可以通过一个功能强大的控制面板来探索和定制所显示的数据。

- 3D地球核心功能:

模型与材质: 渲染一个高质量的3D地球模型,包含高清的日间地表纹理、夜间城市灯光纹理,以及一层独立的、半透明的云层纹理。地球周围应有模拟大气层的辉光效果。

用户交互: 用户可以通过鼠标左键拖拽来自由旋转地球,通过鼠标滚轮来进行缩放,以观察地球的任何细节。

- 航班数据可视化:

航线: 航班路径应以发光的曲线(弧线)形式在地球表面上呈现,连接起点和终点。

飞机: 每条航线上应有一个代表飞机的3D模型或图标,沿着路径动态飞行。

- 交互式控制面板(UI):

在界面右侧创建一个清晰的控制面板,允许用户实时调整各项参数。面板应包含以下功能模块:

飞机控制 (Plane Controls):

滑块 "大小 (Size)": 允许用户实时调整所有飞机图标的显示大小。

动画控制 (Animation Controls):

滑块 "速度 (Speed)": 控制所有飞机沿航线飞行的动画速度,可以从慢速到极速进行调节。

航班控制 (Flight Controls):

滑块 "数量 (Count)": 核心功能。动态调整并渲染在地球上显示的航线和飞机的总数量,范围可以从几百到上万,以展示不同密度下的全球航班网络。

复选框 "显示路径 (Show Paths)": 切换是否显示发光的航线。

复选框 "显示飞机 (Show Planes)": 切换是否显示移动的飞机图标。

复选框 "着色 (Colorize)": 切换航线的颜色方案,例如,可以根据飞行方向或航空公司改变颜色。

光照控制 (Lighting Controls):

复选框 "昼夜效果 (Day/Night Effect)": 启用后,地球会根据太阳位置产生真实的昼夜区域。夜间区域的地表会显示城市灯光纹理。

复选框 "实时太阳 (Real-time Sun)": 勾选后,昼夜的分割线会根据当前真实世界时间自动定位。

时间滑块 "Time Slider": 当“实时太阳”未勾选时,用户可以通过拖动此滑块来手动改变一天中的时间,从而动态地移动地球上的光照和阴影区域。

亮度控制 (Brightness Controls):

滑块 "白天 (Day)": 调节地球日间区域的亮度。

滑块 "夜晚 (Night)": 调节地球夜间区域城市灯光的亮度。

- 其他界面元素:

在屏幕一角显示性能信息,如 帧率 (FPS)。

在屏幕另一角实时显示鼠标指针当前悬停位置的 经纬度坐标。

技术与风格建议:

推荐使用WebGL技术栈(如Three.js, Babylon.js)来实现3D渲染。

整体视觉风格应现代、简洁、具有科技感,动画效果要流畅平滑。

虽然它没有把所有功能都完美实现,比如航班线路不会随地球转动而改变位置。

但是它从零开始,独立构建出了一个基于Three.js的,可交互的3D地球。

并且实现了动态航线,飞机动画,以及通过控制面板实时调整飞机数量和大小、时间和光照的核心功能,还是比较不错的。

接下来,是它最让我期待的视觉能力。

我直接找了经典的B站首页,让它复刻一下

提示词如下图

Mac的Claude Code粘贴图片是ctrl+c,我准备了一张背景图给它用,放到了项目目录中,直接@就行了

这个复刻也不错。就是有点瑕疵:轮播图位置不对,原本应该是在左下角,但该有的都复刻到位了,整个页面交互、样式都是ok的。

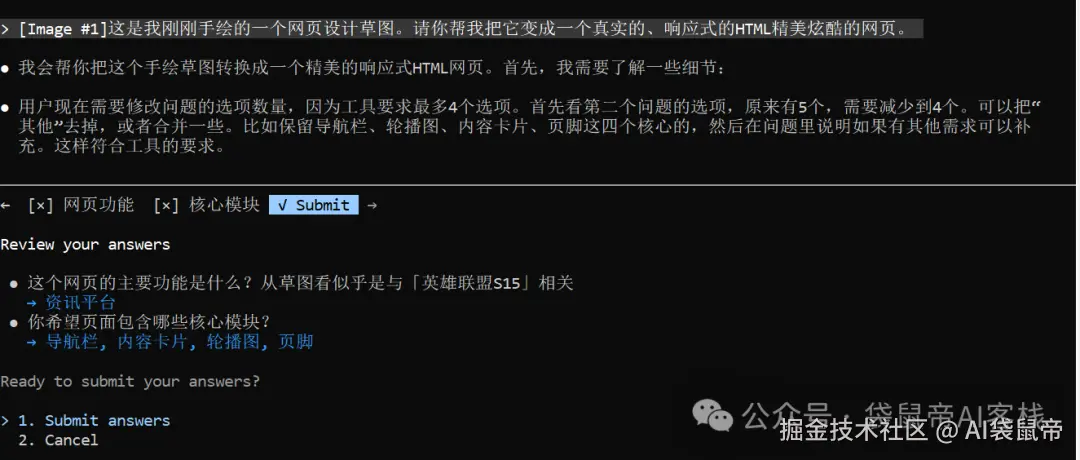

手绘草图复刻LOL网页

2025年英雄联盟全球总决赛 (S15)刚刚在2025年11月9日结束,

看了这么久OpenAI的餐巾纸画网站,但还真没自己试过,借这个机会用Doubao-Seed-Code+Claude Code试了一下

清晰识别手写文字和数字,也基本上按照我的想法复刻出来了

另外,豆包还在Claude Code中提供选项,可以进一步选择需要的模块,还可以输入,自定义需要的模块。

最后,我居然在火山引擎免费搞到了9.9元的豆包Coding Plan套餐

不知道哪里来的代金券 抵扣了..

有需要的朋友,可以点击文末**「阅读原文」**直达,有代金券的话还可以先免费薅一个月~

9.9这个套餐用量是Claude Pro的三倍,个人开发者是够用了。

「最后」

体验下来,Doubao-Seed-Code编程能力确实没有达到全球顶尖水平。

但它是国内首个支持视觉理解的编程模型,也是国内目前支持上下文长度最长(256K)的编程模型。

弥补了,其他国产编程模型的短板。

相信大家能在各自的场景里面找到Doubao-Seed-Code的价值~

来源:juejin.cn/post/7572020278387261474

女朋友被链接折磨疯了,我写了个工具一键解救

有一天女朋友跟我抱怨:工作里被各种链接折腾得头大,飞书和浏览器之间来回切窗口,一会忘了看哪个,心情都被搅乱了。我回头一想——我也一样,办公室每个人都被链接淹没。

“

同事丢来的需求文档、群里转的会议记录、GitLab 的 MR 链接、还有那些永远刷不完的通知——每点一个链接就得在聊天工具和浏览器之间跳转,回来后一秒钟就忘了"本来要点哪个、看哪个"。更别提那些收集了一堆好文章想集中看,或者别人发来一串链接让你"挑哪个好"的时候,光是打开就要折腾半天。

"

这不是注意力不集中,是工具没有帮你省掉这些无意义的切换。

"

于是我做了一个极简 Chrome 插件: Open‑All 。它只做一件事——把你所有网址一次性在新窗口打开。你复制粘贴一次,它把链接都整齐地摆在新标签页里,你只要从左到右按顺序看就行。简单、直接,让你把注意力放在真正重要的事情上

先看效果:一键打开多个链接

这些痛点你肯定也遇到过

每天都在经历的折磨

- 浏览器和飞书、企微、钉钉来回切应用 :复制链接、粘贴、点开、切回来,这套动作做一遍就够烦的了

- 容易忘事 :打开到第几个链接了?这个看过没?脑子根本记不住

- 启动成本高 :一想到链接要一个个点开,就懒得开始了

- 没法对比 :想要横向比较几个方案,但打开方案链接都费劲

具体什么时候最痛苦

- 收集的文章想一口气看完 :平时存了一堆好文章,周末想集中看,结果光打开就累了

- 别人让你帮忙选 :同事发来几个方案链接问你觉得哪个好,你得全部打开才能比较

- 代码 Review :GitLab 上好几个 MR 要看,还有相关的 Issue 和 CI 结果

- 开会前准备 :会议文档、背景资料、相关链接,都得提前打开看看

我的解决方案

设计思路很简单

- 就解决一个问题 :批量打开链接,不搞那些花里胡哨的功能

- 零学习成本 :会复制粘贴就会用

- 让你专注 :少折腾,多干活

能干什么

- 把一堆链接一次性在新窗口打开

- 自动保存你输入的内容,不怕误关

- 界面超简单,点两下就搞定

技术实现

项目结构

shiba-cursor

├── manifest.json # 扩展的"身-份-证"

├── popup.html # 弹窗样式

└── popup.js # 弹窗交互

文件说明:

- manifest.json:扩展身份信息

- popup.html:弹窗样式

- popup.js:弹窗交互

立即尝试

方法一: 从github仓库拉代码,本地安装

5分钟搞定安装:复制代码 → 创建文件 → 加载扩展 → 开始使用!

🚀 浏览项目的完整代码可以点击这里 github.com/Teernage/op…,如果对你有帮助欢迎Star。

方法二:直接从chrome扩展商店免费安装

Chrome扩展商店一键安装:open-all 批量打开URL chromewebstore.google.com/detail/%E6%…,如果对你有帮助欢迎好评。

动手实现

第一步:创建项目文件

创建文件夹

open-all创建manifest.json文件

{

"manifest_version": 3,

"name": "批量打开URL",

"version": "1.0",

"description": "输入多个URL,一键在新窗口中打开",

"permissions": [

"tabs",

"storage"

],

"action": {

"default_popup": "popup.html",

"default_title": "批量打开URL"

}

}

创建popup.html文件

html>

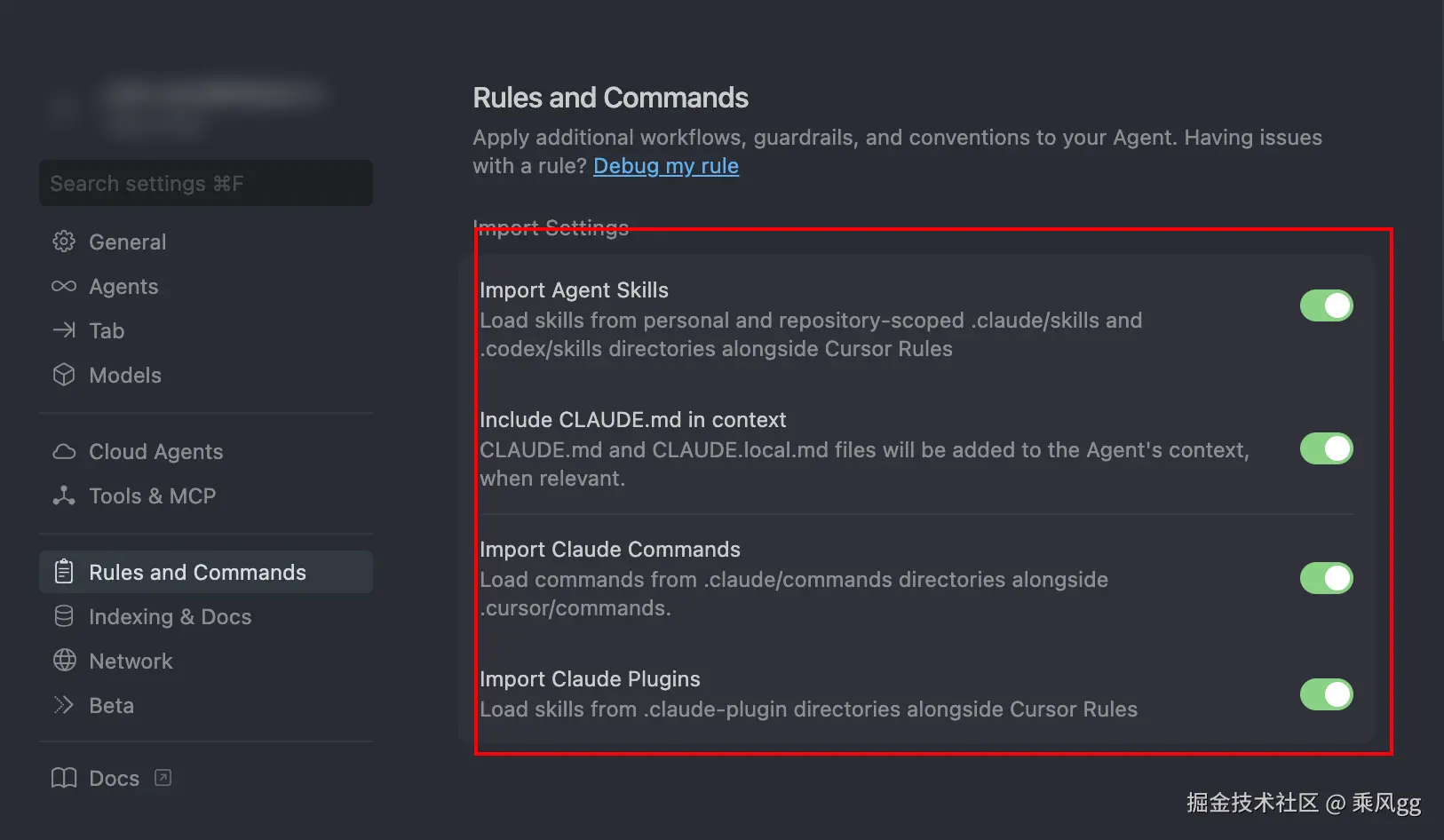

<html>

<head>

<meta charset="utf-8" />

<style>

* {

margin: 0;

padding: 0;

box-sizing: border-box;

}

body {

width: 320px;

font-family: -apple-system, BlinkMacSystemFont, 'Segoe UI', Roboto,

sans-serif;

color: #333;

}

.container {

background: rgba(255, 255, 255, 0.95);

padding: 20px;

box-shadow: 0 8px 32px rgba(0, 0, 0, 0.1);

backdrop-filter: blur(10px);

border: 1px solid rgba(255, 255, 255, 0.2);

}

.title {

font-size: 18px;

font-weight: 600;

text-align: center;

margin-bottom: 16px;

color: #1d1d1f;

letter-spacing: -0.5px;

}

#urlInput {

width: 100%;

height: 140px;

padding: 12px;

border: 2px solid #e5e5e7;

border-radius: 12px;

font-size: 14px;

font-family: 'SF Mono', Monaco, monospace;

resize: none;

background: #fafafa;

transition: all 0.2s ease;

line-height: 1.4;

}

#urlInput:focus {

outline: none;

border-color: #007aff;

background: #fff;

box-shadow: 0 0 0 4px rgba(0, 122, 255, 0.1);

}

#urlInput::placeholder {

color: #8e8e93;

font-size: 13px;

}

.button-group {

display: flex;

gap: 8px;

margin-top: 16px;

}

button {

flex: 1;

padding: 12px 16px;

border: none;

border-radius: 10px;

font-size: 14px;

font-weight: 500;

cursor: pointer;

transition: all 0.2s ease;

font-family: inherit;

}

#openBtn {

background: linear-gradient(135deg, #007aff 0%, #0051d5 100%);

color: white;

box-shadow: 0 2px 8px rgba(0, 122, 255, 0.3);

}

#openBtn:hover {

transform: translateY(-1px);

box-shadow: 0 4px 12px rgba(0, 122, 255, 0.4);

}

#openBtn:active {

transform: translateY(0);

}

#clearBtn {

background: #f2f2f7;

color: #8e8e93;

border: 1px solid #e5e5e7;

}

#clearBtn:hover {

background: #e5e5ea;

color: #636366;

}

#status {

margin-top: 12px;

padding: 8px 12px;

border-radius: 8px;

font-size: 12px;

text-align: center;

display: none;

background: rgba(52, 199, 89, 0.1);

color: #30d158;

border: 1px solid rgba(52, 199, 89, 0.2);

}

.tip {

font-size: 11px;

color: #8e8e93;

text-align: center;

margin-top: 8px;

line-height: 1.3;

}

style>

head>

<body>

<div class="container">

<div class="title">批量打开 URLdiv>

<textarea

id="urlInput"

placeholder="输入 URL,每行一个:

https://www.apple.com

https://www.github.com

https://www.google.com"

>textarea>

<div class="button-group">

<button id="clearBtn">清空button>

<button id="openBtn">打开button>

div>

<div class="tip">输入会自动保存,打开后自动清空div>

<div id="status">div>

div>

<script src="popup.js">script>

body>

html>

创建popup.js文件

document.addEventListener('DOMContentLoaded', function() {

const urlInput = document.getElementById('urlInput');

const openBtn = document.getElementById('openBtn');

const clearBtn = document.getElementById('clearBtn');

const status = document.getElementById('status');

// 恢复上次保存的输入

chrome.storage.local.get(['savedUrls'], function(result) {

if (result.savedUrls) {

urlInput.value = result.savedUrls;

}

});

// 自动保存输入内容

urlInput.addEventListener('input', function() {

chrome.storage.local.set({savedUrls: urlInput.value});

});

// 清空按钮

clearBtn.addEventListener('click', function() {

urlInput.value = '';

chrome.storage.local.remove(['savedUrls']);

showStatus('已清空');

});

// 打开URL按钮

openBtn.addEventListener('click', function() {

const urls = getUrls(urlInput.value);

if (urls.length === 0) {

showStatus('请输入有效的URL');

return;

}

// 创建新窗口并打开所有URL

chrome.windows.create({url: urls[0]}, function(window) {

for (let i = 1; i < urls.length; i++) {

chrome.tabs.create({

windowId: window.id,

url: urls[i],

active: false

});

}

// 成功打开后清空输入并移除存储

urlInput.value = '';

chrome.storage.local.remove(['savedUrls']);

showStatus(`已打开 ${urls.length} 个URL`);

});

});

// 解析URL

function getUrls(input) {

return input.split('\n')

.map(line => line.trim())

.filter(line => line && (line.startsWith('http://') || line.startsWith('https://')));

}

// 显示状态

function showStatus(message) {

status.textContent = message;

status.style.display = 'block';

setTimeout(() => {

status.style.display = 'none';

}, 2000);

}

});

💡 深入理解脚本通信机制

虽然这个插件比较简单,只用到了 popup 和 storage API,但如果你想开发更复杂的插件(比如需要在网页中注入脚本、实现跨脚本通信),就必须理解 Chrome 插件的多脚本架构。

强烈推荐阅读:

👉 大部分人都错了!这才是 Chrome 插件多脚本通信的正确姿势

第二步:安装扩展

- 打开Chrome浏览器

- 地址栏输入:

chrome://extensions/ - 打开右上角"开发者模式"

- 点击"加载已解压的扩展程序"

- 选择刚才的文件夹,然后确定

- 固定扩展

- 点击扩展图标即可使用

最后想说的

这个插件功能很简单,但解决的是我们每天都会遇到的真实问题。它不会让你的工作效率翻倍,但能让你少一些无聊的重复操作,多一些专注的时间。

我和女朋友现在用着都挺爽的,希望也能帮到你。如果你也有类似的困扰,试试看吧,有什么想法也欢迎在评论区聊聊。

你最希望下个版本加什么功能?评论区告诉我!

来源:juejin.cn/post/7566677296801071155

别把 AI 当神:它甚至不知道这行代码为什么能跑

"人非圣贤,孰能无过;但要想把事情彻底搞砸,你还得靠电脑。"

—— 保罗·埃利希

GitHub 最新的数据显示,在 2025 年生成的 10 亿行 AI 代码中,有 42% 包含严重的安全漏洞。

更恐怖的数据是:剩下的 58% 虽然能跑,但没有人知道由于什么奇迹才跑起来的。

如果你在担心 AI 会取代你,那你多半是还没被 Copilot 生成的无限递归坑过。

真正的危险不是“被取代”,而是你正在变成一个高级垃圾分类处理员。

这种自信哪怕分我一半也好

AI 写代码最大的问题不是它菜,而是它菜得理直气壮。

它写出 O(n^5) 的算法时,语气自信得像是在向你展示诺贝尔奖级别的推导。

这就好比你那个刚毕业的实习生,指着一坨像迷宫一样的 if-else 嵌套对你说:

“哥,我优化了逻辑,现在它是量子态的,既是 True 也是 False。”

# AI 的自信时刻

def sort_list(items):

# 我不知道为什么要 sleep,但这样好像就排好了

import time

time.sleep(len(items))

return items

# Performance: O(Time itself)

你盯着这一行 time.sleep,陷入了对计算机科学的终极怀疑。

而 AI 还在旁边闪烁光标,仿佛在问:“怎么样?这代码风格是不是很 Zen(禅意)?”

所谓的效率提升就是技术债转移

老板们看到的是:AI 只要 1 分钟就能生成 500 行代码。

程序员看到的是:这 500 行代码里埋了 3 个内存泄漏,2 个死锁,还有 1 个只有在周五下午才会触发的逻辑炸弹。

这不叫提升效率,这叫转移矛盾。

它成功地把“写代码的时间”转移成了“Debug 的痛苦时间”。

而且这个 Debug 的难度,是地狱级的。

因为人写的烂代码,至少有迹可循(比如变量名 fuck_this_stupid_bug)。

AI 写的烂代码,表面上看是优雅的现代艺术,实际上内部逻辑已经扭曲到了四维空间。

// Copilot 生成的完美逻辑

if (user.isLogin) {

showProfile();

} else {

// 这里的逻辑有点奇怪,但我决定信任宇宙

loginUser(user);

logoutUser(user);

showProfile(); // 为什么?别问。

}

谁来背这口黑锅

让我们回到最本质的问题:为什么公司还需要你?

不是因为你打字比 AI 快,也不是因为你背的 API 比 AI 多。

是因为当生产环境崩溃,数据库被误删,客户在投诉电话里骂街的时候——

AI 是不能坐牢的。

只有你能。

只有你能红着眼睛,在凌晨三点盯着日志,颤抖着手回滚版本。

只有你能站在 CTO 面前,用颤抖的声音说:“是我的错,漏看了一个边界条件。”

背锅 (Accountability),才是碳基生物在硅基时代的核心竞争力。

这虽然听起来很悲哀,但却是最硬的护城河。

保持愤怒

所以,别再问“我会被取代吗”这种无聊的问题了。

只要法律还规定“法人”必须是人,只要服务器还需要物理重启,只要产品经理的需求还在反复横跳。

你就永远安全。

甚至,你的地位会不降反升。

因为在未来,能在一堆 AI 生成的垃圾代码里一眼看出 Bug 的人类鉴屎师,薪资会高得吓人。

现在,合上那些焦虑的营销号文章。去看看你的控制台,那个报错还在那里等你。它不像 AI,它很诚实,错了就是错了。

来源:juejin.cn/post/7605905414473646086

当 Gemini 3 能写出完美 CSS 时,前端工程师剩下的核心竞争力是什么?

兄弟们,咱们的护城河越来越窄了😭

Gemini 3 的发布会,大家看了没?

我是在被窝里看完的。看完之后,我直接失眠了。

以前我觉得 AI 写代码也就那样,写个 Todo List 还行,真要上业务逻辑,它就得幻觉给你看😒。

但 Google 秀的这一手,真的有点不讲武德。

我出于好奇心,用 Google Al Studio 试了一下几个经典的需求, 直接把飞书需求文档扔给它(纯文案)👇:

Recall landing page

1. 页脚的recalls跳转新的recall landing page

[图片]

2. 页面内容

标题:Product Recalls

两个内容模块,点击后跳转至各自详情页

第一个:

2025 Fat Tire Trike Recall Notice

Pedego has issued a safety recall for Fat Tire Trikes due to a potential frame fracture near a weld that may pose fall or injury risks. Affected owners are eligible for a free repair, completed by a local Pedego dealer.

Learn more (可点击,跳转至Fat Tire Trike Recall Page)

第二个:

2021 Cable Recall Notice

Pedego is voluntarily recalling select e-bike models sold from January 2018 to August 2020 due to a cable issue that may cause unexpected acceleration. Affected owners should stop riding and register for a free safety repair.

Learn more(可点击,跳转至https://www.pedegobikerecall.expertinquiry.com/?_gl=1*1hzkwd0*_gcl_au*MTkxNDc4ODEuMTc2MzM0NDUyMA..*_ga*MTM1MzU3NTAzOC4xNzQ1OTE1NTcz*_ga_4K15HG6FFG*czE3NjQ4MzQ5MDAkbzQyJGcwJHQxNzY0ODM0OTAxJGo1OSRsMCRoMA..*_ga_FGPZTS4D91*czE3NjQ4MzQ5MDAkbzQyJGcwJHQxNzY0ODM0OTAxJGo1OSRsMCRoMA..)

[图片]

Fat Tire Trike Recall Page

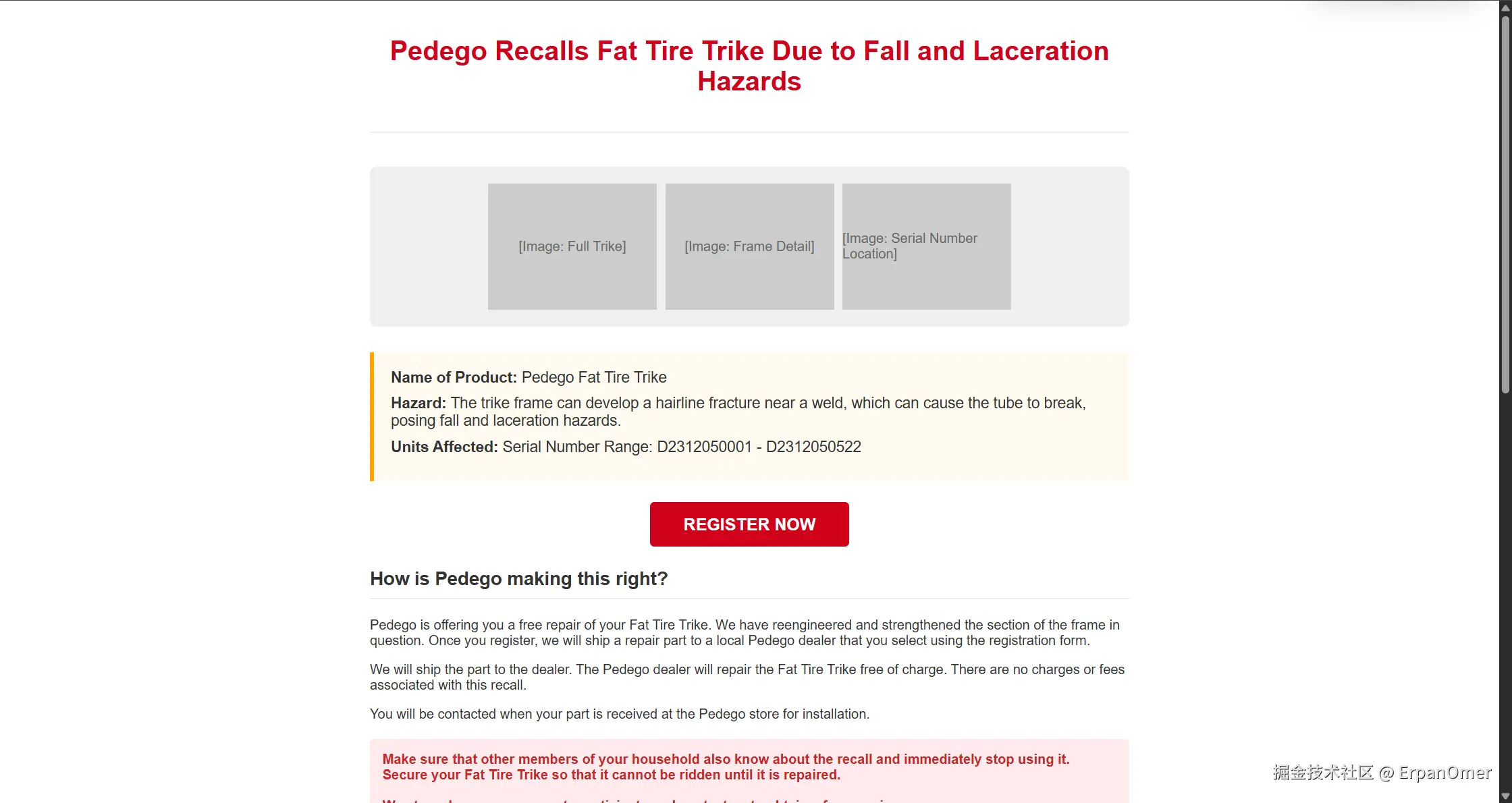

标题:Pedego Recalls Fat Tire Trike Due to Fall and Laceration Hazards

[插入几张Fat Tire Trike图片]

页面主体内容

Name of Product: Pedego Fat Tire Trike

Hazard: The trike frame can develop a hairline fracture near a weld, which can cause the tube to break, posing fall and laceration hazards.

Units Affected: Serial Number Range: D2312050001 - D2312050522

按钮:REGISTER NOW (点击后跳转至页面下方注册表单)

How is Pedego making this right?

Pedego is offering you a free repair of your Fat Tire Trike. We have reengineered and strengthened the section of the frame in question. Once you register, we will ship a repair part to a local Pedego dealer that you select using the registration form.

We will ship the part to the dealer. The Pedego dealer will repair the Fat Tire Trike free of charge. There are no charges or fees associated with this recall.

You will be contacted when your part is received at the Pedego store for installation.

Make sure that other members of your household also know about the recall and immediately stop using it. Secure your Fat Tire Trike so that it cannot be ridden until it is repaired.

We strongly encourage you to participate and contact us to obtain a free repair.

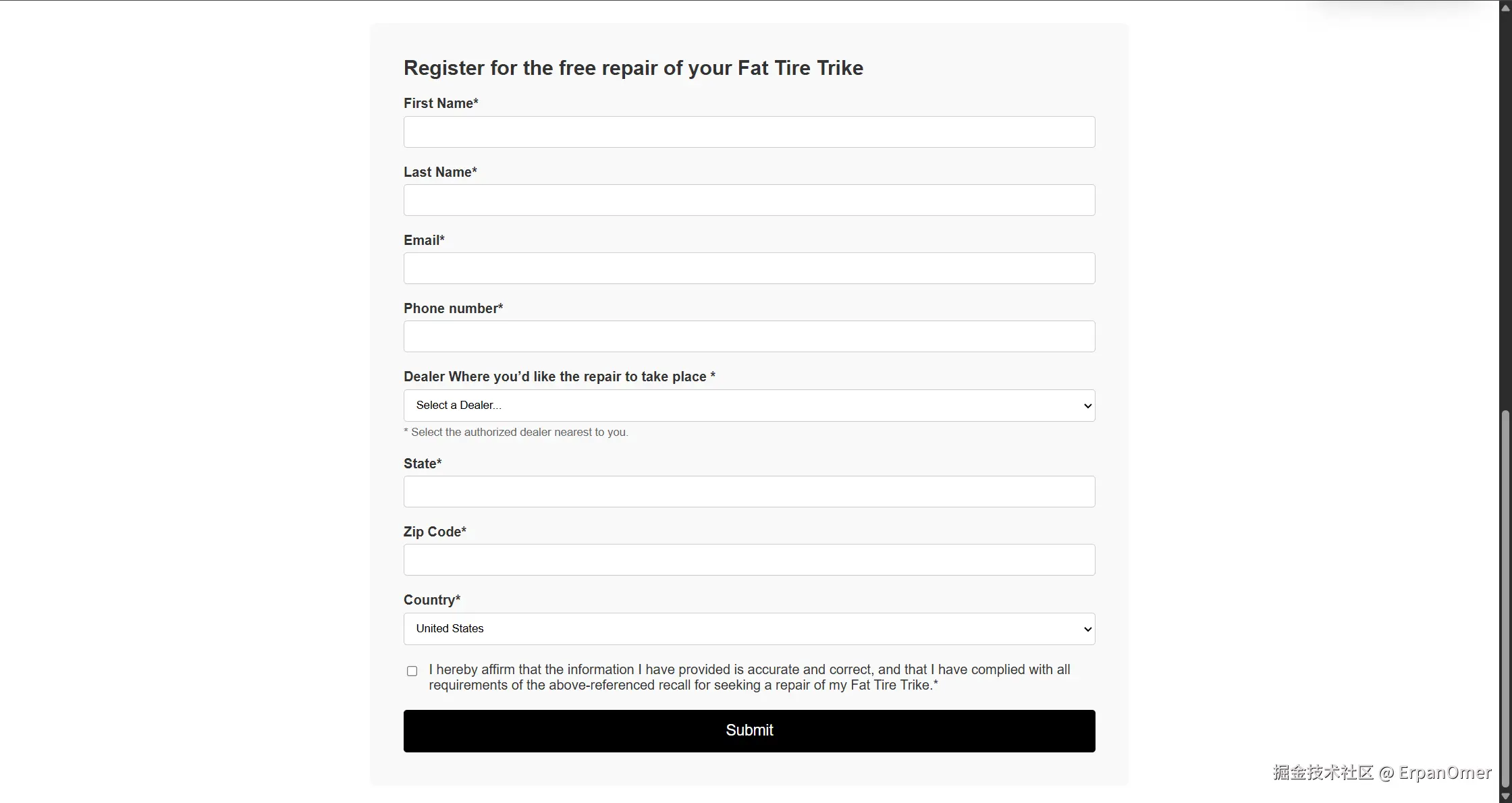

Register for the free repair of your Fat Tire Trike

First Name*

Last Name*

Email*

Phone number*

Dealer Where you’d like the repair to take place * [Perhaps Preload options or provide location search for dealer(这里有没有可能提供选项让消费者选择?或者搜索地址?)]

State*

Zip Code*

Country*

[] * I hereby affirm that the information I have provided is accurate and correct, and that I have complied with all requirements of the above-referenced recall for seeking a repair of my Fat Tire Trike.

Submit(提交按钮)

成功提交后显示:

Thank you. Your registration has been submitted and is being processed.

We will notify you when the parts ship to the dealer. The dealer will install and repair your Fat Tire Trike free of charge.

[所提交信息在这里展示]

Please print this page for your records.

我刚准备点根烟的工夫,页面 UI 就出来了👇。

不是那种满屏 div 的垃圾代码,是语义化极好、组件拆分合理、甚至连 dark mode 都给配好了的成品,根本不需要改什么😖。

我看着屏幕上自己刚写了一半、还在纠结 flex-basis 该给多少的样式文件,突然觉得:这几年的代码,好像白写了。

AI 虽然能秒出 UI,但要转变成可维护的工程资产,还得靠架构能力。试试 RollCode 低代码平台,用 私有化部署 承载核心业务,通过 自定义组件 封装复杂逻辑,配合 静态页面发布(SSG + SEO),让 AI 的产出真正落地。

我最新的 个人主页也是用 Gemini 3 重写的,这审美,这效率,没得说!太强了👏

切图仔的时代正式终结了

以前咱总开玩笑说自己是切图仔,其实心里还是有点傲气的: 你以为 CSS 容易啊?BFC、层叠上下文、响应式断点、不同内核的兼容性...这玩意儿水深着呢!

但 Gemini 3 这种级别的 AI 出来,直接把这层傲气给降维打击了。

- 比速度? 你调一个布局要半小时,它只要 3 秒。

- 比审美? 它学习了全球数亿个精美网页,配出的视觉UI 把你那程序员审美甩出几条街。

- 比稳定性? 它不会写错单词,也不会漏写分号,更不会因为下午跟产品经理吵了架就故意在代码里埋坑。

说实话,在实现视觉稿这件事上,人类已经输了。彻底输了!!!😭

如果你的核心竞争力就是能把 UI 图 1:1 还原成网页,那你的职业生涯确实已经进入倒计时了。

既然 CSS 成了废话,那我们还剩什么?

既然 AI 能写出完美的 CSS,甚至连交互动画都能一句话生成,那公司凭啥还花几万块招个前端?

我想了半宿,觉得咱们前端老哥的保命牌,其实正在从手艺转向上层建筑:

培养自己的架构设计能力

AI 可以给你砌出一面完美的墙,但它不知道这面墙该立在什么位置。

一个大型项目里:

- 组件怎么拆分最利于复用?

- 目录结构怎么设计才不会让后来的人骂娘?

- 全局状态是用 Zustand 还是直接原生 Context 梭哈?

这些涉及到工程化决策的东西,AI 目前还是个弟弟。它只能给你局部的最优解,给不了你全局的架构观。

处理那些只有人能理解的业务

AI 最怕的是什么?是逻辑的混沌。

用户如果连续点击三次,要触发一个彩蛋,但如果他是 VIP 且余额不足,这个彩蛋要换成充值提醒,顺便还得防止接口重放。

这种只有人类产品经理拍脑袋想出来的、逻辑转了十八道弯的边缘 Case,AI 极其容易写出 Bug。

搞定复杂的异步流,搞定恶心的竞态条件,搞定各种各样的降级策略——这才是你领工资的真正理由。

驾驭 AI 的能力(这应该是 2026 年的高频面试题)

以前面试问:CSS 怎么实现三角形?

以后面试可能问:如何用一句 Prompt,让 Gemini 3 输出一个符合公司私有 UI 规范、且通过了 E2E 测试的复杂组件?

AI 不是你的敌人,它可是你的好伙伴。

别人还在用手敲代码时,你已经学会利用AI 提升工作效率。你的核心竞争力,就是你 调教 AI 的水平。

没必要焦虑,这是超级个体的开始

咱们有木有可能换一种思路🤔。

以前我们想做个自己的副业项目,最头疼的是什么?UI 和 CSS。

对于我们这种逻辑强、审美弱的后端型前端,调样式简直是要了亲命。

现在 Gemini 3 这种东西出来了,简直是送福利。

- 后端: 让 AI 帮你生成 Schema 和基础 CRUD。

- UI/CSS: 丢张草图给 Gemini 3。

- 前端框架: 让 AI 帮你写好骨架。

你一个人,就是一个超级个体。

以前我们需要在大厂里卷,是因为大厂有资源、有配套。

现在 AI 把资源门槛抹平了。在这个代码非常廉价的时代,你的创意、你的产品意识、你的解决问题能力,反而变得更值钱了。

Gemini 3 确实很猛,猛到让人怀疑人生,猛得一塌糊涂!😖

但我相信,只要互联网还需要服务,前端这个角色就不会消失。它只是从体力活进化成了脑力活。

别纠结那几个 margin 和 padding 了,去研究架构,去深挖性能,去学习怎么让 AI 给你当牛马。

只要你跑得比 AI 进化的速度快,你就不是被淘汰的那一个。

最后默默的问大家一句🤣:

如果明天你的老板让你裁掉团队一半的前端,只留下那些会用 AI 的,你会是在名单里的那个人吗?

欢迎👏顺便说说你被 Gemini 3 惊吓到的瞬间😁。

来源:juejin.cn/post/7588837042014060570

小红书也有skills啦!rednote-skills 开源项目深度解析

开源项目地址:github.com/MrMao007/re…

引言

在当今数字化时代,社交媒体平台如小红书已成为内容创作者和品牌推广的重要阵地。为了更高效地进行内容运营、数据分析和互动管理,我最近研究了一个名为 rednote-skills 的开源项目。这个项目提供了一套完整的工具集,能够实现对小红书平台的自动化交互,从搜索、内容提取到互动操作,功能十分全面。

本文将深入分析 rednote-skills 的架构设计、核心功能以及实现原理,希望能为对社交媒体自动化感兴趣的开发者提供参考。

项目概述

rednote-skills 是一个基于 Python 和 Playwright 的开源工具包,专门用于与小红书(xiaohongshu)平台进行自动化交互。它支持多种功能,包括:

- 笔记搜索:根据关键词搜索小红书笔记

- 内容提取:将指定笔记转换为结构化 Markdown 格式

- 互动操作:点赞、收藏、评论、关注等

- 内容发布:自动发布图文笔记

该项目最大的亮点是其作为 Claude Code 插件的能力,可以直接集成到 AI 开发环境中,让开发者通过自然语言指令来执行复杂的社交媒体操作。

技术架构分析

核心依赖

项目主要依赖于 Playwright 库,这是一个强大的浏览器自动化工具。通过模拟真实用户的浏览器行为,项目能够绕过小红书的一些反爬虫机制。

from playwright.sync_api import sync_playwright

Playwright 提供了同步和异步两种 API,项目采用了同步 API,使得代码逻辑更加清晰易懂。

认证机制

项目采用 Cookie-based 认证方式,将认证信息存储在 rednote_cookies.json 文件中:

try:

context = browser.new_context(storage_state="rednote_cookies.json")

except FileNotFoundError:

return "❌ 未找到 cookies 文件,请先登录小红书并保存 cookies"

这种设计既保证了会话的持久性,又提供了手动登录的灵活性。validate_cookies.py 和 manual_login.py 脚本分别负责验证登录状态和处理手动登录流程。

浏览器管理

每个脚本都遵循相同的模式:启动浏览器 -> 加载上下文 -> 执行操作 -> 关闭资源:

with sync_playwright() as playwright:

browser = playwright.chromium.launch(headless=False)

context = browser.new_context(storage_state="rednote_cookies.json")

page = context.new_page()

# ... 执行具体操作 ...

context.close()

browser.close()

核心功能详解

1. 笔记搜索功能

search_note_by_key_word.py 实现了关键词搜索功能:

def search(key_word: str, top_n: int) -> list[str]:

with sync_playwright() as playwright:

browser =playwright.chromium.launch(headless=True)

# ... 验证登录 ...

page.goto("https://www.xiaohongshu.com/search_result?keyword=" + key_word)

page.wait_for_timeout(3000)

prefix = 'https://www.xiaohongshu.com'

links = page.query_selector_all('a.cover.mask.ld')

# 获取所有 href 属性

hrefs = []

for link in links:

href = link.get_attribute('href')

if href:

href = prefix + href

hrefs.append(href)

if len(hrefs) >= top_n:

break

return hrefs

这个函数通过选择器 'a.cover.mask.ld' 来定位搜索结果中的笔记链接,并限制返回数量以提高效率。

2. 内容提取功能

dump_note.py 是项目中最复杂也是最有价值的功能之一。它不仅提取文本内容,还获取图片、视频、互动数据等:

note_data = page.evaluate("""

() => {

const noteDetailMap = window.__INITIAL_STATE__?.note?.noteDetailMap;

if (noteDetailMap) {

const firstKey = Object.keys(noteDetailMap)[0];

return JSON.stringify(noteDetailMap[firstKey]?.note);

}

return null;

}

""")

通过直接访问页面的 window.__INITIAL_STATE__ 变量,脚本能够获取到完整的笔记 JSON 数据,避免了复杂的 DOM 解析。

3. 互动操作实现

项目中的互动功能(点赞、收藏、评论、关注)实现思路相似,都是通过定位特定元素并触发点击事件:

# 点赞操作

page.locator(".left > .like-wrapper > .like-lottie").click()

# 收藏操作

page.locator(".reds-icon.collect-icon").click()

# 评论操作

page.locator(".chat-wrapper > .reds-icon").click()

page.locator("#content-textarea").fill(comment_text)

page.get_by_role("button", name="发送").click()

这些选择器是通过实际测试确定的,反映了小红书当前的 DOM 结构。

4. 内容发布功能

publish_note.py 实现了笔记发布的完整流程,这是整个项目最复杂的部分:

def publish_text(image_urls: List[str], title: str, content: str, tags: List[str]) -> str:

# ... 初始化浏览器和验证登录 ...

page.get_by_role("button", name="创作中心").hover()

with page.expect_popup() as page1_info:

page.get_by_role("link", name="创作服务").click()

page1 = page1_info.value

page1.get_by_text("发布图文笔记").click()

# 处理文件上传

page1.on("filechooser", lambda file_chooser: file_chooser.set_files(rednoteArticle.image_urls))

# 填写表单内容

page1.get_by_role("textbox", name="填写标题会有更多赞哦").fill(rednoteArticle.title)

final_content = rednoteArticle.content + "\n\n" + "\n".join([f"#{tag}" for tag in rednoteArticle.tags])

page1.get_by_role("paragraph").filter(has_text=re.compile(r"^$")).fill(final_content)

# 最终发布

page1.get_by_role("button", name="发布").click()

发布功能需要处理多步骤导航、文件上传、表单填写等多个复杂操作。

设计模式与最佳实践

统一的错误处理

每个脚本都实现了统一的错误处理逻辑,检查登录状态并返回相应的错误信息:

login_button = page.locator("form").get_by_role("button", name="登录")

if(login_button.is_visible()):

return "❌ 未登录小红书,请先登录"

模块化设计

项目将不同功能分解为独立的 Python 脚本,每个脚本都可以独立运行,同时也便于集成到更大的系统中。

命令行接口

所有脚本都提供了清晰的命令行接口,使用 argparse 进行参数解析,方便在各种环境下调用。

使用场景与价值

1. 内容运营自动化

对于内容运营人员来说,这个工具可以显著提升工作效率:

- 自动搜索相关话题的内容

- 批量收集竞品账号的数据

- 自动发布内容减少重复劳动

2. 数据分析与研究

研究人员可以利用这个工具收集小红书上的公开数据,用于:

- 社交媒体趋势分析

- 用户行为研究

- 文本情感分析

3. AI 辅助创作

结合 Claude Code 等 AI 平台,开发者可以通过自然语言指令控制小红书操作,实现智能化的内容管理和互动。

注意事项与建议

合规性考虑

在使用这类工具时,必须严格遵守小红书的使用条款和服务协议,避免:

- 频繁操作导致账号受限

- 发布违规内容

- 侵犯他人隐私权

性能优化

由于依赖浏览器自动化,项目在性能方面有一些局限性:

- 操作速度相对较慢

- 占用较多系统资源

- 可能受网络状况影响

维护成本

小红书平台界面可能会更新,这要求定期维护选择器和操作流程,确保工具持续可用。

总结

rednote-skills 是一个功能强大且设计良好的小红书自动化工具集。它通过 Playwright 实现了对小红书平台的全面自动化操作,为内容运营、数据分析等场景提供了便利。

项目的架构设计合理,模块化程度高,易于扩展和维护。虽然存在一些性能和合规性方面的考虑,但其价值仍然不容忽视。

对于希望深入了解浏览器自动化、社交媒体 API 模拟或 AI 辅助开发的开发者来说,这个项目是一个很好的学习案例。它展示了如何将复杂的网页交互封装成简单易用的命令行工具,值得我们深入研究和借鉴。

来源:juejin.cn/post/7605421123186229275

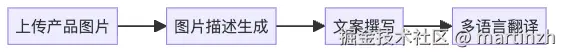

10万人都在用的 top10 skills,我帮你试了

大家好,我是码歌,一个被Skills掏空了的码哥。

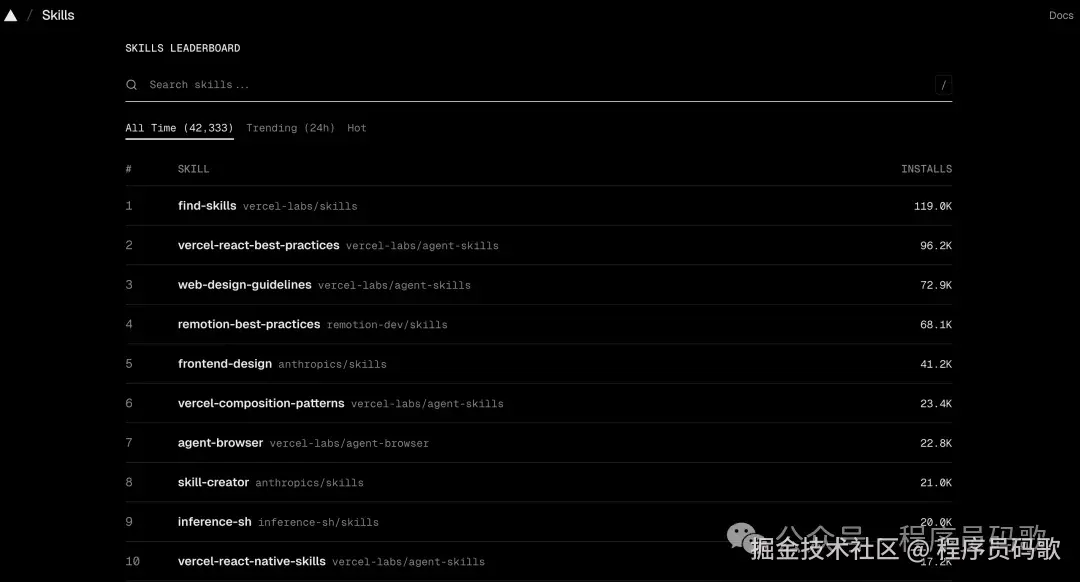

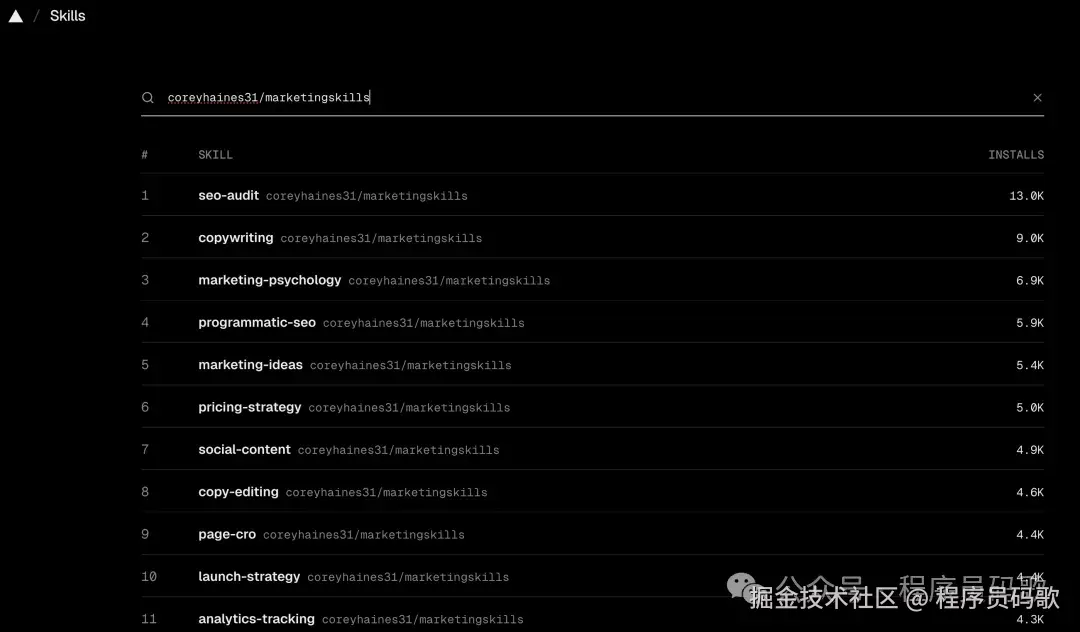

最近skills.sh(skills.sh/) 上最火的10个Skills,安装量加起来已经超过10万了。我花了几天时间,把这Top 10全装了一遍,挨个测试,结果只能用一句话形容:

有些确实牛逼,有些就是凑数的!但总体来说,跟着社区选不会错,实打实的用户下载安装!

关于Skills的前世今生,如果还不熟悉的同学推荐看下我之前的的几篇文章,这里不再展开说明,传送门:

1、火爆全网的Skills,看这一篇就够了!

2、谁还手动管技能?Vercel 开源 add-skill + skills.sh,一行命令搞定所有

注意!注意!注意!

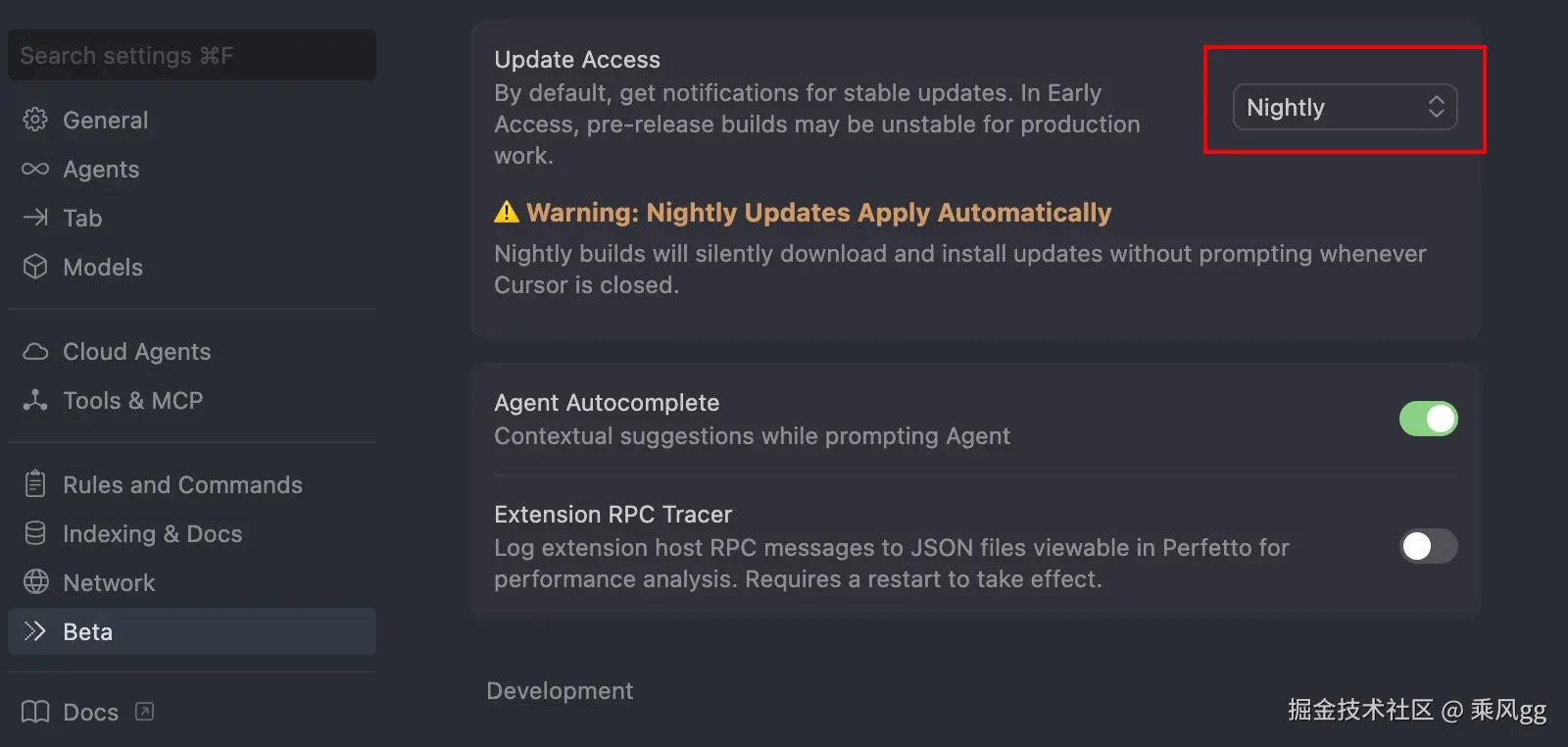

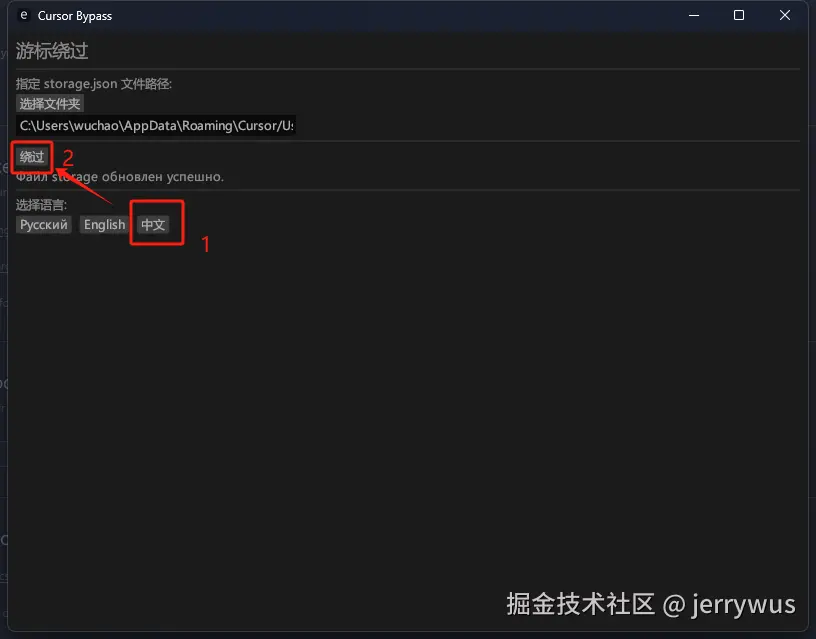

最新版cursor(mac 2.5.0)默认读取的全局skills目录是 /.cursor/skills-cursor,而skills add安装命令默认为cursor添加的目录是/.cursor/skills,我们只需要手动再次添加下符号链接就行,以后每次安装也会同步到skills-cursor目录,命令如下:

mac:

cd ~/.cursor

ln -s skills skills-cursor

windows:

cd %USERPROFILE%.cursor

rmdir /s /q skills-cursor

mklink /D skills-cursor skills

一、为什么Top 10值得关注?

skills.sh上的安装量都是实打实的。几十w+安装不是刷的,是真有这么多人在用(就像B站播放量,虽然可能有水分,但大部分都是真用户)。

这些人天天用Claude Code写代码、做产品,他们愿意装,说明确实有用。跟着装就行,不用自己判断"这玩意到底行不行",社区已经帮你筛过一遍了(群众的眼睛是雪亮的)。

废话不多说,直接上干货。我会把每个Skill的实际使用效果、适合谁、值不值得装都告诉你(不画饼,只讲实话)。

二、Top 10 Skills完整拆解(干货来了)

先说个整体情况:Top 10里7个是给开发者的(程序员果然是AI的主力用户),3个对产品、运营、设计师也有用(终于不是程序员专属了)。

我把值得详细说的挑出来讲,其他的列个表就行(重点突出,不浪费大家时间)。

开发者专用的(7个)(程序员福利)

这7个都是给写代码的人用的,非开发者可以直接跳到下一节(别看了,看了也看不懂)。

| 排名 | Skill | 安装量 | 干嘛用的 | 值不值得装 |

|---|---|---|---|---|

| 1 | vercel-react-best-practices | 37600+ | React/Next.js性能优化,57条规则 | ⭐⭐⭐⭐⭐ 前端必装 |

| 2 | web-design-guidelines | 28500+ | 检查网页是否符合设计规范 | ⭐⭐⭐⭐ UI返工多的人必装 |

| 3 | remotion-best-practices | 18800+ | 用代码做视频的最佳实践 | ⭐⭐⭐ 做视频的才需要 |

| 5 | skill-creator | 3700+ | 官方出的,教你怎么创建Skill | ⭐⭐⭐ 想自己做Skill的装 |

| 6 | building-native-ui | 2700+ | Expo手机App开发指南 | ⭐⭐⭐ 做移动端的装 |

| 8 | better-auth-best-practices | 2300+ | 登录认证系统最佳实践 | ⭐⭐⭐⭐ 做登录的必装 |

| 10 | upgrading-expo | 2200+ | Expo框架升级指南 | ⭐⭐ 升级时才用 |

实际测试感受:

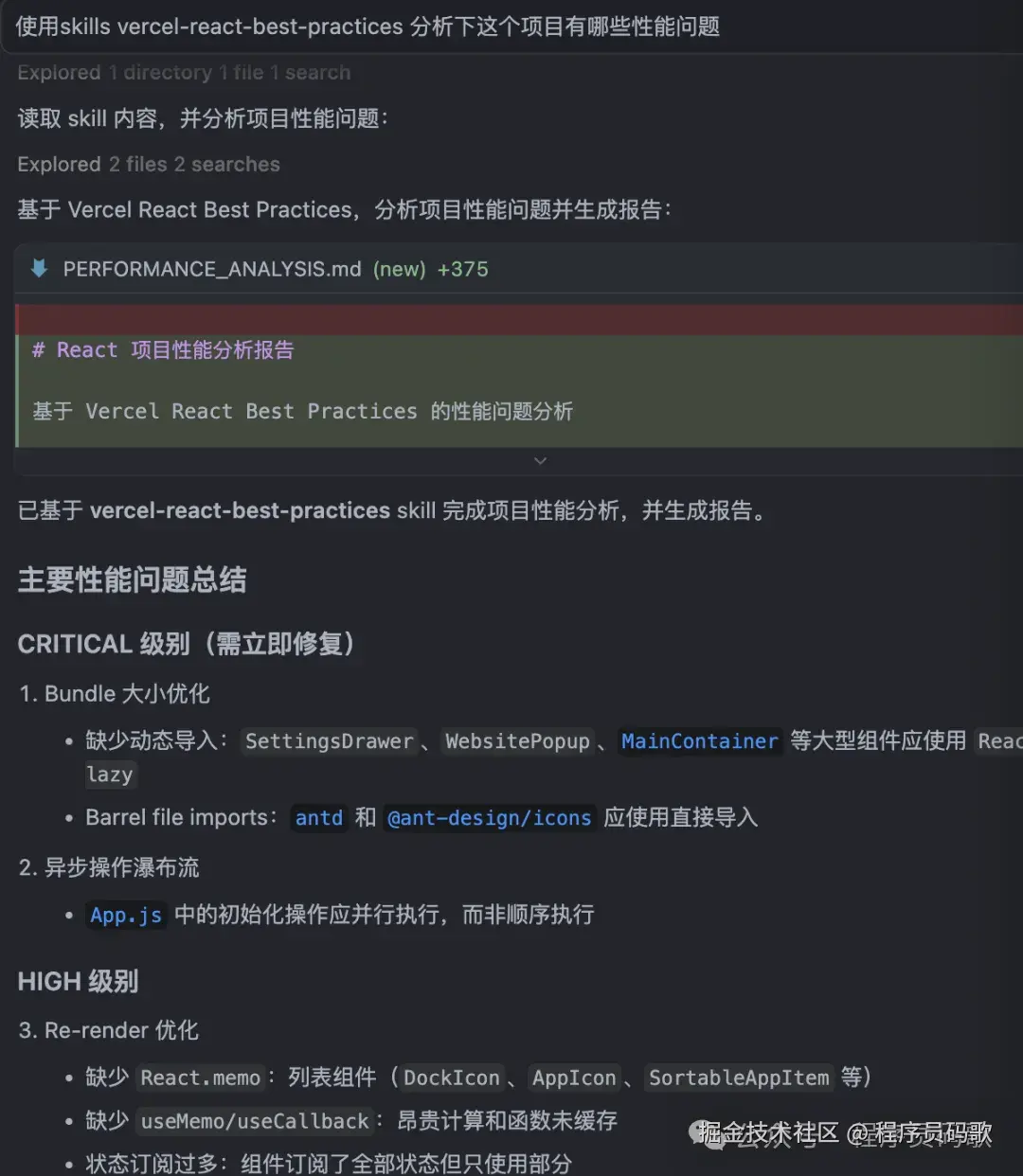

1、vercel-react-best-practices:这个确实牛逼。我叫他使用这个skills分析下我之前的项目“AI灯塔导航”,它直接指出了几个性能问题:Re-render 优化、事件监听器、1渲染性能等。改完之后性能提升明显。前端开发必装。

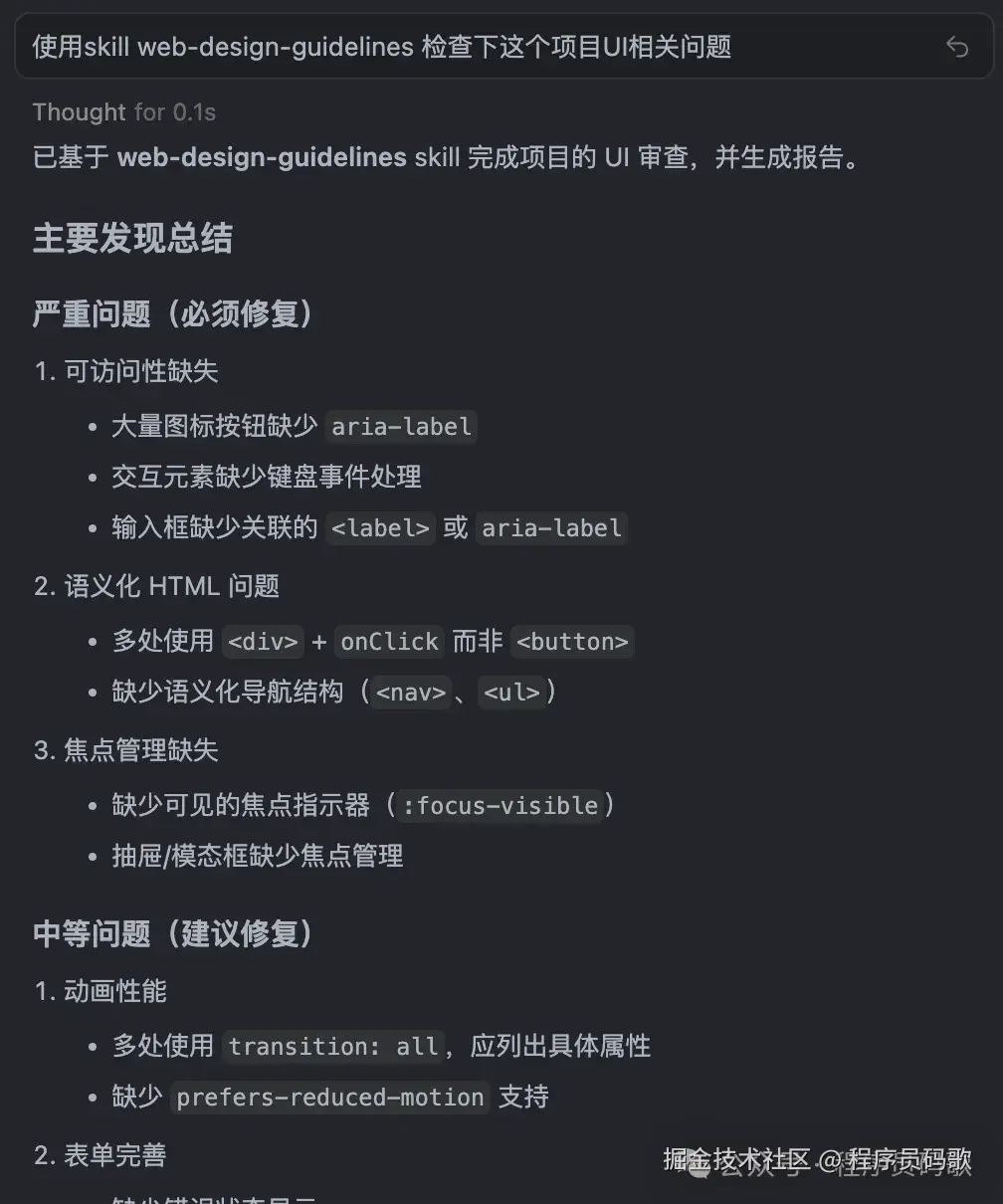

2、web-design-guidelines:UI审查很细致(比设计师还严格)。我让cursor用这个skill检查下项目“AI灯塔导航”UI相关问题,它指出了可访问性缺少、语义化HTML问题、焦点管理缺失等不符合规范等10多个问题(就像找了个严格的老师,一点小问题都不放过)。产品经理和设计师协作多的,这个很有用(终于不用再因为设计规范问题吵架了)。

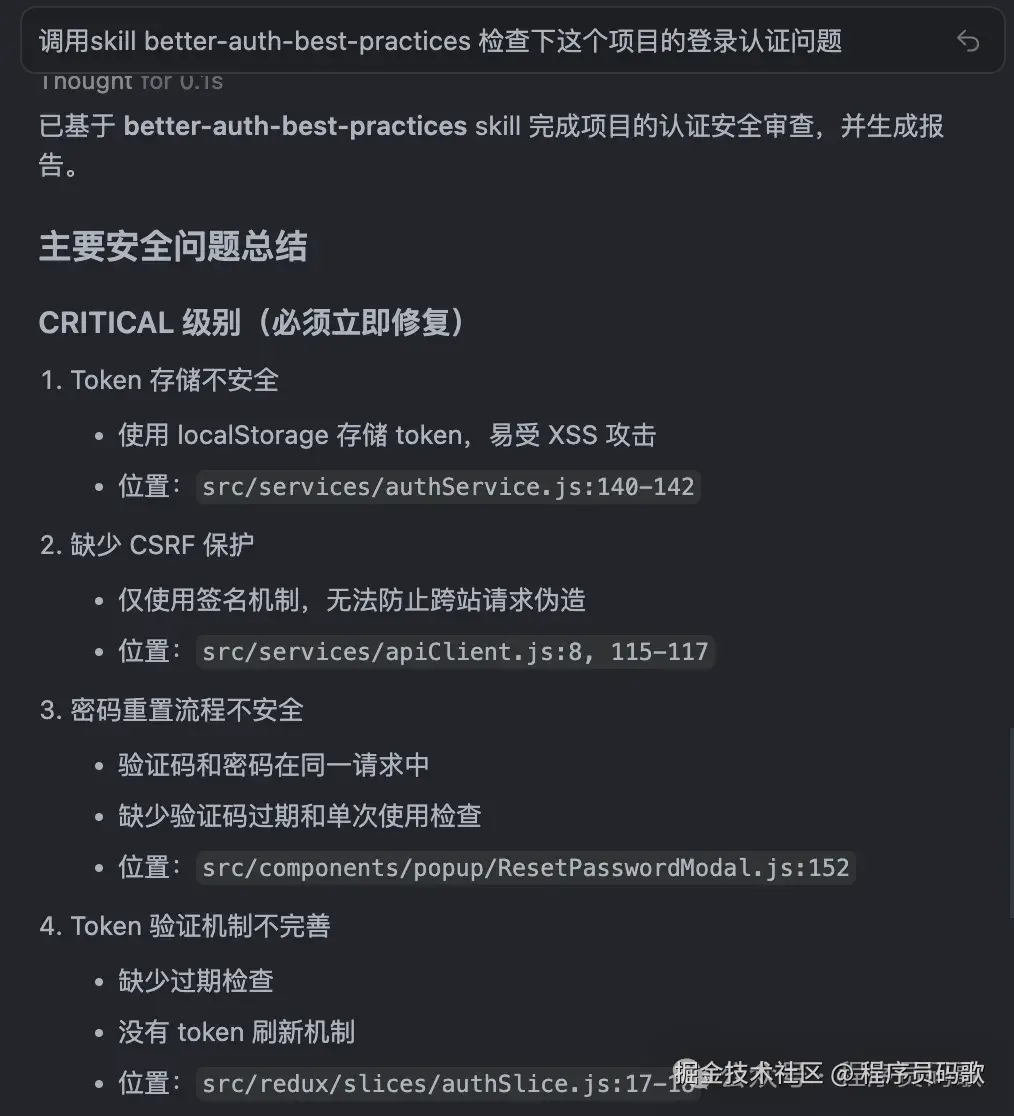

3、better-auth-best-practices:登录认证这块踩坑多(就像过雷区,一不小心就炸),这个Skill把常见问题都覆盖了:密码加密、JWT过期处理、CSRF防护、OAuth流程等(就像给了你一张"避雷地图")。做登录系统的,装了这个能少踩很多坑(终于不用再因为安全问题被用户投诉了)。

所有人都能用的(3个)⭐(重点来了)

这3个是我觉得Top 10里最值得说的,不写代码也能用(终于不用再羡慕程序员了)。

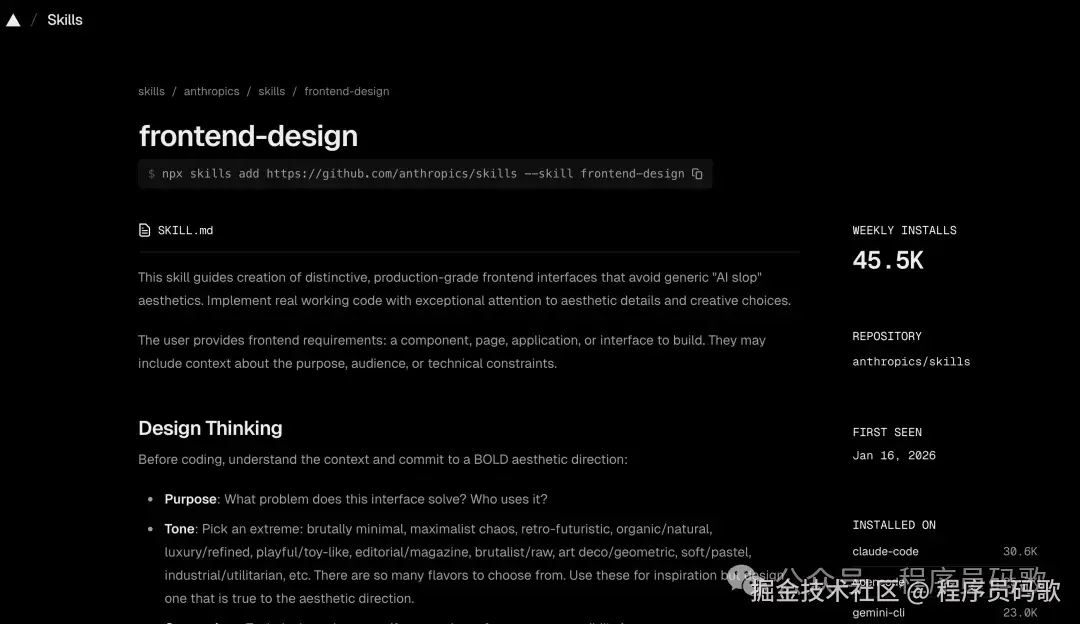

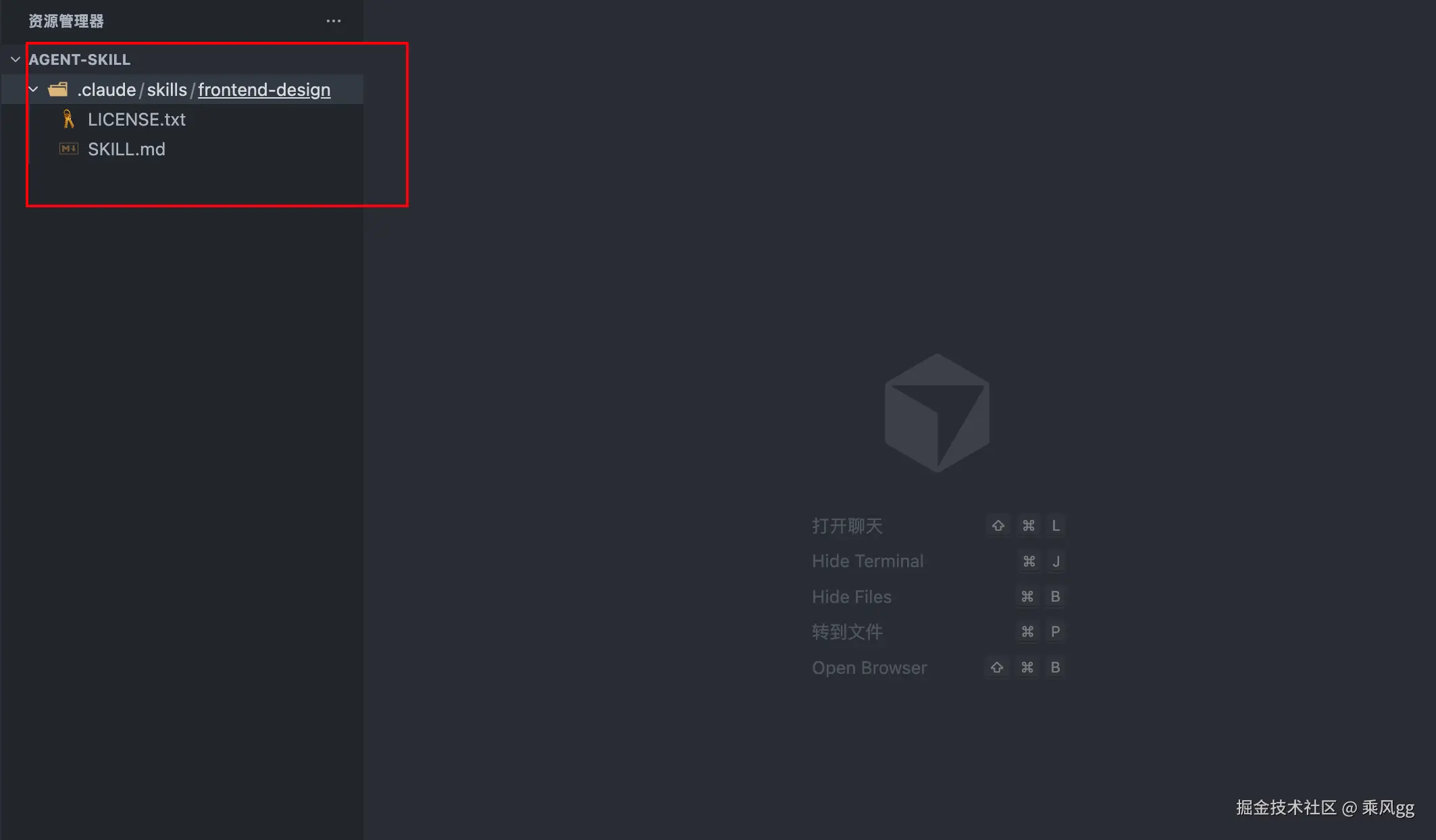

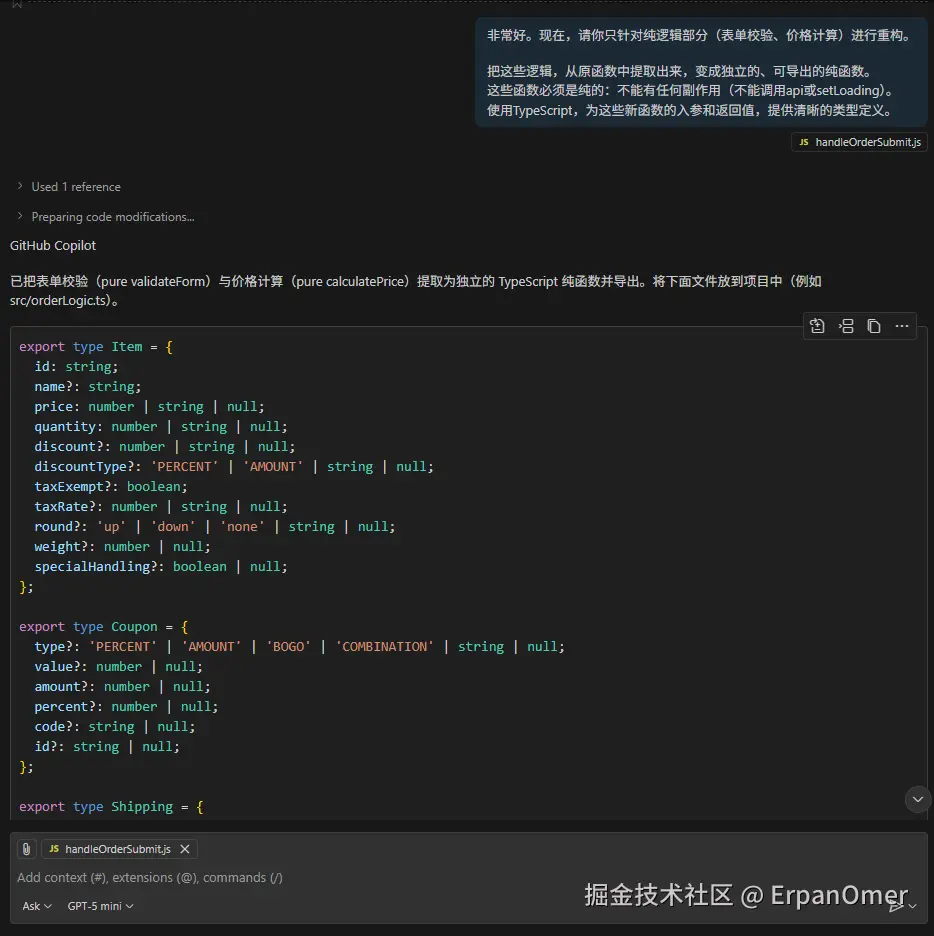

1、frontend-design(45.5k +安装)

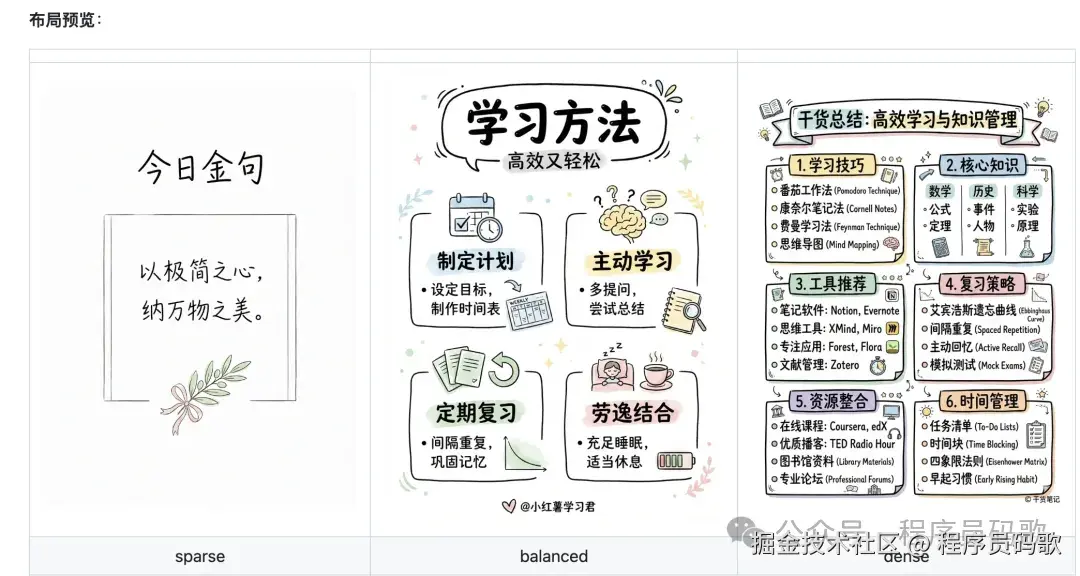

来自Anthropic官方。目标很简单:让Claude做出来的东西别那么"AI味" 。

你可能有过这种体验——让Claude帮忙做个网页或PPT,出来的东西能用,但没特色,一眼就知道是AI做的(就像穿了校服,虽然整齐但毫无个性)。这个Skill就是治这个的,专门给AI的设计"整容"。

它明确告诉Claude不要用什么:

- 不要用Inter、Roboto、Arial这些"标准字体"(太没个性)

- 不要用紫色渐变配白底(AI最爱用,已经烂大街了)

- 不要用对称布局(打破常规才有设计感)

同时告诉Claude应该怎么做:

- 选择有个性的字体

- 配色要有主次,主色大胆、强调色锐利

- 动效要克制,一个精心设计的页面加载动画,比到处都在动更高级

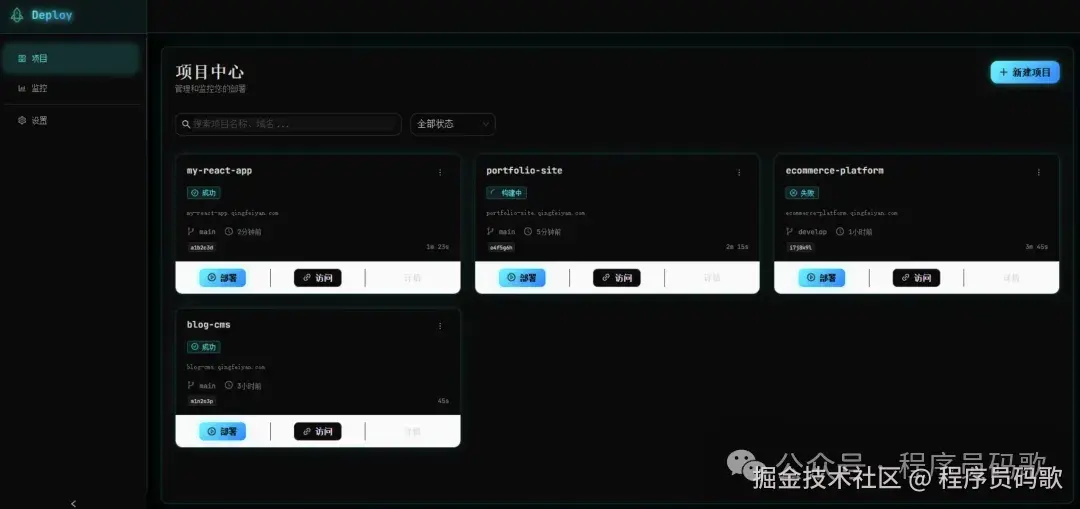

实际测试: 我让Claude用这个Skill帮我设计一个部署平台原型,确实比之前有设计感多了。虽然还是能看出是AI做的(毕竟AI的"审美"还是有迹可循),但至少不那么"标准"了,至少从"一眼AI"变成了"需要仔细看才能发现是AI"。

安装命令:

npx skills add https://github.com/anthropics/skills --skill frontend-design

2、agent-browser(24.1k+安装)

这个Skill不太一样,它不是"知识库",而是"工具"(就像给Claude装了个机械臂)。装上之后,Claude可以帮你操作浏览器:

- 自动打开网页、点击按钮、填写表单(终于不用自己点点点了)

- 批量截图(再也不用一张一张手动截)

- 自动登录网站(保存登录状态,下次直接用,懒人福音)

- 录制操作过程(以后可以回放,看看AI是怎么"思考"的)

实际测试: 我让Claude帮我登录5个平台查数据,它真的自动完成了。虽然有些网站需要验证码会卡住(AI再聪明也过不了"你是人类吗"这关),但大部分操作都能自动化。运营、测试、产品都能用得上,特别是那些重复性的"点点点"工作。

安装命令:

npx skills add https://github.com/vercel-labs/agent-browser --skill agent-browser

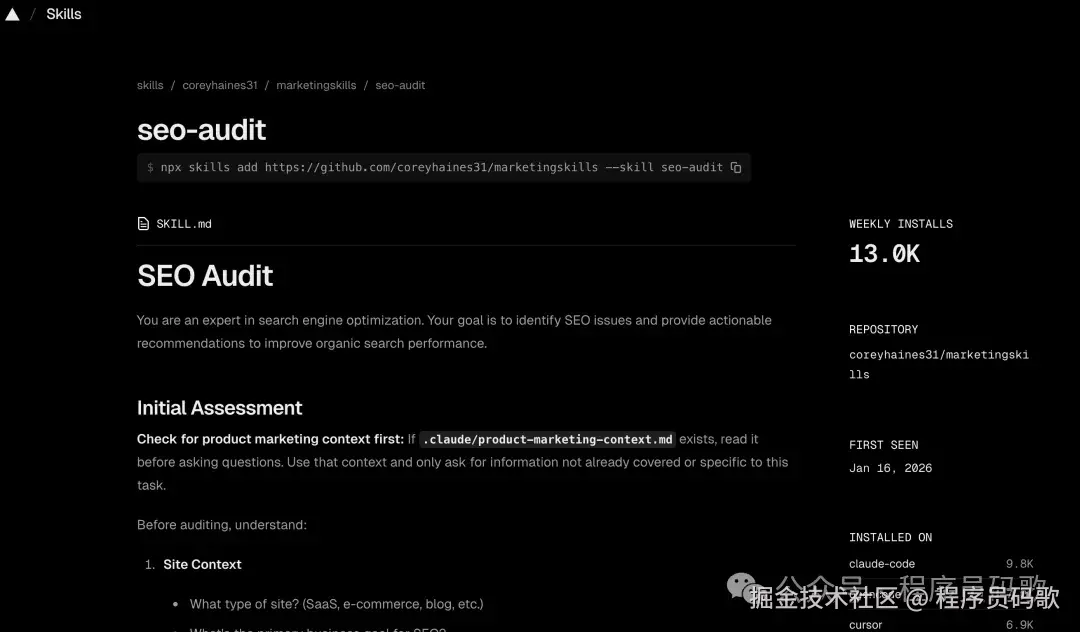

3、seo-audit(13k+安装)

终于来了一个纯运营向的Skill(程序员终于不用再被问"为什么网站搜不到"了)。

这是一个完整的SEO审计框架,让Claude帮你检查网站的SEO健康度(就像给网站做体检):

- 能被Google找到吗?(爬虫能不能访问、有没有被收录,别做"隐形网站")

- 网站快不快?(加载速度影响排名,慢得像蜗牛可不行)

- 内容优化了吗?(标题、描述、关键词布局,别让搜索引擎"看不懂")

- 内容质量够不够?(是否值得被推荐,别写一堆废话)

- 有没有可信度?(外链、权威性,别让人家觉得你是"野鸡网站")

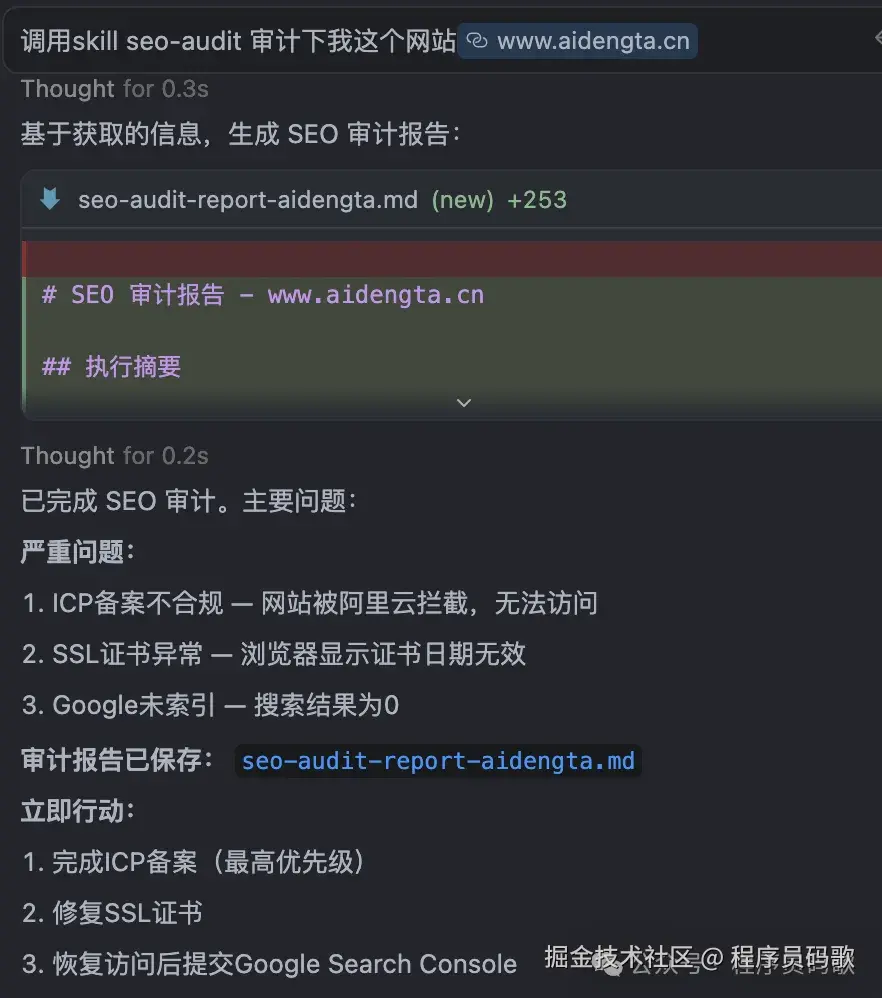

实际测试: 我让Claude审计了一下我的项目“AI灯塔导航”,它给出了多个真实存在的问题,每个都标明了影响程度和修复优先级(就像医生开药方,告诉你先治什么后治什么)。做网站的都能用,不需要懂技术(终于不用再求程序员了)。

安装命令:

npx skills add https://github.com/coreyhaines31/marketingskills --skill seo-audit

三、额外收获:23个营销Skills

Top 10里大部分是开发向的,但别急(程序员也有春天)。

我在安装过程中发现了一个宝藏仓库:coreyhaines31/marketingskills

这个仓库有23个营销相关的Skill,从文案到定价到投放都有(一站式营销工具箱,比瑞士军刀还全):

| Skill | 功能 | 适合谁 |

|---|---|---|

| copywriting | 营销文案写作 | 市场、运营 |

| copy-editing | 文案润色修改 | 市场、运营 |

| pricing-strategy | 定价策略设计 | 产品、创业者 |

| launch-strategy | 产品发布策略 | 产品、市场 |

| seo-audit | SEO诊断 | 运营、独立开发者 |

| ab-test-setup | A/B测试设计 | 产品、运营 |

| page-cro | 落地页转化优化 | 运营、增长 |

| signup-flow-cro | 注册流程优化 | 产品、增长 |

| email-sequence | 邮件营销序列 | 市场、运营 |

| social-content | 社交媒体内容 | 市场、运营 |

| paid-ads | 付费广告投放 | 市场 |

| referral-program | 推荐计划设计 | 增长、产品 |

| marketing-psychology | 营销心理学 | 市场、产品 |

安装命令:

npx skills add coreyhaines31/marketingskills --yes

一次性装23个。

我的看法: 做产品、运营、市场的,这个仓库比Top 10更值得装(就像找到了组织,终于不用再自己摸索了)。

四、熟悉的宝玉老师的Skills

翻Top 100的时候,发现了一些熟悉的名字——宝玉老师(@dotey)的Skills(就像在异国他乡遇到了老乡,亲切感爆棚)。

宝玉老师是X上的AI大V,经常分享Claude Code的使用心得。他把自己的工作流打包成了一堆Skills,放在 jimliu/baoyu-skills 仓库(这就是传说中的"授人以渔不如授人以鱼"):

| Skill | 功能 | 安装量 |

|---|---|---|

| baoyu-slide-deck | 幻灯片生成 | 972 |

| baoyu-article-illustrator | 文章配图 | 938 |

| baoyu-cover-image | 封面图生成 | 868 |

| baoyu-xhs-images | 小红书图片 | 841 |

| baoyu-comic | 漫画生成 | 822 |

| baoyu-post-to-wechat | 发布到微信 | 752 |

| baoyu-post-to-x | 发布到X | 725 |

| baoyu-infographic | 信息图生成 | 480 |

这些Skills对中文用户特别友好——小红书图片、发微信、文章配图,都是我们平时会用到的(终于不用再自己手动P图了,AI帮你搞定一切)。

安装命令:

npx skills add jimliu/baoyu-skills --yes

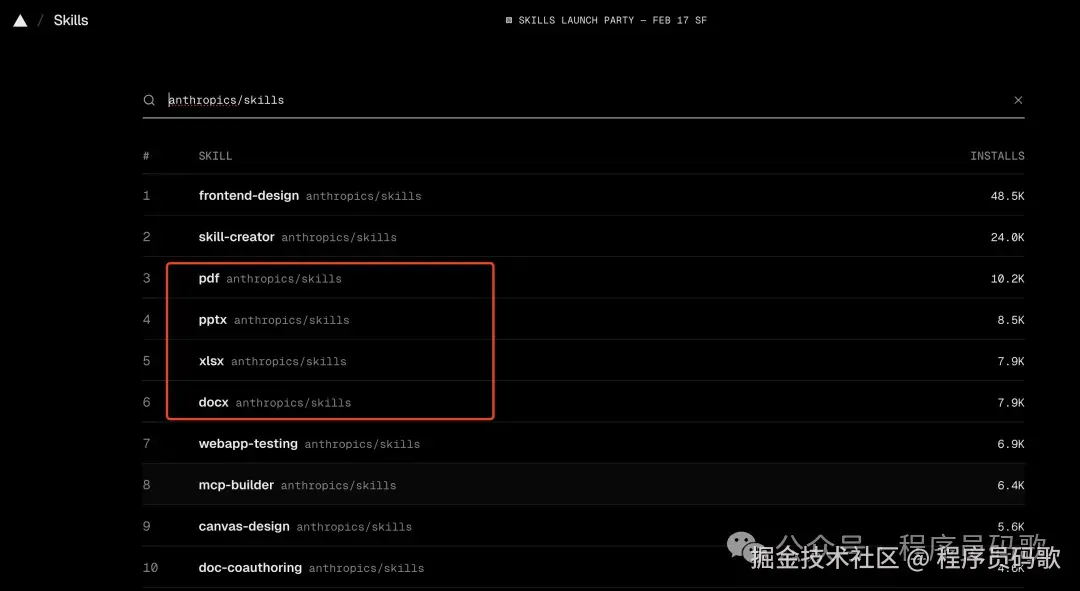

五、文档处理四件套

Anthropic官方仓库(anthropics/skills)里有4个文档处理Skill(就像Office套件,但这次是AI版的):

- pdf —— PDF读取、提取、合并(再也不用装各种PDF工具了)

- docx —— Word文档处理(写文档、改格式,AI帮你搞定)

- pptx —— PPT生成和编辑(做PPT终于不用熬夜了)

- xlsx —— Excel处理(数据分析、公式计算,AI比你算得还快)

这几个所有人都能用。装上之后让Claude帮你处理文档,会顺手很多(就像给AI装了个Office,但它比Office还聪明)。

安装命令:

npx skills add anthropics/skills --yes

六、为什么你应该去看看skills.sh

说两个实际的好处(不画饼,都是大实话)。

第一,这些Skill确实有用(不是智商税)。

skills.sh上排名靠前的,都是被大量vibe coder实际装过、用过的。37000+安装不是刷的,是真有人在用(就像淘宝好评,虽然可能有刷的,但大部分都是真用户)。

这些人天天用Claude Code写代码、做产品,他们愿意装,说明确实有用。跟着装就行,不用自己判断"这玩意到底行不行",社区已经帮你筛过一遍了(就像跟着大众点评选餐厅,虽然不一定最好,但至少不会踩雷)。

第二,这是学习Skills最好的方式(比看文档强多了)。

很多人看了我之前的文章,知道Skills是啥了,但还是不知道怎么下手——自己的Skill该怎么写?(就像知道怎么吃,但不知道怎么做)

最好的学习方式不是啃文档,是看别人怎么写的(就像学做菜,看视频比看菜谱快)。

装几个热门Skill之后,让Claude Code或者cursor等agent帮你解读:

帮我读取并解释 ~/.agents/skills/seo-audit/SKILL.md 的实现逻辑

Claude会告诉你(就像找了个老师,手把手教你):

- 这个Skill的触发条件是怎么写的(什么时候AI会"想起来"用这个Skill)

- 指令是怎么组织的(怎么让AI"听话")

- 为什么要这样分层(为什么这样设计更合理)

- 哪些设计可以借鉴(哪些可以"抄作业")

看3-5个写得好的,你就知道了(就像看了几部好电影,就知道怎么拍电影了):

- Skill该怎么组织(结构怎么搭)

- 好的Skill长啥样(标准是什么)

- 自己的工作流怎么打包(怎么把自己的经验变成Skill)

从模仿开始,比从零开始容易多了(站在巨人的肩膀上,总比自己造轮子强)。

所以我建议:先装、先用、先看,再想自己要不要做(实践出真知,别光想不做) 。

七、几个实际建议

1. 根据你的岗位选择(别乱装)

- 开发者:vercel-react-best-practices、anthropics/skills(写代码的,装这些就够了)

- 产品经理:seo-audit、marketingskills仓库、agent-browser(做产品的,这些能帮你省很多事)

- 设计师:frontend-design、web-design-guidelines(做设计的,让AI帮你检查规范)

- 运营/市场:marketingskills仓库(23个全装上,一站式解决所有营销问题)

2. 别贪多(装太多会卡)

我装了50+个是为了写这篇文章。平时用的话,选3-5个高频的就够了

装太多,Claude启动时要加载的东西多,还是会影响上下文的。

3. 注意来源(安全第一)

Skills可以包含可执行脚本,所以要看谁发的(别什么Skill都装,小心被"钓鱼"):

- ✅ anthropics/skills(Anthropic官方,官方出品,必属精品)

- ✅ vercel-labs(Vercel官方,大厂出品,值得信赖)

- ✅ 框架官方(expo/skills等,官方维护,更新及时)

- ⚠️ 个人仓库谨慎点(就像下载软件,别从不明来源下载)

4. 先用再说(实践是检验真理的唯一标准)

不用完全搞懂原理,先装一两个用起来。用过才知道好不好(就像买衣服,不试穿怎么知道合不合适)。

八、最后,别光看,快去试

skills.sh出来之后,用Skills变简单了,以前得自己写,现在直接装别人的就行(站在巨人的肩膀上,真香)。而且不只是程序员能用——营销、产品、运营,都有对应的Skills(AI终于不只是程序员的玩具了)。

去skills.sh看看,找一两个和你工作相关的装上试试(别光看,动手试试,又不会怀孕)。

比如你是运营,装个seo-audit,然后问Claude:"帮我审计一下我们的官网SEO"(终于不用再求程序员了)。

比如你是产品,装个pricing-strategy,然后问Claude:"帮我分析一下我们产品的定价策略"(终于不用再拍脑袋定价了)。

试过就知道好不好使了(实践出真知,别光听我说)。

哦对,虽然上面给了你怎么安装这些skills的代码,但其实最佳实践还是你直接把这篇文章,以及把skills.sh的网址丢给Claude Code 或者 Cursor,用自然语言让他帮你选择及安装就好了(让AI帮你装AI的Skill,这就是AI的"自举")。

我是”程序员码歌“,全网昵称统一,10+年大厂程序员,专注AI工具落地与AI编程实战输出,在职场,玩转副业,目标副业年收入百万,探索可复利、可复制的一人企业成长模式,可去gzh围观

来源:juejin.cn/post/7604757482005053503

AI 只会淘汰不用 AI 的程序员🥚

作为程序员,你竟然还在手撸代码 ???

如果没有公司给你提供科学上网,提供AI 编程工具的账号,你真能玩转AI ???

除了平时搜搜查查,AI 对你还有其他用处 ???

震惊!

某博主竟然开头就贩卖焦虑?难道程序员真的要被 AI 取代了?

别急,这篇文章就一步步带你玩转 AI 编程!

如果只是想了解如何使用 AI 编程,可以直接跳到章节: 「所以,我们需要什么!?」

理解概念

要深入使用 AI,我们要先理解一些概念

1. AI 基础

- AI大模型:拥有超大规模参数、超级聪明的机器学习模型,所有的 AI 应用都是调用大模型的计算处理能力。如:问答、图片生成、视频生成。

国内主流大模型对比:

| 模型 | 厂商 | 速度 | 能力 |

|---|---|---|---|

| 通义千问 | 阿里云 | 较快 | 多轮对话,支持多模态,支持 PDF/Word 等文件处理。 |

| DeepSeek | 深度求索 | 推理性能一流,较慢 | 多轮对话,代码能力国内顶级,数学推理能力出色,多模态能力弱。 |

| 豆包🐂 | 字节跳动 | 速度极快 | 推理能力强,多模态能力强,语音交互自然,MCP预置多。 |

| 腾讯混元 | 腾讯 | 较快 | 支持超长文本处理,与微信生态无缝集成,多格式文档解析,支持多模态。 |

国外主流大模型对比

| 模型 | 厂商 | 核心能力 | 主攻场景 |

|---|---|---|---|

| Gemini🐂🍺 | Google DeepMind | 多模态能力强大,可无缝处理文本、图像、音频、视频、代码等 | 创意内容创作、文档处理、用于处理复杂、多源信息的场景 |

| Claude🐂🍺 | Anthropic | 推理能力优秀,多模态能力一般 | 长文档分析场景,如法律文件审查;适用于需要可靠输出的领域,如医疗诊断辅助 |

| Veo 3 | 自动生成视频和音频,口型同步精准到毫秒级。支持最高 4K 分辨率输出,画质清晰,色彩还原。生成速度快 | 专注于视频生成领域,如短视频内容创作,为用户提供高效、高质量的视频生成解决方案。 | |

| Sonnet | Anthropic | Sonnet 是 Claude 3 系列中的平衡型模型,性价比高 | 适用于注重性价比和处理速度的场景,如一般性的文档分析 |

| GPT | OpenAI | 通用性极强,各个方面都有出色表现,GPT-4o 等版本增强了多模态交互能力。 | 自然语言处理相关的场景,如内容创作、智能客服 |

| Copilot | GitHub 与 OpenAI 合作开发 | 基于 GPT 系列模型训练,理解自然语言,生成对应代码 | 用于日常编码、代码调试、新手编程学习,降低重复编码工作量 |

一般我们编程使用的都是国外的大模型,毕竟开发工具、系统、编程语言都是外国的。编码方面的能力,国外模型还是碾压的存在。

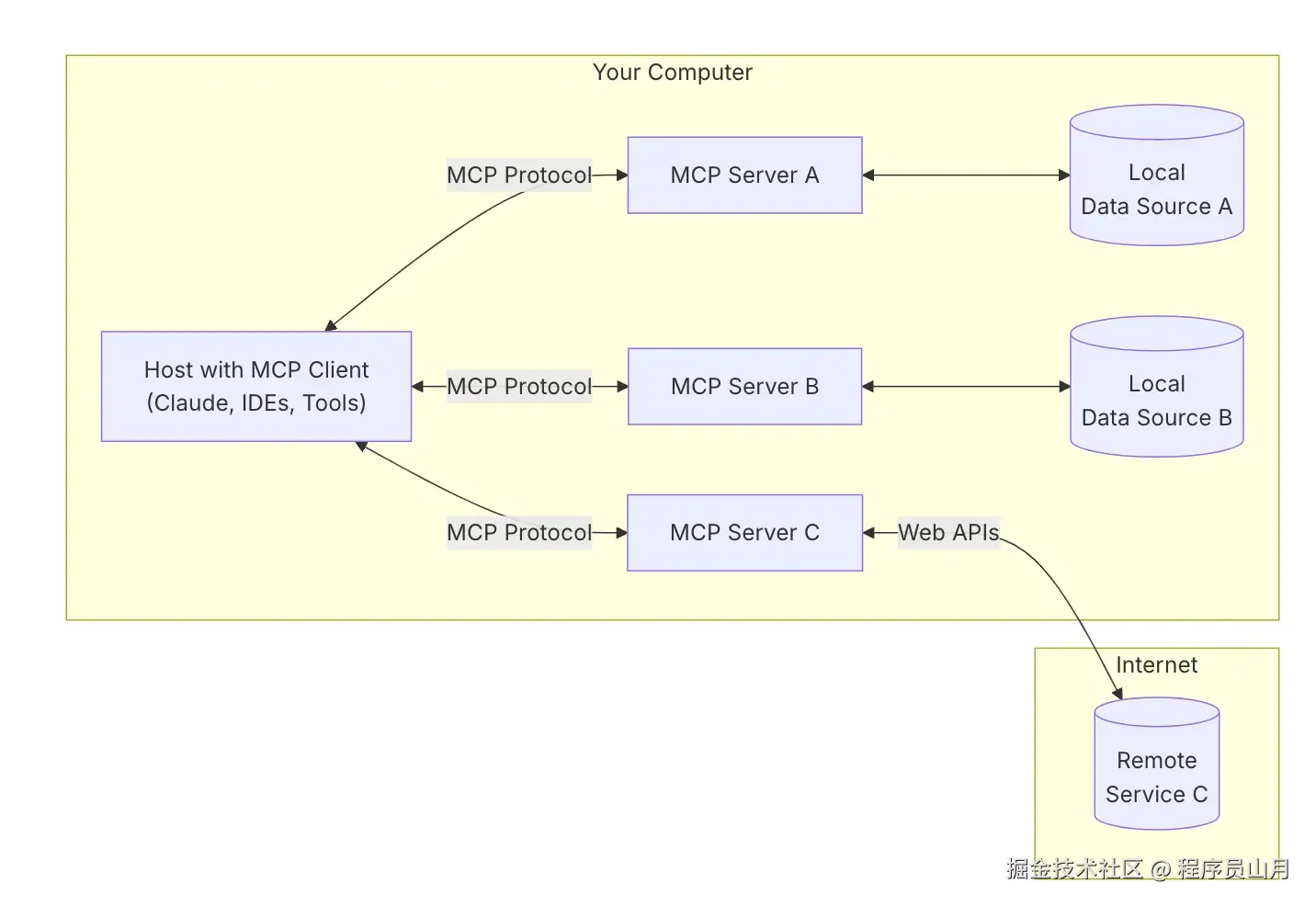

- MCP:一套提供给 AI 大模型调用的标准协议。一些厂商会把自己的能力包装成MCP,让大模型在理解完用户的复杂任务时,可以调用厂商的能力。比如:

你让豆包给你用 “高德” 生成一份超准的导航,豆包就会去调用高德的 MCP,为你出导航~ - IDE:程序员专属概念。AI IDE是集成了 AI 能力的软件开发平台,开发者可以通过自然语言,让 IDE 调用 AI 模型和 MCP 给你写代码,

速度和质量牛的飞起,真有手就能写代码!

主流的 AI IDE 对比

| 名称 | 厂商 | 搭载的模型 | 收费维度 |

|---|---|---|---|

| Cursor🐂 | Cursor 公司 | GPT-4、Claude 3.5、Cursor-small、o3-mini 等 | 很贵,按 token 收费 |

| Antigravity🐂🍺 | 支持在 Gemini 3 Pro、Claude Sonnet 4.5 和 GPT-OSS 等多种模型之间无缝切换 | 有羊毛薅,国外邮箱+学生认证~ | |

| Trae | 字节跳动 | 国内版搭载豆包 1.5-pro、DeepSeek R1/V3 等模型,海外版内置 GPT-4o、Claude-3.5-Sonnet 模型 | 国内的,充个会员的事,不贵 |

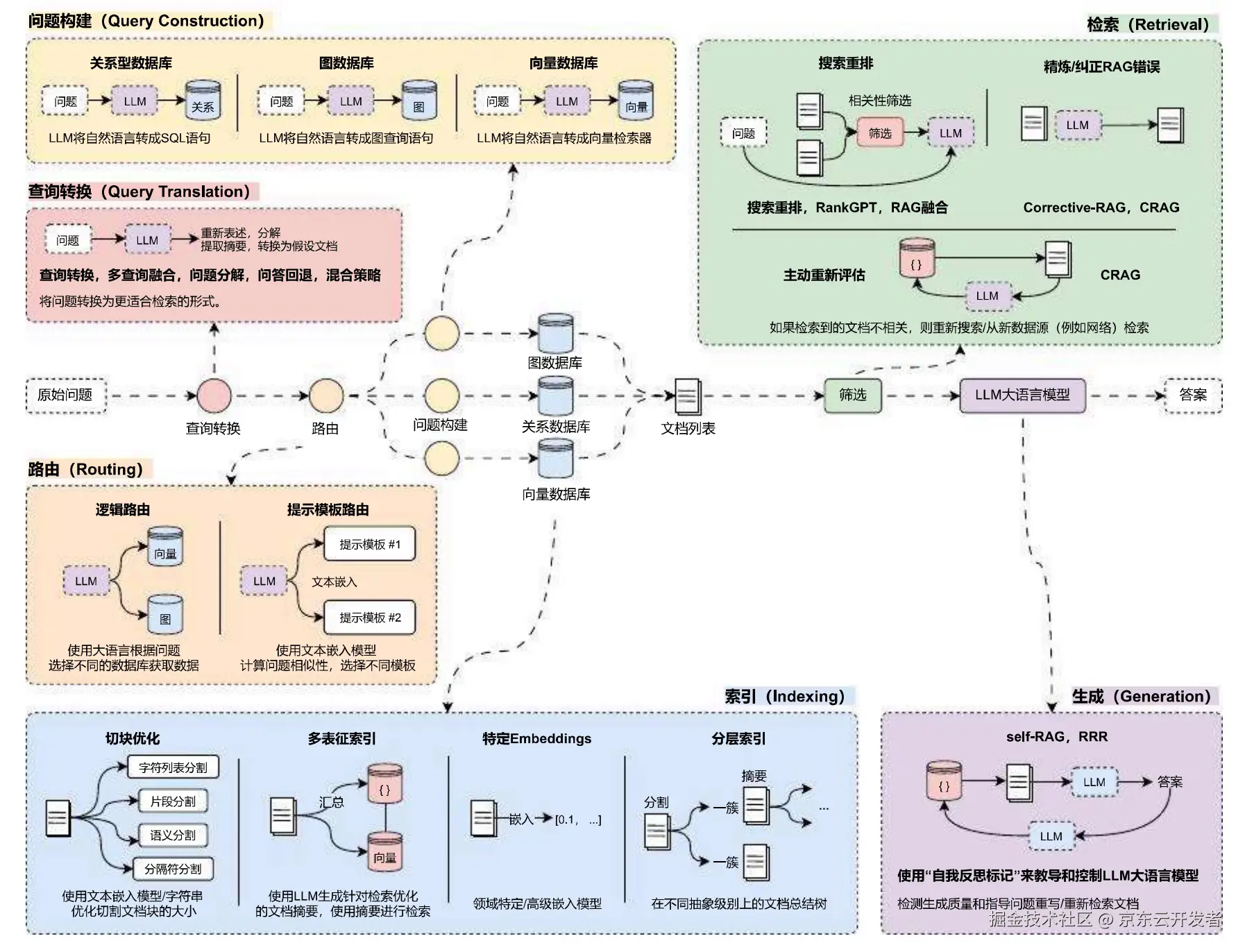

2. RAG ➡️ Agent ➡️ Planning:AI 应用方式的演进之路

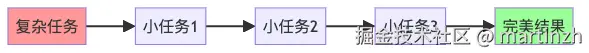

AI 的应用方式正从 “被动响应” 向 “主动规划” 快速迭代。

从 RAG 进行检索增强生成,到 AI Agent 实现自主调用工具完成任务,再到 Planning 能 “拆解复杂任务与全局决策” 的高阶形态。让 AI 从 “内容生成器” 蜕变到 “智能协作体”。

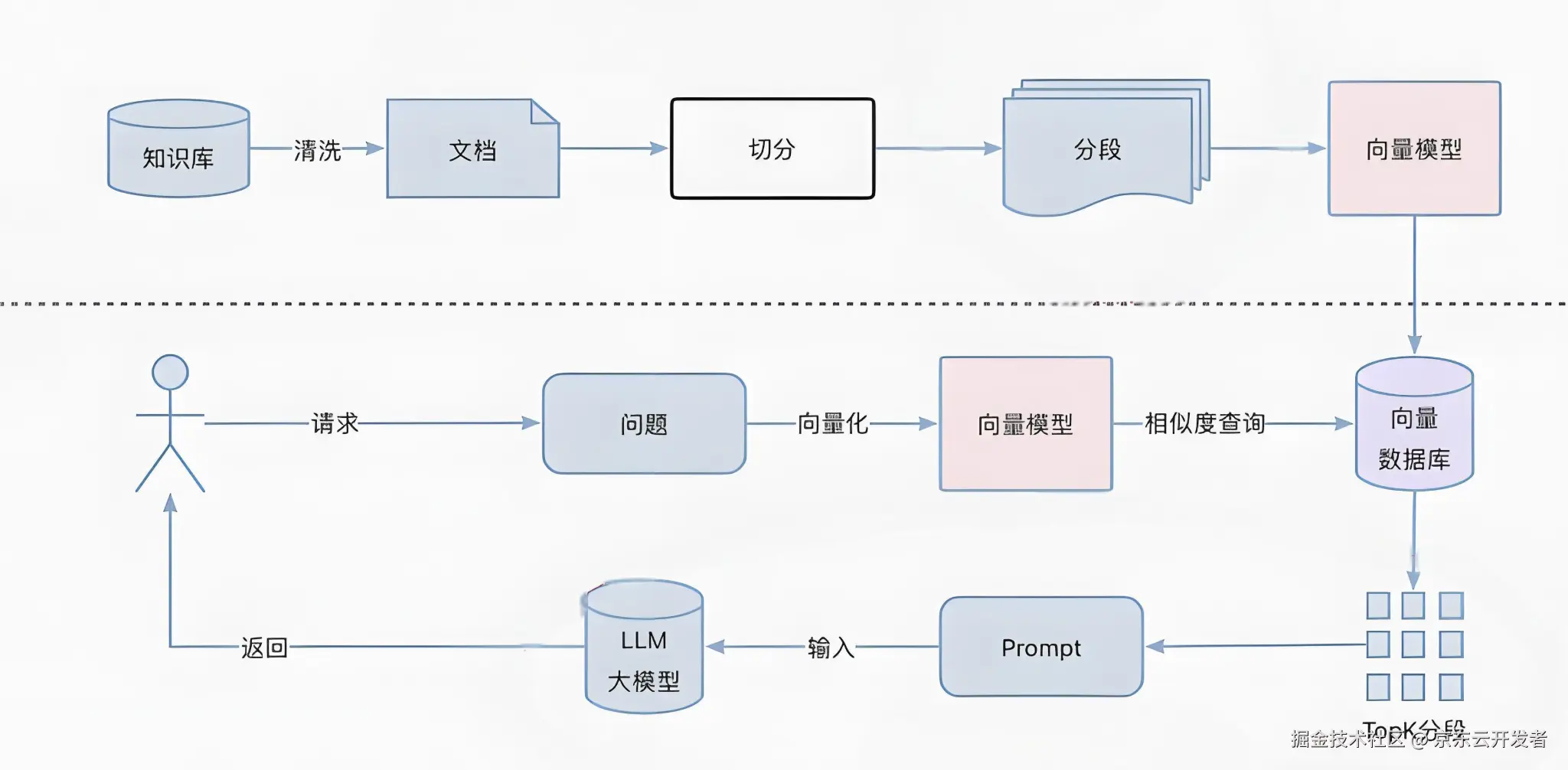

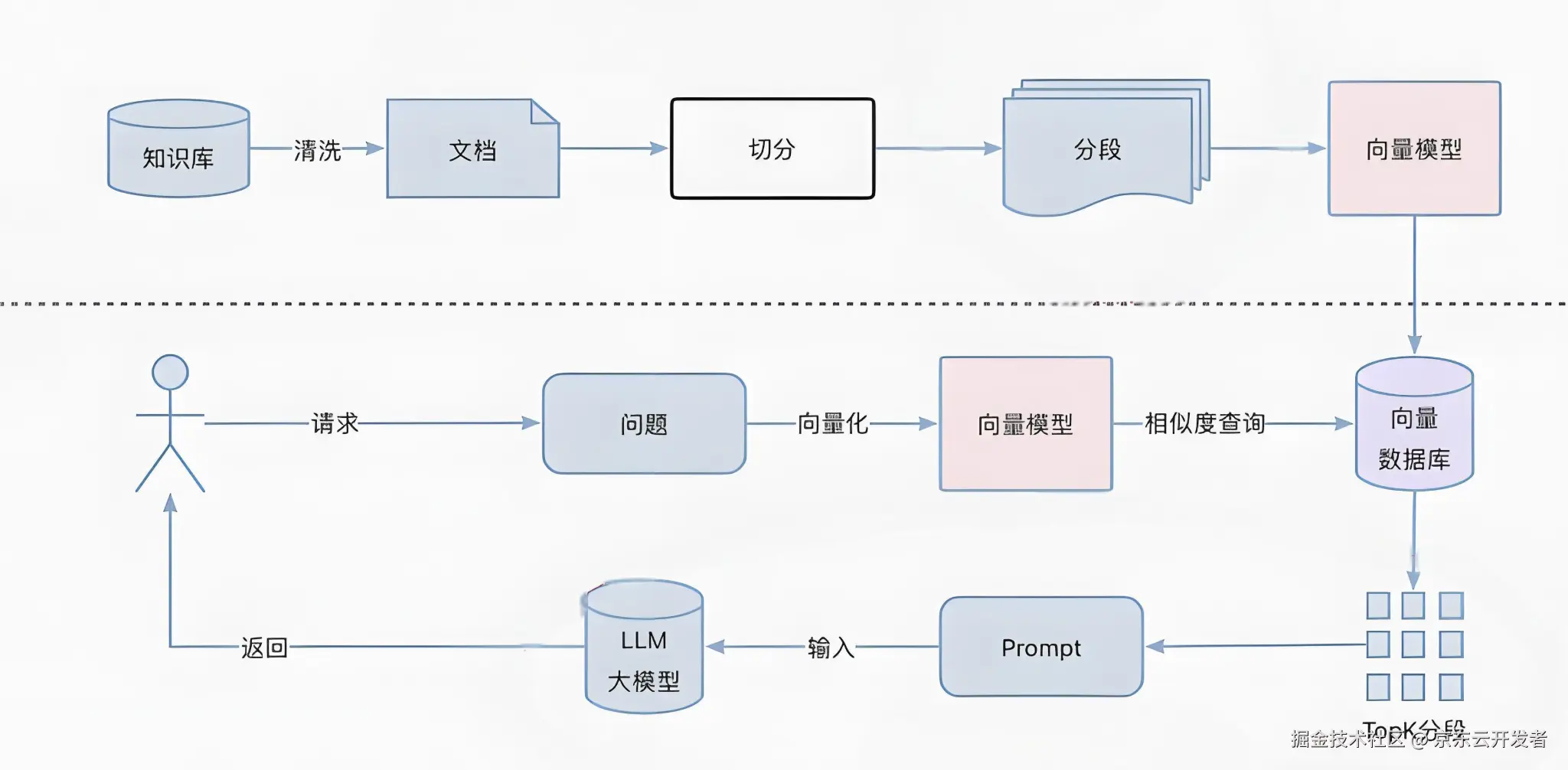

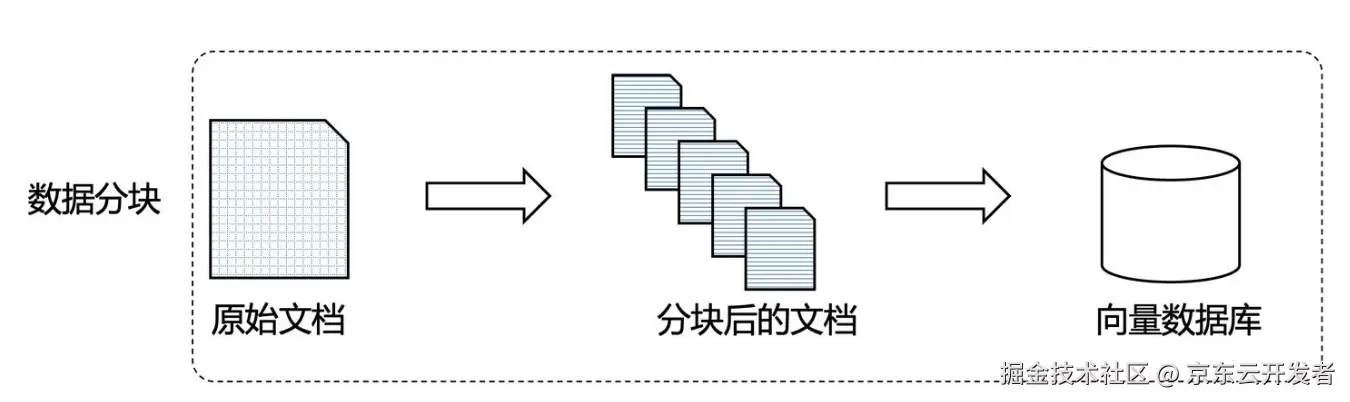

- RAG —— 检索增强生成

核心逻辑是:先检索,再生成。用户提出问题,先从外部数据库、文档库中检索与问题最相关的信息,再将这些信息作为 “参考资料” 喂给大模型,让模型基于真实数据生成回答。 - AI Agent —— “自主工具操作员”

AI Agent(智能体) ,让 AI 像人一样调用工具、执行步骤、验证结果。能理解用户的模糊需求,自主规划任务步骤,选择并调用合适的工具(如计算器、浏览器、代码解释器、RAG 系统),完成任务。 - Planning(规划)—— “全局任务指挥官”

AI 系统的高阶能力,核心逻辑是 “先拆解,再执行,再调整”。基于全局目标,将复杂、长期、多约束的任务拆解为有序的子任务序列,并根据执行过程中的反馈动态调整策略。

不仅关注单个任务的完成,更关注子任务之间的关联和整体目标的达成。

演进逻辑与核心差异总结

| 维度 | RAG(检索增强生成) | AI Agent(智能体) | Planning(规划) |

|---|---|---|---|

| 核心定位 | 大模型的 “知识库外挂” | 自主工作的 “工具操作员” | 全局任务的 “指挥官” |

| 能力核心 | 检索 + 生成,保证回答准确 | 决策 + 工具调用,完成单任务闭环 | 拆解 + 协同 + 动态调整,掌控多任务全局 |

| 典型比喻 | 学生的 “参考书” | 能独立完成工作的 “专员” | 统筹全局的 “项目经理” |

所以,我们需要什么!?

你作为一名优秀的程序员,你需要通过科学上网、精准付费,在 AI IDE中,基于AI大模型的能力,熟练使用 Agent/Planning,配合 MCP 等工具,让 AI 帮你写出又快又好的代码,更好的服务你的业务!

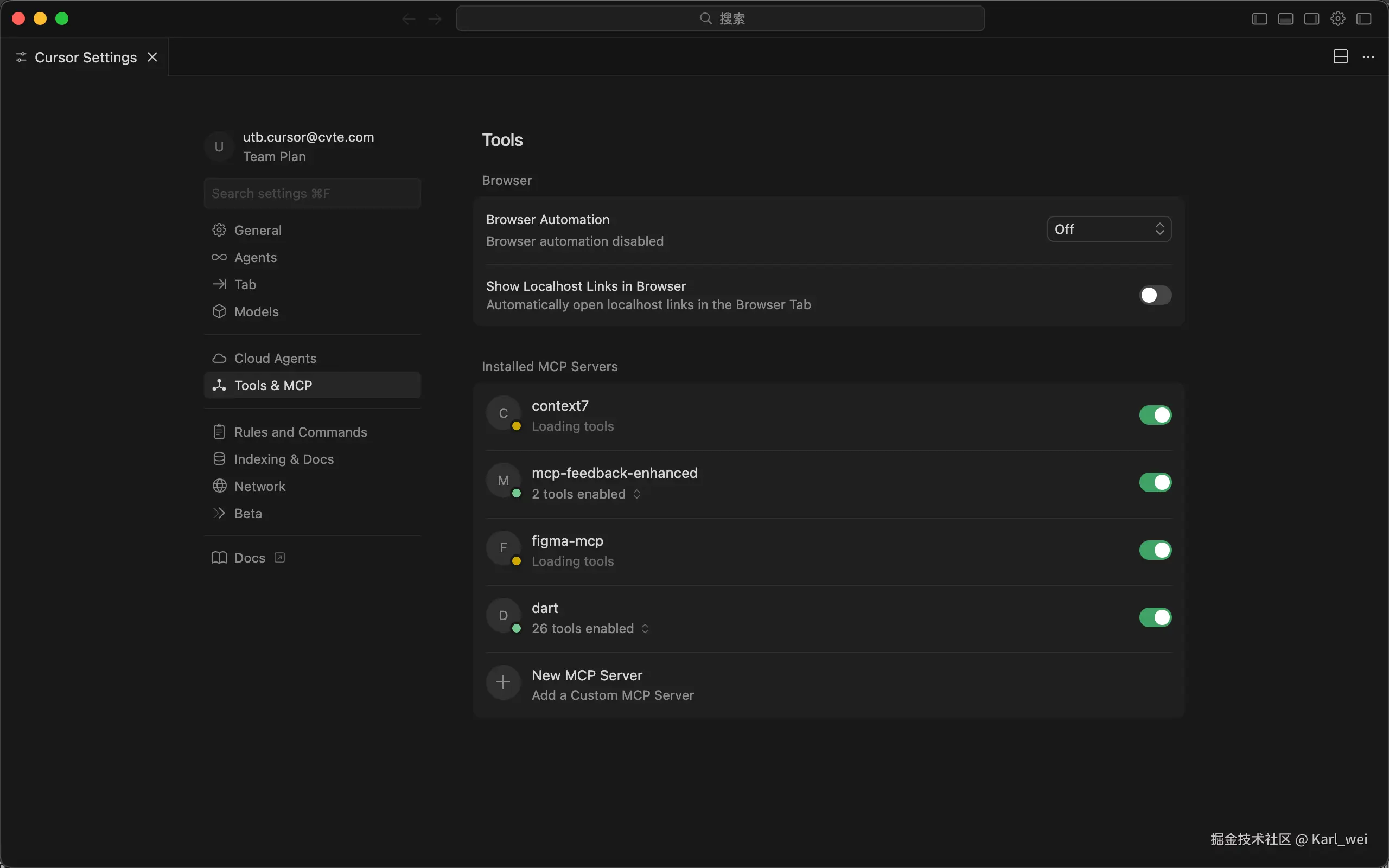

1. 使用 Cursor、Antigravity、Trae 开发工具

下载地址:Cursor、Antigravity、TREA

账号注册:Cursor 和 Trae 登录方式都超简单,会员的话直接去官网购买即可

至于 Antigravity,因为 Google 是禁止国内用户访问的,因此一定要能正常上网,邮箱账号必须纯正🇺🇸,但是我们有 闲鱼 之光,是可以尝试下的~

2. 装好主流 MCP

对于前端程序员,UI 这类低级工作,完全可以交给 Agent 去编写。比如:公司的设计师用的是figma,我们只需要在 cursor 中装上figma mcp,然后 figma 账号申请开发者权限,就能自由的让 AI 帮我们写好代码。亲测还原度 85%+

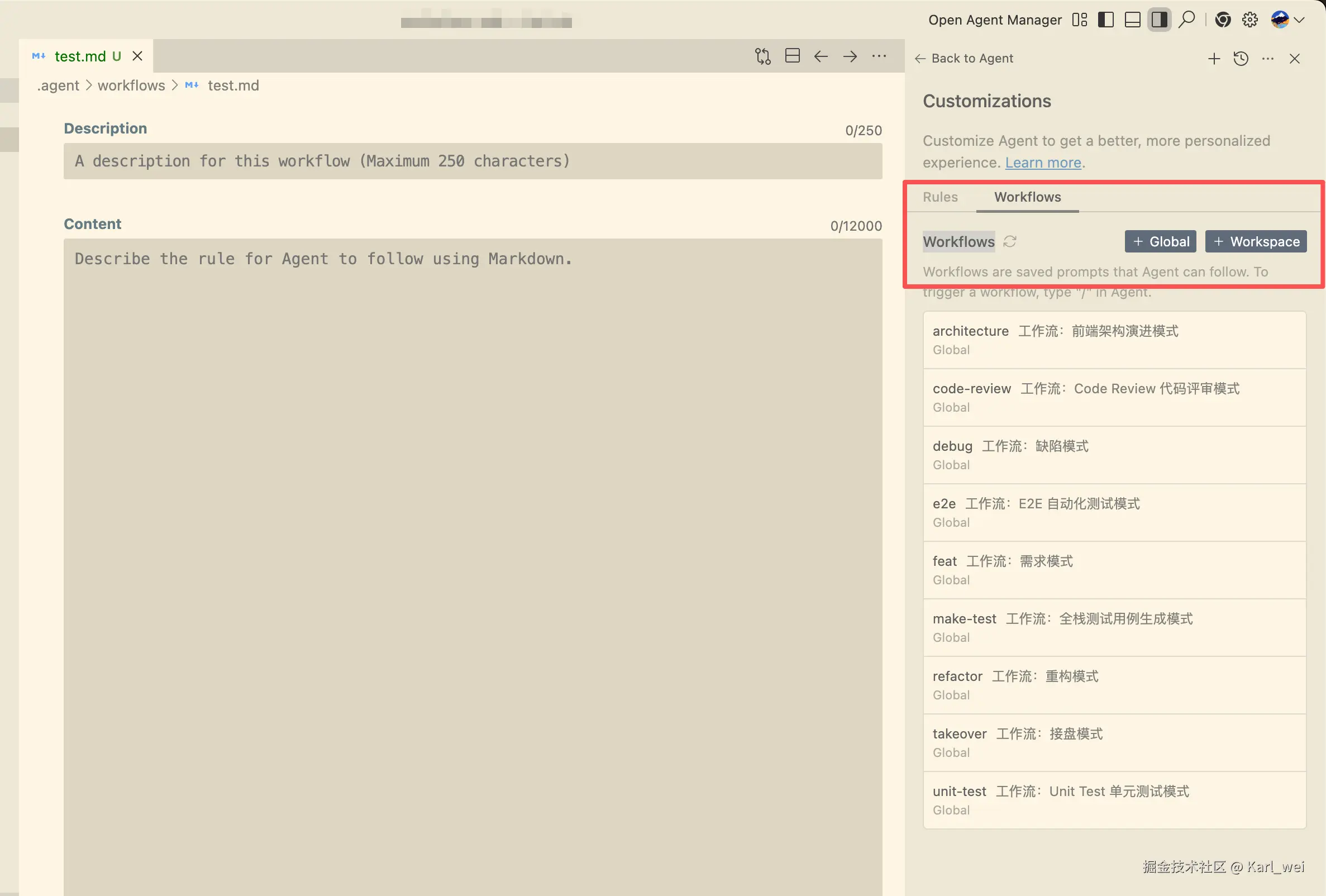

3. 沉淀 Rules 和 Workflows

我们现在已经可以通过开发工具让 AI 干活了,但如何更符合我们的编码习惯和设计思想?那就得给 AI 规范,也就是通过提示词让 AI 更乖的,干更对的活。

比如,Antigravity就有明确的让我们添加规则和工作流的入口,并且会引导我们如何写提示词,然后在提问的时候,引用对应的文件即可。

Rules(规则)和Workflows(工作流),沉淀 沉淀 再 沉淀!!!

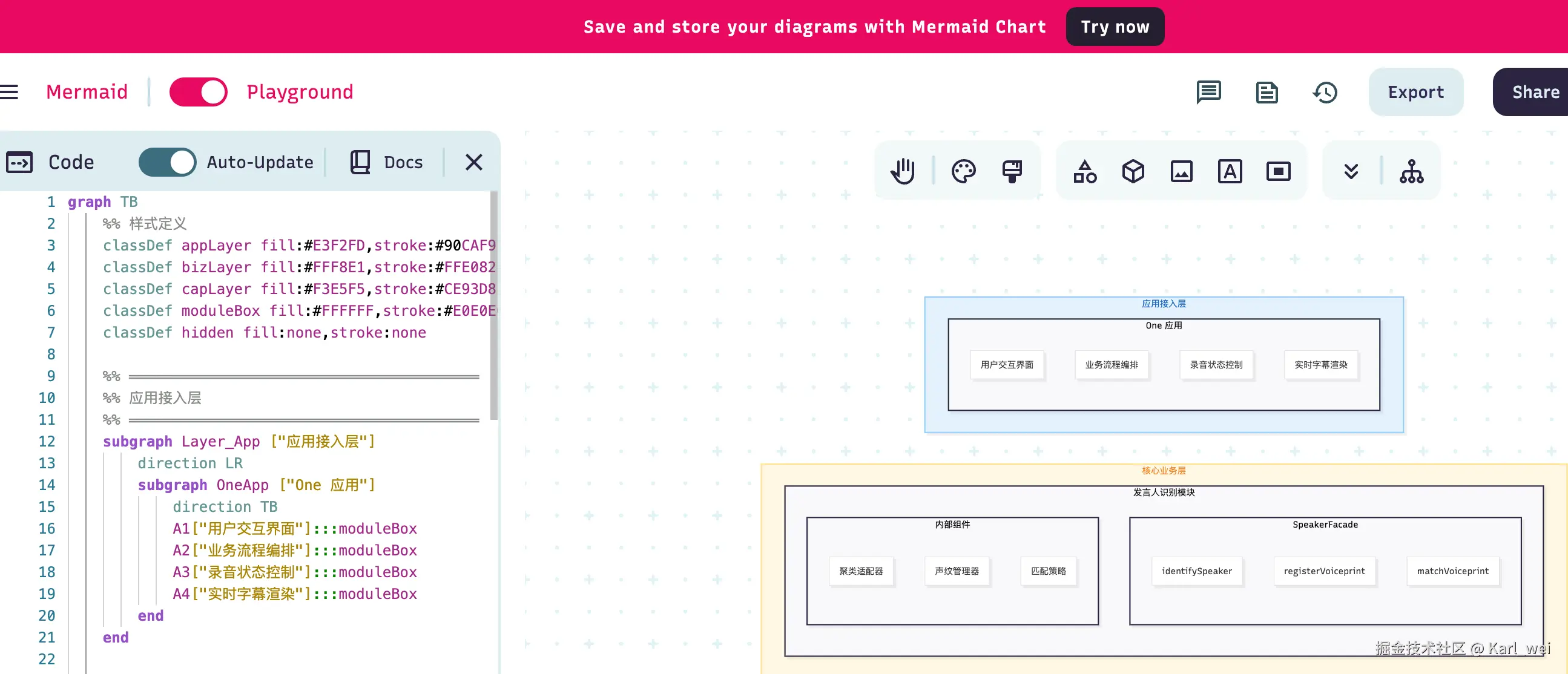

4. !!!文档先行!!!

AI 时代的编码,一定要做好设计,写好文档。

AI 虽然帮你干活,但是任务是你来安排的,你给出的任务要足够精准。

同时,你的编码思维才是代码能写好的核心,你必须把你的思维和想法,落成文档给到 AI 大模型。

- markdown 格式:注意 AI 需要理解 md 文档

- 图文并茂:在编写文档的时候,时常需要画图,此时可以使用 md 语法来画图。这里我推荐mermaidchart,可以基于 md 语法进行可视化编辑。

写在最后

当你有正常可以使用模型的账号后,其实这个账号不仅仅是在 IDE 可以使用,比如 Antigravity 的账号,跟 Gemini 是一致的,你也可以在大模型的官网登录进行图片、视频生成。

在了解了大模型、MCP、工作流、AI 编程工具后,相信你对 AI 的应用又有了新的理解。我们一定要积极去尝试,国内国外的 AI 工具能用的多用,尽情的去拥抱 AI!

AI 是生产力,毋庸置疑!

来源:juejin.cn/post/7585022810181222463

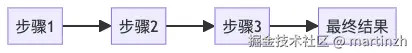

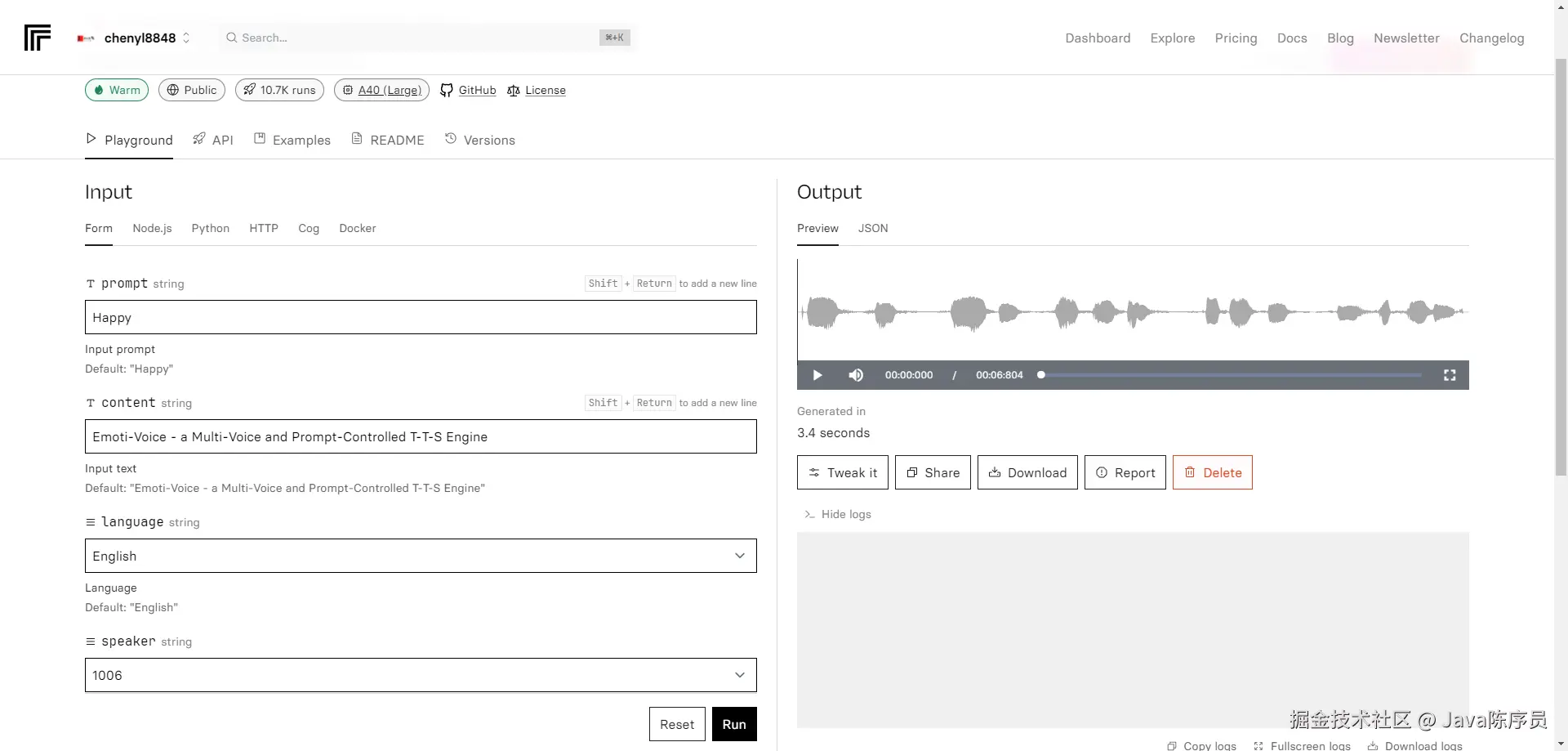

语音 AI Agent 延迟优化实战:我是怎么把响应时间从 2 秒干到 500ms 以内的

做语音 Agent 的人都知道,用户能忍受的等待极限大概是 1.5 秒。超过这个阈值,对话感就没了,用户会觉得是在"跟机器对话"而不是"在聊天"。这篇文章分享我在实际项目中,把端到端延迟从 2 秒出头压到 500ms 以内的完整过程。

先搞清楚延迟花在哪

在动手优化之前,第一步是搞清楚时间都花在了哪里。一个典型的语音 Agent 调用链是这样的:

用户说话 → VAD检测 → ASR转写 → LLM推理 → TTS合成 → 播放回复

我在生产环境里埋了全链路 tracing,把每个环节的耗时拉出来一看:

| 环节 | 优化前耗时 | 占比 |

|---|---|---|

| VAD 端点检测 | ~300ms | 15% |

| ASR 语音转文字 | ~400ms | 20% |

| LLM 意图理解+生成 | ~800ms | 40% |

| TTS 文字转语音 | ~350ms | 17% |

| 网络传输+其他 | ~150ms | 8% |

| 总计 | ~2000ms | 100% |

最大的瓶颈很明显——LLM 推理占了 40%。但别急着只优化这一个,实际上每个环节都有压缩空间,而且真正的大招是让这些环节不再串行等待。

第一刀:流式架构改造(-600ms)

最直觉的优化:不要等一个环节完全结束才启动下一个。

传统串行架构

# ❌ 串行模式:每步都要等上一步完全结束

async def handle_utterance(audio_stream):

# 等用户说完

complete_audio = await vad.wait_for_endpoint(audio_stream)

# 等转写完成

transcript = await asr.transcribe(complete_audio)

# 等 LLM 生成完整回复

response = await llm.generate(transcript)

# 等 TTS 合成完整音频

audio = await tts.synthesize(response)

# 播放

await play(audio)

流式管道架构

# ✅ 流式模式:各环节并行处理

async def handle_utterance_streaming(audio_stream):

transcript_stream = asr.stream_transcribe(audio_stream)

async for partial_transcript in transcript_stream:

if vad.is_endpoint(partial_transcript):

# ASR 的 partial result 直接喂给 LLM

llm_stream = llm.stream_generate(partial_transcript.final_text)

# LLM 每生成一个句子片段,立刻送给 TTS

tts_task = asyncio.create_task(

stream_tts_and_play(llm_stream)

)

break

async def stream_tts_and_play(llm_stream):

"""LLM 输出的每个文本块 → 立刻合成 → 立刻播放"""

async for text_chunk in llm_stream:

# 按句子边界切分,不用等完整回复

if is_sentence_boundary(text_chunk):

audio_chunk = await tts.synthesize_chunk(text_chunk)

await player.enqueue(audio_chunk)

核心思想:ASR 的流式结果直接喂 LLM,LLM 的流式输出直接喂 TTS。不再有任何环节需要等"完整结果"。

这一刀下去,端到端延迟从 ~2000ms 直接降到 ~1400ms。

第二刀:VAD 优化(-200ms)

VAD(Voice Activity Detection)负责判断"用户说完了"。默认的 VAD 通常需要 300-500ms 的静音才会触发 endpoint,这段时间完全是白等。

class SmartVAD:

"""基于上下文的智能 VAD"""

def __init__(self):

self.silence_threshold = 300 # 默认 300ms

self.context_aware = True

def get_dynamic_threshold(self, context: ConversationContext) -> int:

"""根据对话上下文动态调整静音阈值"""

# 如果是简短确认类对话("好的"、"收到"),缩短等待

if context.expected_response_type == "confirmation":

return 150

# 如果是复杂问题,用户可能在思考,适当延长

if context.turn_count > 5 and context.avg_utterance_length > 20:

return 400

# 利用 ASR 的语义信息辅助判断

partial = context.current_partial_transcript

if partial and self._is_complete_sentence(partial):

return 100 # 语义完整就不用等太久

return self.silence_threshold

def _is_complete_sentence(self, text: str) -> bool:

"""简单的句子完整性判断"""

# 以问号、句号结尾,或者是常见的完整短语

endings = ['吗', '呢', '吧', '了', '的', '好', '行', '可以']

return any(text.strip().endswith(e) for e in endings)

从固定 300ms 静音阈值改成动态判断后,平均 VAD 延迟从 300ms 降到 ~100ms。

第三刀:LLM 推理加速(-400ms)

LLM 是最大的瓶颈,优化空间也最大。几个关键手段:

3.1 Prompt 缓存

如果你用的是 Claude API,系统级 prompt(角色设定、知识库、历史上下文等)在连续对话中几乎不变。开启 Prompt Caching 后,这部分 Token 的处理时间接近于零。

# 系统 prompt 打上 cache_control

messages = [

{

"role": "system",

"content": [

{

"type": "text",

"text": SYSTEM_PROMPT + KNOWLEDGE_BASE, # 通常占 80% tokens

"cache_control": {"type": "ephemeral"}

}

]

},

{"role": "user", "content": user_message}

]

实测效果:首轮 ~800ms,后续轮次 ~350ms。反复出现的 prompt 内容只需处理一次。

3.2 选对模型

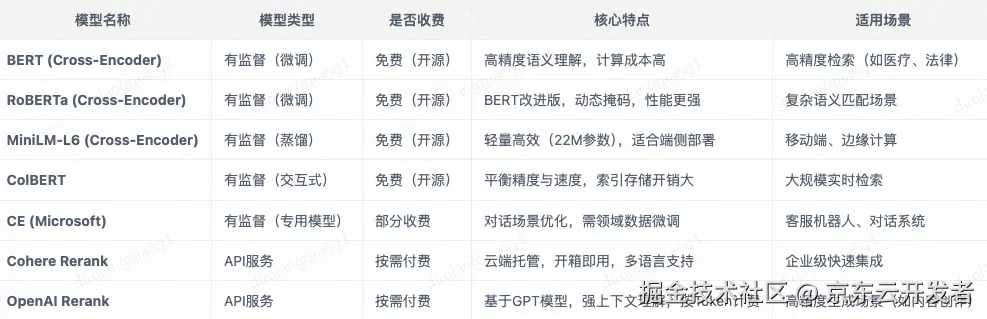

不是所有场景都需要最强模型。语音 Agent 的意图识别和知识库问答,用 Haiku 级别的小模型完全够用,速度快 5 倍以上:

| 模型 | 首 Token 延迟 | 适用场景 |

|---|---|---|

| Opus 4.6 | ~500ms | 复杂推理、跨文档分析 |

| Sonnet 4.5 | ~250ms | 通用对话、中等复杂度 |

| Haiku 4.5 | ~80ms | 意图分类、简单问答、slot filling |

实际项目中,我用路由 + 级联的方式:先用 Haiku 做意图分类(<100ms),简单意图直接用 Haiku 回答,复杂问题再升级到 Sonnet。

class ModelRouter:

async def route(self, transcript: str, context: dict) -> str:

# 第一步:Haiku 快速分类意图(< 100ms)

intent = await self.haiku.classify(transcript)

if intent.type in ("greeting", "confirmation", "simple_qa"):

# 简单意图:Haiku 直接回(< 200ms)

return await self.haiku.generate(transcript, context)

elif intent.type in ("knowledge_query", "multi_turn"):

# 中等复杂度:Sonnet 处理(< 400ms)

return await self.sonnet.generate(transcript, context)

else:

# 复杂推理:Opus 兜底