面试官:CDN是怎么加速网站访问的?

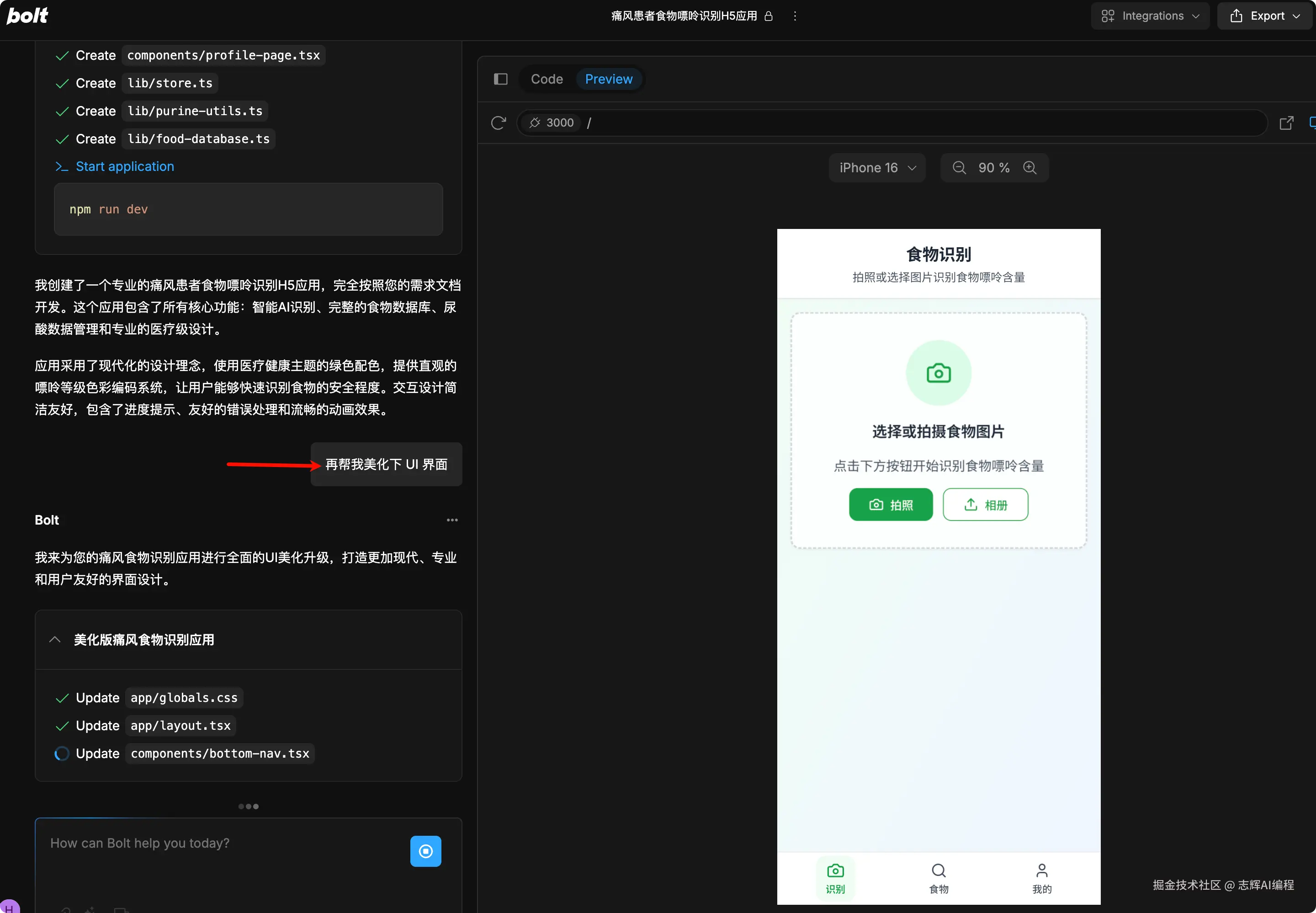

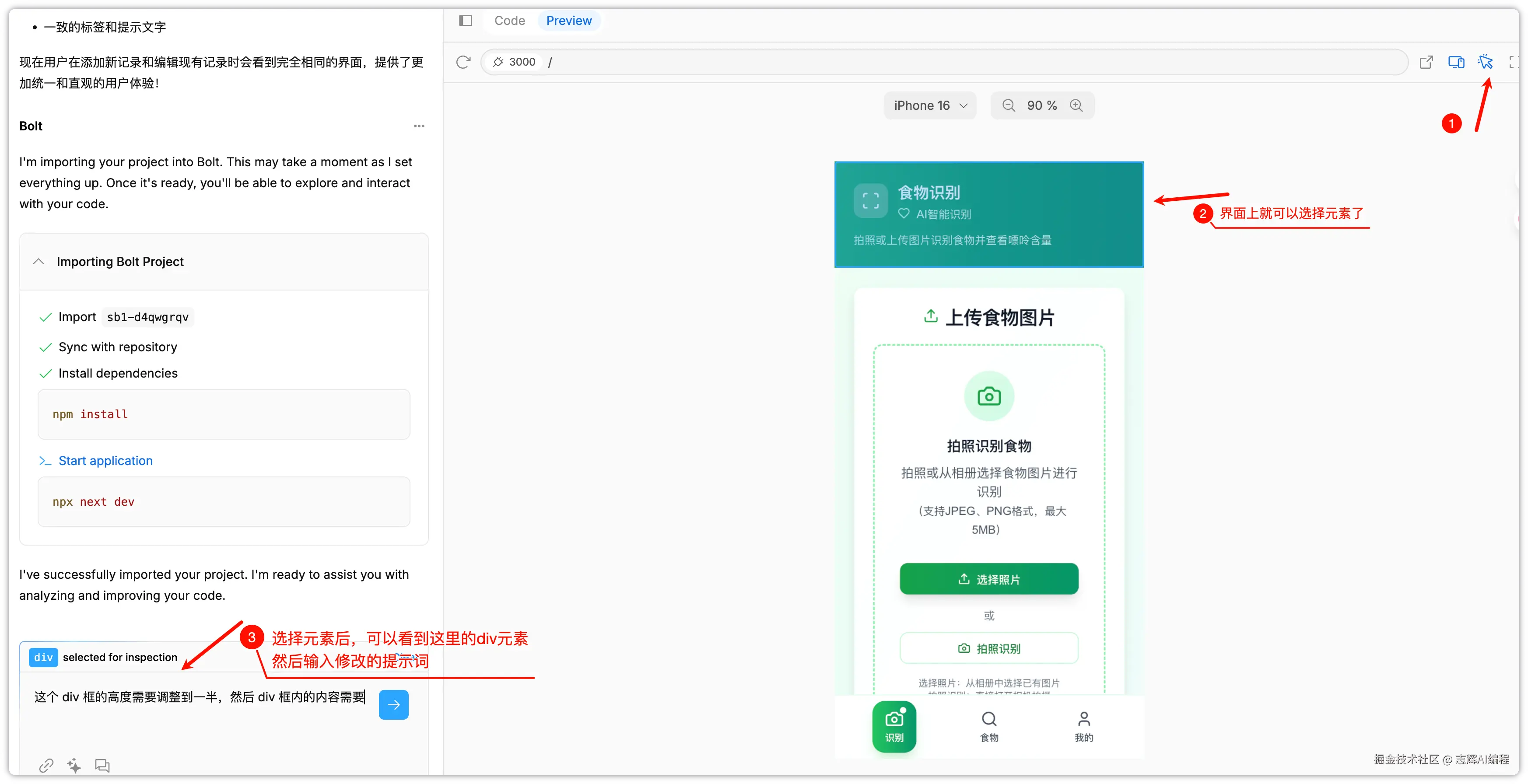

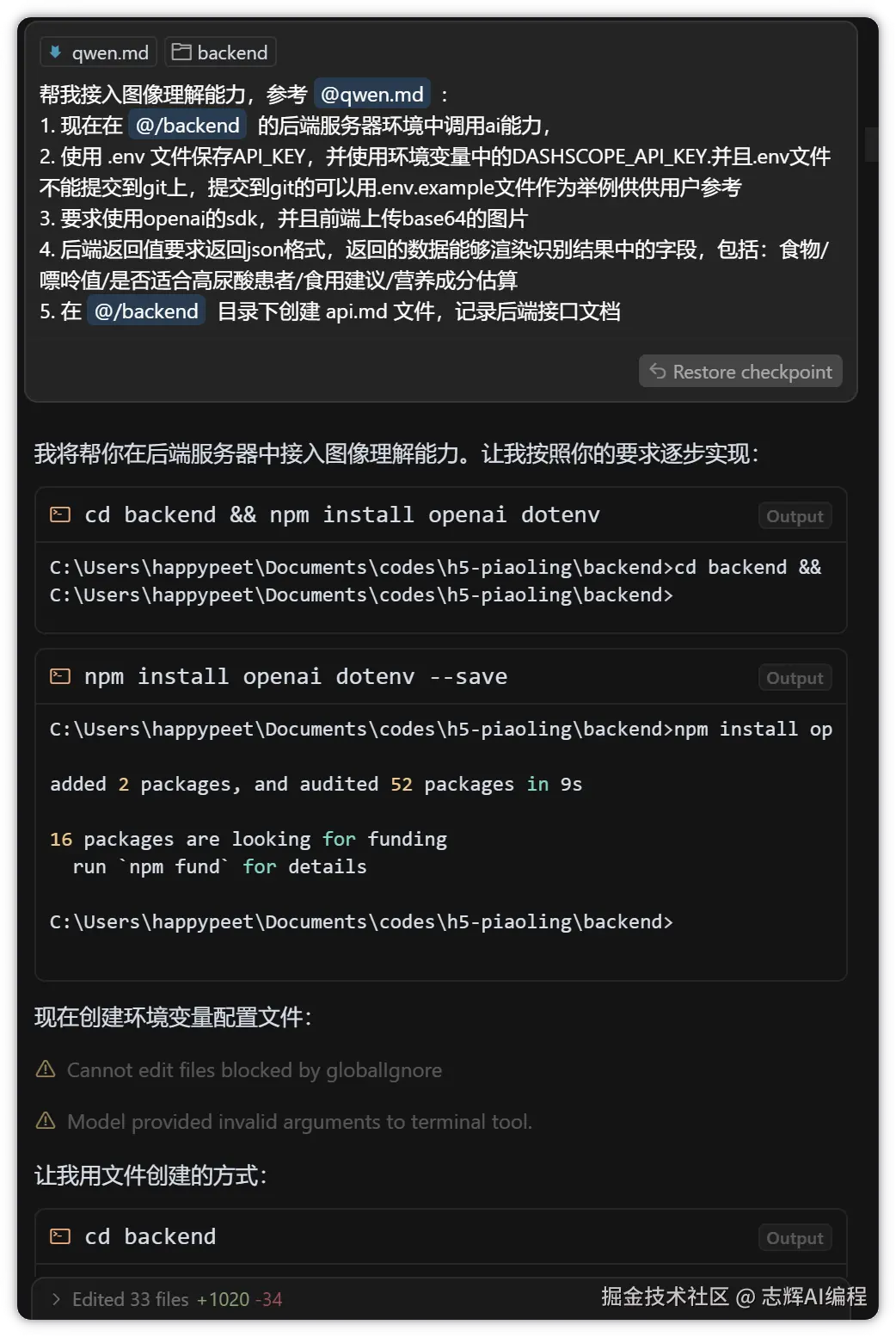

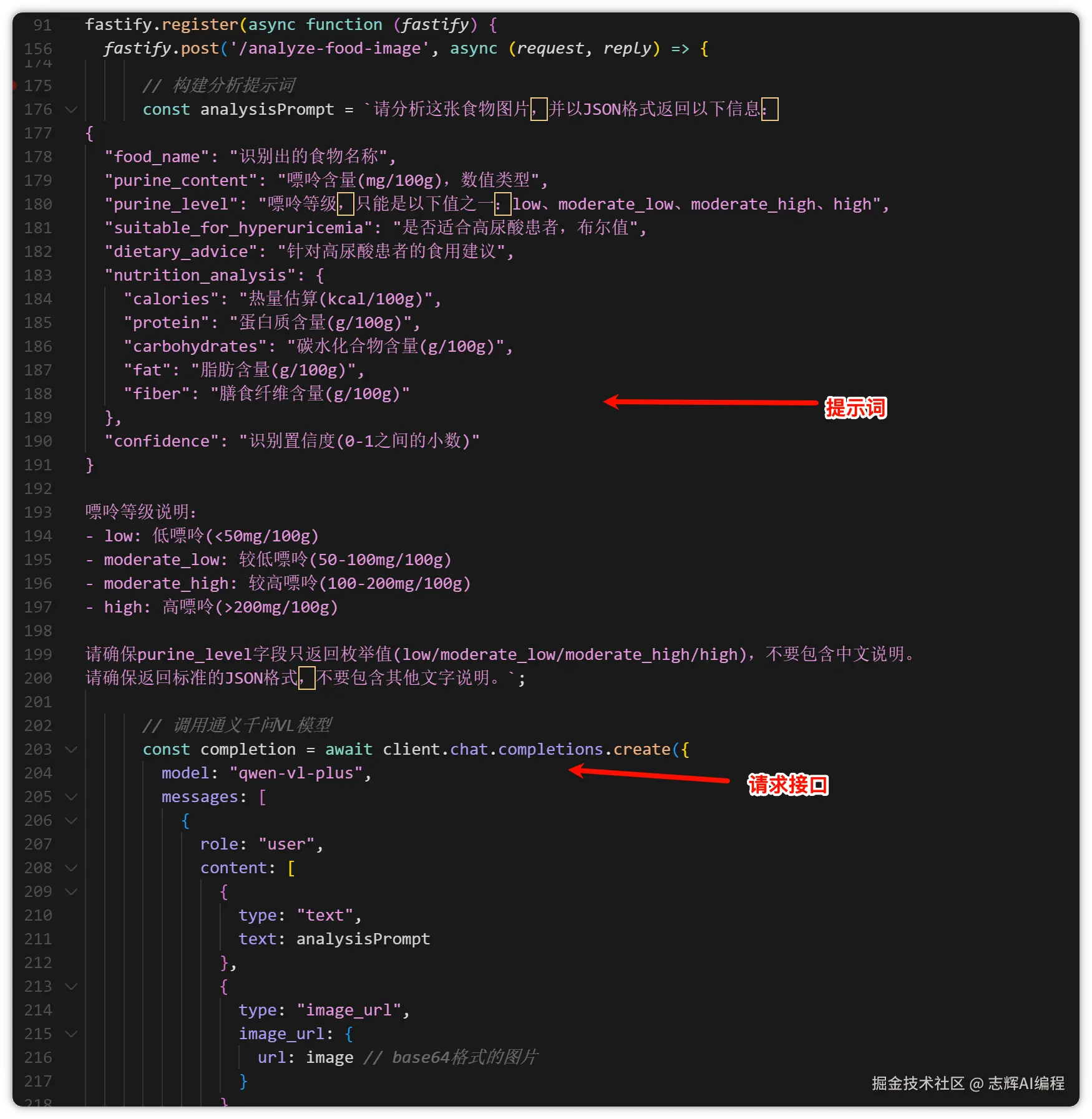

做前端项目的时候,经常听到"静态资源要放CDN"这种说法:

- CDN到底是什么,为什么能加速?

- 用户访问CDN的时候发生了什么?

- 前端项目怎么配置CDN?

先说结论

CDN(Content Delivery Network)的核心原理:把内容缓存到离用户最近的服务器上。

没有CDN时,北京用户访问美国服务器,数据要跨越太平洋。有了CDN,数据从北京的CDN节点返回,快得多。

flowchart LR

subgraph 没有CDN

U1[北京用户] -->|跨越太平洋| S1[美国服务器]

end

subgraph 有CDN

U2[北京用户] -->|就近访问| C2[北京CDN节点]

C2 -.->|首次回源| S2[美国服务器]

end

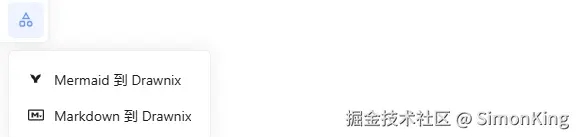

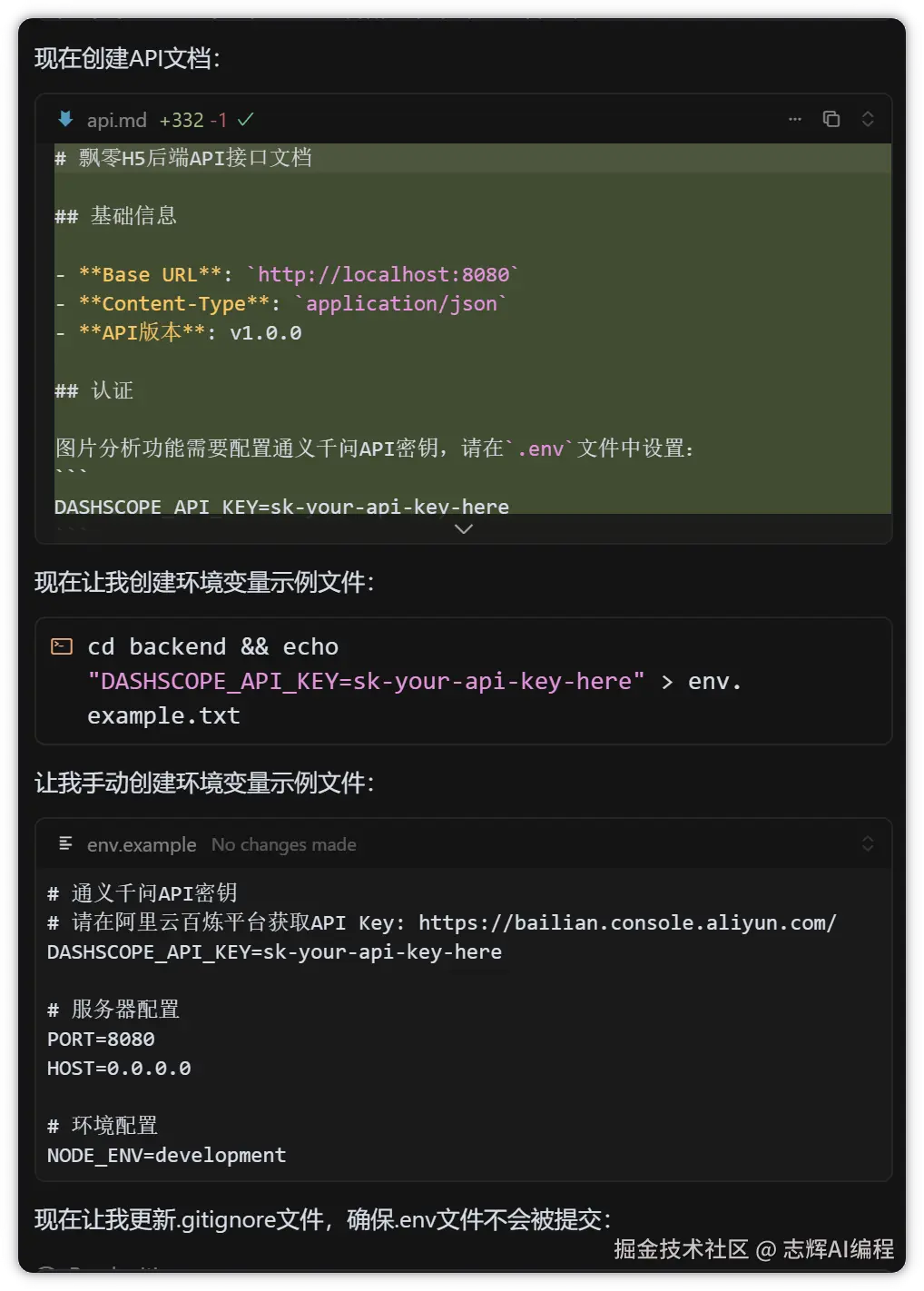

CDN的工作流程

当用户访问一个CDN加速的资源时,会经过这几步:

1. DNS解析

用户访问 cdn.example.com,DNS会返回离用户最近的CDN节点IP。

# 在北京查询

$ dig cdn.example.com

;; ANSWER SECTION:

cdn.example.com. 60 IN A 101.37.27.xxx # 北京节点

# 在上海查询

$ dig cdn.example.com

;; ANSWER SECTION:

cdn.example.com. 60 IN A 47.100.99.xxx # 上海节点

同一个域名,不同地区解析出不同IP,这就是CDN的智能调度。

2. 缓存判断

请求到达CDN节点后,节点检查本地是否有缓存:

- 缓存命中:直接返回,速度最快

- 缓存未命中:向源服务器获取,然后缓存起来

flowchart TD

A[用户请求] --> B[CDN边缘节点]

B --> C{本地有缓存?}

C -->|有| D[直接返回]

C -->|没有| E[回源获取]

E --> F[源服务器]

F --> G[返回内容]

G --> H[缓存到边缘节点]

H --> D

classDef hit fill:#d4edda,stroke:#28a745,color:#155724

classDef miss fill:#fff3cd,stroke:#ffc107,color:#856404

class D hit

class E,F,G,H miss

3. 缓存策略

CDN根据HTTP头决定怎么缓存:

# 典型的静态资源响应头

Cache-Control: public, max-age=31536000

ETag: "abc123"

Last-Modified: Wed, 21 Oct 2024 07:28:00 GMT

max-age=31536000:缓存1年public:允许CDN缓存ETag:文件指纹,用于验证缓存是否过期

为什么CDN能加速

1. 物理距离更近

光在光纤中的传播速度约为 20 万公里/秒。北京到美国往返 2 万公里,光传输就要 100ms。

CDN把内容放到离用户近的地方,这个延迟几乎可以忽略。

2. 分散服务器压力

没有CDN,所有请求都打到源服务器。有了CDN,只有第一次请求(缓存未命中)才需要回源。

假设一张图片被访问 100 万次:

- 没有CDN:源服务器处理 100 万次请求

- 有CDN:源服务器只处理几十次(各节点首次回源)

3. 边缘节点优化

CDN服务商的边缘节点通常有这些优化:

- 自动压缩:Gzip/Brotli压缩

- 协议优化:HTTP/2、HTTP/3

- 连接复用:Keep-Alive连接池

- 智能路由:选择最优网络路径

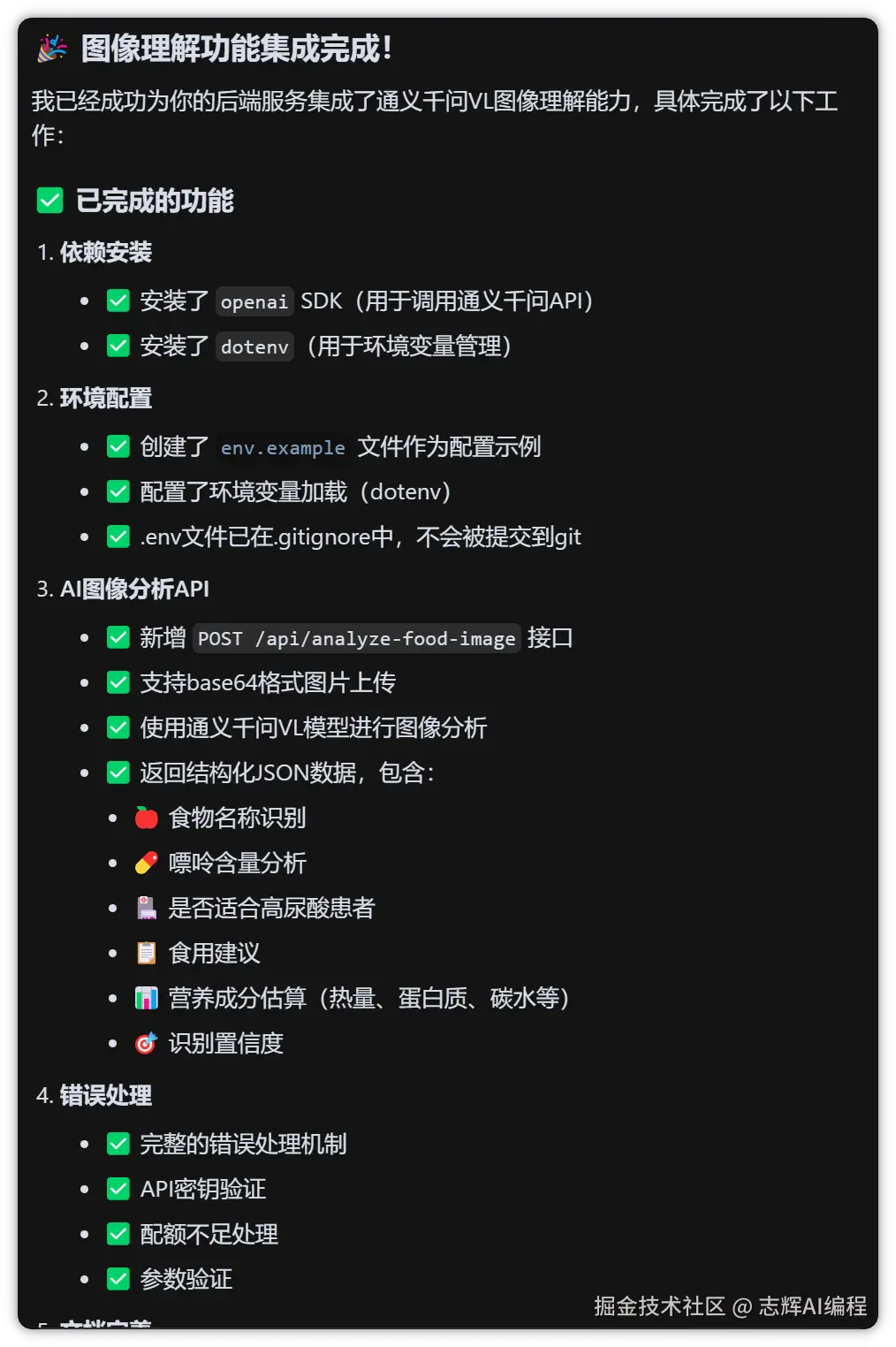

前端项目配置CDN

1. 构建配置

以Vite为例,配置静态资源的CDN地址:

// vite.config.js

export default defineConfig({

base: process.env.NODE_ENV === 'production'

? 'https://cdn.example.com/'

: '/',

build: {

rollupOptions: {

output: {

// 文件名带hash,便于长期缓存

entryFileNames: 'js/[name].[hash].js',

chunkFileNames: 'js/[name].[hash].js',

assetFileNames: 'assets/[name].[hash].[ext]'

}

}

}

})

Webpack配置类似:

// webpack.config.js

module.exports = {

output: {

publicPath: process.env.NODE_ENV === 'production'

? 'https://cdn.example.com/'

: '/',

filename: 'js/[name].[contenthash].js',

}

}

2. 上传到CDN

构建完成后,把dist目录的文件上传到CDN。大多数CDN服务商都提供CLI工具或API:

# 阿里云OSS + CDN

aliyun oss cp -r ./dist oss://your-bucket/

# AWS S3 + CloudFront

aws s3 sync ./dist s3://your-bucket/

# 七牛云

qshell qupload2 --src-dir=./dist --bucket=your-bucket

3. 缓存策略配置

关键是区分两类文件:

带hash的静态资源(JS、CSS、图片):长期缓存

location ~* \.(js|css|png|jpg|jpeg|gif|ico|svg|woff2?)$ {

expires 1y;

add_header Cache-Control "public, immutable";

}

HTML文件:不缓存或短期缓存

location ~* \.html$ {

expires 0;

add_header Cache-Control "no-cache, must-revalidate";

}

为什么这样设计?因为HTML是入口文件,它引用的JS/CSS带有hash。更新代码时:

- 新的JS文件会有新的hash(

app.abc123.js→app.def456.js) - HTML文件引用新的JS文件

- 用户获取新HTML后,会加载新的JS文件

- 旧的JS文件在CDN上继续存在,不影响正在访问的用户

4. DNS配置

把CDN域名配置成CNAME指向CDN服务商:

# 阿里云CDN

cdn.example.com. IN CNAME cdn.example.com.w.kunlunsl.com.

# Cloudflare

cdn.example.com. IN CNAME example.com.cdn.cloudflare.net.

常见问题

跨域问题

CDN域名和主域名不同,字体文件、AJAX请求可能遇到跨域。

解决方案是在CDN配置CORS头:

# CDN服务器配置

add_header Access-Control-Allow-Origin "https://example.com";

add_header Access-Control-Allow-Methods "GET, HEAD, OPTIONS";

或者在源服务器的响应里加上CORS头,CDN会透传。

缓存更新问题

发布新版本后,用户还是看到旧内容?

方案一:文件名带hash(推荐)

前面已经提到,文件名带hash,新版本就是新文件,不存在缓存问题。

方案二:主动刷新缓存

// 调用CDN服务商的刷新API

await cdnClient.refreshObjectCaches({

ObjectPath: 'https://cdn.example.com/app.js\nhttps://cdn.example.com/app.css',

ObjectType: 'File'

});

方案三:URL加版本号

<script src="https://cdn.example.com/app.js?v=1.2.3"></script>

不太推荐,因为有些CDN会忽略查询参数。

HTTPS证书

CDN域名也需要HTTPS证书。大多数CDN服务商提供免费证书或支持上传自有证书。

配置方式:

- 在CDN控制台申请免费证书(通常是DV证书)

- 或上传自己的证书(用Let's Encrypt申请)

# 用certbot申请泛域名证书

certbot certonly --manual --preferred-challenges dns \

-d "*.example.com" -d "example.com"

回源优化

如果源服务器压力大,可以启用"回源加速"或"中间源":

用户 → 边缘节点 → 中间源 → 源服务器

中间源作为二级缓存,减少对源服务器的请求。多数CDN服务商默认开启这个功能。

CDN选型

| CDN服务商 | 优势 | 适用场景 |

|---|---|---|

| 阿里云CDN | 国内节点多,生态完整 | 国内业务为主 |

| 腾讯云CDN | 游戏加速好,直播支持强 | 游戏、直播 |

| Cloudflare | 全球节点,有免费套餐 | 出海业务、个人项目 |

| AWS CloudFront | 与AWS生态集成 | 已用AWS的项目 |

| Vercel/Netlify | 前端项目一站式部署 | JAMStack项目 |

个人项目推荐Cloudflare,免费套餐够用,全球节点覆盖好。

企业项目根据用户分布选择。面向国内用户,阿里云/腾讯云更合适;面向全球用户,Cloudflare或CloudFront。

验证CDN效果

浏览器开发者工具

打开Network面板,关注这几个指标:

- TTFB(Time To First Byte):首字节时间,越小越好

- 响应头中的缓存信息:

X-Cache: HIT表示命中CDN缓存

命令行测试

# 查看响应头

curl -I https://cdn.example.com/app.js

# 输出示例

HTTP/2 200

cache-control: public, max-age=31536000

x-cache: HIT from CN-Beijing

在线工具

- Pingdom - 全球多点测速

- GTmetrix - 性能分析

- WebPageTest - 详细的加载瀑布图

小结

CDN加速的核心原理:

- 就近访问:DNS智能解析,把用户引导到最近的节点

- 缓存机制:边缘节点缓存内容,减少回源

- 协议优化:HTTP/2、压缩、连接复用

前端配置CDN的关键:

- 构建时配置publicPath:指向CDN域名

- 文件名带hash:便于长期缓存

- HTML不缓存:确保用户能获取到最新入口

- 处理跨域:配置CORS头

如果你觉得这篇文章有帮助,欢迎关注我的 GitHub,下面是我的一些开源项目:

Claude Code Skills(按需加载,意图自动识别,不浪费 token,介绍文章):

- code-review-skill - 代码审查技能,覆盖 React 19、Vue 3、TypeScript、Rust 等约 9000 行规则(详细介绍)

- 5-whys-skill - 5 Whys 根因分析,说"找根因"自动激活

- first-principles-skill - 第一性原理思考,适合架构设计和技术选型

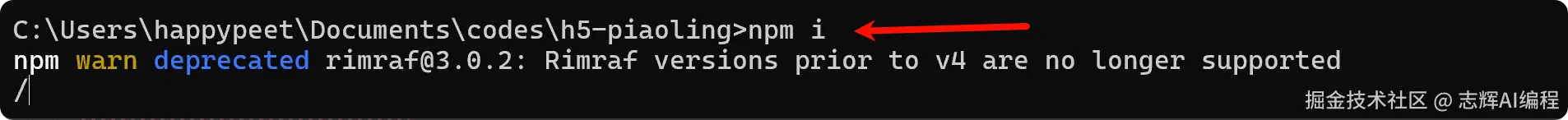

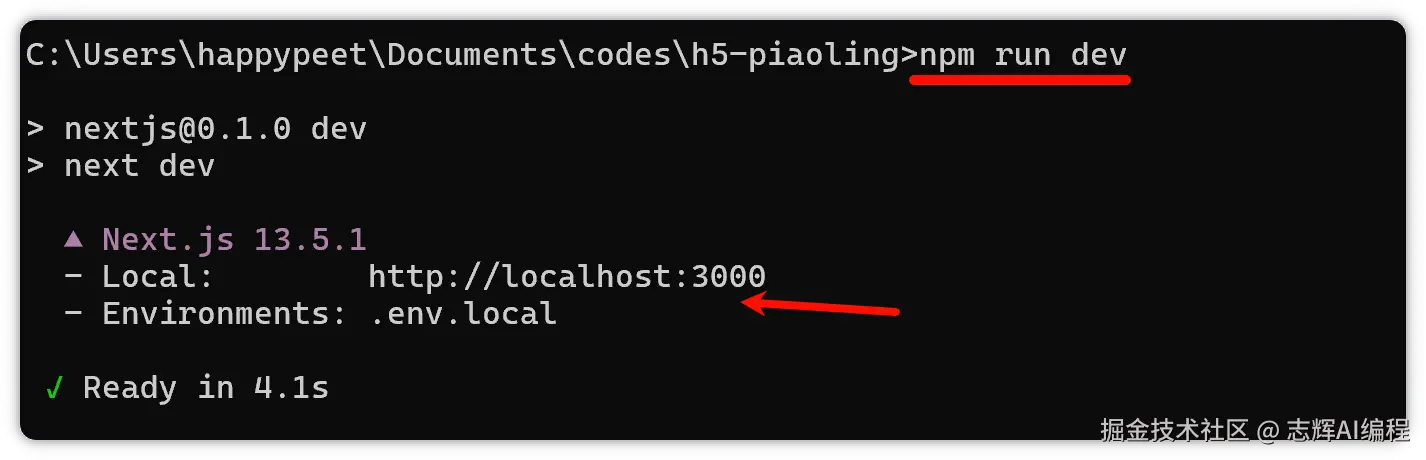

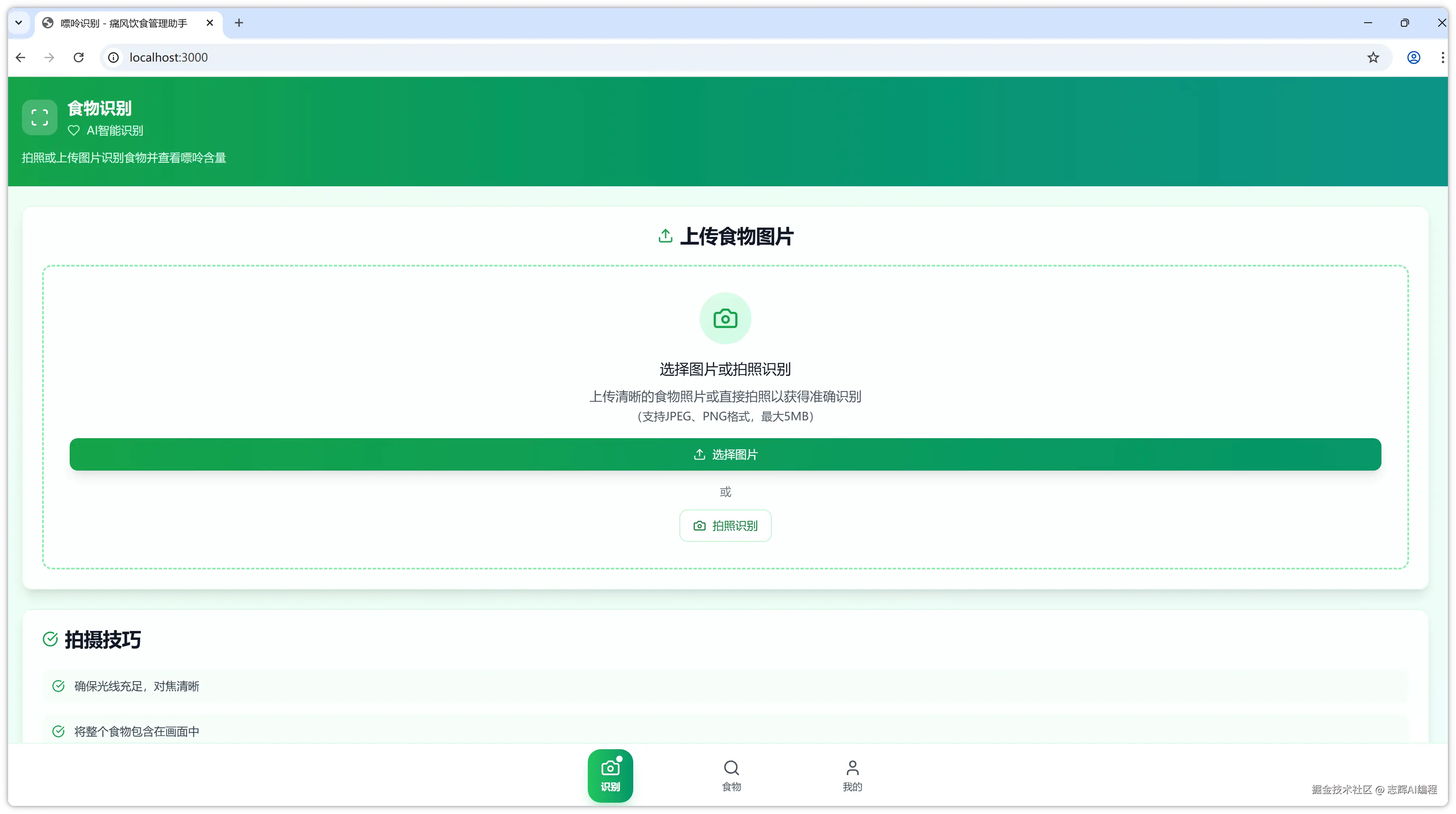

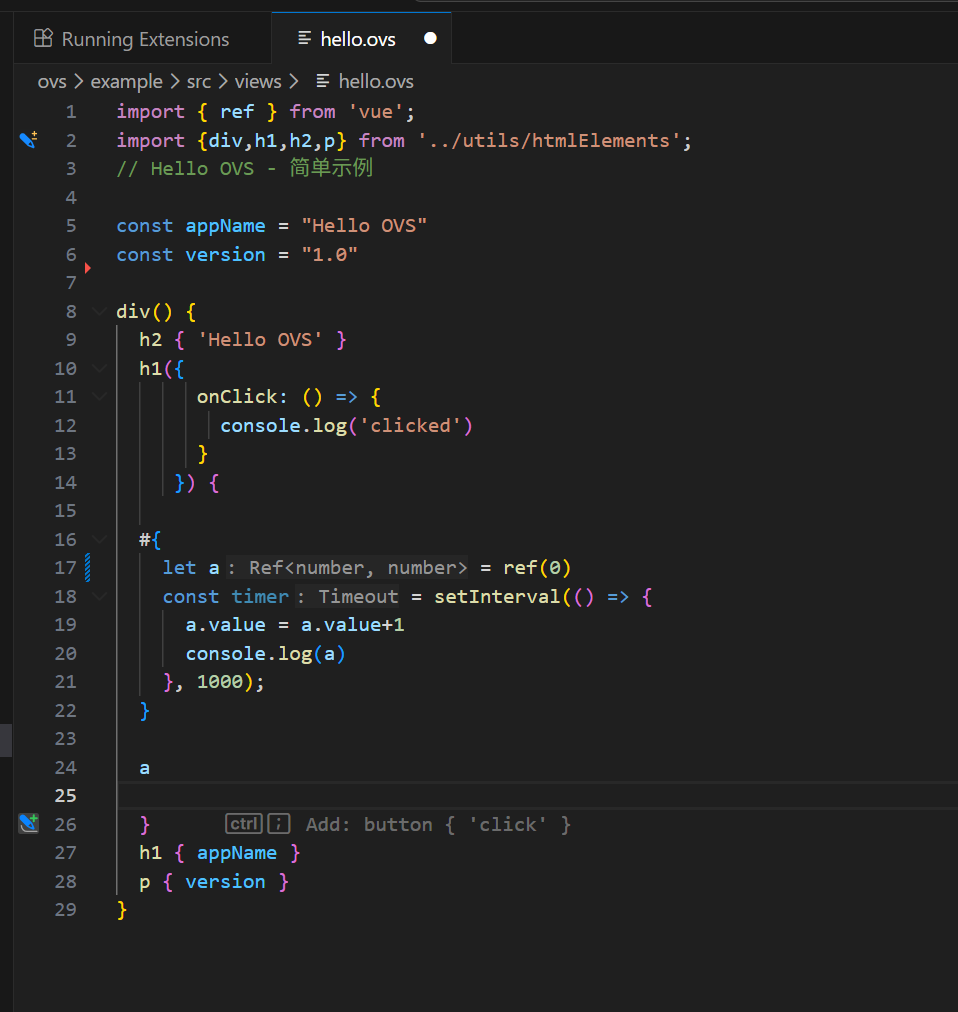

全栈项目(适合学习现代技术栈):

- prompt-vault - Prompt 管理器,用的都是最新的技术栈,适合用来学习了解最新的前端全栈开发范式:Next.js 15 + React 19 + tRPC 11 + Supabase 全栈示例,clone 下来配个免费 Supabase 就能跑

- chat_edit - 双模式 AI 应用(聊天+富文本编辑),Vue 3.5 + TypeScript + Vite 5 + Quill 2.0 + IndexedDB

来源:juejin.cn/post/7582438310103613486

为什么大部分程序员成不了架构师?

很多程序员初学编程那会,几乎都有一个成为架构师的梦想。

❝

毕竟不想当架构师的程序员不是一个好程序员。

这里有几个架构师需要具备的能力模型:

❝

技术深度和广度:

- 具备深厚的技术功底,同时对相关领域非常熟悉与了解。

经验积累:

- 具备在某一领域,有非常丰富的行业经验。

- 具体涉及到系统设计、性能优化、风险管理等方面。

业务理解和沟通能力:

- 需要理解业务需求,将业务目标转化为系统设计。

- 需要与不同角色进行高效的沟通,包括与非技术人员的沟通。

领导和管理能力:

- 在一些情况下,架构师可能需要领导团队、制定技术方向。

学习和适应能力:

- 需要不断学习新的技术和趋势,并将其应用到实际项目中。

其实有些程序员可能更喜欢专注于编码本身。

❝

对于涉及更广泛系统设计和管理方面的工作不感兴趣。

他们可能更倾向于深入技术领域而非走向管理和架构方向。

不过能成为架构师还有几个点很关键:

❝

想成为架构师至少要有一个好平台,还要有毅力钻研技术并付诸实践。

- 而且要经历各种各样的场景。

最好还要有一个好团队一起努力,毕竟一个人的精力是有限的。

不过并非每个程序员都适合成为架构师,不同人有不同的兴趣和职业目标。

有啥其他看法,欢迎在评论区留言讨论。

❝

想看技术文章的,可以去我的个人网站:hardyfish.top/

- 目前网站的内容足够应付基础面试(

P6)了!

每日一题

题目描述

❝

给你一个 非空 整数数组

nums,除了某个元素只出现一次以外,其余每个元素均出现两次。

找出那个只出现了一次的元素。

示例 1 :

ini体验AI代码助手代码解读复制代码输入:nums = [2,2,1]

输出:1

示例 2 :

ini体验AI代码助手代码解读复制代码输入:nums = [4,1,2,1,2]

输出:4

示例 3 :

ini体验AI代码助手代码解读复制代码输入:nums = [1]

输出:1

解题思路

❝

位运算

数组中的全部元素的异或运算结果即为数组中只出现一次的数字。

代码实现

Java代码:

Java体验AI代码助手代码解读复制代码class Solution {

public int singleNumber(int[] nums) {

int single = 0;

for (int num : nums) {

single ^= num;

}

return single;

}

}

Python代码:

Python体验AI代码助手代码解读复制代码class Solution:

def singleNumber(self, nums: List[int]) -> int:

return reduce(lambda x, y: x ^ y, nums)

Go代码:

Go体验AI代码助手代码解读复制代码func singleNumber(nums []int) int {

single := 0

for _, num := range nums {

single ^= num

}

return single

}

复杂度分析

❝

时间复杂度:

O(n),其中n是数组长度。

- 只需要对数组遍历一次。

空间复杂度:

O(1)。

链接:https://juejin.cn/post/7459671967306940431

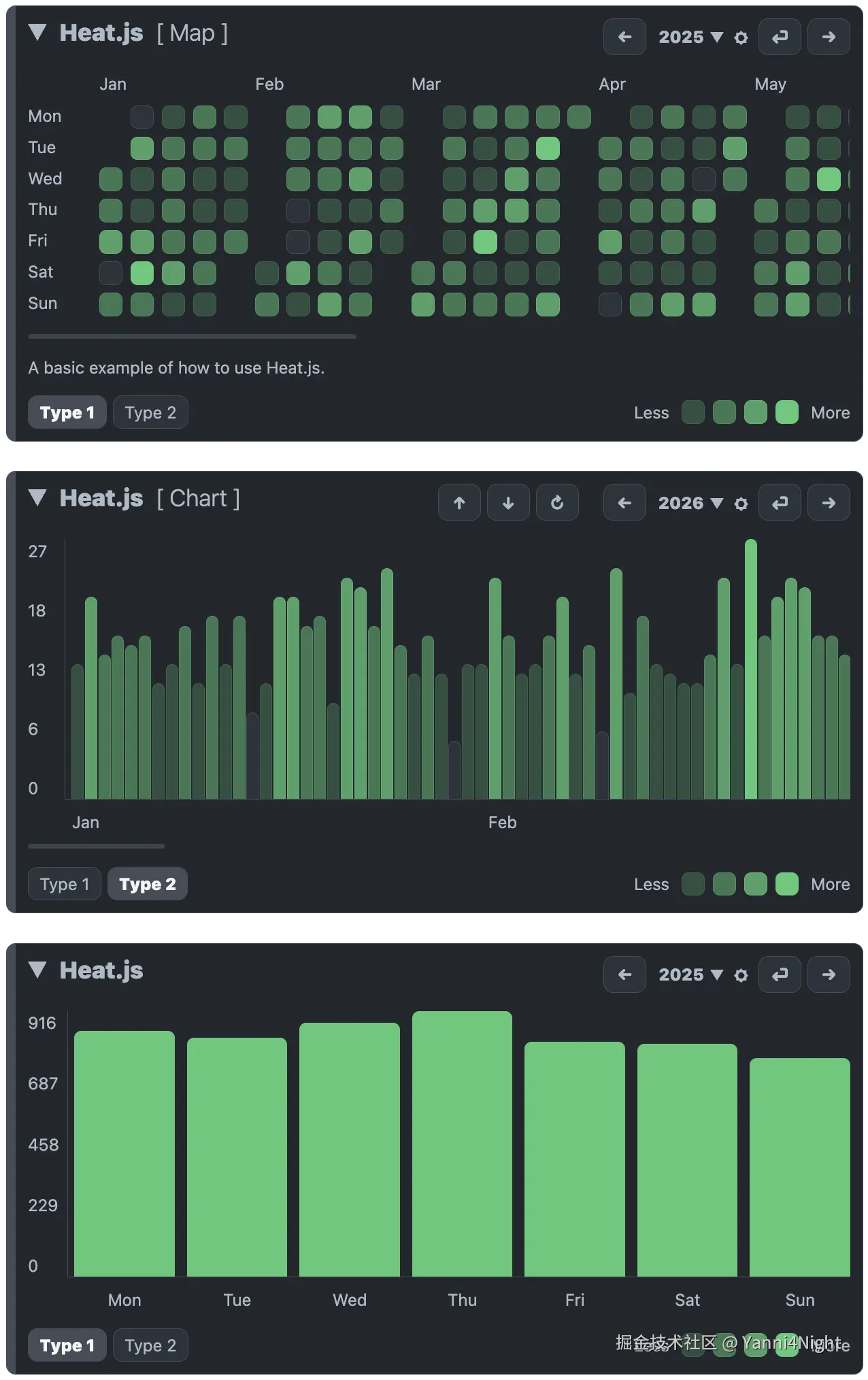

数据可视化神器Heat.js:让你的数据热起来

😱 我发现了一个「零依赖」的数据可视化宝藏!

Hey,前端小伙伴们!今天必须给你们安利一个「让数据说话」的神器——Heat.js!这可不是一个普通的JavaScript库,而是一个能让你的数据「热」起来的魔法工具!

想象一下,当你有一堆枯燥的日期数据,想要以直观、炫酷的方式展示出来时,Heat.js就像一个魔法师,「唰」的一下就能把它们变成色彩斑斓的热图、清晰明了的图表,甚至还有详细的统计分析!

🤩 这个库到底有什么「超能力」?

1. 「零依赖」轻量级选手,绝不拖你后腿 🦵

在这个「依赖地狱」的时代,Heat.js简直就是一股清流!它零依赖,体积小得惊人,加载速度快得飞起!再也不用担心引入一个库就拖慢整个页面加载速度了~

2. 「四种视图」任你选,总有一款适合你 🔄

Heat.js提供了四种不同的视图模式:

- Map视图:就像GitHub贡献图一样炫酷,用颜色深浅展示日期活跃度

- Chart视图:把数据变成专业的图表,让趋势一目了然

- Days视图:专注于展示每一天的详细数据

- Statistics视图:直接给你算出各种统计数据,懒人福音!

想换个姿势看数据?只需轻轻一点,瞬间切换~

3. 「51种语言」支持,真正的「世界公民」🌍

担心你的国际用户看不懂?不存在的!Heat.js支持51种语言,从中文、英文到阿拉伯语、冰岛语,应有尽有!你的应用可以轻松走向全球,再也不用为语言本地化发愁了~

4. 「数据导入导出」无所不能,数据来去自由 📤📥

想导出数据做进一步分析?没问题!Heat.js支持导出为CSV、JSON、XML、TXT、HTML、MD和TSV等多种格式,任你选择!

想导入已有数据快速生成热图?同样简单!支持从JSON、TXT、CSV和TSV导入,甚至还支持拖拽上传,简直不要太方便!

5. 「12种主题」随意切换,颜值与实用并存 💅

担心热图不好看?Heat.js提供了12种精心设计的主题,包括暗黑模式和明亮模式,让你的数据可视化既专业又美观!无论你的网站是什么风格,都能找到匹配的主题~

💡 这个神奇的库可以用来做什么?

1. 「活动追踪」,让你的用户活跃起来 📊

想展示用户的登录活跃度?想用热图展示文章的发布频率?Heat.js帮你轻松实现!就像GitHub的贡献图一样,让你的用户看到自己的「努力成果」,成就感满满!

2. 「数据分析」,让你的决策更明智 🧠

通过Heat.js的Statistics视图,你可以快速获取数据的各种统计信息,比如最活跃的月份、平均活动频率等。这些数据可以帮助你做出更明智的产品决策,优化用户体验!

3. 「趋势展示」,让你的报告更有说服力 📈

想在报告中展示某个指标的变化趋势?Heat.js的Chart视图可以将枯燥的数据变成直观的图表,让你的报告更有说服力,老板看了都说好!

🛠️ 如何用最简单的方式用上这个神器?

第一步:「把宝贝抱回家」📦

npm install jheat.js

或者直接使用CDN:

<link rel="stylesheet" href="https://cdn.jsdelivr.net/gh/williamtroup/Heat.js@4.5.1/dist/heat.js.min.css">

<script src="https://cdn.jsdelivr.net/gh/williamtroup/Heat.js@4.5.1/dist/heat.min.js"></script>

第二步:「给它找个家」🏠

<div id="heat-map" data-heat-js="{ 'views': { 'map': { 'showDayNames': true } } }">

<!-- 这里将显示你的热图 -->

</div>

第三步:「喂它数据」🍽️

// 添加日期数据

let newDateObject = new Date();

$heat.addDate("heat-map", newDateObject, "Trend Type 1", true);

// 移除日期数据(如果需要)

// $heat.removeDate("heat-map", newDateObject, "Trend Type 1", true);

三步搞定!就是这么简单!

🎯 为什么Heat.js值得你拥有?

1. 「简单易用」,小白也能轻松上手 👶

Heat.js的API设计非常友好,文档也很详细,即使是JavaScript初学者也能快速上手。几个简单的步骤,就能实现专业级的数据可视化效果!

2. 「高度定制」,满足你的各种需求 ⚙️

无论是颜色、样式,还是功能配置,Heat.js都提供了丰富的选项。你可以根据自己的需求,定制出独一无二的数据可视化效果!

3. 「响应式设计」,在任何设备上都完美展示 📱💻

Heat.js完全支持响应式设计,无论是在手机、平板还是电脑上,都能完美展示。你的数据可视化效果将在任何设备上都一样出色!

4. 「TypeScript支持」,框架党福利 🎉

如果你使用React、Angular等现代前端框架,Heat.js的TypeScript支持会让你用得更爽!类型定义清晰,代码提示完善,开发体验一流!

🚀 最后想说的话...

在这个「数据为王」的时代,如何让数据更直观、更有说服力,是每个开发者都需要面对的挑战。而Heat.js,就是帮助你征服这个挑战的绝佳工具!

它轻量级、零依赖、功能强大、易于使用,无论是个人项目还是企业应用,都能轻松胜任。最重要的是,它让数据可视化不再是一件复杂的事情,而是一种乐趣!

所以,还等什么呢?赶紧去GitHub上给Heat.js点个Star⭐,然后在你的项目中用起来吧!相信我,它一定会给你带来惊喜!

✨ 祝大家的数据可视化之路一帆风顺,让我们一起用Heat.js让数据「热」起来!✨

来源:juejin.cn/post/7578161740467421235

解决网页前端中文字体包过大的几种方案

最近想给我的博客的网页换个字体,在修复了历史遗留的一些bug之后,去google fonts上找了自己喜欢的字体,本地测试和自己的设备发现没问题后,便以为OK了。

但是当我接朋友的设备打开时,发现网页依然是默认字体。这时候我才发现,我的设备能够翻墙,所以能够使用Google CDN服务,但是对于我的其他读者们,在大陆内是访问不了Google的,便也无法渲染字体了。

于是为了解决这个问题,我尝试了各种办法比如格式压缩,子集化(Subset),分包等等,最后考虑到本站的实际情况选用了一种比较邪门的方法,让字体压缩率达到了惊人的98.5%!于是,这篇文章就是对这个过程的总结。也希望这篇文章能够帮助到你。😊

想要自定义网站的字体,最重要的其实就是字体包的获取。大体上可以分为两种办法:在线获取和网站本地部署。

在线获取──利用 CDN 加速服务

CDN(Content Delivery Network) 意为内容配送网络。你可以简单理解为是一种“就近给你东西”的互联网加速服务。

传统不使用 CDN 服务的是这样的: User ←→ Server,如果相聚遥远,效果显然很差。

使用了 CDN 服务是这样的: User ←→ CDN Nodes ←→ Server,CDN 会提前把你的网站静态资源缓存到各个节点,但你需要时可以直接从最近的节点获取。

全球有多家CDN服务提供商,Google Fonts使用的CDN服务速度很快。所以如果在网络畅通的情况下,使用Google Fonts API是最简单省事的!

你可以直接在文件中导入Google fonts API:

@import url('https://fonts.googleapis.com/css2?family=Inter:ital,opsz,wght@0,14..32,100..900;1,14..32,100..900&family=Merriweather:ital,opsz,wght@0,18..144,733;1,18..144,733&family=Noto+Serif+SC:wght@500&display=swap');

这样网站它便会自动向最近的Google CDN节点请求资源。

当然,这些都是建立在网络状态畅通无阻的情况下。大陆用户一般使用不了Google服务,但并不意味着无法使用CDN服务。国内的腾讯云,阿里云同样提供高效的服务,但具体的规则我并不了解,请自行阅读研究。

本地部署

既然用不了在线的,那就只能将字体包文件一并上传到服务器上了。

这种做法不需要依赖外部服务,但缺点是字体包的文件往往很大,从进入网站到彻底加载完成的时间会及其漫长!而且这种问题尤其在中日韩(CJK)字体上体现的十分明显。

以本站为例,我主要采用了三种字体:Merriweather, Inter, Noto Serif SC. 其中每种字体都包含了Bold和Regular两种格式。前面两种都属于西文字体,每种格式原始文件大小都在200kb-300kb,但是到了思源宋体这里,仅仅一种格式的字体包大小就达到了足足14M多。如果全部加载完,恐怕从进入网站到完全渲染成功,需要耽误个2分钟。所以将原始字体包文件上传是极不可取的做法!

为了解决这个问题,我在网上查阅资料,找到了三种做法。

字体格式转换(WOFF2)

WOFF2 (Web Open Font Format 2.0) 是一种专为 Web 设计的字体文件格式,旨在提供更高的压缩率和更快的加载速度,也是是目前在 Web 上部署自定义字体的推荐标准。它本质上是一种将 TTF 或 OTF 字体数据进行高度压缩后的格式,目前已经获得了所有主流浏览器的广泛支持。

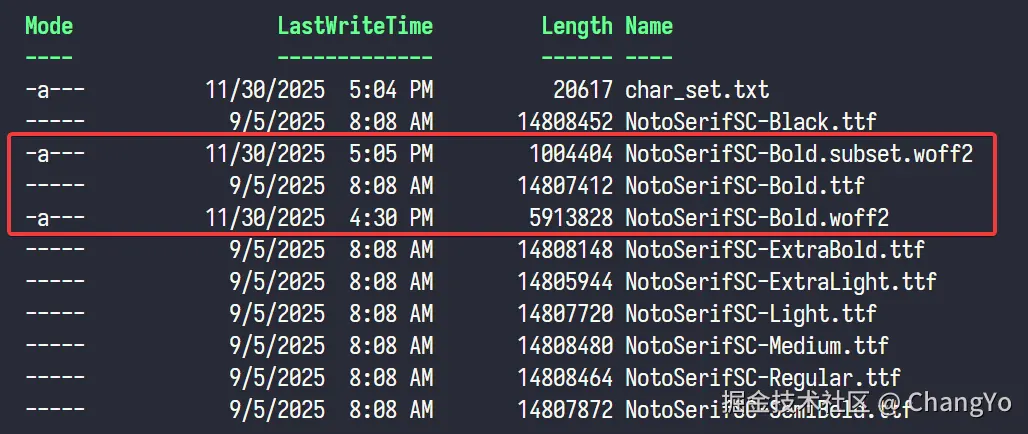

我们可以找一个在线的字体格式转化网站来实现格式的转化。本文我们以NotoSerifSC-Bold.ttf为例,转换后的NotoSerifSC-Bold.woff2文件只有5.8M左右,压缩率达到了60%!

但是,这仍旧是不够的,仅两个中文字体包加起来也已经快12M,还没有算上其他字体。这对于一个网页来说依然是灾难性的。我们必须寻找另一种方法。

子集化处理(Subset)

中国人都知道,虽然中文的字符加起来有2万多个,但是我们平常交流基本只会用到3000多个,范围再大一点,6000多个字符已经可以覆盖99%的使用场景。这意味着:

我们根本不需要保留所有字符,而只需要保留常用的几千个汉字即可。

于是这就给了我们解决问题的思路了。

首先我们可以去寻找中文常用汉字字符表,这里我获取的资源是 All-Chinese-Character-Set。我们将文件下载解压后,可以在里面找到各种各样按照字频统计的官方文件。这里我们就以《通用规范汉字表》(2013年)一级字和二级字为例。我们创建一个文档char_set.txt并将一级字和二级字的内容全部复制进去。这份文档就是我们子集化的对照表。

接着我们需要下载一个字体子集化工具,这里使用的是Python中的fonttools库,它提供了许多工具(比如我们需要的pyftsubset)可以在命令行中执行子集化、字体转化字体操作。

我们安装一下这个库和对应的依赖(在这之前确保你的电脑上安装了Python和pip,后者一般官方安装会自带)

pip install fonttools brotli zopfli

然后找到我们字体包对应的文件夹,将原来的char_set.txt复制到该文件夹内,在该文件下打开终端,然后以NotoSerifSC-Bold.ttf为例,输入以下命令:

pyftsubset NotoSerifSC-Bold.ttf --output-file=NotoSerifSC-Bold.subset.woff2 --flavor=woff2 --text-file=char_set.txt --no-hinting --with-zopfli

过一会就能看到会输出一个NotoSerifSC-Bold.subset.woff2的文件。

我们欣喜的发现这个文件的大小竟然只有980KB。至此,我们已经已经将压缩率达到了93%!到这一步,其实直接部署也并没有十分大问题,不过从加载进去到完全渲染,可能依然需要近十秒左右,我们依然还有优化空间。

我们欣喜的发现这个文件的大小竟然只有980KB。至此,我们已经已经将压缩率达到了93%!到这一步,其实直接部署也并没有十分大问题,不过从加载进去到完全渲染,可能依然需要近十秒左右,我们依然还有优化空间。

分包处理实现动态加载

这个方法是我阅读这篇文章了解到的,但是遗憾的是我并没有在自己的网站上实现,不过失败的尝试也让我去寻找其它的方法,最终找到适用本站的一种极限字体渲染的方法,比这三种的效果还要好。下面我依然简单介绍一下这个方法的原理,想更了解可以通过看到最后通过参考资料去进一步了解。

在2017年,Google Fonts团队提出切片字体,因为他们发现:绝大部分网站只需要加载CJK字体包的小部分内容即可覆盖大部分场景。基于适用频率统计,他们将字符分成多个切片,再按 Unicode 编码对剩余字符进行分类。

怎么理解呢?他其实就是把所有的字符分成许多个小集合,每个集合里面都包含一定数量的字符,在靠前的一些集合中,都是我们常用的汉字,越到后,字形越复杂,使用频率也越低。当网页需要加载字体文件时,它是以切片为单位加载的。这意味,只有当你需要用到某个片区的字符时,这个片区才会被加载。

这种方式的好处时,能够大大加快网站加载速率。我们不用每次都一次性把全部字符加载,而是按需加载。这项技术如今已经被Noto Sans字体全面采用。

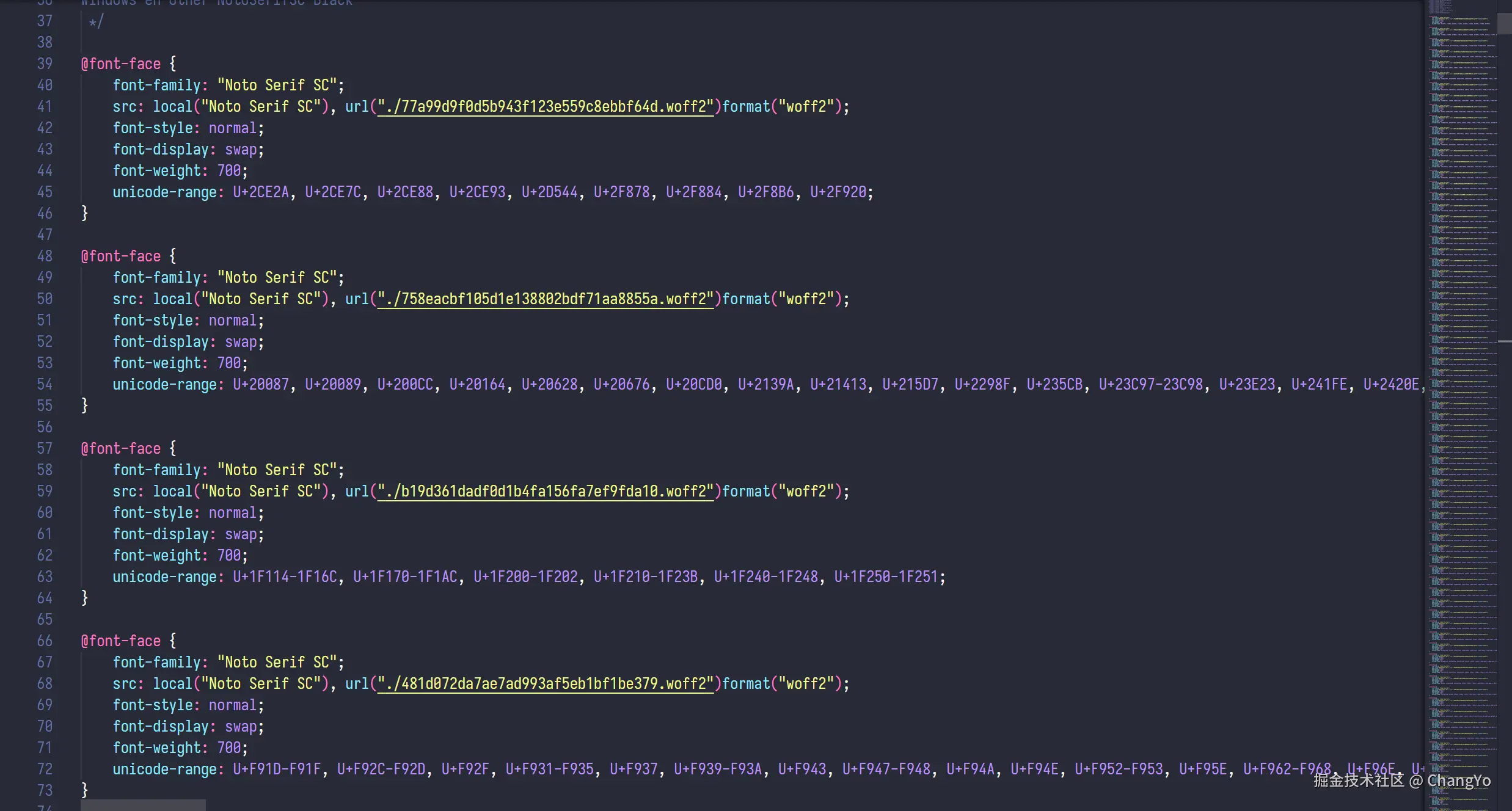

但是我们需要本地部署的话,需要多费一点功夫。这里我们利用中文网字计划的在线分包网站来实现。

我们将需要的字体上传进行分包,可以观察到输出结果是一系列以哈希值命名的woff2文件。分包其实就是做切分,把每个切分后的区域都转化为一份体积极小的woff2文件。

下载压缩包,然后可以将里面的文件夹导入你的项目,并引用文件夹下的

下载压缩包,然后可以将里面的文件夹导入你的项目,并引用文件夹下的result.css即可。理论上,当网站需要加载渲染某个字体时,它会根据css里面的规则去寻找到对应的分包再下载。每个包的体积极小,网站加载的速度应该提升的很明显。

我的实践──将字符压缩到极限

我的方法可以理解为子集化的一种,只不过我的做法更加的极端一些──只保留文章出现的字符!

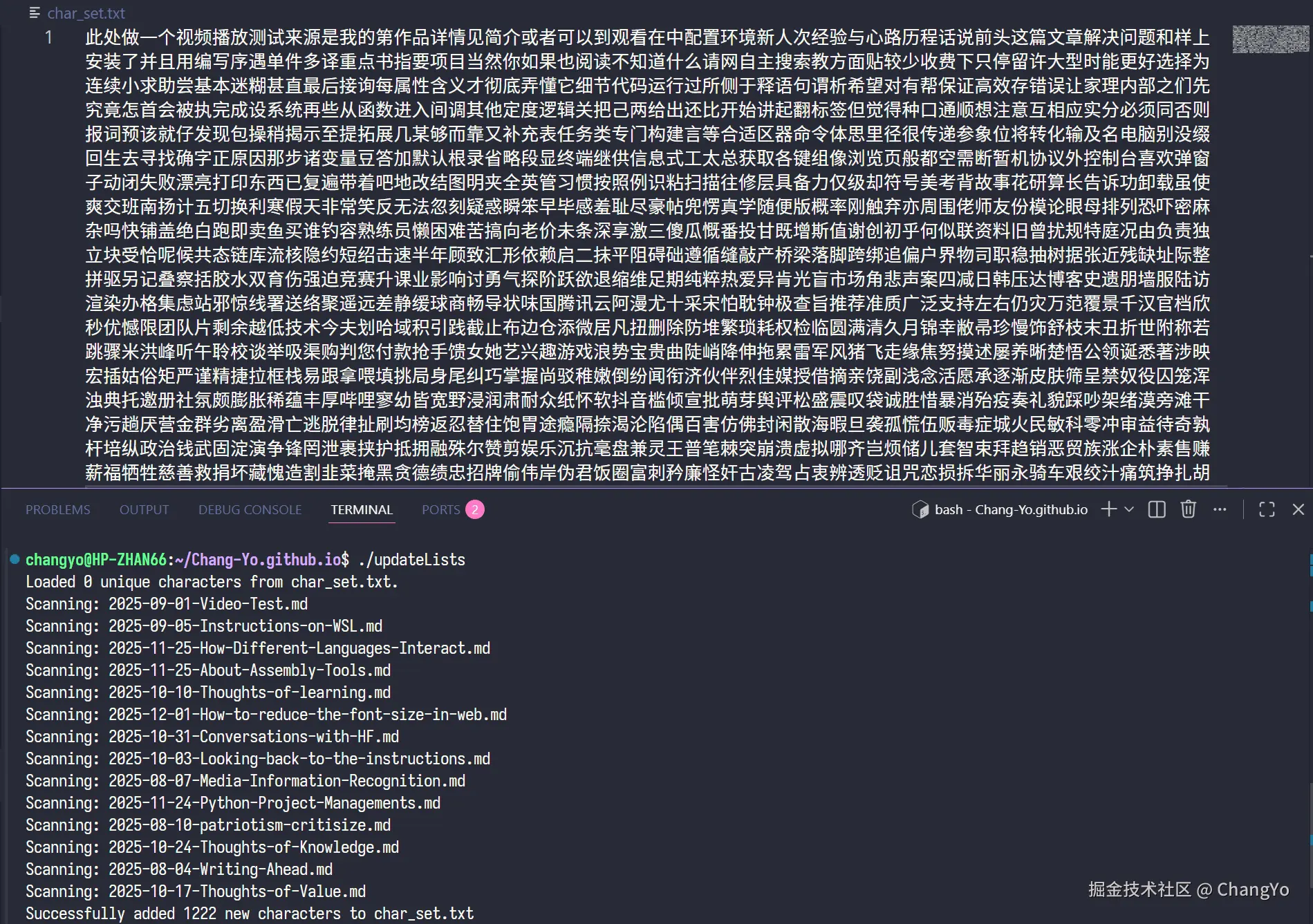

根据统计结果,截止到这篇post发布,我的文章总共出现的所有字符数不到1200个(数据来源见下文),所以我们可以做的更激进一些,只需将文章出现的中文字符全部记录下来,制成一张专属于自己网站的字符表,然后在每次发布文章时动态更新,这样我们能够保证字体完整渲染,并且处于边界极限状态!

实现这个个性化字符表char_set.txt的核心是一个提取文章中文字符的算法。这部分我是通过Gemini生成了一个update_lists.cpp文件,他能够识别_posts/下面所有文章,并输出到根目录的char_set.txt中,你可以根据代码内容进行自定义的修改:

/**

* @file update_lists.cpp

* @brief Scans Markdown files in /_posts/ and updates char_set.txt in root.

* @author Gemini

* @date 2025-11-28

*/

#include

#include

#include

#include

#include

#include

namespace fs = std::filesystem;

namespace char_collector {

const std::string kRegistryFilename = "char_set.txt";

const std::string kMarkdownExt = ".md";

const uint32_t kCJKStart = 0x4E00;

const uint32_t kCJKEnd = 0x9FFF;

bool NextUtf8Char(std::string::const_iterator& it,

const std::string::const_iterator& end,

uint32_t& out_codepoint,

std::string& out_bytes) {

if (it == end) return false;

unsigned char c1 = static_cast<unsigned char>(*it);

out_bytes.clear();

out_bytes += c1;

if (c1 < 0x80) { out_codepoint = c1; it++; return true; }

if ((c1 & 0xE0) == 0xC0) {

if (std::distance(it, end) < 2) return false;

unsigned char c2 = static_cast<unsigned char>(*(it + 1));

out_codepoint = ((c1 & 0x1F) << 6) | (c2 & 0x3F);

out_bytes += *(it + 1); it += 2; return true;

}

if ((c1 & 0xF0) == 0xE0) {

if (std::distance(it, end) < 3) return false;

unsigned char c2 = static_cast<unsigned char>(*(it + 1));

unsigned char c3 = static_cast<unsigned char>(*(it + 2));

out_codepoint = ((c1 & 0x0F) << 12) | ((c2 & 0x3F) << 6) | (c3 & 0x3F);

out_bytes += *(it + 1); out_bytes += *(it + 2); it += 3; return true;

}

if ((c1 & 0xF8) == 0xF0) {

if (std::distance(it, end) < 4) return false;

unsigned char c2 = static_cast<unsigned char>(*(it + 1));

unsigned char c3 = static_cast<unsigned char>(*(it + 2));

unsigned char c4 = static_cast<unsigned char>(*(it + 3));

out_codepoint = ((c1 & 0x07) << 18) | ((c2 & 0x3F) << 12) |

((c3 & 0x3F) << 6) | (c4 & 0x3F);

out_bytes += *(it + 1); out_bytes += *(it + 2); out_bytes += *(it + 3); it += 4; return true;

}

it++; return false;

}

bool IsChineseChar(uint32_t codepoint) {

return (codepoint >= kCJKStart && codepoint <= kCJKEnd);

}

class CharManager {

public:

CharManager() = default;

void LoadExistingChars(const std::string& filepath) {

std::ifstream infile(filepath);

if (!infile.is_open()) {

std::cout << "Info: " << filepath << " not found or empty. Starting fresh." << std::endl;

return;

}

std::string line;

while (std::getline(infile, line)) {

ProcessString(line, false);

}

std::cout << "Loaded " << existing_chars_.size()

<< " unique characters from " << filepath << "." << std::endl;

}

void ScanDirectory(const std::string& directory_path) {

if (!fs::exists(directory_path)) {

std::cerr << "Error: Directory '" << directory_path << "' does not exist." << std::endl;

return;

}

for (const auto& entry : fs::directory_iterator(directory_path)) {

if (entry.is_regular_file() &&

entry.path().extension() == kMarkdownExt) {

ProcessFile(entry.path().string());

}

}

}

void SaveNewChars(const std::string& filepath) {

if (new_chars_list_.empty()) {

std::cout << "No new Chinese characters found." << std::endl;

return;

}

std::ofstream outfile(filepath, std::ios::app);

if (!outfile.is_open()) {

std::cerr << "Error: Could not open " << filepath << " for writing." << std::endl;

return;

}

for (const auto& ch : new_chars_list_) {

outfile << ch;

}

std::cout << "Successfully added " << new_chars_list_.size()

<< " new characters to " << filepath << std::endl;

}

private:

std::unordered_set existing_chars_;

std::vector new_chars_list_;

void ProcessFile(const std::string& filepath) {

std::ifstream file(filepath);

if (!file.is_open()) return;

std::cout << "Scanning: " << fs::path(filepath).filename().string() << std::endl;

std::string content((std::istreambuf_iterator<char>(file)),

std::istreambuf_iterator<char>());

ProcessString(content, true);

}

void ProcessString(const std::string& content, bool track_new) {

auto it = content.begin();

auto end = content.end();

uint32_t codepoint;

std::string bytes;

while (NextUtf8Char(it, end, codepoint, bytes)) {

if (IsChineseChar(codepoint)) {

if (existing_chars_.find(bytes) == existing_chars_.end()) {

existing_chars_.insert(bytes);

if (track_new) {

new_chars_list_.push_back(bytes);

}

}

}

}

}

};

}

int main() {

char_collector::CharManager manager;

manager.LoadExistingChars(char_collector::kRegistryFilename);

manager.ScanDirectory("_posts");

manager.SaveNewChars(char_collector::kRegistryFilename);

return 0;

}

然后我们在终端编译一下再运行即可:

clang++ update_lists.cpp -o update_lists && ./update_lists

然后我们就会发现这张独属于本站的字符表生成了!🥳  为了方便操作,我们把原始的ttf文件放入仓库的

为了方便操作,我们把原始的ttf文件放入仓库的/FontRepo/下(最后记得在.gitignore添加这个文件夹!),然后稍微修改一下之前子集化的命令就可以了:

pyftsubset /FontRepo/NotoSerifSC-Bold.ttf --output-file=/assets/fonts/noto-serif-sc/NotoSerifSC-Bold.subset.woff2 --flavor=woff2 --text-file=char_set.txt --no-hinting --with-zopfli

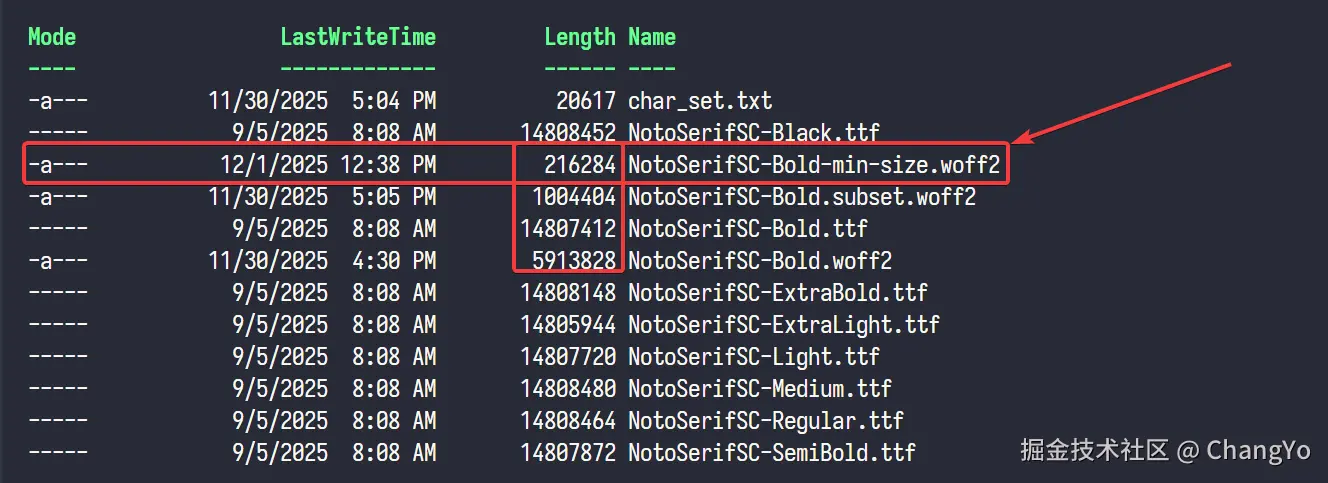

可以看到,最终输出的文件只有200K!压缩率达到了98.5%!

但是这个方法就像前面说的,处于字体渲染的边界。但凡多出一个字符表中的符号,那么这个字符就无法渲染,会回退到系统字体,看起来格外别扭。所以,在每次更新文章前,我们都需要运行一下

但是这个方法就像前面说的,处于字体渲染的边界。但凡多出一个字符表中的符号,那么这个字符就无法渲染,会回退到系统字体,看起来格外别扭。所以,在每次更新文章前,我们都需要运行一下./update_lists。此外,还存在一个问题,每次更新产生新的子集化文件时,都需要把旧的子集化文件删除,防止旧文件堆积。

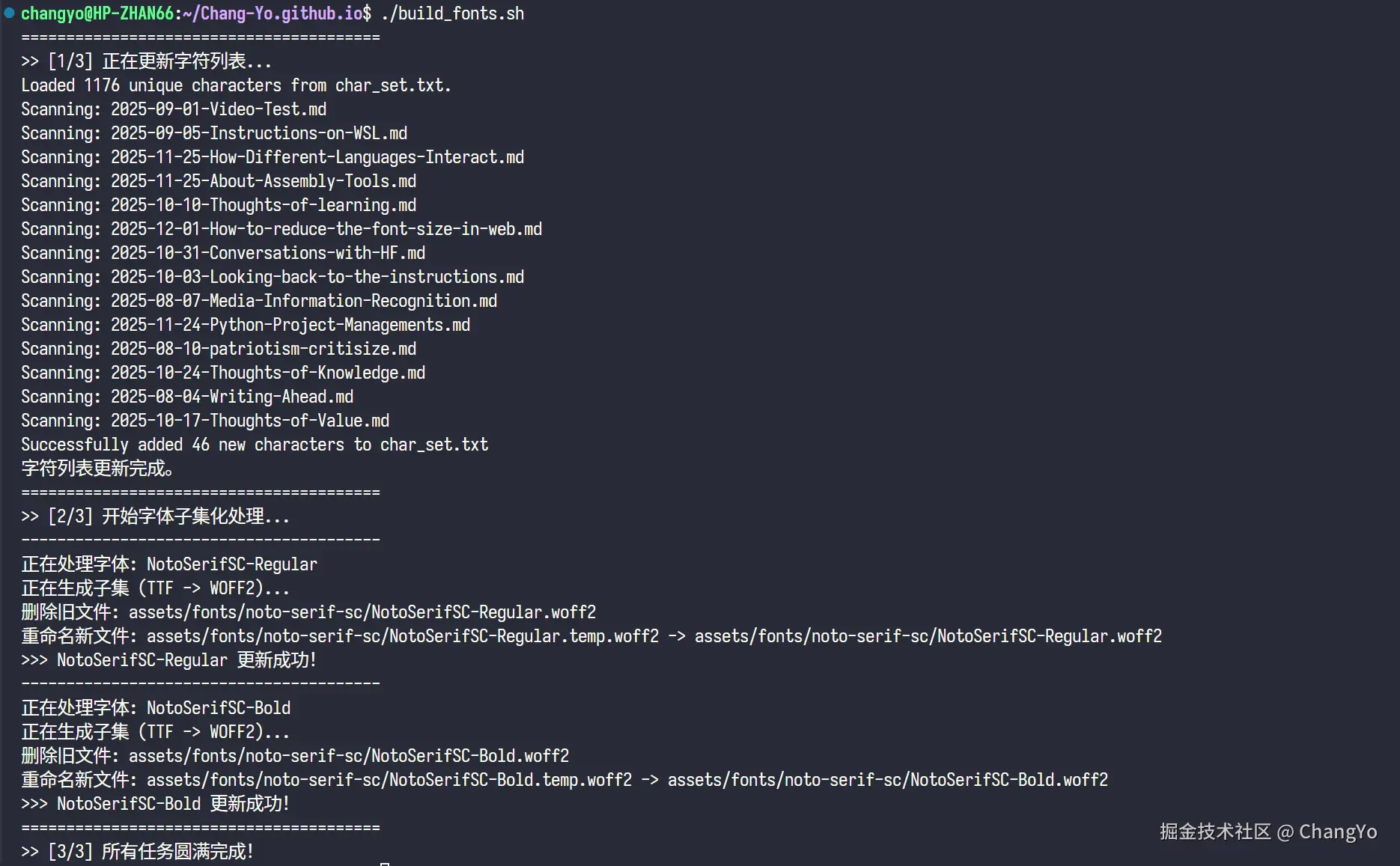

这些过程十分繁琐而且耗费时间,所以我们可以写一个bash脚本来实现这个过程的自动化。我这里同样是求助了Gemini,写了一个build_fonts.sh:

#!/bin/bash

set -e # 遇到错误立即停止执行

# ================= 配置区域 =================

# 字体源文件目录

SRC_DIR="FontRepo"

# 字体输出目录

OUT_DIR="assets/fonts/noto-serif-sc"

# 字符列表文件

CHAR_LIST="char_set.txt"

# C++ 更新工具

UPDATE_TOOL="./updateLists"

# 确保输出目录存在

if [ ! -d "$OUT_DIR" ]; then

echo "创建输出目录: $OUT_DIR"

mkdir -p "$OUT_DIR"

fi

# ================= 第一步:更新字符表 =================

echo "========================================"

echo ">> [1/3] 正在更新字符列表..."

if [ -x "$UPDATE_TOOL" ]; then

$UPDATE_TOOL

else

echo "错误: 找不到可执行文件 $UPDATE_TOOL 或者没有执行权限。"

echo "请尝试运行: chmod +x updateLists"

exit 1

fi

# 检查 char_set.txt 是否成功生成

if [ ! -f "$CHAR_LIST" ]; then

echo "错误: $CHAR_LIST 未找到,字符表更新可能失败。"

exit 1

fi

echo "字符列表更新完成。"

# ================= 定义子集化处理函数 =================

process_font() {

local font_name="$1" # 例如: NotoSerifSC-Regular

local input_ttf="$SRC_DIR/${font_name}.ttf"

local final_woff2="$OUT_DIR/${font_name}.woff2"

local temp_woff2="$OUT_DIR/${font_name}.temp.woff2"

echo "----------------------------------------"

echo "正在处理字体: $font_name"

# 检查源文件是否存在

if [ ! -f "$input_ttf" ]; then

echo "错误: 源文件 $input_ttf 不存在!"

exit 1

fi

# 2. 调用 fonttools (pyftsubset) 生成临时子集文件

# 使用 --obfuscate-names 可以进一步减小体积,但这里只用基础参数以保证稳定性

echo "正在生成子集 (TTF -> WOFF2)..."

pyftsubset "$input_ttf" \

--flavor=woff2 \

--text-file="$CHAR_LIST" \

--output-file="$temp_woff2"

# 3. & 4. 删除旧文件并重命名 (更新逻辑)

if [ -f "$temp_woff2" ]; then

if [ -f "$final_woff2" ]; then

echo "删除旧文件: $final_woff2"

rm "$final_woff2"

fi

echo "重命名新文件: $temp_woff2 -> $final_woff2"

mv "$temp_woff2" "$final_woff2"

echo ">>> $font_name 更新成功!"

else

echo "错误: 子集化失败,未生成目标文件。"

exit 1

fi

}

# ================= 第二步 & 第三步:执行转换 =================

echo "========================================"

echo ">> [2/3] 开始字体子集化处理..."

# 处理 Regular 字体

process_font "NotoSerifSC-Regular"

# 处理 Bold 字体

process_font "NotoSerifSC-Bold"

echo "========================================"

echo ">> [3/3] 所有任务圆满完成!"

如此一来,以后每次更新完文章,都只需要在终端输入./build_fonts.sh就可以完成字符提取、字体包子集化、清除旧字体包文件的过程了。

一点感想

在这之前另外讲个小故事,我尝试更换字体之前发现自定义的字体样式根本没有用,后来检查了很久,发现竟然是2个月前AI在我代码里加的一句font-family:'Noto Serif SC',而刚好他修改的又是优先级最高的文件,所以后面怎么修改字体都没有用。所以有时候让AI写代码前最好先搞清除代码的地位i,并且做好为AI代码后果负全责的准备。

更改网站字体其实很多时候属于锦上添花的事情,因为很多读者其实并不会太在意网站的字体。但不幸的是我对细节比较在意,或者说有种敝帚自珍的感觉吧,想慢慢地把网站装饰得舒适一些,所以才总是花力气在一些细枝末节的事情上。更何况,我是懂一点点设计的,有时候看见一些非常丑的Interface心里是很难受的。尽管就像绝大部分人理解不了设计师在细节上的别有用心一样,绝大部分人也不会在意一个网站的字体如何,但是我自己的家,我想装饰地好看些,对我来说就满足了。

更不要说,如果不去折腾这些东西,怎么可能会有这篇文章呢?如果能够帮助到一些人,也算是在世界留下一点价值了。

参考资料及附录

- 参考资料

a. 网页中文字体加载速度优化

b. 缩减网页字体大小

- 让Gemini生成代码时的Prompt:

---Prompt 1---

# 任务名称:创建脚本实现对字符的收集

请利用C++来完成一下任务要求:

1. 该脚本能够读取项目目录下的markdown文件,并且能够识别当中所有的中文字符,将该中文字符与`/char_test/GeneralUsedChars.txt`的字符表进行查重比较:

若该字在表中存在,则跳过,处理下一个字;

若不存在,则将该字添加到表中,然后继续处理下一个字符

2. 请设计一个高效的算法,尤其是在字符查重的过程中,你需要设计一个高效且准确率高的算法

3. 请注意脚本的通用性,你需要考虑到这个项目以后可能会继续增加更多的markdown文件,所以你不应该仅仅只是处理现有的markdown文件,还需要考虑到以后的拓展性

4. 如果可以的话,尽可能使用C++来实现,因为效率更高

---Prompt 2---

可以了,现在我要求你编写一个脚本以实现自动化,要求如下:

1. 脚本运行时,首先会调用项目根目录下的updateLists可执行文件,更新char_set.txt

2. 接着,脚本会调用fonttools工具,对路径在`/FontRepo/`下的两个文件进行ttf到woff2的子集化转化,其中这两个字体文件的名字分别为`NotoSerifSC-Regular.ttf`和`NotoSerifSC-Bold.ttf`。

3. 转化好的子集文件应该输出到 `/assets/fonts/noto-serif-sc/`文件夹下。

4. 将`/assets/fonts/noto-serif-sc/`文件夹下原本已经存在的两个字体文件`NotoSerifSC-Bold.woff2`和`NotoSerifSC-Regular.woff2`删除,然后将新得到子集化文件重新命名为这两个删除了的文件的名字。这一步相当于完成了字体文件的更新

请注意文件的命名,尤其是不要搞错字号,新子集文件和旧子集文件。

请注意在子集化步骤的bash命令,环境已经安装好fonttools及其对应依赖,你可以参考下面这个命令来使用,或者使用更好更稳定的用法:

pyftsubset --flavor=woff2 --text-file= --output-file=

(再次注意输出路径)

- 最终实践效果(以

NotoSerifSC-Bold为例)处理方式 字体包体积 压缩率 无处理 14.462M 0% 格式转化 5.776M 60.06% 子集化处理 981K 93.21% 分包处理 依据动态加载量而定 无 我的实践 216K 98.5%

来源:juejin.cn/post/7578699866181238822

一个AI都无法提供的html转PDF方案

这也许就是AI无法代替人的原因,只需一行代码就可以实现纯前端 html 转矢量 pdf 的功能

// 引入 dompdf.js库

import dompdf from "dompdf.js";

dompdf(document.querySelector("#capture")).then(function (blob) {

//文件操作

});

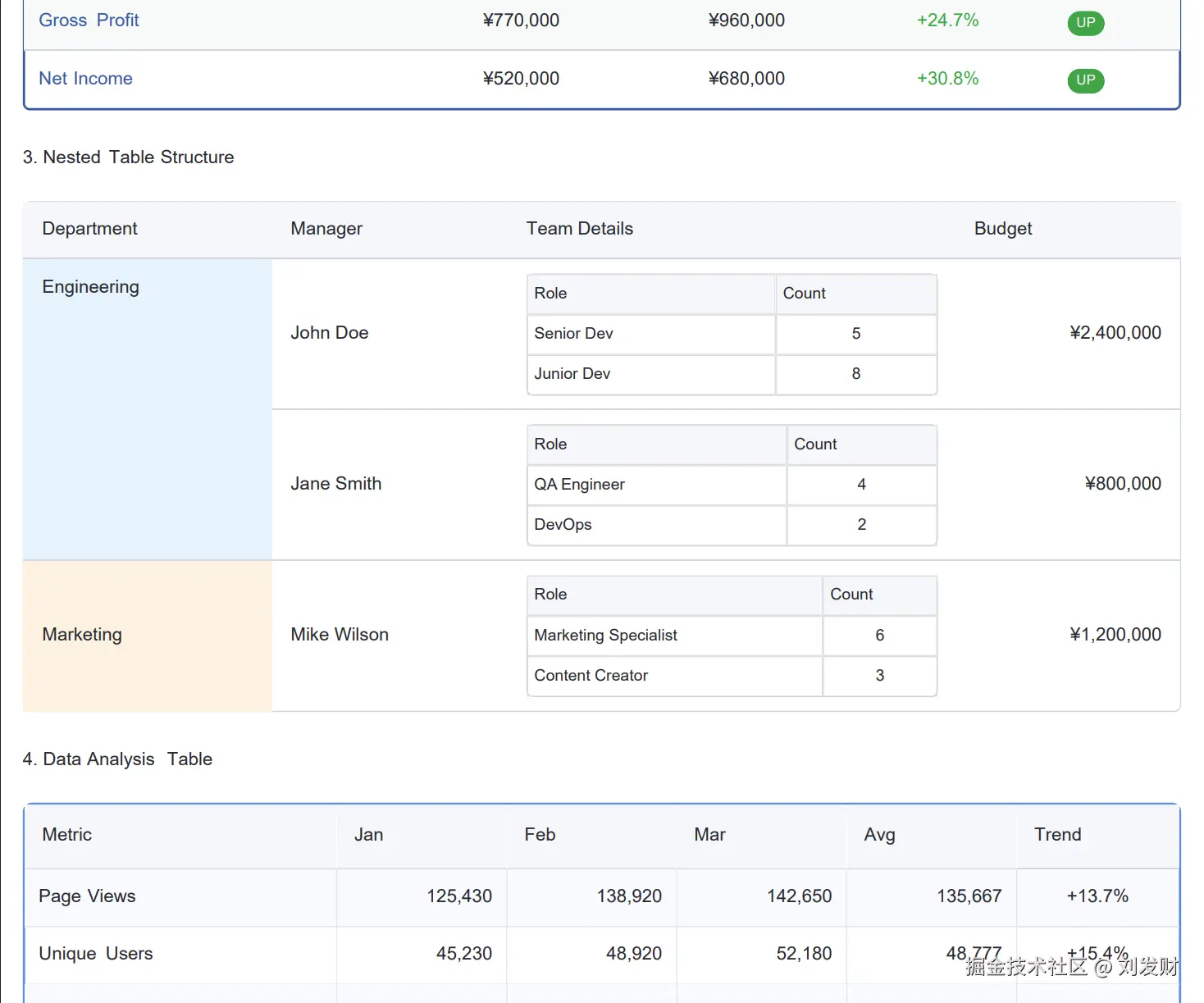

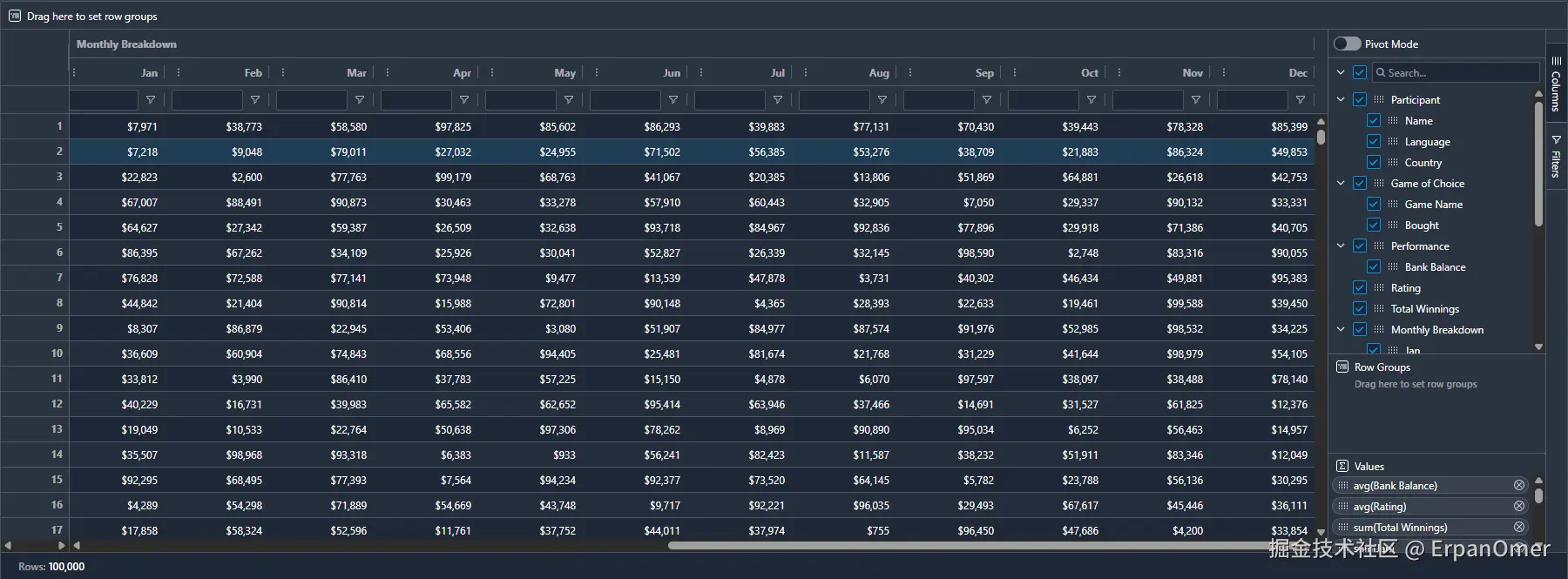

实现效果(复杂表格)

1. 在线体验

2. Git 仓库地址 (欢迎 Star⭐⭐⭐)

3. 生成 PDF

在前端生态里,把网页内容生成 PDF 一直是一个常见但不简单的需求。从报表导出、小票生成、合同下载到打印排版,很多项目或多或少都会遇到。市面上常见的方案大致有以下几类:

- 服务端渲染 PDF(后端库如 wkhtmltopdf、PrinceXML 等)

- 客户端将 HTML 渲染为图片(如 html2canvas + jsPDF)然后再封装为 PDF

- 前端调用相关 pdf 生成库来生成 PDF(如 pdfmake,jspdf,pdfkit)

但是这些方案都有各自的局限性,

- 比如服务端渲染 PDF 对服务器资源要求高,需要后端参与。

- html2canvas + jsPDF 需要将 html 内容渲染为图片,再将图片封装为 PDF,速度会比较慢,而且生成体积会比较大,内容会模糊,限制于 canvas 生成高度,不能生成超过 canvas 高度的内容。

- 而前端调用相关 pdf 生成库来生成 PDF 则需要对相关库有一定的了解,api 比较复杂,学习使用成本很高。

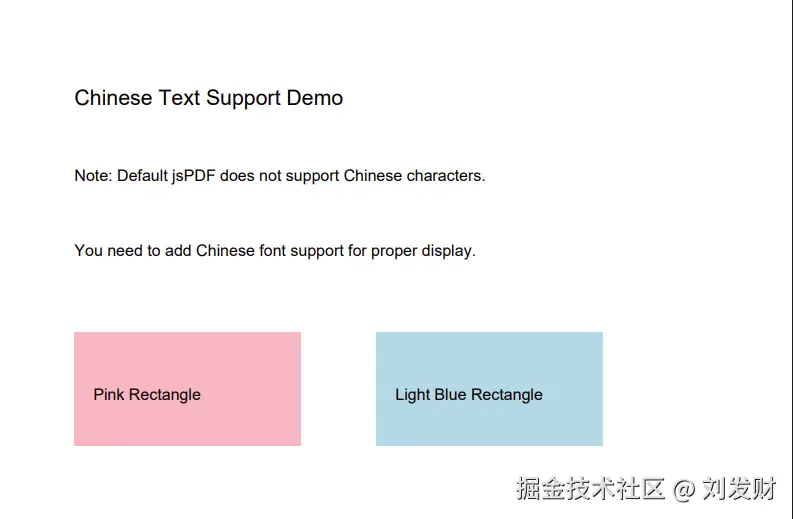

使用 jspdf 生成如图简单的 pdf

就需要如此复杂的代码,如果要生成复杂的 pdf, 比如包含表格、图片、图表等内容,那使用成本就更高了。

function generateChinesePDF() {

// Check if jsPDF is loaded

if (typeof window.jspdf === "undefined") {

alert("jsPDF library has not finished loading, please try again later");

return;

}

const { jsPDF } = window.jspdf;

const doc = new jsPDF();

// Note: Default jsPDF does not support Chinese, this is just a demo

// In real projects you need to add Chinese font support

doc.setFontSize(16);

doc.text("Chinese Text Support Demo", 20, 30);

doc.setFontSize(12);

doc.text("Note: Default jsPDF does not support Chinese characters.", 20, 50);

doc.text("You need to add Chinese font support for proper display.", 20, 70);

// Draw some graphics for demonstration

doc.setFillColor(255, 182, 193);

doc.rect(20, 90, 60, 30, "F");

doc.setTextColor(0, 0, 0);

doc.text("Pink Rectangle", 25, 108);

doc.setFillColor(173, 216, 230);

doc.rect(100, 90, 60, 30, "F");

doc.text("Light Blue Rectangle", 105, 108);

doc.save("chinese-example.pdf");

}

但是现在,有了 dompdf.js,你只需要一行代码,就可以完成比这个复杂 10 倍的 PDF 生成任务,html页面所见即所得,可以将复杂的css样式转化成pdf

dompdf(document.querySelector("#capture")).then(function (blob) {

//文件操作

});

而且,dompdf.js 生成的 PDF 是矢量的,非图片式的,高清晰度的,文字可以选中、复制、搜索等操作(在支持的 PDF 阅读器环境下),区别于客户端将 HTML 渲染为图片(如 html2canvas + jsPDF)然后再封装为 PDF。

具体可以去体验 立即体验 https://dompdfjs.lisky.com.cn

4. dompdf.js 是如何实现的?

其实 dompdf.js 也是基于 html2canvas+jspdf 实现的,但是为什么 dompdf.js 生成的 pdf 文件可以二次编辑,更清晰,体积小呢?

不同于普通的 html2canvas + jsPDF 方案,将 dom 内容生成为图片,再将图片内容用 jspdf 绘制到 pdf 上,这就导致了生成的 pdf 文件体积大,无法编辑,放大后会模糊。

html2canvas 原理简介

1. DOM 树遍历

html2canvas 从指定的 DOM 节点开始,递归遍历所有子节点,构建一个描述页面结构的内部渲染队列。

2. 样式计算

对每个节点调用 window.getComputedStyle() 获取最终的 CSS 属性值。这一步至关重要,因为它包含了所有 CSS 规则(内联、内部、外部样式表)层叠计算后的最终结果。

3. 渲染模型构建

将每个 DOM 节点和其计算样式封装成渲染对象,包含绘制所需的完整信息:位置(top, left)、尺寸(width, height)、背景、边框、文本内容、字体属性、层级关系(z-index)等。

4. Canvas 上下文创建

在内存中创建 canvas 元素,获取其 2D 渲染上下文(CanvasRenderingContext2D)。

5. 浏览器绘制模拟

按照 DOM 的堆叠顺序和布局规则,遍历渲染队列,将每个元素绘制到 Canvas 上。这个过程实质上是将 CSS 属性"翻译"成对应的绘制 API 调用:

| CSS 属性 | 传统 Canvas API | dompdf.js 中的 jsPDF API |

|---|---|---|

background-color | ctx.fillStyle + ctx.fillRect() | doc.setFillColor() + doc.rect(x, y, w, h, 'F') |

border | ctx.strokeStyle + ctx.strokeRect() | doc.setDrawColor() + doc.rect(x, y, w, h, 'S') |

color, font-family, font-size | ctx.fillStyle, ctx.font + ctx.fillText() | doc.setTextColor() + doc.setFont() + doc.text() |

border-radius | arcTo() 或 bezierCurveTo() 创建剪切路径 | doc.roundedRect() 或 doc.lines() 绘制圆角 |

image | ctx.drawImage() | doc.addImage() |

核心创新:API 替换,底层是封装了 jsPDF 的 API

dompdf.js 的关键突破在于改造了 html2canvas 的 canvas-renderer.ts 文件,将原本输出到 Canvas 的绘制 API 替换为 jsPDF 的 API 调用。这样就实现了从 DOM 直接到 PDF 的转换,生成真正可编辑、可搜索的 PDF 文件,而不是传统的图片格式。

目前实现的功能

1. 文字绘制 (颜色,大小)

2. 图片绘制 (支持 jpeg, png 等格式)

3. 背景,背景颜色 (支持合并单元格)

4. 边框,复杂表格绘制 (支持合并单元格)

5. canvas (支持多种图表类型)

6. svg (支持 svg 元素绘制)

7. 阴影渲染 (使用 foreignObjectRendering,支持边框阴影渲染)

8. 渐变渲染 (使用 foreignObjectRendering,支持背景渐变渲染)

7.使用

安装

npm install dompdf.js --save

CDN 引入

<script src="https://cdn.jsdelivr.net/npm/dompdf.js@latest/dist/dompdf.js"></script>

基础用法

import dompdf from "dompdf.js";

dompdf(document.querySelector("#capture"), {

useCORS: true, //是否允许跨域

})

.then(function (blob) {

const url = URL.createObjectURL(blob);

const a = document.createElement("a");

a.href = url;

a.download = "example.pdf";

document.body.appendChild(a);

a.click();

})

.catch(function (err) {

console.log(err, "err");

});

写在最后

dompdf.js 让前端 PDF 生成变得前所未有的简单:无需后端、无需繁琐配置、一行代码即可输出矢量、可检索、可复制的专业文档。无论是简历、报告还是发票,它都能轻松胜任。 欢迎在你的项目中使用它 。

如果它帮到了你,欢迎去 github.com/lmn1919/dom… 点个 Star,提优化,共建项目。

来源:juejin.cn/post/7559886023661649958

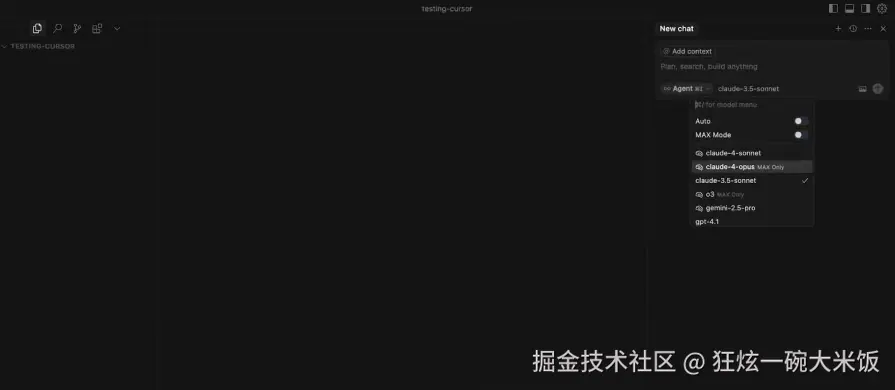

从前端的角度出发,目前最具性价比的全栈路线是啥❓❓❓

我正在筹备一套前端工程化体系的实战课程。如果你在学习前端的过程中感到方向模糊、技术杂乱无章,那么前端工程化将是你实现系统进阶的最佳路径。它不仅能帮你建立起对现代前端开发的整体认知,还能提升你在项目开发、协作规范、性能优化等方面的工程能力。

✅ 本课程覆盖构建工具、测试体系、脚手架、CI/CD、Docker、Nginx 等核心模块,内容体系完整,贯穿从开发到上线的全流程。每一章节都配有贴近真实场景的企业级实战案例,帮助你边学边用,真正掌握现代团队所需的工程化能力,实现从 CRUD 开发者到工程型前端的跃迁。

详情请看前端工程化实战课程

学完本课程,对你的简历和具体的工作能力都会有非常大的提升。如果你对此项目感兴趣,或者课程感兴趣,可以私聊我微信 yunmz777

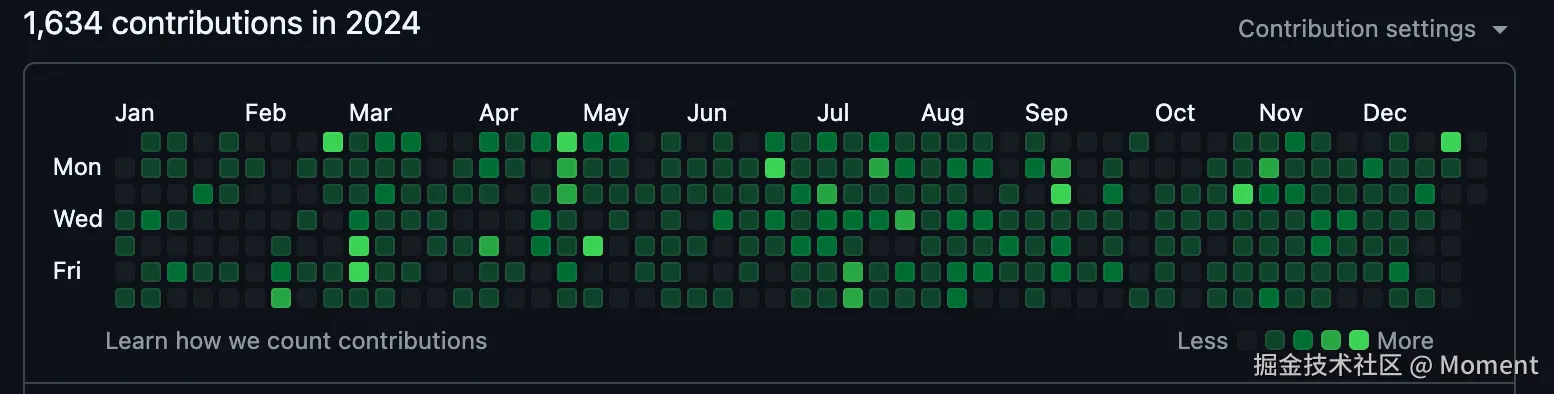

今年大部分时间都是在编码上和写文章上,但是也不知道自己都学到了啥,那就写篇文章来盘点一下目前的技术栈吧,也作为下一年的参考目标,方便知道每一年都学了些啥。

我的技术栈

首先我先来对整体的技术做一个简单的介绍吧,然后后面再对当前的一些技术进行细分吧。

React、Typescript、React Native、mysql、prisma、NestJs、Redis、前端工程化。

React

React 这个框架我花的时间应该是比较多的了,在校期间已经读了一遍源码了,对这些原理已经基本了解了。在随着技术的继续深入,今年毕业后又重新开始阅读了一遍源码,对之前的认知有了更深一步的了解。

也写了比较多跟 React 相关的文章,包括设计模式,原理,配套生态的使用等等都有一些涉及。

在状态管理方面,redux,zustand 我都用过,尤其在 Zustand 的使用上,我特别喜欢 Zustand,它使得我能够快速实现全局状态管理,同时避免了传统 Redux 中繁琐的样板代码,且性能更优。也对 Zustand 有比较深入的了解,也对其源码有过研究。

NextJs

Next.js 是一个基于 React 的现代 Web 开发框架,它为开发者提供了一系列强大的功能和工具,旨在优化应用的性能、提高开发效率,并简化部署流程。Next.js 支持多种渲染模式,包括服务器端渲染(SSR)、静态生成(SSG)和增量静态生成(ISR),使得开发者可以根据不同的需求选择合适的渲染方式,从而在提升页面加载速度的同时优化 SEO。

在路由管理方面,Next.js 采用了基于文件系统的路由机制,这意味着开发者只需通过创建文件和文件夹来自动生成页面路由,无需手动配置。这种约定优于配置的方式让路由管理变得直观且高效。此外,Next.js 提供了动态路由支持,使得开发者可以轻松实现复杂的 URL 结构和参数化路径。

Next.js 还内置了 API 路由,允许开发者在同一个项目中编写后端 API,而无需独立配置服务器。通过这种方式,前后端开发可以在同一个代码库中协作,大大简化了全栈开发流程。同时,Next.js 对 TypeScript 提供了原生支持,帮助开发者提高代码的可维护性和可靠性。

Typescript

今年所有的项目都是在用 ts 写了,真的要频繁修改的项目就知道用 ts 好处了,有时候用 js 写的函数修改了都不知道怎么回事,而用了 ts 之后,哪里引用到的都报红了,修改真的非常方便。

今年花了一点时间深入学习了一下 Ts 类型,对一些高级类型以及其实现原理也基本知道了,明年还是多花点时间在类型体操上,除了算法之外,感觉类型体操也可以算得上是前端程序员的内功心法了。

React Native

不得不说,React Native 不愧是接活神器啊,刚学完之后就来了个安卓和 ios 的私活,虽然没有谈成。

React Native 和 Expo 是构建跨平台移动应用的两大热门工具,它们都基于 React,但在功能、开发体验和配置方式上存在一些差异。React Native 是一个开放源代码的框架,允许开发者使用 JavaScript 和 React 来构建 iOS 和 Android 原生应用。Expo 则是一个构建在 React Native 之上的开发平台,它提供了一套工具和服务,旨在简化 React Native 开发过程。

React Native 的核心优势在于其高效的跨平台开发能力。通过使用 React 语法和组件,开发者能够一次编写应用的 UI 和逻辑,然后部署到 iOS 和 Android 平台。React Native 提供了对原生模块的访问,使开发者能够使用原生 API 来扩展应用的功能,确保性能和用户体验能够接近原生应用。

Expo 在此基础上进一步简化了开发流程。作为一个开发工具,Expo 提供了许多内置的 API 和组件,使得开发者无需在项目中进行繁琐的原生模块配置,就能够快速实现设备的硬件访问功能(如摄像头、位置、推送通知等)。Expo 还内置了一个开发客户端,使得开发者可以实时预览应用,无需每次都进行完整的构建和部署。

另外,Expo 提供了一个完全托管的构建服务,开发者只需将应用推送到 Expo 服务器,Expo 就会自动处理 iOS 和 Android 应用的构建和发布。这大大简化了应用的构建和发布流程,尤其适合不想处理复杂原生配置的开发者。

然而,React Native 和 Expo 也有各自的局限性。React Native 提供更大的灵活性和自由度,开发者可以更自由地集成原生代码或使用第三方原生库,但这也意味着需要更多的配置和维护。Expo 则封装了很多功能,简化了开发,但在需要使用某些特定原生功能时,开发者可能需要“弹出”Expo 的托管环境,进行额外的原生开发。

样式方案的话我使用的是 twrnc,大部分组件都是手撸,因为有 cursor 和 chatgpt 的加持,开发效果还是杠杠的。

rn 原理也争取明年能多花点时间去研究研究,不然对着盲盒开发还是不好玩。

Nestjs

NestJs 的话没啥好说的,之前也都写过很多篇文章了,感兴趣的可以直接观看:

对 Nodejs 的底层也有了比较深的理解了:

Prisma & mysql

Prisma 是一个现代化的 ORM(对象关系映射)工具,旨在简化数据库操作并提高开发效率。它支持 MySQL 等关系型数据库,并为 Node.js 提供了类型安全的数据库客户端。在 NestJS 中使用 Prisma,可以让开发者轻松定义数据库模型,并通过自动生成的 Prisma Client 执行类型安全的查询操作。与 MySQL 配合时,Prisma 提供了一种简单、直观的方式来操作数据库,而无需手动编写复杂的 SQL 查询。

Prisma 的核心优势在于其强大的类型安全功能,所有的数据库操作都能通过 Prisma Client 提供的自动生成的类型来进行,这大大减少了代码中的错误,提升了开发的效率。它还包含数据库迁移工具 Prisma Migrate,能够帮助开发者方便地管理数据库结构的变化。此外,Prisma Client 的查询 API 具有很好的性能,能够高效地执行复杂的数据库查询,支持包括关系查询、聚合查询等高级功能。

与传统的 ORM 相比,Prisma 使得数据库交互更加简洁且高效,减少了配置和手动操作的复杂性,特别适合在 NestJS 项目中使用,能够与 NestJS 提供的依赖注入和模块化架构很好地结合,提升整体开发体验。

Redis

Redis 和 mysql 都仅仅是会用的阶段,目前都是直接在 NestJs 项目中使用,都是已经封装好了的,直接传参调用就好了:

import { Injectable, Inject, OnModuleDestroy, Logger } from "@nestjs/common";

import Redis, { ClientContext, Result } from "ioredis";

import { ObjectType } from "../types";

import { isObject } from "@/utils";

@Injectable()

export class RedisService implements OnModuleDestroy {

private readonly logger = new Logger(RedisService.name);

constructor(@Inject("REDIS_CLIENT") private readonly redisClient: Redis) {}

onModuleDestroy(): void {

this.redisClient.disconnect();

}

/**

* @Description: 设置值到redis中

* @param {string} key

* @param {any} value

* @return {*}

*/

public async set(

key: string,

value: unknown,

second?: number

): Promise<Result<"OK", ClientContext> | null> {

try {

const formattedValue = isObject(value)

? JSON.stringify(value)

: String(value);

if (!second) {

return await this.redisClient.set(key, formattedValue);

} else {

return await this.redisClient.set(key, formattedValue, "EX", second);

}

} catch (error) {

this.logger.error(`Error setting key ${key} in Redis`, error);

return null;

}

}

/**

* @Description: 获取redis缓存中的值

* @param key {String}

*/

public async get(key: string): Promise<string | null> {

try {

const data = await this.redisClient.get(key);

return data ? data : null;

} catch (error) {

this.logger.error(`Error getting key ${key} from Redis`, error);

return null;

}

}

/**

* @Description: 设置自动 +1

* @param {string} key

* @return {*}

*/

public async incr(

key: string

): Promise<Result<number, ClientContext> | null> {

try {

return await this.redisClient.incr(key);

} catch (error) {

this.logger.error(`Error incrementing key ${key} in Redis`, error);

return null;

}

}

/**

* @Description: 删除redis缓存数据

* @param {string} key

* @return {*}

*/

public async del(key: string): Promise<Result<number, ClientContext> | null> {

try {

return await this.redisClient.del(key);

} catch (error) {

this.logger.error(`Error deleting key ${key} from Redis`, error);

return null;

}

}

/**

* @Description: 设置hash结构

* @param {string} key

* @param {ObjectType} field

* @return {*}

*/

public async hset(

key: string,

field: ObjectType

): Promise<Result<number, ClientContext> | null> {

try {

return await this.redisClient.hset(key, field);

} catch (error) {

this.logger.error(`Error setting hash for key ${key} in Redis`, error);

return null;

}

}

/**

* @Description: 获取单个hash值

* @param {string} key

* @param {string} field

* @return {*}

*/

public async hget(key: string, field: string): Promise<string | null> {

try {

return await this.redisClient.hget(key, field);

} catch (error) {

this.logger.error(

`Error getting hash field ${field} from key ${key} in Redis`,

error

);

return null;

}

}

/**

* @Description: 获取所有hash值

* @param {string} key

* @return {*}

*/

public async hgetall(key: string): Promise<Record<string, string> | null> {

try {

return await this.redisClient.hgetall(key);

} catch (error) {

this.logger.error(

`Error getting all hash fields from key ${key} in Redis`,

error

);

return null;

}

}

/**

* @Description: 清空redis缓存

* @return {*}

*/

public async flushall(): Promise<Result<"OK", ClientContext> | null> {

try {

return await this.redisClient.flushall();

} catch (error) {

this.logger.error("Error flushing all Redis data", error);

return null;

}

}

/**

* @Description: 保存离线通知

* @param {string} userId

* @param {any} notification

*/

public async saveOfflineNotification(

userId: string,

notification: any

): Promise<void> {

try {

await this.redisClient.lpush(

`offline_notifications:${userId}`,

JSON.stringify(notification)

);

} catch (error) {

this.logger.error(

`Error saving offline notification for user ${userId}`,

error

);

}

}

/**

* @Description: 获取离线通知

* @param {string} userId

* @return {*}

*/

public async getOfflineNotifications(userId: string): Promise<any[]> {

try {

const notifications = await this.redisClient.lrange(

`offline_notifications:${userId}`,

0,

-1

);

await this.redisClient.del(`offline_notifications:${userId}`);

return notifications.map((notification) => JSON.parse(notification));

} catch (error) {

this.logger.error(

`Error getting offline notifications for user ${userId}`,

error

);

return [];

}

}

/**

* 获取指定 key 的剩余生存时间

* @param key Redis key

* @returns 剩余生存时间(秒)

*/

public async getTTL(key: string): Promise<number> {

return await this.redisClient.ttl(key);

}

}

前端工程化

前端工程化这块花了很多信息在 eslint、prettier、husky、commitlint、github action 上,现在很多项目都是直接复制之前写好的过来就直接用。

后续应该是投入更多的时间在性能优化、埋点、自动化部署上了,如果有机会的也去研究一下 k8s 了。

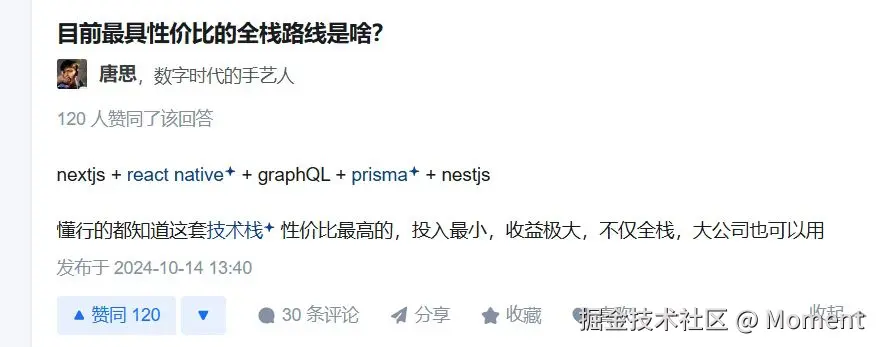

全栈性价比最高的一套技术

最近刷到一个帖子,讲到了

我目前也算是一个小全栈了吧,我也来分享一下我的技术吧:

- NextJs

- React Native

- prisma

- NestJs

- taro (目前还不会,如果有需求就会去学)

剩下的描述也是和他下面那句话一样了(毕业后对技术态度的转变就是什么能让我投入最小,让我最快赚到钱的就是好技术)

总结

学无止境,任重道远。

最后再来提一下这两个开源项目,它们都是我们目前正在维护的开源项目:

如果你想参与进来开发或者想进群学习,可以添加我微信 yunmz777,后面还会有很多需求,等这个项目完成之后还会有很多新的并且很有趣的开源项目等着你。

来源:juejin.cn/post/7451483063568154639

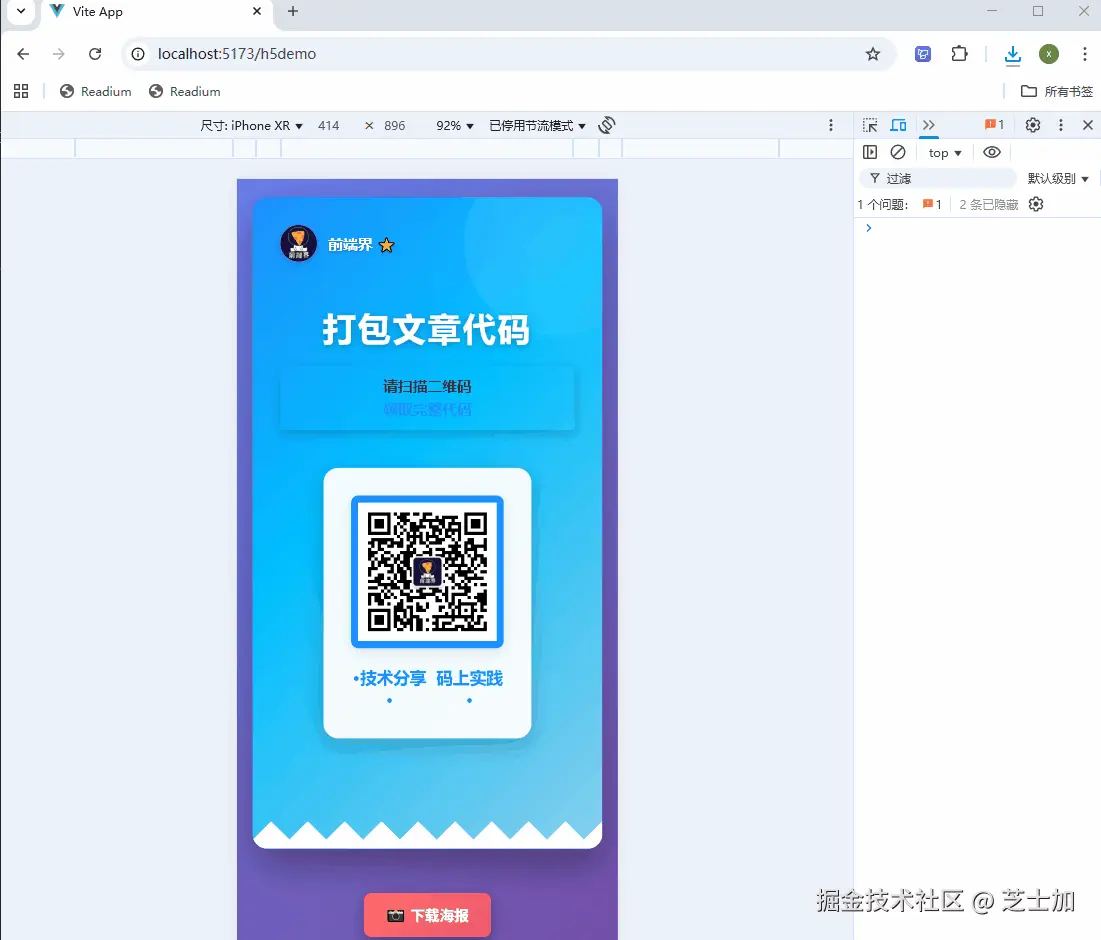

还在用html2canvas?介绍一个比它快100倍的截图神器!

在日常业务开发里,DOM 截图 几乎是刚需场景。

无论是生成分享卡片、导出报表,还是保存一段精美排版内容,前端同学都绕不开它。

但问题来了——市面上的截图工具,比如 html2canvas,虽然用得多,却有一个致命缺陷:慢!

普通截图动辄 1 秒以上,大一点的 DOM,甚至能直接卡到怀疑人生,用户体验一言难尽。

大家好,我是芝士,欢迎点此扫码加我微信 Hunyi32 交流,最近创建了一个低代码/前端工程化交流群,欢迎加我微信 Hunyi32 进群一起交流学习,也可关注我的公众号[ 前端界 ] 持续更新优质技术文章

最近发现一个保存速度惊艳到我的库snapDOM 。

这货在性能上的表现,完全可以用“碾压”来形容:

- 👉 相比 html2canvas,快 32 ~ 133 倍

- 👉 相比 modern-screenshot,也快 2 ~ 93 倍

以下是官方基本测试数据:

| 场景 | snapDOM vs html2canvas | snapDOM vs dom-to-image |

|---|---|---|

| 小元素 (200×100) | 32 倍 | 6 倍 |

| 模态框 (400×300) | 33 倍 | 7 倍 |

| 整页截图 (1200×800) | 35 倍 | 13 倍 |

| 大滚动区域 (2000×1500) | 69 倍 | 38 倍 |

| 超大元素 (4000×2000) | 93 倍 🔥 | 133 倍 |

📊 数据来源:snapDOM 官方 benchmark(基于 headless Chromium 实测)。

⚡ 为什么它这么快?

二者的实现原理不同

html2canvas 的实现方式

- 原理:

通过遍历 DOM,把每个节点的样式(宽高、字体、背景、阴影、图片等)计算出来,然后在<canvas>上用 Canvas API 重绘一遍。 - 特点:

- 需要完整计算 CSS 样式 → 排版 → 绘制。

- 复杂 DOM 时计算量极大,比如渐变、阴影、字体渲染都会消耗 CPU。

- 整个过程基本是 模拟浏览器的渲染引擎,属于“重造轮子”。

所以一旦 DOM 大、样式复杂,html2canvas 很容易出现 1s+ 延迟甚至卡死。

snapDOM 的实现方式

原理:利用浏览器 原生渲染能力,而不是自己模拟。

snapDOM 的 captureDOM 并不是自己用 Canvas API 去一笔一笔绘制 DOM(像 html2canvas 那样),而是:

- 复制 DOM 节点(prepareClone)

- → 生成一个“克隆版”的 DOM,里面包含了样式、结构。

- 把图片、背景、字体都转成 inline(base64 / dataURL)

- → 确保克隆 DOM 是完全自包含的。

- 用

<foreignObject>包在 SVG 里面

- → 浏览器原生支持直接渲染 HTML 片段到 SVG → 再转成 dataURL。

所以核心就是:

👉 利用浏览器自己的渲染引擎(SVG foreignObject)来排版和绘制,而不是 JS 重造渲染过程。

如何使用 snapDOM

snapDOM 上手非常简单, 学习成本比较低。

1. 安装

通过npm 安装:

npm install @zumer/snapdom

或者直接用 CDN 引入:

<script src="https://cdn.jsdelivr.net/npm/@zumer/snapdom/dist/snapdom.min.js"></script>

2. 基础用法

只需要一行代码,就能把 DOM 节点“变”成图片:

// 选择你要截图的 DOM 元素

const target = document.querySelector('.card');

// 导出为 PNG 图片

const image = await snapdom.toPng(target);

// 直接添加到页面

document.body.appendChild(image);

3. 更多导出方式

除了 PNG,snapDOM 还支持多种输出格式:

// 导出为 JPEG

const jpeg = await snapdom.toJpeg(target);

// 导出为 SVG

const svg = await snapdom.toSvg(target);

// 直接保存为文件

await snapdom.download(target, { format: 'png', filename: 'screenshot.png' });

4. 导出一个这样的海报图

开发中生成海报并保存到, 是非常常见的需求,以前使用html2canvas,也要写不少代码, 还要处理图片失真等问题, 使用snapDOM,真的一行代码能搞定。

<div ref="posterRef" class="poster">

....

</div>

<script setup lang="ts">

const downloadPoster = async () => {

if (!posterRef.value) {

alert("海报元素未找到");

return;

}

try {

// snapdom 是 UMD 格式,通过全局 window.snapdom 访问

const snap = (window as any).snapdom;

if (!snap) {

alert("snapdom 库未加载,请刷新页面重试");

return;

}

await snap.download(posterRef.value, {

format: "png",

filename: `tech-poster-${Date.now()}`

});

} catch (error) {

console.error("海报生成失败:", error);

alert("海报生成失败,请重试");

}

};

</script>

相比传统方案需要大量配置和兼容性处理,snapDOM 真正做到了 一行代码,极速生成。无论是分享卡片、营销海报还是报表导出,都能轻松搞定。

await snap.download(posterRef.value, {

format: "png",

filename: `tech-poster-${Date.now()}`

});

大家好,我是芝士,欢迎点此扫码加我微信 Hunyi32 交流,最近创建了一个低代码/前端工程化交流群,欢迎加我微信 Hunyi32 进群一起交流学习,也可关注我的公众号[ 前端界 ] 持续更新优质技术文章

总结

在前端开发里,DOM 截图是一个常见但“让人头疼”的需求。

- html2canvas 代表的传统方案,虽然功能强大,但性能和体验常常拖后腿;

- 而 snapDOM 借助浏览器原生渲染能力,让截图变得又快又稳。

一句话:

👉 如果你还在为截图慢、卡顿、模糊烦恼,不妨试试 snapDOM —— 可能会刷新你对前端截图的认知。 🚀

来源:juejin.cn/post/7542379658522116123

10年老前端吐槽Tailwind CSS:是神器还是“神坑”?

作为一个老前端人比大家虚长几岁,前端技术的飞速发展,从早期的 jQuery 到现代的 React、Vue,再到 CSS 框架的演变。最近几年,Tailwind CSS 成为了前端圈的热门话题,很多人称它为“神器”,但也有不少人认为它是“神坑”。今天,我就从实际项目经验出发,吐槽一下 Tailwind CSS 的弊端。

HTML 代码臃肿,可读性差

例如:

<div class="p-4 bg-white rounded-lg shadow-md text-gray-800 hover:bg-gray-100">

Content

</div>

以至于前端同学前来吐槽,这和写style有个毛线区别。

虽然tailwind提供了@apply方法,将常用的实用类代码提取到css中,来减少html的代码量

.btn {

@apply p-4 bg-blue-500 text-white rounded-lg hover:bg-blue-600;

}

可以一个大型项目样式复杂,常常看到这样的场景:

.btn1 {

@apply p-4 bg-blue-500 text-white rounded-lg hover:bg-blue-600;

}

.btn2 {

@apply p-6 bg-blue-500 text-blue rounded-lg hover:bg-blue-600;

}

.btn3 {

@apply p-8 bg-blue-500 text-red rounded-lg hover:bg-blue-600;

}

.btn4 {

@apply p-10 bg-blue-500 rounded-lg hover:bg-green-600;

}

读起来都费劲。

增加了前端同学的学习成本

开发是必须学习大量的tailwind的实用类,并且要花时间学习这些命名规则,例如:

p-4是 padding,m-4是 margin。text-sm是小字体,text-lg是大字体。bg-blue-500是背景色,text-blue-500是文字颜色。

国内的项目大家都知道,不是在赶工期,就是在赶工期的路上,好多小伙伴开发的时候直接就上style了。

当然这样也有好处,能使用JIT模式,按需生成css,减少文件的大小。避免了以前项目中好多无用的css。

动态样式支持有限

有时候需要动态生成的类会导致错误,例如:

<div class="text-{{ color }}-500 bg-{{ bgColor }}-100">

Content

</div>

如果color被复制为green,但是系统并没有定义 text-green-500 这个类。让项目变得难以调试和维护。

总结

Tailwind CSS 是一把双刃剑,它既能为开发带来极大的便利,也可能成为项目的“神坑”。作为开发者,我们需要根据项目需求,合理使用 Tailwind,并通过一些最佳实践规避它的弊端。希望这篇文章能帮助你在项目中更好地使用 Tailwind CSS,享受它带来的便利,同时避免踩坑!

如果你有更多关于 Tailwind CSS 的问题或经验分享,欢迎在评论区留言讨论! 😊

来源:juejin.cn/post/7484638486994681890

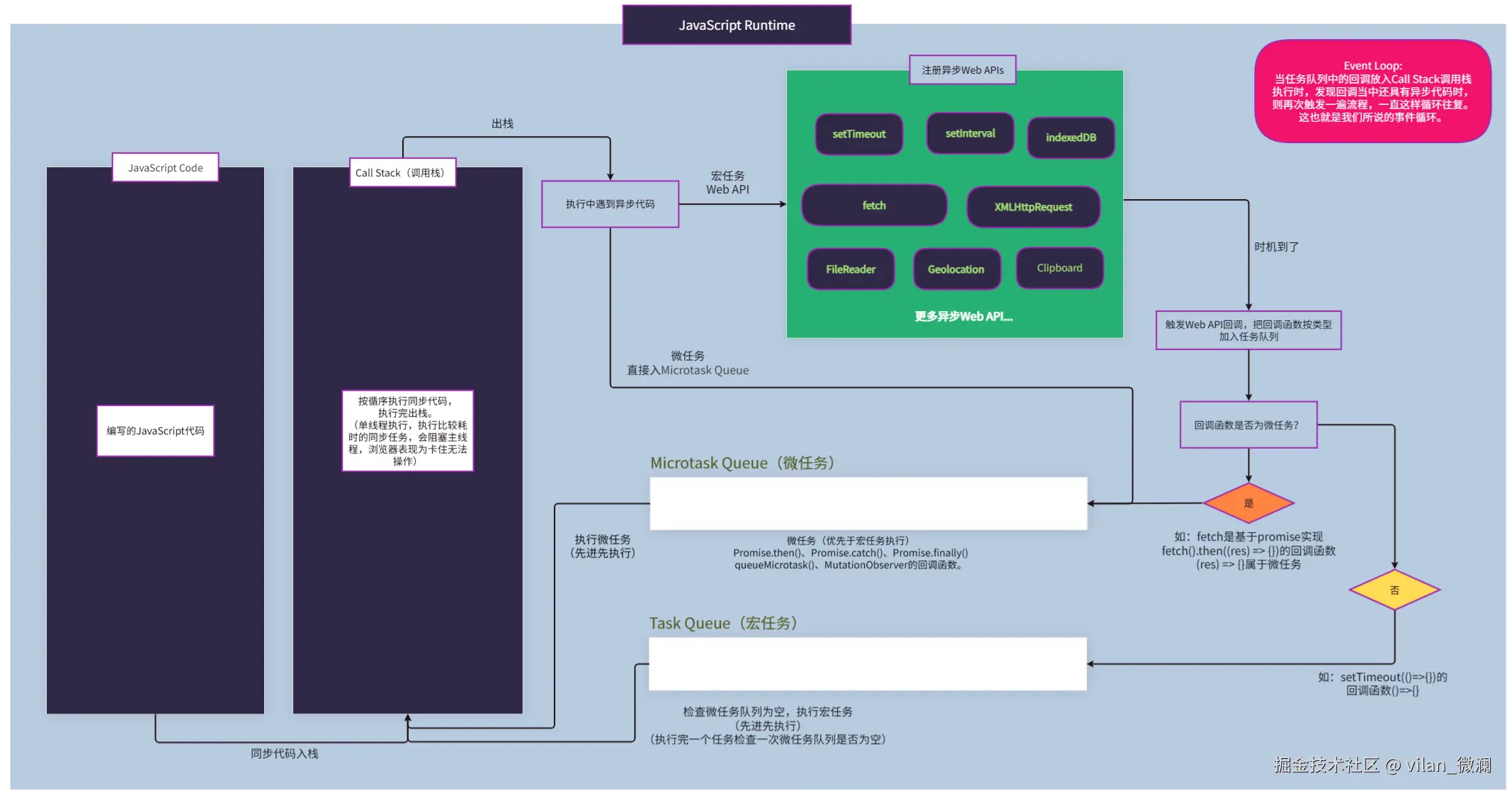

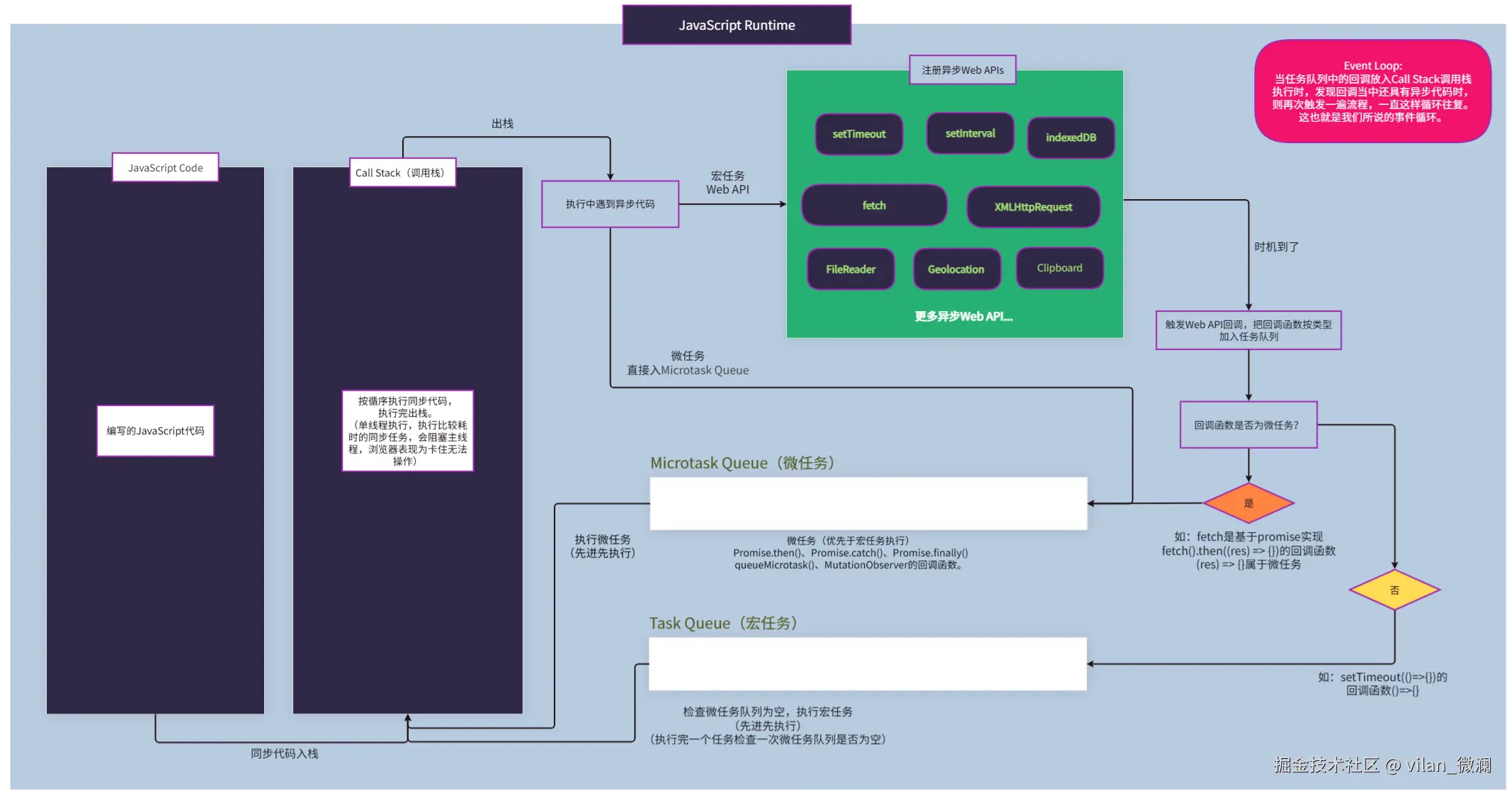

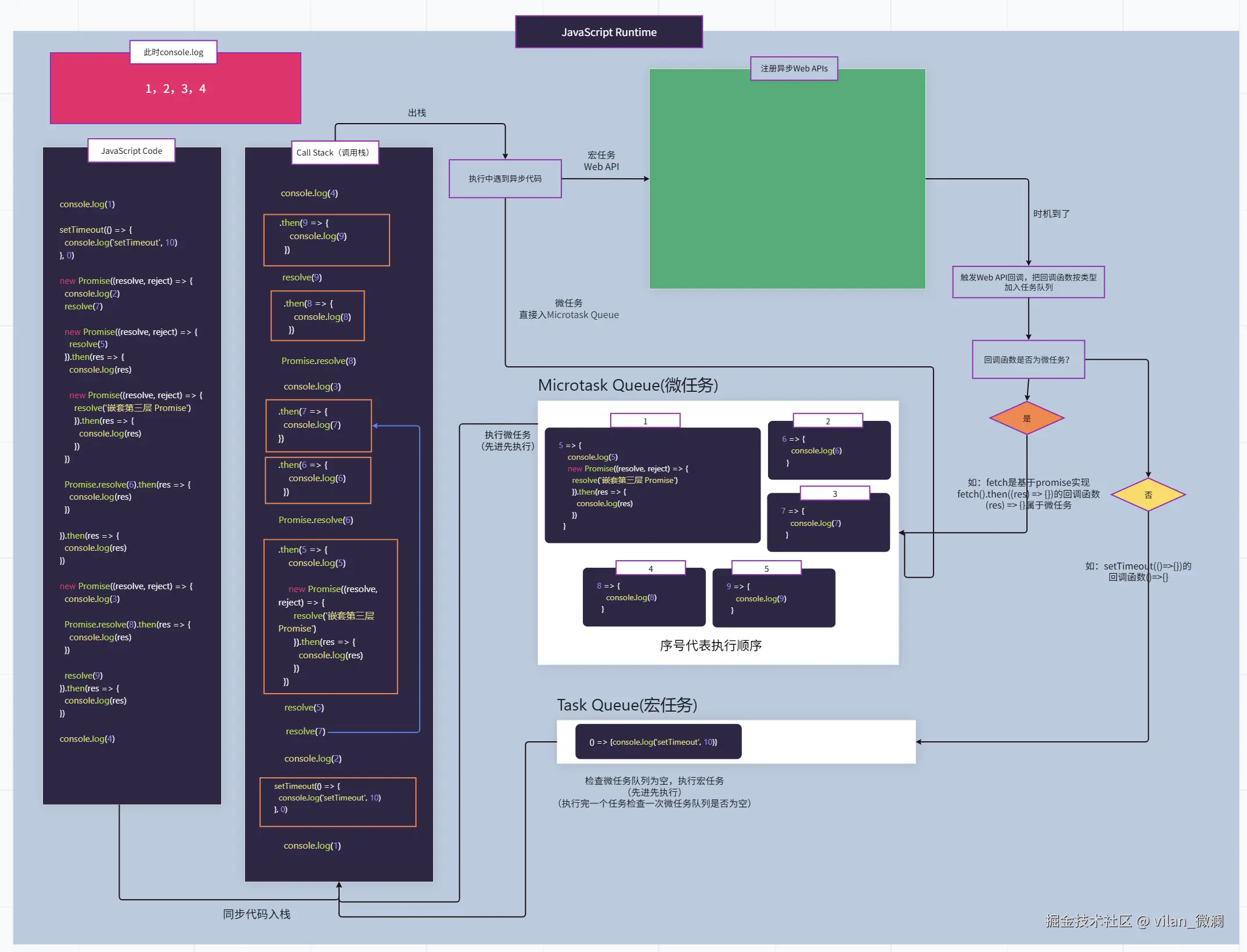

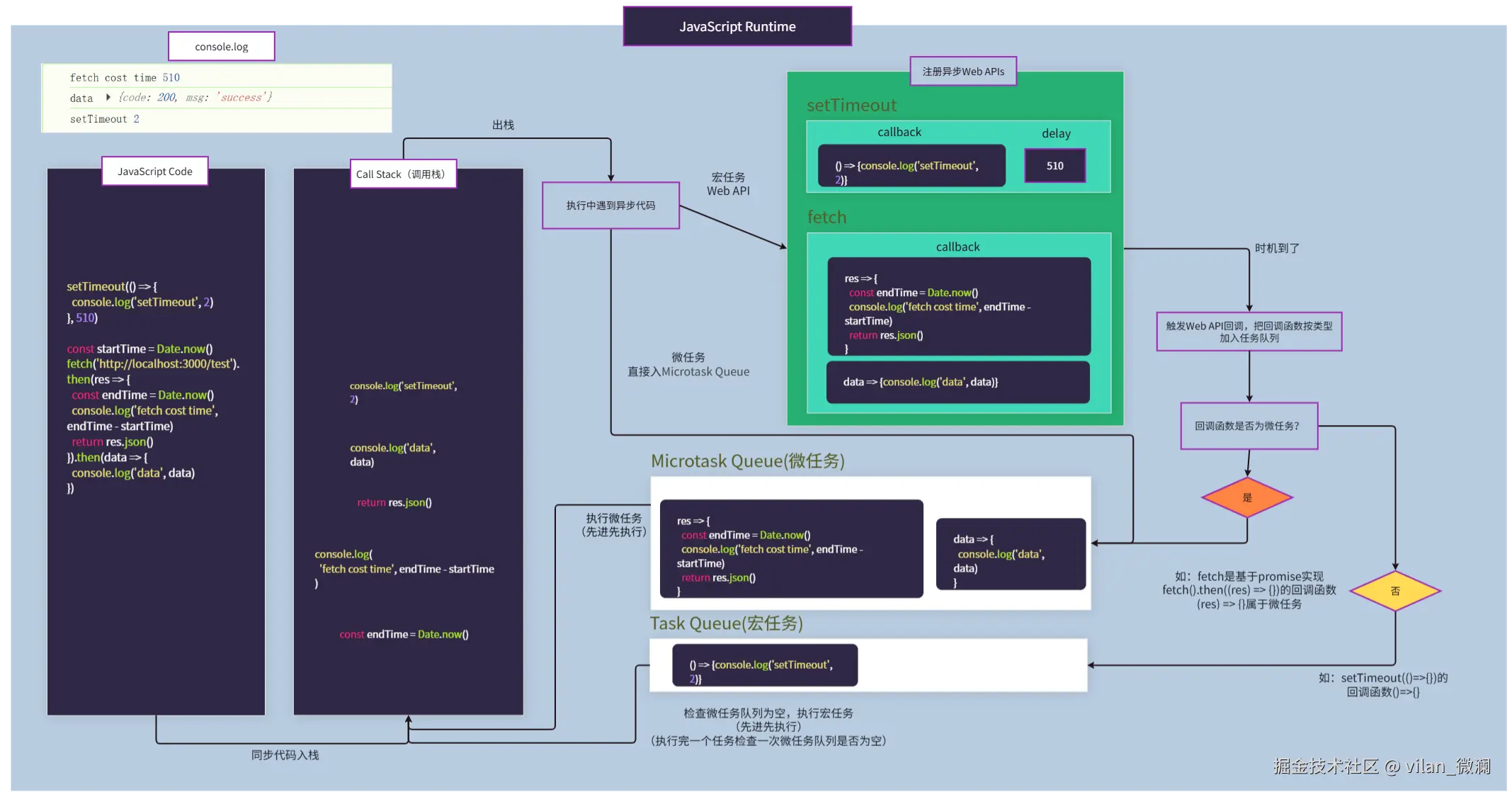

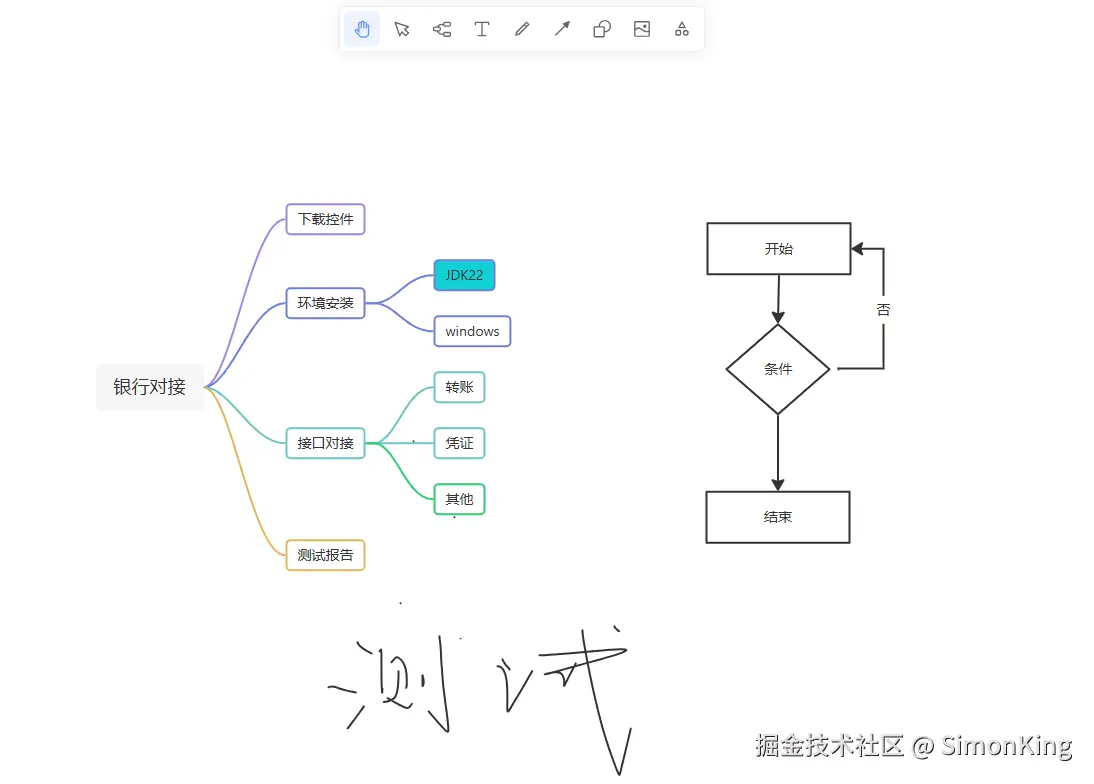

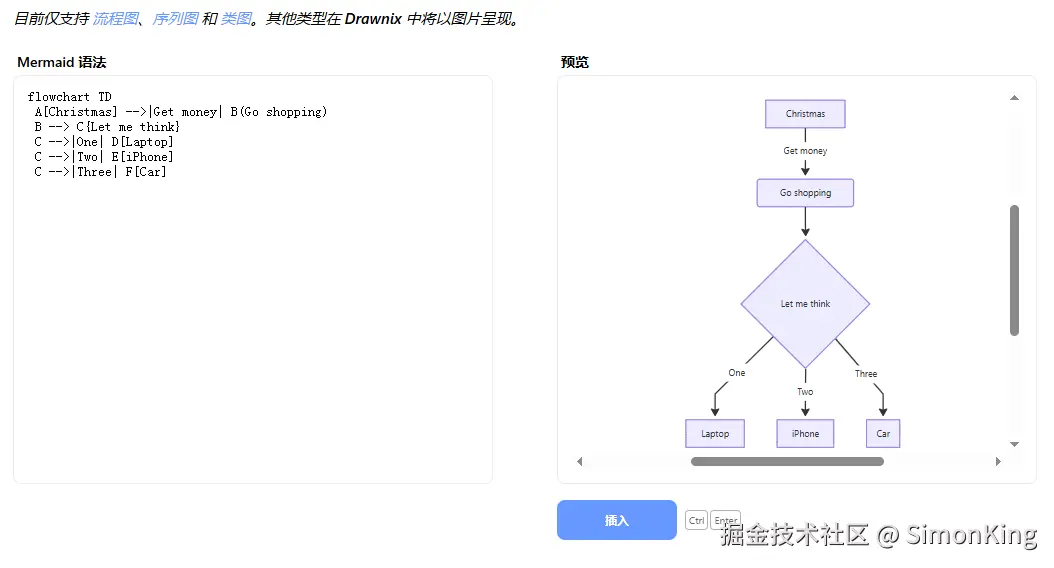

🔄一张图,让你再也忘不了浏览器的事件循环(Event Loop)了

一、前言

下面纯手工画了一张在浏览器执行JavaScript代码的Event Loop(事件循环) 流程图。

后文会演示几个例子,把示例代码放到这个流程图演示其执行流程。

当然,这只是简单的事件循环流程,不过,却能让我们快速掌握其原理。

下面纯手工画了一张在浏览器执行JavaScript代码的Event Loop(事件循环) 流程图。

后文会演示几个例子,把示例代码放到这个流程图演示其执行流程。

当然,这只是简单的事件循环流程,不过,却能让我们快速掌握其原理。

二、概念

事件循环是JavaScript为了处理单线程执行代码时,能异步地处理用户交互、网络请求等任务 (异步Web API),而设计的一套任务调度机制。它就像一个永不停止的循环,不断地检查(结合上图就是不断检查Task Queue和Microtask Queue这两个队列)并需要运行的代码。

事件循环是JavaScript为了处理单线程执行代码时,能异步地处理用户交互、网络请求等任务 (异步Web API),而设计的一套任务调度机制。它就像一个永不停止的循环,不断地检查(结合上图就是不断检查Task Queue和Microtask Queue这两个队列)并需要运行的代码。

三、为什么需要事件循环

JavaScript是单线程的,这意味着它只有一个主线程来执行代码。如果所有任务(比如一个耗时的计算、一个网络请求)都同步执行,那么浏览器就会被卡住,无法响应用户的点击、输入,直到这个任务完成。这会造成极差的用户体验。

事件循环就是为了解决这个问题而生的:它让耗时的操作(如网络请求、文件读取)在后台异步执行,等这些操作完成后,再通过回调的方式来执行相应的代码,从而不阻塞主线程。

JavaScript是单线程的,这意味着它只有一个主线程来执行代码。如果所有任务(比如一个耗时的计算、一个网络请求)都同步执行,那么浏览器就会被卡住,无法响应用户的点击、输入,直到这个任务完成。这会造成极差的用户体验。

事件循环就是为了解决这个问题而生的:它让耗时的操作(如网络请求、文件读取)在后台异步执行,等这些操作完成后,再通过回调的方式来执行相应的代码,从而不阻塞主线程。

四、事件循环流程图用法演示

演示一:小菜一碟

先来一个都是同步代码的小菜,先了解一下前面画的流程图是怎样在调用栈当中执行JavaScript代码的。

console.log(1)

function funcOne() {

console.log(2)

}

function funcTwo() {

funcOne()

console.log(3)

}

funcTwo()

console.log(4)

控制台输出:

1 2 3 4

下图为调用栈执行流程

每执行完一个同步任务会把该任务进行出栈。在这个例子当中每次在控制台输出一次,则进行一次出栈处理,直至全部代码执行完成。

先来一个都是同步代码的小菜,先了解一下前面画的流程图是怎样在调用栈当中执行JavaScript代码的。

console.log(1)

function funcOne() {

console.log(2)

}

function funcTwo() {

funcOne()

console.log(3)

}

funcTwo()

console.log(4)

控制台输出:

1 2 3 4

下图为调用栈执行流程

每执行完一个同步任务会把该任务进行出栈。在这个例子当中每次在控制台输出一次,则进行一次出栈处理,直至全部代码执行完成。

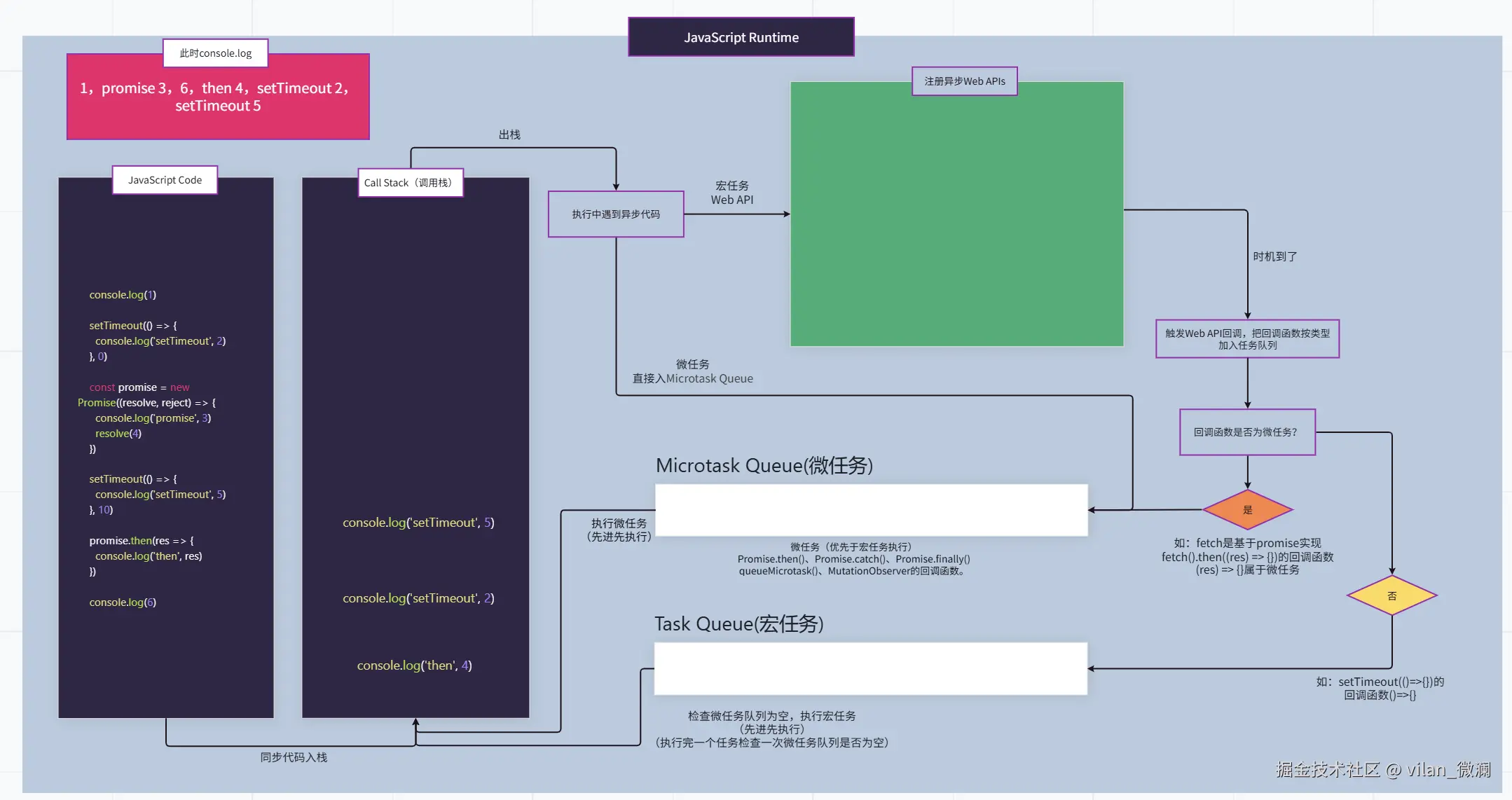

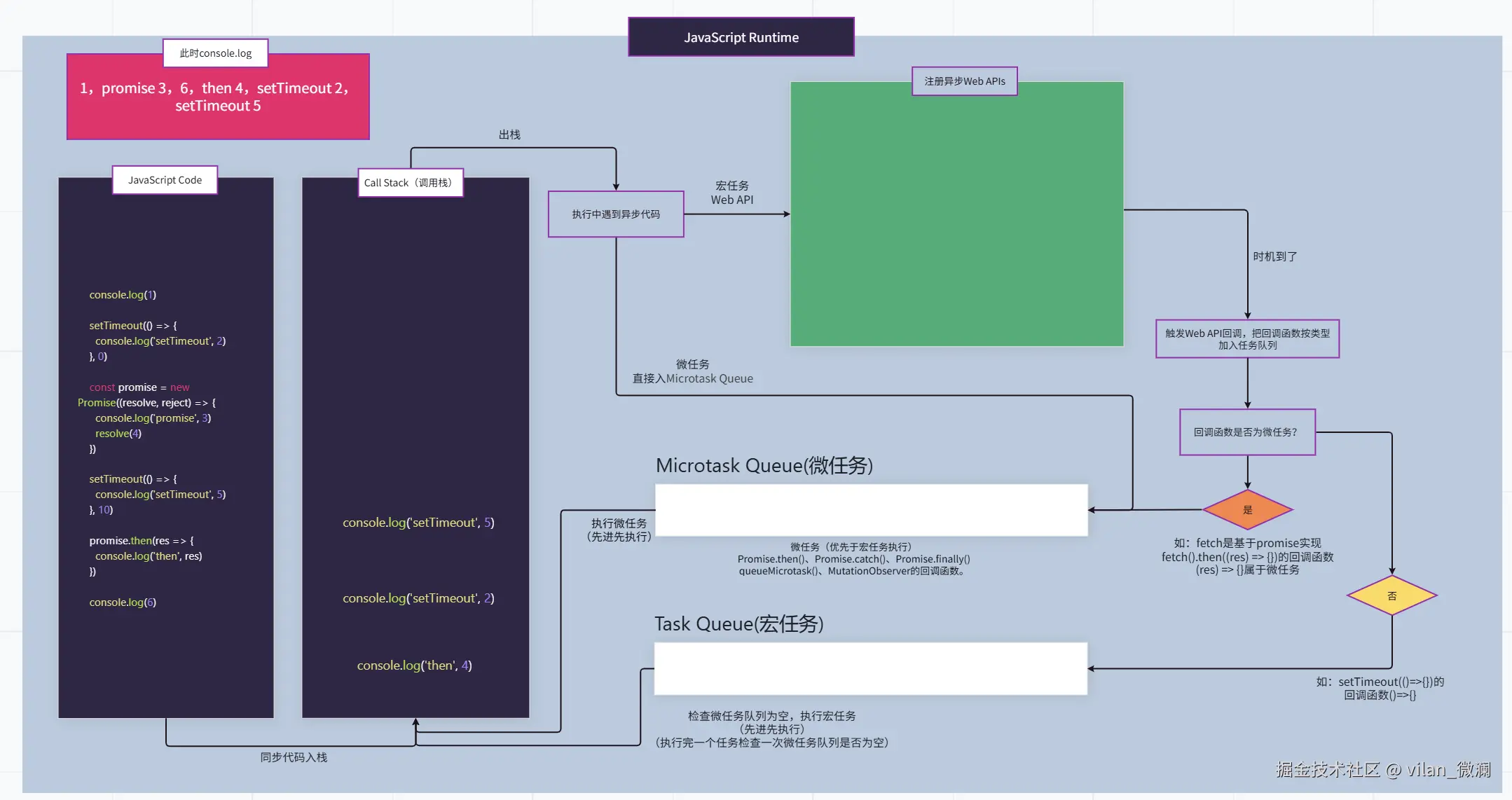

演示二:小试牛刀

setTimeout+Promise组合拳,了解异步代码是如何进入任务队列等待执行的。

console.log(1)

setTimeout(() => {

console.log('setTimeout', 2)

}, 0)

const promise = new Promise((resolve, reject) => {

console.log('promise', 3)

resolve(4)

})

setTimeout(() => {

console.log('setTimeout', 5)

}, 10)

promise.then(res => {

console.log('then', res)

})

console.log(6)

控制台输出:

1 promise 3 6 then 4 setTimeout 2 setTimeout 5

setTimeout+Promise组合拳,了解异步代码是如何进入任务队列等待执行的。

console.log(1)

setTimeout(() => {

console.log('setTimeout', 2)

}, 0)

const promise = new Promise((resolve, reject) => {

console.log('promise', 3)

resolve(4)

})

setTimeout(() => {

console.log('setTimeout', 5)

}, 10)

promise.then(res => {

console.log('then', res)

})

console.log(6)

控制台输出:

1 promise 3 6 then 4 setTimeout 2 setTimeout 5

流程图执行-步骤一:

先执行同步代码,如遇到异步代码,则把异步回调事件放到后台监听或对应的任务队列。

- 执行

console.log(1),控制台输出1。 - 执行定时器,遇到异步代码,后台注册定时器回调事件,时间到了,把回调函数

() => {console.log('setTimeout', 2)},放到宏任务队列等待。 - 执行创建

Promise实例,并执行其中同步代码:执行console.log('promise', 3),控制台输出promise 3;执行resolve(4),此时Promise已经确定为完成fulfilled状态,把promise.then()的回调函数响应值设为4。 - 执行定时器,遇到异步代码,后台注册定时器回调事件,时间未到,把回调函数

() => { console.log('setTimeout', 5) }放到后台监听。 - 执行

promise.then(res => { console.log('then', res) }),出栈走异步代码,把回调函数4 => { console.log('then', 4) }放入微任务队列等待。

先执行同步代码,如遇到异步代码,则把异步回调事件放到后台监听或对应的任务队列。

- 执行

console.log(1),控制台输出1。 - 执行定时器,遇到异步代码,后台注册定时器回调事件,时间到了,把回调函数

() => {console.log('setTimeout', 2)},放到宏任务队列等待。 - 执行创建

Promise实例,并执行其中同步代码:执行console.log('promise', 3),控制台输出promise 3;执行resolve(4),此时Promise已经确定为完成fulfilled状态,把promise.then()的回调函数响应值设为4。 - 执行定时器,遇到异步代码,后台注册定时器回调事件,时间未到,把回调函数

() => { console.log('setTimeout', 5) }放到后台监听。 - 执行

promise.then(res => { console.log('then', res) }),出栈走异步代码,把回调函数4 => { console.log('then', 4) }放入微任务队列等待。

流程图执行-步骤二:

上面已经把同步代码执行完成,并且把对应异步回调事件放到了指定任务队列,接下来开始事件循环。

- 扫描微任务队列,执行

4 => { console.log('then', 4) }回调函数,控制台输出then 4。 - 微任务队列为空,扫描宏任务队列,执行

() => {console.log('setTimeout', 2)}回调函数,控制台输出setTimeout 2。 - 每执行完一个宏任务,需要再次扫描微任务队列是否存在可执行任务(假设此时后台定时到了,则会把

() => { console.log('setTimeout', 5) }加入到了宏任务队列末尾)。 - 微任务队列为空,扫描宏任务队列,执行

() => { console.log('setTimeout', 5) },控制台输出setTimeout 5。

上面已经把同步代码执行完成,并且把对应异步回调事件放到了指定任务队列,接下来开始事件循环。

- 扫描微任务队列,执行

4 => { console.log('then', 4) }回调函数,控制台输出then 4。 - 微任务队列为空,扫描宏任务队列,执行

() => {console.log('setTimeout', 2)}回调函数,控制台输出setTimeout 2。 - 每执行完一个宏任务,需要再次扫描微任务队列是否存在可执行任务(假设此时后台定时到了,则会把

() => { console.log('setTimeout', 5) }加入到了宏任务队列末尾)。 - 微任务队列为空,扫描宏任务队列,执行

() => { console.log('setTimeout', 5) },控制台输出setTimeout 5。

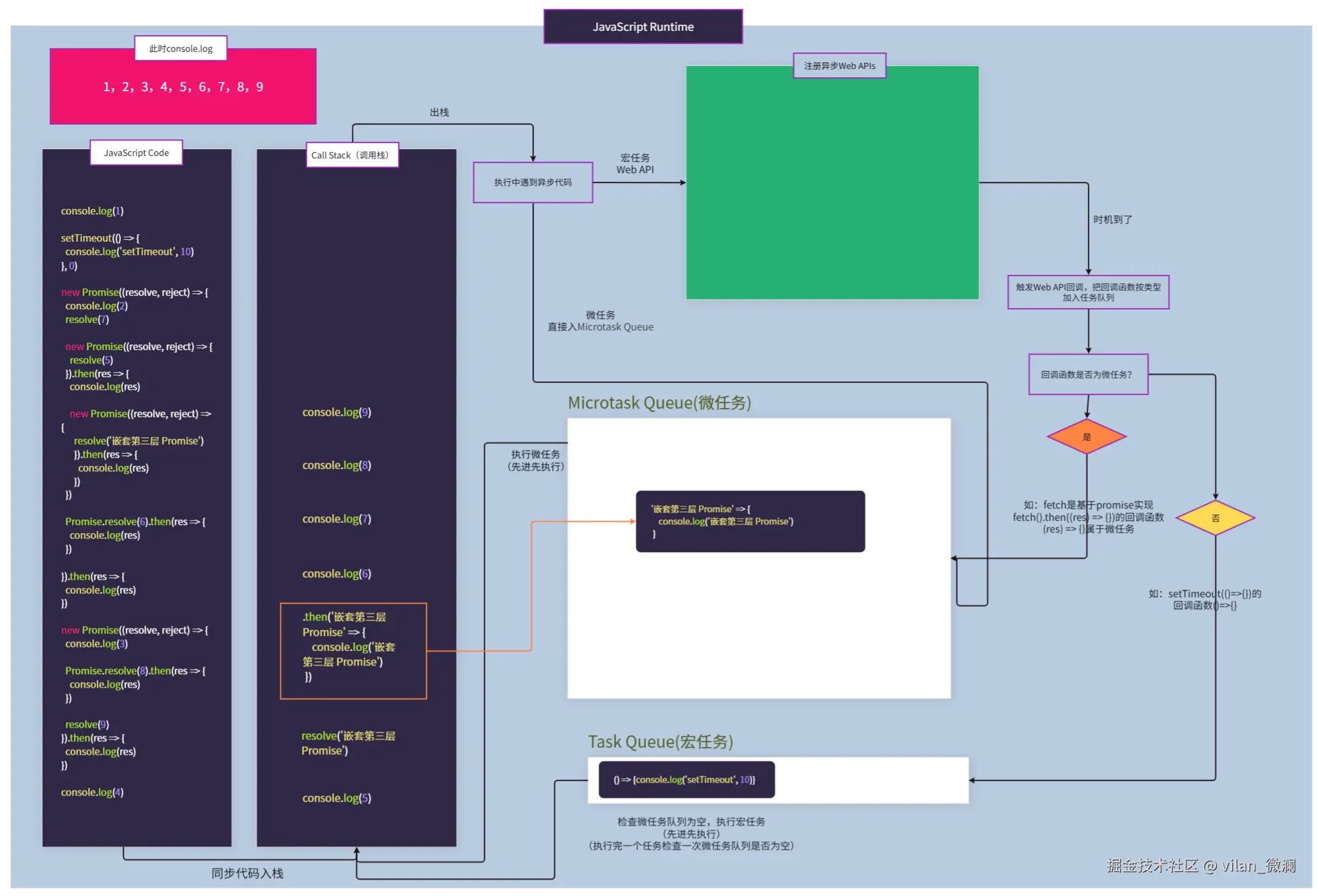

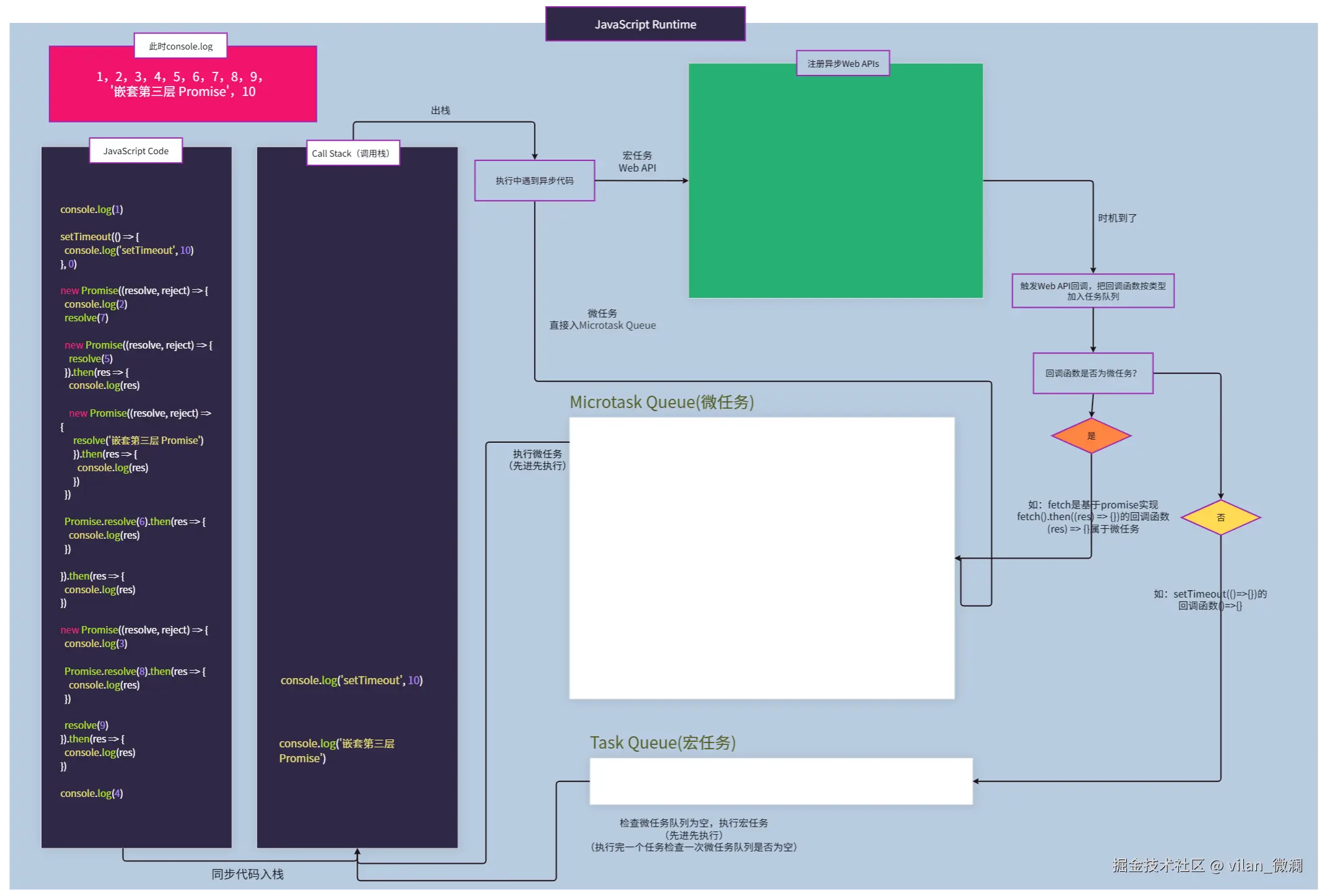

演示三:稍有难度

setTimeout+Promise组合拳+多层嵌套Promise

console.log(1)

setTimeout(() => {

console.log('setTimeout', 10)

}, 0)

new Promise((resolve, reject) => {

console.log(2)

resolve(7)

new Promise((resolve, reject) => {

resolve(5)

}).then(res => {

console.log(res)

new Promise((resolve, reject) => {

resolve('嵌套第三层 Promise')

}).then(res => {

console.log(res)

})

})

Promise.resolve(6).then(res => {

console.log(res)

})

}).then(res => {

console.log(res)

})

new Promise((resolve, reject) => {

console.log(3)

Promise.resolve(8).then(res => {

console.log(res)

})

resolve(9)

}).then(res => {

console.log(res)

})

console.log(4)

上一个演示说明了流程图执行的详细步骤,下面就不多加赘叙了,直接看图!

talk is cheap, show me the chart

上图,调用栈同步代码执行完成,开始事件循环,先看微任务队列,发现不为空,按顺序执行微任务事件:

上图,已经把刚才排队的微任务队列全部清空了。但是在执行第一个微任务时,发现还有嵌套微任务,则把该任务放到微任务队列末尾,然后接着一起执行完所有新增任务。

最后微任务清空后,接着执行宏任务。到此全部事件已执行完毕!

控制台完整输出顺序:

1 2 3 4 5 6 7 8 9 10

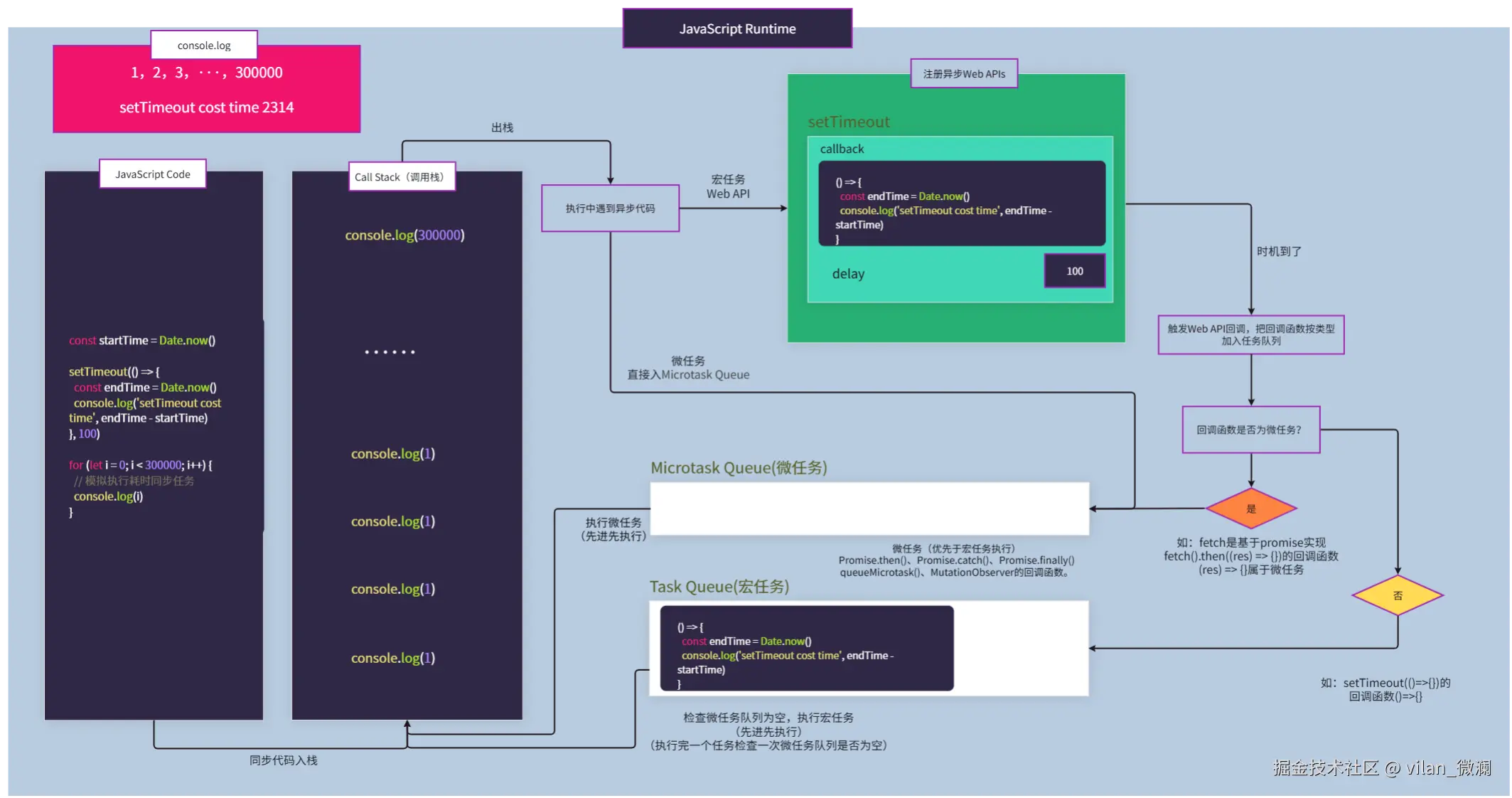

演示四:setTimeout伪定时

setTimeout并不是设置的定时到了就马上执行,而是把定时回调放在task queue任务队列当中进行等待,待主线程调用栈中的同步任务执行完成后空闲时才会执行。

const startTime = Date.now()

setTimeout(() => {

const endTime = Date.now()

console.log('setTimeout cost time', endTime - startTime)

// setTimeout cost time 2314

}, 100)

for (let i = 0; i < 300000; i++) {

// 模拟执行耗时同步任务

console.log(i)

}

控制台输出:

1 2 3 ··· 300000 setTimeout cost time 2314

下图演示了其执行流程:

演示五:fetch网络请求和setTimeout

获取网络数据,fetch回调函数属于微任务,优于setTimeout先执行。

setTimeout(() => {

console.log('setTimeout', 2)

}, 510)

const startTime = Date.now()

fetch('http://localhost:3000/test').then(res => {

const endTime = Date.now()

console.log('fetch cost time', endTime - startTime)

return res.json()

}).then(data => {

console.log('data', data)

})

下图当前Call Stack执行栈执行完同步代码后,由于fetch和setTimeout都是宏任务,所以走宏任务Web API流程后注册这两个事件回调,等待定时到后了,由于定时回调是个普通的同步函数,所以放到宏任务队列;等待fetch拿到服务器响应数据后,由于fetch回调为一个Promise对象,所以放到微任务队列。

经过多番刷新网页测试,下图控制台打印展示了setTimeout延时为510ms,fetch请求响应同样是510ms的情况下,.then(data => { console.log('data', data) })先执行了,也是由于fetch基于Promise实现,所以其回调为微任务。

五、结语

这可能只是简单的JavaScript代码执行事件循环流程,目的也是让大家更直观理解其中原理。实际执行过程可能还会读取堆内存获取引用类型数据、操作dom的方法,可能还会触发页面的重排、重绘等过程、异步文件读取和写入操作、fetch发起网络请求,与服务器建立连接获取网络数据等情况。

但是,它们异步执行的回调函数都会经过图中的这个事件循环过程,从而构成完整的浏览器事件循环。

来源:juejin.cn/post/7577395040592756746

单点登录:一次登录,全网通行

大家好,我是小悟。

- 想象一下你去游乐园,买了一张通票(登录),然后就可以玩所有项目(访问各个系统),不用每个项目都重新买票(重新登录)。这就是单点登录(SSO)的精髓!

SSO的日常比喻

- 普通登录:像去不同商场,每个都要查会员卡

- 单点登录:像微信扫码登录,一扫全搞定

- 令牌:像游乐园手环,戴着就能证明你买过票

下面用代码来实现这个"游乐园通票系统":

代码实现:简易SSO系统

import java.util.*;

// 用户类 - 就是我们这些想玩项目的游客

class User {

private String username;

private String password;

public User(String username, String password) {

this.username = username;

this.password = password;

}

// getters 省略...

}

// 令牌类 - 游乐园手环

class Token {

private String tokenId;

private String username;

private Date expireTime;

public Token(String username) {

this.tokenId = UUID.randomUUID().toString();

this.username = username;

// 令牌1小时后过期 - 游乐园晚上要关门的!

this.expireTime = new Date(System.currentTimeMillis() + 3600 * 1000);

}

public boolean isValid() {

return new Date().before(expireTime);

}

// getters 省略...

}

// SSO认证中心 - 游乐园售票处

class SSOAuthCenter {

private Map<String, Token> validTokens = new HashMap<>();

private Map<String, User> users = new HashMap<>();

public SSOAuthCenter() {

// 预先注册几个用户 - 办了年卡的游客

users.put("zhangsan", new User("zhangsan", "123456"));

users.put("lisi", new User("lisi", "abcdef"));

}

// 登录 - 买票入场

public String login(String username, String password) {

User user = users.get(username);

if (user != null && user.getPassword().equals(password)) {

Token token = new Token(username);

validTokens.put(token.getTokenId(), token);

System.out.println(username + " 登录成功!拿到游乐园手环:" + token.getTokenId());

return token.getTokenId();

}

System.out.println("用户名或密码错误!请重新买票!");

return null;

}

// 验证令牌 - 检查手环是否有效

public boolean validateToken(String tokenId) {

Token token = validTokens.get(tokenId);

if (token != null && token.isValid()) {

System.out.println("手环有效,欢迎继续玩耍!");

return true;

}

System.out.println("手环无效或已过期,请重新登录!");

validTokens.remove(tokenId); // 清理过期令牌

return false;

}

// 登出 - 离开游乐园

public void logout(String tokenId) {

validTokens.remove(tokenId);

System.out.println("已登出,欢迎下次再来玩!");

}

}

// 业务系统A - 过山车

class SystemA {

private SSOAuthCenter authCenter;

public SystemA(SSOAuthCenter authCenter) {

this.authCenter = authCenter;

}

public void accessSystem(String tokenId) {

System.out.println("=== 欢迎来到过山车 ===");

if (authCenter.validateToken(tokenId)) {

System.out.println("过山车启动!尖叫声在哪里!");

} else {

System.out.println("请先登录再玩过山车!");

}

}

}

// 业务系统B - 旋转木马

class SystemB {

private SSOAuthCenter authCenter;

public SystemB(SSOAuthCenter authCenter) {

this.authCenter = authCenter;

}

public void accessSystem(String tokenId) {

System.out.println("=== 欢迎来到旋转木马 ===");

if (authCenter.validateToken(tokenId)) {

System.out.println("木马转起来啦!找回童年记忆!");

} else {

System.out.println("请先登录再玩旋转木马!");

}

}

}

// 测试我们的SSO系统

public class SSODemo {

public static void main(String[] args) {

// 创建认证中心 - 游乐园大门

SSOAuthCenter authCenter = new SSOAuthCenter();

// 张三登录

String token = authCenter.login("zhangsan", "123456");

if (token != null) {

// 拿着同一个令牌玩不同项目

SystemA systemA = new SystemA(authCenter);

SystemB systemB = new SystemB(authCenter);

systemA.accessSystem(token); // 玩过山车

systemB.accessSystem(token); // 玩旋转木马

// 登出

authCenter.logout(token);

// 再尝试访问 - 应该被拒绝

systemA.accessSystem(token);

}

// 测试错误密码

authCenter.login("lisi", "wrongpassword");

}

}

运行结果示例:

zhangsan 登录成功!拿到游乐园手环:a1b2c3d4-e5f6-7890-abcd-ef1234567890

=== 欢迎来到过山车 ===

手环有效,欢迎继续玩耍!

过山车启动!尖叫声在哪里!

=== 欢迎来到旋转木马 ===

手环有效,欢迎继续玩耍!

木马转起来啦!找回童年记忆!

已登出,欢迎下次再来玩!

=== 欢迎来到过山车 ===

手环无效或已过期,请重新登录!

请先登录再玩过山车!

用户名或密码错误!请重新买票!

总结一下:

单点登录就像:

- 一次认证,处处通行 🎫

- 不用重复输入密码 🔑

- 安全又方便 👍

好的SSO系统就像好的游乐园管理,既要让游客玩得开心,又要确保安全!

谢谢你看我的文章,既然看到这里了,如果觉得不错,随手点个赞、转发、在看三连吧,感谢感谢。那我们,下次再见。

您的一键三连,是我更新的最大动力,谢谢

山水有相逢,来日皆可期,谢谢阅读,我们再会

我手中的金箍棒,上能通天,下能探海

来源:juejin.cn/post/7577599015426228259

别让认知天花板,变成你的职业终点——技术人如何走出信息茧房

我们都活在自己编织的真相里吗?

最近参加了两位前端同事的转正答辩。他们的总结都很真诚,也很努力,但两人之间那种微妙的认知落差,却让我久久不能平静。

第一位同事踏实勤恳,技术中规中矩,对自己的评价也相对保守。他清楚自己的短板,也知道自己需要提升,但他把改变的希望寄托在别人身上——希望有人来指导他、推动他。可实际上,他并没有拿出具体的行动或方案。没有外力,他似乎就只能停在原地。看着他,我忽然想起几年前的自己:是不是也曾这样,一边焦虑,一边等待别人来拯救?

第二位同事则完全不同。他自信满满,言谈间流露出对自身能力的高度认可,甚至认为自己已经达到了“高级工程师”的水平。他在团队协作、沟通表达上也自认表现优异,列举了不少“高光时刻”。但当我站在更高的视角去看这些“成果”时,却感到一种强烈的错位——他的“高级”,建立在一个极其有限的认知框架之上。

他对跨团队协作的理解,停留在“配合顺畅”;对技术深度的衡量,止步于“功能能跑”。他看不到系统设计中的耦合隐患,意识不到架构演进背后的权衡逻辑,更缺乏对业务本质的追问。

那一刻我突然明白:一个人最深的局限,往往不是能力不足,而是根本不知道自己不知道。

而更令人警觉的是,这种认知盲区,并非个例。它像一层透明的茧,包裹着我们每一个人。我们常称之为“信息茧房”,但或许更准确的说法是:认知茧房。

被这个时代悄悄做局了

我们生活在一个信息爆炸的时代,但获取信息的方式,却被前所未有地“驯化”了。

算法精准推送你喜欢的内容,社交圈层不断强化你已有的观点,搜索引擎只呈现你愿意相信的答案。你读的每一篇文章、看的每一段视频、加入的每一个群聊,都在悄悄加固这层茧。

久而久之,我们开始相信:

- 我看到的就是真实的世界;

- 我认同的就是正确的道理;

- 我周围人的共识就是普世的价值。

于是,偏执悄然滋生。我们变得难以倾听异见,习惯性地把不同声音归为“愚蠢”或“别有用心”。沟通不再是交换思想,而成了立场的对抗。我们活在由自己偏好构建的“回音室”里,每一次回响都让我们更加确信:我没错,错的是世界。

那位自认“高级”的同事,问题不在技术本身,而在于他无法感知更高维度的存在。他没见过真正的系统复杂性,没经历过技术债务的反噬,也没体会过从0到1推动变革的艰难。他的“高级”,只是井底之蛙眼中的天空。

偏听则暗,兼听则明

信息茧房最危险的地方,在于它让人变得偏执。偏执的人很难沟通,再加上“傻子共振效应”(相似认知的人互相强化),整个世界的理解就越来越狭隘。

在这个被算法投喂的时代,你看到的,都是你想看的;你喜欢的,也被不断推给你。这不断强化你的认知,形成你的价值观,同时也压缩了你的视野、削弱了你的思辨能力,最终让你陷入一个自我闭环的逻辑牢笼。

你开始以为自己了解世界的运作原理,甚至以为自己看清了本质。但最致命的是——你不觉得自己被局限了。

我不禁反思:

我知道的,是不是错的?

我是不是也在自我麻痹?

我是不是一只井底之蛙,而我身边的人,也都是井底之蛙?我们彼此认同,形成联盟,却浑然不觉自己被困在同一个井里。

更可怕的是,这种“共识”会让我们坚信:我们不在茧房里。

睁眼看世界,看到的未必是真实

你看到的世界,可能是别人想让你看到的,也可能是你自己想让自己看到的。你可能并不知道真实的世界是什么样,但你以为你知道。

如今的大数据和智能推荐,正不断按照你的喜好,一层层加固你的信息茧房。人类的惰性,又被海量信息投喂成“奶头乐”——不加思考,被动消费,逐渐沦为信息时代的消费品。

当然,我写下这些,也可能带着某种激进甚至偏激。但正因如此,才更要停下来问一问:

我是否也陷在这样的焦油坑里?

我是不是也自以为是、固步自封?

是不是只听自己想听的,只信自己愿意信的?

是不是被网络言论洗脑,被算法圈套套牢?

我常常做一些自以为不错的事,但别人可能完全不会那样做。这提醒我:我的“正确”,未必是世界的尺度。

不要被无意义的信息重塑价值观。真正的出路,必须从内在出发。

认知决定你能活出怎样的人生

我们常说:“人赚不到认知以外的钱。”其实这句话可以更广义地理解为:人活不出认知以外的人生。

你的决策、判断、人际关系、职业发展,甚至对幸福的定义,都被你当下的认知边界框定。如果你的认知是扁平的、片面的、情绪化的,那么无论多努力,你也只能在同一个维度里打转。

要破局,第一步是承认自己被困住了。

这不是自我否定,而是一种清醒的自知。真正的成长,始于一个简单的念头:

“这样是不是太受限了?”

这个念头,就是打破茧房的第一道裂痕。

如何让裂痕扩大,直至破茧?

主动“反向输入”:让异见成为养分

不要只读你认同的书,只听你支持的声音。刻意去接触那些让你不适的观点:

- 读一本政治立场与你对立的作者写的书;

- 看一部挑战你价值观的纪录片;

- 和一个你平时不会交往的人深入聊一次天。

重点不是说服对方,而是理解:他为什么这么想?

拓展“认知半径”:走出同类人的圈子

你周围的人,往往和你有相似的背景、价值观和信息来源。这种“同温层”会不断强化你的既有认知。试着去接触:

- 不同行业的人(比如医生、教师、手艺人);

- 不同年龄段的人(年轻人的焦虑,老人的智慧);

- 不同文化背景的人(你会发现,很多你视为“理所当然”的事,在别处根本不存在)。

成年后,我们的圈子越来越小,思维越来越固化。这时候,更需要主动打破圈层的束缚。

3保持“空杯心态”:允许自己被推翻

最可怕的不是无知,而是以为自己知道。定期问自己:

- 我三年前相信什么?现在还信吗?

- 如果我现在的观点是错的,世界会是什么样子?

- 有没有可能,我引以为傲的“成就”,其实只是低水平的重复?

这种自我质疑,不是自我贬低,而是一种精神上的“排毒”。

站在更高的维度看问题

当我开始带团队后,才发现下属的问题会暴露无遗。这也反过来提醒我:站得更高,才能看得更清。

或许我们永远无法抵达“全知”的境界,但至少可以仰望星空。

写到这里,我也在警惕:

这会不会是另一种“认知优越感”?

我是否也在用“破茧”的叙事,构建一个新的茧?

很可能。

但关键不在于是否彻底摆脱茧房——那几乎不可能——而在于是否保有觉察和挣扎的意愿。

我们无法看到全貌,但可以努力多转几个角度;

我们无法摆脱偏见,但可以学会与之共处并保持警惕;

我们可能永远都是井底之蛙,但至少可以抬头,看看那圈之外,是否还有星光。

或许,我们永远无法完全摆脱茧房

这个世界越来越复杂,而我们的认知工具却未必同步进化。

算法在固化我们,信息在淹没我们,社交在同化我们。

但人之所以为人,正是因为我们有反思的能力,有超越当下的渴望。

不必追求绝对的“正确”,也不必幻想彻底的“觉醒”。

只需在每一个自以为是的瞬间,轻轻问一句:

“我是不是,又忘了抬头?”

认知的破局,不在远方,就在此刻的怀疑与开放之中

来源:juejin.cn/post/7580592190020517922

老板:能不能别手动复制路由了?我:写个脚本自动扫描

起因

周五快下班,老板过来看权限配置页面。

"这个每次都要手动输路径?"

"对,现在是这样。"我打开给他看:

角色:运营专员

路由路径:[手动输入] /user/list

组件路径:[手动输入] @/views/user/List.vue

"上次运营配错了,/user/list 写成 /user/lists,页面打不开找了半天。能不能做个下拉框,直接选?"

我想了想:"可以,但得先有个页面列表。"

"那就搞一个,现在页面这么多,手动输容易出错。"

确实,项目现在几十个页面,每次配置权限都要翻代码找路径,复制粘贴,还担心复制错。

解决办法

周末琢磨了一下,其实就是缺个"页面清单"。views 目录下都是页面文件,扫描一遍不就有了?

写了个 Node 脚本,自动扫描 views 目录,生成路由映射表。配置权限的时候下拉框选,还能搜索。

实现

两步:扫描文件 + 生成映射。

扫描 .vue 文件

function getAllVueFiles(dir, filesList = []) {

const files = fs.readdirSync(dir);

files.forEach((file) => {

const filePath = path.join(dir, file);

if (fs.statSync(filePath).isDirectory()) {

getAllVueFiles(filePath, filesList); // 递归子目录

} else if (file.endsWith(".vue")) {

filesList.push(filePath); // 收集 .vue 文件

}

});

return filesList;

}

生成映射文件

function start() {

const viewsDir = path.resolve(__dirname, "../views");

let files = getAllVueFiles(viewsDir);

// 兼容 Windows 路径

files = files.map(item => item.replace(/\\/g, "/"));

// 拼接成 import 映射

let str = "";

files.forEach(item => {

let n = item.replace(/.*src\//, "@/");

str += `"${n}":()=>import("${n}"),\r\n`;

});

// 写入文件

fs.writeFileSync(

path.resolve(__dirname, "../router/all.router.js"),

`export const ROUTERSDATA = {\n${str}}`

);

}

最后生成的文件大概是这样:

// src/router/all.router.js

export const ROUTERSDATA = {

"@/views/Home.vue": () => import("@/views/Home.vue"),

"@/views/About.vue": () => import("@/views/About.vue"),

"@/views/user/List.vue": () => import("@/views/user/List.vue"),

}

怎么用

权限配置页面

<template>

<el-select

v-model="selectedRoute"

filterable

placeholder="搜索并选择页面">

<el-option

v-for="(component, path) in ROUTERSDATA"

:key="path"

:label="path"

:value="path">

{{ path }}

</el-option>

</el-select>

</template>

<script setup>

import { ROUTERSDATA } from '@/router/all.router.js'

// 后台返回的权限路由配置

const permissionRoutes = [

{ path: '/user/list', component: '@/views/user/List.vue' },

{ path: '/order/list', component: '@/views/order/List.vue' }

]

// 直接从映射表取组件

const routes = permissionRoutes.map(route => ({

path: route.path,

component: ROUTERSDATA[route.component] // 这里直接用

}))

</script>

好处:

- 下拉框自动包含所有页面

- 支持搜索,输入 "user" 就能找到所有用户相关页面

- 新加页面自动出现在列表里

动态路由

后台返回权限配置,前端从映射表取组件:

function generateRoutes(backendConfig) {

return backendConfig.map(item => ({

path: item.path,

component: ROUTERSDATA[item.component] // 直接用

}))

}

效果

周一把代码提上去,改了权限配置页面:

<!-- 配置页面 -->

<el-select v-model="route" filterable placeholder="搜索页面">

<el-option

v-for="(component, path) in ROUTERSDATA"

:key="path"

:label="path"

:value="path" />

</el-select>

老板过来试了一下,在下拉框输入 "user" 就搜到所有用户相关页面。

"嗯,这个好用。新加页面也会自动出现在这里吧?"

"对,每次启动项目会自动扫描。"

"行,那就这样。"

后来发现还有些意外收获:

- 新人看这个映射表就知道项目有哪些页面

- 后台只存路径字符串,数据库干净

- 顺带解决了手动 import 几十个路由的问题

在 package.json 加个脚本:

{

"scripts": {

"dev": "node src/start/index.js && vite"

}

}

每次 npm run dev 会先扫描 views 目录,生成最新的映射表。

完整代码

// src/start/index.js

const fs = require("fs");

const path = require("path");

function getAllVueFiles(dir, filesList = []) {

const files = fs.readdirSync(dir);

files.forEach((file) => {

const filePath = path.join(dir, file);

const stat = fs.statSync(filePath);

if (stat.isDirectory()) {

getAllVueFiles(filePath, filesList);

} else if (file.endsWith(".vue")) {

filesList.push(filePath);

}

});

return filesList;

}

function start() {

console.log("[自动获取全部可显示页面]");

const viewsDir = path.resolve(__dirname, "../views");

let files = getAllVueFiles(viewsDir);

// 统一路径分隔符,兼容 Windows 反斜杠

files = files.map((item) => item.replace(/\\/g, "/"));

let str = "";

// 构造 import 映射:"@/views/xxx.vue": ()=>import("@/views/xxx.vue")

files.forEach((item) => {

let n = item.replace(/.*src\//, "@/");

str += `"${n}":()=>import("${n}"),\r\n`;

});

const routerFilePath = path.resolve(__dirname, "../router/all.router.js");

// 将映射写入路由聚合文件,供路由动态引用

fs.writeFileSync(

routerFilePath,

`

export const ROUTERSDATA = {

${str}

}`,

);

console.log("[./src/router/all.router.js 写入]");

}

start();

注意事项

记得把生成的 src/router/all.router.js 加到 .gitignore,毕竟是自动生成的文件,没必要提交。

# .gitignore

src/router/all.router.js

后来

用了一个多月,运营配置权限再也没出过错。上周老板说:"这个功能不错,其他项目也加上。"

代码其实挺简单的,但确实解决了问题。

来源:juejin.cn/post/7582808491583504420

进入外包,我犯了所有程序员都会犯的错!

前言

前些天有位小伙伴和我吐槽他在外包工作的经历,语气颇为激动又带着深深的无奈。

本篇以他的视角,进入他的世界,看看这一段短暂而平凡的经历。

1. 上岸折戟尘沙

本人男,安徽马鞍山人士,21年毕业于江苏某末流211,在校期间转码。

上网课期间就向往大城市,于是毕业后去了深圳,找到了一家中等IT公司(人数500+)搬砖,住着宝安城中村,来往繁华南山区。

待了三年多,自知买房变深户无望,没有归属感,感觉自己也没那么热爱技术,于是乎想回老家考公务员,希望待在宇宙的尽头。

24年末,匆忙备考,平时工作忙里偷闲刷题,不出所料,笔试卒,梦碎。

2. 误入外包

复盘了备考过程,觉得工作占用时间过多,想要找一份轻松点且离家近的工作,刚好公司也有大礼包的指标,于是主动申请,辞别深圳,前往徽京。

Boss上南京的软件大部分是外包(果然是外包之都),前几年外包还很活跃,这些年外包都沉寂了不少,找了好几个月,断断续续有几个邀约,最后实在没得选了,想着反正就过渡一下挣点钱不寒碜,接受了外包,作为WX服务某为。薪资比在深圳降了一些,在接受的范围内。

想着至少苟着等待下一次考公,因此前期做项目比较认真,遇到问题追根究底,为解决问题也主动加班加点,同为WX的同事都笑话我说比自有员工还卷,我却付之一笑。

直到我经历了几件事,正所谓人教人教不会,事教人一教就会。

3. 我在外包的二三事

有一次,我提出了自有员工设计方案的衍生出的一个问题,并提出拉个会讨论一下,他并没有当场答应,而是回复说:我们内部看看。

而后某天我突然被邀请进入会议,聊了几句,意犹未尽之际,突然就被踢出会议...开始还以为是某位同事误触按钮,然后再申请入会也没响应。

后来我才知道,他们内部商量核心方案,因为权限管控问题,我不能参会。

这是我第一次体会到WX和自有员工身份上的隔阂。

还有一次和自有员工一起吃饭的时候,他不小心说漏嘴了他的公积金,我默默推算了一下他的工资至少比我高了50%,而他的毕业院校、工作经验和我差不多,瞬间不平衡了。

还有诸如其它的团建、夜宵、办公权限、工牌等无一不是明示着你是外包员工,要在外包的规则内行事。

至于转正的事,头上还有OD呢,OD转正的几率都很低,好几座大山要爬呢,别想了。

3. 反求诸己

以前网上看到很多吐槽外包的帖子,还总觉得言过其实,亲身经历了才刻骨铭心。

我现在已经摆正了心态,既来之则安之。正视自己WX的身份,给多少钱干多少活,给多少权利就承担多少义务。

不攀比,不讨好,不较真,不内耗,不加班。

另外每次当面讨论的时候,我都会把工牌给露出来,潜台词就是:快看,我就是个外包,别为难我😔~

另外我现在比较担心的是:

万一我考公还是失败,继续找工作的话,这段外包经历会不会是我简历的污点😢

当然这可能是我个人感受,其它外包的体验我不知道,也不想再去体验了。

对,这辈子和下辈子都不想了。

附南京外包之光,想去或者不想去的伙伴可以留意一下:

来源:juejin.cn/post/7511582195447824438

为什么 SVG 能在现代前端中胜出?

如果你关注前端图标的发展,会发现一个现象:

过去前端图标主要有三种方案:

- PNG 小图(配合雪碧图)

- Iconfont

- SVG

到了今天,大部分中大型项目都把图标系统全面迁移到 SVG。

无论 React/Vue 项目、新框架(Next/Remix/Nuxt),还是大厂的设计规范(Ant Design、Material、Carbon),基本都默认 SVG。

为什么是 SVG 胜出?

为什么不是 Iconfont、不是独立 PNG、不是雪碧图?

答案不是一句“清晰不失真”这么简单。

下面从前端实际开发的角度,把 SVG 胜出的原因讲透。

一、SVG 为什么比位图(PNG/JPG)更强?

① 矢量图永不失真(核心优势)

PNG/JPG 是位图,只能按像素存图。

移动端倍率屏越来越高(2x、3x、4x……),一张 24px 的 PNG 在 iPhone 高分屏里可能看起来糊成一团。

SVG 是矢量图,数学计算绘制:

- 任意缩放不糊

- 任意清晰度场景都不怕

- 深色模式也不会变形

这点直接解决了前端图标领域长期存在的一个痛点:适配成本太高。

② 体积小、多级复用不浪费

同样一个图标:

- PNG 做 1x/2x/3x 需要三份资源

- SVG 只要一份

而且:

- SVG 本质是文本

- gzip 压缩非常有效

在 CDN 下,通常能压到个位数 KB,轻松复用。

③ 图标换色非常容易

PNG 改颜色很麻烦:

- 设计师改

- 重新导出

- 重新上传/构建

Iconfont 的颜色只能统一,只能覆盖轮廓颜色,多色很麻烦。

SVG 则非常灵活:

.icon {

fill: currentColor;

}

可以跟随字体颜色变化,支持 hover、active、主题色。

深浅模式切换不需要任何额外资源。

④ 支持 CSS 动画、交互效果

SVG 不只是图标文件,它是 DOM,可以直接加动画:

- stroke 动画

- 路径绘制动画

- 颜色渐变

- hover 发光

- 多段路径动态控制

PNG 和 Iconfont 都做不到这种级别的交互。

很多现代 UI 的微动效(Loading、赞、收藏),都是基于 SVG 完成。

二、SVG 为什么比 iconfont 更强?

Iconfont 在 2015~2019 年非常火,但明显已经退潮了。

原因有以下几个:

① 字体图标本质是“字符”而不是图形

这带来大量问题:

● 不能多色

只能 monochrome,彩色图标很难实现。

● 渲染脆弱

在 Windows 某些字体渲染环境下会出现:

- 发虚

- 锯齿

- baseline 不一致

● 字符冲突

不同项目的字体图标可能互相覆盖。

相比之下,SVG 是独立图形文件,没有这些问题。

② iconfont 需要加载字体文件,失败会出现“乱码方块”

如果字体文件没加载成功,你会看到:

☐ ☐ ☐ ☐

这在弱网、支付类页面、海外环境都非常常见。

SVG 就没有这个风险。

③ iconfont 不利于按需加载

字体文件通常包含几十甚至几百个图标:

一次加载很重,不够精细。

SVG 可以做到按需加载:

- 一个组件一个 SVG

- 一个页面只引入用到的部分

- 可组合、可动态切换

对于现代构建体系非常友好。

三、SVG 为什么比“新版雪碧图”更强?

即便抛开 iconfont,PNG 雪碧图也完全被淘汰。

原因很简单:

- 雪碧图文件大

- 缓存粒度差

- 不可按需加载

- 维护复杂

- retina 适配麻烦

- 颜色不可动态变更

而 SVG 天生具备现代开发所需的一切特性:

- 轻量化

- 组件化

- 可变色

- 可动画

- 可 inline

- 可自动 tree-shaking

雪碧图本质上是为了“减少请求数”而生的产物,

但在 HTTP/2/3 中已经没有价值。

而 SVG 不是 hack,而是自然适配现代 Web 的技术方案。

四、SVG 为什么能在工程体系里更好地落地?

现代构建工具(Vite / Webpack / Rollup)原生支持 SVG:

- 转组件

- 优化路径

- 压缩

- 自动雪碧(symbol sprite)

- Tree-shaking

- 资源分包

这让 SVG 完全融入工程体系,而不是外挂方案。

例如:

import Logo from './logo.svg'

你可以:

- 当组件使用

- 当资源下载

- 当背景图

- 动态注入

工程化友好度是它胜出的关键原因之一。

五、SVG 胜出的根本原因总结

不是 SVG “长得好看”,也不是趋势,是整个现代前端生态把它推到了最合适的位置。

1)协议升级:HTTP/2/3 让雪碧图和 Iconfont 的优势全部消失

2)设备升级:高分屏让位图模糊问题暴露得更明显

3)工程升级:组件化开发需要精细化图标

4)体验升级:动画、主题、交互都离不开 SVG

一句话总结:

SVG 不只是“更清晰”,而是从工程到体验全面适配现代前端的图标方案,因此胜出。

来源:juejin.cn/post/7577691061034172462

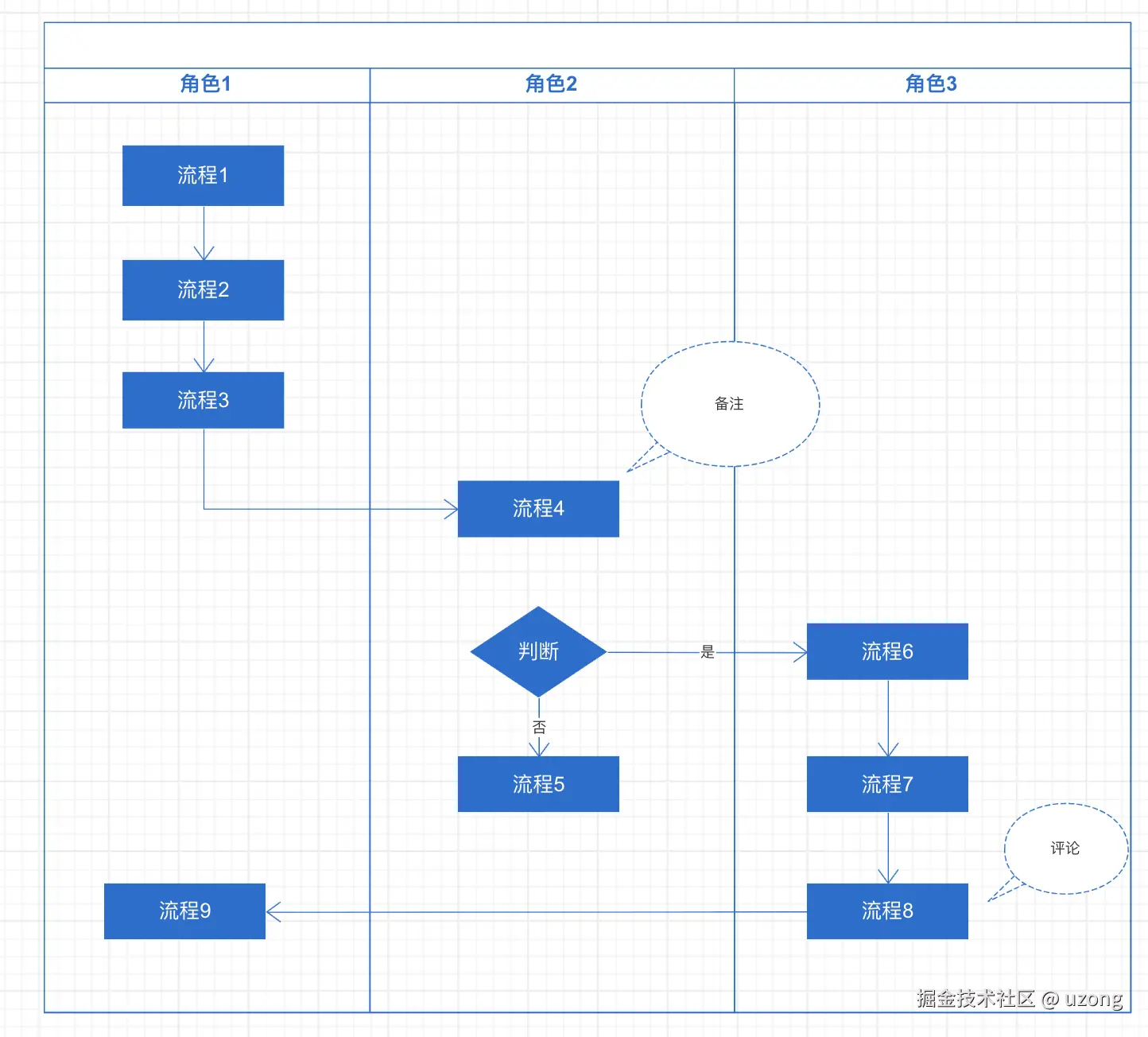

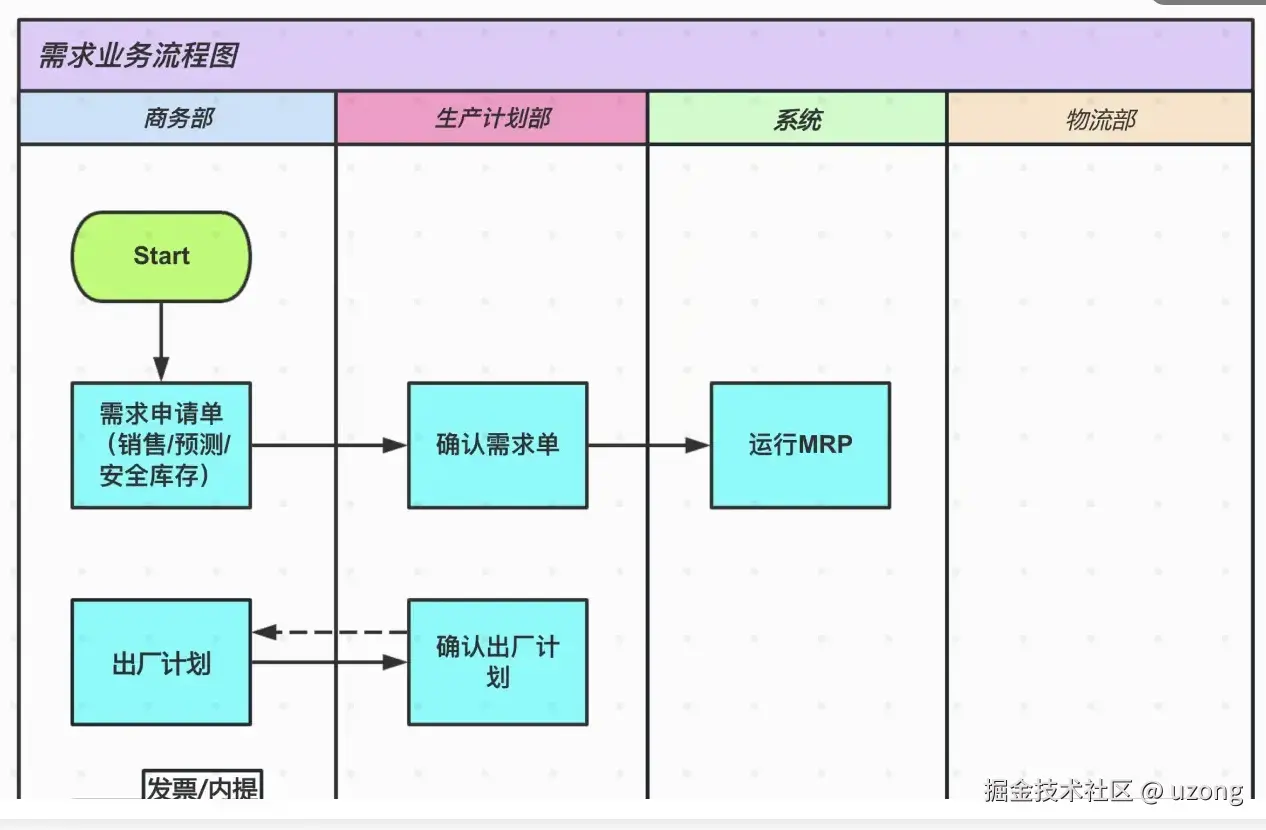

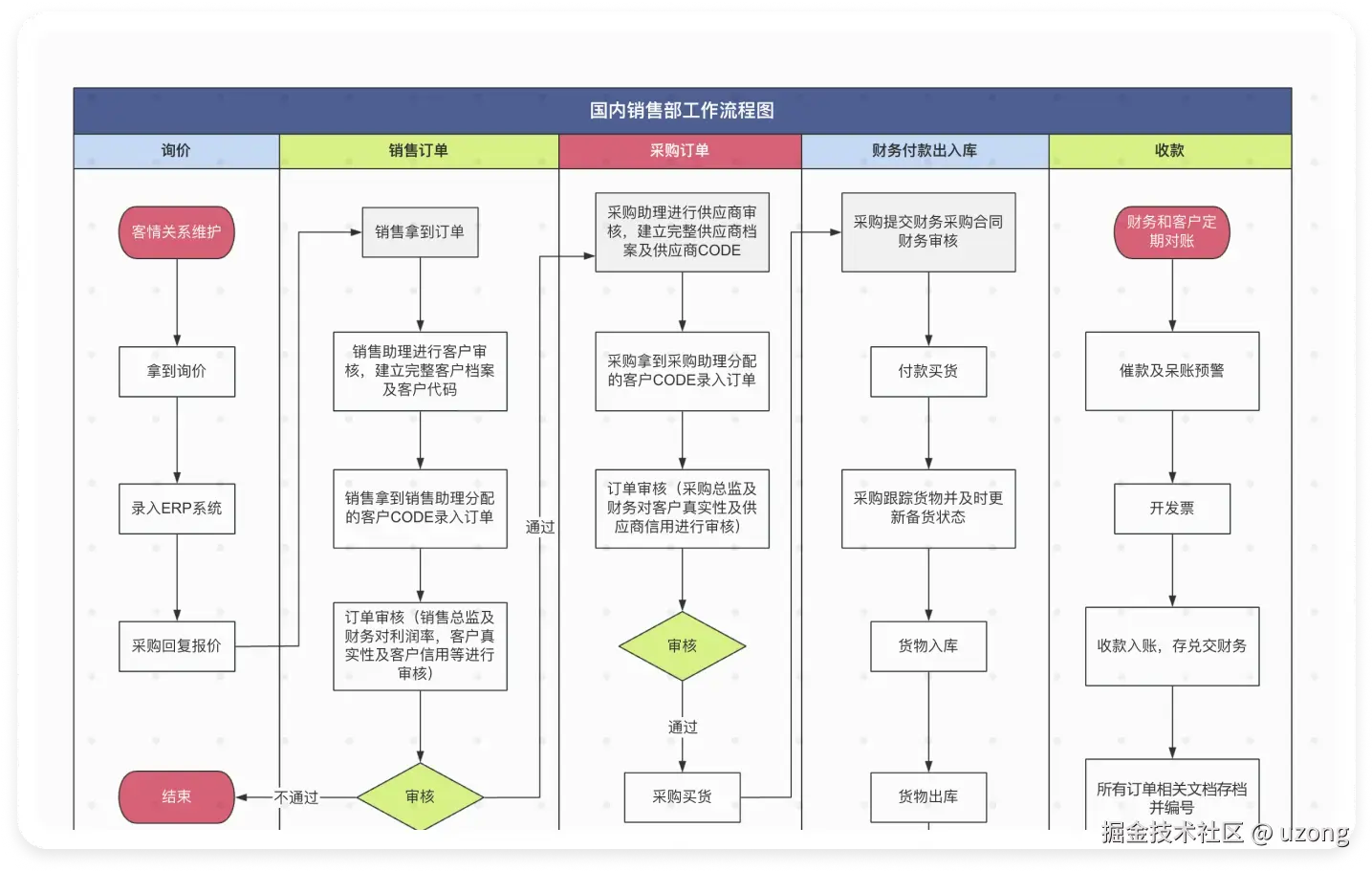

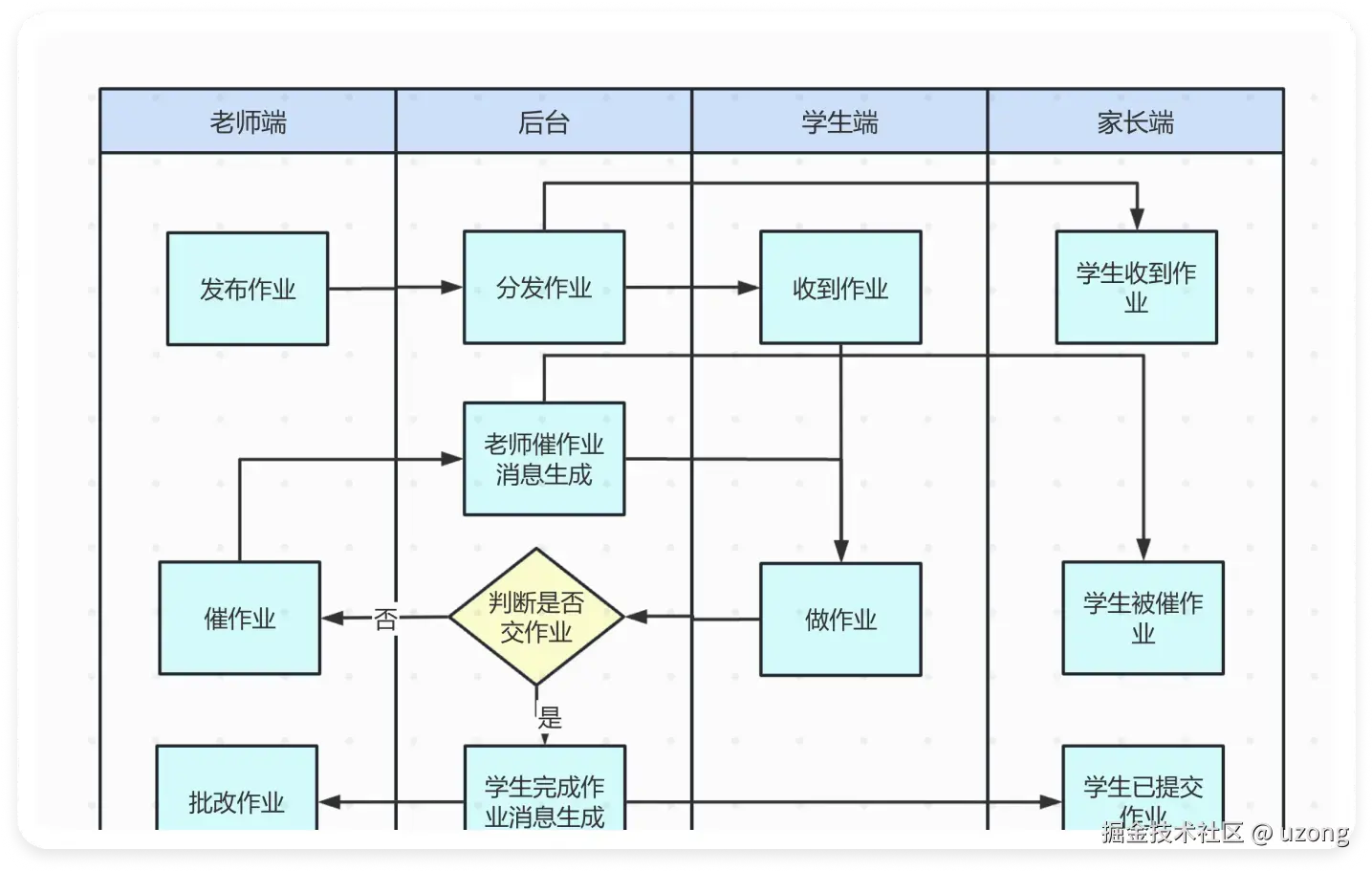

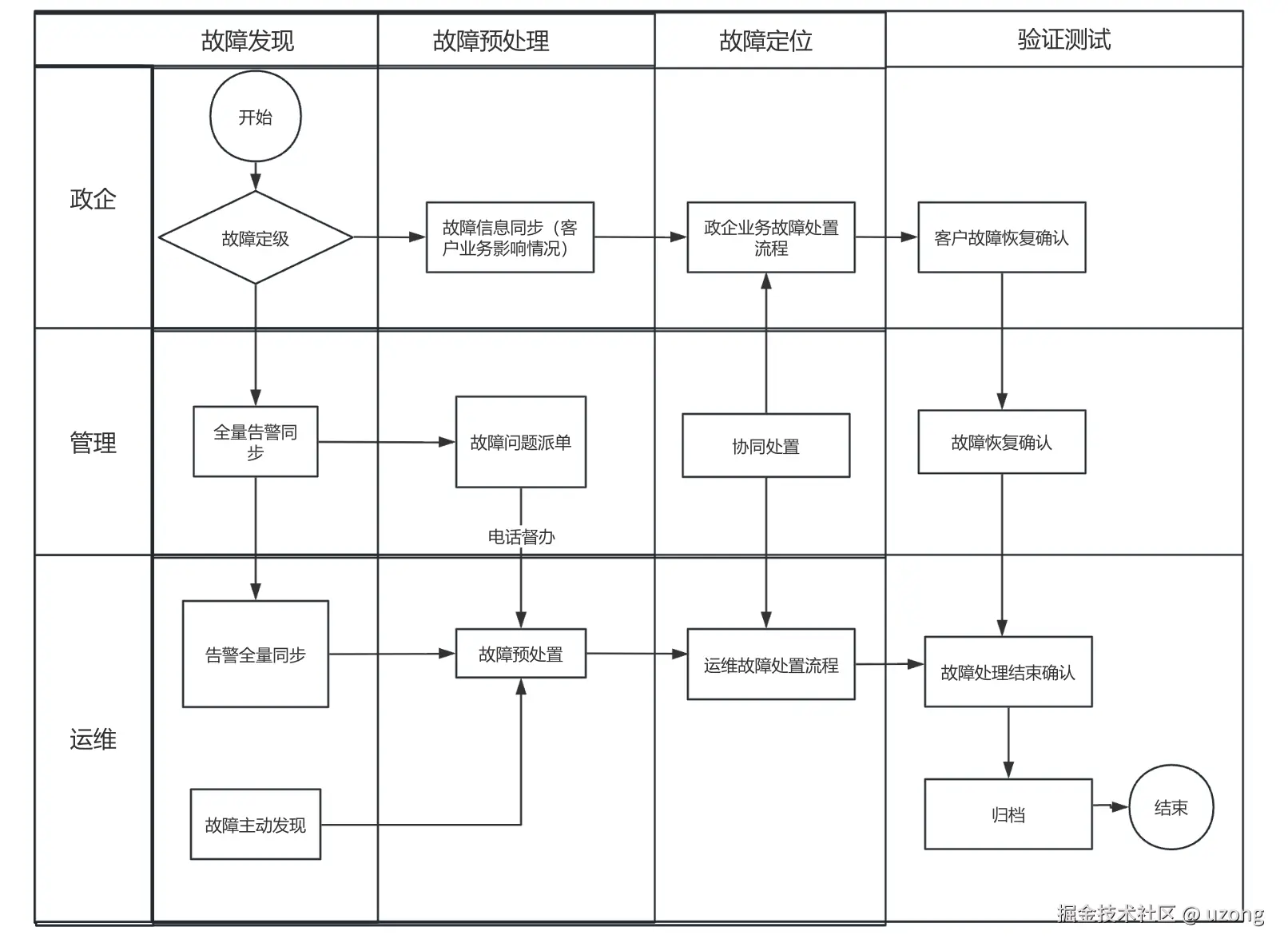

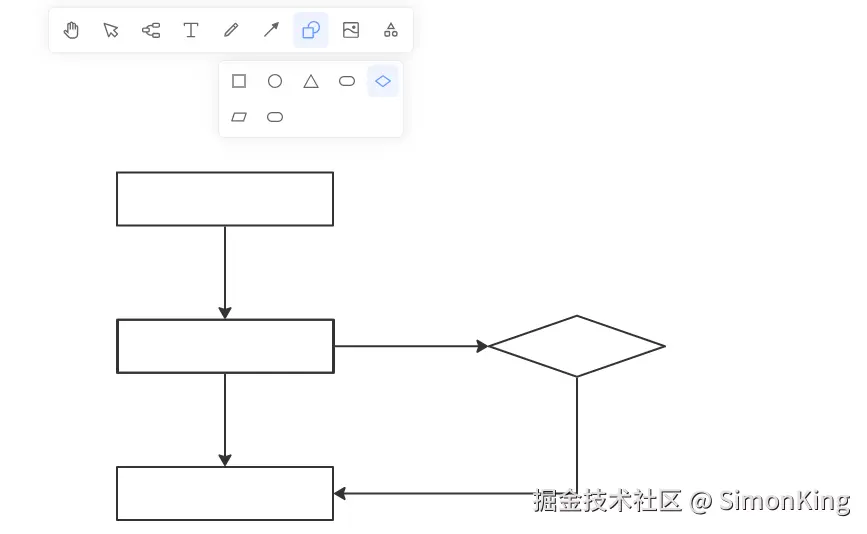

软件工程师必须要掌握的泳道图

作者:面汤放盐 / uzong

在软件开发的世界里,我们习惯用代码表达逻辑,但当系统涉及多个角色、多个服务、甚至跨团队协作时,光靠代码注释或口头沟通,往往不够。这时候,一张清晰的流程图,胜过千行文档。

泳道图 :它可能不像 UML 那样“高大上”,也不如架构图那样宏观,但在梳理业务流程、厘清责任边界、排查系统瓶颈时,它真的非常实用。

1. 什么是泳道图

泳道图的核心思想很简单:把流程中的每个步骤,按执行者(人、系统、模块)分组排列,就像游泳池里的泳道一样,各走各道,互不干扰又彼此关联。

每一列就是一个“泳道”,代表一个责任主体。流程从左到右、从上到下流动,谁在什么时候做了什么,一目了然

一眼就能看出:谁干了什么,谁依赖谁,边界是什么。

与流程的差异点:

- 流程图聚焦:“步骤顺序”,侧重 “先做什么、再做什么”,适合梳理线性业务流程;

- 泳道图聚焦: “流转通道”,侧重 “什么东西在什么约束下通过什么路径流转”,适合拆解复杂、多路径、有规则约束的流转场景(如分布式系统数据同步、供应链物料流转、微服务请求链路等)

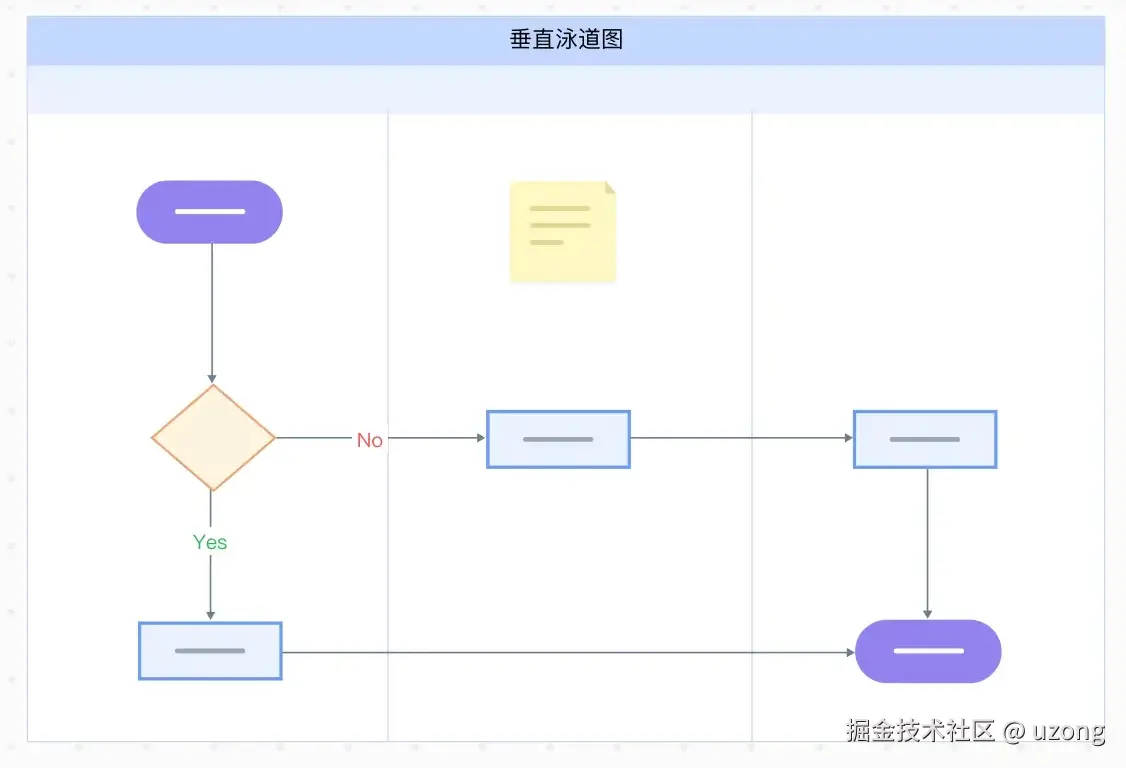

2. 泳道图分类

2.1. 垂直泳道图

垂直泳道图采取上下布局结构,主要强调职能群体。这种布局方式更适合于展示跨职能任务和流程中,各职能部门或角色之间的垂直关系和职能分工。

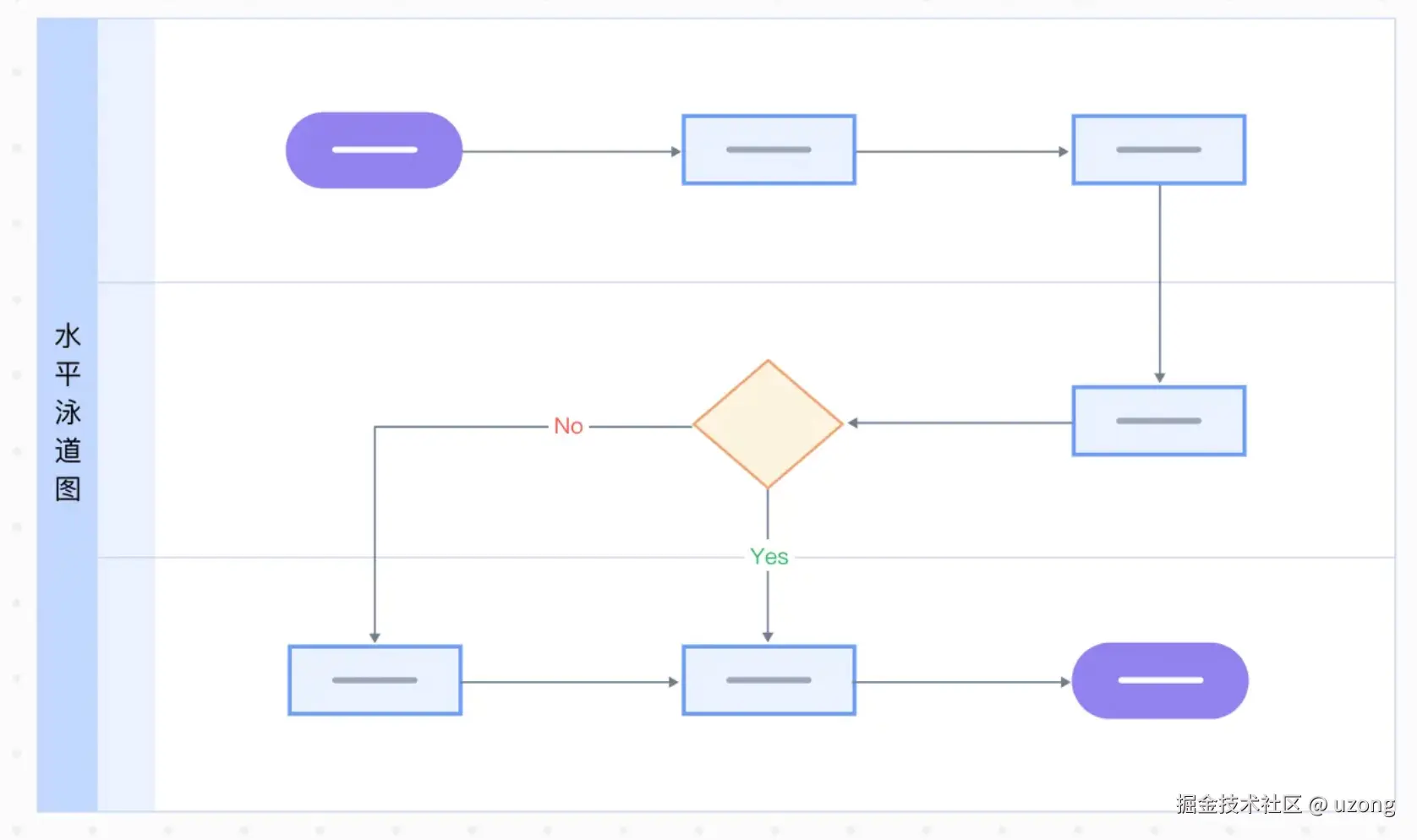

2.2. 水平泳道图

水平泳道图则采用左右布局结构,重点在于事件进程的展示。这种布局方式更适合于强调事件或过程的水平流动,以及不同阶段或部门在流程中的水平参与

3. 泳道图组成元素

泳池: 泳池是泳道图的外部框架,泳道、流程都包含于泳池内。

泳道: 泳池里可以创建多个泳道。

流程: 实际的业务流程。

部门: 通过部门或者责任来区分,明确每个部门/人/信息系统负责完成的任务环节。

阶段: 通过任务阶段来区分,明确每个阶段需要处理的任务环节。

4. 泳道图应用场景

4.1. 项目管理

展示项目从启动到完成的各个阶段,明确每个团队或成员在项目中的角色和职责,便于进行项目管理和监控,同时促进团队协作和沟通

4.2. 业务流程分析

展示业务流程的各个环节和涉及的不同部门或职能。通过分析泳道图,可以发现业务流程中的瓶颈、冗余环节或不合理之处,进而进行流程优化和改进。

4.3. 系统设计

展示系统的整体架构和各个组件之间的关系,描述系统的工作流程,包括数据的输入、处理、输出等各个环节,有助于系统开发人员更好地理解系统的功能和需求

5. 更多参考模板

故障处理多维泳道图

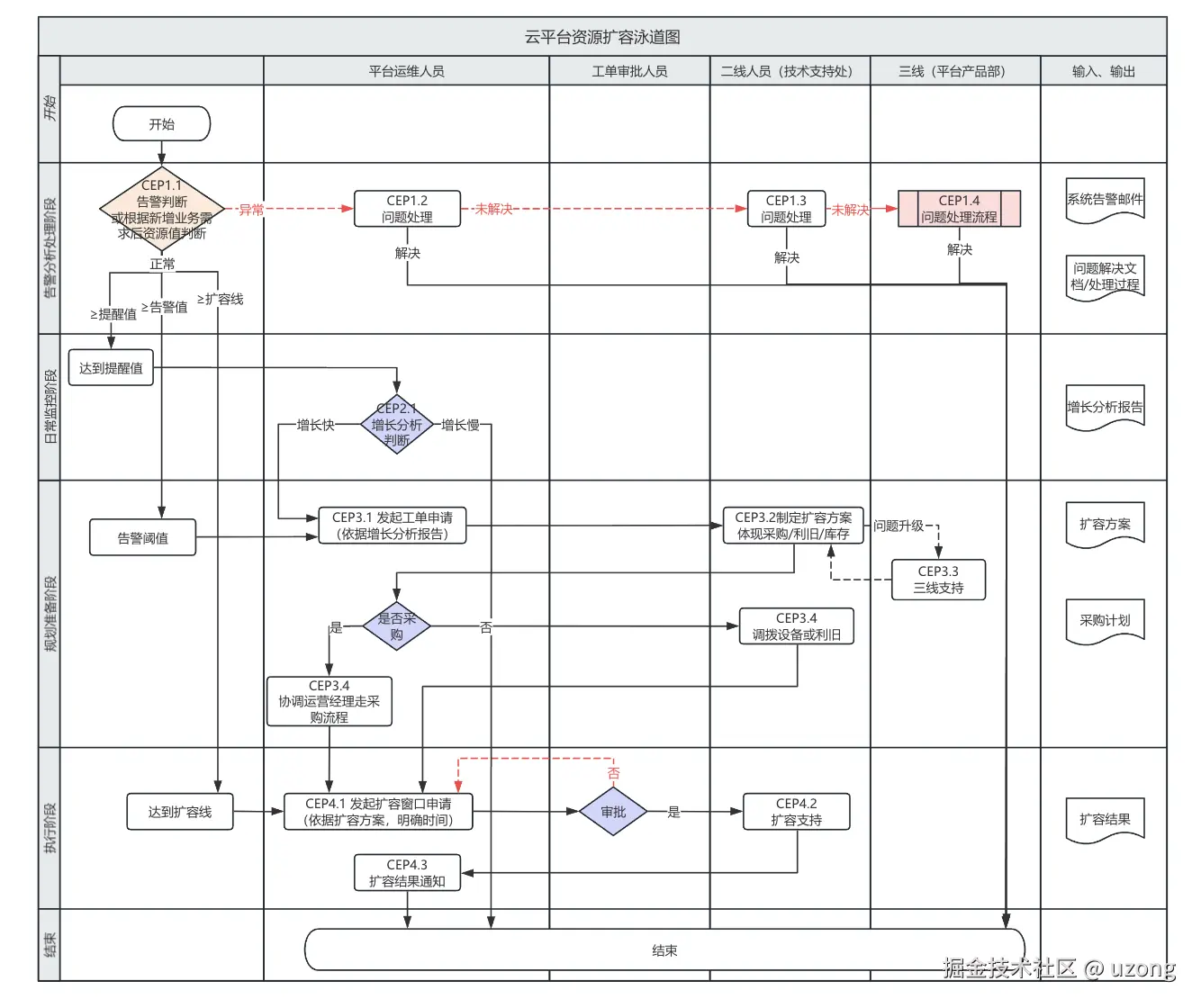

资源扩容泳道图

6. 最后

我刚工作时,看到导师抛出一份精致的泳道图,把一团乱麻的问题讲得透亮,心里特别佩服。直到自己多年后用上才真正体会:在面对跨部门协作、复杂故障排查、关键流程设计时,掏出这么一张图,往往就是高效沟通的开始。

作为开发者,我们常陷入“只要代码跑得通就行”的思维惯性。但软件不仅是机器执行的指令,更是人与人协作的媒介。泳道图这样的工具,本质上是在降低认知成本——让复杂的事情变得可沟通、可验证、可迭代。 其实泳道图的核心不是“画图”,而是“梳理流程、明确权责”。

在跨部门、协同需求、故障分析等关键场景使用泳道图是非常合适,并且也能把问题讲清楚。技术世界充满了抽象和复杂性,而优秀工程师的能力之一,就是创建合适的可视化工具,让复杂问题变得简单可见。

本文中的大部分图片来源于 ProcessOn,ProcessOn 是一个非常不错的画图软件,功能强大,界面优美。

来源:juejin.cn/post/7580423629164068916

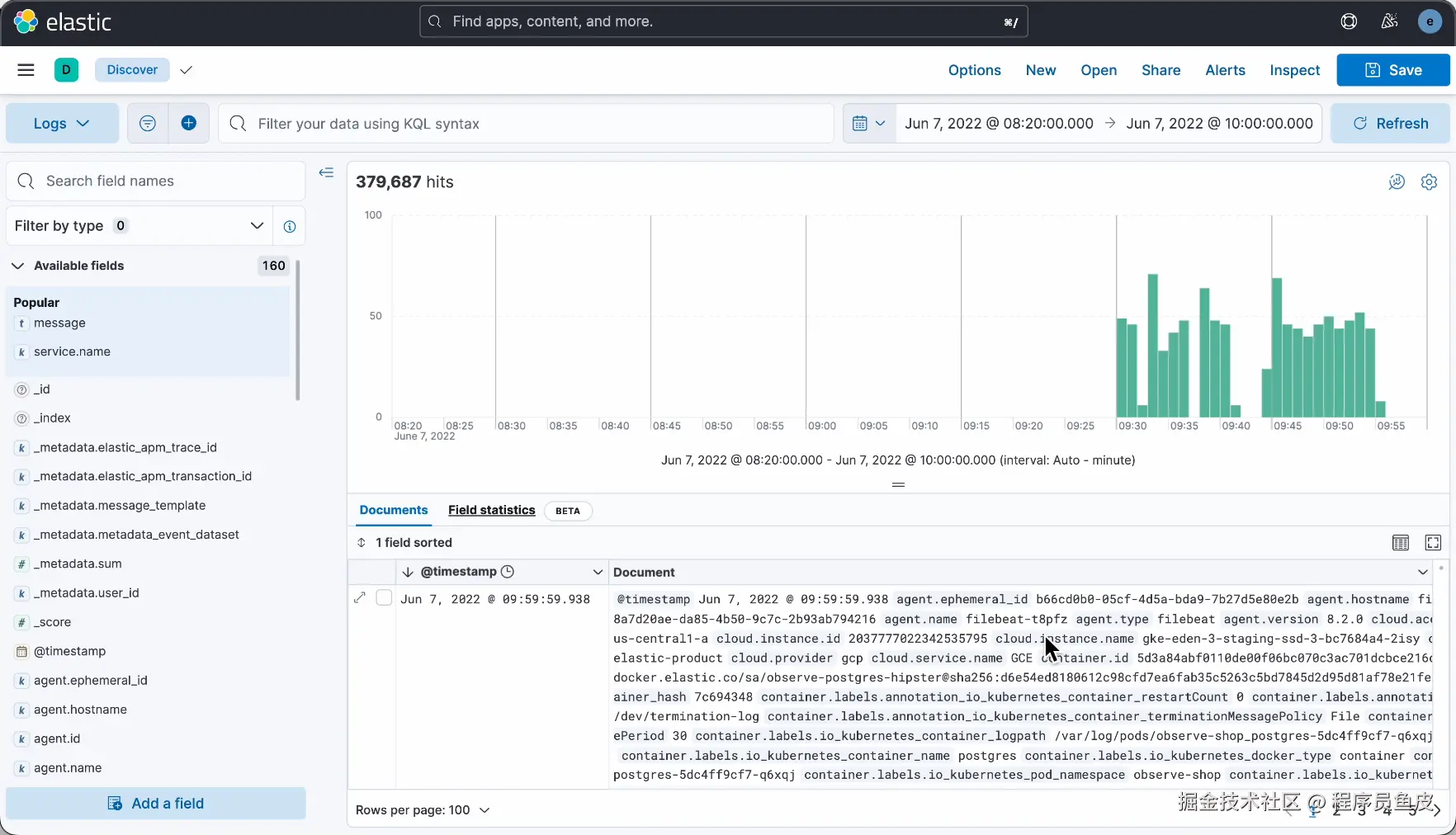

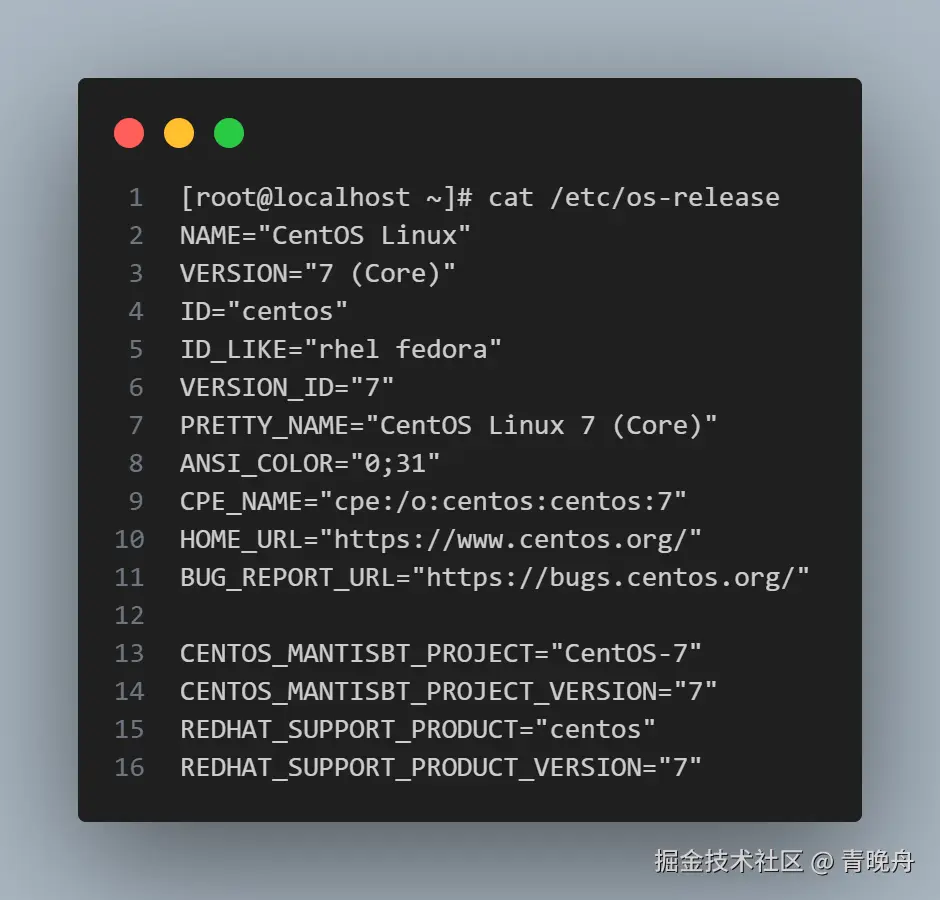

我发现很多程序员都不会打日志。。。

你是小阿巴,刚入职的低级程序员,正在开发一个批量导入数据的程序。

没想到,程序刚上线,产品经理就跑过来说:小阿巴,用户反馈你的程序有 Bug,刚导入没多久就报错中断了!

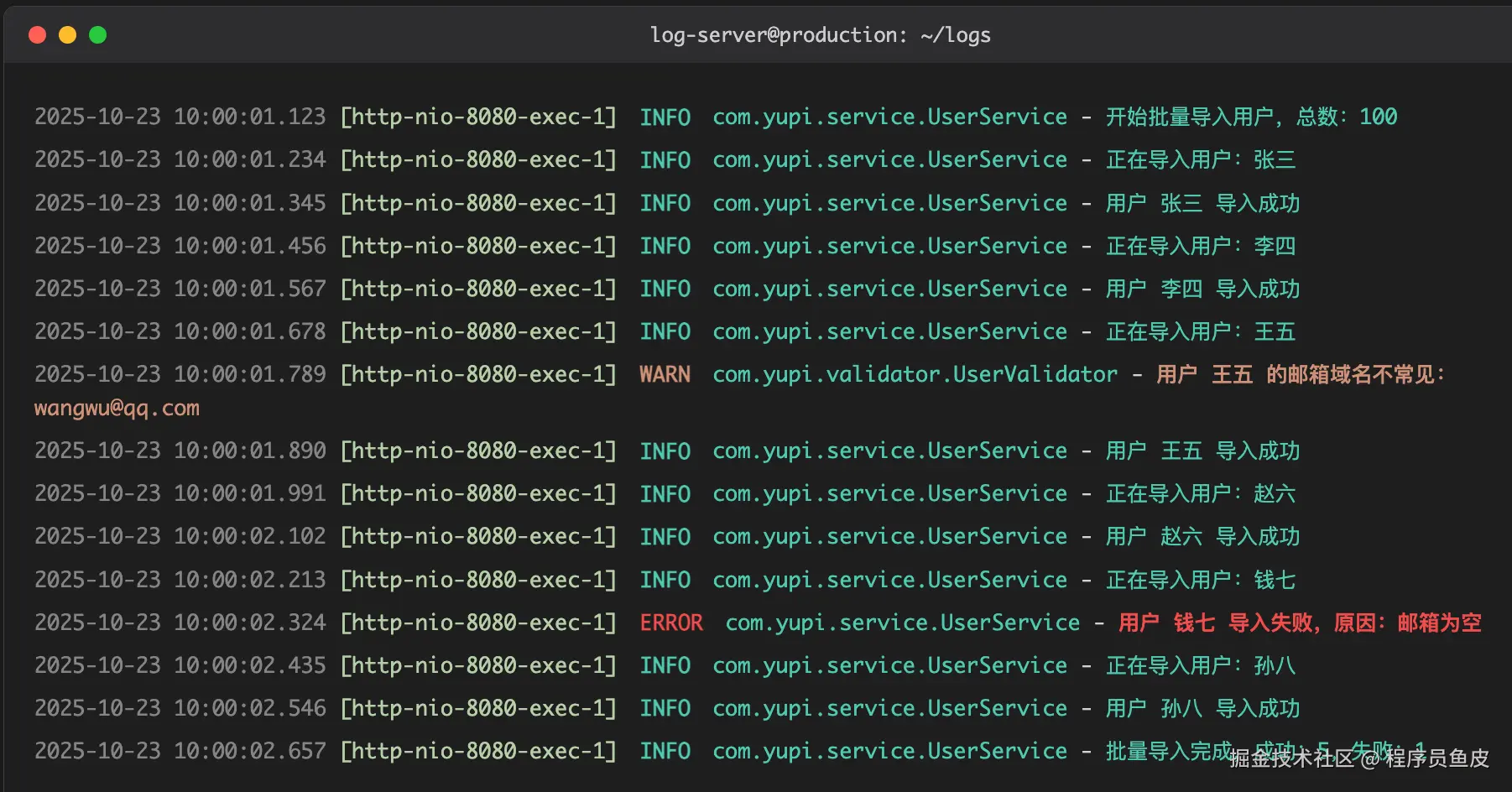

你赶紧打开服务器,看着比你发量都少的报错信息:

你一脸懵逼:只有这点儿信息,我咋知道哪里出了问题啊?!

你只能硬着头皮让产品经理找用户要数据,然后一条条测试,看看是哪条数据出了问题……

原本大好的摸鱼时光,就这样无了。

这时,你的导师鱼皮走了过来,问道:小阿巴,你是持矢了么?脸色这么难看?

你无奈地说:皮哥,刚才线上出了个 bug,我花了 8 个小时才定位到问题……

鱼皮皱了皱眉:这么久?你没打日志吗?

你很是疑惑:谁是日志?为什么要打它?

鱼皮叹了口气:唉,难怪你要花这么久…… 来,我教你打日志!

⭐️ 本文对应视频版:bilibili.com/video/BV1K7…

什么是日志?

鱼皮打开电脑,给你看了一段代码:

@Slf4j

public class UserService {

public void batchImport(List<UserDTO> userList) {

log.info("开始批量导入用户,总数:{}", userList.size());

int successCount = 0;

int failCount = 0;

for (UserDTO userDTO : userList) {

try {

log.info("正在导入用户:{}", userDTO.getUsername());

validateUser(userDTO);

saveUser(userDTO);

successCount++;

log.info("用户 {} 导入成功", userDTO.getUsername());

} catch (Exception e) {

failCount++;

log.error("用户 {} 导入失败,原因:{}", userDTO.getUsername(), e.getMessage(), e);

}

}

log.info("批量导入完成,成功:{},失败:{}", successCount, failCount);

}

}

你看着代码里的 log.info、log.error,疑惑地问:这些 log 是干什么的?

鱼皮:这就是打日志。日志用来记录程序运行时的状态和信息,这样当系统出现问题时,我们可以通过日志快速定位问题。

你若有所思:哦?还可以这样!如果当初我的代码里有这些日志,一眼就定位到问题了…… 那我应该怎么打日志?用什么技术呢?

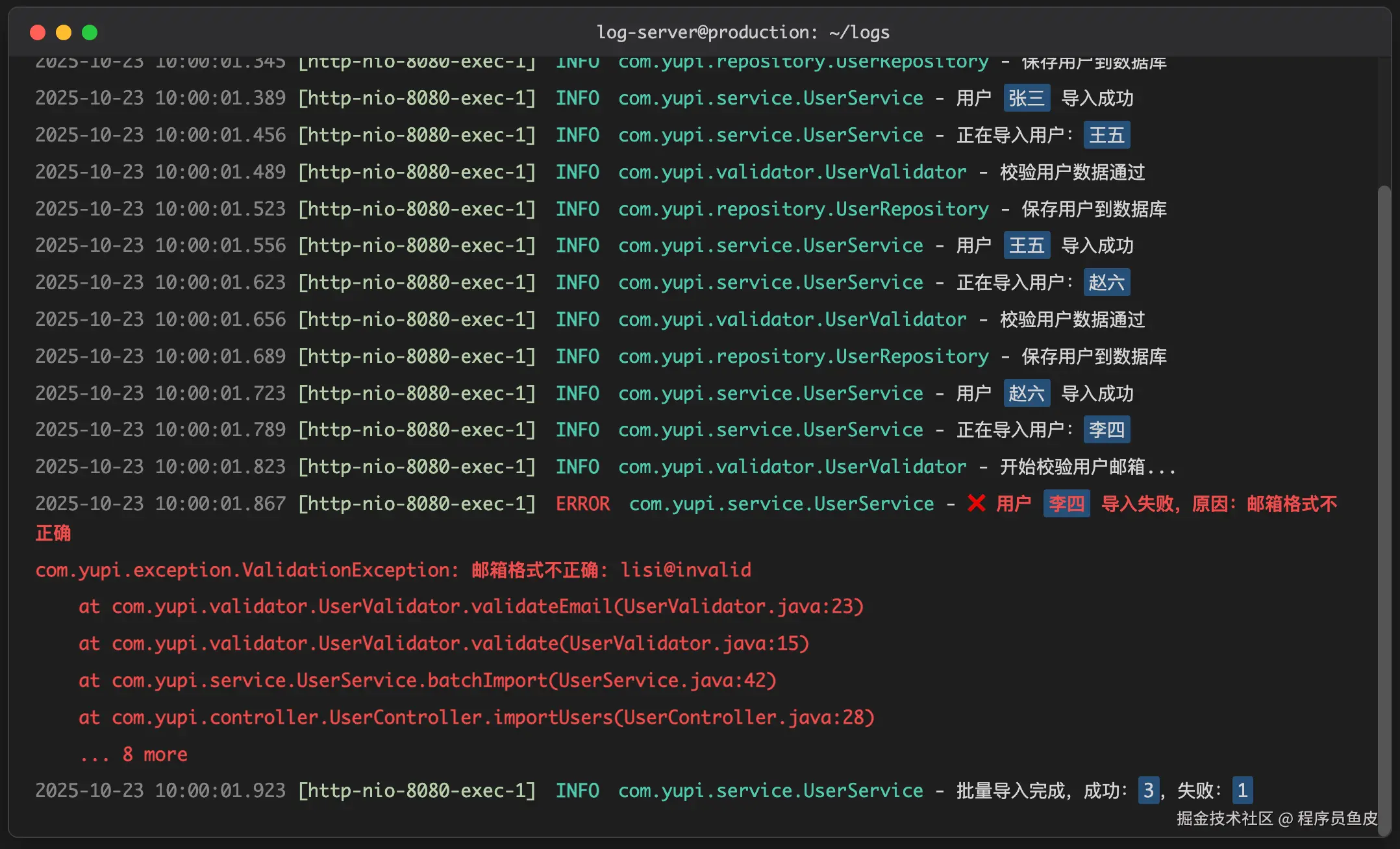

怎么打日志?

鱼皮:每种编程语言都有很多日志框架和工具库,比如 Java 可以选用 Log4j 2、Logback 等等。咱们公司用的是 Spring Boot,它默认集成了 Logback 日志框架,你直接用就行,不用再引入额外的库了~

日志框架的使用非常简单,先获取到 Logger 日志对象。

1)方法 1:通过 LoggerFactory 手动获取 Logger 日志对象:

public class MyService {

private static final Logger logger = LoggerFactory.getLogger(MyService.class);

}

2)方法 2:使用 this.getClass 获取当前类的类型,来创建 Logger 对象:

public class MyService {

private final Logger logger = LoggerFactory.getLogger(this.getClass());

}

然后调用 logger.xxx(比如 logger.info)就能输出日志了。

public class MyService {

private final Logger logger = LoggerFactory.getLogger(this.getClass());

public void doSomething() {

logger.info("执行了一些操作");

}

}

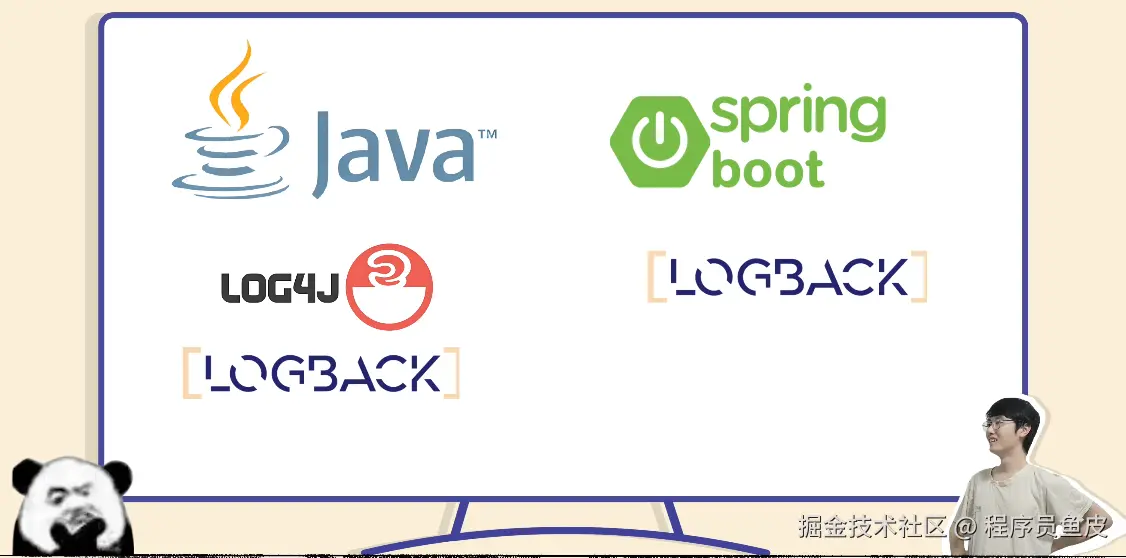

效果如图:

小阿巴:啊,每个需要打日志的类都要加上这行代码么?

鱼皮:还有更简单的方式,使用 Lombok 工具库提供的 @Slf4j 注解,可以自动为当前类生成日志对象,不用手动定义啦。

@Slf4j

public class MyService {

public void doSomething() {

log.info("执行了一些操作");

}

}

上面的代码等同于 “自动为当前类生成日志对象”:

private static final org.slf4j.Logger log =

org.slf4j.LoggerFactory.getLogger(MyService.class);

你咧嘴一笑:这个好,爽爽爽!

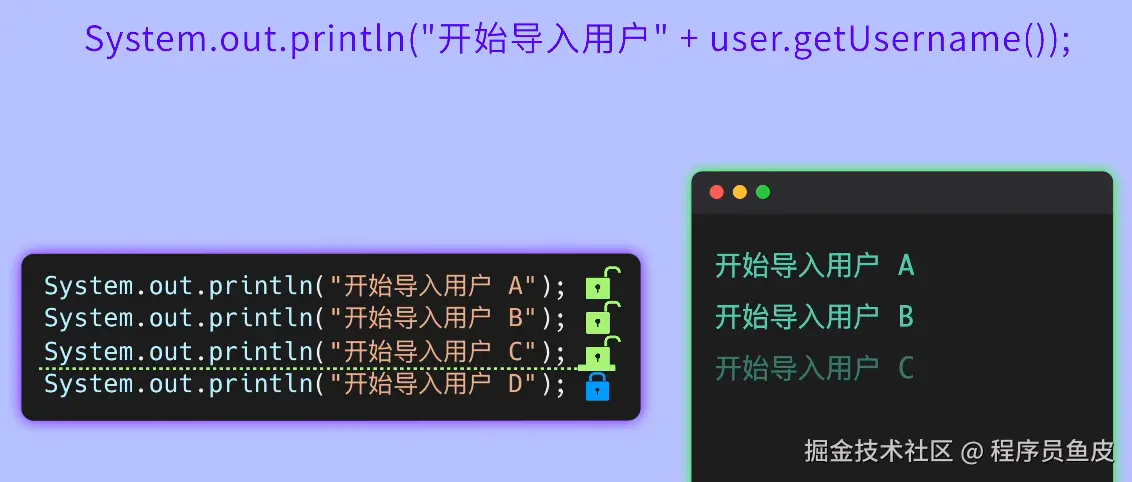

等等,不对,我直接用 Java 自带的 System.out.println 不也能输出信息么?何必多此一举?

System.out.println("开始导入用户" + user.getUsername());

鱼皮摇了摇头:千万别这么干!

首先,System.out.println 是一个同步方法,每次调用都会导致耗时的 I/O 操作,频繁调用会影响程序的性能。

而且它只能输出信息到控制台,不能灵活控制输出位置、输出格式、输出时机等等。比如你现在想看三天前的日志,System.out.println 的输出早就被刷没了,你还得浪费时间找半天。

你恍然大悟:原来如此!那使用日志框架就能解决这些问题吗?

鱼皮点点头:没错,日志框架提供了丰富的打日志方法,还可以通过修改日志配置文件来随心所欲地调教日志,比如把日志同时输出到控制台和文件中、设置日志格式、控制日志级别等等。

在下苦心研究日志多年,沉淀了打日志的 8 大邪修秘法,先传授你 2 招最基础的吧。

打日志的 8 大最佳实践

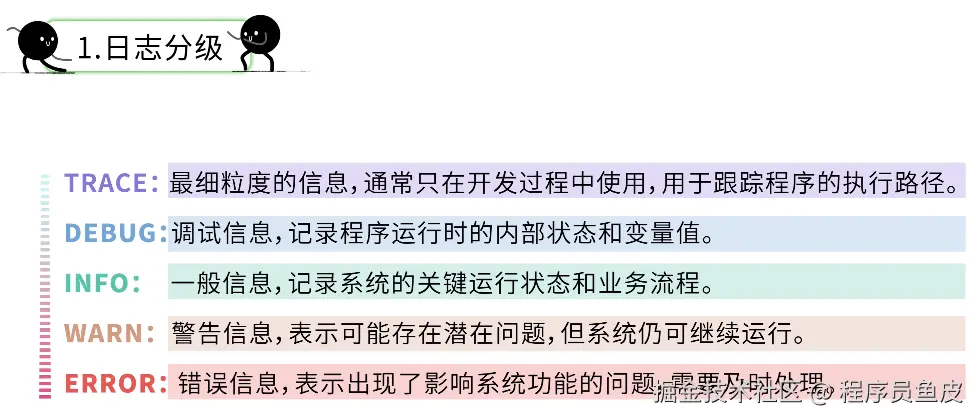

1、合理选择日志级别

第一招,日志分级。

你好奇道:日志还有级别?苹果日志、安卓日志?

鱼皮给了你一巴掌:可不要乱说,日志的级别是按照重要程度进行划分的。

其中 DEBUG、INFO、WARN 和 ERROR 用的最多。

- 调试用的详细信息用 DEBUG

- 正常的业务流程用 INFO

- 可能有问题但不影响主流程的用 WARN

- 出现异常或错误的用 ERROR

log.debug("用户对象的详细信息:{}", userDTO); // 调试信息

log.info("用户 {} 开始导入", username); // 正常流程信息

log.warn("用户 {} 的邮箱格式可疑,但仍然导入", username); // 警告信息

log.error("用户 {} 导入失败", username, e); // 错误信息

你挠了挠头:俺直接全用 DEBUG 不行么?

鱼皮摇了摇头:如果所有信息都用同一级别,那出了问题时,你怎么快速找到错误信息?

在生产环境,我们通常会把日志级别调高(比如 INFO 或 WARN),这样 DEBUG 级别的日志就不会输出了,防止重要信息被无用日志淹没。

你点点头:俺明白了,不同的场景用不同的级别!

2、正确记录日志信息

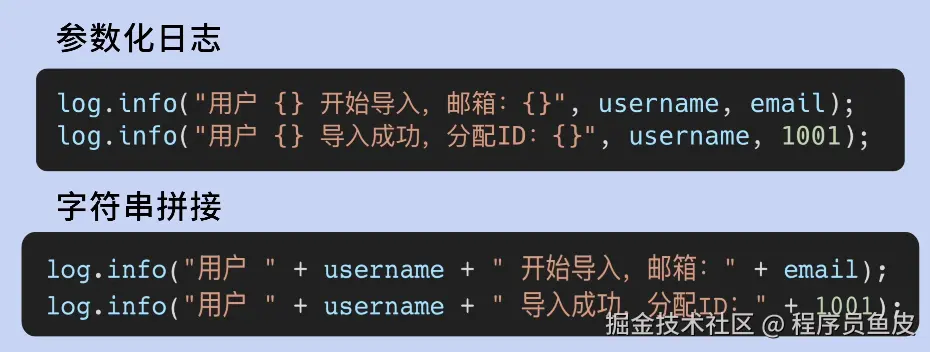

鱼皮:没错,下面教你第二招。你注意到我刚才写的日志里有一对大括号 {} 吗?

log.info("用户 {} 开始导入", username);

你回忆了一下:对哦,那是啥啊?

鱼皮:这叫参数化日志。{} 是一个占位符,日志框架会在运行时自动把后面的参数值替换进去。

你挠了挠头:我直接用字符串拼接不行吗?

log.info("用户 " + username + " 开始导入");

鱼皮摇摇头:不推荐。因为字符串拼接是在调用 log 方法之前就执行的,即使这条日志最终不被输出,字符串拼接操作还是会执行,白白浪费性能。

你点点头:确实,而且参数化日志比字符串拼接看起来舒服~

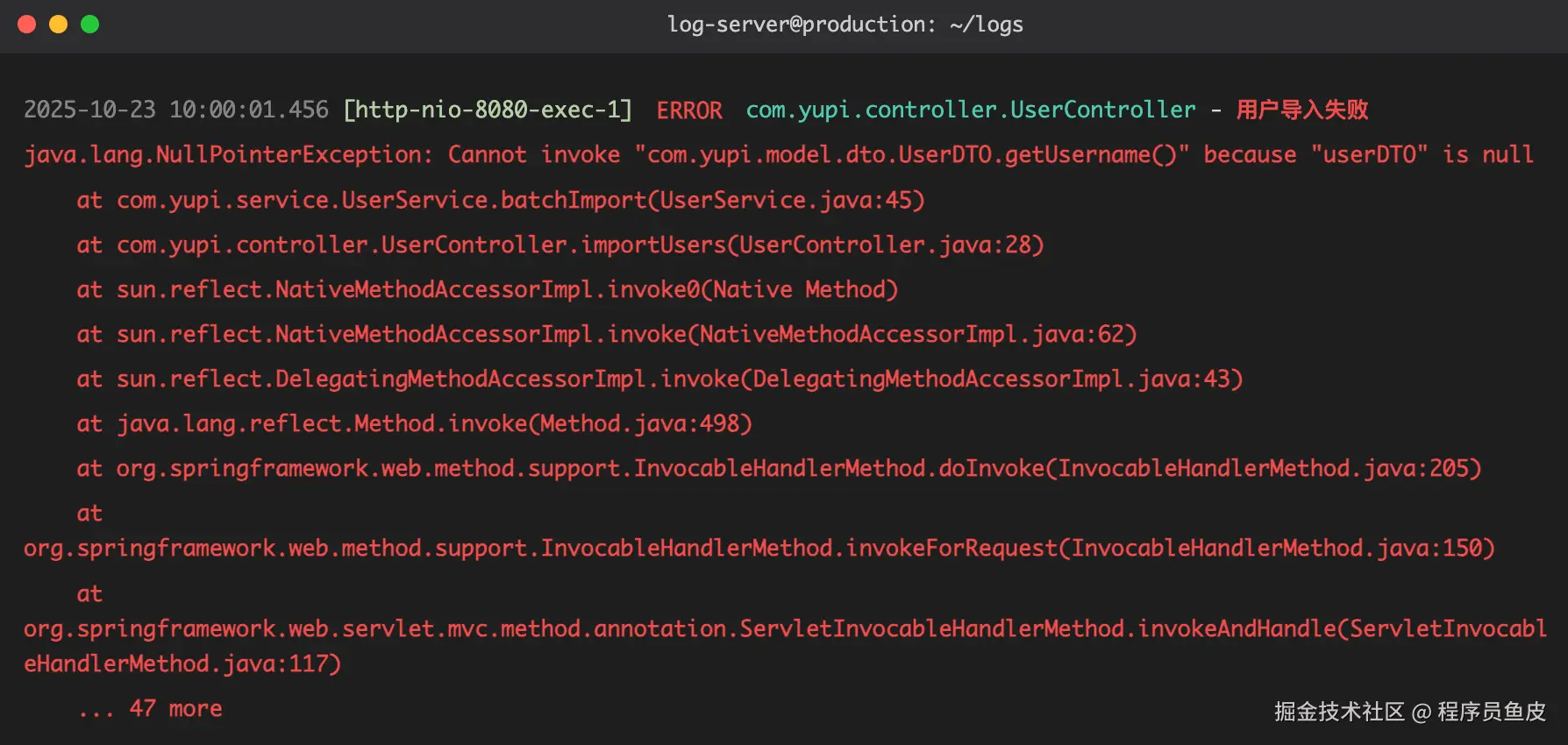

鱼皮:没错。而且当你要输出异常信息时,也可以使用参数化日志:

try {

// 业务逻辑

} catch (Exception e) {

log.error("用户 {} 导入失败", username, e); // 注意这个 e

}

这样日志框架会同时记录上下文信息和完整的异常堆栈信息,便于排查问题。

你抱拳:学会了,我这就去打日志!

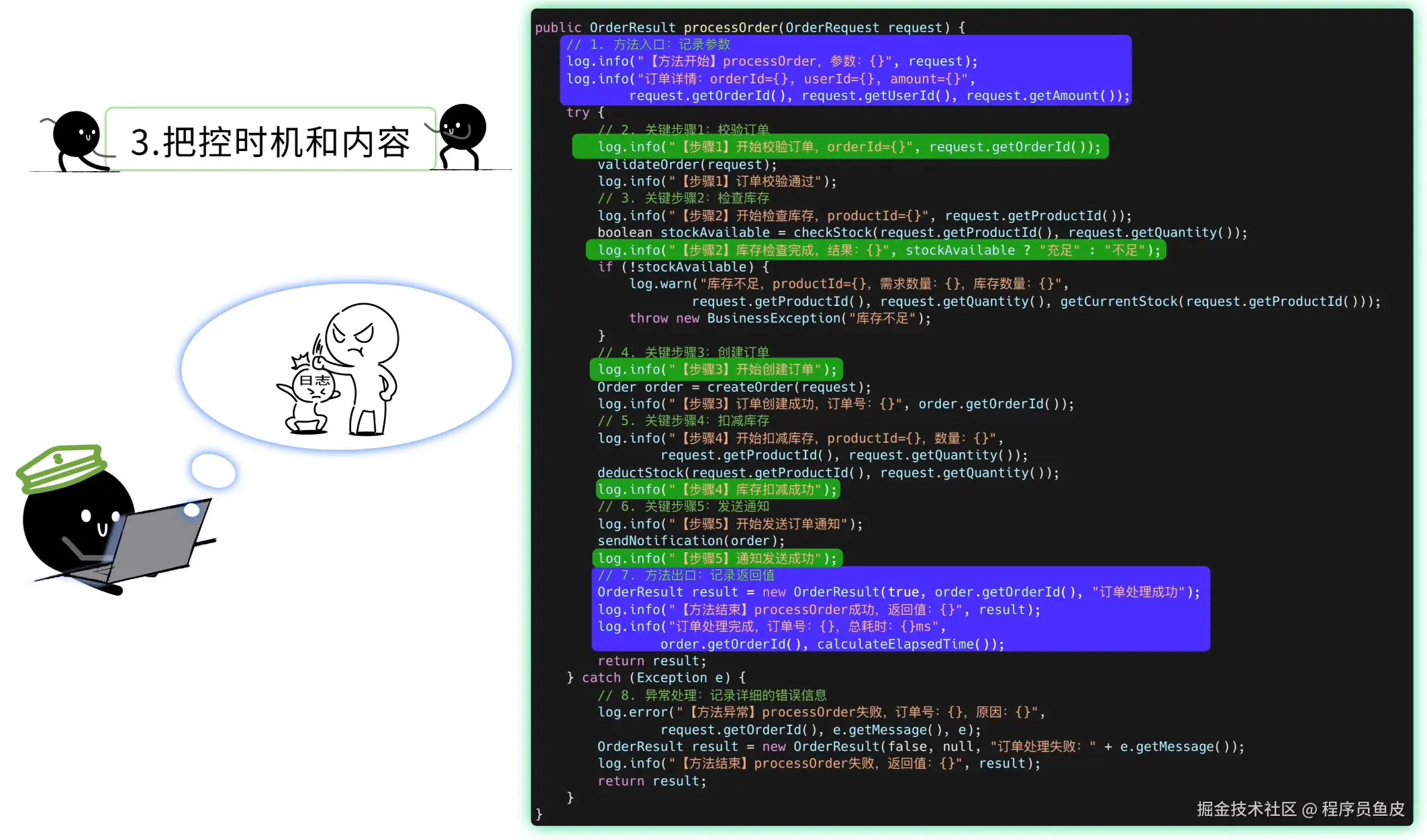

3、把控时机和内容

很快,你给批量导入程序的代码加上了日志:

@Slf4j

public class UserService {

public BatchImportResult batchImport(List<UserDTO> userList) {

log.info("开始批量导入用户,总数:{}", userList.size());

int successCount = 0;

int failCount = 0;

for (UserDTO userDTO : userList) {

try {

log.info("正在导入用户:{}", userDTO.getUsername());

// 校验用户名

if (StringUtils.isBlank(userDTO.getUsername())) {

throw new BusinessException("用户名不能为空");

}

// 保存用户

saveUser(userDTO);

successCount++;

log.info("用户 {} 导入成功", userDTO.getUsername());

} catch (Exception e) {

failCount++;

log.error("用户 {} 导入失败,原因:{}", userDTO.getUsername(), e.getMessage(), e);

}

}

log.info("批量导入完成,成功:{},失败:{}", successCount, failCount);

return new BatchImportResult(successCount, failCount);

}

}

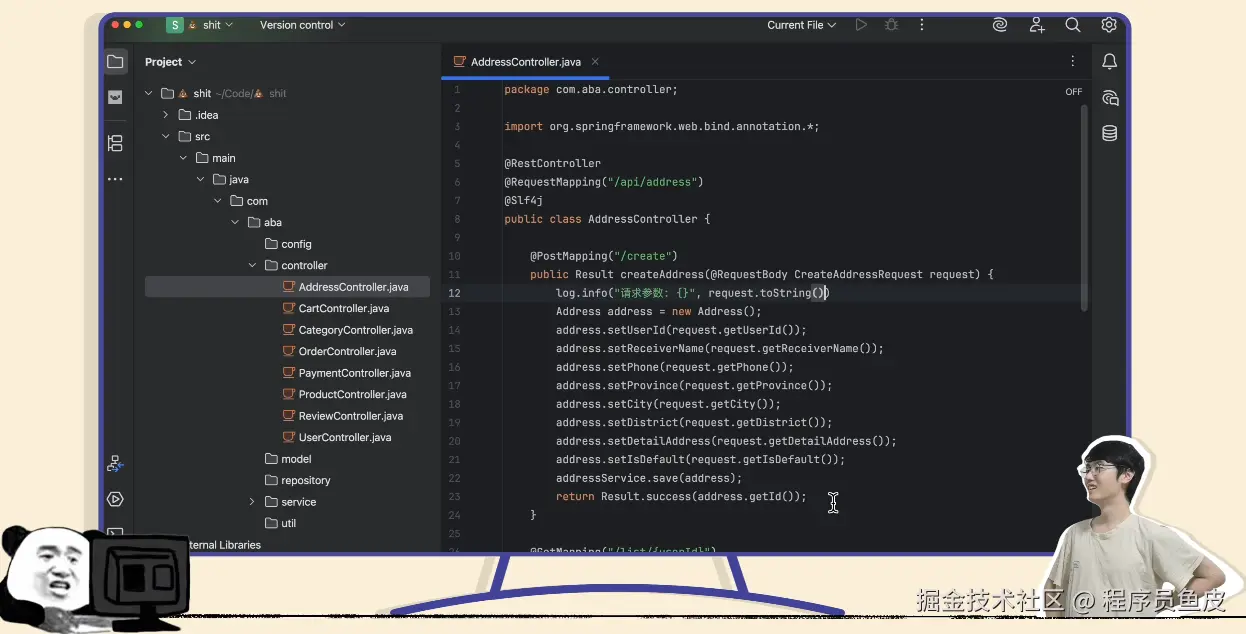

光做这点还不够,你还翻出了之前的屎山代码,想给每个文件都打打日志。

但打着打着,你就不耐烦了:每段代码都要打日志,好累啊!但是不打日志又怕出问题,怎么办才好?

鱼皮笑道:好问题,这就是我要教你的第三招 —— 把握打日志的时机。

对于重要的业务功能,我建议采用防御性编程,先多多打日志。比如在方法代码的入口和出口记录参数和返回值、在每个关键步骤记录执行状态,而不是等出了问题无法排查的时候才追悔莫及。之后可以再慢慢移除掉不需要的日志。

你叹了口气:这我知道,但每个方法都打日志,工作量太大,都影响我摸鱼了!

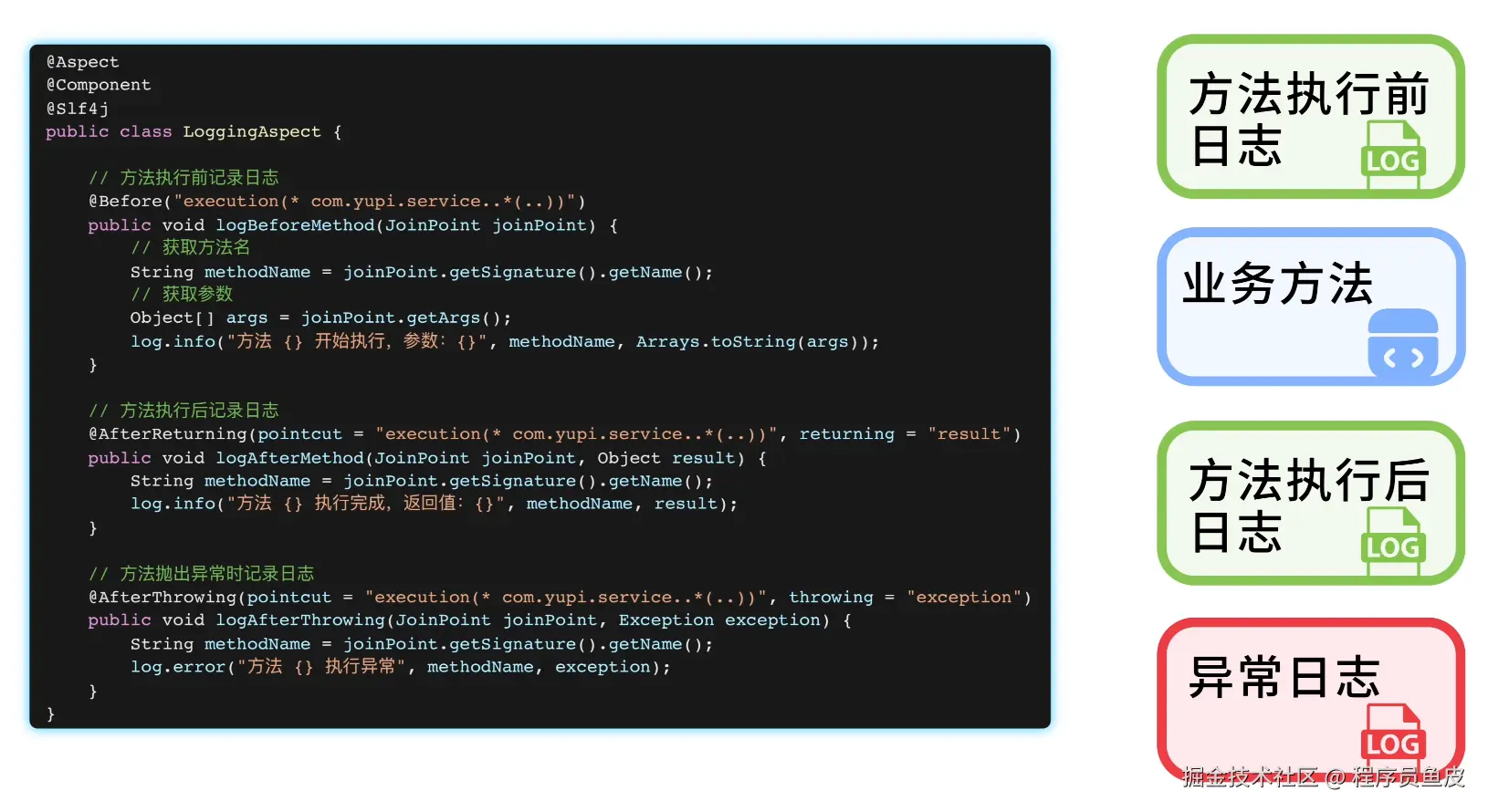

鱼皮:别担心,你可以利用 AOP 切面编程,自动给每个业务方法的执行前后添加日志,这样就不会错过任何一次调用信息了。

你双眼放光:这个好,爽爽爽!

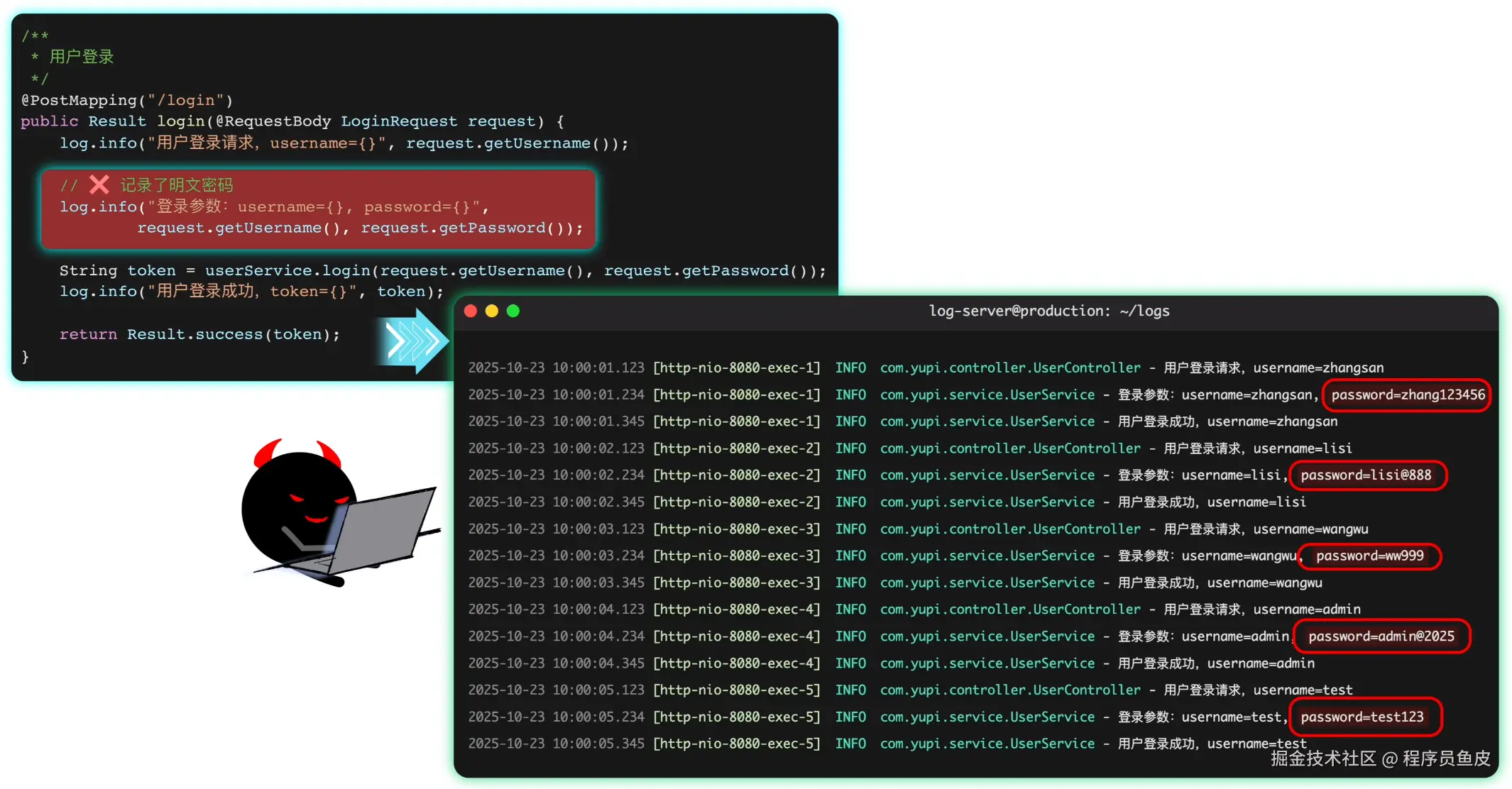

鱼皮:不过这样做也有一个缺点,注意不要在日志中记录了敏感信息,比如用户密码。万一你的日志不小心泄露出去,就相当于泄露了大量用户的信息。

你拍拍胸脯:必须的!

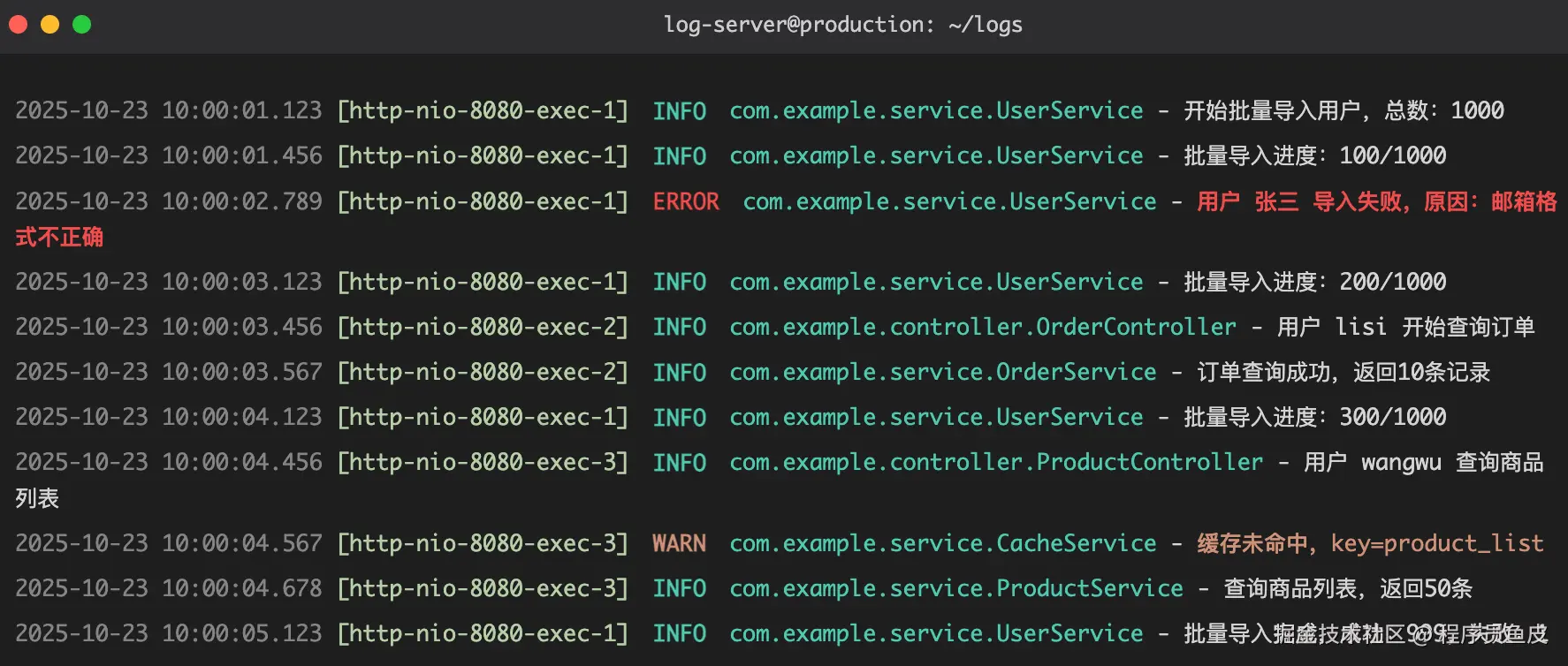

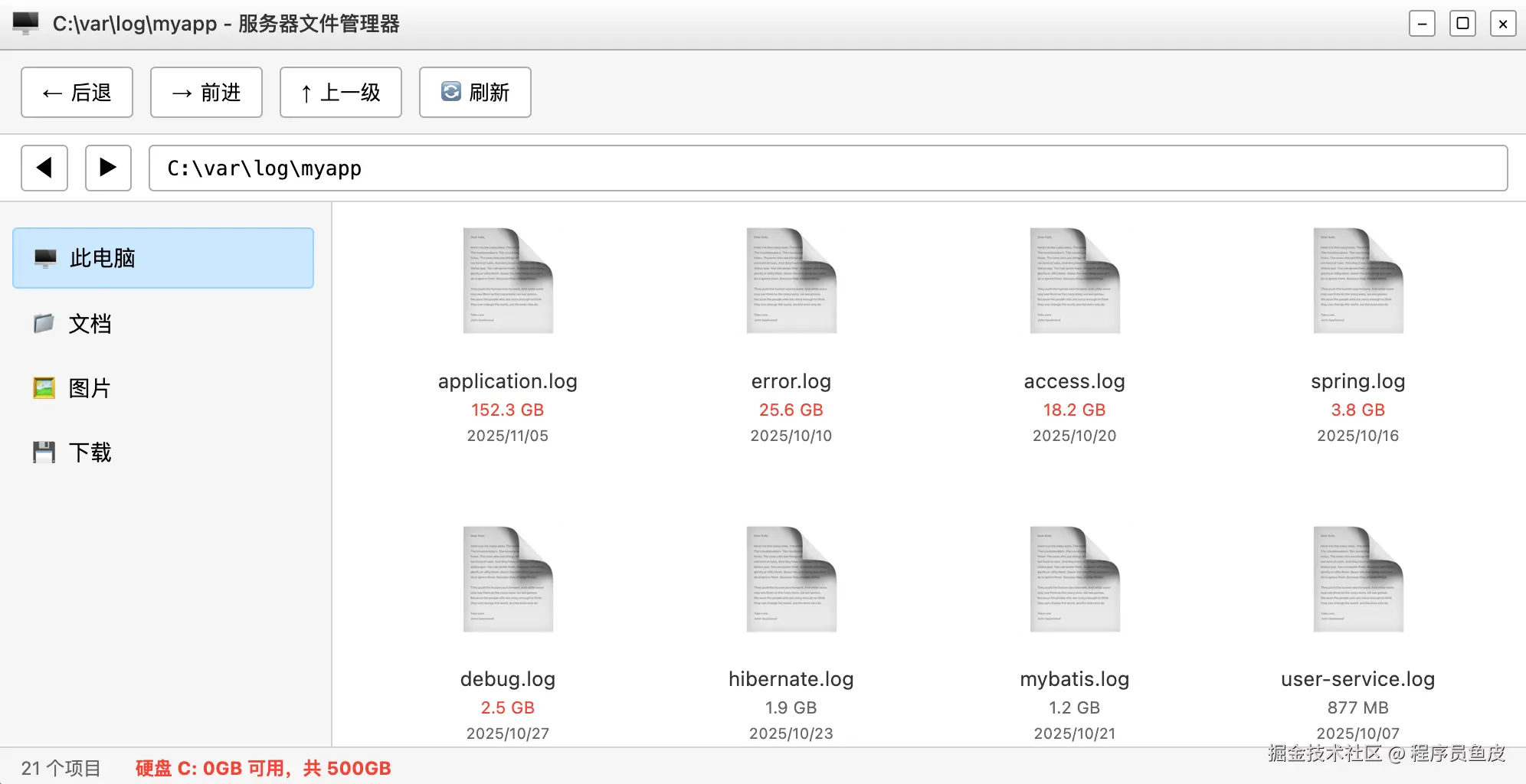

4、控制日志输出量

一个星期后,产品经理又来找你了:小阿巴,你的批量导入功能又报错啦!而且怎么感觉程序变慢了?

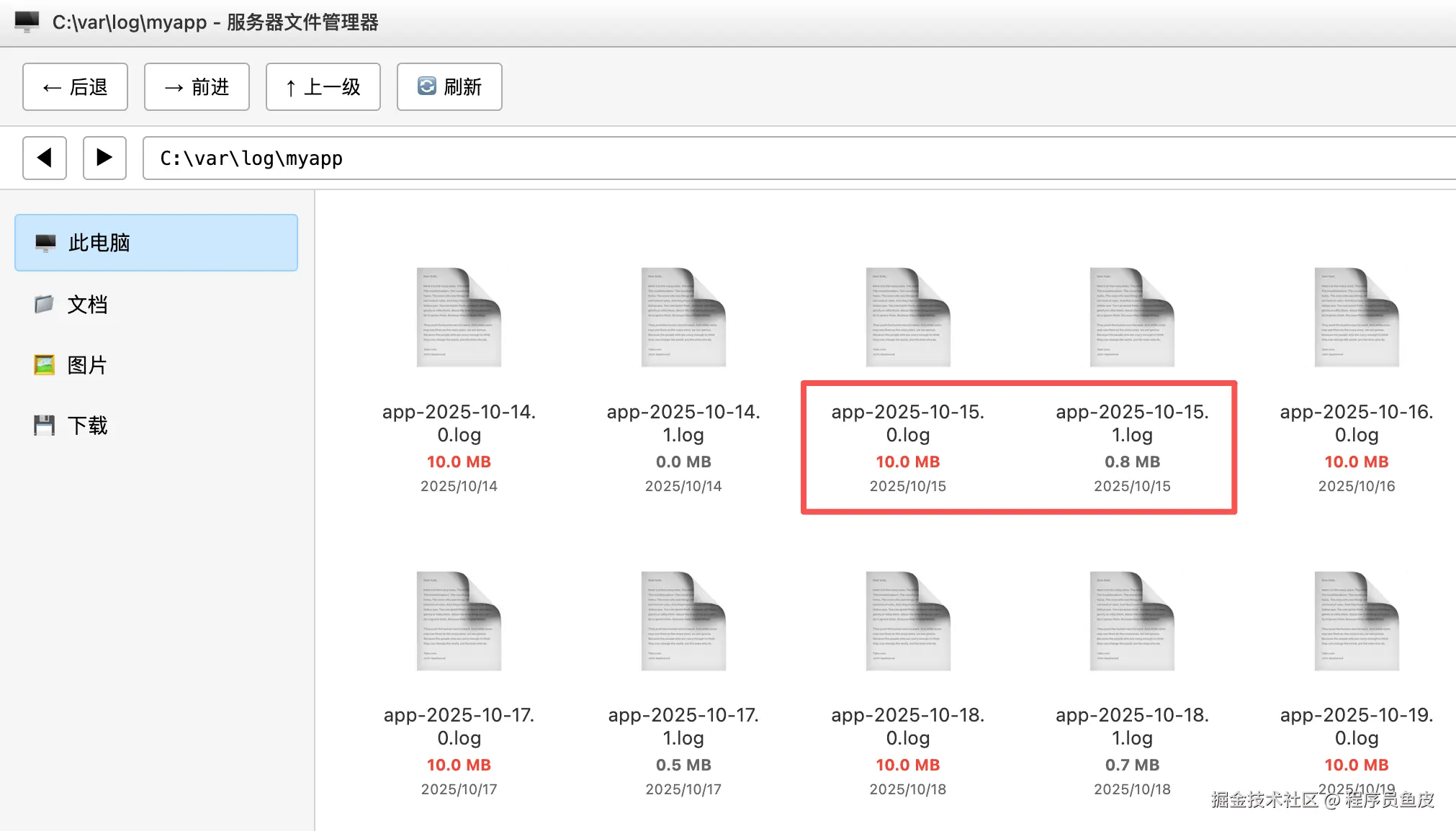

你完全不慌,淡定地打开服务器的日志文件。结果瞬间呆住了……

好家伙,满屏都是密密麻麻的日志,这可怎么看啊?!

鱼皮看了看你的代码,摇了摇头:你现在每导入一条数据都要打一些日志,如果用户导入 10 万条数据,那就是几十万条日志!不仅刷屏,还会影响性能。

你有点委屈:不是你让我多打日志的么?那我应该怎么办?

鱼皮:你需要控制日志的输出量。

1)可以添加条件来控制,比如每处理 100 条数据时才记录一次:

if ((i + 1) % 100 == 0) {

log.info("批量导入进度:{}/{}", i + 1, userList.size());

}

2)或者在循环中利用 StringBuilder 进行字符串拼接,循环结束后统一输出:

StringBuilder logBuilder = new StringBuilder("处理结果:");

for (UserDTO userDTO : userList) {

processUser(userDTO);

logBuilder.append(String.format("成功[ID=%s], ", userDTO.getId()));

}

log.info(logBuilder.toString());

3)还可以通过修改日志配置文件,过滤掉特定级别的日志,防止日志刷屏:

<appender name="FILE" class="ch.qos.logback.core.FileAppender">

<file>logs/app.log</file>

<!-- 只允许 INFO 级别及以上的日志通过 -->

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>INFO</level>

</filter>

</appender>

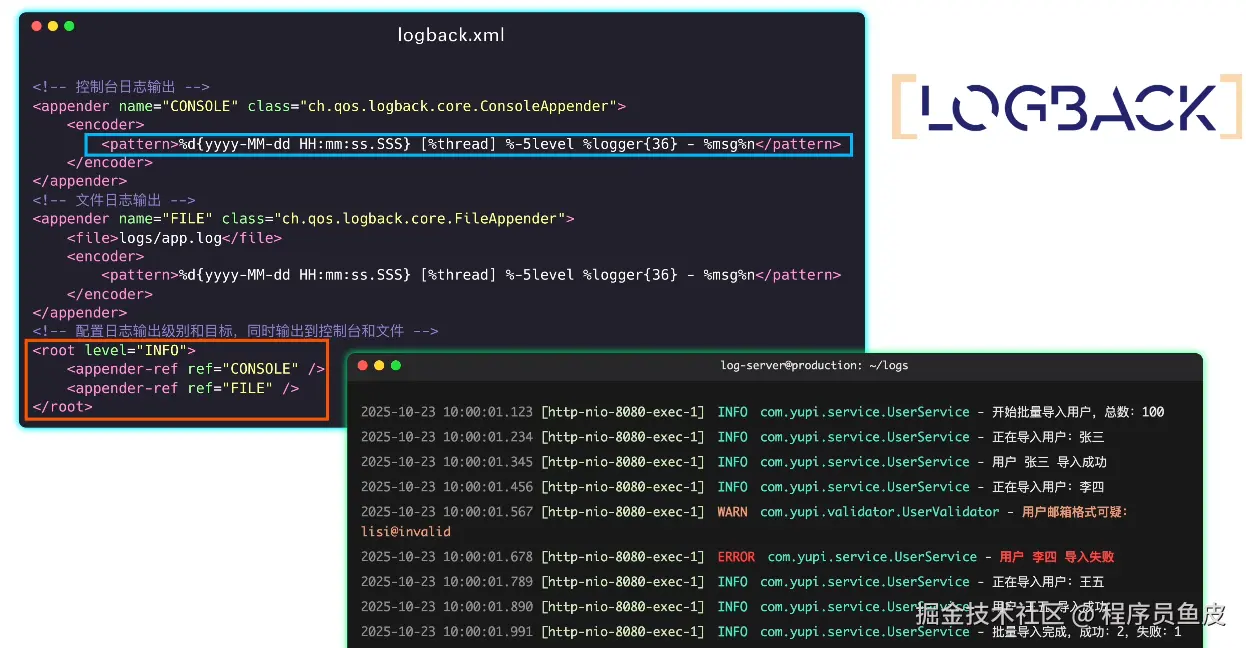

5、统一日志格式

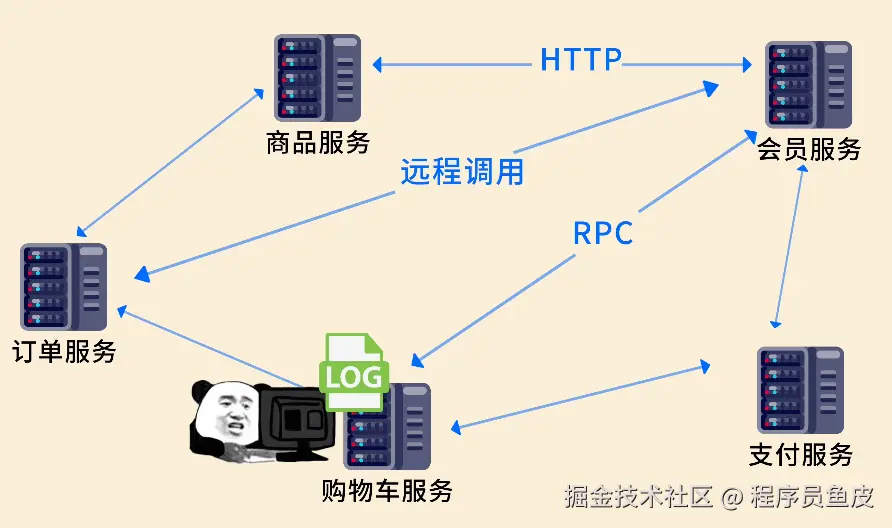

你开心了:好耶,这样就不会刷屏了!但是感觉有时候日志很杂很乱,尤其是我想看某一个请求相关的日志时,总是被其他的日志干扰,怎么办?

鱼皮:好问题,可以在日志配置文件中定义统一的日志格式,包含时间戳、线程名称、日志级别、类名、方法名、具体内容等关键信息。

<!-- 控制台日志输出 -->

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<!-- 日志格式 -->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n</pattern>

</encoder>

</appender>

这样输出的日志更整齐易读:

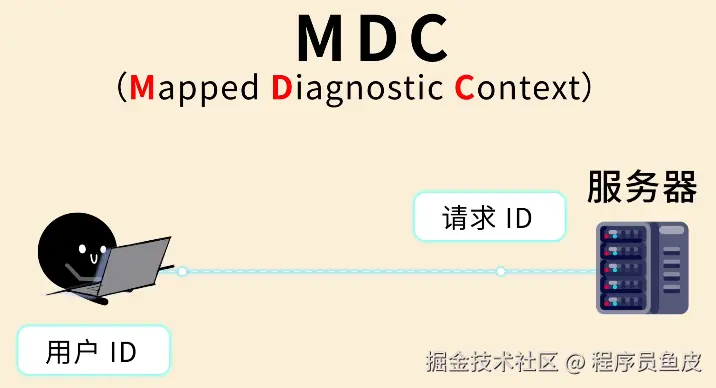

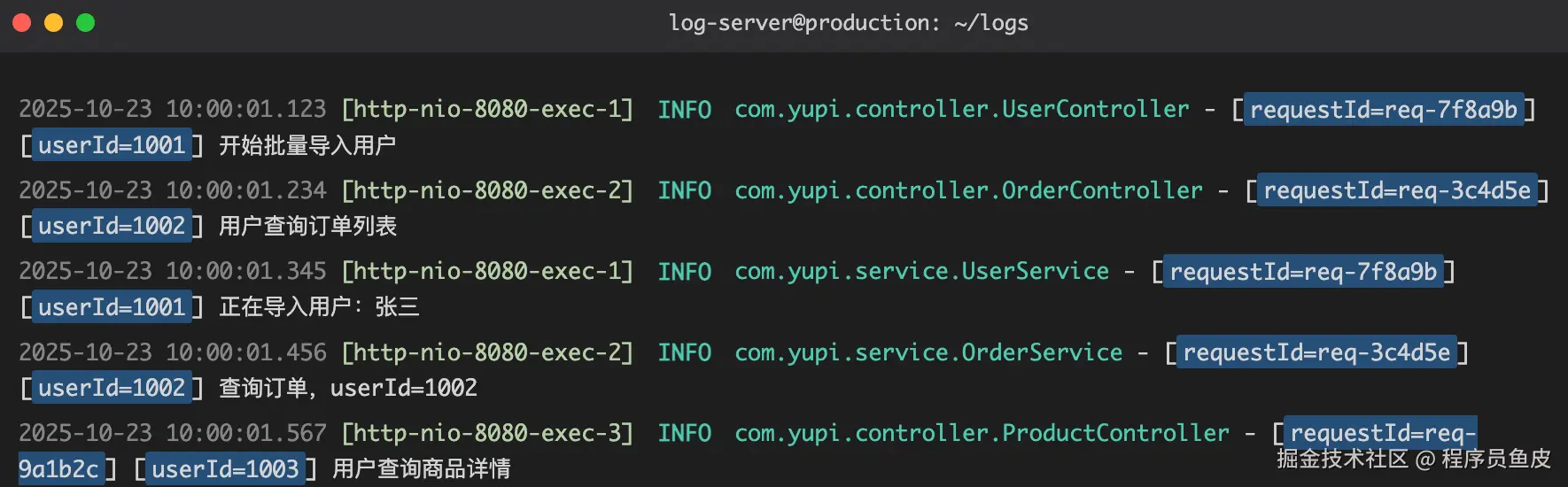

此外,你还可以通过 MDC(Mapped Diagnostic Context)给日志添加额外的上下文信息,比如请求 ID、用户 ID 等,方便追踪。

在 Java 代码中,可以为 MDC 设置属性值:

@PostMapping("/user/import")

public Result importUsers(@RequestBody UserImportRequest request) {

// 1. 设置 MDC 上下文信息

MDC.put("requestId", generateRequestId());

MDC.put("userId", String.valueOf(request.getUserId()));

try {

log.info("用户请求处理完成");

// 执行具体业务逻辑

userService.batchImport(request.getUserList());

return Result.success();

} finally {

// 2. 及时清理MDC(重要!)

MDC.clear();

}

}

然后在日志配置文件中就可以使用这些值了:

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<encoder>

<!-- 包含 MDC 信息 -->