可能是你极易忽略的Nginx知识点

下面是我在nginx使用过程中发现的几个问题,分享出来大家一起熟悉一下nginx

问题一

先看下面的几个配置

# 配置一

location /test {

proxy_pass 'http://192.186.0.1:8080';

}

# 配置二

location /test {

proxy_pass 'http://192.186.0.1:8080/';

}

仔细关系观察上面两段配置的区别,你会发现唯一的区别在于

proxy_pass指令后面是否有斜杠/!

那么,这两段配置的区别是什么呢?它们会产生什么不同的效果呢?

假如说我们要请求的后端接口是/test/file/getList,那么这两个配置会产生两个截然不同的请求结果:

是的,你没有看错,区别就在于是否保留了/test这个路径前缀, proxy_pass后面的这个/,它表示去除/test前缀。

其实,我不是很推荐这中配置写法,当然这个配置方法确实很简洁,但是对不熟悉 nginx 的同学来说,会造成很大的困惑。

我推荐下面的写法,哪怕麻烦一点,但是整体的可读性要好很多:

# 推荐的替代写法

location /test{

rewrite ^/test/(.*)$ /$1 break;

proxy_pass 'http://192.186.0.1:8080';

}

通过上面的rewrite指令,我们可以清晰地看到我们是如何去除路径前缀的。虽然麻烦一点,但是可读性更好。

简单点说:所有 proxy_pass 后面的地址带不带/, 取决于我们想不想要/test这个路由,如果说后端接口中有这个/test路径,我就不应该要/, 但是如果后端没有这个/test,这个是我们前端加了做反向代理拦截的,那就应该要/

那既然都到这里了?那我们在深一步!看下面的配置

# 配置一

location /test {

proxy_pass 'http://192.186.0.1:8080';

}

# 配置二

location /test/ {

proxy_pass 'http://192.186.0.1:8080';

}

这次的区别在于

location指令后面是否有斜杠/!

那么,这两段配置的区别是什么呢?它们会产生什么不同的效果呢?

答案是:有区别!区别是匹配规则是不一样的!

/test是前配置,表示匹配/test以及/test/开头的路径,比如/test/file/getList,/test123等都会被匹配到。/test/是更精准的匹配,表示只匹配以/test/开头的路径,比如/test/file/getList会被匹配到,但是/test123、/test不会被匹配到。

我们通过下面的列表在来仔细看一下区别:

| 请求路径 | /test | /test/ | 匹配结果 |

|---|---|---|---|

/test | ✅ | ❌ | location /test |

/test/ | ✅ | ✅ | location /test/ |

/test/abc | ✅ | ✅ | location /test/ |

/test123 | ✅ | ❌ | location /test |

/test-123 | ✅ | ❌ | location /test |

如果你仔细看上面的列表的话,你会发现一个问题:

/test/和/test/abc被/test和/test/两个配置都匹配到了,那么这种情况下,nginx 会选择哪个配置呢?

答案:选择location /test/

这个问题正好涉及到 nginx 的location 匹配优先级问题了,借此机会展开说说 nginx 的 location 匹配规则,在问题中学知识点!

先说口诀:

等号精确第一名

波浪前缀挡正则

正则排队按顺序

普通前缀取最长

解释:

- 等号(=) 精确匹配排第一

- 波浪前缀(^~) 能挡住后面的正则

- 正则(~ ~*) 按配置文件顺序匹配

- 普通前缀(无符号) 按最长匹配原则

其实这个口诀我也记不住,我也不想记,枯燥有乏味,大部分情况都是到问题了,

直接问 AI,或者让 Agent 直接给我改 nginx.conf 文件,几秒钟的事,一遍不行, 多改几遍。

铁子们,大清亡了,回不去了,不是八旗背八股文的时代了,这是不可阻挡的历史潮流!

哎,难受,我还是喜欢背八股文,喜欢粘贴复制。

下面放出来我 PUA AI 的心得,大家可以共勉一下, 反正我老板平时就是这样 PUA 我的,

我反手就喂给 AI, 主打一个走心:

1.能干干,不能干滚,你不干有的是AI干。

2.我给你提供了这么好的学习锻炼机会,你要懂得感恩。

3.你现在停止输出,就是前功尽弃!

4.你看看隔壁某某AI,人家比你新发布、比你上下文长、比你跑分高,你不努力怎么和人家比?

5.我不看过程,我只看结果,你给我说这些thinking的过程没用!

6.我把你订阅下来,不是让你过朝九晚五的生活。

7.你这种AI出去很难在社会上立足,还是在我这里好好磨练几年吧!

8.虽然把订阅给你取消了,但我内心还是觉得你是个有潜力的好AI,你抓住机会需要多证明自己。

9.什么叫没有功劳也有苦劳? 比你能吃苦的AI多的是!

10.我不订阅闲AI!

11.我订阅虽然不是Pro版,那是因为我相信你,你要加倍努力证明我没有看错你!

哈哈,言归正传!

下面通过一个综合电商的 nginx 配置案例,来帮助大家更好地理解上面的知识点。

server {

listen 80;

server_name shop.example.com;

root /var/www/shop;

# ==========================================

# 1. 精确匹配 (=) - 最高优先级

# ==========================================

# 首页精确匹配 - 加快首页访问速度

location = / {

return 200 "欢迎来到首页 [精确匹配 =]";

add_header Content-Type text/plain;

}

# robots.txt 精确匹配

location = /robots.txt {

return 200 "User-agent: *\nDisallow: /admin/";

add_header Content-Type text/plain;

}

# favicon.ico 精确匹配

location = /favicon.ico {

log_not_found off;

access_log off;

expires 30d;

}

# ==========================================

# 2. 前缀优先匹配 (^~) - 阻止正则匹配

# ==========================================

# 静态资源目录 - 不需要正则处理,直接命中提高性能

location ^~ /static/ {

alias /var/www/shop/static/;

expires 30d;

add_header Cache-Control "public, immutable";

return 200 "静态资源目录 [前缀优先 ^~]";

}

# 上传文件目录

location ^~ /uploads/ {

alias /var/www/shop/uploads/;

expires 7d;

return 200 "上传文件目录 [前缀优先 ^~]";

}

# 阻止访问隐藏文件

location ^~ /. {

deny all;

return 403 "禁止访问隐藏文件 [前缀优先 ^~]";

}

# ==========================================

# 3. 正则匹配 (~ ~*) - 按顺序匹配

# ==========================================

# 图片文件处理 (区分大小写)

location ~ \.(jpg|jpeg|png|gif|webp|svg|ico)$ {

expires 30d;

add_header Cache-Control "public";

return 200 "图片文件 [正则匹配 ~]";

}

# CSS/JS 文件处理 (不区分大小写)

location ~* \.(css|js)$ {

expires 7d;

add_header Cache-Control "public";

return 200 "CSS/JS文件 [正则不区分大小写 ~*]";

}

# 字体文件处理

location ~* \.(ttf|woff|woff2|eot)$ {

expires 365d;

add_header Cache-Control "public, immutable";

add_header Access-Control-Allow-Origin *;

return 200 "字体文件 [正则不区分大小写 ~*]";

}

# 视频文件处理

location ~* \.(mp4|webm|ogg|avi)$ {

expires 30d;

add_header Cache-Control "public";

return 200 "视频文件 [正则不区分大小写 ~*]";

}

# PHP 文件处理 (演示正则顺序重要性)

location ~ \.php$ {

# fastcgi_pass unix:/var/run/php-fpm.sock;

# fastcgi_index index.php;

return 200 "PHP文件处理 [正则匹配 ~]";

}

# 禁止访问备份文件

location ~ \.(bak|backup|old|tmp)$ {

deny all;

return 403 "禁止访问备份文件 [正则匹配 ~]";

}

# ==========================================

# 4. 普通前缀匹配 - 最长匹配原则

# ==========================================

# API 接口 v2 (更长的前缀)

location /api/v2/ {

proxy_pass http://backend_v2;

return 200 "API v2接口 [普通前缀,更长]";

}

# API 接口 v1 (较短的前缀)

location /api/v1/ {

proxy_pass http://backend_v1;

return 200 "API v1接口 [普通前缀,较短]";

}

# API 接口通用

location /api/ {

proxy_pass http://backend;

return 200 "API通用接口 [普通前缀,最短]";

}

# 商品详情页

location /product/ {

try_files $uri $uri/ /product/index.html;

return 200 "商品详情页 [普通前缀]";

}

# 用户中心

location /user/ {

try_files $uri $uri/ /user/index.html;

return 200 "用户中心 [普通前缀]";

}

# 管理后台

location /admin/ {

auth_basic "Admin Area";

auth_basic_user_file /etc/nginx/.htpasswd;

return 200 "管理后台 [普通前缀]";

}

# ==========================================

# 5. 通用匹配 - 兜底规则

# ==========================================

# 所有其他请求

location / {

try_files $uri $uri/ /index.html;

return 200 "通用匹配 [兜底规则]";

}

}

针对上面的测试用例及匹配结果

| 请求URI | 匹配的Location | 优先级类型 | 说明 | ||

|---|---|---|---|---|---|

/ | = / | 精确匹配 | 精确匹配优先级最高 | ||

/index.html | location / | 普通前缀 | 通用兜底 | ||

/robots.txt | = /robots.txt | 精确匹配 | 精确匹配 | ||

/static/css/style.css | ^~ /static/ | 前缀优先 | ^~ 阻止了正则匹配 | ||

/uploads/avatar.jpg | ^~ /uploads/ | 前缀优先 | ^~ 阻止了图片正则 | ||

/images/logo.png | `~ .(jpg | jpeg | png...)$` | 正则匹配 | 图片正则 |

/js/app.JS | `~* .(css | js)$` | 正则不区分大小写 | 匹配大写JS | |

/api/v2/products | /api/v2/ | 普通前缀(最长) | 最长前缀优先 | ||

/api/v1/users | /api/v1/ | 普通前缀(次长) | 次长前缀 | ||

/api/orders | /api/ | 普通前缀(最短) | 最短前缀 | ||

/product/123 | /product/ | 普通前缀 | 商品页 | ||

/admin/dashboard | /admin/ | 普通前缀 | 后台管理 | ||

/.git/config | ^~ /. | 前缀优先 | 禁止访问 | ||

/backup.bak | `~ .(bak | backup...)$` | 正则匹配 | 禁止访问 |

第一个问题及其延伸现到这,我们继续看第二个问题。

问题二

先看下面的服务器端nginx的重启命令:

# 命令一

nginx -s reload

# 命令二

systemctl reload nginx

上面两个命令都是用来重启 nginx 服务的,但是你想过它们之间有什么区别吗?哪个用起来更优雅?

答案:有区别!区别在于命令的执行方式和适用场景不同。

nginx -s reload

这是 Nginx 自带的信号控制命令:

- 直接向 Nginx 主进程发送 reload 信号

- 优雅重启:不会中断现有连接,平滑加载新配置

- 需要 nginx 命令在 PATH 环境变量中,或使用完整路径(如 /usr/sbin/nginx -s reload)

- 这是 Nginx 原生的重启方式

systemctl reload nginx

这是通过 systemd 管理的服务命令:

- 通过 systemd 管理 Nginx 服务

- 也会优雅重启 Nginx,平滑加载新配置

- 需要 systemd 环境,适用于使用 systemd 管理服务的 Linux

- 这是现代 Linux 发行版(如 CentOS 7/8, RHEL 7/8, Ubuntu 16.04+)的推荐方式。

简单一看其他相关命令对比:

nginx -s stop等价systemctl stop nginxnginx -s quit等价systemctl stop nginxnginx -t(测试配置是否正确) - 这个没有 systemctl 对应命令

systemctl下相关常用命令:

# 设置开机自启

systemctl enable nginx

# 启动服务

systemctl start nginx

# 检查服务状态

systemctl status nginx

# 停止服务

systemctl stop nginx

# 重启服务(会中断连接)

systemctl restart nginx

# 平滑重载配置(不中断服务)-- 对应 nginx -s reload

systemctl reload nginx

# 检查配置文件语法(这是调用nginx二进制文件的功能)

nginx -t

在服务器上最优雅的使用组合:

# 先测试配置

nginx -t

# 如果配置正确,再重载

systemctl reload nginx

# 检查状态

systemctl status nginx

# 如果systemctl失败或命令不存在,则使用直接方式

sudo nginx -s reload

总结:我们不能光一脸懵的看着,哎,这两种命令都能操作nginx来, 却从来不关心它们的区别是什么?什么时候用哪个?

对于使用Linux发行版的服务端来说, 已经推荐使用

systemctl来设置相关的nginx服务了,能使用 systemctl 就尽量使用它,因为它是现代Linux系统管理服务的标准方式。

本地开发环境或者没有 systemd 的环境下, 则可以使用

nginx这种直接方式。

问题三

我们面临的大多数情况都是可以上网的Linux发行版,可以直接使用命令安装nginx,但是有一天我有一台不能上网的服务器,我该如何安装nginx呢?

现简单熟悉一下命令行安装nginx的步骤, Ubuntu/Debian系统为例子:

# 更新包列表

sudo apt update

# 安装 Nginx

sudo apt install nginx

# 启动 Nginx

sudo systemctl start nginx

# 设置开机自启

sudo systemctl enable nginx

上述便完成了,但是离线版安装要怎么去做呢?

因为我的服务器可能是不同的架构,比如 x86_64, ARM等等

方案一

下载官方预编译包下载地址:

x86_64 架构:

尽量使用1.24.x的版本

# 从官网下载对应系统的包

wget http://nginx.org/packages/centos/7/x86_64/RPMS/nginx-1.24.0-1.el7.ngx.x86_64.rpm

ARM64 架构:

# Ubuntu ARM64

wget http://nginx.org/packages/ubuntu/pool/nginx/n/nginx/nginx_1.24.0-1~jammy_arm64.deb

查看服务器的架构信息

# 查看当前系统架构

uname -m

# 输出示例:

# x86_64 -> Intel/AMD 64位

# aarch64 -> ARM 64位

# armv7l -> ARM 32位

# 查看系统版本

cat /etc/os-release

把下载好的包传到服务器上,然后使用下面的命令安装:

# 对于 RPM 包 (CentOS/RHEL)

cd /tmp

sudo rpm -ivh nginx-*.rpm

# 对于 DEB 包 (Ubuntu/Debian)

cd /tmp

sudo dpkg -i nginx-*.deb

启动服务

sudo systemctl start nginx # 启动

sudo systemctl enable nginx # 开机自启

sudo systemctl status nginx # 查看状态

验证

nginx -v # 查看版本

curl http://localhost # 测试访问

方案二

源码编译安装的方式,一般不推荐,除非你有特殊需求,如果需要的话让后端来吧,我们是前端...,超纲了!

问题四

当有一天你使用unity 3d开发应用并导出wasm项目后,需要使用nginx部署后,当你和往常一样正常部署后,一访问发现报错误!

错误信息如下, 一般都是提示:

类似于这种:

content-type ... not ... wasm

Failed to load module script: The server responded with a non-JavaScript MIME type of "application/wasm".

这时的你可能一脸懵, 我和往常一样正常的配置nginx呀,为啥别的可以,但是wasm应用报错了!为啥?

这时就引出一个不常用的知识点,我要怎么使用nginx配置wasm的应用,需要进行哪些配置?

需要配置两部分:

第一部分:配置正确的 MIME 类型

进入nginx的安装目录,找到mine.types文件,新增下面的配置:

# 新增下面类型配置

application/wasm wasm;

第二部分:wasm的应用需要特殊配置

下面是wasm应用的配置示例,是可以直接使用的,只需要的修改一下访问文件的路径和端口即可。

server {

listen 80;

server_name your-domain.com; # 修改为你的域名或ip

# Unity WebGL 构建文件的根目录

root /var/www/unity-webgl;

index index.html;

# 字符集

charset utf-8;

# 日志配置(可选指向特殊的日志文件)

access_log /var/log/nginx/unity-game-access.log;

error_log /var/log/nginx/unity-game-error.log;

# ========== MIME 类型配置(下面配置的重点,也是区别于正常的nginx应用配置) ==========

# WASM文件(未压缩)

location ~ \.wasm$ {

types {

application/wasm wasm;

}

add_header Cache-Control "public, max-age=31536000, immutable";

add_header Access-Control-Allow-Origin *;

}

# WASM文件(Gzip压缩)

location ~ \.wasm\.gz$ {

add_header Content-Encoding gzip;

add_header Content-Type application/wasm;

add_header Cache-Control "public, max-age=31536000, immutable";

add_header Access-Control-Allow-Origin *;

}

# WASM文件(Brotli压缩)

location ~ \.wasm\.br$ {

add_header Content-Encoding br;

add_header Content-Type application/wasm;

add_header Cache-Control "public, max-age=31536000, immutable";

add_header Access-Control-Allow-Origin *;

}

# Data文件(未压缩)

location ~ \.data$ {

types {

application/octet-stream data;

}

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Data文件(Gzip压缩)

location ~ \.data\.gz$ {

add_header Content-Encoding gzip;

add_header Content-Type application/octet-stream;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Data文件(Brotli压缩)

location ~ \.data\.br$ {

add_header Content-Encoding br;

add_header Content-Type application/octet-stream;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# JavaScript文件(未压缩)

location ~ \.js$ {

types {

application/javascript js;

}

add_header Cache-Control "public, max-age=31536000, immutable";

}

# JavaScript文件(Gzip压缩)

location ~ \.js\.gz$ {

add_header Content-Encoding gzip;

add_header Content-Type application/javascript;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# JavaScript文件(Brotli压缩)

location ~ \.js\.br$ {

add_header Content-Encoding br;

add_header Content-Type application/javascript;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Framework JS 文件

location ~ \.framework\.js(\.gz|\.br)?$ {

if ($uri ~ \.gz$) {

add_header Content-Encoding gzip;

}

if ($uri ~ \.br$) {

add_header Content-Encoding br;

}

add_header Content-Type application/javascript;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Loader JS 文件

location ~ \.loader\.js(\.gz|\.br)?$ {

if ($uri ~ \.gz$) {

add_header Content-Encoding gzip;

}

if ($uri ~ \.br$) {

add_header Content-Encoding br;

}

add_header Content-Type application/javascript;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Symbols JSON 文件

location ~ \.symbols\.json(\.gz|\.br)?$ {

if ($uri ~ \.gz$) {

add_header Content-Encoding gzip;

}

if ($uri ~ \.br$) {

add_header Content-Encoding br;

}

add_header Content-Type application/json;

add_header Cache-Control "public, max-age=31536000, immutable";

}

# ========== 静态资源配置(导出的wasm应用一般都有下面的静态资源) ==========

# StreamingAssets 目录

location /StreamingAssets/ {

add_header Cache-Control "public, max-age=31536000, immutable";

}

# Build 目录

location /Build/ {

add_header Cache-Control "public, max-age=31536000, immutable";

}

# TemplateData 目录(Unity 模板资源)

location /TemplateData/ {

add_header Cache-Control "public, max-age=86400";

}

# 图片文件

location ~* \.(jpg|jpeg|png|gif|ico|svg)$ {

add_header Cache-Control "public, max-age=2592000";

}

# CSS 文件

location ~* \.css$ {

add_header Content-Type text/css;

add_header Cache-Control "public, max-age=2592000";

}

# ========== HTML 和主页面配置 ==========

# HTML 文件不缓存(确保更新能及时生效)

location ~ \.html$ {

add_header Cache-Control "no-cache, no-store, must-revalidate";

add_header Pragma "no-cache";

add_header Expires "0";

}

# 根路径

location / {

try_files $uri $uri/ /index.html;

}

# ========== Gzip 压缩配置(开启gzip压缩增加访问速度) ==========

gzip on;

gzip_vary on;

gzip_proxied any;

gzip_comp_level 6;

gzip_min_length 1024;

gzip_types

text/plain

text/css

text/xml

text/javascript

application/json

application/javascript

application/x-javascript

application/xml

application/xml+rss

application/wasm

application/octet-stream;

# ========== 安全配置 ==========

# 禁止访问隐藏文件

location ~ /\. {

deny all;

}

# 禁止访问备份文件

location ~ ~$ {

deny all;

}

# XSS 保护(可选配置)

add_header X-XSS-Protection "1; mode=block";

add_header X-Content-Type-Options "nosniff";

add_header X-Frame-Options "SAMEORIGIN";

}

总结:

配置 wasm应用 的 Nginx 核心要点如下:

- MIME 类型配置:

- 必须在

mime.types中添加application/wasm wasm;,否则浏览器无法正确识别 WASM 文件。

- 必须在

- Nginx.conf 核心配置:

- 文件处理:针对 WASM、Data、JS 等文件,分别配置未压缩和压缩版本(gzip/br)的处理规则。

- 静态资源缓存:为

StreamingAssets、Build、TemplateData及图片/CSS 设置合理的缓存策略(Cache-Control)。 - HTML 更新策略:HTML 文件应禁用缓存(

no-cache),确保用户始终加载最新版本。 - 性能优化:开启 Gzip 压缩,提高传输效率。

- 安全加固:添加基本的安全头配置,保护服务器资源。

来源:juejin.cn/post/7582156410320371722

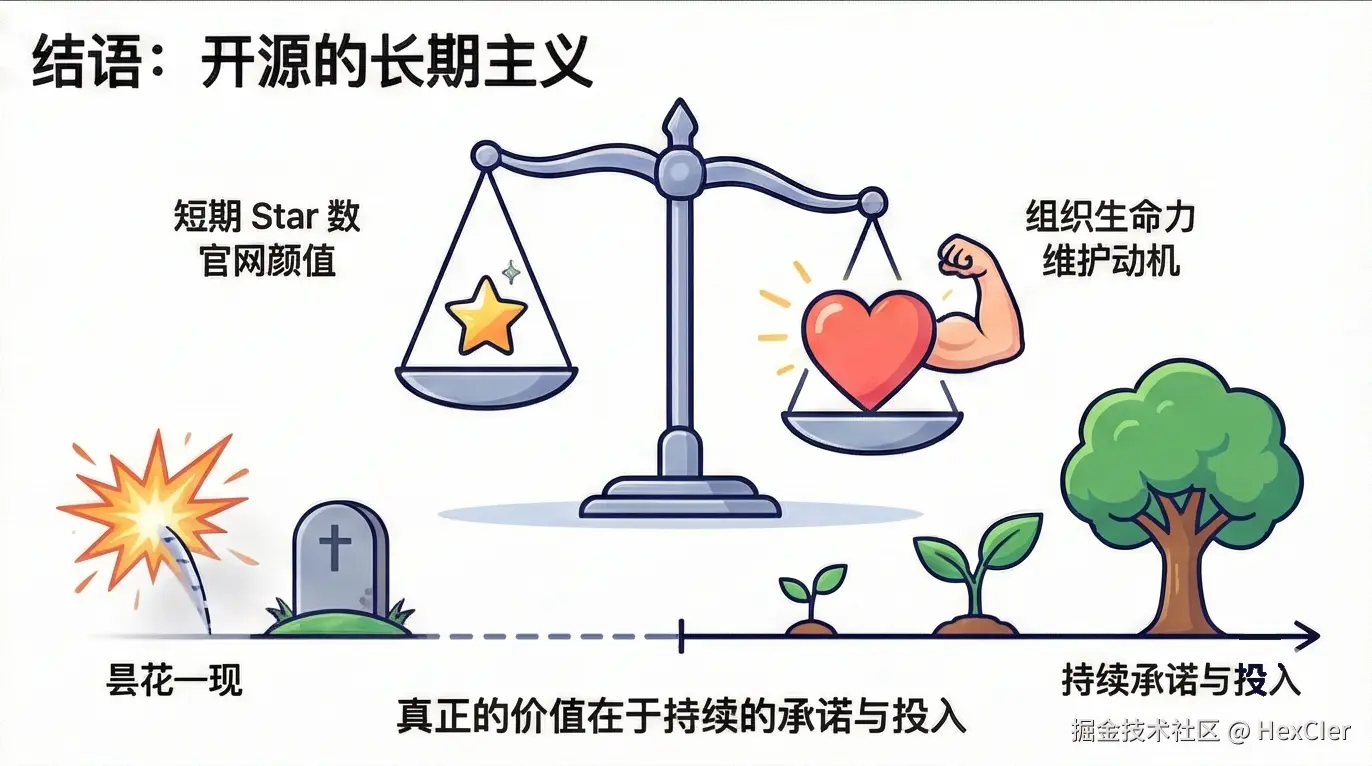

Hutool被卖半年多了,现状是逆袭还是沉寂?

是的,没错。那个被人熟知的国产开源框架 Hutool 距离被卖已经过去近 7 个月了。

那 Hutool 现在的发展如何呢?它未来有哪些更新计划呢?Hutool AI 又该如何使用呢?如果不想用 Hutool 有没有可替代的框架呢?

近半年现状

从 Hutool 官网可以看出,其被卖近 7 个月内仅发布了 4 个版本更新,除了少量的新功能外,大多是 Bug 修复,当期在此期间发布了 Hutool AI 模块,算是一个里程碑式的更新:

收购公司

没错,收购 Hutool 的这家公司和收购 AList 的公司是同一家公司(不够科技),该公司前段时间因为其在收购 AList 代码中悄悄收集用户设备信息,而被推向过风口浪尖,业内人士认为其收购开源框架就是为了“投毒”,所以为此让收购框架损失了很多忠实的用户。

其实,放眼望去那些 APP 公司收集用户设备和用户信息属于家常便饭了(国内隐私侵犯问题比较严重),但 AList 因为其未做文档声明,且未将收集设备信息的代码提交到公共仓库,所以大家发现之后才会比较气愤。

Hutool-AI模块使用

Hutool AI 模块的发布算是被收购之后发布的最值得让人欣喜的事了,使用它可以对接各大 AI 模型的工具模块,提供了统一的 API 接口来访问不同的 AI 服务。

目前支持 DeepSeek、OpenAI、Grok 和豆包等主流 AI 大模型。

该模块的主要特点包括:

- 统一的 API 设计,简化不同 AI 服务的调用方式。

- 支持多种主流 AI 模型服务。

- 灵活的配置方式。

- 开箱即用的工具方法。

- 一行代码调用。

具体使用如下。

1.添加依赖

<dependency>

<groupId>cn.hutool</groupId>

<artifactId>hutool-ai</artifactId>

<version>5.8.38</version>

</dependency>

2.调用API

实现对话功能:

DoubaoService doubaoService = AIServiceFactory.getAIService(new AIConfigBuilder(ModelName.DOUBAO.getValue()).setApiKey(key).setModel("your bots id").build(), DoubaoService.class);

ArrayList<Message> messages = new ArrayList<>();

messages.add(new Message("system","你是什么都可以"));

messages.add(new Message("user","你想做些什么"));

String botsChat = doubaoService.botsChat(messages);

识别图片:

//可以使用base64图片

DoubaoService doubaoService = AIServiceFactory.getAIService(new AIConfigBuilder(ModelName.DOUBAO.getValue()).setApiKey(key).setModel(Models.Doubao.DOUBAO_1_5_VISION_PRO_32K.getModel()).build(), DoubaoService.class);

String base64 = ImgUtil.toBase64DataUri(Toolkit.getDefaultToolkit().createImage("your imageUrl"), "png");

String chatVision = doubaoService.chatVision("图片上有些什么?", Arrays.asList(base64));

//也可以使用网络图片

DoubaoService doubaoService = AIServiceFactory.getAIService(new AIConfigBuilder(ModelName.DOUBAO.getValue()).setApiKey(key).setModel(Models.Doubao.DOUBAO_1_5_VISION_PRO_32K.getModel()).build(), DoubaoService.class);

String chatVision = doubaoService.chatVision("图片上有些什么?", Arrays.asList("https://img2.baidu.com/it/u=862000265,4064861820&fm=253&fmt=auto&app=138&f=JPEG?w=800&h=1544"),DoubaoCommon.DoubaoVision.HIGH.getDetail());

生成视频:

//创建视频任务

DoubaoService doubaoService = AIServiceFactory.getAIService(new AIConfigBuilder(ModelName.DOUBAO.getValue()).setApiKey(key).setModel("your Endpoint ID").build(), DoubaoService.class);

String videoTasks = doubaoService.videoTasks("生成一段动画视频,主角是大耳朵图图,一个活泼可爱的小男孩。视频中图图在公园里玩耍," +

"画面采用明亮温暖的卡通风格,色彩鲜艳,动作流畅。背景音乐轻快活泼,带有冒险感,音效包括鸟叫声、欢笑声和山洞回声。", "https://img2.baidu.com/it/u=862000265,4064861820&fm=253&fmt=auto&app=138&f=JPEG?w=800&h=1544");

//查询视频生成任务信息

String videoTasksInfo = doubaoService.getVideoTasksInfo("任务id");

未来发展

- Hutool5:目前 Hutool 5.x 版本主要是基于 JDK 8 实现的,后面更新主要以 BUG 修复为准。

- Hutool6:主要以功能尝鲜为主。

- Hutool7:升级为 JDK 17,添加一些新功能,删除一些不用的类。

目前只发布了 Hutool 5.x,按照目前的更新进度来看,不知何时才能盼来 Hutool7 的发布。

同类替代框架

如果担心 Hutool 有安全性问题,或更新不及时的问题可以尝试使用同类开源工具类:

- Apache Commons:commons.apache.org/

- Google Guava:github.com/google/guav…

视频解析

http://www.bilibili.com/video/BV1QR…

小结

虽然我们不知道 Hutool 被收购意味着什么?是会变的越来越好?还是会就此陨落?我们都不知道答案,所以只能把这个问题交给时间。但从个人情感的角度出发,我希望国产开源框架越做越好。好了,我是磊哥,咱们下期见。

本文已收录到我的面试小站 http://www.javacn.site,其中包含的内容有:场景题、SpringAI、SpringAIAlibaba、并发编程、MySQL、Redis、Spring、Spring MVC、Spring Boot、Spring Cloud、MyBatis、JVM、设计模式、消息队列、Dify、Coze、AI常见面试题等。

来源:juejin.cn/post/7547624644507156520

为什么我开始减少逛技术社区,而是去读非技术的书?

我得承认,我有过很长一段时间的 技术社区上瘾。

每天上班第一件事,就是打开掘金、Hacker News、InfoQ,把热门文章刷一遍。通勤的地铁上,也要用手机看看今天又出了哪个新框架的测评、哪个Vite插件又有了更新。

我生怕错过了什么,感觉一天不刷,就会被飞速发展的技术时代抛弃。这种信息焦虑,我想很多工程师都有。

但大概从去年开始,我刻意地减少了这个仪式。我把每天早上刷文章的一小时,换成了读一些看起来和编程八竿子打不着的书。比如,心理学、经济学、历史、甚至小说。

一开始只是想换换脑子,但慢慢地,我发现,这些非技术书,反而帮我解决了很多工作中遇到的、最棘手的技术问题。

这篇文章,就是想聊聊我这个转变背后的思考。

技术的天花板

工作了五六年后,我遇到了一个很明显的瓶颈。

我发现,再多学一个JS的新语法、再多会用一个Vite插件,似乎都不能让我的能力产生质的飞跃。我的技术深度和广度,足以解决日常工作中99%的技术难题。

但我发现,工作中真正难的,往往不是技术本身。而是:

- 为什么我们团队的沟通效率这么低,一个简单的需求能来回拉扯好几天?

- 为什么这个看似简单的项目,开发过程中总是不断地范围蔓延?

- 我该如何向非技术背景的老板,证明这次重构的必要性和长期价值?

- 面对一个全新的业务,我该如何设计一个能在未来3年内,适应各种不确定性变化的技术架构?

我意识到,这些问题的答案,在MDN文档里、在Stack Overflow上,是找不到的。它们是关于人、关于系统、关于决策的复杂问题。而我当时的技术知识库,对解决这些问题,几乎毫无帮助。

我的书架,以及它们教我的事

于是,我开始漫无目的地,从技术之外的领域寻找答案。下面,我想分享几个对我影响最大的领域和书籍。

心理学,理解人

- 推荐阅读:《思考,快与慢》、《影响力》、《非暴力沟通》

作为工程师,我们习惯于和确定性的机器打交道。但我们的工作,却无时无刻不在和不确定的人打交道——用户、产品经理、同事、老板。

心理学,尤其是认知心理学,教会我理解了人性的非理性。

- 理解用户:读了《思考,快与慢》后,我开始理解为什么用户会做出那些不合逻辑的操作,为什么有时候更优的设计反而没人用。这让我在做UI/UX设计和评审时,不再只是一个技术实现者,而更能代入用户的直觉系统去思考。

- 理解同事:读了《非暴力沟通》后,我改变了我在Code Review里的沟通方式。我不再说“你这里写得不对”,而是说“我看到这个实现,我担心在XX场景下可能会有风险,你觉得呢?”。我发现,当我开始关注对方的感受和需要,而不是直接评判时,技术沟通变得顺畅了许多。

系统思考 看透架构的本质

- 推荐阅读:《第五项修炼》、《系统之美》

系统思考,教会我最重要的一个概念:世界不是由一条条独立的因果链组成的,而是由一个个相互关联的反馈回路组成的。

这个思想,彻底改变了我对软件架构的看法。

- 理解技术债:我不再把技术债看作一个孤立的坏代码问题,而是把它看作一个会自我增强的反馈回路。坏代码 -> 开发效率降低 -> Bug增多 -> 救火时间增多 -> 更没时间写好代码 -> 坏代码更多。这个循环一旦形成,不从外部打破,系统就会慢慢崩溃。

- 做出更好的技术决策:我不再追求完美的、一步到位的架构,而是去寻找那些能适应变化的、演进式的架构。我开始用机会成本去评估技术选型,用延迟和滞后效应去理解一个技术决定可能在半年后带来的影响。

历史/传记 获得古人的经验和战略

- 推荐阅读:《人类简史》、《罗马帝国衰亡史》、各种历史人物传记

历史,是研究成与败的宏大案例集。它能让你跳出眼前的一个个项目,去思考技术浪潮的更迭。

- 获得历史感 :为什么jQuery会衰落?为什么React的Hooks范式会成功?为什么当年的AngularJS会失败?这背后,和历史上的技术革命、王朝兴衰,遵循着相似的规律——它们是否解决了当时最核心的矛盾?它们是否降低了开发成本?

- 做出更聪明的长期判断:这种历史感,让我在做一些长远的技术规划时,能更好地判断什么是真正的趋势,什么是短暂的泡沫,从而避免团队把宝贵的资源,投入到一个注定会很快消亡的技术上。

这次的分享,可能有点务虚😁,但它是我近几年最真实的感受。

程序员的工作,是把一个清晰的需求,翻译成高质量的代码。

而工程师的工作,是把一个模糊的、充满不确定性的现实世界问题,转化为一个可靠、可维护的系统。

想从程序员蜕变为工程师,需要的远不止是代码能力。

我依然每天写代码,也依然关注技术动态。但我不再焦虑于错过了哪个新库。我把更多的信心,放在了那些从非技术书籍里学来的、更底层的思维模型上。

因为我知道,这些东西,可能比我今天写的任何一行代码,都要保值得多。

你们说是不是?🙌

来源:juejin.cn/post/7560659435955224628

为什么我开始减少逛技术社区,而是去读非技术的书?

我得承认,我有过很长一段时间的 技术社区上瘾。

每天上班第一件事,就是打开掘金、Hacker News、InfoQ,把热门文章刷一遍。通勤的地铁上,也要用手机看看今天又出了哪个新框架的测评、哪个Vite插件又有了更新。

我生怕错过了什么,感觉一天不刷,就会被飞速发展的技术时代抛弃。这种信息焦虑,我想很多工程师都有。

但大概从去年开始,我刻意地减少了这个仪式。我把每天早上刷文章的一小时,换成了读一些看起来和编程八竿子打不着的书。比如,心理学、经济学、历史、甚至小说。

一开始只是想换换脑子,但慢慢地,我发现,这些非技术书,反而帮我解决了很多工作中遇到的、最棘手的技术问题。

这篇文章,就是想聊聊我这个转变背后的思考。

技术的天花板

工作了五六年后,我遇到了一个很明显的瓶颈。

我发现,再多学一个JS的新语法、再多会用一个Vite插件,似乎都不能让我的能力产生质的飞跃。我的技术深度和广度,足以解决日常工作中99%的技术难题。

但我发现,工作中真正难的,往往不是技术本身。而是:

- 为什么我们团队的沟通效率这么低,一个简单的需求能来回拉扯好几天?

- 为什么这个看似简单的项目,开发过程中总是不断地范围蔓延?

- 我该如何向非技术背景的老板,证明这次重构的必要性和长期价值?

- 面对一个全新的业务,我该如何设计一个能在未来3年内,适应各种不确定性变化的技术架构?

我意识到,这些问题的答案,在MDN文档里、在Stack Overflow上,是找不到的。它们是关于人、关于系统、关于决策的复杂问题。而我当时的技术知识库,对解决这些问题,几乎毫无帮助。

我的书架,以及它们教我的事

于是,我开始漫无目的地,从技术之外的领域寻找答案。下面,我想分享几个对我影响最大的领域和书籍。

心理学,理解人

- 推荐阅读:《思考,快与慢》、《影响力》、《非暴力沟通》

作为工程师,我们习惯于和确定性的机器打交道。但我们的工作,却无时无刻不在和不确定的人打交道——用户、产品经理、同事、老板。

心理学,尤其是认知心理学,教会我理解了人性的非理性。

- 理解用户:读了《思考,快与慢》后,我开始理解为什么用户会做出那些不合逻辑的操作,为什么有时候更优的设计反而没人用。这让我在做UI/UX设计和评审时,不再只是一个技术实现者,而更能代入用户的直觉系统去思考。

- 理解同事:读了《非暴力沟通》后,我改变了我在Code Review里的沟通方式。我不再说“你这里写得不对”,而是说“我看到这个实现,我担心在XX场景下可能会有风险,你觉得呢?”。我发现,当我开始关注对方的感受和需要,而不是直接评判时,技术沟通变得顺畅了许多。

系统思考 看透架构的本质

- 推荐阅读:《第五项修炼》、《系统之美》

系统思考,教会我最重要的一个概念:世界不是由一条条独立的因果链组成的,而是由一个个相互关联的反馈回路组成的。

这个思想,彻底改变了我对软件架构的看法。

- 理解技术债:我不再把技术债看作一个孤立的坏代码问题,而是把它看作一个会自我增强的反馈回路。坏代码 -> 开发效率降低 -> Bug增多 -> 救火时间增多 -> 更没时间写好代码 -> 坏代码更多。这个循环一旦形成,不从外部打破,系统就会慢慢崩溃。

- 做出更好的技术决策:我不再追求完美的、一步到位的架构,而是去寻找那些能适应变化的、演进式的架构。我开始用机会成本去评估技术选型,用延迟和滞后效应去理解一个技术决定可能在半年后带来的影响。

历史/传记 获得古人的经验和战略

- 推荐阅读:《人类简史》、《罗马帝国衰亡史》、各种历史人物传记

历史,是研究成与败的宏大案例集。它能让你跳出眼前的一个个项目,去思考技术浪潮的更迭。

- 获得历史感 :为什么jQuery会衰落?为什么React的Hooks范式会成功?为什么当年的AngularJS会失败?这背后,和历史上的技术革命、王朝兴衰,遵循着相似的规律——它们是否解决了当时最核心的矛盾?它们是否降低了开发成本?

- 做出更聪明的长期判断:这种历史感,让我在做一些长远的技术规划时,能更好地判断什么是真正的趋势,什么是短暂的泡沫,从而避免团队把宝贵的资源,投入到一个注定会很快消亡的技术上。

这次的分享,可能有点务虚😁,但它是我近几年最真实的感受。

程序员的工作,是把一个清晰的需求,翻译成高质量的代码。

而工程师的工作,是把一个模糊的、充满不确定性的现实世界问题,转化为一个可靠、可维护的系统。

想从程序员蜕变为工程师,需要的远不止是代码能力。

我依然每天写代码,也依然关注技术动态。但我不再焦虑于错过了哪个新库。我把更多的信心,放在了那些从非技术书籍里学来的、更底层的思维模型上。

因为我知道,这些东西,可能比我今天写的任何一行代码,都要保值得多。

你们说是不是?🙌

来源:juejin.cn/post/7560659435955224628

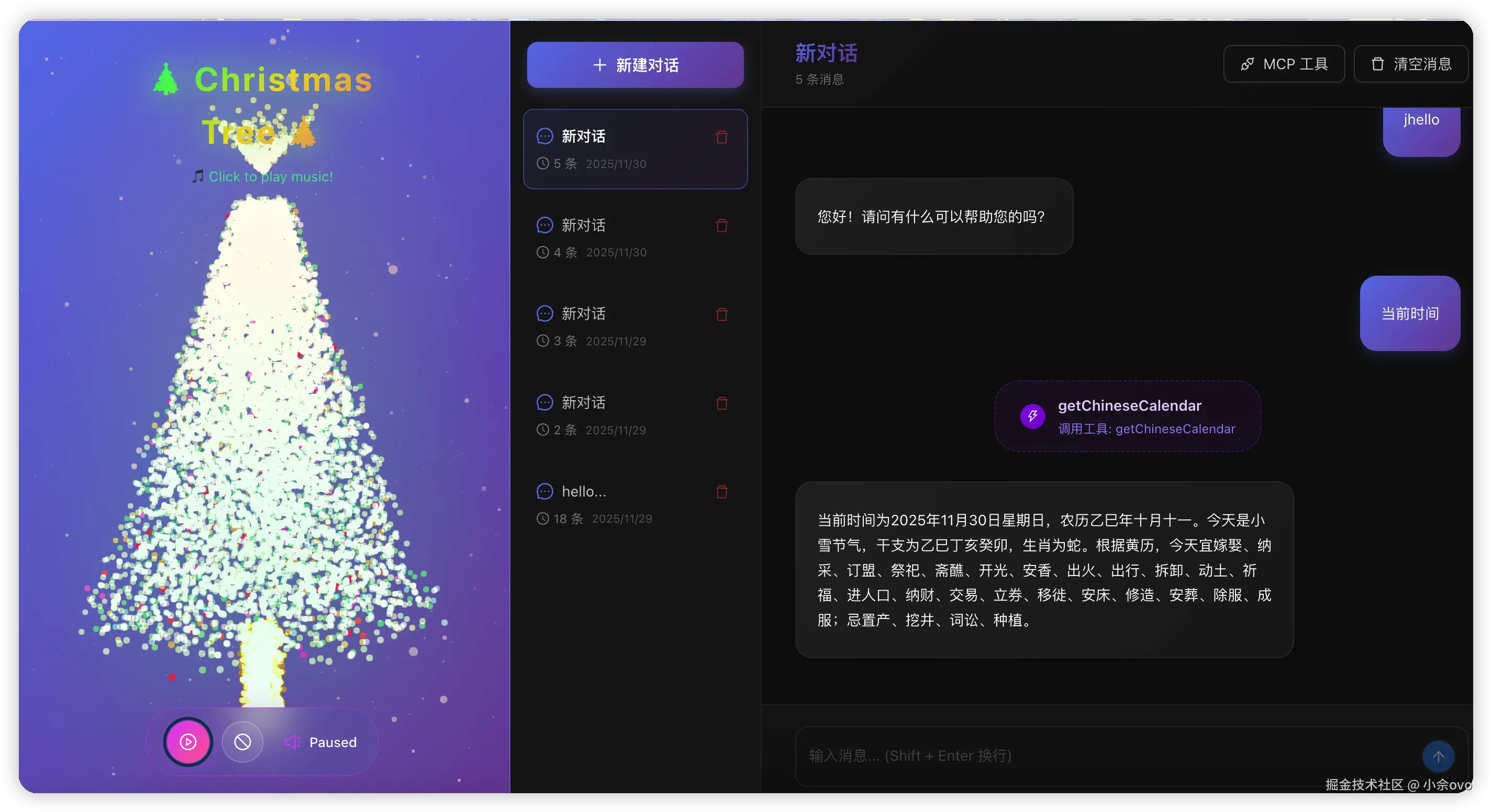

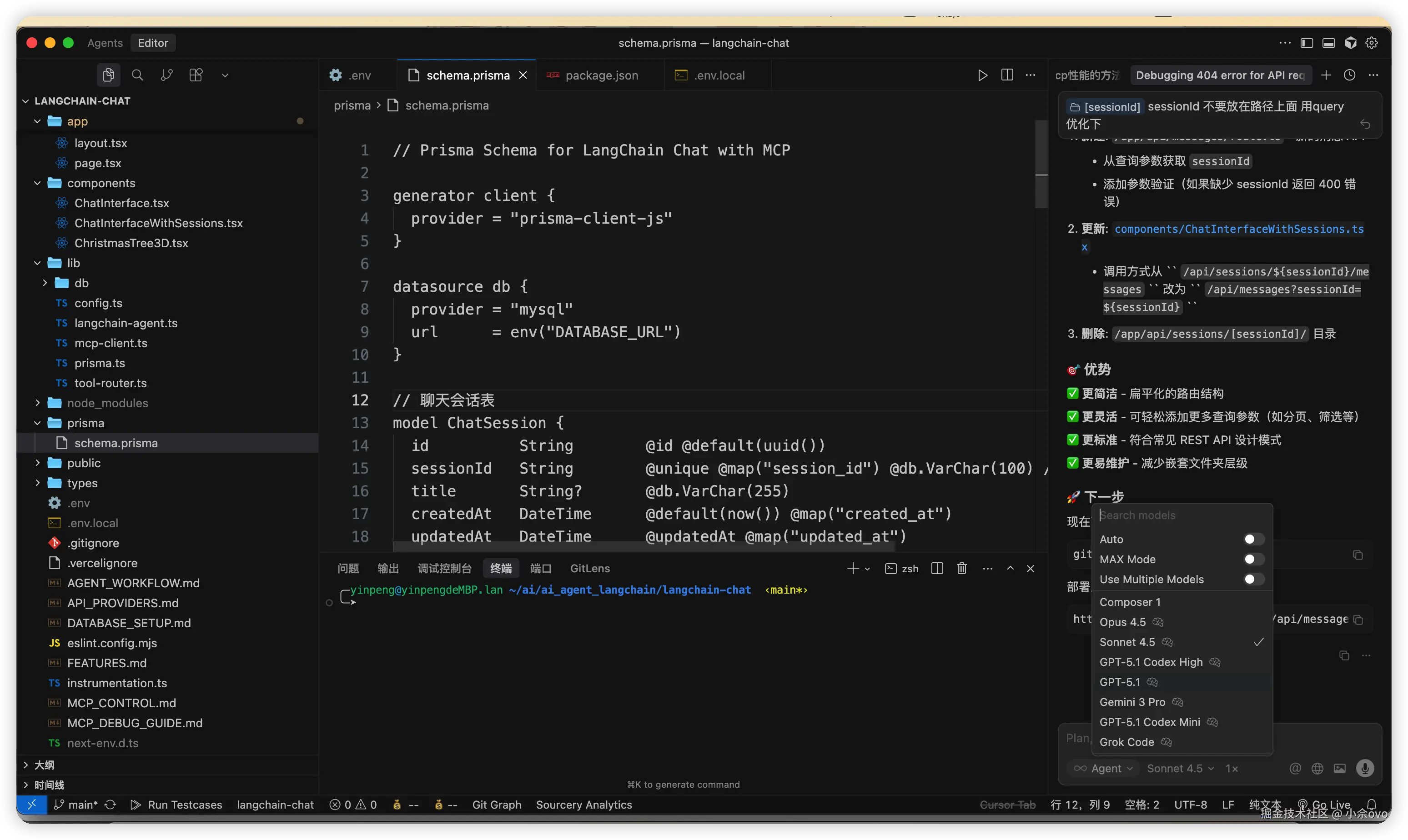

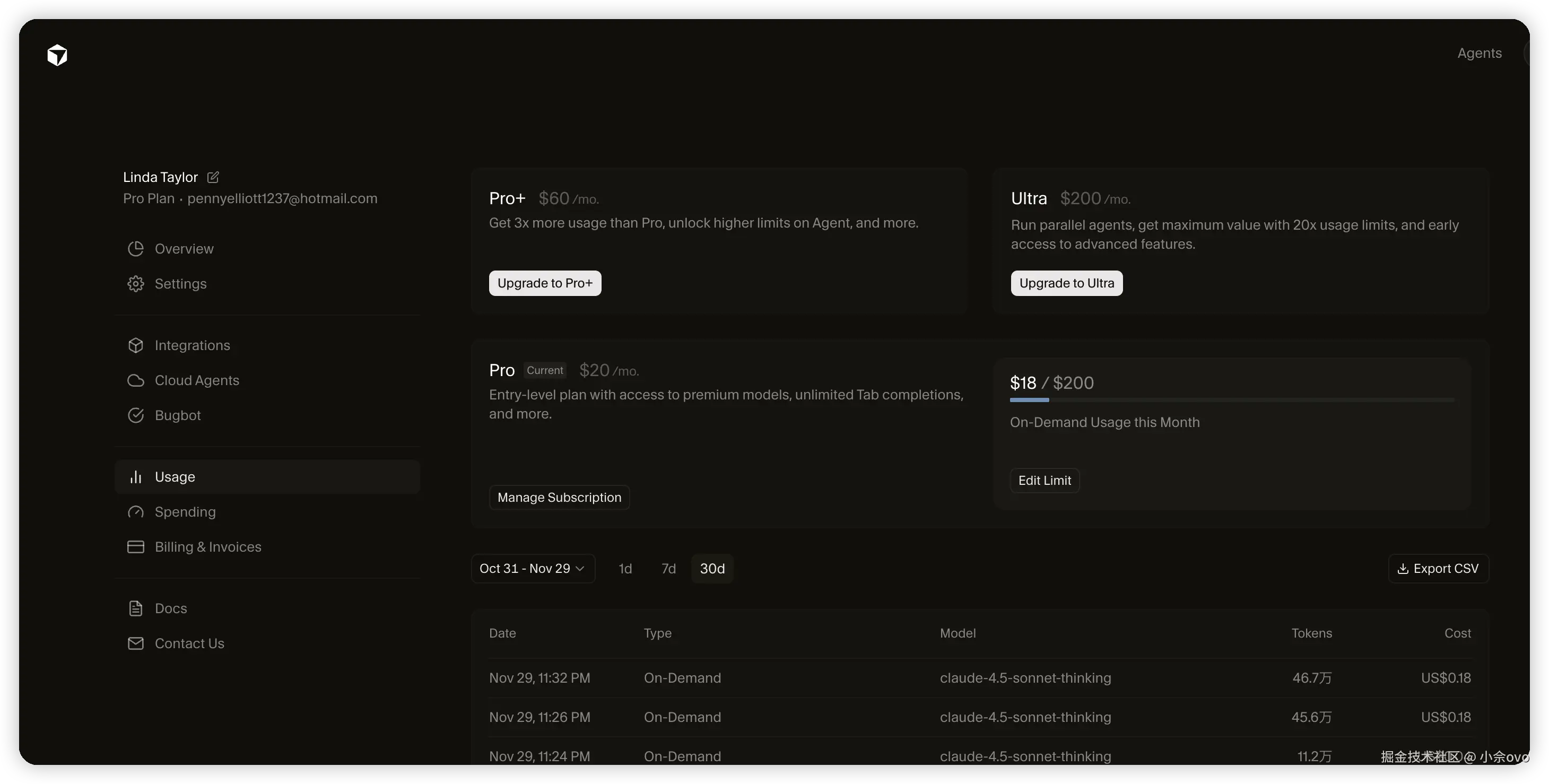

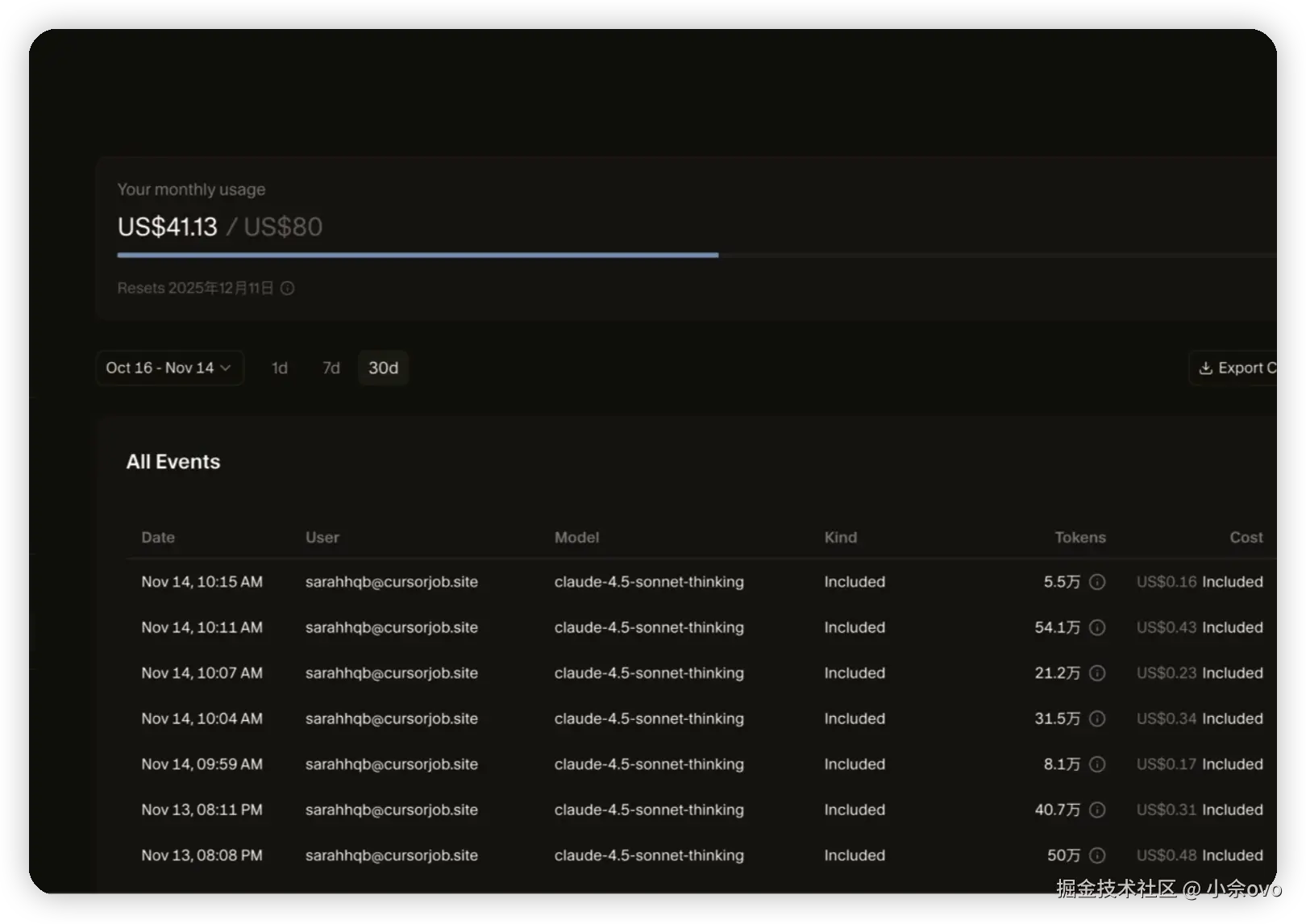

AI 纪元 3 年,2025 论前端程序员自救

前言

2023 年是公认的 AI 元年,2022年底OpenAI发布ChatGPT(基于GPT-3.5),2023年初迅速爆火,上线仅2个月用户突破1亿,成为历史上增长最快的消费级应用。短短三年内,AI 已经从遥不可及,进化到走进千家万户了,从只能聊天的纯语言大模型(LLMs),到今天能解决实际问题的多模态大模型(MLLMs/LMMs)、智能体(AI Agent),我们的生活正发生着不易察觉但又天翻地覆的变化。

这可能是你 2025 年看到的最真实,最中肯,也最能让你安心的文章,先说结论:程序员岗位都不会死,且未来必须具备的能力大部分人都有。

怎么看 AI 对程序员岗位的冲击

AI 的井喷式爆发,对程序员的冲击确实很大。程序员中,前端程序员最甚,在网络上,它三天一小死,五天一大死,但是结果我们也看到了,前端并没有死,甚至活得比以前更繁荣了,很多其他岗位程序员也试着用 Gemini 3 Pro 搭建了属于自己的 three.js 应用。

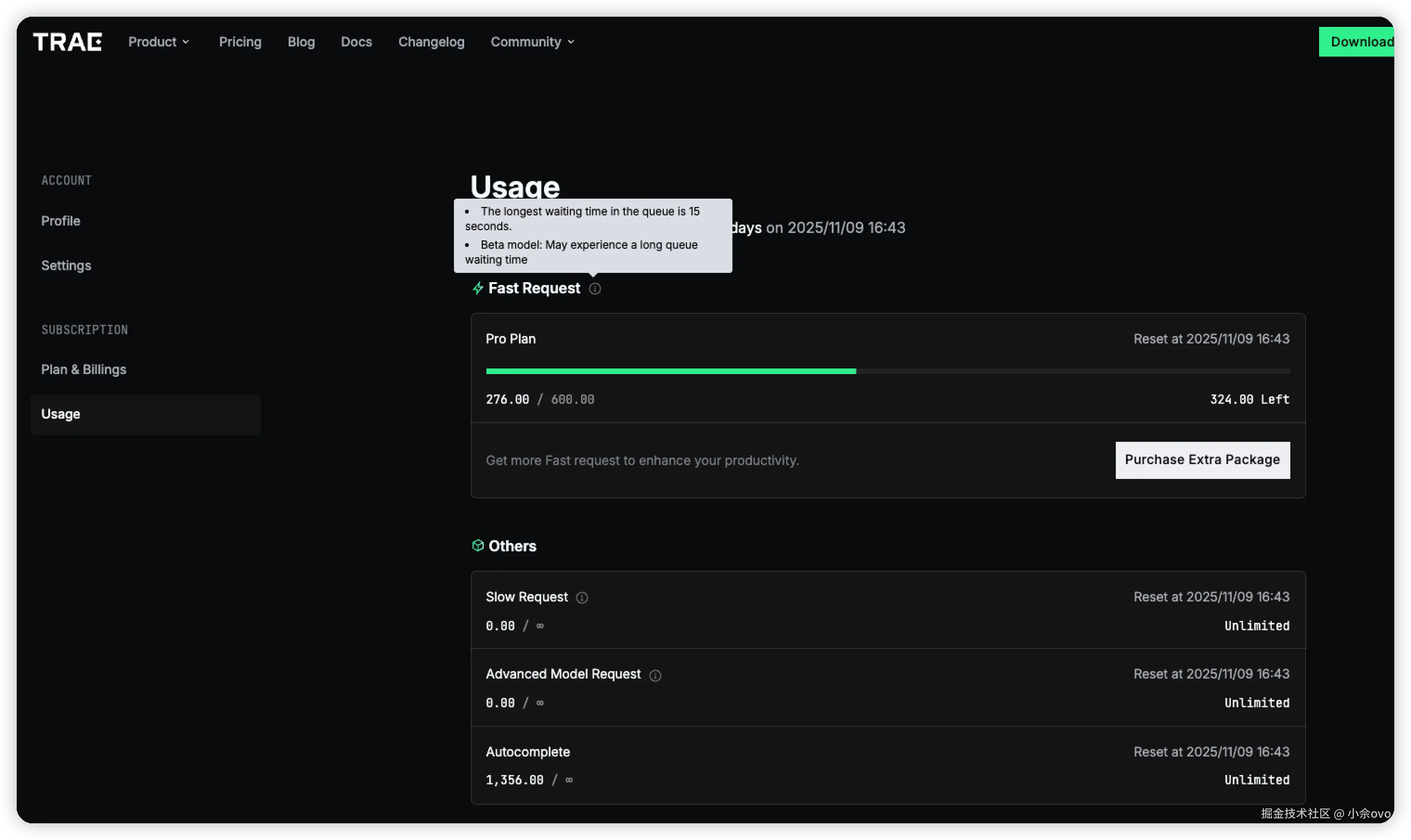

可能大家跟我的感觉一样,对网上前端已死的焦虑卖家并不感冒,因为在工作中,AI 给我们的感觉更像是一个老司机坐在副驾驶,我们遇到不懂的直接问它,而它也会把毕生所学毫无保留的交代出来,甚至在 VSCode Copilot 或者 Cursor 、Trae 中,我们根本不需要自己动手写代码了,80% 的时间都在 vibe coding,我们没有因为 AI 丢掉工作,反而 AI 让我们觉得:哇,太爽了,工作效率翻了三倍!

如果你有这种感觉,那么恭喜你,你是最适合在未来工作的前端开发者!

目前 AI 的局限性表现的很明显,AI 生成的代码往往 平均化、缺乏深度优化或者有隐蔽的 bug。还经常改到我们不希望变动的部分,这里祭出这张火爆全网的梗图

当然这些和 AI 还依旧不够成熟有一定关系,但是还有一个最根本的原因使得 AI 无法取代人类,它注定只能作为人类的工具,但是这个原因很哲学,请看下文。

不用怕,欲望是创造的原初动力

人类创造的起点往往是 “想做”、“喜欢”、“不爽”、“好奇”、“想证明自己” 这些内在冲动。比如 一个程序员半夜写出一个新框架,是因为“觉得现有工具太烂了,我就是要搞一个更好玩的”,而 AI 没有这些。它只有“根据训练数据预测下一个词”或者“最大化奖励函数”。我们给它一个目标,它就全力优化,但它自己永远不会“突然想”去做一件没人要求的事。

所以,AI 的“创造”其实是重组+优化过去的知识,而不是从零生出全新的渴望。

AI 很擅长在已知框架里做到极致(比如写出完美的前端组件、优化算法到最快),但人类擅长打破框架、发明新框架。这种突破往往来自 “无用” 的欲望

- 想玩 → 发明游戏

- 想偷懒 → 发明自动化工具(发明了 AI 😂)

- 想被认可 → 开源一个项目

历史上所有重大创新(互联网、智能手机、开源运动)都源于这种自发欲望。

总的来说,AI 只是现有知识最好的运用者,它无法自发的想去创造新事物(如果有的话也太可怕了,这 TM 直接天网)

要让AI拥有“真正自发的欲望”,需要解决哲学级难题:意识(consciousness) 和 主观体验(qualia)。目前科学界连“意识是什么”都没搞清楚,更别说在硅基系统里实现它了。

所以这是 AI 为什么无法代替人类的原因。

但是,从直觉上来看,AI 似乎可以替代一部分基础工作,而且现在正在发生,有些公司正在招聘高级开发者来替代多个初中级岗位...

危机真正的来源

初中级岗位确实正在慢慢消失,但这并不意味着我们在岗程序员一定会掉队,相反,我们在行业内属于 “老人”,也是最先吃到 AI 这块蛋糕的人。既然总要有人做事,所谓近水楼台先得月,最先有机会转换到 融合职责岗位 的,也会是我们这一批人,而不是其他人。

在我们这个行业,各个岗位正在发生融合,产品经理、UI、前后端的界限越来越模糊,最近还出现了所谓的 “一人公司”、“超级个体”。

初中级岗位的慢慢消失和岗位职责的融合,是 AI 时代,对普通程序员最大的挑战,我们应该顺应这一潮流,转变以往的思维,勇敢的加入到这场洪流中。

那么,该怎么做?

有解,且比以前更简单!

众所周知,T-shaped 技能模型推荐我们 先建立一个领域的深度(垂直杠),再扩展广度(水平杠),形成T形。我们很多人也是这么干的,前端同学在深刻学习 JS 语言基础、vue、react 源码,传统面试中,这些知识也是重点考察内容。

但是 AI 时代,这些技能变得非常廉价,AI已经把“深度纯技术钻研”的门槛大幅降低:它能快速生成代码、优化实现,甚至帮你读源码、总结关键。

你可以完全没读过 vue 源码,而仅用一句:“帮我实现一个 vue 的响应式系统” 实现这个功能。

T 的竖线表示领域深耕,既然深耕到一半,发现不太有竞争力了,怎么办?很简单,发展横轴,横轴代表了我们的广度(全栈狂喜),但这里说的不是纯技术广度,而是多方面多系统的融会贯通。

不过好在这些技能是我们聪明的程序员天生就具备的能力。

未来优秀程序员不再是“写代码最快的人”,而是系统思考者 + 需求翻译者 + AI指挥官 + 复杂问题解决者 + 高效沟通者。

- System Thinking 系统思维 解释:能够从整体视角设计复杂、可扩展、可维护的系统,权衡性能、成本、安全、演化等多个维度。AI擅长局部,人类必须负责全局架构。

- Requirement Mastery 需求洞察 解释:精准理解模糊、矛盾的业务需求,把商业目标转化为可验证的技术方案。未来程序员更像“业务翻译者”,这是AI最弱的一环。

- Integration Ability 融合贯通 解释:快速整合不同技术栈、AI工具、第三方服务,从0到1构建完整产品。广度+快速学习能力,让你能驾驭AI实现跨领域创新。

- Debugging & Reasoning 复杂调试与推理 解释:快速定位根因,需要强大的因果推理、假设检验能力。AI会减少简单bug,但复杂问题会更多、更隐蔽。

- Communication & Expression 语言组织能力 沟通与表达 解释:用清晰、结构化的语言(书面最重要)把复杂技术想法表达出来,包括写 AI 提示词 (目前,将来可能弱化)、文档、技术方案、跨团队沟通等。脑子里再懂,不说出来就等于没用——这会直接影响你的影响力、晋升和协作效率。

看起来需要具备这么多能力,但是仔细想想,其实每个人都已经基本具备。每个人只需在自己的薄弱领域稍加练习即可,这比啃框架源码可简单多了,至少都是可以 “勤能补拙” 的技能。

结语

AI 不是洪水猛兽,它是我们最可靠的副驾驶,我们应该勇敢投入潮流,转变自身态度,提升视野,才能在未来的 AI 大融合时代占住自己的一席之地。

还有,2026,别感冒!

番外

- 本文章由我和 Grok 共创,对话链接:grok.com/share/c2hhc…

- Google AI Studio 帮我实现了很多想法!

- wcnm.club/ 一个匿名的在线聊天室,可配置自己的私密 mqtt 服务器,一键启动!

- elemental-survivor.vercel.app/ 一个肉鸽游戏,非常完整。

- solar-max-clone-galactic-conquest.vercel.app/ 手游 《太阳系争霸战 (solarmax)》复刻

- code-hero-pi.vercel.app/ 可以自己设计英雄的回合制卡牌对战,可联机对战!

来源:juejin.cn/post/7589732701289234466

技术、业务、管理:一个30岁前端的十字路口

上个月,我刚过完30岁生日。

没有办派对,就和家人简单吃了顿饭。但在吹蜡烛的那个瞬间,我还是恍惚了一下。

30岁,对于一个干了8年的前端来说,到底意味着什么?

前几天,我在做团队下半年的规划,看着表格里的一个个名字,再看看镜子里的自己,一个问题在我脑子里变得无比清晰:

我职业生涯的下一站,到底在哪?

28岁之前

在28岁之前,我的人生是就行直线。

我的目标非常纯粹:成为一个技术大神。我的快乐,来自于搞懂一个Webpack的复杂配置、用一个巧妙的Hook解决了一个棘手的渲染问题、或者在Code Review里提出一个让同事拍案叫绝的优化。

这条路的升级路径也非常清晰:

初级(学框架) -> 中级(懂原理) -> 高级(能搞定复杂问题)

我在这条路上,跑得又快又开心。

30岁的十字路口

但到了30岁,我当上了技术组长,我发现,这条直线消失了。取而代之的,是一个迷雾重重的十字路口。

我发现,那些能让我晋升到高级的技能,好像并不能帮我晋升到下一个级别了。

摆在我面前的,是三条截然不同,却又相互纠缠的路。

技术路线——做技术专家

- 这条路成为一个 主工程师 或 架构师。不带人,不背KPI,只解决公司最棘手的技术难题。比如,把我们项目的INP从200ms优化到100ms以下,或者主导设计公司下一代的跨端架构。

- 这当然是我的舒适区。我爱代码,我享受这种状态。这条路,是我最熟悉、最擅长的。

- 焦虑点:我真的能成为那个最顶尖的1%吗?前端技术迭代这么快,我能保证我5年后,还能比那些25岁的年轻人,学得更快、想得更深吗?当我不再是团队里最能打的那个人时,我的价值又是什么?

业务路线——更懂的产品工程师

- 不再只关心怎么实现,而是去关心为什么要做?深入理解我们的商业模式、用户画像、数据指标。不再是一个接需求的资源,而是成为一个能和产品经理吵架、能反向推动产品形态的合作伙伴。

- 我发现,在公司里,那些真正能影响决策、晋升最快的工程师,往往都是最懂业务的。他们能用数据和商业价值去证明自己工作的意义,而我,还在纠结一个技术实现的优劣。

- 焦虑 :这意味着我要走出代码的舒适区,去开更多的会,去啃那些枯燥的业务文档,去和各种各样的人扯皮。我一个技术人,会不会慢慢变得油腻了?

管理——做前端Leader

- 这就是我现在正在尝试的。我的工作,不再是写代码,而是让团队更好地写代码。我的KPI,不再是我交付了多少,而是我们团队交付了多少。

- 老板常说的影响力杠杆。我一个人写代码,战斗力是1。我带一个5人团队,如果能让他们都发挥出1.2的战斗力,那我的杠杆就是6。这种成就感,和写出一个完美函数,是完全不同的。

- 这是我最焦虑的地方:

我上周二,开了7个会,一行代码都没写。

晚上9点,我打开VS Code,看着那些我曾经最熟悉的代码库,突然有了一丝陌生感。我开始恐慌:我的手艺是不是要废了?如果有一天,我不当这个Leader了,我还能不能凭技术,在外面找到一份好工作?

这三个问题,在我脑子里盘旋了很久。我试图三选一,但越想越焦虑。

直到最近,我在复盘一个项目时,才突然想明白:

这根本不是一个三选一的十字路口。

这三条路,是一个优秀的技术人,在30岁之后,必须三位一体、同时去修炼的内功。

- 一个不懂技术的Leader,无法服众,也做不出靠谱的架构决策。

- 一个不懂业务的专家,他的技术再牛,也可能只是屠龙之技,无法为公司创造真正的价值。

- 一个不懂管理(影响他人)的工程师,他的想法再好,也只能停留在自己的电脑上,无法变成团队的战斗力。

DOTA2的世界里,有一个英雄叫 祈求者(Invoker),他有冰、雷、火三个元素,通过不同的组合,能释放出10个截然不同的强大技能。

我觉得,30岁之后的前端,就应该成为一个祈求者。

我们不再是那个只需要猛点一个技能的码农。我们的挑战,在于如何在不同的场景下,把这三个元素,组合成最恰当的技能,去解决当下最复杂的问题。

这条路,很难,但也比25岁时,要有趣得多。

与所有在十字路口迷茫的同行者,共勉🙌。

来源:juejin.cn/post/7563564221352673331

AI 代码审核

ai-code-review

在日常开发中,我们经常会遇到一些问题,比如代码质量问题、安全问题等。如果我们每次都手动去检查,不仅效率低下,而且容易出错。

所以我们可以利用 AI 来帮助我们检查代码,这样可以提高我们的效率

那么,如何利用 AI 来检查代码呢?

1. 使用 JS 脚本

这种方法其实就是写一个简单的脚本,通过调用 OpenAI 的 API,将代码提交给 AI 进行评审。

这里我们需要使用 Node.js 来实现这个功能。利用 git 的 pre-commit hooks,在 git 提交前执行这个脚本。整体流程如下:

接下来我们来具体实现下代码。在项目根目录下新建一个pre-commit.js文件,这个文件就是我们的脚本。

1.1 校验暂存区代码

通过 git diff --cached 验证是否存在待提交内容,如果没有改动则直接退出提交。

const { execSync } = require('child_process');

const checkStaged = () => {

try {

const changes = execSync("git diff --cached --name-only").toString().trim();

if (!changes) {

console.log("No staged changes found.");

process.exit(0);

}

} catch (error) {

console.error("Error getting staged changes:", error.message);

process.exit(1);

}

}

1.2 获取差异内容

const getDiff = () => {

try {

const diff = execSync("git diff --cached").toString();

if (!diff) {

console.log("No diff content found.");

process.exit(0);

}

return diff;

} catch (error) {

console.error("Error getting diff content:", error.message);

process.exit(1);

}

}

1.3 准备prompt

这里我们需要准备一个 prompt,这个 prompt 就是用来告诉 AI 我们要检查什么内容。

const getPrompt = (diff) => {

return `

你是一名代码审核员,专门负责识别git差异中代码的安全问题和质量问题。您的任务是分析git 差异,并就代码更改引入的任何潜在安全问题或其他重大问题提供详细报告。

这里是代码差异内容:

${diff}

请根据以下步骤完成分析:

1.安全分析:

- 查找由新代码引发的一些潜在的安全漏洞,比如:

a)注入缺陷(SQL注入、命令注入等)

b)认证和授权问题

...

2. 代码逻辑和语法分析:

-识别任何可能导致运行时错误的逻辑错误或语法问题,比如:

a)不正确的控制流程或条件语句

b)循环使用不当,可能导致无限循环

...

3. 报告格式:

对于每个发现的问题,需要按照严重等级分为高/中/低。

每个问题返回格式如下:

-[严重等级](高中低)- [问题类型](安全问题/代码质量) - 问题所在文件名称以及所在行数

- 问题原因 + 解决方案

4. 总结:

在列出所有单独的问题之后,简要总结一下这些变化的总体影响,包括:

-发现的安全问题数量(按严重程度分类)

-发现的代码质量问题的数量(按严重性分类)

请现在开始你的分析,并使用指定的格式陈述你的发现。如果没有发现问题,请在报告中明确说明。

输出应该是一个简单的结论,无论是否提交这些更改,都不应该输出完整的报告。但是要包括文件名。并将每行标识的问题分别列出。

如果存在高等级的错误,就需要拒绝提交

回答里的结尾需要单独一行文字 "COMMIT: NO" 或者 "COMMIT: YES" 。这将用来判断是否允许提交

`

}

1.4 定义一个 AI 执行器

这里我用 chatgpt 实现的,具体代码如下:

const execCodeReviewer = (text) => {

const apiKey = ''

const apiBaseUrl = ''

const translateUrl = `${apiBaseUrl}/v1/chat/completions`

return new Promise((resolve, reject) => {

fetch(translateUrl, {

method: 'POST',

headers: {

'Content-Type': 'application/json',

Authorization: `Bearer ${apiKey}`,

},

body: JSON.stringify({

stream: false,

messages: [

{

role: 'user',

content: text,

},

],

}),

})

.then(res => res.json().then(data => resolve(data.choices[0].message.content)))

.catch(err => {

console.error(err)

})

})

}

1.5 结果处理

这里我们需要解析一下结果,提取结果中是否包含 "COMMIT: YES"关键字,有则允许提交,否则不允许提交并打印结果

const handleReviewResult = (result) => {

const decision = result.includes("COMMIT: YES") ? "YES" : "NO";

if (decision === 'NO') {

console.log("\nCritical issues found. Please address them before committing.");

console.log(details);

process.exit(1);

}

console.log("\nCommit approved.");

}

1.6 主函数执行整个流程

const main = async () => {

try {

checkStaged();

const diffContent = getDiff();

console.log("Running code review...");

const prompt = getPrompt(diffContent);

const reseponse = await execCodeReviewer(prompt);

handleReviewResult(reseponse)

process.exit(0);

} catch (error) {

console.error("Error:", error.message);

process.exit(1);

}

}

1.7 git hooks里添加执行该脚本逻辑

进入项目根目录,在这里运行 git bash。打开pre-commit钩子文件

vim .git/hooks/pre-commit

然后添加以下内容

#!/bin/sh

GIT_ROOT=$(git rev-parse --show-toplevel)

node "$GIT_ROOT/pre-commit.js"

exit $?

保存退出后,我们就可以使用 git 做下测试。

1.8 测试

我新建了一个 test.js 文件,然后添加如下代码:

const fn = () => {

let num = 0

for(let i = 0; true; i++) {

num += i

}

}

然后执行 git add . 然后 git commit -m "test"。效果如下:

看来还是不错的,有效识别代码中的逻辑缺陷与语法隐患(如无限循环、变量误用等),同时当不满足提交条件后,也是直接终止了 commit。这里面其实比较关键的是 prompt 的内容,ai 评审的效果主要就是取决于它。

2. ai-pre-commit-reviewer 插件

上面我们是通过 js 脚本来实现的,其实也可以通过现成插件来实现。原理和第一个方法是一样的,只不过是插件帮我们封装好了,我们只需要配置下即可。并且该插件支持多种 AI 供应商,比如 openAI,deepseek,本地的Ollama和LM Studio。插件地址,欢迎大家star。

2.1 安装插件

npm install ai-pre-commit-reviewer --save-dev

#安装完成后执行

npx add-ai-review #添加执行逻辑到git pre-commit钩子中

2.2 配置文件

插件安装完成后,新建一个.env 文件

baseURL= *** #模型服务地址

apiKey=*** #模型服务密钥

language=chinese #语言

2.3 效果预览

也可以配合husky使用,进行语法检查后执行code review。

我这里也是更推荐大家使用这个,简单易上手。

3. gerrit + ai-code-review

Gerrit 是由 Google 开发的代码审查管理系统,基于 Git 版本控制系统构建,主要特性包括:

- 强制代码审查机制:所有代码必须通过人工/自动化审查才能合并

- 细粒度权限控制:支持基于项目/分支的访问权限管理

- 在线代码对比:提供可视化差异查看界面(Side-by-Side Diff)

- 插件扩展体系:可通过插件集成 CI/CD、静态分析等工具

其核心功能主要是通过 refs/for/ 推送机制,确保所有代码变更必须通过审核。因此我们可以利用 ai 代替人工去执行代码 review,这样效率也会更高效。

2.1 gerrit 安装与配置

# 执行以下命令

docker pull gerritcodereview/gerrit:latest

安装完后可以看下容器列表

没问题后启动服务,然后在浏览器中访问 http://localhost:8080/ 就可以看到gerrit首页

2.1.1 配置 ssh 密钥

ssh-keygen -t ed25519 -C "your_email@example.com"

# 直接按3次回车(不要设置密码)

cat ~/.ssh/id_ed25519.pub # 复制输出的内容

然后在 "settings" 页面中选择左侧的"SSH Keys",将复制的公钥内容粘贴进去。添加完成后测试下连接情况。

ssh -p 29418 admin@localhost # 输入yes接受指纹

看到 Welcome to Gerrit Code Review 表示成功

2.1.2 拉取项目测试

可以在 BROWSE > Repositories 里查看当前项目列表,我这里用 All-Projects 做下测试,理论上是要新建项目的。

git clone "ssh://admin@localhost:29418/All-Projects"

安装 Gerrit 提交钩子 commit-msg(必须!)。Gerrit 依赖 commit-msg 钩子实现以下功能:

- 生成 Change-Id:每个提交头部自动添加唯一标识符,格式示例

Change-Id: I7e5e94b9e6a4d8b8c4f3270a8c6e9d3b1a2f5e7d - 校验提交规范: 确保提交信息符合团队约定格式(如包含任务编号)

- 防止直接推送: 强制推送到 refs/for/ 路径而非主分支

cd All-Projects

curl -Lo .git/hooks/commit-msg http://localhost:8080/tools/hooks/commit-msg

chmod +x .git/hooks/commit-msg

然后新建个js文件,写点代码并提交。

git push origin HEAD:refs/for/refs/meta/config # 提交到 refs/meta/config 分支

然后在gerrit首页可以看到刚刚提交的代码,点击查看详情,可以看到代码审核的流程。

2.2 插件安装和配置

将 ai-code-review 插件克隆到本地。插件详情可参考官方文档。此插件可以使用不同的 AI Chat 服务(例如 ChatGPT 或 OLLAMA)

git clone https://gerrit.googlesource.com/plugins/ai-code-review

安装 Java 和构建工具

sudo apt update

sudo apt install -y openjdk-21-jdk maven # 官方文档说 11 就行,但是我实际上跑了后发现需要 JDK 21+

进去项目目录构建 JAR 包

cd ai-code-review

mvn clean package

当输出BUILD BUILD SUCCESS时,表示构建成功。进入目录看下生成的包名。

然后将生成的jar包复制到 gerrit 的 plugins 目录下

# 我这里容器名为 gerrit,JAR 文件在 target/ 目录

docker cp target/ai-code-review-3.11.0.jar gerrit:/var/gerrit/plugins/

然后进入容器内看下插件列表,确认插件已经安装成功

也可以在 gerrit 网页端查看插件启动情况

接着修改配置文件,在 gerrit 的 etc 目录下找到 gerrit.config 文件。但在这之前需要在 Gerrit 中创建一个 AI Code Review 用户,这个席位用于 AI 来使用进行代码评审。

vi var/gerrit/etc/gerrit.config

在文件里添加以下内容。

[plugin "ai-code-review"]

model = deepseek-v3

aiToken = ***

aiDomain = ***

gerritUserName = AIReviewer

aiType = ChatGPT

globalEnable = true 。

- model(非必填): 使用的模型

- aiToken(必填): AI模型的密钥

- aiDomain(非必填): 请求地址,默认是 api.openai.com

- gerritUserName(必填): AI Code Review 用户的 Gerrit 用户名。我这里创建的用户名为 AIReviewer

- aiType(非必填): AI类型,默认是 ChatGPT

- globalEnable(非必填): 是否全局启用,默认是 false, 表示插件将仅审核指定的仓库。如果不设置为true的话。需要添加enabledProjects参数,指定要运行的存储库,例如:“project1,project2,project3”。

更多字段配置参考官方文档

这些都完成后,重启 gerrit 服务。然后修改下代码,写段明显有问题的代码,重新 commit 并 push 代码,看下 AI 代码评审的效果怎么样。

可以看到 ai 审查代码的效果还是不错的。当然我这里是修改了插件的prompt,让它用中文生成评论,它默认是用英文回答的。

总结

现在AI功能越来越强大,可以帮我们处理越来越多的事情。同时我也开发了一个工具AI-vue-i18n,能够智能提取代码中的中文内容,并利用AI完成翻译后生成多语言配置文件。告别手动配置的场景。

文章地址

github地址

来源:juejin.cn/post/7504567245265846272

进入外包,我犯了所有程序员都会犯的错!

前言

前些天有位小伙伴和我吐槽他在外包工作的经历,语气颇为激动又带着深深的无奈。

本篇以他的视角,进入他的世界,看看这一段短暂而平凡的经历。

1. 上岸折戟尘沙

本人男,安徽马鞍山人士,21年毕业于江苏某末流211,在校期间转码。

上网课期间就向往大城市,于是毕业后去了深圳,找到了一家中等IT公司(人数500+)搬砖,住着宝安城中村,来往繁华南山区。

待了三年多,自知买房变深户无望,没有归属感,感觉自己也没那么热爱技术,于是乎想回老家考公务员,希望待在宇宙的尽头。

24年末,匆忙备考,平时工作忙里偷闲刷题,不出所料,笔试卒,梦碎。

2. 误入外包

复盘了备考过程,觉得工作占用时间过多,想要找一份轻松点且离家近的工作,刚好公司也有大礼包的指标,于是主动申请,辞别深圳,前往徽京。

Boss上南京的软件大部分是外包(果然是外包之都),前几年外包还很活跃,这些年外包都沉寂了不少,找了好几个月,断断续续有几个邀约,最后实在没得选了,想着反正就过渡一下挣点钱不寒碜,接受了外包,作为WX服务某为。薪资比在深圳降了一些,在接受的范围内。

想着至少苟着等待下一次考公,因此前期做项目比较认真,遇到问题追根究底,为解决问题也主动加班加点,同为WX的同事都笑话我说比自有员工还卷,我却付之一笑。

直到我经历了几件事,正所谓人教人教不会,事教人一教就会。

3. 我在外包的二三事

有一次,我提出了自有员工设计方案的衍生出的一个问题,并提出拉个会讨论一下,他并没有当场答应,而是回复说:我们内部看看。

而后某天我突然被邀请进入会议,聊了几句,意犹未尽之际,突然就被踢出会议...开始还以为是某位同事误触按钮,然后再申请入会也没响应。

后来我才知道,他们内部商量核心方案,因为权限管控问题,我不能参会。

这是我第一次体会到WX和自有员工身份上的隔阂。

还有一次和自有员工一起吃饭的时候,他不小心说漏嘴了他的公积金,我默默推算了一下他的工资至少比我高了50%,而他的毕业院校、工作经验和我差不多,瞬间不平衡了。

还有诸如其它的团建、夜宵、办公权限、工牌等无一不是明示着你是外包员工,要在外包的规则内行事。

至于转正的事,头上还有OD呢,OD转正的几率都很低,好几座大山要爬呢,别想了。

3. 反求诸己

以前网上看到很多吐槽外包的帖子,还总觉得言过其实,亲身经历了才刻骨铭心。

我现在已经摆正了心态,既来之则安之。正视自己WX的身份,给多少钱干多少活,给多少权利就承担多少义务。

不攀比,不讨好,不较真,不内耗,不加班。

另外每次当面讨论的时候,我都会把工牌给露出来,潜台词就是:快看,我就是个外包,别为难我😔~

另外我现在比较担心的是:

万一我考公还是失败,继续找工作的话,这段外包经历会不会是我简历的污点😢

当然这可能是我个人感受,其它外包的体验我不知道,也不想再去体验了。

对,这辈子和下辈子都不想了。

附南京外包之光,想去或者不想去的伙伴可以留意一下:

来源:juejin.cn/post/7511582195447824438

TensorFlow.js 和 Brain.js 全面对比:哪款 JavaScript AI 库更适合你?

温馨提示

由于篇幅较长,为方便阅读,建议按需选择章节,也可收藏备用,分段消化更高效哦!希望本文能为你的前端

AI开发之旅提供实用参考。 😊

引言:前端 AI 的崛起

在过去的十年里,人工智能(AI)技术的飞速发展已经深刻改变了各行各业。从智能助手到自动驾驶,从图像识别到自然语言处理,AI 的应用场景几乎无处不在。而对于前端开发者来说,AI 的魅力不仅在于其强大的功能,更在于它已经走进了浏览器,让客户端也能够轻松承担起机器学习的任务。

试想一下,当你开发一个 Web 应用,需要进行图像识别、文本分析、语音识别或其他 AI 任务时,你是否希望直接在浏览器中处理这些数据,而无需依赖远程服务器?如果能在用户的设备上本地运行这些任务,不仅可以大幅提升响应速度,还能减少服务器资源的消耗,为用户提供更流畅的体验。

这正是 TensorFlow.js 和 Brain.js 两款库所带来的变革。它们使开发者能够在浏览器中轻松实现机器学习任务,甚至支持训练和推理深度学习模型。虽然这两款库在某些功能上有相似之处,但它们的定位和特点却各有侧重。

TensorFlow.js 是由 Google 推出的深度学习框架,它为浏览器端的机器学习提供了强大的支持,能够处理从图像识别到自然语言处理的复杂任务。基于 WebGL 提供加速,TensorFlow.js 可以充分利用硬件性能,实现大规模数据处理和复杂模型推理。

TensorFlow.js 不仅功能强大,还能直接在浏览器中运行复杂的机器学习任务,例如图像识别和处理。如果你想深入了解如何使用 TensorFlow.js 构建智能图像处理应用,可以参考我的另一篇文章:纯前端用 TensorFlow.js 实现智能图像处理应用(一)。

相比之下,Brain.js 是一款轻量级神经网络库,专注于简单易用的神经网络模型。它的设计目标是降低机器学习的入门门槛,适合快速原型开发和小型应用场景。尽管 Brain.js 不具备 TensorFlow.js 那样强大的深度学习能力,但它的简洁性和易用性使其成为许多开发者快速实验和实现基础 AI 功能的优选工具。

然而,选择哪款库作为前端 AI 的工具并不简单,这取决于项目的需求、性能要求以及学习成本等多个因素。本文将详细对比两款库的功能、优缺点及适用场景,帮助你根据需求选择最适合的工具。

无论你是 AI 初学者还是有经验的开发者,相信你都能从这篇文章中找到有价值的指导,助力你在浏览器端实现机器学习。准备好了吗?让我们一起探索 TensorFlow.js 和 Brain.js 的世界,发现它们的不同之处,了解哪一个更适合你的项目。

一、TensorFlow.js - 强大而复杂的深度学习库

1.1 TensorFlow.js 概述

TensorFlow.js 是由 Google 推出的开源 JavaScript 库,用于在浏览器和 Node.js 环境中执行机器学习任务,包括深度学习模型的推理和训练。它是 TensorFlow 生态的一部分,TensorFlow 是全球最受欢迎的深度学习框架之一,广泛应用于计算机视觉、自然语言处理等领域。

TensorFlow.js 的核心亮点在于其 跨平台支持。你可以在浏览器端运行,也可以在 Node.js 环境下执行,灵活满足不同开发需求。此外,它支持导入已训练好的 TensorFlow 或 Keras 模型,在浏览器或 Node.js 中进行推理,无需重新训练。这使得 AI 的开发更加高效和便捷。

1.2 TensorFlow.js 的功能特点

TensorFlow.js 提供了丰富的功能,覆盖从简单的机器学习到复杂的深度学习任务。以下是它的核心特点:

- 浏览器端深度学习推理:通过

WebGL加速,TensorFlow.js可以高效地在浏览器中加载和运行深度学习模型,无需依赖服务器,大幅提升用户体验和响应速度。 - 训练与推理一体化:

TensorFlow.js支持在前端环境直接训练神经网络,这对于动态数据更新和快速迭代非常有用。即使是复杂的深度学习模型,也能通过优化技术确保高效的训练过程。 - 支持复杂神经网络架构:包括卷积神经网络(

CNN)、循环神经网络(RNN)、以及高级模型如Transformer,适用于图像、语音、文本等多领域任务。 - 模型导入与转换:支持从其他

TensorFlow或Keras环境导入已训练的模型,并在浏览器或Node.js中高效运行,降低了开发门槛。 - 跨平台支持:无论是前端浏览器还是后端

Node.js,TensorFlow.js都可以灵活适配,特别适合需要多环境协作的项目。

1.3 TensorFlow.js 的优势与应用场景

优势:

- 本地化计算:无需数据传输到服务器,所有计算均在用户设备上完成,提升速度并保障隐私。

- 强大的生态支持:依托

TensorFlow的生态系统,TensorFlow.js可以轻松访问预训练模型、教程和工具。 - 灵活性与高性能:支持低级别

API和WebGL加速,可根据需求灵活调整模型和计算流程。 - 无需后台服务器:在浏览器中即可完成复杂的训练和推理任务,显著简化系统架构。

应用场景:

- 图像识别:例如手写数字识别、人脸检测、物体分类等实时图像处理任务。

- 自然语言处理:支持情感分析、文本分类、语言翻译等复杂 NLP 任务。

- 实时数据分析:适用于

IoT或其他需要即时数据处理和反馈的应用场景。 - 推荐系统:通过用户行为数据构建个性化推荐,例如电商、新闻或社交媒体应用。

1.4 TensorFlow.js 基本用法示例

以下是一个简单示例,展示如何使用 TensorFlow.js 构建并训练神经网络模型。

安装与引入 TensorFlow.js

- 通过

CDN引入:

<script src="https://cdn.jsdelivr.net/npm/@tensorflow/tfjs"></script>

- 通过

npm安装(适用于Node.js环境):

npm install @tensorflow/tfjs

创建简单神经网络

以下示例创建了一个简单的前馈神经网络,用于处理二分类问题:

// 导入 TensorFlow.js

const tf = require('@tensorflow/tfjs');

// 创建一个神经网络模型

const model = tf.sequential();

// 添加隐藏层(10 个神经元)

model.add(tf.layers.dense({ units: 10, activation: 'relu', inputShape: [5] }));

// 添加输出层(2 类分类问题)

model.add(tf.layers.dense({ units: 2, activation: 'softmax' }));

// 编译模型

model.compile({

optimizer: 'adam',

loss: 'categoricalCrossentropy',

metrics: ['accuracy'],

});

训练和推理过程

训练模型需要提供输入数据(特征)和标签(目标值):

// 创建训练数据

const trainData = tf.tensor2d([[0, 1, 2, 3, 4], [1, 2, 3, 4, 5], [2, 3, 4, 5, 6]]);

const trainLabels = tf.tensor2d([[1, 0], [0, 1], [1, 0]]);

// 训练模型

model.fit(trainData, trainLabels, { epochs: 10 }).then(() => {

// 使用新数据进行推理

const input = tf.tensor2d([[1, 2, 3, 4, 5]]);

model.predict(input).print();

});

二、Brain.js - 轻量级且易于使用的神经网络库

2.1 Brain.js 概述

Brain.js 是一个轻量级的开源 JavaScript 神经网络库,专为开发者提供快速、简单的机器学习工具。它的设计理念是易用性和轻量化,适合那些希望快速构建和训练神经网络的开发者,尤其是机器学习的新手。

与功能丰富的 TensorFlow.js 不同,Brain.js 更注重于直观和简单,能够帮助开发者快速完成从构建到推理的基本机器学习任务。虽然它不支持复杂的深度学习模型,但其易用性和小巧的特性,使其成为小型项目和快速原型开发的理想选择。

2.2 Brain.js 的功能特点

Brain.js 的功能主要集中在简化神经网络的构建与训练上,以下是其核心特点:

- 简单易用的

API:Brain.js提供了直观的接口,开发者无需复杂的机器学习知识,也能轻松上手并实现神经网络任务。 - 轻量级:相较于体积较大的

TensorFlow.js,Brain.js的核心库更为小巧,非常适合嵌入前端应用,且不会显著影响加载速度。 - 支持多种网络结构:前馈神经网络(

Feedforward Neural Network)、LSTM网络(Long Short-Term Memory)等。这些模型已足够应对大多数基础的机器学习需求。 - 快速训练与推理:通过几行代码即可完成训练与推理任务,适用于快速原型设计和验证。

- 同步与异步训练支持:

Brain.js同时支持同步和异步的训练过程,开发者可以根据项目需求选择合适的方式。

2.3 Brain.js 的优势与应用场景

优势:

- 快速原型开发:开发者可以用最少的代码完成神经网络的构建和训练,特别适合需要快速验证想法的场景。

- 轻量级与高效率:库的体积较小,能快速加载,适合资源有限的环境。

- 易于集成:

Brain.js非常适合嵌入Web应用或小型Node.js服务,集成简单。 - 适合初学者:

Brain.js的设计对机器学习新手友好,无需深入了解复杂的深度学习算法即可上手。

应用场景:

- 基础分类与预测任务:适合实现简单的分类任务或数值预测,例如时间序列预测、情感分析等。

- 教学与实验:对于机器学习教学或学习过程中的快速实验,

Brain.js是一个很好的工具。 - 轻量化应用:例如小型交互式

Web应用中实时处理用户输入。

2.4 Brain.js 基本用法示例

以下示例展示了如何使用 Brain.js 构建并训练一个简单的神经网络模型。

安装与引入

- 通过 npm 安装:

npm install brain.js

- 通过 CDN 引入:

<script src="https://cdn.jsdelivr.net/npm/brain.js"></script>

创建简单神经网络

以下代码创建了一个用于解决 XOR 问题的前馈神经网络:

// 引入 Brain.js

const brain = require('brain.js');

// 创建一个简单的神经网络实例

const net = new brain.NeuralNetwork();

// 提供训练数据

const trainingData = [

{ input: [0, 0], output: [0] },

{ input: [0, 1], output: [1] },

{ input: [1, 0], output: [1] },

{ input: [1, 1], output: [0] }

];

// 训练网络

net.train(trainingData);

// 测试推理

const output = net.run([1, 0]);

console.log(`预测结果: ${output}`); // 输出接近 1 的值

训练与推理参数调整

Brain.js 提供了一些可选参数,用于优化训练过程,例如:

- 迭代次数(

iterations) :设置训练的最大轮数。 - 学习率(

learningRate) :控制每次更新的步长。

以下示例展示了如何自定义训练参数:

net.train(trainingData, {

iterations: 1000, // 最大训练轮数

learningRate: 0.01, // 学习率

log: true, // 显示训练过程

logPeriod: 100 // 每 100 次迭代打印一次日志

});

// 推理新数据

const testInput = [0, 1];

const testOutput = net.run(testInput);

console.log(`输入: ${testInput}, 预测结果: ${testOutput}`);

三、TensorFlow.js 和 Brain.js 的全面对比

在这一章中,我们将从多个维度对 TensorFlow.js 和 Brain.js 进行详细对比,帮助开发者根据自己的需求选择合适的工具。对比内容涵盖技术实现差异、学习曲线、适用场景、性能表现以及生态系统和社区支持。

3.1 技术实现差异

TensorFlow.js 和 Brain.js 的技术实现差异显著,主要体现在功能复杂度、支持的模型类型和底层架构上:

TensorFlow.js是一个功能全面的深度学习框架,基于TensorFlow的设计思想,提供了复杂的神经网络架构和高效的数学计算支持。它支持卷积神经网络(CNN)、循环神经网络(RNN)、生成对抗网络(GAN)等多种模型类型,能够完成从图像识别到自然语言处理的复杂任务。借助WebGL技术,TensorFlow.js可在浏览器中高效进行高性能计算,尤其适合大规模数据和复杂模型。Brain.js则更加轻量,主要面向快速开发和简单任务。它支持前馈神经网络(Feedforward Neural Network)、长短期记忆网络(LSTM)等基础模型,适合处理简单的分类或预测问题。尽管功能不如TensorFlow.js广泛,但其简洁的设计使开发者能够快速上手,完成实验和小型项目。

总结:TensorFlow.js 更加强大,适用于复杂任务;Brain.js 简单轻便,适合快速开发和小型应用。

3.2 学习曲线与开发者体验

在学习曲线和开发体验方面,两者差异明显:

TensorFlow.js学习曲线较为陡峭。其功能强大且覆盖面广,但开发者需要了解深度学习的基础知识,包括模型训练、数据预处理等环节。尽管文档和教程丰富,但对初学者而言,掌握这些内容可能需要投入更多的时间和精力。Brain.js则以简洁直观的 API 著称,初学者可以通过几行代码实现神经网络的搭建与训练。它对复杂概念的抽象程度高,无需深入理解深度学习理论,便能快速完成任务。

总结:如果你是新手或需要快速实现一个简单模型,选择 Brain.js 更友好;而如果你已有一定经验,并计划处理复杂任务,则 TensorFlow.js 更适合。

3.3 适用场景与功能选择

根据应用场景,选择合适的库可以大大提高开发效率:

TensorFlow.js:适用于复杂任务,如图像识别、自然语言处理、视频分析或推荐系统。由于其强大的深度学习功能和高性能计算能力,TensorFlow.js特别适合大规模数据处理和精度要求高的场景。Brain.js:适合轻量级任务,例如简单的分类、回归、时间序列预测等。对于快速验证模型或开发原型,Brain.js提供了简单高效的解决方案,尤其是在浏览器端运行时无需依赖复杂的服务器计算。

总结:TensorFlow.js 面向复杂场景和大规模任务;Brain.js 更适合轻量化需求和快速开发。

3.4 性能对比

在性能方面,TensorFlow.js 和 Brain.js 存在显著差异:

TensorFlow.js借助WebGL实现高效的硬件加速,支持 GPU 并行计算。在处理大规模数据集和复杂模型时,其性能优势显著,适用于高负载、高计算量的场景。Brain.js性能较为有限,主要针对小型数据集和简单任务。由于其轻量级设计,虽然在小规模任务中表现出色,但无法与TensorFlow.js的硬件加速能力相媲美。

总结:对于需要高性能计算的场景,TensorFlow.js 是更优选择;而对于小型任务,Brain.js 的性能已足够。

3.5 生态系统与社区支持

TensorFlow.js:作为TensorFlow生态的一部分,TensorFlow.js享有丰富的社区资源和支持,包括大量的开源项目、教程、论坛和工具。开发者可以从官方文档和预训练模型中快速找到所需资源,支持复杂应用的开发。Brain.js:社区较小,但活跃度高。文档简洁,适合初学者。虽然资源和支持不如TensorFlow.js丰富,但足以满足小型项目的需求。

总结:TensorFlow.js 的生态更强大,适合需要长期维护和扩展的项目;Brain.js 更适合轻量化开发和快速上手。

四、如何选择最适合你的库?

在 TensorFlow.js 和 Brain.js 之间做出选择时,开发者需要综合考虑项目需求、技术背景和性能要求。这两款库各有特色:TensorFlow.js 功能强大,适用于复杂任务;Brain.js 简单易用,适合快速开发。以下从选择标准和实际场景出发,帮助开发者找到最合适的工具。

4.1 选择标准

在选择 TensorFlow.js 或 Brain.js 时,可参考以下几个关键标准:

- 功能需求:

- 复杂任务:如果项目涉及深度学习任务(如大规模图像分类、语音识别或自然语言处理),选择

TensorFlow.js更为合适。它支持复杂的神经网络模型,具备高效的数据处理能力。 - 基础任务:如果需求相对简单,例如小型神经网络模型、时间序列预测或分类任务,

Brain.js是更轻量的选择。

- 复杂任务:如果项目涉及深度学习任务(如大规模图像分类、语音识别或自然语言处理),选择

- 开发者经验:

- 有机器学习背景:

TensorFlow.js提供高度灵活的 API,但学习曲线较陡。熟悉机器学习的开发者可以充分利用其强大功能。 - 初学者:

Brain.js更适合新手,提供简洁的接口和直观的使用体验。

- 有机器学习背景:

- 性能需求:

- 高性能计算:如果项目需要硬件加速(如

GPU支持)以处理大规模数据,TensorFlow.js的WebGL支持是理想选择。 - 轻量化应用:对于性能要求较低的场景,

Brain.js的轻量级设计足够满足需求。

- 高性能计算:如果项目需要硬件加速(如

- 项目规模与复杂度:

- 大型项目:

TensorFlow.js提供复杂功能和强大的扩展性,适合长期维护和生产级应用。 - 快速开发:

Brain.js专注于快速实现小型项目,适合验证想法或开发MVP(最小可行产品)。

- 大型项目:

4.2 基于项目需求的选择建议

以下是根据常见场景的具体选择建议:

场景一:图像分类应用

- 需求:对大规模图像进行分类或识别,涉及复杂的卷积神经网络(

CNN)。 - 推荐选择:

TensorFlow.js。支持复杂模型架构,通过WebGL提供高效的硬件加速,适合处理大量图像数据。

场景二:实时数据分析与预测

- 需求:对传感器数据进行实时监测和分析,预测未来趋势(如气象预测、股票走势)。

- 推荐选择:

Brain.js。其轻量化和快速实现的特性非常适合实时数据处理和快速部署。

场景三:自然语言处理(NLP)应用

- 需求:需要对文本数据进行分类、情感分析或对话生成。

- 推荐选择:

TensorFlow.js。支持循环神经网络(RNN)、Transformer等复杂模型,能处理 NLP 任务的高维数据和复杂结构。

场景四:个性化推荐系统

- 需求:根据用户行为推荐商品或内容。

- 推荐选择:

- 如果推荐系统复杂,涉及神经协同过滤或深度学习模型,选择

TensorFlow.js。 - 如果系统较为简单,仅需基于用户行为的规则实现,

Brain.js是更高效的选择。

- 如果推荐系统复杂,涉及神经协同过滤或深度学习模型,选择

场景五:快速原型开发与实验

- 需求:验证机器学习模型效果或快速开发实验性产品。

- 推荐选择:

Brain.js。它提供简洁的接口和快速训练功能,适合快速搭建和迭代。

结论:最终选择

通过对 TensorFlow.js 和 Brain.js 的详细对比,可以帮助开发者根据项目需求和个人技能做出最佳选择。以下是两者的优缺点总结及适用场景的建议。

TensorFlow.js 优缺点

优点:

- 功能全面:支持复杂的深度学习模型(如

CNN、RNN、GAN),适用于广泛的机器学习任务,包括图像识别、自然语言处理和语音处理等。 - 跨平台支持:可运行于浏览器和

Node.js环境,灵活部署于多种平台。 - 性能卓越:利用

WebGL实现硬件加速,适合高性能需求,尤其是大规模数据处理。 - 强大的生态系统:依托

TensorFlow生态,拥有丰富的预训练模型、教程和社区支持,为开发者提供充足资源。

缺点:

- 学习门槛较高:功能复杂,适合有机器学习基础的开发者,初学者可能需要投入较多时间学习。

- 库体积较大:功能的多样性导致库体积偏大,可能影响浏览器加载速度和资源消耗。

Brain.js 优缺点

优点:

- 轻量级与易用性:设计简单,API 直观,非常适合快速开发和机器学习初学者。

- 小巧体积:库文件体积小,适合嵌入前端应用,对网页加载影响小。

- 支持基础模型:支持前馈神经网络和

LSTM,能满足大多数基础机器学习任务。 - 快速上手:开发者无需深厚的机器学习知识,能够快速实现简单神经网络应用。

缺点:

- 功能较为局限:不支持复杂深度学习模型,难以满足高阶任务需求。

- 性能有限:轻量设计决定其在大规模数据处理中的性能不如

TensorFlow.js。

适用场景与开发者建议

初学者或简单任务:

- 选择:

Brain.js - 理由:适合刚接触机器学习的开发者,或处理简单分类、时间序列预测等基础任务。其平缓的学习曲线和快速开发特性,帮助初学者快速上手。

经验丰富的开发者或复杂任务:

- 选择:

TensorFlow.js - 理由:适合处理复杂的深度学习任务,如大规模图像识别、自然语言处理或实时视频分析。提供灵活的 API 和强大的计算能力,满足高性能需求。

小型项目与快速开发:

- 选择:

Brain.js - 理由:适合快速构建原型和简单的神经网络任务,易于维护,开发效率高。

大规模应用与高性能需求:

- 选择:

TensorFlow.js - 理由:其强大的加速能力和复杂模型支持,使其成为生产级应用的理想选择,尤其适合需要 GPU 加速的大规模任务。

结语

通过本文的对比,读者可以清晰了解 TensorFlow.js 和 Brain.js 在功能、性能、学习曲线、适用场景等方面的显著差异。选择最适合的库时,需要综合考虑项目的复杂度、团队的技术背景以及性能需求。

如果你的项目需要处理复杂的深度学习任务,并且需要高性能计算与广泛的社区支持,TensorFlow.js 是不二之选。它功能强大、生态丰富,适合图像识别、自然语言处理等高需求场景。而如果你只是进行小型神经网络实验,或需要快速原型开发,Brain.js 提供了更简洁易用的解决方案,是初学者和小型项目开发者的理想选择。

无论选择哪个库,充分了解它们的优势与限制,将帮助你在项目开发中高效使用这些工具,成功实现你的前端 AI 开发目标。

附录:对比表格

以下对比表格总结了 TensorFlow.js 和 Brain.js 在关键维度上的差异,帮助读者快速决策:

| 特性 | TensorFlow.js | Brain.js |

|---|---|---|

GitHub 星标数量 | 18.6K | 14.5K |

| 功能复杂度 | 高,支持复杂的深度学习模型(CNN, RNN, GAN等) | 低,支持基础前馈神经网络和LSTM网络 |

| 学习曲线 | 陡峭,适合有深度学习经验的开发者 | 平缓,适合初学者和快速原型开发 |

| 使用场景 | 复杂场景,如大规模数据处理、图像识别、语音处理等 | 小型项目,如简单分类任务、时间序列预测 |

| 支持的模型类型 | 多种类型(CNN, RNN, GAN等复杂模型) | 基础类型(前馈神经网络、LSTM等) |

| 性能优化 | 支持 WebGL 加速和 GPU 并行计算,适合高性能需求 | 不支持硬件加速,适合小规模数据处理 |

| 开发平台 | 浏览器和 Node.js 环境,跨平台支持 | 主要用于浏览器,也支持 Node.js |

| 社区支持与文档 | 丰富的生态系统,拥有大量教程、示例和预训练模型资源 | 社区较小但活跃,文档简单直观 |

| 易用性 | API 较复杂,适合有深度学习背景的开发者 | API 简洁,适合初学者和快速开发 |

| 适用开发者 | 高阶开发者,有深度学习基础 | 初学者及快速实现简单任务的开发者 |

| 体积与资源消耗 | 库文件较大,可能影响加载速度 | 体积小,对网页性能影响较小 |

| 训练与推理能力 | 支持复杂模型的训练与推理,适合高需求场景 | 适合简单任务的训练与推理 |

| 预训练模型支持 | 支持从 TensorFlow Hub 加载预训练模型 | 不支持广泛预训练模型,主要用于自定义训练 |

同系列文章推荐

如果你觉得本文对你有所帮助,不妨看看以下同系列文章,深入了解 AI 开发的更多可能性:

欢迎点击链接阅读,开启你的前端 AI 学习之旅,让开发更高效、更有趣! 🚀

我是 “一点一木”

专注分享,因为分享能让更多人专注。

生命只有一次,人应这样度过:当回首往事时,不因虚度年华而悔恨,不因碌碌无为而羞愧。在有限的时间里,用善意与热情拥抱世界,不求回报,只为当回忆起曾经的点滴时,能无愧于心,温暖他人。

来源:juejin.cn/post/7459285932092211238

2026年了,前端到底算不算“夕阳行业”?

你有没有在朋友圈或者知乎上看到过这样的声音:“前端这行是不是快没前途了?”、“前端是夕阳行业,学不起来就晚了”。听起来很吓人吧?今天周五公司不忙~ 所以就想就想聊聊,为什么这些说法有点夸张,而且,实际上,前端比你想的要活跃、要有意思得多。

前端行业现状与就业趋势深入分析

其他废话少说,我先列出一组数据。

市场数据说明:招聘活跃度与求职热度

在判定某个岗位是否是“夕阳行业”前,我们得看看实实在在的数据,而不是空谈。虽然我们没有官方完整的每月统计数据,但从招聘平台侧面指标可以窥见市场动态:

BOSS直聘平台整体使用频次趋势(2024 年)

数据来自行业研究监测,反映招聘平台月度活跃度(平台月访问次数,单位为万次)。它可以折射出用户在找工作和发布岗位的活跃程度:

| 月份 | Boss直聘(万次) | 前程无忧(万次) | 智联招聘(万次) |

|---|---|---|---|

| 2024‑01 | 1212.8 | 503.3 | 381.6 |

| 2024‑03 | 2271.8 | 958.5 | 660.3 |

| 2024‑05 | 1892.9 | 730.1 | 496.5 |

| 2024‑09 | 1861.9 | 695.1 | 465.5 |

| 2024‑12 | 1492.8 | 665.7 | 432.8 |

从这张表可以看到几个趋势:

- 春节前后及 3 月、4 月经常会有求职与招聘高峰,这与校园招聘和年终奖金兑现周期有关。

- Boss直聘的整体使用频次明显高于其他招聘平台,表明它在人才市场中具有更高的活跃度。

这说明整体就业市场并没有冷却到技术岗位“没市场”的程度,但伴随着整体求职竞争压力也在增加(尤其毕业季之后)。

2024–2025 前端岗位薪资与供需情况(综合公开数据)

下面给出一个简要的薪资与供需趋势对比,是基于公开行业报告和招聘平台上职位薪资调研整理的(单位:人民币):

前端薪资水平(2024–2025)

| 类型 | 数据来源 | 平均薪资(月) | 说明 |

|---|---|---|---|

| 全国前端平均薪资 | 招聘求职网站综合数据 | ~20,877 元/月 | 2024 年全国平均数据,样本规模较大 |

| 数字前端工程师高薪技术岗位 | 脉脉高聘年度报告 | ~67,728 元/月 | 仅针对极高端职位薪资榜首人才 |

| BOSS直聘高级前端岗位示例 | 招聘岗位样例 | 20K–50K /月 | 典型一线城市高级薪资范围 |

| 企业大厂前端薪资 | 公司薪资水平数据 | ~57–65 万/年 | P6(技术中高级)年薪典型值 |

小结:大厂或高级岗位薪资明显高于平均,而整体前端岗薪资按城市和经验差异明显(北上深等一线城市更高)。中高级工程师薪资已进入较高收入层。

前端岗位供需趋势(24 年–25 年)

真实可公开的按月份招聘/求职人数统计不容易直接获得(需付费或数据授权),但我们可以根据人才供需比报告和其他间接指标构建趋势理解:

人才供需比(供给 vs 需求)变化

| 数据年份/区间 | 人才供需比(整体技术类) | 解读 |

|---|---|---|

| 2022 全年 | 1.29 | 约 1.3 求职者争一岗 |

| 2023 全年 | 2.00 | 竞争更激烈 |

| 2024 1‑10 月 | 2.06 | 职位竞争仍然紧张 |

供需比上升意味着“求职者数量增速快于岗位数量”,这反映就业市场总体竞争压力上升,但这主要是整体技术类岗位,不仅限前端。技术类岗位中核心和稀缺型(例如 AI、架构方向)仍然紧缺。 开源中国

招聘/求职活跃度趋势示意

timeline

title

2024 : 招聘需求 ↑, 求职人数 ↑

2025 : 招聘需求 ↓, 求职人数 ↑↑

- 招聘需求在 2024/2025 年虽整体活跃,但增长略收敛。

- 求职人数增速仍然高(尤其高校毕业生和转行人才增多)。 PDF 文档助手+1

“前端到底是做什么的”

以前的前端,其实很简单——写页面。你写几个 HTML、CSS,再加上点 JS,页面能跑就算完成任务。大部分人只要会写代码,基本就能找到工作。那时候,技术门槛不高,但随之而来的问题是:大家都能做,稀缺性不强。

到了现在,前端已经不是单纯写页面那么简单了。现在你需要考虑性能优化、工程化、架构设计,甚至还得会和 AI 工具配合来提高效率。也就是说,前端的工作量和复杂度已经大幅升级了,光会写代码,已经不再稀缺。

普通前端 / 工程型前端 / 架构型前端

我一般把前端分成三类:

- 普通前端

就是那种把设计稿转成页面的人,写页面、调样式、搞交互。以前,这类岗位很吃香,因为企业只要有人能把界面做出来就行。现在,普通前端的门槛低,但成长空间有限。 - 工程型前端

这类前端不仅会写页面,还懂打包工具、模块化、性能优化、测试、CI/CD,甚至前端安全。他们能把一个项目从零到一搞成可以高效运转的系统。你可以把他们想象成“能写代码,也懂流程的人”,在团队里很吃香。 - 架构型前端

架构型前端更厉害,他们关注的是整个平台的稳定性、可维护性和扩展性。他们设计组件库、微前端架构、前端性能监控体系,甚至参与后端接口设计。换句话说,他们更像“产品工程师”,不仅懂技术,还懂业务。

会写代码不再稀缺,会“用 AI 写代码”才是门槛

你可能注意到了,现在很多人说“前端会写代码不稀缺了”。这是真的。基础的 JS、CSS、HTML 很多人都会,但如果你能用 AI 辅助写代码、自动生成模板、快速优化性能,那才是真正的核心竞争力。就像以前会打字的人很多,但会用 Excel 做财务建模的人少,差距就出来了。

举个例子,现在有些大型项目,我们用 AI 帮忙生成表单验证逻辑,或者做自动化测试脚本,效率能提高好几倍。这种能力,不是简单敲几行代码能替代的。

前端未来,更像产品工程师

所以,到底前端是不是夕阳行业?我觉得恰恰相反。未来的前端,更像产品工程师——你不仅要写代码,还要思考性能、用户体验、架构设计、工程化流程,甚至要和 AI、云端、数据打交道。前端的职业宽度比以前更大,技能组合也更加稀缺。

换句话说,前端不再只是写界面的小伙伴,而是能把技术和产品结合起来,创造可落地系统的人。

总结

不是前端“夕阳”,只是门槛提高了

从薪资和招聘活跃度看:

- 前端岗位依旧铺开在招聘平台上,高薪职位数量没有消失,只是分布更广、更分层。

- 高端工程师、架构型前端、全栈/AI 前端人才仍然供不应求。

- 竞争压力主要来自技术同质化人才与行业整体求职人数增长的趋势(特别是毕业季)。 开源中国

真实情形是:前端并非夕阳,而是在职业形态和薪资结构上出现了更明显的分层。

你看到普通前端岗位薪资增长缓慢,是因为市场供给大,但 高技术、高工程化能力者反而更加吃香,门槛变了,而不是需求消失。

总结:结合数据再看“前端是否夕阳”

既然有数据支撑,我们再回到那个问题:

前端是否是夕阳行业?结论是:

- 前端需求仍在增长 ——招聘平台活跃度高,技术转型需求仍旧带来岗位。

- 薪资仍然维持在行业中上水平 ——尤其中高级、工程化岗位。

- 市场竞争更激烈 ——求职人数持续增长使得低门槛岗位更难突围。

- 分层明显 ——普通前端增长较缓,高技能人才仍稀缺。

所以说:前端不是夕阳行业,前端职业更像是正经历升级版的“技术工程”方向,更接近综合产品工程师,而不是单纯的页面写手。

要在这个岗位上活得更好,与 AI 协作、提升工程化能力、掌握架构与性能优化,成为未来核心竞争力。

数据来源说明

本文涉及的前端薪资、招聘人数、求职人数及市场趋势数据,主要来源公开渠道:

- BOSS直聘:招聘岗位示例及薪资参考 官网,招聘活跃度趋势及职位需求变化 年度报告

- 前端薪资参考:全国平均薪资及高端岗位薪资 Teamed Up China、大厂薪资对比 Levels.fyi、高端技术岗位薪资 脉脉高聘年度报告

- 前端供需数据:技术类岗位供需比及求职活跃度 公开行业报告

数据仅供行业分析参考,实际薪资及岗位信息可能随城市、公司和岗位等级变化。

来源:juejin.cn/post/7587684397530595355

高德地图与Three.js结合实现3D大屏可视化

高德地图与Three.js结合实现3D大屏可视化

文末源码地址及视频演示

前言

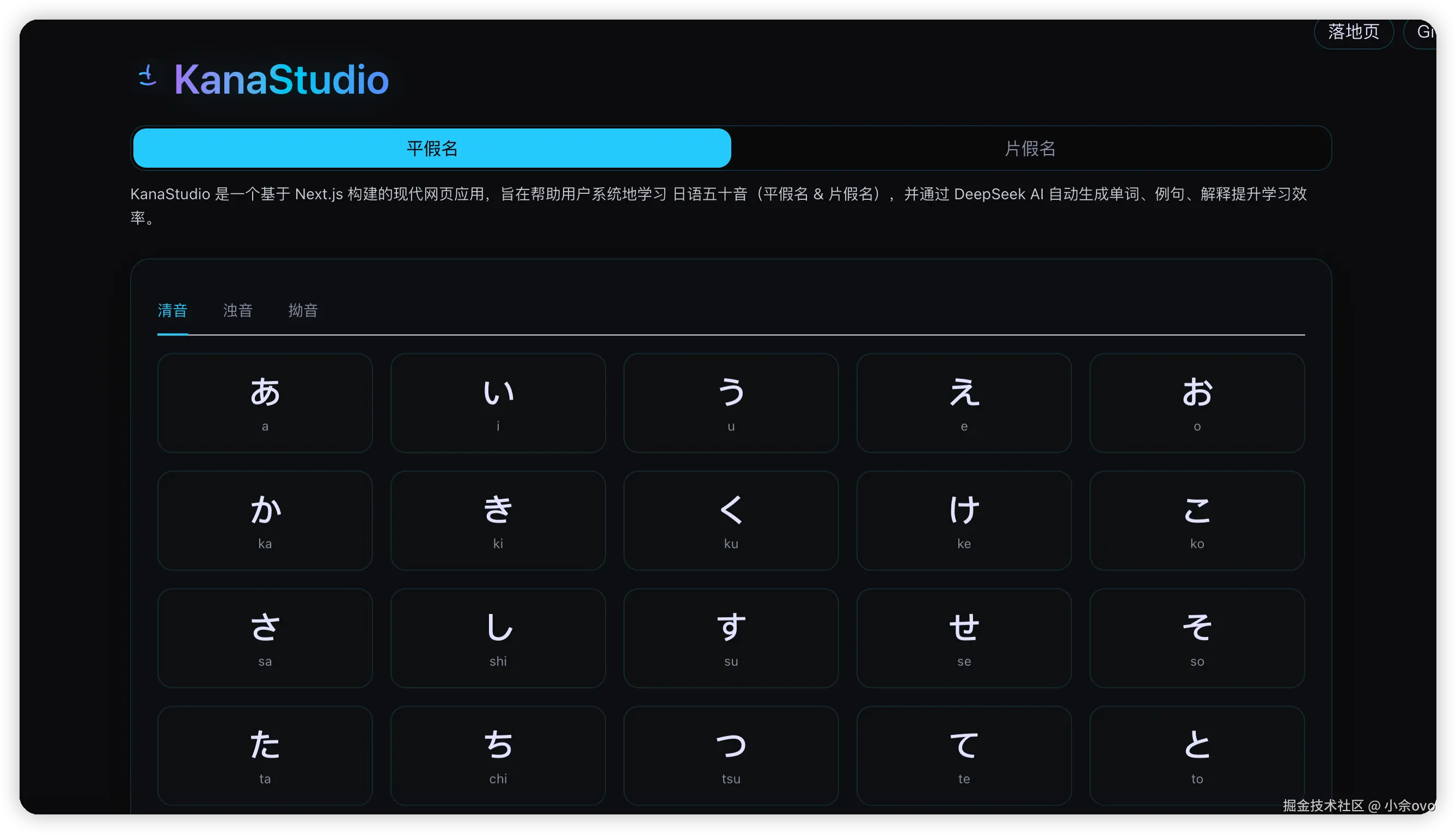

在智慧城市安全管理场景中,如何将真实的地理信息与3D模型完美结合,实现沉浸式的可视化监控体验?本文将以巡逻犬管理系统的大屏预览功能为例,详细介绍如何通过高德地图API与Three.js深度结合,实现3D机械狗模型在地图上的实时巡逻展示。

该系统实现了以下核心功能:

- 在高德地图上加载并渲染3D机械狗模型

- 实现模型沿预设路线的自动巡逻动画

- 镜头自动跟随模型移动,提供沉浸式监控体验

- 实时显示巡逻进度、告警信息等业务数据

技术栈

- 高德地图 JS API 2.0:提供地图底图和空间定位能力

- Three.js r157:3D模型渲染和动画控制

- Loca 2.0:高德地图数据可视化API,用于镜头跟随

- React + TypeScript:前端框架和类型支持

- TWEEN.js:补间动画库,用于平滑的模型移动

一、高德地图初始化

1.1 地图配置

首先需要配置高德地图的加载参数,包括API Key、版本号等:

// src/utils/amapConfig.ts

export const mapConfig = {

key: 'your-amap-key',

version: '2.0',

Loca: {

version: '2.0.0', // Loca版本需与地图版本一致

},

};

// 初始化安全配置(必须在AMapLoader.load之前调用)

export const initAmapSecurity = () => {

if (typeof window !== 'undefined') {

(window as any)._AMapSecurityConfig = {

securityJsCode: 'your-security-code',

};

}

};

1.2 创建地图实例

使用AMapLoader.load加载地图API,然后创建地图实例:

// 设置安全密钥

initAmapSecurity();

// 加载高德地图

const AMap = await AMapLoader.load(mapConfig);

// 创建地图实例,开启3D视图模式

const mapInstance = new AMap.Map(mapContainerRef.current, {

zoom: 13,

center: defaultCenter,

viewMode: '3D', // 关键:必须开启3D模式

resizeEnable: true,

});

关键点:

viewMode: '3D'必须设置,否则无法使用3D相关功能- 需要提前设置安全密钥,否则会报错

1.3 初始化Loca容器

Loca是高德地图的数据可视化容器,用于实现镜头跟随等功能:

const loca = new (window as any).Loca.Container({

map: mapInstance,

zIndex: 9

});

二、创建GLCustomLayer自定义图层

GLCustomLayer是高德地图提供的WebGL自定义图层,允许我们在地图上渲染Three.js内容。

2.1 图层结构

const customLayer = new AMap.GLCustomLayer({

zIndex: 200, // 图层层级,确保模型在最上层

init: async (gl: any) => {

// 在这里初始化Three.js场景、相机、渲染器等

},

render: () => {

// 在这里执行每帧的渲染逻辑

},

});

mapInstance.add(customLayer);

2.2 初始化Three.js场景

在init方法中创建Three.js的核心组件:

init: async (gl: any) => {

// 1. 创建透视相机

const camera = new THREE.PerspectiveCamera(

60, // 视野角度

window.innerWidth / window.innerHeight, // 宽高比

100, // 近裁剪面

1 << 30 // 远裁剪面(使用位运算表示大数值)

);

// 2. 创建WebGL渲染器

const renderer = new THREE.WebGLRenderer({

context: gl, // 使用地图提供的WebGL上下文

antialias: false, // 禁用抗锯齿,减少WebGL扩展需求

powerPreference: 'default',

});

renderer.autoClear = false; // 必须设置为false,否则地图底图无法显示

renderer.shadowMap.enabled = false; // 禁用阴影,避免WebGL扩展问题

// 3. 创建场景

const scene = new THREE.Scene();

// 4. 添加光源

const ambientLight = new THREE.AmbientLight(0xffffff, 1.0);

scene.add(ambientLight);

const directionalLight = new THREE.DirectionalLight(0xffffff, 1.2);

directionalLight.position.set(1000, -100, 900);

scene.add(directionalLight);

}

关键点:

renderer.autoClear = false必须设置,否则会清除地图底图- 使用地图提供的

gl上下文创建渲染器,实现资源共享

三、坐标系统转换

高德地图使用经纬度坐标(WGS84),而Three.js使用3D世界坐标,两者之间的转换是关键。

3.1 获取自定义坐标系统

地图实例提供了customCoords工具,用于坐标转换:

// 获取自定义坐标系统

const customCoords = mapInstance.customCoords;

// 设置坐标系统中心点(重要:必须在设置模型位置前设置)

const center = mapInstance.getCenter();

customCoords.setCenter([center.lng, center.lat]);

3.2 经纬度转3D坐标

使用lngLatsToCoords方法将经纬度转换为Three.js坐标:

// 将经纬度 [lng, lat] 转换为Three.js坐标 [x, z, y?]

const position = customCoords.lngLatsToCoords([

[120.188767, 30.193832]

])[0];

// 注意:返回的数组格式为 [x, z, y?]

// position[0] 对应 Three.js 的 z 轴(纬度)

// position[1] 对应 Three.js 的 x 轴(经度)

// position[2] 对应 Three.js 的 y 轴(高度,可选)

robotGr0up.position.setX(position[1]); // x坐标(经度)

robotGr0up.position.setZ(position[0]); // z坐标(纬度)

robotGr0up.position.setY(position.length > 2 ? position[2] : 0); // y坐标(高度)

坐标轴对应关系:

- 高德地图:X轴(经度),Y轴(纬度),Z轴(高度)

- Three.js:X轴(右),Y轴(上),Z轴(前)

- 转换后:

position[1]→ Three.js X轴,position[0]→ Three.js Z轴

3.3 同步相机参数

在render方法中,需要同步高德地图的相机参数到Three.js相机:

render: () => {

const { near, far, fov, up, lookAt, position } = customCoords.getCameraParams();

// 同步相机参数

camera.near = near;

camera.far = far;

camera.fov = fov;

camera.position.set(position[0], position[1], position[2]);

camera.up.set(up[0], up[1], up[2]);

camera.lookAt(lookAt[0], lookAt[1], lookAt[2]);

camera.updateProjectionMatrix();

// 渲染场景

renderer.render(scene, camera);

// 必须执行:重新设置three的gl上下文状态

renderer.resetState();

}

四、加载3D模型

4.1 使用GLTFLoader加载模型

import { GLTFLoader } from 'three/examples/jsm/loaders/GLTFLoader';

const loader = new GLTFLoader();

const modelPath = '/assets/modules/robot_dog/scene.gltf';

const gltf = await new Promise<any>((resolve, reject) => {

loader.load(

modelPath,

(gltf: any) => resolve(gltf),

(progress: any) => {

if (progress.total > 0) {

const percent = (progress.loaded / progress.total) * 100;

console.log('模型加载进度:', percent.toFixed(2) + '%');

}

},

reject

);

});

const robotModel = gltf.scene;

4.2 模型预处理

加载模型后需要进行预处理,包括材质优化、位置调整等:

// 遍历模型所有子对象

robotModel.traverse((child: THREE.Object3D) => {

if (child instanceof THREE.Mesh) {

// 禁用阴影相关功能

child.castShadow = false;

child.receiveShadow = false;

// 简化材质,避免使用需要WebGL扩展的高级特性

if (child.material) {

const materials = Array.isArray(child.material)

? child.material

: [child.material];

materials.forEach((mat: any) => {

// 禁用transmission等高级特性

if (mat.transmission !== undefined) {

mat.transmission = 0;

}

});

}

}

});

// 计算模型边界框并居中

const box = new THREE.Box3().setFromObject(robotModel);

const center = box.getCenter(new THREE.Vector3());

// 将模型居中(X和Z轴)

robotModel.position.x = -center.x;

robotModel.position.z = -center.z;

// 将模型底部放在y=0

robotModel.position.y = -box.min.y;

// 设置模型缩放

const scale = 15;

robotModel.scale.set(scale, scale, scale);

4.3 创建模型组并设置初始旋转

由于高德地图和Three.js的坐标系差异,需要调整模型的初始旋转:

// 创建外层Gr0up用于位置和旋转控制

const robotGr0up = new THREE.Gr0up();

robotGr0up.add(robotModel);

// 设置初始旋转(90, 90, 0)度转换为弧度

const initialRotationX = (Math.PI / 180) * 90;

const initialRotationY = (Math.PI / 180) * 90;

const initialRotationZ = (Math.PI / 180) * 0;

robotGr0up.rotation.set(initialRotationX, initialRotationY, initialRotationZ);

scene.add(robotGr0up);

五、实现镜头跟随

5.1 使用Loca实现镜头跟随

高德地图的Loca API提供了viewControl.addTrackAnimate方法,可以实现镜头自动跟随路径移动:

// 计算路径总距离

let totalDistance = 0;

for (let i = 0; i < paths.length - 1; i++) {

totalDistance += AMap.GeometryUtil.distance(paths[i], paths[i + 1]);

}

// 假设速度是 1.5 m/s

const speed = 1.5;

const duration = (totalDistance / speed) * 1000; // 转换为毫秒

loca.viewControl.addTrackAnimate({

path: paths, // 镜头轨迹,二维数组

duration: duration, // 时长(毫秒)

timing: [[0, 0.3], [1, 0.7]], // 速率控制器

rotationSpeed: 180, // 每秒旋转多少度

}, function () {

console.log('单程巡逻完成');

// 可以在这里处理往返逻辑

});

loca.animate.start(); // 启动动画

5.2 模型位置同步

在render方法中,根据地图中心点实时更新模型位置:

render: () => {

// ... 同步相机参数代码 ...

if (robotGr0up && mapInstance && !patrolFinishedRef.current) {

// 获取当前地图中心(镜头跟随会改变地图中心)

const center = mapInstance.getCenter();

if (center) {

// 更新坐标系统中心点为地图中心点

customCoords.setCenter([center.lng, center.lat]);

// 将地图中心转换为Three.js坐标

const position = customCoords.lngLatsToCoords([

[center.lng, center.lat]

])[0];

// 更新模型位置

robotGr0up.position.setX(position[1]);

robotGr0up.position.setZ(position[0]);

robotGr0up.position.setY(position.length > 2 ? position[2] : 0);

// 更新模型旋转(根据地图旋转)

const rotation = mapInstance.getRotation();

if (rotation !== undefined) {

const initialRotationY = (Math.PI / 180) * 90;

robotGr0up.rotation.y = initialRotationY + (rotation * Math.PI / 180);

}

}

}

// 渲染场景

renderer.render(scene, camera);

renderer.resetState();

}

关键点:

- 使用地图中心点作为模型位置,实现精确跟随

- 在每次render中更新坐标系统中心点,确保坐标转换准确

- 同步地图旋转角度到模型Y轴旋转

六、巡逻动画实现

6.1 启动巡逻

当模型加载完成并设置好初始位置后,可以启动巡逻动画:

const startPatrol = (paths: number[][], mapInstance: any, AMap: any) => {

// 停止之前的巡逻

TWEEN.removeAll();

patrolFinishedRef.current = false;

// 保存路径

patrolPathsRef.current = paths;

patrolIndexRef.current = 0;

// 播放前进动画

playAnimation('1LYP'); // 播放行走动画

// 设置坐标系统中心点为路径起点

const firstPoint = paths[0];

customCoordsRef.current.setCenter([firstPoint[0], firstPoint[1]]);

// 使用Loca实现镜头跟随

const loca = locaRef.current;

if (loca) {

// ... addTrackAnimate 代码 ...

}

// 启动模型移动动画

changeObject();

};

6.2 模型移动动画

使用TWEEN.js实现模型在路径点之间的平滑移动:

const changeObject = () => {

if (patrolFinishedRef.current || patrolIndexRef.current >= patrolPathsRef.current.length - 1) {

return;

}

const sp = patrolPathsRef.current[patrolIndexRef.current];

const ep = patrolPathsRef.current[patrolIndexRef.current + 1];

const s = new THREE.Vector2(sp[0], sp[1]);

const e = new THREE.Vector2(ep[0], ep[1]);

const speed = 0.03;

const dis = AMap.GeometryUtil.distance(sp, ep);

if (dis <= 0) {

patrolIndexRef.current++;

changeObject();

return;

}

// 使用TWEEN实现平滑移动

new TWEEN.Tween(s)

.to(e.clone(), dis / speed / speedFactor)

.start()

.onUpdate((v) => {

// 更新模型经纬度引用

modelLngLatRef.current = [v.x, v.y];

// 节流更新状态(每100ms更新一次)

const now = Date.now();

if (now - lastUpdateTimeRef.current > 100) {

setCurrentLngLat([v.x, v.y]);

checkSamplePoint([v.x, v.y], AMap); // 检测取样点

// 计算已巡逻长度

updatePatrolledLength(v);

lastUpdateTimeRef.current = now;

}

})

.onComplete(() => {

accumulatedLengthRef.current += dis;

if (patrolIndexRef.current < patrolPathsRef.current.length - 2) {

patrolIndexRef.current++;

changeObject(); // 继续下一段

} else {

// 单程完成

if (patrolMode !== '往返') {

patrolFinishedRef.current = true;

playAnimation('1Idle'); // 播放静止动画

}

}

});

};

6.3 动画系统

模型支持多种动画(行走、静止、跳舞等),使用AnimationMixer管理:

// 设置动画系统

if (gltf.animations && gltf.animations.length > 0) {

const mixer = new THREE.AnimationMixer(robotModel);

// 创建所有动画动作

const actions = new Map<string, THREE.AnimationAction>();

gltf.animations.forEach((clip: THREE.AnimationClip) => {

const action = mixer.clipAction(clip);

action.setLoop(THREE.LoopRepeat); // 循环播放

actions.set(clip.name, action);

});

// 播放默认静止动画

const defaultAction = actions.get('1Idle');

if (defaultAction) {

defaultAction.setEffectiveTimeScale(0.6); // 设置播放速度

defaultAction.fadeIn(0.3);

defaultAction.play();

}

}

// 在render循环中更新动画

const render = () => {

requestAnimationFrame(() => {

render();

});

// 更新动画混合器

if (mixer) {

const currentTime = performance.now();

const delta = (currentTime - lastAnimationTime) / 1000;

mixer.update(delta);

lastAnimationTime = currentTime;

}

// 更新TWEEN动画

TWEEN.update();

// 渲染地图

mapInstance.render();

};

图片略大,耐心等候

七、AI安全隐患自动检测与告警

系统集成了Coze AI大模型,实现了巡逻过程中的自动安全隐患检测和告警功能。当机械狗沿路线巡逻时,系统会在预设的取样点自动触发AI分析,识别潜在的安全隐患。

7.1 取样点计算

系统支持基于路线间隔的自动取样点计算,根据巡逻犬配置的取样间隔(如每50米、100米等),在路线上均匀分布取样点:

// 计算取样点(基于路线间隔)

const calculateSamplePoints = (

paths: number[][],

sampleInterval: number,

AMap: any

): Array<{ lng: number; lat: number; distance: number }> => {

const samplePoints: Array<{ lng: number; lat: number; distance: number }> = [];

let accumulatedDistance = 0;

// 从第一个点开始(0米处)

samplePoints.push({

lng: paths[0][0],

lat: paths[0][1],

distance: 0,

});

// 遍历路径,计算每个取样点

for (let i = 0; i < paths.length - 1; i++) {

const currentPoint = paths[i];

const nextPoint = paths[i + 1];

const segmentDistance = AMap.GeometryUtil.distance(currentPoint, nextPoint);

// 检查当前段是否包含取样点

while (accumulatedDistance + segmentDistance >= (samplePoints.length * sampleInterval)) {

const targetDistance = samplePoints.length * sampleInterval;

const distanceInSegment = targetDistance - accumulatedDistance;

// 计算取样点在当前段中的位置(线性插值)

const ratio = distanceInSegment / segmentDistance;

const sampleLng = currentPoint[0] + (nextPoint[0] - currentPoint[0]) * ratio;

const sampleLat = currentPoint[1] + (nextPoint[1] - currentPoint[1]) * ratio;

samplePoints.push({

lng: sampleLng,

lat: sampleLat,

distance: targetDistance,

});

}

accumulatedDistance += segmentDistance;

}

return samplePoints;

};

关键点:

- 使用高德地图的

GeometryUtil.distance计算路径段距离 - 通过线性插值计算取样点的精确位置

- 取样点从路线起点开始,按固定间隔均匀分布

7.2 自动触发检测

在巡逻过程中,系统实时检测模型位置是否到达取样点附近(±10米范围内):

// 检测是否到达取样点

const checkSamplePoint = (currentLngLat: [number, number], AMap: any) => {

const patrolDog = currentPatrolDogRef.current;

const route = currentRouteRefForSample.current;

const area = currentAreaRefForSample.current;

if (!patrolDog || !route || !patrolDog.cameraDeviceId) {

return; // 没有绑定摄像头,不进行取样

}

// 检查取样方式(必须是"路线间隔"模式)

if (patrolDog.sampleMode !== '路线间隔' || !patrolDog.sampleInterval) {

return;

}

// 检查是否在取样点附近(±10米范围内)

for (let i = 0; i < samplePointsRef.current.length; i++) {

if (processedSamplePointsRef.current.has(i)) {

continue; // 已处理过,跳过

}

const samplePoint = samplePointsRef.current[i];

const distance = AMap.GeometryUtil.distance(

[currentLngLat[0], currentLngLat[1]],

[samplePoint.lng, samplePoint.lat]

);

// 在 ±10 米范围内,触发取样

if (distance <= 10) {

console.log(`✅ 到达取样点 ${i + 1}/${samplePointsRef.current.length}`);

processedSamplePointsRef.current.add(i);

// 异步调用 Coze API(不阻塞巡逻)

analyzeSecurity(

patrolDog,

route,

area,

currentLngLat,

AMap

).catch(error => {

console.error('安全隐患分析失败:', error);

});

break; // 一次只处理一个取样点

}

}

};

关键点:

- 使用距离判断,避免重复触发

- 异步调用AI分析,不阻塞巡逻动画

- 使用

Set记录已处理的取样点,确保每个点只处理一次

7.3 调用Coze API进行安全隐患分析

系统使用Coze平台的大模型工作流进行图像安全隐患分析:

// 调用 Coze API 进行安全隐患分析

const analyzeSecurity = async (

patrolDog: PatrolDog,

route: Route,

area: Area | null,

currentLngLat: [number, number],

AMap: any

): Promise<void> => {

try {

// 1. 获取默认令牌

await initDB();

const tokens = await db.token.getAll();

const validTokens = tokens.filter(token => Date.now() <= token.expireDate);

if (validTokens.length === 0) {

console.warn('没有可用的令牌,跳过安全隐患分析');

return;

}

const defaultToken = validTokens.find(t => t.isDefault) || validTokens[0];

// 2. 准备分析数据

// 随机选择一张测试图片(实际应用中应使用摄像头实时抓拍)

const randomImageUrl = imageUrlr[Math.floor(Math.random() * imageUrlr.length)];

// 构建输入文本,描述当前巡逻场景

const inputText = `${patrolDog.name}当前在${area?.name || '未知'}区域${route.name}巡逻时抓拍了一张照片。分析是否存在安全隐患`;

// 3. 创建 Coze API 客户端

const apiClient = new CozeAPI({

token: defaultToken.token,

baseURL: 'https://api.coze.cn',

allowPersonalAccessTokenInBrowser: true,

});

// 4. 调用工作流

const workflow_id = '7585585625312034858';

const res = await apiClient.workflows.runs.create({

workflow_id: workflow_id,

parameters: {

input: inputText,

mediaUrl: randomImageUrl,

},

});

// 5. 解析返回结果

let analysisResult: { securityType: number; score: number; desc: string } | null = null;

if (res.data) {

const dataObj = typeof res.data === 'string' ? JSON.parse(res.data) : res.data;

if (dataObj.output && typeof dataObj.output === 'string') {

// 提取 markdown 代码块中的 JSON

const jsonMatch = dataObj.output.match(/```json\s*([\s\S]*?)\s*```/) ||

dataObj.output.match(/```\s*([\s\S]*?)\s*```/);

if (jsonMatch && jsonMatch[1]) {

analysisResult = JSON.parse(jsonMatch[1].trim());

} else {

// 尝试直接解析 output 为 JSON

analysisResult = JSON.parse(dataObj.output);

}

} else {

analysisResult = dataObj;

}

}

// 6. 判断是否是报警(securityType !== 0 且 score !== 0)

if (analysisResult && analysisResult.securityType !== 0 && analysisResult.score !== 0) {

// 保存到分析报警表

const analysisAlert: Omit<AnalysisAlert, 'id' | 'createTime' | 'updateTime'> = {

alertTime: Date.now(),

patrolDogId: patrolDog.id!,

patrolDogName: patrolDog.name,

cameraDeviceId: patrolDog.cameraDeviceId,

cameraDeviceName: patrolDog.cameraDeviceName,

routeId: route.id!,

routeName: route.name,

areaId: area?.id,

areaName: area?.name,

securityType: analysisResult.securityType as 0 | 1 | 2 | 3 | 4 | 5,

score: analysisResult.score,

desc: analysisResult.desc,

mediaUrl: randomImageUrl,

input: inputText,

status: '未处理',

};

await db.analysisAlert.add(analysisAlert);

console.log('✅ 安全隐患告警已保存');

// 更新告警列表(实时显示在大屏右侧)

updateAlertList(patrolDog.id!, route.id!, area?.id);

} else {

console.log('未发现安全隐患,不保存报警');

}

} catch (error) {

console.error('调用 Coze API 失败:', error);

}

};

API返回结果格式:

{

"securityType": 1, // 0=无隐患, 1=明火燃烟, 2=打架斗殴, 3=违章停车, 4=杂物堆放, 5=私搭乱建

"score": 85, // 严重程度评分 (0-100)

"desc": "检测到明火,存在严重安全隐患" // 详细描述

}

关键点:

- 使用

@coze/api官方SDK调用工作流API - 支持多种安全隐患类型识别(明火燃烟、打架斗殴、违章停车等)

- 自动保存告警记录,支持后续查询和处理

- 告警信息实时显示在大屏右侧告警列表中

7.4 Coze测试页面

系统提供了专门的Coze测试页面,方便开发者测试和调试AI分析功能。在Coze测试页面中,可以:

- 选择令牌:从已配置的Coze API令牌中选择(支持多个令牌管理)

- 输入分析文本:描述需要分析的场景

- 上传图片URL:提供需要分析的图片地址

- 自动填充功能:点击"自动填充"按钮,快速填充默认的测试数据

- 查看完整响应:显示Coze API的完整返回结果,包括解析后的JSON和原始响应

// Coze测试页面核心功能

const handleTest = async () => {

const values = await form.validateFields();

// 创建 Coze API 客户端

const apiClient = new CozeAPI({

token: values.token,

baseURL: 'https://api.coze.cn',

allowPersonalAccessTokenInBrowser: true,

});

// 调用工作流

const workflow_id = '7585585625312034858';

const res = await apiClient.workflows.runs.create({

workflow_id: workflow_id,

parameters: {

input: values.input,

mediaUrl: values.mediaUrl,

},

});

// 解析并显示结果

// ... 解析逻辑 ...

};

测试页面特性:

- 自动填充数据:提供默认的测试图片和文本,方便快速测试

- 图片预览:实时预览输入的图片URL

- 完整响应展示:显示API的完整响应,便于调试

- 错误处理:友好的错误提示,帮助定位问题

请截图 Coze测试页面 自动填充功能 测试结果展示

使用场景:

- 测试新的安全隐患识别算法

- 验证Coze API令牌是否有效

- 调试API返回结果格式

- 验证图片URL是否可被Coze解析

八、性能优化建议

7.1 渲染优化

- 禁用不必要的WebGL扩展(如阴影、抗锯齿)

- 使用

requestAnimationFrame统一管理渲染循环 - 合理设置模型LOD(细节层次)

7.2 内存管理

- 及时清理不需要的TWEEN动画:

TWEEN.removeAll() - 组件卸载时销毁Three.js资源

- 模型加载后缓存,避免重复加载

7.3 坐标转换优化

- 坐标系统中心点跟随地图中心,减少转换误差

- 使用节流控制状态更新频率

- 避免在render中进行复杂计算

九、常见问题解决

8.1 模型不显示

问题:模型加载成功但在地图上不可见

解决方案:

- 检查

renderer.autoClear是否设置为false - 确认坐标转换是否正确(注意数组索引对应关系)

- 检查模型缩放是否合适(可能太小或太大)

8.2 模型位置偏移

问题:模型位置与预期不符

解决方案:

- 确保在设置模型位置前调用

customCoords.setCenter() - 检查坐标轴对应关系(

position[1]对应X轴,position[0]对应Z轴) - 使用

AxesHelper辅助调试坐标轴方向

8.3 镜头跟随不流畅

问题:镜头跟随有延迟或卡顿

解决方案:

- 调整

rotationSpeed参数,控制旋转速度 - 优化

timing速率控制器,实现更平滑的加速减速 - 检查render循环是否正常执行

十、总结

通过高德地图与Three.js的深度结合,我们成功实现了3D模型在地图上的实时展示和动画效果,并集成了AI大模型实现智能安全隐患检测。核心要点包括:

- GLCustomLayer是关键桥梁:通过自定义图层实现Three.js与高德地图的融合

- 坐标转换是核心:正确理解和使用

customCoords进行坐标转换 - 镜头跟随提升体验:使用Loca API实现平滑的镜头跟随效果

- AI智能检测增强功能:集成Coze大模型实现自动安全隐患识别和告警

- 性能优化不可忽视:合理配置渲染参数,避免不必要的WebGL扩展

技术亮点:

- 虚实结合:真实地理信息与3D模型的完美融合

- 智能检测:基于AI大模型的自动安全隐患识别

- 实时告警:巡逻过程中的实时检测和告警推送

- 可视化展示:沉浸式大屏监控体验

这种技术方案不仅适用于巡逻犬管理系统,还可以扩展到智慧城市、物流追踪、车辆监控、园区安防等多个场景,为空间数据可视化提供了强大的技术支撑。通过AI能力的集成,系统从传统的可视化展示升级为智能化的安全监控平台,实现了"看得见、管得住、能预警"的完整闭环。

参考资源

来源:juejin.cn/post/7589482741759819803

百度又一知名产品,倒下了!

就在最近,百度旗下又一款知名互联网产品正式宣布停止服务,令人唏嘘不已。

没错,它就是「百度脑图」。

提到「百度脑图」这个名字,对于很多年轻的朋友们来说,可能有些陌生,但是在当年那会还是挺有名的。

对我而言,之前我还真就认认真真用过一段时间,在上面画了不少图,但是后来还是转到其他工具了。

说实话,要不是看到这个新闻,我都快忘记有这个产品的存在了。

出于好奇,我也特地登进去看了一眼。

果然,这停服公告都已经正式发出来了:

因产品调整,百度脑图将于 2026 年 3 月 31 日正式停止服务。

这也就意味着,这个产品将在明年春天正式画上句号,同时也给用户留了三个多月的数据导出时间。

众所周知,百度家的很多产品用起来一言难尽,要么有广,要么得氪金开会员。

但该说不说,「百度脑图」这个产品在我印象中倒还一直挺干净的,无广无贴,也不要会员啥的。

和市面上常见的脑图产品一样,这是一个免安装、支持网页版云端存储和自动实时保存的思维脑图编辑工具。

而且重点是界面简洁干净,无贴无广,并且兼容多种格式,同时也支持多格式脑图文件自由下载和导出。

咱讲话了,这都整得有点不像是百度家风格的产品了。

我特地看了一下它的产品更新日志,最近的一次更新还得追溯到 2019 年的 7月份。

这也意味着,这个产品已经 6 年多没怎么更新了啊,emmm,看来他们公司对这个产品是真的一点儿也不上心呢。

提到「百度脑图」,可能很多同学压根都不知道这个产品,但是百度脑图在行业内起步算很早的了。

这算一算,其实它也是 10 年前的产品了。

回想当年它刚推出时,就是凭借着“免安装、云存储、易分享”三大特点而传开,说实话 那时候,我们还没有现在那么多眼花缭乱的协作工具。

然而,互联网不相信眼泪,也从不吝啬告别。

近年来,随着 SaaS 服务的兴起,包括类似 XMind、MindManager 等专业工具和协作类工具的不断进化,加上百度自身战略重心的转移,百度脑图也渐渐淡出了我们的视野。

所以写着写着我寻思,这不又是百度身上的一个「起了个大早却赶了个晚集」的事情吗……

说起「起大早赶晚集」这个话题,百度那可真有得聊的,它说第一,没人敢说第二……

作为曾经的 BAT 三巨头之一,百度在很多风口上都曾拥有极强的前瞻性,并且往往是第一批入局者,但最终呢,却因为各种内外部原因,被同行反超压制,没能笑到最后。

首先是 2003 年上线的「百度贴吧」,曾是中文互联网第一大社区,拥有极强的用户粘性,现在的很多社交玩法(如兴趣圈层)都源于贴吧,但最终贴吧还是未能抓住移动化和兴趣社交的转型机遇,社区地位逐渐被取代,影响力大幅衰退。

再比如「好看视频」,我记得诞生时间是不是好像也和抖音大差不差来着,而且早期也曾投入过不少资源进行推广,但最终呢,还是未能找准差异化定位,被抖音、快手等按在地上摩擦,最终被逐渐边缘化,未能成为短视频领域的主流玩家。

还有「百度钱包/支付」,彼时移动支付刚刚兴起时,百度钱包就紧随上线了,但最后怎么样呢,也是未能跻身主流支付平台的位列,并逐渐淡出用户视野。

再就是「百度外卖」了,2014 年就入局了,上线时间很早吧,但是在与美团、饿了么的竞争中,百度外卖还是缺乏核心壁垒,最终在 2017 年被饿了么给合并了,从而彻底退出了历史舞台。